P

Paul Mazdak

Gast

Hallo in die Runde

an der Stelle möchte ich hierbei folgende Beobachtung teilen (wobei 4 Grafikkarten zum testen auf 3 unterschiedlichen System verwendet worden sind) ....

Alle 3 Systeme verwenden:

Windows 11 Pro, 22631.3668*

* beim Intel-System wurde die TPM Sperre mit Rufus umgangen (und ein Inplace Upgrade ausgeführt)

Alle Windows Updates, + die jeweiligen aktuellsten Chipsatztreiber für die jeweilige Plattform sind installiert.

Bei den verwendeten Systemen handelt es sich entweder um eine komplette NeuInstallation (AM4+AM5)

oder ggf. sofern es sich um Inplace Upgrade gehandelt hat (Intel System); wurde DDU im abgesicherten Modus ausgeführt.

Testweise wurde aber auch beim AM4/AM5 DDU im abgesicherten Modus nochmals nachträglich ausgeführt.

= Installiert ist hierbei bei allen die 24.5.1

(u.a. auch wegen der letzten Sicherheitsupdates; welche man im englischsprachigen Changelog findet).

Die jeweiligen Systeme sind jeweils maximal 1x per HDMI angeschlossen:

Es handelt sich also in keinem der Fälle um ein Multi-Monitor-Setup.

Wo es möglich war (etwa beim OLED42C37LA; wurde FreeSync aktiviert jedoch wurden die FPS per Chill auf 61/62 begrenzt).

Bei den 2 anderen Systemen:

LG 32UN659P-W (Monitor; mit 60hz max, Standartprofil)

LG 43QNED765RA (TV mit 60hz max; im LG HomeHub ist dieser aber wie o.g. OLed als "PC" definiert und die Einstellung "Spiele" ausgewählt)

Firmware-Updates (WebOs); bei den 2 Geräten wo es ging sind ebenfalls auf aktuellsten Stand.

Ein Austausch der bisherigen 2.1 Kabel zu einen anderen Premium-Hersteller, blieb wie erwartet ohne Veränderung.

Profil:

3840x2160@60Hz bzw. 59,94hz, auf

8Bit begrenzt

FreeSync An beim OLed (bzw. bei den 2 anderen Geräten nicht vorhanden)

VSync bzw. auf Vertikalen Neuaufbau warten: An

RGB 4:4:4 Pixel Format PC-Standard

HDR ist im Windows-Betrieb inaktiv geschaltet. Ebenso das 10Bit Pixelformat; welches wiederum auf 8Bit begrenzt worden ist.

GPU Skalierung ist angeschaltet (zeigte jedoch auch auf Aus) und der nachträglichen Übernahme in den Windows-Einstellungen keine Unterschiede im Verbrauch.

Versuche:

Ein Heruntersetzen der HZ Zahl auf 59Hz bzw. testweise 50HZ, ggf. eine niedrigere HZ Zahl blieb ohne Erfolg.

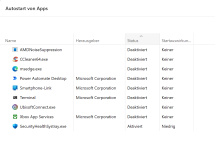

Mehrere Versuche in Windows > System > Bildschirm > Grafik > Benutzerdefinierte Optionen mit "Energiesparmodus" nachträglich zu triggern blieben ohne Veränderung.

Eine benutzerdefinierte Auflösung zu erstellen:

Mit den Timing Standard: CVT, ggf. CVT verringerte Auslastung + Übernahme in den Windows-Einstellungen brachte keine Veränderung. Die Übernahme der neuen Settings in den Windows-Einstellungen wurde zu keiner Zeit vergessen und manuell per Auswahl übernommen.

CRU (im administrativen Modus ausgeführt) mit einer Clock-Rate von 90, testweise 150 bzw. maximal 200 verändern nichts am Grundverbrauch. Die Idle-Werte bleiben mehr oder weniger identisch. (auch nach Neustart des Treibers über reset64)

Radeon ReLive ist grundsätzlich deaktiviert.

Auto-HDR ebenso.

Die Metrik-Einstellungen (Sampling Intervall) sind auf Treiber Standard belassen worden.

Der Shader-Cache wurde versuchsweise ebenfalls zurückgesetzt.

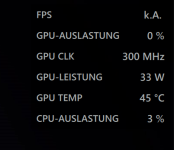

Auffällig ist das vor allem bei RX 570 Polaris, bzw. der kleinstem RDNA3 (7600). Jene haben sich bezüglich des IDLE Verbrauchs in der Vergangenheit bisher noch am genügsamsten verhalten, schlagen inzwischen doch sehr stark aus.

Die 7700 XT ist da nochmal eine andere Ausnahme; zumindest in meinem Fall.

Beispiel:

6700 XT (nicht mehr vorhanden, hier berufe ich mich darauf was mir meine Erinnerung sagt) & der noch vorhandenen RX 7600.

Im Windows Betrieb (und ohne Fensterbewegung) bin ich damals bei beiden Grafikkarten seltenst über die 14 Watt hinausgekommen. 8 Watt waren hierbei eher Alltag.

Inzwischen & vor allem mit den aktuellsten Treibern aus diesem Jahr; muss sich das m.M.n. irgendwann verschlechtert haben.

33-35 Watt Idle ist und war bei beiden Karten bei mir zuletzt das absolut messbare Minimum. In YT (SDR) geht dies teilweise auf beiden Karten bis auf 55- maximal 60 Watt hoch. Während dies bei der 6700 XT im August(?) 2023 maximal 30 Watt betragen hat, bzw. bei der 7600 irgendwas (laut meiner Erinnerung) um die 20-22 Watt gewesen sein müssten.

Jenes ist gegensätzlich dem entgegengesetzt,

was damals CB in ihren Test gemessen hat und dem was ich gleichzeitig aus August(?) 2023 mehr oder weniger laut meiner Erinnerung noch im Gedächtnis habe.

Die RX570, welche laut Test:

https://www.computerbase.de/artikel/grafikkarten/radeon-rx-580-570-test.59085/

bei mir ebenfalls vorher zwischen 8-14 vor sich hindümpelte; powert nun in der Regel zwischen 32-35 Watt im IDLE rum. In YT 4K; SDR knallt diese locker auf 40 Watt hoch; während es vorher "nur" ca. 30 Watt waren. 60 Watt sind diesbezüglich (siehe späteren Post) wiederum aber leider auch keine Ausnahme mehr.

Die 7700 XT, welche laut Test:

https://www.computerbase.de/artikel...nitt_leistungsaufnahme_spiele_youtube_desktop

Idle ca 12 Watt verbrauchen sollte, bekomme ich erst gar nicht mehr unter 22Watt. Die 22 Watt sind dabei eher die Ausnahme. In der Regel verbleibt dabei viel lieber auf ca. 40 Watt (ohne Fensterbewegung).

Anderseits geht diese in SDR YT aber auch nicht über die 40 Watt (*siehe Nachtrag/Korrektur; inzwischen sind es bei mir leider ebenfalls bis zu 60 Watt).

Persönlicher Eindruck:

Was halt sehr für auffällig für mich ist, ist der Standpunkt das ich die damals von CB gemessenen Werte; welche ich selbst auf meinen Systemen bisher problemlos nachverfolgen konnte - inzwischen nicht mehr gibt. Auf keinen meiner Systeme komm ich an jene damaligen Werte auch nur im Ansatz heran.

Zwischendurch gab es zwar anscheinend Verbesserungen, seitens AMD am IDLE Verbrauch; u.a. hier erwähnt:

https://www.computerbase.de/news/gr...t-erneut-den-desktop-stromverbrauch-an.85231/

- nur merke ich diese leider nicht. Bzw. nicht mehr(?).

In all meinen Fällen, bleibt der IDLE-Verbrauch bei sich allen 3 noch im Besitz findenden AMD Grafikkarten eindeutig zu hoch.

Ob es jetzt dieser Fehler an mir liegt oder meinen Setups (ist höchstwahrscheinlich das Naheliegendste), oder ob dies ggf. an Windows oder AMD liegt, kann ich daher nicht mehr so richtig ausmachen. Diverse möglichen Fehlerbehebungen auf YT :

bzw.

bzw.

oder die im CB-Forum empfohlene Möglichkeiten;

siehe Thread: https://www.computerbase.de/forum/threads/neue-rx7900-xt-hohe-leistungsaufnahme-im-idle.2133974/) brachten mir absolut keine Veränderung.

Irgendwie mit meinen "Latein" am Ende.

Daher möchte ich gerne nachfragen:

1.) Hättet ihr noch andere Tipps, die man versuchen könnte (ohne jetzt in ggf. in CRU rumfummeln zu müssen)?

2.a) Wie sind diesbezüglich eure aktuellen Erfahrungen?

2.b) Habt ihr ggf. die selben Beobachtung machen können (vor allem mit einen der letzten Treiber aus 2024)?

PS:

An der Stelle möchte ich jetzt ungern wegen "10-20 Watt mehr" (und den paar Cents/Euros im Jahr) ´rumheulen´; anderseits möchte ich gerne eine Ersparnis mitnehmen. Sofern sie denn vorhanden ist & möglich sein sollte.

Vor allem bei der Polaris, ggf. der RDNA3 "ärgert" es mich doch ein bisschen, das der Verbrauch inzwischen(?) höher ist, als das was CB offiziell bzw. ich damals bzw. im gleichen Fall für mich heute selbst nachträglich messen konnte.

Das die kleinste RDNA3 (7600) nun auch nicht mehr so sparsam läuft - wie dies evtl. im letzten Test der Fall war - ärgert mich. 33 statt 8 Watt, empfinde ich dann doch leider als zu starke Verschlechterung.

Das RDNA 3 als Mittelklasse (im Fall der 7700 XT) ausschlägt, empfinde ich zwar ebenso als absolut nervig; jedoch war in meinem Fall der IDLE-Verbrauch noch nie gut; weswegen ich mich an diesen Umstand mehr oder weniger gewöhnt habe. Trotzdem würde ich mir natürlich gerne eine Lösung herbeiwünschen, welche dies auf die im CB-Test veranschlagten 12 Watt drückt. 60 Watt für YT (7700XT) - während eine Mittelklasse im System werkelt - erscheint mir auch etwas zu hoch.

Das Polaris hier ebenso "austickt"; verwundert mich um einiges mehr.

an der Stelle möchte ich hierbei folgende Beobachtung teilen (wobei 4 Grafikkarten zum testen auf 3 unterschiedlichen System verwendet worden sind) ....

- RX 7700 XT (Powercolor Hellhound); an einem AM5 System (Ryzen 7600, Asrock Riptide B650M, 32GB DDR5 GSkill 6000Mhz)

- RX 6700 XT (Saphire Pulse) *inzwischen nicht mehr vorhanden); an einem AM4 System (Ryzen 3600, Gigabyte B550 Aorus Elite, 16GB DDR4 3200MHZ)

- RX 7600 (Asus Strix OC), welche ursprünglich als reine BackUp Karte gedacht war. Diese hat die 6700 XT komplett ersetzt und fand Heimat im Sytem aus 2.

- RX 570 (Saphire Nitro); auf einen älteren Intel-System (Asrock P8P67 Deluxe, I7 2600K, DDR3? 16GB)

- Die 3 MBs haben das jeweils letzte BIOS/UEFI Update installiert.

- Die Grafikkarten verwenden bis auf Asus alle ihr mitgeliefertes Bios. Ausnahme bildet dabei die Asus Variante; welche ein Bios-Update für das OC-Bios erhielt (2023/07/04).

Alle 3 Systeme verwenden:

Windows 11 Pro, 22631.3668*

* beim Intel-System wurde die TPM Sperre mit Rufus umgangen (und ein Inplace Upgrade ausgeführt)

Alle Windows Updates, + die jeweiligen aktuellsten Chipsatztreiber für die jeweilige Plattform sind installiert.

- Beim AMD4/5 System wird für das Energiesparprofil: Ryzen Balanced genutzt.

- Beim Intel-System: Ausbalanciert

Bei den verwendeten Systemen handelt es sich entweder um eine komplette NeuInstallation (AM4+AM5)

oder ggf. sofern es sich um Inplace Upgrade gehandelt hat (Intel System); wurde DDU im abgesicherten Modus ausgeführt.

Testweise wurde aber auch beim AM4/AM5 DDU im abgesicherten Modus nochmals nachträglich ausgeführt.

= Installiert ist hierbei bei allen die 24.5.1

(u.a. auch wegen der letzten Sicherheitsupdates; welche man im englischsprachigen Changelog findet).

Die jeweiligen Systeme sind jeweils maximal 1x per HDMI angeschlossen:

Es handelt sich also in keinem der Fälle um ein Multi-Monitor-Setup.

Wo es möglich war (etwa beim OLED42C37LA; wurde FreeSync aktiviert jedoch wurden die FPS per Chill auf 61/62 begrenzt).

Bei den 2 anderen Systemen:

LG 32UN659P-W (Monitor; mit 60hz max, Standartprofil)

LG 43QNED765RA (TV mit 60hz max; im LG HomeHub ist dieser aber wie o.g. OLed als "PC" definiert und die Einstellung "Spiele" ausgewählt)

Firmware-Updates (WebOs); bei den 2 Geräten wo es ging sind ebenfalls auf aktuellsten Stand.

Ein Austausch der bisherigen 2.1 Kabel zu einen anderen Premium-Hersteller, blieb wie erwartet ohne Veränderung.

Profil:

3840x2160@60Hz bzw. 59,94hz, auf

8Bit begrenzt

FreeSync An beim OLed (bzw. bei den 2 anderen Geräten nicht vorhanden)

VSync bzw. auf Vertikalen Neuaufbau warten: An

RGB 4:4:4 Pixel Format PC-Standard

HDR ist im Windows-Betrieb inaktiv geschaltet. Ebenso das 10Bit Pixelformat; welches wiederum auf 8Bit begrenzt worden ist.

GPU Skalierung ist angeschaltet (zeigte jedoch auch auf Aus) und der nachträglichen Übernahme in den Windows-Einstellungen keine Unterschiede im Verbrauch.

Versuche:

Ein Heruntersetzen der HZ Zahl auf 59Hz bzw. testweise 50HZ, ggf. eine niedrigere HZ Zahl blieb ohne Erfolg.

Mehrere Versuche in Windows > System > Bildschirm > Grafik > Benutzerdefinierte Optionen mit "Energiesparmodus" nachträglich zu triggern blieben ohne Veränderung.

Eine benutzerdefinierte Auflösung zu erstellen:

Mit den Timing Standard: CVT, ggf. CVT verringerte Auslastung + Übernahme in den Windows-Einstellungen brachte keine Veränderung. Die Übernahme der neuen Settings in den Windows-Einstellungen wurde zu keiner Zeit vergessen und manuell per Auswahl übernommen.

CRU (im administrativen Modus ausgeführt) mit einer Clock-Rate von 90, testweise 150 bzw. maximal 200 verändern nichts am Grundverbrauch. Die Idle-Werte bleiben mehr oder weniger identisch. (auch nach Neustart des Treibers über reset64)

Radeon ReLive ist grundsätzlich deaktiviert.

Auto-HDR ebenso.

Die Metrik-Einstellungen (Sampling Intervall) sind auf Treiber Standard belassen worden.

Der Shader-Cache wurde versuchsweise ebenfalls zurückgesetzt.

Auffällig ist das vor allem bei RX 570 Polaris, bzw. der kleinstem RDNA3 (7600). Jene haben sich bezüglich des IDLE Verbrauchs in der Vergangenheit bisher noch am genügsamsten verhalten, schlagen inzwischen doch sehr stark aus.

Die 7700 XT ist da nochmal eine andere Ausnahme; zumindest in meinem Fall.

Beispiel:

6700 XT (nicht mehr vorhanden, hier berufe ich mich darauf was mir meine Erinnerung sagt) & der noch vorhandenen RX 7600.

Im Windows Betrieb (und ohne Fensterbewegung) bin ich damals bei beiden Grafikkarten seltenst über die 14 Watt hinausgekommen. 8 Watt waren hierbei eher Alltag.

Inzwischen & vor allem mit den aktuellsten Treibern aus diesem Jahr; muss sich das m.M.n. irgendwann verschlechtert haben.

33-35 Watt Idle ist und war bei beiden Karten bei mir zuletzt das absolut messbare Minimum. In YT (SDR) geht dies teilweise auf beiden Karten bis auf 55- maximal 60 Watt hoch. Während dies bei der 6700 XT im August(?) 2023 maximal 30 Watt betragen hat, bzw. bei der 7600 irgendwas (laut meiner Erinnerung) um die 20-22 Watt gewesen sein müssten.

Jenes ist gegensätzlich dem entgegengesetzt,

was damals CB in ihren Test gemessen hat und dem was ich gleichzeitig aus August(?) 2023 mehr oder weniger laut meiner Erinnerung noch im Gedächtnis habe.

Die RX570, welche laut Test:

https://www.computerbase.de/artikel/grafikkarten/radeon-rx-580-570-test.59085/

bei mir ebenfalls vorher zwischen 8-14 vor sich hindümpelte; powert nun in der Regel zwischen 32-35 Watt im IDLE rum. In YT 4K; SDR knallt diese locker auf 40 Watt hoch; während es vorher "nur" ca. 30 Watt waren. 60 Watt sind diesbezüglich (siehe späteren Post) wiederum aber leider auch keine Ausnahme mehr.

Die 7700 XT, welche laut Test:

https://www.computerbase.de/artikel...nitt_leistungsaufnahme_spiele_youtube_desktop

Idle ca 12 Watt verbrauchen sollte, bekomme ich erst gar nicht mehr unter 22Watt. Die 22 Watt sind dabei eher die Ausnahme. In der Regel verbleibt dabei viel lieber auf ca. 40 Watt (ohne Fensterbewegung).

Anderseits geht diese in SDR YT aber auch nicht über die 40 Watt (*siehe Nachtrag/Korrektur; inzwischen sind es bei mir leider ebenfalls bis zu 60 Watt).

Persönlicher Eindruck:

Was halt sehr für auffällig für mich ist, ist der Standpunkt das ich die damals von CB gemessenen Werte; welche ich selbst auf meinen Systemen bisher problemlos nachverfolgen konnte - inzwischen nicht mehr gibt. Auf keinen meiner Systeme komm ich an jene damaligen Werte auch nur im Ansatz heran.

Zwischendurch gab es zwar anscheinend Verbesserungen, seitens AMD am IDLE Verbrauch; u.a. hier erwähnt:

https://www.computerbase.de/news/gr...t-erneut-den-desktop-stromverbrauch-an.85231/

- nur merke ich diese leider nicht. Bzw. nicht mehr(?).

In all meinen Fällen, bleibt der IDLE-Verbrauch bei sich allen 3 noch im Besitz findenden AMD Grafikkarten eindeutig zu hoch.

Ob es jetzt dieser Fehler an mir liegt oder meinen Setups (ist höchstwahrscheinlich das Naheliegendste), oder ob dies ggf. an Windows oder AMD liegt, kann ich daher nicht mehr so richtig ausmachen. Diverse möglichen Fehlerbehebungen auf YT :

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

oder die im CB-Forum empfohlene Möglichkeiten;

siehe Thread: https://www.computerbase.de/forum/threads/neue-rx7900-xt-hohe-leistungsaufnahme-im-idle.2133974/) brachten mir absolut keine Veränderung.

Irgendwie mit meinen "Latein" am Ende.

Daher möchte ich gerne nachfragen:

1.) Hättet ihr noch andere Tipps, die man versuchen könnte (ohne jetzt in ggf. in CRU rumfummeln zu müssen)?

2.a) Wie sind diesbezüglich eure aktuellen Erfahrungen?

2.b) Habt ihr ggf. die selben Beobachtung machen können (vor allem mit einen der letzten Treiber aus 2024)?

PS:

An der Stelle möchte ich jetzt ungern wegen "10-20 Watt mehr" (und den paar Cents/Euros im Jahr) ´rumheulen´; anderseits möchte ich gerne eine Ersparnis mitnehmen. Sofern sie denn vorhanden ist & möglich sein sollte.

Vor allem bei der Polaris, ggf. der RDNA3 "ärgert" es mich doch ein bisschen, das der Verbrauch inzwischen(?) höher ist, als das was CB offiziell bzw. ich damals bzw. im gleichen Fall für mich heute selbst nachträglich messen konnte.

Das die kleinste RDNA3 (7600) nun auch nicht mehr so sparsam läuft - wie dies evtl. im letzten Test der Fall war - ärgert mich. 33 statt 8 Watt, empfinde ich dann doch leider als zu starke Verschlechterung.

Das RDNA 3 als Mittelklasse (im Fall der 7700 XT) ausschlägt, empfinde ich zwar ebenso als absolut nervig; jedoch war in meinem Fall der IDLE-Verbrauch noch nie gut; weswegen ich mich an diesen Umstand mehr oder weniger gewöhnt habe. Trotzdem würde ich mir natürlich gerne eine Lösung herbeiwünschen, welche dies auf die im CB-Test veranschlagten 12 Watt drückt. 60 Watt für YT (7700XT) - während eine Mittelklasse im System werkelt - erscheint mir auch etwas zu hoch.

Das Polaris hier ebenso "austickt"; verwundert mich um einiges mehr.

Anhänge

Zuletzt bearbeitet von einem Moderator:

(Kleine Anpassungen, da RDNA2 (6700 XT) nicht mehr vorhanden)