- Registriert

- Jan. 2020

- Beiträge

- 724

Ja, vermutlich bin ich an die Board-Wahl ein wenig naiv/uninformiert herangegangen.TheHille schrieb:Hm, bei Gigabyte schallert es mir immer etwas im Ohr mit der Linux-Kompatibilität...

Nordwind2000 schrieb:Mit meinem B650 von Gigabyte / Aorus hab ich so keine Probleme... Egal ob OpenSuse Tumbleweed, Fedora 41, Debian 12 oder Ubuntu 24.04.1... Der Verbauch von der CPU deckt sich zu 98% gegenüber Windows.

Sobald der PC fertig optimiert/eingerichtet ist, lege ich auch keinen Wert mehr auf das Auslesen von Lüftergeschwindigkeiten/Spannungen etc. im laufenden Betrieb. Doch während des Tunings hätte ich schon gern die Möglichkeit dazu, relevante Werte zumindest auslesen zu können. Aber das ist bei Gigabyte on Linux echt frickelig.SavageSkull schrieb:Allerdings weiß ich auch nicht, was ihr mit "Linux-Kompatibilität" meint.

Ich stelle Spannungen und Takt im UEFI ein, Lüfterkurve im UEFI und das OS hat mit alledem nichts am Hut.

SavageSkull schrieb:Auch wenn die ~10W zu hoch angesetzt sind, sind 2,2W für das gesamte Notebook (samt Tischnetzteil) schon extrem wenig.

Nein & nein. Lenovo bietet ein Low-Power-Display für die Thinkpads an.SavageSkull schrieb:Wenn du das Komma um eins nach rechts verschiebst wird das glaubwürdig.

Allein ein 14" Display braucht auf niedriger Helligkeit für sich schon ~10W.

Wie ich schon schrieb, ließ ich den Laptop mit aktiviertem Display&WLAN im Leerlauf stehen und kam auf annähernd 24h Laufzeit, bevor sich der Laptop in den Standby verabschiedete. Bei einer Akkukapazität von 57 Wh kannst Du Dir ausrechnen, dass das bei "Komma nach rechts verschieben" nicht möglich gewesen wäre.

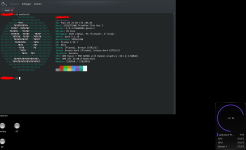

Angehangen noch ein frischer Screenshot, den ich vorhin erstellt habe (der Laptop war zu dem Zeitpunkt etwa 15 Minuten im Leerlauf; WLAN aktiviert, Bildschirm auf niedrigster Stufe). Rechts unten im Screenshot ist ein Systemmonitor - dort sieht man den (errechneten) Systemverbrauch. Ja, ich weiß, das ist nicht akkurat, weil der Wert lediglich aufgrund von Spannungsänderungen des Akkus berechnet wird, aber er ist mir genau genug und deckt sich auch mit dem angesprochenen 24h-Laufzeittest. Der angegebene Verbrauch von 2,2 Watt (bzw. aktuell sogar nur 2,1 Watt) bezieht sich demnach auf "Systemverbrauch ohne Netzteil".

Das originale Netzteil von Lenovo ist mir übrigens zu klobig und liegt bis heute gänzlich ungenutzt in der Verpackung. Unterwegs nutze ich ein 65W-GAN-Netzteil, am Arbeitsplatz tut es ein fest verbautes 35W-GAN-Netzteil, mit dem ich sämtliche Peripherie (Maus, Tastattur, Smartphone, ReMarkable, Kopfhörer) auch lade. Wie effizient die beiden Netzteile sind und ob das originale Netzteil des Laptops besser wär, habe ich bisher nicht gemessen.

Ich sag mal so: Mein System habe ich so auf- und umgebaut, dass ich relativ problemlos die Distro wechseln und binnen 1-2h wieder produktiv sein könnte.SavageSkull schrieb:Wenn du doch vorrangig auf dem PC arbeitest, wäre das sicher nicht meine erste Wahl. Du weist nicht wie sich das weiter entwickelt und die Anpassungen bringen dir effektiv nichts.

Gründe für Nobara waren damals auch OBS Studio (Aufzeichnung von Video-Konferenzen/-Meetings) und Steam (auch wenn ich nicht oft spiele, aber hin und wieder will ich's eben doch). Das mag bei vielen anderen Distros auch problemlos möglich sein, aber bei Nobare waren das One-Click-Installationen, die sofort liefen. Ich will jetzt keine Formatdiskussion beginnen und es hat auch wenig mit Nobara zu tun, aber Live-Video-Encoding mit AV1 bei ~1% zusätzlicher Systemlast ist dank Hardware-Unterstützung des 8700G schon ziemlich nett

Würde ich mit dem heutigen Wissen erneut zu Nobara greifen? Vermutlich nicht. Aber so lange es mir keine Probleme bereitet, bleibe ich dabei.

Alles, was ich mache, könnte ich prinzipiell auch auf dem Laptop machen, das stimmt. Aber wie ich schon sagte, nervt es mich, wenn ich von Lüftergeräuschen umgeben bin. Mein Laptop dient mir mehr oder weniger als Backup-Lösung oder wenn ich mal von unterwegs aus arbeiten muss.SavageSkull schrieb:Andere haben ja schon das Beispiel gebracht, eher auf dem Notebook zu arbeiten. Ich selbst hätte wohl zwei Systeme parallel genutzt und deinen 5900X als Basis behalten, auch um Produktiv und Privat besser zu trennen.

Eine strikte Trennung zwischen beruflichen und privaten IT-Tätigkeiten gibt es bei mir nicht - teilweise überschneiden sich die Projekte sogar. Für mich wäre es völlig absurd, die Geräte zu wechseln, obowhl ich gleiche Tätigkeiten mache.

Die GTX 1660Super besitze ich nicht mehr. Ich hab' noch eine 1050Ti als Backup hier rumliegen, aber den Stress mit NVidia gebe ich mir nicht, nur um mal schnell was zu testen... sorry!Grumgum schrieb:Würdest du auch nochmal deine Graka mit einbauen und deinen Monitor über iGPU laufen lassen um mal zu testen wie smooth AMD CPUs zwischen iGPU und dedizierter GraKa switchen können unter Lastszenarien?

Glücklicherweise haben andere Personen aus dem Forum hier bereits Erfahrungswerte

Das ist Dein gutes Recht und verbietet Dir auch niemand. Ich habe jedoch eben genau nach dem Kompromiss gesucht und ihn mit dem 8700G gefunden.opoderoso schrieb:Dann geh ich lieber zu 100% auf Effizienz

Es gibt ein recht günstiges ASRock-Board mit B650-Chipsatz, das vergleichsweise sehr sparsam sein soll. Hätte ich das Board damals schon gekannt, hätte ich mir das vermutlich anstatt des Gigabyte-Boards zugelegt.Nitschi66 schrieb:Ein b650 ist nicht zum sparen da.

Ich habe GPT4All sowie Fooocus auf meinem System installiert. Ok, für die Bildgenerierung braucht es ca. 2 Minuten pro Bild (bei 30 Iterationen), aber der Chat mit 4GB-Modellen läuft flüssig.oicfar schrieb:Ich habe die 5700G und habe wg. KI doch noch eine GraKa eingebaut.