- Registriert

- Mai 2010

- Beiträge

- 2.916

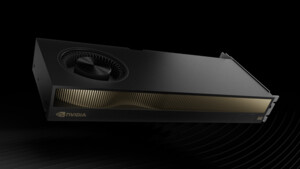

Wenn das wie auf den obigen Bilder ausgeführt ist, wird hier doch lediglich der GPU-Kern und die Kartenrückseite gekühlt (wo bei der RTX3090 dort ja z.B. wenigstens noch VRAM-Module waren). Auf der 4080-Platine ist rückseitig rein garnichts verbaut, das gekühlt werden muss... VRAM, Mosfets und Spannungswandler liegen allesamt frei und sterben den Hitzetod.

Deine Logging-Tools (welche auch immer du benutzt hast) lesen wahrscheinlich nur die GPU-CoreTemp aus.

Die mag eventuell auch noch passen. Aber ein GDDR6X-Modul ohne jegliche Kühlung ist sofort auf 105°C und dann schaltet die Karte halt ab (Selbst-Schutz).

Eine RTX4080 hat 320W und die nimmt sie sich im Benchmark auch...

Somit hat allein die GPU in etwa die Leistungsaufnahme des kompletten vorherigen Systems.

Vor allem wenn die Kühlung so schlecht ist.

Höhere Temps = mehr Verbrauch.

Deine Logging-Tools (welche auch immer du benutzt hast) lesen wahrscheinlich nur die GPU-CoreTemp aus.

Die mag eventuell auch noch passen. Aber ein GDDR6X-Modul ohne jegliche Kühlung ist sofort auf 105°C und dann schaltet die Karte halt ab (Selbst-Schutz).

Ja und eine GTX1080 hatte 180W TDP max. (die sie auch nur selten gezogen hat).leistiko schrieb:läuft selbst mit nVidia1080 und i7 auch im Sommer bei 30 Grad absolut sauber.

Eine RTX4080 hat 320W und die nimmt sie sich im Benchmark auch...

Somit hat allein die GPU in etwa die Leistungsaufnahme des kompletten vorherigen Systems.

Vor allem wenn die Kühlung so schlecht ist.

Höhere Temps = mehr Verbrauch.

Zuletzt bearbeitet: