ScOuRgE_

Ensign

- Registriert

- Mai 2006

- Beiträge

- 195

Intels Vorsprung gegenüber der Konkurrenz lässt sich primär damit erklären, dass sie den FinFET entwickelt haben. Dadurch lässt sich die Streuung der Dotierstoffatome während der Ionenimplantation gut kompensieren, weil beim FinFET die beweglichen Ladungsträger nur noch aus der Drain-u Sourceelektrode stammen. Die Schwellenspannung wird also nicht durch die Kanaldotierung bestimmt, sondern durch die resultierende Austrittsarbeit von den Elektroden zum Kanal. Dadurch haben sie die Streuung der Transistorparameter so gut in den Griff bekommen, dass sie 22nm sehr gut wirtschaftlich fertigen konnten. Die Konkurrenz holt das jetzt auf und danach fehlt Intel ein derart technologischer Vorsprung.

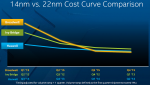

Nein, das ist nicht zu einfach gedacht, denn von 22nm FinFET auf 14nm FinFET findet lediglich eine andere Lithographie statt und evtl. kommen andere low-k Dielektrika im Spin-On statt im CVD in den Metallisierungsebenen zum Einsatz. Ansonsten sind die Prozesse gleich, lediglich die Ausbeute sinkt, weil die Prozessführung genauer sein muss und die Streueffekte zunehmen. Da liegt eher das Problem. Abgesehen davon sind die Waferkosten durchaus zu berücksichtigen, denn SOI-Wafer kosten ein Vielfaches mehr als Bulk-Wafer. Wenn Sie zur Abwechslung aber gerne mal mit Wissen und nicht mit Halbwissen glänzen wollen, kann ich Ihnen nur wärmstens das Buch von meinem Prof empfehlen:

Silizium-Halbleitertechnologie

@strexstrex schrieb:Zitat entfernt

Nein, das ist nicht zu einfach gedacht, denn von 22nm FinFET auf 14nm FinFET findet lediglich eine andere Lithographie statt und evtl. kommen andere low-k Dielektrika im Spin-On statt im CVD in den Metallisierungsebenen zum Einsatz. Ansonsten sind die Prozesse gleich, lediglich die Ausbeute sinkt, weil die Prozessführung genauer sein muss und die Streueffekte zunehmen. Da liegt eher das Problem. Abgesehen davon sind die Waferkosten durchaus zu berücksichtigen, denn SOI-Wafer kosten ein Vielfaches mehr als Bulk-Wafer. Wenn Sie zur Abwechslung aber gerne mal mit Wissen und nicht mit Halbwissen glänzen wollen, kann ich Ihnen nur wärmstens das Buch von meinem Prof empfehlen:

Silizium-Halbleitertechnologie

Zuletzt bearbeitet von einem Moderator:

(Zitat entfernt)