Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Quartalszahlen: AMD kann nicht von Nvidias GTX-970-Debakel profitieren

- Ersteller Volker

- Erstellt am

- Zur News: Quartalszahlen: AMD kann nicht von Nvidias GTX-970-Debakel profitieren

J

johnniedelta

Gast

Wo sind die AMD-Treiber denn bitte scheiße? Und wenn du dir mal z. B. Ubisoft ansiehst, kann man kaum eine Bevorzugung Nvidias leugnen, um nur ein Beispiel zu nennen. Das die Branche durchaus Absprachen kennt und mitunter kartellartige Strukturen aufweist,Tallantis schrieb:Unfug, AMD hat sich eigentlich viele Partner gesichert vor allem SquareEnix ist sehr groß mit AMD. Die Treiber von AMD sind immernoch genauso scheiße wie immer und können oft den technologischen Vorteil nur bei absurd hohen Einstellungen zeigen. Für Otto Normal Spieler ist nvidia einfach besser. Aktuell haben sie einfach gepennt was nvidia angeht und versuchen mit der LastGen irgendwie mitzuhalten obwohl sie einfach nachziehen müssen.

ist nur meine subjektive Meinung, aber widerleg das erstmal. Als Unfug würde ich das aber keineswegs bezeichnen.

Und ob AMD gepennt haben, da lass uns nochmal nach der Vorstellung der neuen Karten drüber reden...

Sie hinken nur zeitlich etwas, falls du das meinst, aber technologisch, das denke ich nicht.

Lisa Su ist zwar erst seit Kurzem dabei aber mir scheint es so, als ob sie keine richtige Vision für das Unternehmen hat. Wo sieht sie AMD in der Zukunft? Cloudcomputing, Microserver, mobile Anwendungen etc. sind doch ein weiterhin wachsender Markt, weniger die High-End-GPU oder CPU.

Den Titel der News finde ich sehr unglücklich gewählt. Das ist kurzsichtig und doch nur ein kleiner Teil von AMD.

Den Titel der News finde ich sehr unglücklich gewählt. Das ist kurzsichtig und doch nur ein kleiner Teil von AMD.

@fandre, also eine Vision wie damals Tom Cook mit Apple hatte, die dürfte so ziemlich die größte Erfolgsstory in der Geschichte gewesen sein, zumindest für lange Zeit erstmal.

-AMD mit Ihren kleinen Budget können erstmal nur kleine Ziele verfolgen, und vor allem müssen die erstmal die angefangenen zu Ende bringen. CPUs/GPUs haben haben immer noch gute Zukunft, auch wenn die größte x86 Zeit wohl vorbei zu sein scheint. AMD hat im Vergleich zu Intel einen sehr geringen % Anteil an verkauften CPUs, somit wäre da noch eine Menge drin, sollte AMD hier mal wieder so ein Erfolgsdesign gelingen wie damals mit Ihren 64bit CPUs.

-Und so abgeschlagen ist AMD auch wieder nicht mit Ihren Bulldozer bzw. Steamroller CPUs. Sollte hier mit der Zen CPU nochmals gelingen sich zurück zu Melden, dann wäre man wieder plötzlich voll dabei. -Gleichzeitig auch bei den Server CPUs.

-AMDs Carrizo liegt im Plan und wird bereits ausgeliefert (man muß mal auch das positive sehen), immerhin soll die APU bis zu 40% effizienter werden (natürlich mit Vorsicht zu Betrachten) , wenn da 20-30% davon bleiben, bin ich auf jeden Fall schon mal begeistert (da altes Herstellungsverfahren 28nm), das wäre schon echt klasse, und vor allem sehr günstig in der Herstellung.

-GPUs reichen für Full HD mittlerweile aus, aber UHD ist immer mehr im kommen (auch wenn dieser Markt noch für die meisten von uns uninteressant ist, da schlicht zu teuer der "Spaß" und sehr starke GPUs quasi jetzt schon am Limit laufen bei UHD, also quasi noch nicht das Wahre ist. -Erst die kommenden Gen GPUs werden soweit wohl sein.

-Vor allem ist es erstmal wichtig wie HBM Speicher sein wird, auch in der Herstellung, und wie GF die neue Fertigung der GPUs hinbekommt (zum ersten mal in der Geschichte wird Nvidia bei TSMC herstellen lassen, AMD bei GF (früher immer beide bei TSMC)

-Bald werden von GF die feineren Herstellungsverfahren 20nm und 14nm so weit sein um die Massenfertigung auch für AMD zu starten. -Hoffentlich klappt es reibungslos, da AMD weniger Einfluss drauf hat als in der Vergangenheit (mit eigenen Werken noch).

-Und was allgemein die Visionen zwischen allen 3 Big Playern angeht (ja zähle AMD dazu ) , sind die anderen auch nicht besser. -Im Gegenteil, AMD hat sich viel mehr bewegt als die anderen, auch wenn Sie dafür noch nicht belohnt worden sind, eher nur zum Teil (Konsolen)

) , sind die anderen auch nicht besser. -Im Gegenteil, AMD hat sich viel mehr bewegt als die anderen, auch wenn Sie dafür noch nicht belohnt worden sind, eher nur zum Teil (Konsolen)

LG

-AMD mit Ihren kleinen Budget können erstmal nur kleine Ziele verfolgen, und vor allem müssen die erstmal die angefangenen zu Ende bringen. CPUs/GPUs haben haben immer noch gute Zukunft, auch wenn die größte x86 Zeit wohl vorbei zu sein scheint. AMD hat im Vergleich zu Intel einen sehr geringen % Anteil an verkauften CPUs, somit wäre da noch eine Menge drin, sollte AMD hier mal wieder so ein Erfolgsdesign gelingen wie damals mit Ihren 64bit CPUs.

-Und so abgeschlagen ist AMD auch wieder nicht mit Ihren Bulldozer bzw. Steamroller CPUs. Sollte hier mit der Zen CPU nochmals gelingen sich zurück zu Melden, dann wäre man wieder plötzlich voll dabei. -Gleichzeitig auch bei den Server CPUs.

-AMDs Carrizo liegt im Plan und wird bereits ausgeliefert (man muß mal auch das positive sehen), immerhin soll die APU bis zu 40% effizienter werden (natürlich mit Vorsicht zu Betrachten) , wenn da 20-30% davon bleiben, bin ich auf jeden Fall schon mal begeistert (da altes Herstellungsverfahren 28nm), das wäre schon echt klasse, und vor allem sehr günstig in der Herstellung.

-GPUs reichen für Full HD mittlerweile aus, aber UHD ist immer mehr im kommen (auch wenn dieser Markt noch für die meisten von uns uninteressant ist, da schlicht zu teuer der "Spaß" und sehr starke GPUs quasi jetzt schon am Limit laufen bei UHD, also quasi noch nicht das Wahre ist. -Erst die kommenden Gen GPUs werden soweit wohl sein.

-Vor allem ist es erstmal wichtig wie HBM Speicher sein wird, auch in der Herstellung, und wie GF die neue Fertigung der GPUs hinbekommt (zum ersten mal in der Geschichte wird Nvidia bei TSMC herstellen lassen, AMD bei GF (früher immer beide bei TSMC)

-Bald werden von GF die feineren Herstellungsverfahren 20nm und 14nm so weit sein um die Massenfertigung auch für AMD zu starten. -Hoffentlich klappt es reibungslos, da AMD weniger Einfluss drauf hat als in der Vergangenheit (mit eigenen Werken noch).

-Und was allgemein die Visionen zwischen allen 3 Big Playern angeht (ja zähle AMD dazu

LG

cele

Lieutenant

- Registriert

- Jan. 2015

- Beiträge

- 671

das werden Intel und Nvidia zu verhindern wissen.

Ansonsten drohen in der EU und anderswo dicke Probleme mit der Kartellaufsicht.

Und das, nämlich eine Zerschlagung, ist weit schlimmer als ein kleiner Konkurrent, der sich ein paar Prozent Marktanteil nimmt.

Ansonsten drohen in der EU und anderswo dicke Probleme mit der Kartellaufsicht.

Und das, nämlich eine Zerschlagung, ist weit schlimmer als ein kleiner Konkurrent, der sich ein paar Prozent Marktanteil nimmt.

sunnyday schrieb:Was ist wenn alle Mantle nutzen. AMDs Schuld? ne, nicht nur.

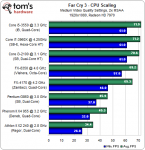

AMD hat sich von aktiven Mantle Support so wie ich es Verstanden habe, etwas zurück genommen. Nicht im negativen Sinne, Microsoft hat nämlich angefangen Ihre Arbeit wieder zu Machen (ist eigentl. auch deren Aufgabe, für bessere CPU Auslastung bzw. Core Arbeitsverteilung zu Sorgen). AMD hat nur für den "Schubser" gesorgt. Dann bleiben uns hoffentlich Benchmarks wie diese hier in Zukunft erspart:

Man beachte dabei dass eine i3@3.1 Ghz CPU so schnell ist in etwa wie eine i7 3960X@4.1 Ghz ist

-Davon dürften auch die FX CPUs einen neuen Frühling Erfahren, aber auch die i5/i7 CPUs, sprich, wir alle hätten wieder was davon. Von mir aus kann DirectX 12 schon am besten Morgen kommen.

-Man beachte dass quasi das kleine AMD dafür Sorgen musste, dass das so große Microsoft wieder auch Menschen neue Anreize gibt, Ihr kommendes Betriebssystem schmackhafter zu Machen.

Zuletzt bearbeitet:

chancaine

Captain

- Registriert

- Feb. 2006

- Beiträge

- 3.174

Ich denke, dass AMD so ein bisschen das Looser-Image hat:

ihre CPUs sind nicht der Burner und sie bekommen die Dominanz von

Intel einfach nicht wirklich in den Griff und die GPUs sind auch etwas weniger gut

in Sachen Stromverbrauch und Lautstärke. Da fällt es einem schon schwer, trotz

dem 970er Debakel freiwillig AMD zu kaufen. Ich setze auch lieber auf eine GTX970,

die weniger Strom verbraucht, leiser ist und mehr Leistung bringt, als (preislich)

vergleichbare Karten von AMD.

Schade, zu Zeiten von ATi hätte ich diese immer genommen.

ihre CPUs sind nicht der Burner und sie bekommen die Dominanz von

Intel einfach nicht wirklich in den Griff und die GPUs sind auch etwas weniger gut

in Sachen Stromverbrauch und Lautstärke. Da fällt es einem schon schwer, trotz

dem 970er Debakel freiwillig AMD zu kaufen. Ich setze auch lieber auf eine GTX970,

die weniger Strom verbraucht, leiser ist und mehr Leistung bringt, als (preislich)

vergleichbare Karten von AMD.

Schade, zu Zeiten von ATi hätte ich diese immer genommen.

Naja AMD hat es nicht verpennt, kam doch wieder so ein "Fixer" Video und sonstige Tweets zum 3.5G Debakel.

Aber solang AMD auch keine gescheiten Grakas raus bringt, welche nicht in jedem neuen Spiel am flackern sind wie die Irren werde ich auch keine mehr kaufen.

Und ich glaub die meisten die Nvidia haben, lieben den durchgehend stabilen und vielfältigen Treibersupport welcher bei AMD so in diesen Maßen schlicht und ergreifend nicht vorhanden ist, weil dafür auch keiner zahlt.

Wenn DirectX12 meinen FX 8350 nicht ordentlich treten wird, dann hab ich auch keine AMD CPU mehr im Rechner, da hängt schon der nächste Flop.

Dazu kommen noch ziemlich schlechte OC Ergebnisse von denen man relativ wenig merkt, außer dass man nach 2 Stunden in einem Zimmer mit ner AMD CPU das schwitzen anfängt.

Aber solang AMD auch keine gescheiten Grakas raus bringt, welche nicht in jedem neuen Spiel am flackern sind wie die Irren werde ich auch keine mehr kaufen.

Und ich glaub die meisten die Nvidia haben, lieben den durchgehend stabilen und vielfältigen Treibersupport welcher bei AMD so in diesen Maßen schlicht und ergreifend nicht vorhanden ist, weil dafür auch keiner zahlt.

Wenn DirectX12 meinen FX 8350 nicht ordentlich treten wird, dann hab ich auch keine AMD CPU mehr im Rechner, da hängt schon der nächste Flop.

Dazu kommen noch ziemlich schlechte OC Ergebnisse von denen man relativ wenig merkt, außer dass man nach 2 Stunden in einem Zimmer mit ner AMD CPU das schwitzen anfängt.

Zuletzt bearbeitet:

eax1990 schrieb:Und ich glaub die meisten die Nvidia haben, lieben den durchgehend stabilen und vielfältigen Treibersupport welcher bei AMD so in diesen Maßen schlicht und ergreifend nicht vorhanden ist, weil dafür auch keiner zahlt.

http://www.heise.de/newsticker/meld...artentreiber-320-18-haeufen-sich-1887422.html

Genau, so irgendwie in der Art muß es wohl sein, warum Nvidia Treiber immer stabil sind und man als Nvidia Jünger sich immer drauf verlassen kann...

oder so:

http://www.winboard.org/software-al...-89-macht-erhebliche-probleme-bluescreen.html

Oder am Besten ein Nvidia Treiber der das Problem ganz von alleine Löst und dank des so tollen Super-Duper Nvidia Treibers die GPU zum Schmelzen bringt und somit sich alles weitere erübrigt.

http://www.golem.de/1003/73647.html

Offensichtlich schaft Nvidia aber eins: Die Leute vor lauter grünen Star Erblinden zu lassen und über vieles hin weg Sehen zu können, ohne dass die Patienten es selbst Merken.

So auch bei dir, und man "vergisst" sogar dass man beim GTX 970 Kauf um den VRam beschissen worden ist, Hut ab.

eax1990 schrieb:Wenn DirectX12 meinen FX 8350 nicht ordentlich treten wird, dann hab ich auch keine AMD CPU mehr im Rechner, da hängt schon der nächste Flop.

Dazu kommen noch ziemlich schlechte OC Ergebnisse von denen man relativ wenig merkt, außer dass man nach 2 Stunden in einem Zimmer mit ner AMD CPU das schwitzen anfängt.

-Dass du auch keine bessere Leistung durch OC beim FX 8350 merkst, wundert mich auch nicht mehr, wie denn auch?

Zuletzt bearbeitet:

Marcel55

Fleet Admiral

- Registriert

- Nov. 2007

- Beiträge

- 18.725

Das ist ein verbreitetes Gerücht. Der Stromverbrauch ist zwar etwas höher, das rechnet sich aber erst nach tausenden Spielstunden, und die Lautstärke haben die Tri-X Karten von Sapphire sehr gut im Griff.chancaine schrieb:GPUs sind auch etwas weniger gut

in Sachen Stromverbrauch und Lautstärke.

Ich nutze sie jetzt seit 2 Tagen und bin erstaunt wie leise sie ist, meine Palit Jetstream GTX970 war gefühlt lauter, u.a. auch weil sie ein viel nervigeres Lüftergeräusch hat. Während bei der Palit ein Jet neben dir abhebt summt die Tri-X leise vor sich hin. Dabei ist die Palit gemessen vielleicht leiser, aber diese habe ich doch recht deutlich aus dem System rausgehört.

Die MSI macht da natürlich noch einiges besser.

Da ich nicht mehr warten wollte, war die 290 als Zwischenlösung geplant, ich dachte mir ein paar Monate komme ich schon mit der hohen Lautstärke aus...da wurde ich mehr als positiv überrascht.

Die Hawaii-GPUs sind defintiv besser als ihr Ruf. Diesen wiederum hat AMD dank des grandiosen Referenzkühlers geschaffen

Keine Ahnung was denen eingefallen ist die Karte damit auf den markt zu werfen. Sapphire hat es jedenfalls geschafft da einen sehr guten Kühler draufzusetzen.

Leider sind die Preise dank des Euro-Kurses gerade recht hoch, was den Kauf von Grakas generell recht unakttraktiv macht...an die 400€ für ne GTX970, die haben doch ein Rad ab. Ich bin mal gespannt wie sich der Trend in Zukunft entwickeln wird. Kann ja nicht sein dass man bald mehr als 500€ für ne Grafikkarte ausgeben darf, die was taugt...

soweit ich weiß ist die GTX970 kein Debakel sondern eher ein Kassenschlager! also wenn CB meint alla derart Bild-Zeitungsstil Titelthemen zu bringen kann das auf jedenfall nicht förderlich sein. naja ich will nicht zu kleinkariert sein. die Thematik ist klar und muss angesprochen werden! Die GTX 970 ist einfach eine sehr gute Grafikkarte und diese kleine Einbuße ist minimal im Verhältnis zum Großen und Ganzen was man mit der Karte letztendlich bekommt!

Nicht verwunderlich das sie kein Debakel ist sondern eher ein Kassenschlager!

AMD könnte wenn dann nur profitieren wenn sie Ihre Alternativen jetzt vorlegen würden und nicht erst im 2. Halbjahr...!

Nicht verwunderlich das sie kein Debakel ist sondern eher ein Kassenschlager!

AMD könnte wenn dann nur profitieren wenn sie Ihre Alternativen jetzt vorlegen würden und nicht erst im 2. Halbjahr...!

guru meditation

Lieutenant

- Registriert

- Apr. 2011

- Beiträge

- 1.000

phiber66 schrieb:soweit ich weiß ist die GTX970 kein Debakel sondern eher ein Kassenschlager! also wenn CB meint alla derart Bild-Zeitungsstil Titelthemen zu bringen kann das auf jedenfall nicht förderlich sein. naja ich will nicht zu kleinkariert sein. die Thematik ist klar und muss angesprochen werden! Die GTX 970 ist einfach eine sehr gute Grafikkarte und diese kleine Einbuße ist minimal im Verhältnis zum Großen und Ganzen was man mit der Karte letztendlich bekommt!

Nicht verwunderlich das sie kein Debakel ist sondern eher ein Kassenschlager!

AMD könnte wenn dann nur profitieren wenn sie Ihre Alternativen jetzt vorlegen würden und nicht erst im 2. Halbjahr...!

Fakt ist, dass die GTX 970 eine gute Grafikkarte ist. NVidia hat diese Karte eben beschnitten.

- ganz einfach deshalb, damit die GTX 980 zu einem hohen Preis verkauft werden kann

- ganz einfach deshalb, damit sich Käufer der GTX 780ti nicht veräppelt vorkommen, die ist auch klar besser.

- ganz einfach deshalb, weil AMD keine wirklich moderne GPU bieten kann.

NVidia hat mit Kepler und Maxwell innerhalb kurzer Zeit GPU-Architekturen geliefert, welche dem Zeitgeist entsprechen, und hat das gut umgesetzt.

Mantle war von AMD ein guter Ansatz, konnte aber wegen der über Jahre angespannten finanziellen Situation nicht zufriedenstellend umgesetzt werden.

NVidia hat mit der Optimierung seiner Treiber @DX11 gut dagegen halten können.

AMD musste jetzt zwei APIs optimieren, Mantle und DX11. Der Aufwand war wohl zu groß, so ist der AMD-Vorteil verpufft.

Kleine Brötchen backen wäre für AMD vielleicht der bessere Ansatz gewesen. NVidia tut das ja auch - siehe die GTX 970 oder die GTX 960.

Weniger ist manchmal mehr.

Trotzdem ist es vollkommen richtig und im Sinne von uns allen, wenn NVidia mit der GTX 970 an den Pranger gestellt wird.

Die haben uns ganz schön hinters Licht geführt. Richtig ist auch, dass dies aufgedeckt wurde.

GPU-Reviews waren ja voll des Lobs, aber diesmal waren es die User die den Fake bemerkt haben.

Die GTX 970 ist immer noch ne gute Grafikkarte, aber trotzdem darf jeder, auch die CB-Redaktion, NVidia ne Klatsche geben.

chancaine

Captain

- Registriert

- Feb. 2006

- Beiträge

- 3.174

Das Debakel ist, dass Nvidia nicht selbst offensiv nach vorne gegangen ist, sondern sich von Tests diese Schwäche hat präsentieren lassen.

Die Gaming-Gemeinde hat das Thema dankend aufgenommen und es gibt mittlerweile ja jede Menge Beiträge dazu, wann es durchaus mal

limitierend sein kann - sicher, die meisten Szenarien wird man nicht haben. Dennoch haben sie sich nicht gerade mit Ruhm bekleckert.

Ob Nvidia jetzt die besseren Treiber hat, lasse ich jetzt mal offen, da hier augenscheinlich der eine oder andere Nvidia-Hater rum läuft und

in der Tat blind ist.

Fakt ist: der Stromverbrauch rechnet sich nicht erst in 1000 Jahren, sondern in jeder Minute, die der Rechner läuft, denn auch der Idle ist bei

vergleichbaren Karten von Nvidia geringer. Die Lautstärke ist durch verschiedene Tests nachgewiesenermaßen geringer, wenn man sich am

Referenzdesign orientiert und keine exotischen Layouts mit dem Referenzdesign Nvidias vergleicht.

Die Gaming-Gemeinde hat das Thema dankend aufgenommen und es gibt mittlerweile ja jede Menge Beiträge dazu, wann es durchaus mal

limitierend sein kann - sicher, die meisten Szenarien wird man nicht haben. Dennoch haben sie sich nicht gerade mit Ruhm bekleckert.

Ob Nvidia jetzt die besseren Treiber hat, lasse ich jetzt mal offen, da hier augenscheinlich der eine oder andere Nvidia-Hater rum läuft und

in der Tat blind ist.

Fakt ist: der Stromverbrauch rechnet sich nicht erst in 1000 Jahren, sondern in jeder Minute, die der Rechner läuft, denn auch der Idle ist bei

vergleichbaren Karten von Nvidia geringer. Die Lautstärke ist durch verschiedene Tests nachgewiesenermaßen geringer, wenn man sich am

Referenzdesign orientiert und keine exotischen Layouts mit dem Referenzdesign Nvidias vergleicht.

Fakt ist das der Stromverbrauch bei einem normalen Nutzer, und nein das sind keine 5-10h am Tag 100% Volllast zocken, relativ egal ist. Auch ist eine GPU nicht immer zu 100% ausgelastet. Dann auch noch mit TDPs argumentieren, die nvidia seien ja im Ref Design so sparsam, aber Gigabyte knallt das Powertarget samt Verbrauch hoch.

Ebenso dann die nvidia schön übertakten. Das dann der Verbrauch eben nicht mehr so toll da steht seitens nvidia ist plötzlich dann auch nicht mehr relevant.

Das ist ein vorgeschobenes Argument. Nichts weiter. Lautstärke wird auch gerne selektiv wahrgenommen, da wird die Lautstärke des Lüfters hochgelobt, Spulenfiepen ist dann aber wieder nicht relevant bzw es heißt das andere Dinge das übertönen...

Bzgl Treiber - was heißt nvidia Hater? Fakt ist das die Treiber sich nichts nehmen. Beide haben schon Murks geliefert, aber wenn man einigen "AMD Hatern" die nvidia Fehler präsentiert ist dies plötzlich nicht relevant.

Da werden dann wieder Gameworks Titel benannt, wo es nicht verwundert das nvidia besser da steht erstmal für 2-3 Wochen, wenn man die Konkurrenz erstmal zu Reverse Engineering zwingt, weil nvidia die Einsicht in GW verweigert.

Ich kann diese -teils maßlose- übertriebene negative Kritik an AMD und die dafür relativierenden Lobeshymnen auf nvidia nicht mehr hören...

Zuletzt bearbeitet:

chancaine

Captain

- Registriert

- Feb. 2006

- Beiträge

- 3.174

Kann ich so auch nachvollziehen. Allerdings lobt ja keiner Nvidia in den Himmel, wenn man AMD kritisiert.

Da liegt der Denkfehler. Wenn ich sage, dass IOS toll ist, mache ich damit ja nicht Android schlecht.

Das ist die Interpretation des Lesers, nicht meine Aussage.

Der Stromverbrauch ist durchaus sehr relevant. Nicht unbedingt, was die Stromrechnung angeht, sehr wohl

aber bei der Auslastung bzw. Auswahl des richtigen Netzteils. Da können 40 Watt an der falschen Stelle

dann ein Problem verursachen bzw. das entsprechende NT überlasten.

Da liegt der Denkfehler. Wenn ich sage, dass IOS toll ist, mache ich damit ja nicht Android schlecht.

Das ist die Interpretation des Lesers, nicht meine Aussage.

Der Stromverbrauch ist durchaus sehr relevant. Nicht unbedingt, was die Stromrechnung angeht, sehr wohl

aber bei der Auslastung bzw. Auswahl des richtigen Netzteils. Da können 40 Watt an der falschen Stelle

dann ein Problem verursachen bzw. das entsprechende NT überlasten.

chancaine schrieb:Der Stromverbrauch ist durchaus sehr relevant. Nicht unbedingt, was die Stromrechnung angeht, sehr wohl

aber bei der Auslastung bzw. Auswahl des richtigen Netzteils. Da können 40 Watt an der falschen Stelle

dann ein Problem verursachen bzw. das entsprechende NT überlasten.

Wetten, dass ich in einer Minuten gurgeln mehr Konfigurationen mit einem fett ÜBERdimensionierten Netzteil auftreiben kann, als du in zehn Minuten an UNTERdimensionierten findest?

[Böllernetzteile mit aufgedruckter Leistung = 2x Real-Dauerleistung fallen übrigens aus der Wertung, die könnte man ja beiden Lagern zurechnen]