Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

"Upgrade" zu energiesparender/schneller Lösung (AMD R9 5900X -> i7-12700)

- Ersteller savagepc

- Erstellt am

wenn nicht gespielt wird und 8 Kerne reichen ist die beste Variante, die 1070 zu verkaufen und als CPU den AMD Ryzen 7 5700 G (da ohne Chiplets energieeffizient im Idle / Teillast) zwischen 250 (mindstar) und 300 € zu kriegen.

Mein 2700X mit undervolting -0-075 CPU und -0.1 SoC, limitiert auf 80 Watt, macht inkl. VMWare (für Office, Internet) alles ausreichend schnell und rel. sparsam - idle und als Server mit VM im Anhang - liegt für SoC plus CPU im idle bei 15 W und im Betrieb mit VM bei 25 W an (2) 4K Monitore mit einer 1060 GPU, die jeweils 20 Watt schluckt also inkl. GPU bei 35 bis 45 Watt - die APU dürfte mit deutlich weniger auskommen - vielleiht kann ja ein 5700 G Besitzer was dazu beitragen

Mein 2700X mit undervolting -0-075 CPU und -0.1 SoC, limitiert auf 80 Watt, macht inkl. VMWare (für Office, Internet) alles ausreichend schnell und rel. sparsam - idle und als Server mit VM im Anhang - liegt für SoC plus CPU im idle bei 15 W und im Betrieb mit VM bei 25 W an (2) 4K Monitore mit einer 1060 GPU, die jeweils 20 Watt schluckt also inkl. GPU bei 35 bis 45 Watt - die APU dürfte mit deutlich weniger auskommen - vielleiht kann ja ein 5700 G Besitzer was dazu beitragen

Anhänge

Also manchmal denke ich, dass sich die Leute auch was in die Tasche denken.

Gottseidank hat mein Netzteil eine Anzeige für den Verbrauch. Mein Gesamtsystem verbraucht im Idle ca. 70W.

Mit meinem 5950X und 3090 waren es ca. 105W.

Man sollte bedenken, dass es auch darauf ankommt mit welchen Settings der Monitor angesteuert wird. Wenn man z.B. HDR aktiviert hat, zieht sich die GPU im Idle fast das Doppelte.

Out of the Box ist RDNA2 deutlich sparsamer als das Pendant von Nvidia. Die 3090 und auch meine 3080Ti haben im Idle ca. 28-30W verbraucht. Die 6900XT benötigt hier nur 8W.

Auch benötigt der 12900K ca. 15W weniger im Idle, als der 5950X.

Ob ich dafür mein System wechseln würde? Im Leben nicht ^^.

Gottseidank hat mein Netzteil eine Anzeige für den Verbrauch. Mein Gesamtsystem verbraucht im Idle ca. 70W.

Mit meinem 5950X und 3090 waren es ca. 105W.

Man sollte bedenken, dass es auch darauf ankommt mit welchen Settings der Monitor angesteuert wird. Wenn man z.B. HDR aktiviert hat, zieht sich die GPU im Idle fast das Doppelte.

Out of the Box ist RDNA2 deutlich sparsamer als das Pendant von Nvidia. Die 3090 und auch meine 3080Ti haben im Idle ca. 28-30W verbraucht. Die 6900XT benötigt hier nur 8W.

Auch benötigt der 12900K ca. 15W weniger im Idle, als der 5950X.

Ob ich dafür mein System wechseln würde? Im Leben nicht ^^.

eRacoon

Rear Admiral

- Registriert

- Aug. 2007

- Beiträge

- 5.442

Die Nvidia GPUs ziehen im Dual Screen Setup leider absurd unnötig Power.

Meine 2080Ti zieht im idle durch zwei Monitore auch dauerhaft ~30W+.

Mein 12900k dagegen ist so sparsam im idle wie ich noch kein Setup hatte.

Hab die letzte Stunde gesurft, YT geschaut und diverse Office Sachen gemacht und damit immer noch nur einen Verbrauch von nur ~10W im Schnitt.

Und das mit starkem RAM OC, was den RAM Controller in der CPU eigentlich mehr verbrauchen lässt als üblich.

Wenn du die GPU nicht brauchst dann ist das eigentlich ein No Brainer, verkauf das AMD Setup + GPU.

Dafür bekommst du gebraucht noch mehr als dich eine Alder Lake Plattform kostet.

Allein durch den Wegfall der GPU wirst du vermutlich 50% Strom sparen.

Eigentlich eine Win Win Situation in meinen Augen wenn GPU eh nicht benötigt wird.

Meine 2080Ti zieht im idle durch zwei Monitore auch dauerhaft ~30W+.

Mein 12900k dagegen ist so sparsam im idle wie ich noch kein Setup hatte.

Hab die letzte Stunde gesurft, YT geschaut und diverse Office Sachen gemacht und damit immer noch nur einen Verbrauch von nur ~10W im Schnitt.

Und das mit starkem RAM OC, was den RAM Controller in der CPU eigentlich mehr verbrauchen lässt als üblich.

Wenn du die GPU nicht brauchst dann ist das eigentlich ein No Brainer, verkauf das AMD Setup + GPU.

Dafür bekommst du gebraucht noch mehr als dich eine Alder Lake Plattform kostet.

Allein durch den Wegfall der GPU wirst du vermutlich 50% Strom sparen.

Eigentlich eine Win Win Situation in meinen Augen wenn GPU eh nicht benötigt wird.

Anhänge

MyPVR

Lieutenant

- Registriert

- Mai 2010

- Beiträge

- 757

Mal überlegt einfach das Mainboard gegen eines mit 2 Monitoranschlüssen und die CPU gegen einen R7 5700G auszutauschen? Dann kannst Du R9/Mainboard/1070Ti verkaufen.

Oder unterstützt dein Mainboard vielleicht sogar HDMI über Type-C am Back Panel?

Ergänzung ()

Oder unterstützt dein Mainboard vielleicht sogar HDMI über Type-C am Back Panel?

Zuletzt bearbeitet:

the_ButcheR

Vice Admiral

- Registriert

- Mai 2010

- Beiträge

- 6.860

Ich hab nicht alles gelesen, aber weil noch niemand die durchschnittliche Leistung ausgerechnet hat:

Minimal: 5 kWh / 18 h = 278 W

Maximal: 6 kWh / 14 h = 429 W

Selbst wenn wir davon jetzt die Monitore abziehen bleibt noch ein zu hoher Wert über (wenn der Rechner nicht die ganze Zeit mit hoher - sehr hoher Last läuft, was der TE ja verneint hat).

Minimal: 5 kWh / 18 h = 278 W

Maximal: 6 kWh / 14 h = 429 W

Selbst wenn wir davon jetzt die Monitore abziehen bleibt noch ein zu hoher Wert über (wenn der Rechner nicht die ganze Zeit mit hoher - sehr hoher Last läuft, was der TE ja verneint hat).

MyPVR

Lieutenant

- Registriert

- Mai 2010

- Beiträge

- 757

Mal eine spaßig gemeinte Alternative:

Mal für mein Verständnis:

Du arbeitest nicht in Deutschland oder? Hier wären 10 Stunden + Pause max (aber keine 18h).

- Rechner lassen wie er ist

- 20km mit dem Fahrrad absolvieren

Mal für mein Verständnis:

Du arbeitest nicht in Deutschland oder? Hier wären 10 Stunden + Pause max (aber keine 18h).

Die GPU fressen viel Strom im Dual-Betrieb (Monitor), auch im Idle. zieh mal einen stecker aus der GPU raus. Auch dann frisst der PC immer noch zu viel, meiner Ansicht nach.

Mein PC: 3600+B450+gtx 1050 verbraucht 32W im Idle und 47W beim 1080p Streaming (mein Monitor nicht berücksichtigt).

Mein PC: 3600+B450+gtx 1050 verbraucht 32W im Idle und 47W beim 1080p Streaming (mein Monitor nicht berücksichtigt).

Burfi

Commander

- Registriert

- Aug. 2008

- Beiträge

- 2.130

Er betreibt die CPU dauerhaft unter Vollast und natürlich braucht sie dann entsprechend viel. Ein Intel 12700 würde bei dieser Last noch deutlich mehr Strom brauchen. Der Wechsel der CPU alleine wird also überhaupt nichts bringen.savagepc schrieb:2.) Der PC ist kaum mal (selbst bei Test mit VM) nicht voll ausgelastet (alle CPUs). Ich erstelel viele Python Programme die nur auf einem Thread laufen. Nur wenig mach ich neu in Go wo dann mal kurzfristig 10 MNintuen alles voll ist (100000 XML Dateien Laden -> Kassenbons).

Ich würde hier klar bei der alten, bei Dual Monitor, recht ineffizienten Grafikkarte ansetzen.

Hier würde ich einfach eine moderne, kleine Grafikkarte als Ersatz verbauen.

Nebenbei:

Ich bezweifle, dass es eine gute Idee wäre jetzt auf eine weniger schnelle CPU zu wechseln, wenn du den Ryzen 5900X bereits voll auslasten kannst...

Das klingt für mich nach Feature Creep, ohne zu merken, dass das bisher nur ging, weil du eben so viel Leistung hast. Am Ende würdest du durch eine langsamere CPU jetzt wahrscheinlich Zeit verlieren..

Den 5700G hab ich auch überlegt. Aber das Mainboard hat nur einem Displayausgang. Dann müsste ich auch ein neues Mainboard kaufen. Dann könnte ich auch gleich zu Intel wechseln.

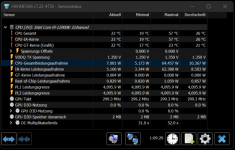

Mit PBO deaktiviert zeigt das Strommessgerät so ca. 127-175W. Nur Firefox mit 2-3 Tabs offen.

Von AMD GPU halte ich nichts, die Treiber taugen unter Linux nichts.

Für Intel ist die Linuxunterstützung auch viel besser. Das ist zumindest mein Eindruck. AMD ist da einfach zu faul etwas beizutragen.

Mit PBO deaktiviert zeigt das Strommessgerät so ca. 127-175W. Nur Firefox mit 2-3 Tabs offen.

Von AMD GPU halte ich nichts, die Treiber taugen unter Linux nichts.

Für Intel ist die Linuxunterstützung auch viel besser. Das ist zumindest mein Eindruck. AMD ist da einfach zu faul etwas beizutragen.

- Registriert

- Feb. 2019

- Beiträge

- 6.054

Ok, dass ist aber schon nicht mehr Idle. Denke du kannst die 127 Watt für den PC auf vielleicht 70 Watt drücken im Bestcase. Wären dann 50 Watt weniger. Ob das den Unterschied macht? Normal ist Intel/AMD aber eher bei 10-20 Watt Unterschied, nicht mehr.

Wenn ich daran denke, dass vor nicht solanger Zeit noch eine einzige Glühbirne 60 Watt gezogen hat...

PS: Du sagst auch "Strommessgerät". Was hast du für ein Netzteil? Auch da geht ja nochmal einiges verloren, je nach Effizenz.

Wenn ich daran denke, dass vor nicht solanger Zeit noch eine einzige Glühbirne 60 Watt gezogen hat...

PS: Du sagst auch "Strommessgerät". Was hast du für ein Netzteil? Auch da geht ja nochmal einiges verloren, je nach Effizenz.

Zuletzt bearbeitet:

MyPVR

Lieutenant

- Registriert

- Mai 2010

- Beiträge

- 757

Ja, ist leider so. War überrascht als ich mir auf der Gigabyte Seite das MB angesehen habe: Nur ein Anschluß... schade, sonst wäre ein Wechsel eine Arbeit von ner halben Stunde gewesen.savagepc schrieb:Den 5700G hab ich auch überlegt. Aber das Mainboard hat nur einem Displayausgang.

@Burfi Da hab ich mich verschrieben. Der PC ist vielelicht für ein paar Test am Tag voll ausgelastet (insgesamt wohl maximal 10 Mintuen am Tag). Sonst wird meinst nur im Editor, Browser und Word getippt.

Für eingie Stunden hab ich auch eine Remot Desktopverbindung auf ein Notebook (vom Kunden) offen.

Also ich halte den Strombedarf für Browsen im Forum für zu hoch. CPU-Temperatur ist dann so um die 40°C

Beim Seitenwechsel dann Spike auf 50-60°C hoch.

Für eingie Stunden hab ich auch eine Remot Desktopverbindung auf ein Notebook (vom Kunden) offen.

Also ich halte den Strombedarf für Browsen im Forum für zu hoch. CPU-Temperatur ist dann so um die 40°C

Beim Seitenwechsel dann Spike auf 50-60°C hoch.

Drewkev

Geizkragen

- Registriert

- Okt. 2016

- Beiträge

- 40.114

Ja gut das ist erstmal nicht schlimm, die Temperaturen schwanken heutzutage sehr stark innerhalb von Sekunden.savagepc schrieb:Beim Seitenwechsel dann Spike auf 50-60°C hoch.

Sicher, dass du das nicht verwechselst?savagepc schrieb:Von AMD GPU halte ich nichts, die Treiber taugen unter Linux nichts.

Verwechselst du da evtl. AMD und Nvidia, was den Linux-Support angeht? Bei Nvidia ist es der Open Source Treiber, der nichts taugt, weil Nvidia den Entwicklern keinen Zugriff auf alle Features (Stromsparmechanismen, Boost) der Grafikkarte erlaubt und dem eigenen proprietären Treiber vorbehält.savagepc schrieb:Von AMD GPU halte ich nichts, die Treiber taugen unter Linux nichts.

Für Intel ist die Linuxunterstützung auch viel besser. Das ist zumindest mein Eindruck. AMD ist da einfach zu faul etwas beizutragen.

AMD stellt dagegen offiziell einen Open Source Treiber (amdgpu) zur Verfügung, der eigentlich gleichwertig mit dem Windows-Treiber ist.

MyPVR

Lieutenant

- Registriert

- Mai 2010

- Beiträge

- 757

Hmmm... nicht lachen, aber ich habe ein ähnliches Setup völlig anders umgesetzt:savagepc schrieb:er PC ist vielelicht für ein paar Test am Tag voll ausgelastet (insgesamt wohl maximal 10 Mintuen am Tag). Sonst wird meinst nur im Editor, Browser und Word getippt.

Für eingie Stunden hab ich auch eine Remot Desktopverbindung auf ein Notebook (vom Kunden) offen.

- Ein dickerer Linux PC mit ausreichend RAM und Storage steht in der Ecke

- Brauche ich den, nutze ich Wake-up On Lan

- Brauche ich den nicht, fahre ich den ins Off (nicht Suspend)

- Für IDE/Office/Browser nutze ich einen Mini PC mit einer kleinen CPU unter Linux

- Ryzen 3 3200U, max 15 Watt

- 16GB RAM

- 500GB SSD

- 2x HDMI

- Per SSH und ggf. RDP greife ich vom Mini auf den großen PC zu

Zuletzt bearbeitet:

Tanzmusikus

Fleet Admiral

- Registriert

- Aug. 2010

- Beiträge

- 10.397

Ja, was eine Unsitte der Mainboard-Hersteller ist, da man (theoretisch) die Garantie von AMD für die CPU verliert & zudem höheren Stromverbrauch sowie Wärmeabgabe erhält.savagepc schrieb:Ist das (PBO alias XFR2) per Default aktiviert ?

Das Einstellungsmenü ist oftmals schwer zu finden, weil es irgendwie anders benannt wurde oder/und sich verschachtelt in einem der vielen Unterordner von z.B. "AMD CBS", "CPU OC" o.s.ä. befindet.

Grüße

Ergänzung ()

Per DisplayPort (DP) kann man auch mehrere Displays an einem DP-Kabel betreiben.savagepc schrieb:Den 5700G hab ich auch überlegt. Aber das Mainboard hat nur einem Displayausgang.

Keine ahnung, ob das auch mit unterschiedlichen Auflösungen geht.

Zumindest darf man dann nicht 4K @ 144 Hz erwarten, sondern eher 2x 2K oder 2,5K @ 60 Hz.

Hier müssen aber wohl auch die Monitore die DP-Funktion "Multi-Stream-Transport" unterstützen.

***

Schau auch, dass Du im UEFI alles abschaltest, was nicht gebraucht wird.

Z.B. wären das: BT, WiFi, usw. ...

***

Letzte Idee (wurde hier schon genannt): PC öfter mal in den Standby-Modus versetzen.

Überprüfe bitte, ob wirklich Gesamt-PC + die zwei Monitore auf ~150-200W kommen (3,6 - 4,8 kWh/Tag).

Und wie viel davon die beiden Monitore verbraucht haben.

Grüße

Zuletzt bearbeitet:

Danke, das hier ist doch die wichtigste Aussage.the_ButcheR schrieb:Ich hab nicht alles gelesen, aber weil noch niemand die durchschnittliche Leistung ausgerechnet hat:

Minimal: 5 kWh / 18 h = 278 W

Maximal: 6 kWh / 14 h = 429 W

Selbst wenn wir davon jetzt die Monitore abziehen bleibt noch ein zu hoher Wert über (wenn der Rechner nicht die ganze Zeit mit hoher - sehr hoher Last läuft, was der TE ja verneint hat).

Der TE hat einen Minimalverbrauch von 278W. Entweder wird da die Arbeitszeit unterschätzt oder die Zahlen stimmen nicht. Fast 300W haut das System exkl. GPU nicht mal bei Volllast raus.