Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Video: Performance-Vorteil durch DX 10.1

- Ersteller Wolfgang

- Erstellt am

- Zur News: Video: Performance-Vorteil durch DX 10.1

Und weiter?y33H@ schrieb:

y33H@

Fleet Admiral

- Registriert

- Apr. 2006

- Beiträge

- 25.670

Dort findest du Furmark-Werte der HD4870 Ref- wie Custom-Design.gruffi schrieb:Und weiter?

Korrekt.Aber Unterschiede zwischen DX9->DX10 waren viiiiiel größer als bei DX10->DX11

Und woran sehe ich konkret, dass es sich um ein Referenzdesign handelt?y33H@ schrieb:Dort findest du Furmark-Werte der HD4870 Ref- wie Custom-Design.Korrekt.

Dann nenne mir doch mal konkret die Punkte, die es bei einem Referenzdesign zu beachten gibt. Speicher? Spannung? Spannungswandler? Taktraten? etc... Und wo genau sehe ich, dass bei PCGH alles innerhalb der Spezifikationen liegt? Einfach irgendwelche Plattitüden kann ja jeder ablassen.

Wie wäre es mit einer kurzen Zusammenfassung von dir oder y33H@, damit der Laie einen besseren Überblick bekommt?

Wie wäre es mit einer kurzen Zusammenfassung von dir oder y33H@, damit der Laie einen besseren Überblick bekommt?

y33H@

Fleet Admiral

- Registriert

- Apr. 2006

- Beiträge

- 25.670

Das RefDesign wie Custom-Designs erkennt man am Kühler und der Platine. Wenn du das nicht differenzieren kannst, ist die Diskussion ohnehin recht einseitiggruffi schrieb:Und woran sehe ich konkret, dass es sich um ein Referenzdesign handelt?

Das Referenz-PCB v1.0 mit Custum-Kühlung hatten beispielsweise die erste Revision der Powercolor PCS+ (mit Zerotherm-Kühler), die Force3D (mit AC-Kühler) und die erste Revision der Sapphire Toxic. Alle diese drei Karten stürzen im Furmark ab und erzielen mit die höchste Leistungsaufnahme. Kein Referenz-PCB und eine Custum-Kühlung haben die VaporX, die aktuelle Toxic, die aktuelle PCS+, die Gainward/Palit mit den Dual-Fans oder die Asus Dark Knight. Bei diesen ist die Leistungsaufnahme geringer, da die GPU kühler bleibt und andere Wandler bzw. ein eigenes PCB zum Einsatz kommt.

Die Specs sind bekannt: Die MBP liegt bei 160 Watt (die die HD 4870 um über 20 Watt übertrifft unter Furmark-Last), die PCI-E-Specs bei 225 Watt (75 aus dem Slot plus 2x 75 aus den beiden 6-Pin). Wird einer dieser Werte überschritten, bewegen wir uns logischerweise außerhalb der Specs.gruffi schrieb:Und wo genau sehe ich, dass bei PCGH alles innerhalb der Spezifikationen liegt?

Und wie sollst du da bitteschön erkennen, dass zB Spannungswandler dem Referenzdesign entsprechen?y33H@ schrieb:Das RefDesign wie Custom-Designs erkennt man am Kühler und der Platine.

Und mal abgesehen davon, wenn Furmark abstürzt, liegt noch etwas ganz anderes im Argen. Selbst wenn die Karte mehr Leistung benötigt, sollte die Stromversorgung zumindest ausreichend dimensioniert sein. Du interpretierst da imo zu viel rein. Die Probleme liegen scheinbar jedenfalls nicht beim Chip. Und alles andere ist aus Sicht AMDs erstmal uninteressant.

Zuletzt bearbeitet:

y33H@

Fleet Admiral

- Registriert

- Apr. 2006

- Beiträge

- 25.670

Oh man ... an der Anzahl, der Anordnung, am Namen usw.gruffi schrieb:Und wie sollst du da bitteschön erkennen, dass zB Spannungswandler dem Referenzdesign entsprechen?

Im Falle der HD4870 ist sie das, die HD4780 X2 und die HD4890 aber sprengen die PCI-E-Specs bzw. pendeln am Limit [die X2 ist satte 70 Watt/20% drüber, die HD4980 pendelt bei 225 Watt rum], die GTX 295 btw auch [20 Watt/7% drüber].gruffi schrieb:Selbst wenn die Karte mehr Leistung benötigt, sollte die Stromversorgung zumindest ausreichend dimensioniert sein.

Das darf nicht sein.

Woran sonst? Die HD4890 hat mehr Takt und mehr VCore als die HD4890, sonst sind die Unterschiede bei den stromfressenden Bauteilen kaum vorhanden. Zieht man die VCore einer HD4870 auf das Niveau einer HD4890 und den Takt auch, verbrauchen beide praktisch gleichviel. Es liegt ergo maßgeblich an der GPU.gruffi schrieb:Die Probleme liegen scheinbar jedenfalls nicht beim Chip.

Man kann eine Karte nur als ganzes nutzen.Und alles andere ist aus Sicht AMDs erstmal uninteressant.

Steht das im Artikel oder liest du das mit der Lupe von Screenshots ab oder wie soll ich mir das vorstellen? Wieso fällt es dir so schwer, mal eine klare und vernünftige Aussage diesbezüglich zu machen? Irgendwie habe ich das Gefühl, du weisst selbst nicht so richtig, was das Referenzdesign spezifiziert und was man davon letztendlich auf den getesteten Karten wiederfindet.y33H@ schrieb:Oh man ... an der Anzahl, der Anordnung, am Namen usw.

Ich habe nie über die X2 gesprochen. Und wen interessieren PCIe Specs? Ging es nicht um die TDP?y33H@ schrieb:Im Falle der HD4870 ist sie das, die HD4780 X2 und die HD4890 aber sprengen die PCI-E-Specs bzw. pendeln am Limit [die X2 ist satte 70 Watt/20% drüber, die HD4980 pendelt bei 225 Watt rum], die GTX 295 btw auch [20 Watt/7% drüber].

Und HT4U ist hier einfach höchst unsachlich. Auf der einen Seite echauffieren sie sich über die TDP und dass Kunden damit getäuscht werden. Auf der anderen Seite nehmen sie einen völlig praxisfernen Test mit Furmark und können nicht mal klar stellen, wie die TDP denn definiert ist. Dass jeder Hersteller da sein eigenes Süppchen kocht und es leider keine standardisierte Definition gibt, sollte bekannt sein. Auf diesen Unsinn kann man als geneigter Kunde wirklich verzichten. Das hat mit konstruktiver Kritik nun wirklich nichts mehr zu tun.

Ich gebe dir noch einen Hinweis. Ebenfalls bei HT4U zu finden.y33H@ schrieb:Woran sonst?

Es liegt eben nicht am Chip selbst, wenn die Karte instabil wird oder Leistungsgrenzen sprengt.Während sich die GPU-Temperatur in absolut undenklichen Gefilden bewegt, steigt die Temperatur der Wandler ins Unermessliche.

y33H@

Fleet Admiral

- Registriert

- Apr. 2006

- Beiträge

- 25.670

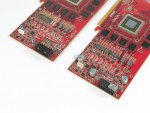

Es gibt von den meisten Karte Bilder des Kühlers und der Platine. Diese schaue ich mir an oder ich habe die Karte da und schraube sie selbst auseinander. Das HD4870-Referenzdesign sieht so aus (jeweils links):gruffi schrieb:Steht das im Artikel oder liest du das mit der Lupe von Screenshots ab oder wie soll ich mir das vorstellen?

Du irrstgruffi schrieb:Irgendwie habe ich das Gefühl, du weisst selbst nicht so richtig, was das Referenzdesign spezifiziert und was man davon letztendlich auf den getesteten Karten wiederfindet.

Das Board und das NT.gruffi schrieb:Und wen interessieren PCIe Specs?

AMD spricht von der MBP. Und die Max Board Power impliziert, dass der genannte Wert das Maximum ist, welches die Karte an Leistung zieht. Und AMD benennt dies mit 160 Watt. Das ist falsch, da das Maximum bei knapp 190 Watt im Furmark liegt. Und das ist ein Benchmark wie jeder andere und den gab es schon lange vor den HD4k. Und btw nutzen HT4U auch Bioshock.gruffi schrieb:Ging es nicht um die TDP? [...] Auf der anderen Seite nehmen sie einen völlig praxisfernen Test mit Furmark und können nicht mal klar stellen, wie die TDP denn definiert ist

Warum verzichten AMD und nV dann nicht auf diesen Unsinn? AMD gibt lustigerweise für die FireGLs an, dass eine HD4890 Peaks bis zu 225 Watt macht - soviel schluckt sie auch im Furmark. Aber den Otto-Normal-Bürger kann man ruhig verarschen. Entweder beide IHVs geben korrekte Werte an (das können sie auch, wollen aber nicht), oder sie lassen es gleich.gruffi schrieb:Auf diesen Unsinn kann man als geneigter Kunde wirklich verzichten.

Zu dumm, dass die Wandler an der GPU hängen. Saugt die GPU mehr, werden die Wandler stärker belastet und ergo heißer.gruffi schrieb:Es liegt eben nicht am Chip selbst, wenn die Karte instabil wird oder Leistungsgrenzen sprengt.

Zuletzt bearbeitet:

Schaffe89

Banned

- Registriert

- Sep. 2008

- Beiträge

- 7.933

Den Otto Normalbürger verarscht man eigentlich nicht, da niemand davon ausgeht dass man ständig mit Furmark bencht.

Wenn sich die Karte im Normalzustand bewegt, sprich Games, dann stimmt die TDP schon.

Außerdem liegt Nvidia bei der TDP im Furmark auch klar über den angegebenen Werten, also sprengen die auch die Specs.

Wenn sich die Karte im Normalzustand bewegt, sprich Games, dann stimmt die TDP schon.

Außerdem liegt Nvidia bei der TDP im Furmark auch klar über den angegebenen Werten, also sprengen die auch die Specs.

Zuletzt bearbeitet:

tza

Lt. Commander

- Registriert

- Feb. 2009

- Beiträge

- 1.361

Das Referenzdesign wird von ATI vorgegeben. Dabei sind mit sicherheit auch die Spawas spezifiziert. Da hat ATI nunmal mist gebaut. Wer solche werte in die welt setzt muss dann auch mit den Folgen leben. Rausreden es ginge nur um den chip bringt da nix. Oder willst du behaupten NVidia und ATI entwickeln nur die chips und den rest überlassen sie andern???

@Schaffe89

NVidia verglühen dabei aber nicht die Spawas...

@Schaffe89

NVidia verglühen dabei aber nicht die Spawas...

y33H@

Fleet Admiral

- Registriert

- Apr. 2006

- Beiträge

- 25.670

Die Aussage der MBP ist schlicht falsch. Punkt. Im Workstation-Markt ist AMD ehrlich. Das ist Verarsche und grenzt an eine Zweiklassengesellschaft, böse ausgedrückt.Schaffe89 schrieb:Den Otto Normalbürger verarscht man eigentlich nicht, da niemand davon ausgeht dass man ständig mit Furmark bencht.

MBP, nicht TDP. TDP wäre Typical Design Power, dann wäre ich mit 160 Watt für die HD4870 auch vollkommen einverstanden.Schaffe89 schrieb:Wenn sich die Karte im Normalzustand bewegt, sprich Games, dann stimmt die TDP schon.

TDP, nicht MBP - bitte differenzieren. Aber ja, die PCI-E-Specs sprengt die GTX 295 und das ist schei0e.Schaffe89 schrieb:Außerdem liegt Nvidia bei der TDP im Furmark auch klar über den angegebenen Werten, also sprengen die auch die Specs.

Schaffe89

Banned

- Registriert

- Sep. 2008

- Beiträge

- 7.933

Das ist richtig,ich sag ja nur^^.

Ati sowie n Nvidia geben erstmals Spezifizierungen raus an denen nix zu rütteln ist, bzw an die sich XFX,BFG;Sparkle usw.. halten müssen. Also liegt das nich an den Partnern sondern bei ATI selbst, da hamm se wirklich mist gebaut.

Das Problem liegt am Furmark, bzw. an den 5D Shadern, da der Furmark droht alle auszulasten, also wird die Leistung gedrosselt, weilsonst alles abfackeln würde.

Trotz der Drosselung werden die Spawas ziemlich heiß.

Mich persönlich intressiert Furmark usw.. ziemlich wenig, also ists mir auch egal ob die da abfackeln würden oder nicht, weil ich Schwanzmark sowieso nicht verwende, auch wenn man das bei meinen 2 x2´s vermuten möchte.

Hoffentlich machts AMD/ATI beim nächsten Mal besser.

@y33H@ Also gibt NVidia auch MBP und TDP an?

TDP is ja klar, aber von MBP hab ich von Nvidia noch nichts gelesen.

Ati sowie n Nvidia geben erstmals Spezifizierungen raus an denen nix zu rütteln ist, bzw an die sich XFX,BFG;Sparkle usw.. halten müssen. Also liegt das nich an den Partnern sondern bei ATI selbst, da hamm se wirklich mist gebaut.

Das Problem liegt am Furmark, bzw. an den 5D Shadern, da der Furmark droht alle auszulasten, also wird die Leistung gedrosselt, weilsonst alles abfackeln würde.

Trotz der Drosselung werden die Spawas ziemlich heiß.

Mich persönlich intressiert Furmark usw.. ziemlich wenig, also ists mir auch egal ob die da abfackeln würden oder nicht, weil ich Schwanzmark sowieso nicht verwende, auch wenn man das bei meinen 2 x2´s vermuten möchte.

Hoffentlich machts AMD/ATI beim nächsten Mal besser.

@y33H@ Also gibt NVidia auch MBP und TDP an?

TDP is ja klar, aber von MBP hab ich von Nvidia noch nichts gelesen.

Zuletzt bearbeitet:

y33H@

Fleet Admiral

- Registriert

- Apr. 2006

- Beiträge

- 25.670

Es liegt an den Partnern, ob diese (wenn AMD es gestattet) alternative PCB-Designs entwickeln. Und da sollte ein Fauxpas wie minderwertige VMR-Kühlung nicht vor kommen - das RefDesign geht im Furmark nicht in die Knie bzw. stürzt nicht ab; einige Custom-Designs schon - hier wurde gespart.

nV spricht auf der Homepage auch von "Maximum Graphics Card Power". Ergo wird die bei der GTX 295 auch gesprengt (MGCP sind 289 Watt), so wie die PCI-E-Specs von 300 Watt. Die GTX 285 liegt im Furmark auch über der MGCP, die GTX 275 und GTX 260 allerdings darunter. Sprich, die Highend-SGPU- wie MGPU-Karten reizen die MGCP aus bzw. liegen drüber. Im Falle von AMD wird die MBP jedoch von allen HD4k gesprengt, die 5-Vecs scheinen stark zu saugen.

nV spricht auf der Homepage auch von "Maximum Graphics Card Power". Ergo wird die bei der GTX 295 auch gesprengt (MGCP sind 289 Watt), so wie die PCI-E-Specs von 300 Watt. Die GTX 285 liegt im Furmark auch über der MGCP, die GTX 275 und GTX 260 allerdings darunter. Sprich, die Highend-SGPU- wie MGPU-Karten reizen die MGCP aus bzw. liegen drüber. Im Falle von AMD wird die MBP jedoch von allen HD4k gesprengt, die 5-Vecs scheinen stark zu saugen.

Also bitte künftig die MBP/MGCP auch im Retailmark korrekt benennen oder wieder die gute alte TDP einführen. Und zwar bei beiden IHVs!

Kommando zurückSchaffe89 schrieb:Also gibt NVidia auch MBP und TDP an? TDP is ja klar, aber von MBP hab ich von Nvidia noch nichts gelesen.

Also bitte künftig die MBP/MGCP auch im Retailmark korrekt benennen oder wieder die gute alte TDP einführen. Und zwar bei beiden IHVs!

Zuletzt bearbeitet:

Lonely Shepherd

Lieutenant

- Registriert

- Okt. 2008

- Beiträge

- 666

tza schrieb:@Schaffe89

NVidia verglühen dabei aber nicht die Spawas...

Bei der HD4890 aber mittlerweile auch nicht mehr.

Nachweis:http://ht4u.net/reviews/2009/amd_radeon_hd4890_reloaded/index5.php

Ähnliche Themen

- Antworten

- 18

- Aufrufe

- 1.267

- Antworten

- 7

- Aufrufe

- 2.371

- Antworten

- 3

- Aufrufe

- 1.677