MalWiederIch

Lt. Commander

- Registriert

- März 2023

- Beiträge

- 1.572

Naja, das hat sich erst vor Kurzem geändert, als Intel die 14. Gen angekündigt hat, da fiel der Preis des 7800X3D deutlich.Bright0001 schrieb:Finde ich, besonders wenn man den X3D zum Vergleich nimmt, jetzt nicht.

Effizienz bzw. der Verbrauch wird ja eben immer dann zum Problem, wenn die Kiste ordentlich Strom ziehen und in gleichem Maße Abwärme abführen muss. Dagegen sind +/- 20 Watt im Idle völlig irrelevant, ein ordentlicher Lüfter wäre bei einer 400€ CPU anzunehmen.

Und mit Kosten kann man ja auch nicht argumentieren, denn bis man die 40€ Aufpreis für den 13700K wieder raus hat, hat die CPU 2,5 Jahre lang täglich 8h im Idle gesessen. Das als "Knaller-Argument" für den 13700K ist dann doch eher mau.

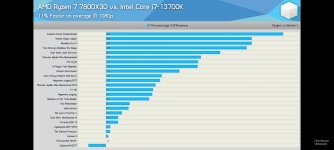

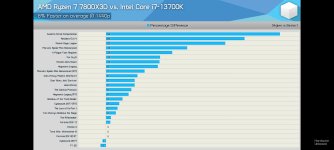

Davor war der 7800X3D immer knapp 10% teurer als der 13700K bei 50% (!!!) geringerer Rohleistung laut CB Leistungsrating:

https://www.computerbase.de/artikel...4/#abschnitt_leistungsaufnahme_in_anwendungen

Wenn 20W im Idle irrelevant sind (0,006€/Stunde), dann sind es die 30 (0,008€/Stunde) bis 40W (0,01€/Stunde) nur bei Last erst recht oder was soll das für eine seltsame einseitige Logik sein

Hatte vor wenigen Monaten ebenfalls zwischen 13700K und 7800X3D (bzw. eigentlich eher 7900X3D) überlegt(, der ja dann leider zum Reinfall wurde.)

Der 7800X3D war 40€ teurer - bei 0,28€/kWh hätte ich also 4.000-5.000 Stunden (!!!) zocken müssen, bevor sich das rechnet - da sieht man wie irrelevant die Differenz im Stromverbrauch eigentlich ist.

Im Gesamtrating Spiele geben sich 13700K und 7800X3D gerade einmal 3% (!), kaum nennenswert.

Das fällt ja fast in den Bereich Messtoleranz.

8 vs 16 Kerne und dementsprechend 49% weniger Leistung wird aber besser nicht erwähnt … 8 Kerne für 500€ UVP, gleichauf mit dem i5 13500, siehe Leistungsrating oben … hier von nicht subjektiv zu sprechen wirkt nicht sehr faktenbezogen.

Ergänzung ()

Für manche scheint das eine Art Enthusiasmus zu sein - mit Blick auf die Stromrechnung rechnet sich das jedenfalls nicht. Und auch das Mehr an Abwärme von 30-40W im max. ist doch eher ein Witz neben einer entsprechenden 450W GPU … wer sich einen 7800X3D holt, holt sich vermutlich keine GTX 1050 dazu … nennenswert lauter wird der übliche Tower Kühler bestimmt nicht bei 66 zu 107W, der in beiden Fällen deutlich mehr abführen kann, wenn man das überhaupt neben der entsprechenden GPU wahrnehmen kann.Ethan Hunt schrieb:Ich muss mich ja mal wieder amüsieren, wenn ich das so alles lese. Ich meine, von was reden wir denn? 30-40 Watt mehr oder weniger? Eine einzige Glühlampe von derer vielen hatte in damaligen Haushalten 40-60 Watt! Ich weiß nicht, man kann es auch übertreiben.

Zuletzt bearbeitet: