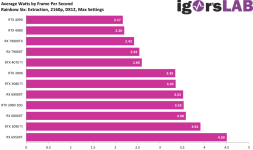

Ja, Nvidia hat wieder das beste Gesamtpaket und etabliert dafür auch die Tier 3 Klasse bei 900 Euro.Sappen schrieb:Ich möchte die AMD Karten jetzt auch nicht nur schlecht reden

NEUNHUNDERT Euro lol.

Das ist der "Tausch" und der Preis....

Alles fail.

Nvidia und AMD liefen diese Generation beste Gründe, um alles zu skippen. Ich lauere nach wie vor im Bekanntenbreis der "non-Enthusiasten" auf 3070, 3070 Tis und 6800XTs .

Die langen für full HD und 1440p dicke.

Wer 4K spielen will oder "muss", ja, darf dann leider 1000 Euro oder mehr hinlatzen. Oder sitzt das ab jetzt einfach noch nochmal nicht ganz Jahre 2 btw. rund 21 Monate aus.