janeeisklar schrieb:

Wenn "Overdrive" bei FreeSync/GSync aktivierbar ist, dann muss der Monitor Hersteller eben nicht wissen wie lange es bis zum nächsten Refresh tatsächlich dauert.

Selbst die GKarte, SpieleEngine, ... "wissen" nicht wie lange das nächste Bild benötigt.

Das was du schreibst ist Stuss!

Das ganze geht natürlich nur mit Puffern. In sofern ist "Vorhersage" wohl das falsche Wort, sondern es ist vielmehr ein "Rückblick".

Ein Bild kommt an, wird in einem Speicher gepuffert und erst wenn das nächste Bild im Puffer ankommt weißt du wie lange es gedauert hat und kannst anhand der beiden Bilder und dem Zeitunterschied deine Overdriveberechnungen durchführen.

Was meinst du, warum das G-Sync Modul 768 MB Speicher mit an Bord hat. Die werden da ja nicht ohne Grund verbaut.

Der Monitor Hersteller muss "nur" dafür sorgen dass seine Angaben über die SyncRange stimmen und er diese "Schaltzeiten" mit Overdrive und der angegebenen FreeSync/GSync Range auch einhalten kann. Oder er hat Overdrive bei aktiviertem FreeSync/Gsync zu deaktivieren.

Overdrive deaktivieren ist keine Option und es reicht auch nicht dem Overdrive einfach nur eine Range mitzuteilen.

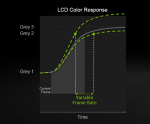

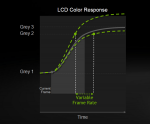

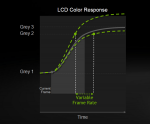

Macht das Bild denn nicht deutlich, warum der Algorithmus wissen muss, wie lang der Zeitraum zwischen den Frames sein muss?

Du willst eigentlich die graue Linie treffen, wenn aber ohne dein Wissen der Refresh zu früh kommt hast du bereits eine viel zu hohe Overdrivespannung angelegt, weil du eigentlich erwartet hast, dass der Subpixel mittlerweile schon wieder viel dunkler geworden ist. Das ist er aber nicht un wenn du ihn jetzt erneut mit zu hoher Spannung übersteuerst, dann wird er zu hell.

Anders herum gilt das gleiche Spiel, wenn der Refresh zu lange auf sich warten lässt, dann wird der Subpixel einfach zu dunkel.

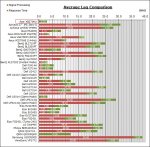

Und bitte keine FreeSync/GSync vergleiche (Im besonderen bei aktiviertem Overdrive!) mit unterschiedlichen Monitorherstellen und bitte bitte nicht von:

April 9th, 2015 at 10:00 pm

Danke

Das ist aber auch nur einer von massenhaft vielen Artikeln, Berichten und Foreneinträgen im Netz, die alle das selbe Bild wiederspiegeln, wenn du mal nach dem Thema googlest.

G-Sync = keinerlei Ghosting, FreeSync = Ghosting

Selbst AMD drückt sich schön um das Thema herum.

I asked Nvidia's Tom Petersen about this issue, and he explained that maintaining the correct overdrive voltage needed to reduce ghosting on an LCD with variable refresh rates is a tricky challenge, one that Nvidia worked to overcome in the development of its G-Sync module. I think that's a credible claim.

When I asked AMD's Robert Hallock for his take, he responded with: "In our view, ghosting is one part firmware, one part panel, and zero parts FreeSync." I think that also is a credible statement.

Laut AMD liegt das also alles in der Verantwortung der Monitorhersteller, was in der Tat eine vertretbare Aussage ist.

Was hat AMD damit zu tun, wie Monitorhersteller ihre Displays ansteuern?

AMD kann hier auch nichts anderes machen. Das ist ganz einfach so, wenn man auf DP1.2a setzt. Damit geht das einfach nicht anders und das ist ganz einfach ein Nachteil gegenüber einem Hardwaremodul in den Monitoren, weswegen nVidia ja auch sagt, dass der adaptiveSync Vesa Standard nicht deren Qualitätsansprüchen genügt.

aivazi schrieb:

Dein Acer hat dasselbe Panel wie mein Acer ( XF270HUA ) und das Overdrive ist im Freesync Modus fixierr und kann nicht verändert werden, dadurch kommt es auch zu keinerlei Ghosting in irgendeiner Situation.

Du sagst mir lediglich, dass du keinerlei Möglichkeiten hast unterschiedliche Overdrive-Settings auszuwählen. Das sagt aber nichts über die Qualität des Overdrive-Algorithmusses aus, die dein Monitor verwendet.

Ich habe doch gesagt, dass die Hersteller das so gut wie möglich versuchen das zu lösen, es aber nicht so perfekt funktioniert (funktionieren kann) wie bei G-Sync, da ihnen die nötige Information über den nächsten Refresh fehlt.

Implementiert tun das aber alle IPS Panel, denn ansonsten würdest du nur auf eine Reaktionszeit von 16ms g2g kommen.