Nein, wir hatten die Situation schon zwei Mal, wir wissen, wie AMD damals gehandelt hat, es handelt sich dabei um geschichtliche Fakten, keine Märchen.Aldaric87 schrieb:Ich finde solche Sprüche "wenn AMD in der Position wäre...blabla" immer so lustig. Diese Situation haben wir momentan nicht, dass ist Fakt. Alles andere ist Märchenstunde

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test AMD-Grafikkarten im Test: Radeon 5870, 6970, 7970, 290X, Fury und Vega 64 im Vergleich

Nein. Der 1 GHz Athlon war für den Slot A, der 1 GHz Pentium!!! für den Slot 1, beide bereits existierende Plattformen.Aldaric87 schrieb:Und auch da war man kundenfreundlicher mit den Sockeln als die Konkurrenz.

Tanzmusikus

Fleet Admiral

- Registriert

- Aug. 2010

- Beiträge

- 10.489

Komisch, meine 290X Lightning verbraucht im Idle nur 12W. Warum misst CB denn da 21W?

@incurable

Es kamen aber noch bis zu ein Jahr später die Thunderbirds und bis zu 3 Jahre die Durons für Slot A raus.

Ich hatte selbst einen 1200er Duron.

Nach dem PIII 1GHz kam für Slot 1 nichts mehr.

@incurable

Es kamen aber noch bis zu ein Jahr später die Thunderbirds und bis zu 3 Jahre die Durons für Slot A raus.

Ich hatte selbst einen 1200er Duron.

Nach dem PIII 1GHz kam für Slot 1 nichts mehr.

Zuletzt bearbeitet:

sven.ghostrider

Lieutenant

- Registriert

- Aug. 2009

- Beiträge

- 659

Aldaric87 schrieb:Und als sie vorne lagen, konnte man trotzdem den Sockel beibehalten und neuere CPU's draufschnallen.

Eher nicht, als ich damals auf Sockel 939 einen x2 hatte und der zu langsam wurde... Auf was für eine neue CPU hätte man deiner Meinung nach denn bei gleichen Sockel upgraden können?

Am2 ging zwar bis x6, aber da lagen die gegenüber den 1366 i7 wirklich nicht vorn

Tanzmusikus

Fleet Admiral

- Registriert

- Aug. 2010

- Beiträge

- 10.489

Naja, es gab von ASRock Upgrade-Kits für bestimmte S.939 Boards, um z.B. eine AM2 darauf zu betreiben.

Und mit AM2 -> AM2+, AM2+ -> AM3 sowie AM3 -> AM3+ waren alle halbwegs kompatibel.

Die CPUs & Boards konnten teils 2 RAM-Versionen unterstützen.

Das war enorm vorteilhaft und es boten sich kleine Upgrade-Stufen an.

War schon recht vorteilhaft ...

P.S.

Sockel AM2 ging nur bis Athlon/Phenom X4.

AM2+/AM3/AM3+ dann bis Phenom X6.

Wie man sieht, große Auswahl an Boards, CPU & RAM möglich.

Aber wir sind ja bei Highend GPU . . .

Und mit AM2 -> AM2+, AM2+ -> AM3 sowie AM3 -> AM3+ waren alle halbwegs kompatibel.

Die CPUs & Boards konnten teils 2 RAM-Versionen unterstützen.

Das war enorm vorteilhaft und es boten sich kleine Upgrade-Stufen an.

War schon recht vorteilhaft ...

P.S.

Sockel AM2 ging nur bis Athlon/Phenom X4.

AM2+/AM3/AM3+ dann bis Phenom X6.

Wie man sieht, große Auswahl an Boards, CPU & RAM möglich.

Aber wir sind ja bei Highend GPU . . .

Zuletzt bearbeitet:

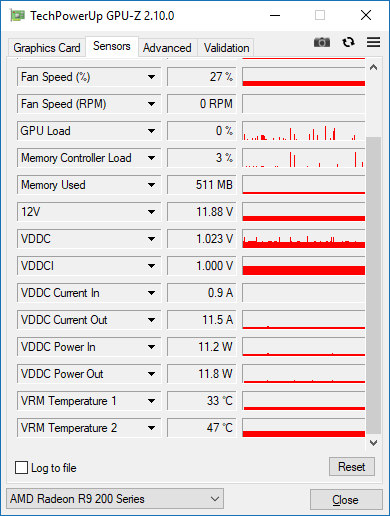

VDDC ist nur die Leistungsaufnahme der GPU selbst, der gute @Wolfgang hat sicher die komplette Karte gemessen.Tanzmusikus schrieb:Komisch, meine 290X Lightning verbraucht im Idle nur 12W. Warum misst CB denn da 21W?

Anhang anzeigen 705876

Nope, beide 1 GHz Modelle waren die letzten und schnellsten ihrer Art, es gab danach keine weiteren CPUs mehr für diese Plattformen. (und der Duron war Sockel-A exklusiv)Tanzmusikus schrieb:@incurable

Es kamen aber noch bis zu ein Jahr später die Thunderbirds und bis zu 3 Jahre die Durons für Slot A raus.

Ich hatte selbst einen 1200er Duron.

Nach dem PIII 1GHz kam für Slot 1 nichts mehr.

Tanzmusikus

Fleet Admiral

- Registriert

- Aug. 2010

- Beiträge

- 10.489

Ach so? Dann hat der Lüfter wohl ~10Watt verbraucht.incurable schrieb:VDDC ist nur die Leistungsaufnahme der GPU selbst, der gute @Wolfgang hat sicher die komplette Karte gemessen.

Na gut - bei 2-3 Lüftern der Partner kann ich das verstehen, aber bei einer Referenzkarte mit einem Axial-Lüfter?

Ist schon komisch, was Du da vermutest ... hier Fakten:incurable schrieb:Nope, beide 1 GHz Modelle waren die letzten und schnellsten ihrer Art, es gab danach keine weiteren CPUs mehr für diese Plattformen. (und der Duron war Sockel-A exklusiv)

https://de.wikipedia.org/wiki/AMD_Athlon_(K7)#K75_(Pluto/Orion)

https://de.wikipedia.org/wiki/AMD_Duron

Slot A

K75 Pluto/Orion @ 1GHz -> 06.03.2000

K7 Thunderbird ... ... ... -> bis 06.06.2001

Duron Aplebred ... ... ... -> bis 21.08.2003

Zuletzt bearbeitet:

Neben dem Spannungsregulator für den Kern, der VDDC produziert, gibt es noch mindestens für RAM, PCIe, und eine weitere Spannung eigene Wandler, dazu kommt in der Regel noch mindestens ein Wandler für gate drive. All das wird in der Software nicht mitgelesen (logisch, die spricht maximal mit dem Controller für den Kern oder Kern und RAM, je nach Design), verbraucht aber selbstrendend auch Strom, weshalb die Messung aller Eingänge einer Karte über der am Controller nur für VDDC liegt.Tanzmusikus schrieb:Ach so? Dann hat der Lüfter wohl ~10Watt verbraucht.

Na gut - bei 2-3 Lüftern der Partner kann ich das verstehen, aber bei einer Referenzkarte mit einem Axial-Lüfter?

Da steht genau das, was ich eben geschrieben habe?Tanzmusikus schrieb:Ist schon komisch, was Du da vermutest ... hier Fakten:

https://de.wikipedia.org/wiki/AMD_Athlon_(K7)#K75_(Pluto/Orion)

Tanzmusikus

Fleet Admiral

- Registriert

- Aug. 2010

- Beiträge

- 10.489

@ GPU ... verstanden. Danke, gut beschrieben!

@ CPU ... also 1 Jahr länger bei K7 & 3 Jahre länger bei Duron sind = 4 Jahre (Scherz) .

.

Man konnte also super von einem Athlon 1GHz auf einen Athlon 1,4GHz oder Duron 1,8GHz aufrüsten, wenn Board (FSB+RAM) mitmachten.

Gut Nacht incurable!

@ CPU ... also 1 Jahr länger bei K7 & 3 Jahre länger bei Duron sind = 4 Jahre (Scherz)

Man konnte also super von einem Athlon 1GHz auf einen Athlon 1,4GHz oder Duron 1,8GHz aufrüsten, wenn Board (FSB+RAM) mitmachten.

Gut Nacht incurable!

Gute Nacht

Von einem der ersten 1 GHz Athlons konnte man nicht aufrüsten denn die höher getakteten Thunderbird- und Duron-modelle waren alle für den Sockel A, welcher überhaupt erst 3 Monate nach dem 1-GHz-Modell auf den Markt kam.

Verwechselst Du vieleicht Slot A und Sockel A?

Von einem der ersten 1 GHz Athlons konnte man nicht aufrüsten denn die höher getakteten Thunderbird- und Duron-modelle waren alle für den Sockel A, welcher überhaupt erst 3 Monate nach dem 1-GHz-Modell auf den Markt kam.

Verwechselst Du vieleicht Slot A und Sockel A?

sven.ghostrider

Lieutenant

- Registriert

- Aug. 2009

- Beiträge

- 659

Tanzmusikus schrieb:ASRock Upgrade-Kits

Hatte ich auch eines, witzige Sache, aber stellt eher doch die Ausnahme dar

Ansonsten kam man mit nem 3800+ @2,8 kaum höher, nur ewig teure FX kamen paar MHz höher

Sockel 775 ging dann auf 4x4ghz dank dem q6600 g0 durch Upgrade von einem dual core, da war amd aber auch schon wieder nicht mehr vorn

Wird aber langsam zu OT

Mit der 6950 mit mehr shadern und oc kam ich bis zur 480 gut aus, man merkte aber zum Ende hin dass sie vor gcn war

Tanzmusikus

Fleet Admiral

- Registriert

- Aug. 2010

- Beiträge

- 10.489

Hab ich wohl anscheinend getan.incurable schrieb:Verwechselst Du vieleicht Slot A und Sockel A?

Finde aber immer noch nicht, dass das ein kundenunfreundliches oder monokapitalistisches Gebahren ist, wenn man neben der Slot A (März 2000) auch noch eine Sockel A 1GHz-CPU anbietet. Slot A kam halt nicht über 100MHz FSB hinaus. Das lag an der Bauweise, gerade weil Cache & FSB außerhalb der CPU über relativ lange Leitungen lief. Mit dem Sockel A wurde das in den CPU-Die integriert.

Ich sehe da also keinen Missbrauch der Front-Position. Inwieweit hätte AMD mit gewagtem (unverschämtem bzw. betrügerischem) Verhalten/Absprachen andere Hersteller quasi aus dem Rennen drängen wollen? Das ist der Punkt.

Gewagt haben sie die zunehmend gesteigerte Qualität & Rechengeschwindigkeit sowie das Dranbleiben in schlechten Zeiten.

Und Ja -> OT ... da gab es übrigens die GPU-Sparte bei AMD noch nicht.

Zuletzt bearbeitet:

timboboy123

Ensign

- Registriert

- Aug. 2017

- Beiträge

- 181

Palmdale schrieb:Das mit dem Sony Gerücht war mir bekannt. Dass man von einer PS5 Entwicklung gleich darauf schließen sollte, dass Navi für PC dann ein Gaming-fokussierter Chip wird, liegt für mich nicht auf der Hand. Die Programmierung der Playstation-Spiele ist nicht dem des PC gleich zu setzen und sogar noch weiter weg als die Xbox Programmierung.

Hauptsächlich unterscheidet sich Konsolen-Programmierung von PC-Programmierung im Multi-Core-Management und darin, dass man den "VRAM" selbst managen muss... Es ist nicht so, dass Konsolen-Chips komplett anders funktionieren als Desktop-Grafikchips. Wenn das mit der Allokierung klappt sind die Schritte die selben wie am PC. Xbox One Spiele sind durch UWP relativ portabel. Dafür hat MS gesorgt. GNM/X sind halt auch nur Grafik-APIs...

Die Unterschiede werden kleiner...

Zuletzt bearbeitet:

Inras

Ensign

- Registriert

- Aug. 2012

- Beiträge

- 246

Zitat:

"Noch einmal einen Sprung erreicht die Radeon R9 Fury X, die 40 Prozent besser als die Radeon R9 Fury X abschneidet."

Ähhhhhh wat?! ^^

Topic:

Mit der Radeon HD 7870 / 7970 hatte AMD wirklich was tolles geliefert. Selbst heute sind die Karten in HD noch gut zu gebrauchen. Bis 2016 hatte ich noch eine 7870 im PC!

"Noch einmal einen Sprung erreicht die Radeon R9 Fury X, die 40 Prozent besser als die Radeon R9 Fury X abschneidet."

Ähhhhhh wat?! ^^

Topic:

Mit der Radeon HD 7870 / 7970 hatte AMD wirklich was tolles geliefert. Selbst heute sind die Karten in HD noch gut zu gebrauchen. Bis 2016 hatte ich noch eine 7870 im PC!

Das ganze erklärt aber immer noch nicht, warum "der gute Wolfgang" so ganz andere Testergebnisse hat, als er selbst sie vor ein paar Jahren gemessen hat. Der Ursprungstest der 5870 stammt, wenn ich mich nicht irre, von Ihm. damals hat er zwar den ganzen Rechner gemessen, die Karte lag aber im Vergleich zu anderen Karten und Tests sehr günstig im Normalbereich. Das heißt, so wie man es von einer im Idle bei 20W liegenden Karte erwarten kann. Jetzt misst er aber ungefähr den doppelten Wert.incurable schrieb:Neben dem Spannungsregulator für den Kern, der VDDC produziert, gibt es noch mindestens für RAM, PCIe, und eine weitere Spannung eigene Wandler, dazu kommt in der Regel noch mindestens ein Wandler für gate drive. All das wird in der Software nicht mitgelesen ..

Dito bei der 6870. Die Werte stimmen so nicht, würde ich vermuten. Auch im Vergleich mit anderen Tests (z.B. auf ht4u.net) Es wäre interessant dafür mal eine Erklärung zu bekommen. Oder ist es so, dass die neuen Betriebssysteme, oder Treiber die Karte im Idle so beschäftigen, dass sie so viel Strom zieht?

Tanzmusikus

Fleet Admiral

- Registriert

- Aug. 2010

- Beiträge

- 10.489

Danke WommU, ich kann diese Gesamtleistungs-Werte leider gar nicht einschätzen/errechnen, wie man da auf die Nettowerte der Grafikkarte kommt.

Ähnliche Themen

- Antworten

- 128

- Aufrufe

- 36.525

- Antworten

- 245

- Aufrufe

- 58.856