Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News AMD zeigt DX11-Spiel auf „Fusion“-APU

- Ersteller Volker

- Erstellt am

- Zur News: AMD zeigt DX11-Spiel auf „Fusion“-APU

D

Dorian_Gray

Gast

@Schaffe89

In Anbetracht dessen, dass es sich zum einen bei der AvP-Demo um ein aktuelles Spiel handelt und zum anderen nur der Ontario zum Einsatz kam, finde ich die Performance geradezu sensationell.

Da ja quasi permanent davon berichtet wird, dass sich die Entwicklungs-Studios von Computer-Spielen verstärkt auf Konsolen fokussieren wollen, so könnte ich mir sehr gut vorstellen, dass der APU die Zukunft gehört -> zumindest für den Massenmarkt.

Ich, zu meinem Teil, habe den ganzen Aufrüstwahn und den BQ- bzw. Grafik-Fetischismus langsam satt.

In Anbetracht dessen, dass es sich zum einen bei der AvP-Demo um ein aktuelles Spiel handelt und zum anderen nur der Ontario zum Einsatz kam, finde ich die Performance geradezu sensationell.

Da ja quasi permanent davon berichtet wird, dass sich die Entwicklungs-Studios von Computer-Spielen verstärkt auf Konsolen fokussieren wollen, so könnte ich mir sehr gut vorstellen, dass der APU die Zukunft gehört -> zumindest für den Massenmarkt.

Ich, zu meinem Teil, habe den ganzen Aufrüstwahn und den BQ- bzw. Grafik-Fetischismus langsam satt.

Die Frage die sich mir bei den integrierten Grafiklösungen stellt ist:

Inwiefern noch der Arbeitsspeicher des Systems gegenüber einer dedizierten Grafikkarte

die Bandbreite beeinträchtigt. Es wäre doch im Falle daß die GPU in der CPU integriert

ist, so daß nun der gesamte Renderingprozess Texturen usw. im auch RAM passiert und dieser

muss sich ja schon für die CPU Physik,KI, Kernel usw. hergeben .

Kann das mal jemand einschätzen ?

Inwiefern noch der Arbeitsspeicher des Systems gegenüber einer dedizierten Grafikkarte

die Bandbreite beeinträchtigt. Es wäre doch im Falle daß die GPU in der CPU integriert

ist, so daß nun der gesamte Renderingprozess Texturen usw. im auch RAM passiert und dieser

muss sich ja schon für die CPU Physik,KI, Kernel usw. hergeben .

Kann das mal jemand einschätzen ?

Zuletzt bearbeitet:

Krautmaster

Fleet Admiral

- Registriert

- Feb. 2007

- Beiträge

- 24.348

naja, das APU und Clarkdale Zusammenpapperei nicht dasselbe sind steht außer Frage. Dass eine APU eine Revolution ist bestreite ich auch nicht.

Die Vorteile dieser Lösung werden sich aber im X86 Bereich erstmal beweisen müssen, und ich denke genau dieses x86 wird diesem Konzept weitestgehend einen Strich durch die Rechnung machen. Und eben deshalb glaube ich, dass zumindest von Anwendersicht aus die Vorteile, vorerst gering sein werden.

Was sich daraus entwickelt steht auf einem anderen Blatt, und gut dass AMD wie bei 64 Bit auch hier Vorreiter ist. Natürlich muss man das begrüßen, aber den Athlon 64 haben nicht die 64 bit so schnell gemacht, sondern die eigentlichen x86 Optimierungen die mit diesem einher gingen.

Auch habe ich nie Clarkdale mit Liano und Fusion vergleichen wollen. Dass letztere die technologisch bessere Lösung darsteht steht doch außer Frage, aus marktwitschaftlicher Sicht stellt aber die erste noch die intelligentere Lösung dar. Intel muss doch nur zusehen, und dann diese APU Lösung mit dem rießen Budget binnen 6 Monaten nachbauen, ähnlich wie bei 64 Bit.

Ich habe die Diskussion angefangen, da sich viele die große Performancesteigerung davon versprechen - die aber vermutlich in geringerem Ausmaß stattfinden wird, vorallem durch Optimierungen an der eigentlichen CPU Architektur die erstmal wenig mit der Integratin der GPU zur APU zu tun haben. Sicher geht der Zuwach auch einen Teil auf diese APU zurück, - wieviel das bringt kann man spätestens in einem Jahr sagen.

Fakt ist doch dass wir uns generell von x86 und den "Kernen" der bisherigen Form wegbewegen müssen, um überhaupt eine Steigerung ausmachen zu können. AMD mag da mitihren Produkten Vorreiterrolle sein, viel genutzt hat es bis heute aber nicht.

Irgendeiner muss die Technik vorrantreiben. Schön dass AMD dies öffensichtlich tut.

Liano wird sich gegen Sandy Bridge stellen müssen, richtig erkannt. Letzteres wird wohl bis zu 6 Monaten früher da sein. Die Frage ist ob man den Markt der "technoligischen Vorreiterrolle" bedienen will, oder den Markt schnell mit dem bedient was benötigt und gefragt wird. Vielleicht fährt manchmal einfach besser wenn man binnen 2 Moanten einen "Murks" wie Clarkdale oder einen lahmen ATOM auf dem Markt wirft... ganz ohne APU.

Die Vorteile dieser Lösung werden sich aber im X86 Bereich erstmal beweisen müssen, und ich denke genau dieses x86 wird diesem Konzept weitestgehend einen Strich durch die Rechnung machen. Und eben deshalb glaube ich, dass zumindest von Anwendersicht aus die Vorteile, vorerst gering sein werden.

Was sich daraus entwickelt steht auf einem anderen Blatt, und gut dass AMD wie bei 64 Bit auch hier Vorreiter ist. Natürlich muss man das begrüßen, aber den Athlon 64 haben nicht die 64 bit so schnell gemacht, sondern die eigentlichen x86 Optimierungen die mit diesem einher gingen.

Auch habe ich nie Clarkdale mit Liano und Fusion vergleichen wollen. Dass letztere die technologisch bessere Lösung darsteht steht doch außer Frage, aus marktwitschaftlicher Sicht stellt aber die erste noch die intelligentere Lösung dar. Intel muss doch nur zusehen, und dann diese APU Lösung mit dem rießen Budget binnen 6 Monaten nachbauen, ähnlich wie bei 64 Bit.

Ich habe die Diskussion angefangen, da sich viele die große Performancesteigerung davon versprechen - die aber vermutlich in geringerem Ausmaß stattfinden wird, vorallem durch Optimierungen an der eigentlichen CPU Architektur die erstmal wenig mit der Integratin der GPU zur APU zu tun haben. Sicher geht der Zuwach auch einen Teil auf diese APU zurück, - wieviel das bringt kann man spätestens in einem Jahr sagen.

Fakt ist doch dass wir uns generell von x86 und den "Kernen" der bisherigen Form wegbewegen müssen, um überhaupt eine Steigerung ausmachen zu können. AMD mag da mitihren Produkten Vorreiterrolle sein, viel genutzt hat es bis heute aber nicht.

Irgendeiner muss die Technik vorrantreiben. Schön dass AMD dies öffensichtlich tut.

Liano wird sich gegen Sandy Bridge stellen müssen, richtig erkannt. Letzteres wird wohl bis zu 6 Monaten früher da sein. Die Frage ist ob man den Markt der "technoligischen Vorreiterrolle" bedienen will, oder den Markt schnell mit dem bedient was benötigt und gefragt wird. Vielleicht fährt manchmal einfach besser wenn man binnen 2 Moanten einen "Murks" wie Clarkdale oder einen lahmen ATOM auf dem Markt wirft... ganz ohne APU.

Zuletzt bearbeitet:

Athlonscout

Rear Admiral

- Registriert

- Jan. 2008

- Beiträge

- 5.942

Krautmaster schrieb:Intel muss doch nur zusehen, und dann diese APU Lösung mit dem rießen Budget binnen 6 Monaten nachbauen, ähnlich wie bei 64 Bit.

Allgemein kann ich deine Meinung, die du hier im Thread vertritts nicht nachvollziehen.

Das du aber Intel, gerade was Grafikkarten angeht, bei weitem überschätzt zeigt doch auch das gescheiterete Larrabee Projekt, bei dem Intel in den letzten Jahren Mrd $ versenkt hat (nicht mal kurz in 6 Monaten).

Einfach nachbauen geht aus lizenztechnischer Sicht auch nicht so einfach, dazu muß Intel erst mal die entsprechenden Lizenzen teuer erwerben, was wiederum auch nur mit Einverständnis des Lizenzinhabers möglich ist (siehe Nvidia - X86).

Complication

Banned

- Registriert

- Okt. 2009

- Beiträge

- 4.277

Na jetzt wissen wir auch wie Intel Ende des Jahres die APU kontern wird:

Sie packen auf X58 Boards schon HD5770 IGPs

ASUS demos Immensity X58 Hydra mainboard with integrated ATI Radeon HD 5770 GPU

lol scheint dass Llano seine Lianen weit voraus wirft

Sie packen auf X58 Boards schon HD5770 IGPs

ASUS demos Immensity X58 Hydra mainboard with integrated ATI Radeon HD 5770 GPU

lol scheint dass Llano seine Lianen weit voraus wirft

Krautmaster

Fleet Admiral

- Registriert

- Feb. 2007

- Beiträge

- 24.348

@In vino veritas

sry -> Bescheuerter Name der wohl einige etwas durcheinander bringt ...

-> Bescheuerter Name der wohl einige etwas durcheinander bringt ...

http://www.google.com/search?hl=de&q=Liano+AMD&aq=f&aqi=g1&aql=&oq=&gs_rfai=

übrigens hieß es hier

https://www.computerbase.de/news/prozessoren/offizielle-desktop-plattform-roadmap-von-amd.26239/

und

https://www.computerbase.de/news/notebooks/details-zu-amds-notebook-plaenen-bis-2011.26240/

auch Liano ^^

@

naja das hat a) wenig mit APU und b) wenig mit Intel zu tun

Naja, APU hat ja auch nichtmehr allzuviel mit Grafikkarten zu tun. "Spielen" wird ja zunehmend zum Nebeneffekt den die Technik mit sich bringt. "Spielen" zu beschleunigen ist sehr einfach, da hier eine sehr gute Skalierung dank Parallelisierung einhergeht. x86 zu beschleunigen ist weit komplexer und "ausgelutschter" - natürlich bringt es nichts mehr nur über Kerne zu gehen, Kerne im ursprünglichen Sinn. Mit mehr als 8 Threads kann der Heimanwender wneig anfangen. APU hat ja als Ziel die einzelnen X86 Kerne durch diese Auslagerung zu beschleunigen. Was wir bekommen ist ein großer X86 Prozessor, dessen Kernanzahl schwer ausgedrückt werden kann, da der interne Aufbau komplett skalierbar gehalten wird, die Anzahl der Rechneineinheiten nicht auf einzelne Kerne heruntergebrochen werden kann.

Naja, solange das ganze unter x86 läuft, kann Intel prinzipiell machen was sie wollen. Wäre ja nicht das erste mal dass etwas ähnliches unter anderem Namen mit leichter Abänderung auf den Markt kommt. Bei nur zwei bestimmenden Herstellern auch kein Wunder. Wenn einer von beiden etwas bahnbrechendes auf den Weg bringt wird dem anderen über kurz oder lang die Lizenz zugesprochen...

Mir soll es recht sein wenn wir uns von X86 entfernen... Ist aber noch ein weiter Weg

sry

http://www.google.com/search?hl=de&q=Liano+AMD&aq=f&aqi=g1&aql=&oq=&gs_rfai=

übrigens hieß es hier

https://www.computerbase.de/news/prozessoren/offizielle-desktop-plattform-roadmap-von-amd.26239/

und

https://www.computerbase.de/news/notebooks/details-zu-amds-notebook-plaenen-bis-2011.26240/

auch Liano ^^

@

naja das hat a) wenig mit APU und b) wenig mit Intel zu tun

Ergänzung ()

Athlonscout schrieb:Das du aber Intel, gerade was Grafikkarten angeht, bei weitem überschätzt zeigt doch auch das gescheiterete Larrabee Projekt, bei dem Intel in den letzten Jahren Mrd $ versenkt hat (nicht mal kurz in 6 Monaten).

Naja, APU hat ja auch nichtmehr allzuviel mit Grafikkarten zu tun. "Spielen" wird ja zunehmend zum Nebeneffekt den die Technik mit sich bringt. "Spielen" zu beschleunigen ist sehr einfach, da hier eine sehr gute Skalierung dank Parallelisierung einhergeht. x86 zu beschleunigen ist weit komplexer und "ausgelutschter" - natürlich bringt es nichts mehr nur über Kerne zu gehen, Kerne im ursprünglichen Sinn. Mit mehr als 8 Threads kann der Heimanwender wneig anfangen. APU hat ja als Ziel die einzelnen X86 Kerne durch diese Auslagerung zu beschleunigen. Was wir bekommen ist ein großer X86 Prozessor, dessen Kernanzahl schwer ausgedrückt werden kann, da der interne Aufbau komplett skalierbar gehalten wird, die Anzahl der Rechneineinheiten nicht auf einzelne Kerne heruntergebrochen werden kann.

Einfach nachbauen geht aus lizenztechnischer Sicht auch nicht so einfach, dazu muß Intel erst mal die entsprechenden Lizenzen teuer erwerben, was wiederum auch nur mit Einverständnis des Lizenzinhabers möglich ist (siehe Nvidia - X86).

Naja, solange das ganze unter x86 läuft, kann Intel prinzipiell machen was sie wollen. Wäre ja nicht das erste mal dass etwas ähnliches unter anderem Namen mit leichter Abänderung auf den Markt kommt. Bei nur zwei bestimmenden Herstellern auch kein Wunder. Wenn einer von beiden etwas bahnbrechendes auf den Weg bringt wird dem anderen über kurz oder lang die Lizenz zugesprochen...

Mir soll es recht sein wenn wir uns von X86 entfernen... Ist aber noch ein weiter Weg

Zuletzt bearbeitet:

Complication

Banned

- Registriert

- Okt. 2009

- Beiträge

- 4.277

Diese Einschätzung zeigt dass du dich mit den APUs nicht ausreichend beschäftigt hast und nach wie vor noch nicht völlig erfasst hast wie diese Architektur arbeiten soll.Was wir bekommen ist ein großer X86 Prozessor, dessen Kernanzahl schwer ausgedrückt werden kann, da der interne Aufbau komplett skalierbar gehalten wird, die Anzahl der Rechneineinheiten nicht auf einzelne Kerne heruntergebrochen werden kann.

Das wird kein grosser x86 Prozessor. Llano ist so gross wie ein heutiger Athlon X4 und das inkl. 400-480 DX11 Shader einer HD5770.

Du würdest auch heute kaum sagen dass Recheneinheiten nicht auf Kerne heruntergebrochen werden können nur weil in den CPUs mathematische Coprozessoren sitzen oder Intel Hyperthreading nutzt. Auch ist der Interne Aufbau nicht skalierbar, da die GPU Einheit zum Uncore gerechnet werden kann - nur die Anzahl der Kerne wird skalierbar bleiben wie bisher auch.

Und wenn du dir die aktuellen AMD CPUs anschaust und auf welche Weise AMD fertigt, dann wird dir schnell klar werden dass verschiedene Modelle auf der selben Maske basieren werden, siehe Deneb oder Propus. Das deaktivieren bestimmter Teilbereiche hat sich für AMD absolut bewährt und ermöglicht auch langfristig eine wesentlich aggressivere Preispolitik ohne auf Gewinne zu verzichten.

M

MC BigMac

Gast

erst mal abwarten, das ist Theorie, praktisch muss es sich noch bewähren. Auf dem Papier sieht es schon mal gut aus.

Krautmaster

Fleet Admiral

- Registriert

- Feb. 2007

- Beiträge

- 24.348

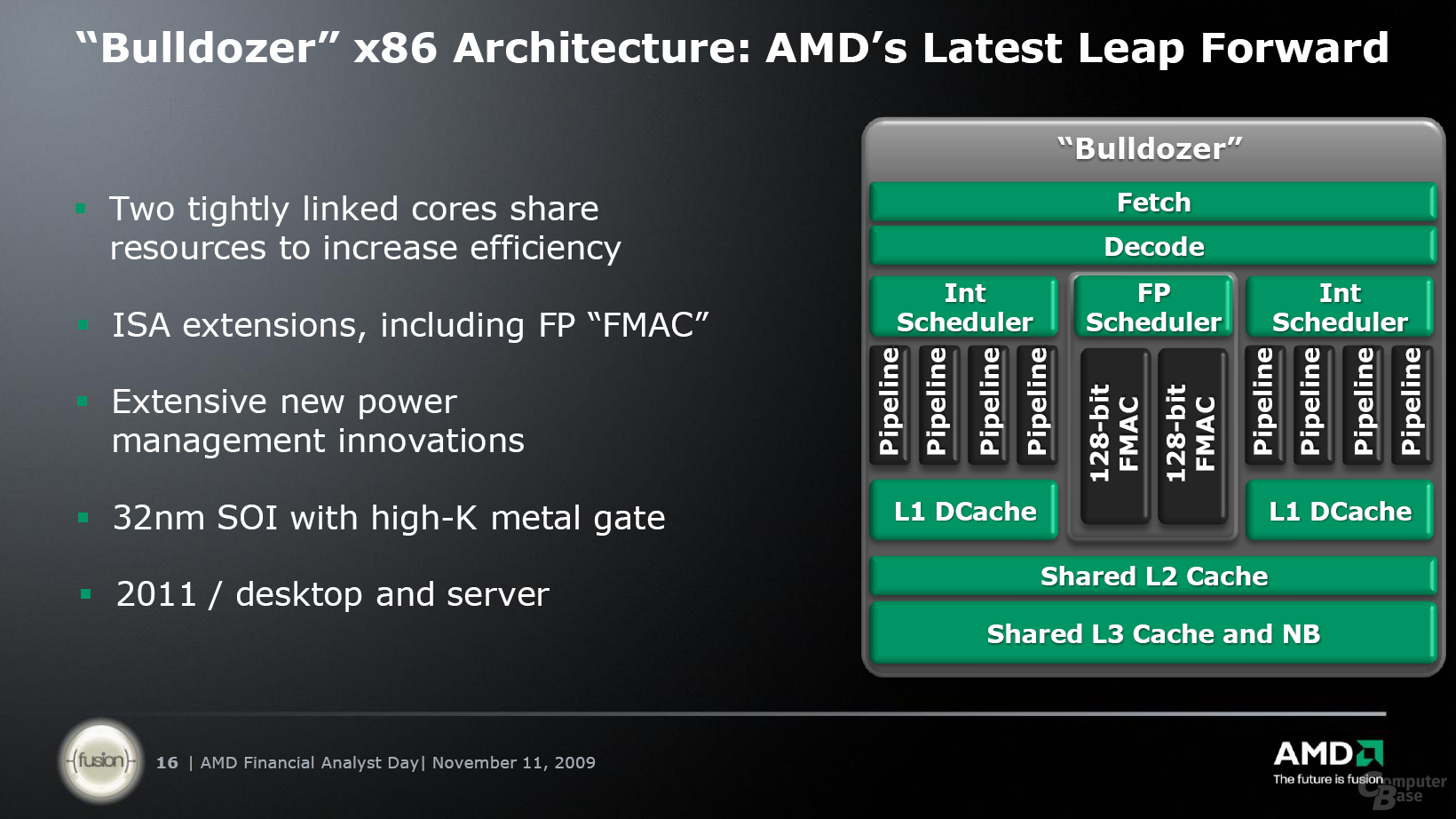

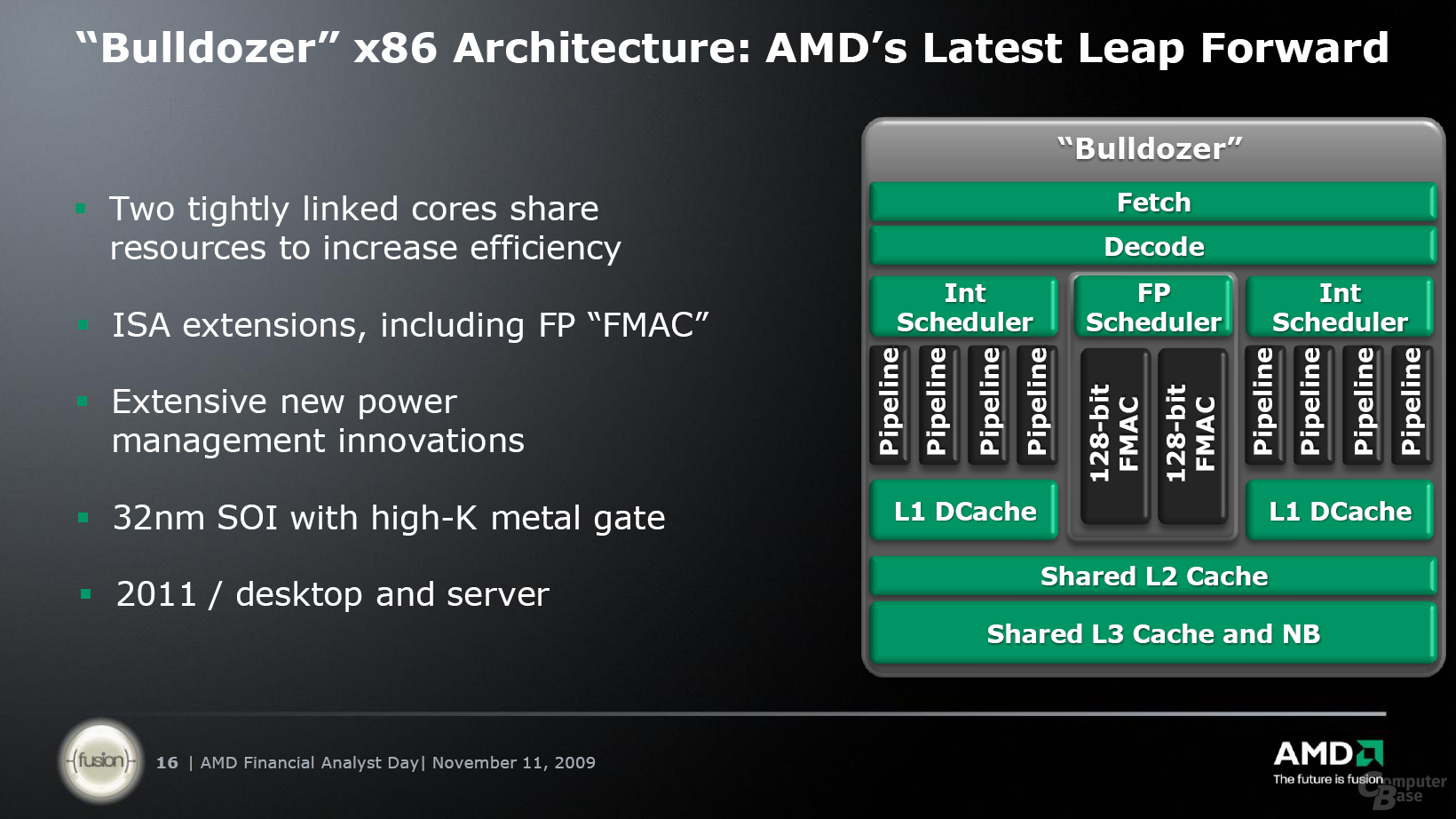

naja ich meine das mit dem "großen" x86 Kern nicht in Bezug auf die DIE Fläche, sondern die Vereinigung der Speziellen Rechnencluster zu einem Kern, wobei die Anzahl der jeweiligen Spezialrecheneinheit skalierbar ist:

Wie es Bulldozer vor macht: Zwei Integer-"Kerne" kommen auf einen FloatingPoint-"Kern" - zusammen kann man es als einen Kern sehen oder als 2+1. Wie man will. Nimmt man nun die "GPU" als "Kern" hinein so kätte man über die Ganze CPU eventuell 4x FP, 8 xInt und 1 GPU Kern(e) - wobei man GPU wieder als einzelne Shaderkerne herunterbrechen könnte usw...

Das meine ich mit dem großen x86 Kern der immer weniger mit dem Kern in der bisherigen Form zu tun hat.

Was man genau als Kern bezeichnet bleibt wohl dem Hersteller überlassen...

Wichtig is ja was hinten rauskommt. Bin gespannt was AMD hier an Boden gut machen kann zur bisherigen Architektur, besonders in Bezug auf Leistung pro Takt. Ansonsten seh ichs wie MC BigMac - auf dem Papier schön und gut, Performance wird sich zeigen müssen und da können wir noch ein ganzes Weilchen warten.

Wie es Bulldozer vor macht: Zwei Integer-"Kerne" kommen auf einen FloatingPoint-"Kern" - zusammen kann man es als einen Kern sehen oder als 2+1. Wie man will. Nimmt man nun die "GPU" als "Kern" hinein so kätte man über die Ganze CPU eventuell 4x FP, 8 xInt und 1 GPU Kern(e) - wobei man GPU wieder als einzelne Shaderkerne herunterbrechen könnte usw...

Das meine ich mit dem großen x86 Kern der immer weniger mit dem Kern in der bisherigen Form zu tun hat.

Was man genau als Kern bezeichnet bleibt wohl dem Hersteller überlassen...

Wichtig is ja was hinten rauskommt. Bin gespannt was AMD hier an Boden gut machen kann zur bisherigen Architektur, besonders in Bezug auf Leistung pro Takt. Ansonsten seh ichs wie MC BigMac - auf dem Papier schön und gut, Performance wird sich zeigen müssen und da können wir noch ein ganzes Weilchen warten.

Zuletzt bearbeitet:

Zuletzt bearbeitet:

M

MC BigMac

Gast

schade eigentlich, das man die Desktop Prozessor mit einer ACP von 55Watt, wenn man schon im Laptop meist nur noch 10-15W benötigt. Wenn die Grafik stimmen sollte.

Zuletzt bearbeitet:

Complication

Banned

- Registriert

- Okt. 2009

- Beiträge

- 4.277

Du solltest hier nicht vergessen dass eine komplette GPU mit an Board ist. Im Notebokk kommst du da auch lange nicht auf 10-15 W

M

MC BigMac

Gast

aber höchsten 20-30W von CPU, weil die TDP ist für den ...., die spiegelt ja nicht mal die tatsächlicher Verbrauch.

ja aber der direkte Verbrauch liegt meist etwas höher als die angegebene TDP und nicht niedriger. Und heutige Geräte sind definitiv ineffizienter als das was in paar Monaten mit der APU kommt.

Wie gesagt, beispiel: Atom + Ion...hat so gut wie 0 Leistung und ein Laptop mit den Innereien schluckt ja schon 40 Watt in Summe inkl. Display und Festplatte, etc.....natürlich geht der Verbrauch runter wenn man nix grafiklastiges macht. Aber wenn das so wäre wie du schreibst BigMac dann hätte heute schon jeder Laptop mit einem Akku von beispielsweise 80 Wh Laufzeiten von 8 Stunden

Aber in der Praxis haben die 1-2 Stunden wenn du mal was machst was Leistung braucht. Und dann kann mans leicht ausrechnen...hast du z.b. ein kleineres Gerät mit 13 Zoll liegen die Akkus um die sagen wir mal 60 Wh. Schluckt das Gerät 30 Watt...ist nach 2 Stunden der Saft leer...ganz einfach.

Es kommt einfach seeehr viel darauf an was man mit so einem Gerät macht.

Aber wenn ich sehe das mit Ontario ein DX11 chip kommt der inkl Prozessor 20 Watt schluckt....dann kann man sich ausrechnen, dass bald der Begriff "Nettop" bald wegfällt.

Es wird dann keine Geräte mehr geben die "nur" zum surfen reichen oder für office. Selbst die kleinsten Geräte haben dann soviel Leistung dass man damit auch Gelegenheitszocker zufriedenstellen kann die eben kein Crysis spielen. Aber für Civ 5 reichts vermutlich ...und das dann eben keine 1-2 Stunden sondern vielleicht 4 Stunden ohne an strom zu müssen. 4 Stunde reines spielen wo die APU vielleicht auf 90% auslastung fährt

...und das dann eben keine 1-2 Stunden sondern vielleicht 4 Stunden ohne an strom zu müssen. 4 Stunde reines spielen wo die APU vielleicht auf 90% auslastung fährt

Wie gesagt, beispiel: Atom + Ion...hat so gut wie 0 Leistung und ein Laptop mit den Innereien schluckt ja schon 40 Watt in Summe inkl. Display und Festplatte, etc.....natürlich geht der Verbrauch runter wenn man nix grafiklastiges macht. Aber wenn das so wäre wie du schreibst BigMac dann hätte heute schon jeder Laptop mit einem Akku von beispielsweise 80 Wh Laufzeiten von 8 Stunden

Aber in der Praxis haben die 1-2 Stunden wenn du mal was machst was Leistung braucht. Und dann kann mans leicht ausrechnen...hast du z.b. ein kleineres Gerät mit 13 Zoll liegen die Akkus um die sagen wir mal 60 Wh. Schluckt das Gerät 30 Watt...ist nach 2 Stunden der Saft leer...ganz einfach.

Es kommt einfach seeehr viel darauf an was man mit so einem Gerät macht.

Aber wenn ich sehe das mit Ontario ein DX11 chip kommt der inkl Prozessor 20 Watt schluckt....dann kann man sich ausrechnen, dass bald der Begriff "Nettop" bald wegfällt.

Es wird dann keine Geräte mehr geben die "nur" zum surfen reichen oder für office. Selbst die kleinsten Geräte haben dann soviel Leistung dass man damit auch Gelegenheitszocker zufriedenstellen kann die eben kein Crysis spielen. Aber für Civ 5 reichts vermutlich

Zuletzt bearbeitet:

das ist mal interessant zu hören  immer wenn ich mal schau liegt der Verbrauch höher...z.b. Intel 750er hat TDP bei 95 Watt, Verbrauch bei 115 Watt.

immer wenn ich mal schau liegt der Verbrauch höher...z.b. Intel 750er hat TDP bei 95 Watt, Verbrauch bei 115 Watt.

Und so bewegt sich das über die komplette Produktreihe....die Hersteller reden sich ihre Prozzis immer etwas "schöner"....ist mein pers. Eindruck so daß es für mich eher als die Regel erscheint

Wobei ich das entspannt sehe: wenn etwas z.b. für 95 Watt "designt" ist....muß das ja nicht heißen dass der Verbrauch immer nur drunter bleibt. Gibt ja etliche verschiedene Belastungszustände je nachdem was man macht...also gehts auchmal drüber.

Imgrunde sind max. Stromaufnahmen ja nur durch spezielle Programme überhaupt erreichbar weil die das letzte Fitzel´chen ausreizen. Im Regelfall bleibt man eh drunter..das stimmt schon.

nichtsdestotrotz: Die TDP ist nur ein Richtwert und keine feste physikalische Gernze wie bei autos die auf 250 km/h abgeriegelt werden , also kann der Verbrauch auch drüber gehn.

Und so bewegt sich das über die komplette Produktreihe....die Hersteller reden sich ihre Prozzis immer etwas "schöner"....ist mein pers. Eindruck so daß es für mich eher als die Regel erscheint

Wobei ich das entspannt sehe: wenn etwas z.b. für 95 Watt "designt" ist....muß das ja nicht heißen dass der Verbrauch immer nur drunter bleibt. Gibt ja etliche verschiedene Belastungszustände je nachdem was man macht...also gehts auchmal drüber.

Imgrunde sind max. Stromaufnahmen ja nur durch spezielle Programme überhaupt erreichbar weil die das letzte Fitzel´chen ausreizen. Im Regelfall bleibt man eh drunter..das stimmt schon.

nichtsdestotrotz: Die TDP ist nur ein Richtwert und keine feste physikalische Gernze wie bei autos die auf 250 km/h abgeriegelt werden , also kann der Verbrauch auch drüber gehn.

Zuletzt bearbeitet:

Schaffe89

Banned

- Registriert

- Sep. 2008

- Beiträge

- 7.933

chendal schrieb:das ist mal interessant zu hören immer wenn ich mal schau liegt der Verbrauch höher...z.b. Intel 750er hat TDP bei 95 Watt, Verbrauch bei 115 Watt.

Wo guckst du denn da?

Ich kenne nur eine Seite (HT4U) die so aufwendig misst.

Der Verbrauch geht vor allem bei CPU´s sogut wie nie über die TDP, eigentlich nie, zumindest in letzter Zeit, wie es vor 5 Jahren war, weiß ich nicht.