- Registriert

- Apr. 2008

- Beiträge

- 13.347

Dies ist ein ausgelagertes Thema aus diesem Hauptthread:

https://www.computerbase.de/forum/t...kussion-zu-spieletests.1728575/#post-20678303

Edit 2021: Dieser Test ist auf Zen und Zen+ CPUs bezogen.

Für die Zen3 CPUs gibt es Reviews, die extreme Vorteile für dual ranked zeigen.

Edit: Mit Zen3 CPUs zeigen manche Testberichte riesige Unterschiede von bis zu 15% die ich mit einem 5700X und einem 5800X3D nicht nachvollziehen konnte.

Anno 1800 reagiert überhaupt nicht auf dual ranked und Cyberpunk 2077 sind bei mir nur 2-6 wie sie auch hier mit Zen möglich sind.

Intro:

Seit dem Release der ersten Ryzen CPUs taucht immer wieder das Thema "dual ranked Ram" auf.

Aussagen wie: "Ryzen mag dual ranked.", "Dual ranked 2666MHz ist so schnell wie single ranked 3000." und "Dual ranked kann man nicht so hoch takten.", ließt man immer wieder und verlinked wurde fast immer folgende Quelle:

https://community.amd.com/community...emory-oc-showdown-frequency-vs-memory-timings

Es gibt aber noch eine Reihe weitere:

http://www.pcgameshardware.de/Ryzen-5-1600X-CPU-265842/Tests/R5-1500X-Review-Mainstream-1225280/3/

Bis zu diesem Test, wo dual ranked 2666 CL16 in einigen Spielen so schnell sein soll wie SR 3200 CL14:

https://www.golem.de/news/ram-overc...-von-ddr4-3200-und-dual-rank-1704-127262.html

Ich war bei Ryzen fast von Anfang an dabei und hatte 2x16GB 3200 Cl14er Ram, wobei die 16GB Module dual ranked sind.

Nach ein paar Bios updates und diversem herumprobieren, liefen die dann auch wie vorgesehen. Anders als diese alten Tests, kann ich also auch 3200MHz DR testen.

Ich bin bei den meisten Tests, die da gemacht wurden skeptisch, weil meine Erfahrung mit dem Ryzen Ram OC mir gezeigt haben, wie deutlich die Unterschiede sein können, wenn andere Subtimings verwendet werden.

Ein frühes Bios hat beim laden des Ram Profils so schlechte Subtimings gewählt, das 3200 CL14 langsamer war als 2400 Cl15.

Das hat sich dann später gebessert, aber das optimieren der Subtimings hat trotzdem noch einen ordentlichen Einfluss.

Ohne Angabe aller Timings oder zumindest einer Angabe, dass diese fest und gleich gewählt wurden, ergeben die Tests wenig Sinn.

Auch die CB Tests zu dual- vs. single ranked schenken den Subtimings keine Aufmerksamkeit(lassen sie auf Auto) und es wird auch nicht auf die Messgenauigkeiten und die genauen Testumstände eingegangen.

Man kann sicherlich argumentieren, dass diese Tests die Unterschiede zeigen. wie sie beim Kunden entstehen, der Ram XY kauft und das Ram Profil lädt.

Für mich gehört zum untersuchen eines Architekturunterschieds, aber auch möglichst viele Unbekannte auszuschließen und ein möglichst allgemeingültiges Ergebnis präsentieren zu können, wo ich eine Abschätzung über die Messungenauigkeit treffen kann und ich bin der Überzeugung, das Leue die sich um "Ram- ranks" Gedanken machen, sich auch solche Tests wünschen.

Daher wollte ich selbst testen und bei der Gelegenheit auch gleich noch dual channel gegen single channel Betrieb testen, sowie der Frage nach gehen, wie viel Leistung Leute opfern wenn sie den günstigen und einfachen Weg gehen und für ihr Ryzen System nur 3000MHz CL16er Ram kaufen und diesen mit XMP/docp Profil betreiben, anstatt 3200 Cl14(Samsung B die) zu kaufen und dann noch Mühe in das optimieren von Subtimings zu stecken....das aber in einem weiteren Artikel.

Was mir fehlte war ein SR Kit, das ich mir dann diese Jahr in Form von 2x8GB 3600 CL15 gekauft habe.

Natürlich war es kein Problem das SR Kit mit dem gleichen Takt und den gleichen Timings(alle 27, die ich in Bios wählen kann) wie mein DR Kit zu betreiben. Leider waren die ersten Tests, die ich gemacht habe nicht ausreichend genau um die oft feinen Unterschiede zuverlässig zu messen.

Wie ich meine Tests gemacht und verbessert habe:

Benchmark Ergebnisse und neue Testsequenzen

Ich habe mich dazu entschieden die absoluten Frametimedaten und die Vorstellung der neuen Testsequenzen in einen extra Artikel auszulagern.

Dann kann ich mich hier auf die prozentualen Unterschiede von dual zu single ranked konzentrieren.

Ramtest-Session Juli/August 2018

.......................

Synthetische Benchmarks(Aida64)

An dieser Stelle nochmal ein kurzer Überblick über das verwendete System und die verwendeten Ramtimings:

Ein Ryzen 1800X mit Pstate OC auf 3,8GHz. 100.2MHz BCLk(für die optik). Ich musste für die sommerlichen Temperaturen etwas undervolting zurücknehmem und komme unter IBT Last auf 1,3-1,312V.

Asus Crosshair VI Hero @ Bios 6002

Vega64 LC mit custom Wasserkühlung für CPU und GPU. PT+50%, P7 = 1702MHz, 1050mV(resultiert in ca 1610MHz bei 1V),

HBM2@1050MHz, P6 als min gesetzt

2x16GB DR und 2x8GB SR DDR4 mit Samsung B-die

Sämtliche im Bios einstellbaren Timings wurden für die höchste effektive Ram Taktrate des DR Kits optimiert und manuell festgesetzt.

Und dann für das SR Kit gleich gewählt.

Die Timings für 2933 CL16 habe ich aus verschiedenen Angaben aus dem Internet für Aegis 3000 CL16er Ram entnommen und bei widersprüchlichen Angaben den Mittelwert eingestellt. Die Subtimings sind dabei ganz in Ordnung aber natürlich weit von "optimiert" entfernt....eben das was man bekommt wenn man das docp Profil lädt und es so lässt.

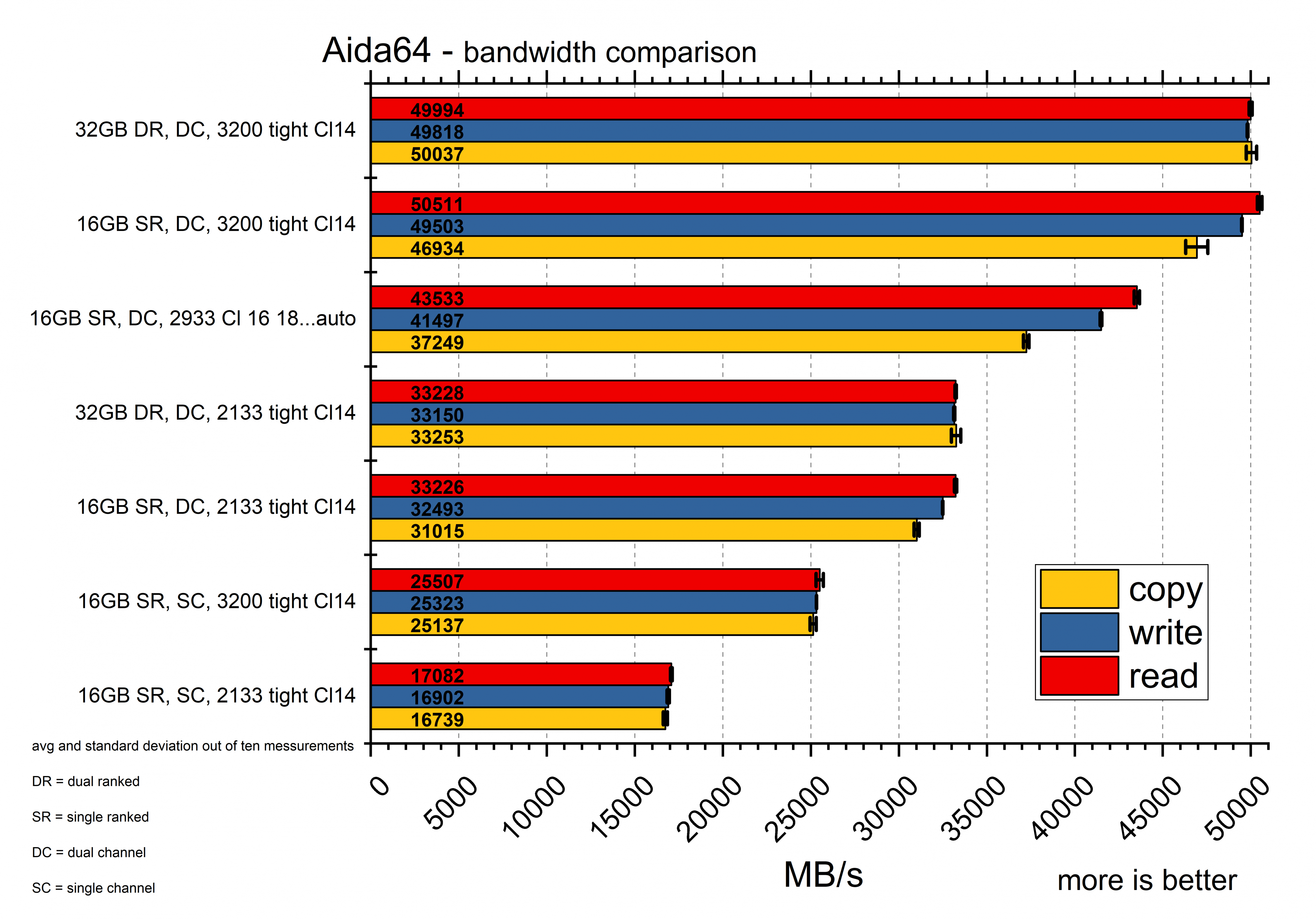

Kommen wir jetzt zu den Bandbreiten und Latenzen, die Aida misst:

Wie man sieht zeigen sich bei 3200MHz effektivem Ramtakt minimale aber reproduzierbare Vorteile für den SR Ram(1%) aber etwas Nachteile bei den Kopier-Werten(6,6%). Die Schreibraten waren praktisch im Bereich der Messungenauigkeit und daher als gleich anzusehen.

Ein ähnliches Bild zeigt sich bei 2133Mhz. Hier kann sich SR zwar nicht beim lesen absetzen und verliert minimal beim Schreiben, der deutliche Unterschied bleibt jedoch wieder der Kopierwert(7,1%).

Warum sich das Bild leicht verschiebt, könnte daran liegen, das sich die absoluten "Arbeitsschrittzeiten" gegeneinander unterschiedlich verschieben, sobald die Ram Frequenz geändert wird. Die Verhältnisse bleiben gleich, aber manche Subtimings sind bei 5 und andere bei 12.

Multipliziert mit der Zeit für einen Takt, wird der absolute Abstand größer und hat damit eventuell andere Einflüsse, wenn die Ram Frequenz sinkt.

Wenn die 8GB Riegel im single channel Modus gesteckt sind, sieht man wie sich die Bandbreiten fast halbieren. Ein erwartbares Ergebnis.

Die 2933 mit Cl 16 18 18 38er Timings positioniert sich mittig zwischen 2133 und 3200 Cl14.

Die Aufspaltung zwischen read und copy ist deutlich größer, was ich auf die Timings zurückzuführen würde.

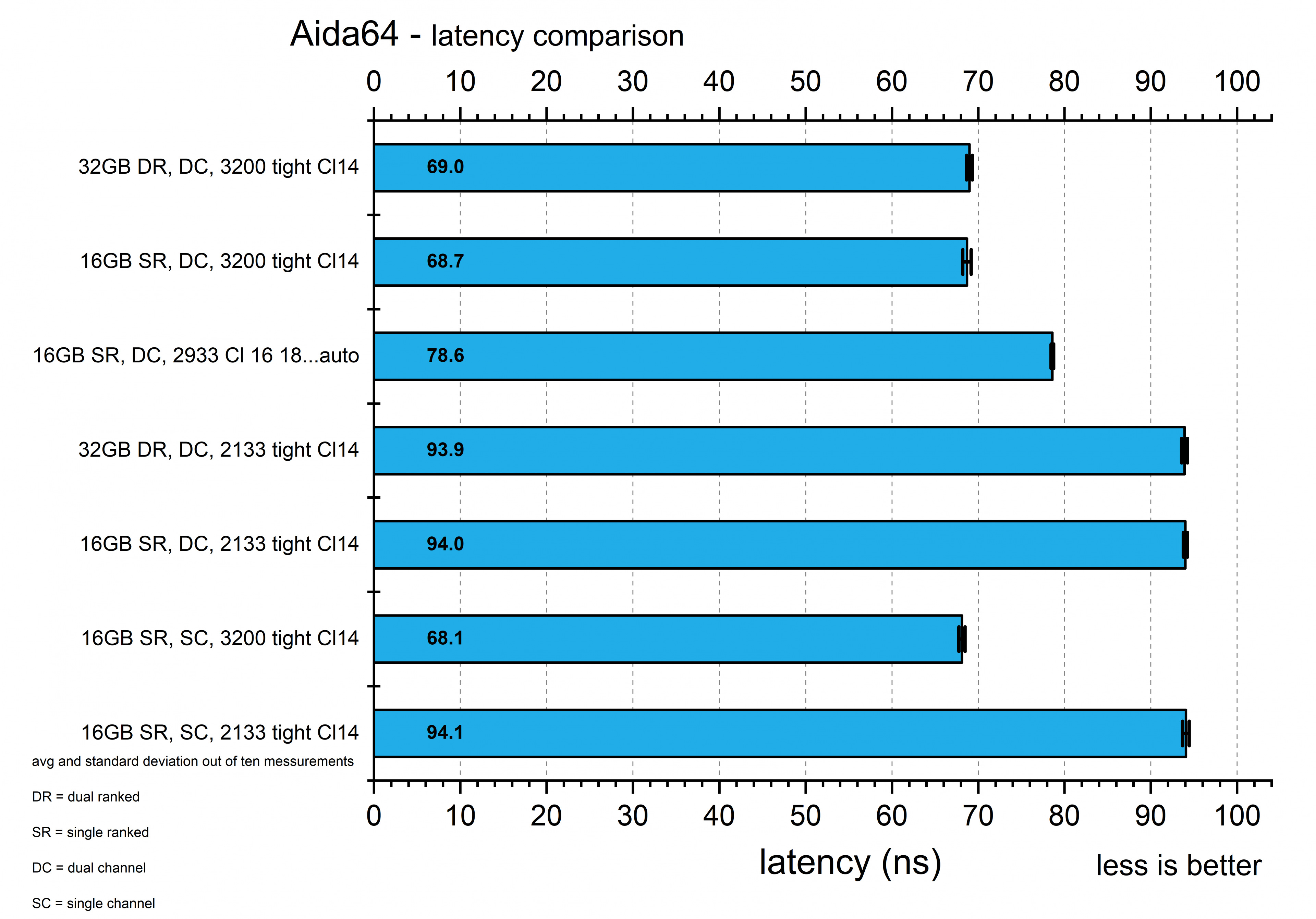

Anders als bei den Bandbreiten, scheinen hier SR und SC keine Nachteile zu haben.

Der SC Betrieb hat bei 3200 sogar die besten Werte, wobei man hier praktisch im Bereich der Messungenauigkeit liegt.

Die 2933 Cl16 liegen wieder im Mittelfeld. Ich hatte aufgrund der schlechteren Timings schlimmeres erwartet und bin positiv überrascht.

Die erhobenen Daten sind aus dem Juli/August 2018 und sind sicher gegen Meltdown und Spectre(nach aktuellem Wissensstand).

Windows 10 und Treiber waren aktuell, HPET aus, Energieoptionen auf Höchstleistung.

Mit diesen "theoretischen" Werten im Hinterkopf können wir und jetzt an die Auswertung der Spieleergebnisse machen....

Spieletests: Dual ranked vs. single ranked

Trotz meines enormen Aufwandes, sind nicht alle Daten so zuverlässig, dass sie eine Aussagekraft haben. Ich zeige daher erstmal nur die Daten die mir zuverlässig erscheinen und wer alles sehen möchte muss den Spoiler öffnen.

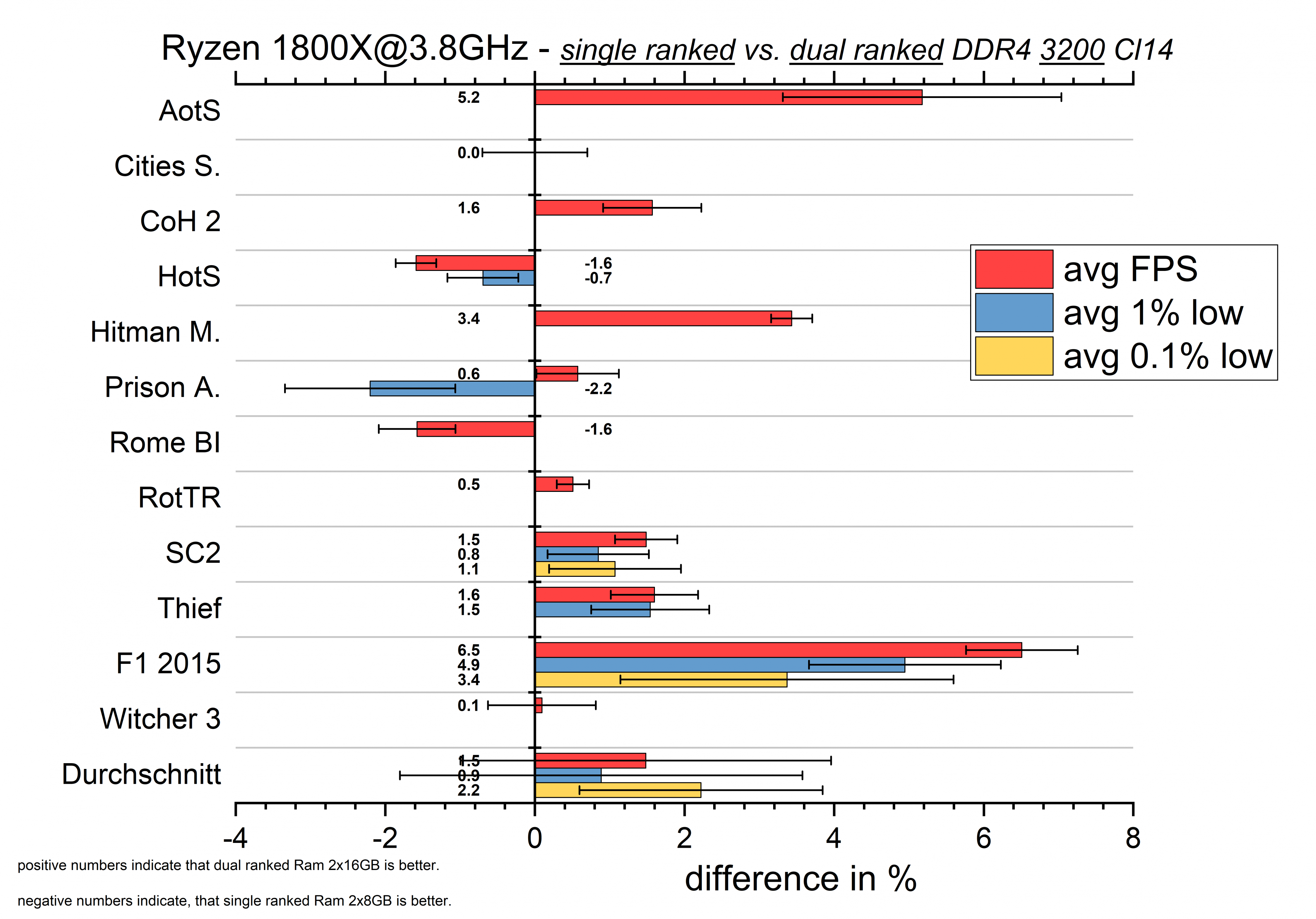

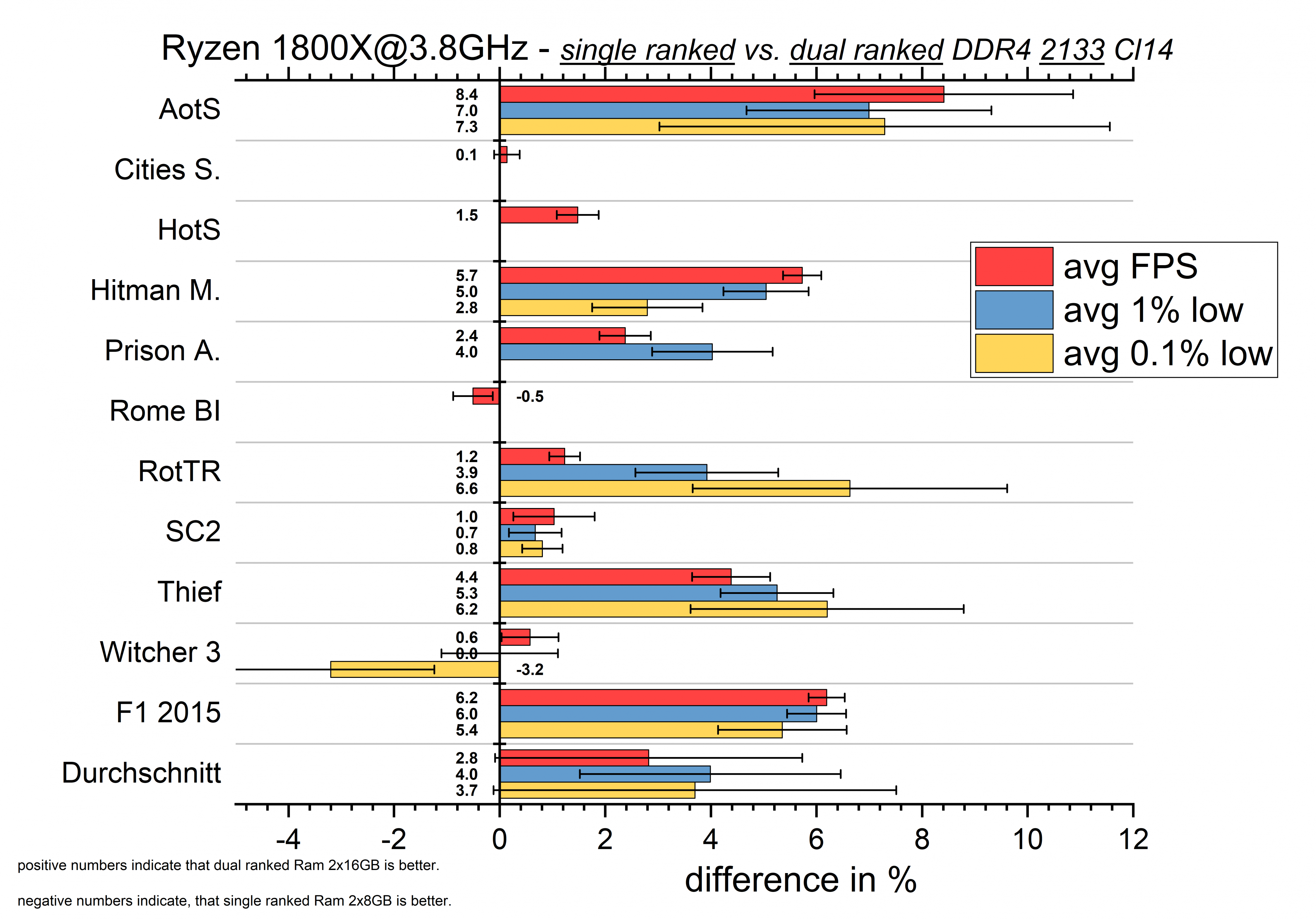

DR vs. SR bei 3200 Cl14:

Ich musste The Witcher 2 komplett rausnehmen und auch viele der 1% und 0.1% low Werte.

Die übrig gebliebenen Daten, zeigen ein paar Spiele, die durchaus gute Vorteile aus dual ranked Ram ziehen.

Ashes of the Singularity, Hitman und F1 2015 profitieren mit grob 3-6% in dem Bereich, in dem der Vorteil von DR beim Aida copy Test lag(6,6%).

Starcraft 2, CoH2 und Thief(vier) profitieren mit ungefär 1,5%.

ROTTR gewinnt minimal bei den avg FPS und wenn man die großen Fehlerbalken ignoriert(siehe spoiler) dann auch bei den Frametimes.

HotS und Rome BI verlieren leicht an Leistung. Eventuell eine Mischung aus den minimal besseren read und Latency Werten des SR Kits.

Bei Prison Architect sieht man einen winzigen Vorteil für DR bei den avg FPS aber leichte Nachteile bei den 1% low Werten.

Klingt erstmal nach einem Messfehler, aber dieser Zusammenhang zeigt sich auch in einer Reihe der ausgeblendeten Daten.

AotS, Cities Skylines, Prison Architect, Rome BI, Witcher 2 und witcher 3 zeigen alle stärkere Nachteile für DR bei den Frametimes in Vergleich zu den avg FPS!

Die ausgeblendeten Daten sind nicht ohne Grund ausgeblendet(große Fehlerbalken), aber in der Summe halte ich das durchaus für ein legitimes Ergebnis.

Aber schauen wir uns erst einaml den Vergleich bei 2133Mhz an:

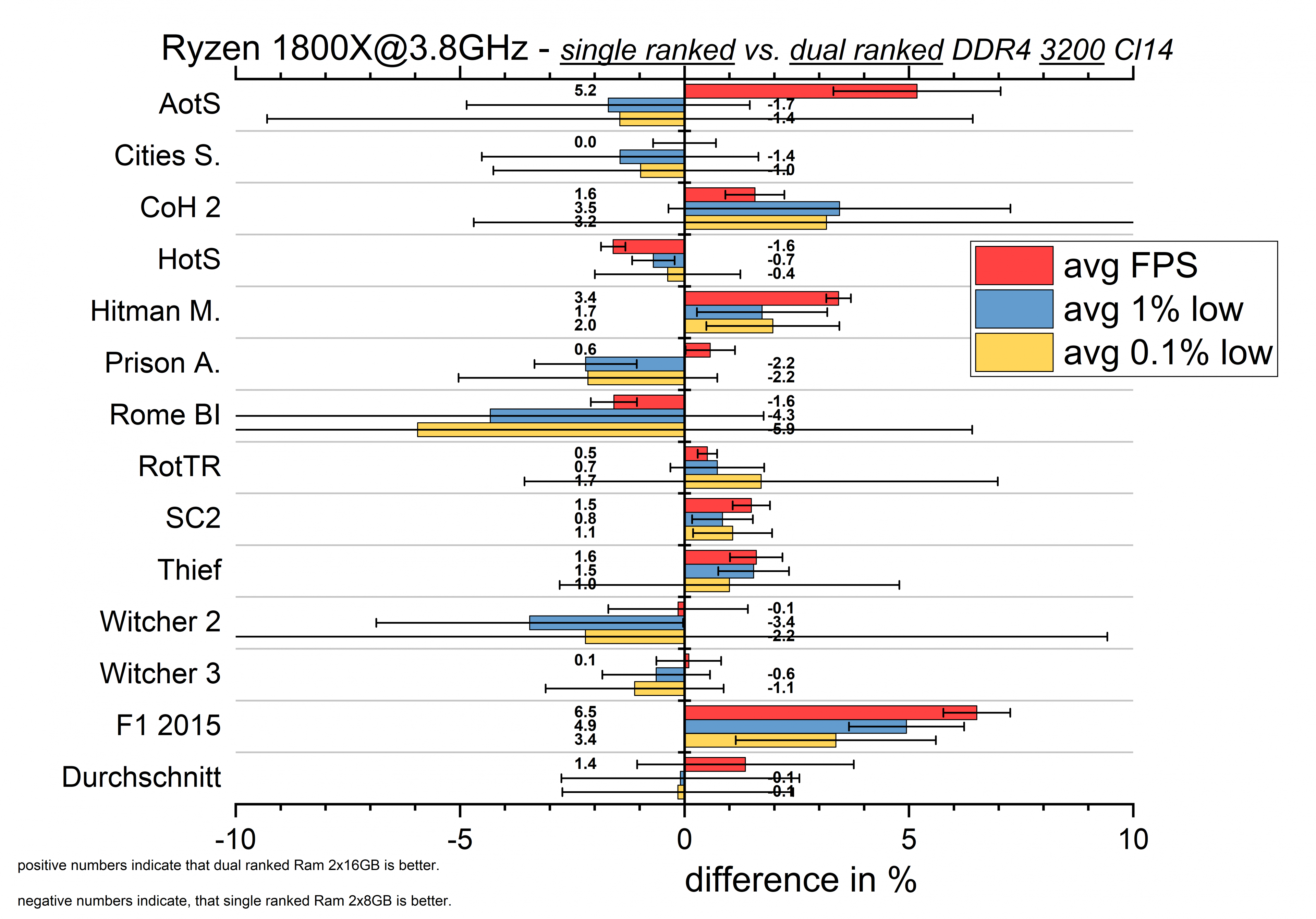

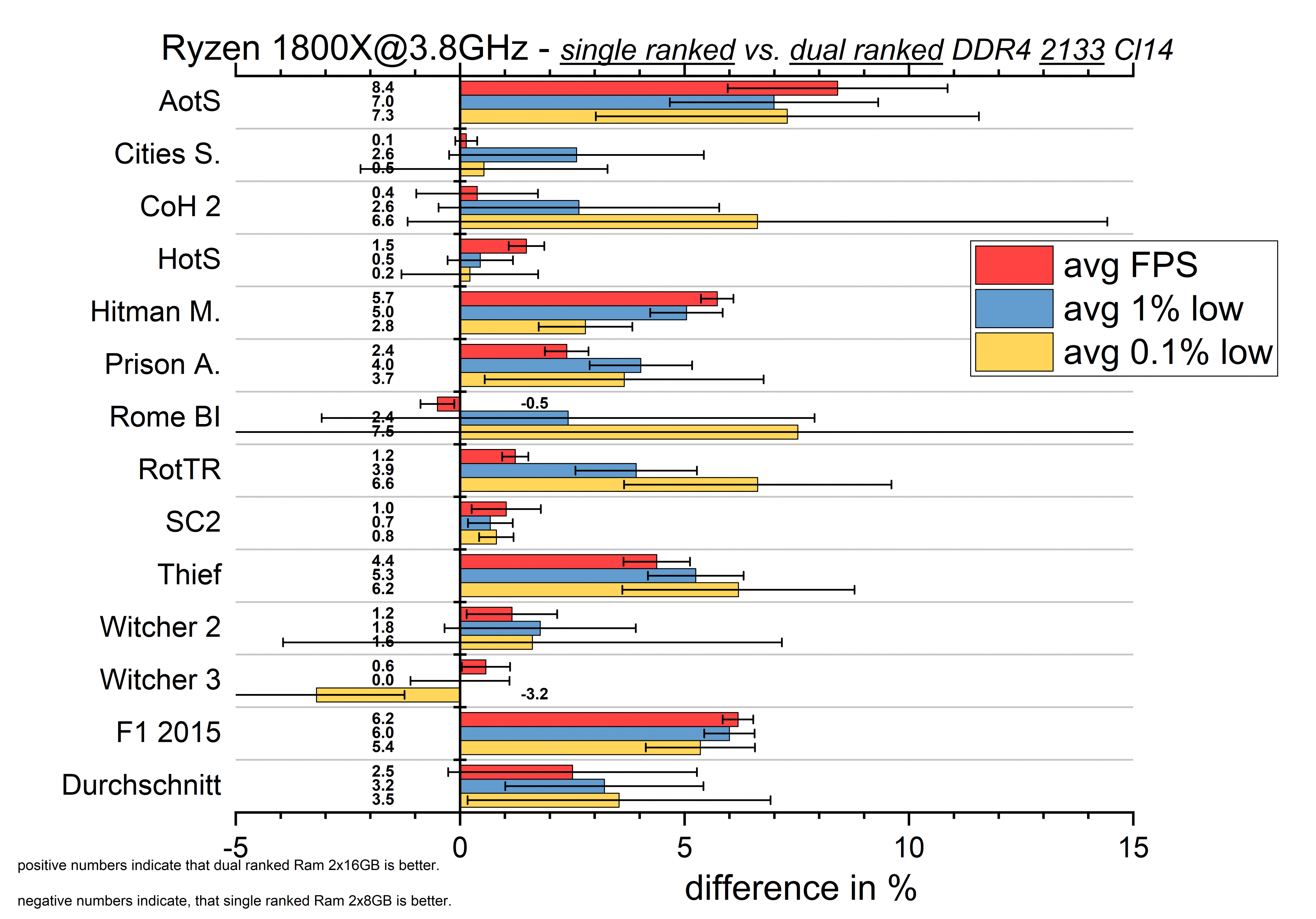

DR vs. SR bei 2133 Cl14:

Bei 2133 sehen wir praktisch nur Siege für den DR Ram.

Auch die Frametimes zeigen jetzt öfter größere Vorteile für DR als bei den avg FPS.

Lediglich The Witcher 3 hat schlechtere 0.1% low Werte, die jedoch auch mit einem sehr großen Fehler verbunden sind.

Und Rome ist noch minimal schlechter bei den avg Werten, jetzt aber tendenziell besser bei den Frametimes.

AotS, Hitman und F1 2015 sind weiterhin große Profitöre von dual ranked Ram. Die 5-8% sind wieder im Bereich der Aida copy Werte(7,1%).

Bis auf die Witcher 3/Rome Ausnahmen profitieren hier alle Spiele mehr oder weniger von DR.

Verglichen mit den Aida64 Ergebnissen passt das zusammen. Da hatte es mit 3200MHz noch leichte Vorteile für SR bei read und latency gegeben.

Mit 2133MHz waren diese Vorteile verschwunden und DR war in jedem Punkt besser, wenn auch nur bei Copy in einem signifikanten Bereich.

Bewertung der "dual ranked Mythen" und Fazit:

Die Antwort auf die Frage nach Vorteilen durch DR Ram bei Ryzen ist wie so oft: "Es kommt darauf an!"

Es ist deutlich geworden, das DR Vorteile bietet wenn es um das kopieren von Daten im Ram geht.

Das ist logisch, den mit mehr "ranks"(vier statt zwei bei DC Betrieb) die angesprochen werden können, (besteht einfacher die Möglichkeit direkt von einem in einen anderen rank zu kopieren.)Edit: bin mir nicht mehr sicher ob das so geht.

Was ein Vorteil ist, ist die Anzahl an Bank Groups, die dann die Wahrscheinlichkeit erhöhen zwei Operationen auf unterschiedlichen Gruppen durchzuführen, was deutlich schneller geht.

Verschiedene Spiele haben sicherlich verschiedene Anforderungen an den Ram und sobald oft/viele Daten kopiert werden müssen, kann der DR Ram seine Stärke ausspielen.

Eigentlich sollte DR Ram zusätzlich den Vorteil haben, seine ranks abwechselnd aufzufrischen.

Wenn ich das richtig verstanden habe wurde das Feature von AMD, in späteren Agesa Versionen, jedoch in Form von "BankgroupSwap" generell deaktiviert und durch BankGroupSwapAlt ersetzt. Warum man das gemacht hat ist mir schleierhaft. Zum release von Ryzen hatte ich mit meinem DR Ram größere Vorteile für enabled gesehen.

Test aus dem Internet haben mit SR Ram Nachteile gesehen und daher wurde es wohl abgeschaltet.Warum es sich aber nicht mehr manuell aktivieren lässt sobald man DR Ram hat ist unverständlich für mich.

Edit: mit den neuesten Bios Versionen mit Agesa 0.0.7.2 ist die Option wieder einstellbar.

Man kann nun GBS enabled nutzen, wenn man dafür GBSAlt disabled.

Ich habe es noch nicht ausreichend getestet, aber bis jetzt waren die Unterschiede gering bis nicht vorhanden.

Das muss ich aber noch weiter testen um hier eine zuverlässige Aussage treffen zu können, wie es sich aktuell auswirkt.

Nicht ganz klar ist, warum der SR Ram bei 3200 in Aida64 leicht besser bei den read und latency Werten ist, bei 2133 aber nicht.

Dies zeigt sich jedoch auch in den Spielen, die in einigen Beispielen bessere Frametimes für SR 3200er Ram zeigen.

Der Zusammenhang scheint logisch, so sind es doch gerade die Lese- und Reaktionszeiten die wichtig sind um unvorhergesehene Berechnungen mit Daten zu versorgen. Um so schneller dies geht um so weniger Nachteile hat es in den Frametimes.

Alles in allem kann ich die Mythen "Ryzen mag dual ranked Ram." und "Dual ranked Ram kann man nicht so hoch takten" bestätigen.

Vermutlich mag Intel ebenfalls DR Ram und auch bei Intel kann man DR nicht so hoch takten....bei Ryzen ist die Taktgrenze aber schneller erreicht.

Es stimmt auf jeden Fall, dass man auf Ryzen/AM4 DR nur schwer über 3200- eventuell 3333 bekommt. SR aber auf 3400- eventuell 3600MHz.(passenden Ram und Einstellungen vorausgesetzt)

Gerade bei 2133 aber auch bei 3200MHz zeigten sich Vorteile für DR in Spielen. Die Vorteile/Nachteile hängen stark von den vewendeten Spielen ab, weshalb ich nicht auf die durchschnittlichen Unterschiede eingehen möchte.

Der Durchschnitt hängt zu stark von meiner Spieleauswahl ab!

Wenn ich die Spiele in Kategorien einteile und versuche Muster zu erkennen, dann würde ich folgendes schlussfolgern:

- Größtenteils GPU limitierte Spiele wie The Witcher 3 und ROTTR mit 3200er Ram zeigen logischerweise keine sinnvollen Unterschiede.

- Moderne Spiele, die große Mengen an Textur und Effekt-Daten in und aus dem Ram kopieren, profitieren stärker von DR Ram.

Beispiele sind bei mir AotS, Hitman und F1 2015....und irgendwie auch Thief.....das sind all die Spiele, die in meinem Test zum single channel Betrieb die größten Einbußen hatten, also auf hohe Bandbreiten angewiesen sind.

-Die restlichen Spiele zeigen mal geringe Vorteile mal Nachteile.... Ich nehme an, dass es hier nicht den einen Faktor gibt der ausschlaggebend ist, es also eher eine undurchsichtige Mischung aus read, copy und latency ist.

- Alle Spiele haben bei 2133, im Vergleich zu 3200, eher DR bevorzugt. Oder anders gesagt verschwinden die Vorteile von DR zu hohen Ram Frequenzen immer mehr und Nachteile treten stärker hervor.

Was ist mit dem Mythos, das DR, je nachdem wen man fragt, mal "eine Frequenzstufe schneller" ist oder gar "2666 cl16 DR gleichauf mit 3200 CL14" sein soll?

Eine Taktstufe(266MHz) mehr ist sicherlich je nach Spiel drin.

Da das aber nur wenige Spiele sind wo DR deutlich profitiert!

Aber fast alle, CPU limitierten Spiele, profitieren generell von schnellerem Ramtakt. Daher sehe ich diesen Punkt nicht als wichtig an.

Ich kann besser 266MHz mehr Ram Speed bei SR haben und bei vielen Spielen besser und in manchen Spielen "nur" gleichauf mit DR sein,

als manchmal gleich gut und dann oft langsamer zu sein.

Ich habe nicht explizit DR 2666 CL16 getestet aber es wird sich grob in der Mitte zwischen 2133 und 3200 CL14 einfinden.

Schaue ich nur die Spiele an, wo DR 3-8% schneller ist bei gleichem Takt und gleichen Timings, und gucke wie viel diese von 2133 bis 3200MHZ CL14 profitiert haben, dann liege ich da im worst case von 2133 DR auf 3200 SR bei 19,1-25.9%. Die Hälfte davon wäre 9,5-12,9% und damit weit mehr als die 3-8%.

Die Daten von Golem.de halte ich also für falsch gemessen oder durch schlechte Subtimings bei deren 3200 CL14 SR Kit verfälscht.

3 von 4 Mythen bestätigt ist besser als meine Erwartungen an diese Testreihe.

Kaufberatung:

Was sind eure Meinungen dazu?

Habt ihr Verbesserungsvorschläge oder wollt ihr besimmte Sachen sehen, die ich hier nicht behandelt habe?

https://www.computerbase.de/forum/t...kussion-zu-spieletests.1728575/#post-20678303

Edit 2021: Dieser Test ist auf Zen und Zen+ CPUs bezogen.

Für die Zen3 CPUs gibt es Reviews, die extreme Vorteile für dual ranked zeigen.

Edit: Mit Zen3 CPUs zeigen manche Testberichte riesige Unterschiede von bis zu 15% die ich mit einem 5700X und einem 5800X3D nicht nachvollziehen konnte.

Anno 1800 reagiert überhaupt nicht auf dual ranked und Cyberpunk 2077 sind bei mir nur 2-6 wie sie auch hier mit Zen möglich sind.

Intro:

Seit dem Release der ersten Ryzen CPUs taucht immer wieder das Thema "dual ranked Ram" auf.

Aussagen wie: "Ryzen mag dual ranked.", "Dual ranked 2666MHz ist so schnell wie single ranked 3000." und "Dual ranked kann man nicht so hoch takten.", ließt man immer wieder und verlinked wurde fast immer folgende Quelle:

https://community.amd.com/community...emory-oc-showdown-frequency-vs-memory-timings

Es gibt aber noch eine Reihe weitere:

http://www.pcgameshardware.de/Ryzen-5-1600X-CPU-265842/Tests/R5-1500X-Review-Mainstream-1225280/3/

Bis zu diesem Test, wo dual ranked 2666 CL16 in einigen Spielen so schnell sein soll wie SR 3200 CL14:

https://www.golem.de/news/ram-overc...-von-ddr4-3200-und-dual-rank-1704-127262.html

Ich war bei Ryzen fast von Anfang an dabei und hatte 2x16GB 3200 Cl14er Ram, wobei die 16GB Module dual ranked sind.

Nach ein paar Bios updates und diversem herumprobieren, liefen die dann auch wie vorgesehen. Anders als diese alten Tests, kann ich also auch 3200MHz DR testen.

Ich bin bei den meisten Tests, die da gemacht wurden skeptisch, weil meine Erfahrung mit dem Ryzen Ram OC mir gezeigt haben, wie deutlich die Unterschiede sein können, wenn andere Subtimings verwendet werden.

Ein frühes Bios hat beim laden des Ram Profils so schlechte Subtimings gewählt, das 3200 CL14 langsamer war als 2400 Cl15.

Das hat sich dann später gebessert, aber das optimieren der Subtimings hat trotzdem noch einen ordentlichen Einfluss.

Ohne Angabe aller Timings oder zumindest einer Angabe, dass diese fest und gleich gewählt wurden, ergeben die Tests wenig Sinn.

Auch die CB Tests zu dual- vs. single ranked schenken den Subtimings keine Aufmerksamkeit(lassen sie auf Auto) und es wird auch nicht auf die Messgenauigkeiten und die genauen Testumstände eingegangen.

Man kann sicherlich argumentieren, dass diese Tests die Unterschiede zeigen. wie sie beim Kunden entstehen, der Ram XY kauft und das Ram Profil lädt.

Für mich gehört zum untersuchen eines Architekturunterschieds, aber auch möglichst viele Unbekannte auszuschließen und ein möglichst allgemeingültiges Ergebnis präsentieren zu können, wo ich eine Abschätzung über die Messungenauigkeit treffen kann und ich bin der Überzeugung, das Leue die sich um "Ram- ranks" Gedanken machen, sich auch solche Tests wünschen.

Daher wollte ich selbst testen und bei der Gelegenheit auch gleich noch dual channel gegen single channel Betrieb testen, sowie der Frage nach gehen, wie viel Leistung Leute opfern wenn sie den günstigen und einfachen Weg gehen und für ihr Ryzen System nur 3000MHz CL16er Ram kaufen und diesen mit XMP/docp Profil betreiben, anstatt 3200 Cl14(Samsung B die) zu kaufen und dann noch Mühe in das optimieren von Subtimings zu stecken....das aber in einem weiteren Artikel.

Was mir fehlte war ein SR Kit, das ich mir dann diese Jahr in Form von 2x8GB 3600 CL15 gekauft habe.

Natürlich war es kein Problem das SR Kit mit dem gleichen Takt und den gleichen Timings(alle 27, die ich in Bios wählen kann) wie mein DR Kit zu betreiben. Leider waren die ersten Tests, die ich gemacht habe nicht ausreichend genau um die oft feinen Unterschiede zuverlässig zu messen.

Wie ich meine Tests gemacht und verbessert habe:

Ursprünglich hatte ich für jede Hardwarekonfiguration in jedem Spiel 6 mal hintereinander die Frametimes gemessen.

Dann habe ich die erste Messung("Vormessung") verworfen, da sie in vielen Spielen mit Nachladerucklern zu kämpfen hat und dabei teilweise sogar höhere Durchschnitts-FPS liefert. Ein Mysterium, das ich auf polygonärmere/fehlende Strukturen und schlechtere Texturen schiebe, die bis zum hereinladen der besseren Versionen höhere FPS ermöglichen....oder durch mehr Platz im Cache weil dieser noch nicht so voll ist.....außerdem sind in Spielen, die die GPU stark beanspruchen, kurz nach dem Spielstart die Temperaturen besser und damit der Boost-Takt leicht höher.

Von den fünf verbleibenden Messungen hatte ich mit einem eigenen Auswertungsprogramm die Frametimes über diverse statistische Methoden analysiert.

Um bis zu zwei Ausreißer zu eliminieren bildet das Programm dann nur einen Mittelwert der jeweils besten drei Werte und eine empirische Standardabweichung dieser drei.

Ich denke, dass diese Methode bereits deutlich bessere Ergebnisse lieferte als die der meisten anderen CPU/Ram orientierten Spieletests.

Jedoch musste ich herausfinden, dass die Reproduzierbarkeit trotzdem nicht gut genug für meine Ansprüche war.

Bei den älteren Tests, wo ich Ryzen gegen einen ivy i5 oder 2133 gegen 3200MhzRam getestet habe, waren die Abstände in der Regel deutlich genug um Unterschiede klar zu erkennen.

Lediglich mein Versuch mit einer 2+2 gegen eine 4+0 Konfiguration des Ryzen bei unterschiedlichen Ram Frequenzen die Einflüsse des IF zu untersuchen scheiterte an der Genauigkeit.

Nun sollte es also deutlich genauer werden!

Also habe ich mein Programm erweitert um einen zweiten Satz von 5 Frametime Messungen einlesen und verarbeiten zu können.

Das Programm wertet beide Messungen erst getrennt voneinander aus, so wie schon vorher, und dann nimmt es aus beiden, jeweils die 3 Besten und kombiniert diese.

Es werden jetzt also von 10 Messungen, der Mittelwert von 6 Auserwählten gebildet.

Was sich dabei gezeigt hat, ist wie oft die Messungen einen systematischen Fehler bekommen. Auch wenn die einzelnen Messreihen in sich eine geringe statistischen Schwankung haben, können sie von Tag zu Tag merklich abweichen. Teils sogar sehr deutlich.

Ich bin auf Ursachenforschung gegangen und habe die verschiedenen Spiele mit aktivem OSD getestet. Habe festgestellt, dass das OSD selbst schon überraschend viel Leistung zieht...egal.... es ist bei den späteren Messungen aus.

Es war aber weiterhin schwer die teils einige % betragenden Abweichungen zu ergründen.

Bei einigen Spielen hat die Arbeit des Schedulers den Ausschlag gegeben. Manchmal wurde die Last auf einzelnen Kernen festgehalten...am nächsten Tag eher hin und her geschoben.....dann haben einige Spiele einzelne Kerne überlastet, indem zwei Threads des gleichen CPU Kerns gleichzeitig stark belastet wurden.

Mal wurden Threads des gleichen CCX benutzt und mal gemischt.

Kurz gesagt macht der Windows Scheduler, (vor allem bei älteren Spielen) einen miesen Job auf Ryzen CPUs!

Um dies reproduzierbarer zu machen, habe ich in allen Spielen, die nur wenige Threads benutzen die zugewiesenen CPU-Threads angepasst.

Heroes of the Storm, Starcraft 2, Prison Architect, The Witcher 2, Thief und Frostpunk wurden nur die Threads 0, 2, 4 und 6 zugewiesen.

Also nur 4 echte Kerne eines CCX. Keine Inter-core-Kommunikation über den Infinity Fabric und keine Probleme mit SMT.

Rome TW habe ich die Threads 0 und 1 zugewiesen, also beide Threads des gleichen Kerns und Company of Heroes hat alle Threads eines CCX bekommen also 0-7...auch wenn es besser läuft mit mehr Kernen und ohne SMT.

Ich versuche den Großteil meiner Tests im CPU limit zu machen und da versucht meine Vega64 natürlich Strom zu sparen und niedrigere PStates zu nutzen. Leider schätzt sie die Last immer mal unterschiedlich ein und taktet dann unterschiedlich weit runter und geht auch beim HBM2 mal auf 500MHz und mal nicht.

Um diese Verhalten zu stabilisieren, habe ich für die Benchmarks den P6 als niedrigsten PState festgelegt.

Da die Karte wassergekühlt ist, kommt sie nie in Situationen, wo sie zu heiß läuft. Da die Taktrate aber die Temperatur als ständigen Faktor in die Berrechnung einbezieht, kann ich nicht ausschließen, das der Takt von Messung zu Messung weiterhin leicht unterschiedlich ist. Die Unterschiede sind aber gering und werden im CPU Limit keine Rolle spielen.

Ein weiterer Punkt bei Ryzen ist der "sleep-Bug". Etwas das beim Wechsel in den Standby oder auch beim Herunterfahren unter Windows 10 passieren kann. Danach läuft der Timer falsch und da Frametimemessungen Zeitmessungen sind, fallen die Ergebnisse falsch aus.

Um dem vorzubeugen, habe ich den PC jeweils erst aus und wieder an gemacht und dann noch einen Neustart hinterhergeschoben.

Das an/aus bietet eine gleiche Ausgangsbasis und der Neustart behebt einen eventuell auftretenden Sleep Bug.

Interessanterweise konnte ich mehrere Male feststellen, das nach dem Prozedere die Messungen typische Werte ergaben, bei einem zweiten Neustart, die Ergebnisse jedoch viel zu gut ausgefallen sind. Und nach mehr und mehr Neustarts nährt man sich dann wieder immer mehr dem "Normalfall" an.

Sehr strange .

.

Ich habe eine saubere 1803 Win10 Installation aufgespielt.

Nur die Treiber und nötigsten Programme installiert und die HDD abgekoppelt um nur SSDs im System zu haben.

Ich musste Elex aus meiner Spieleauswahl streichen, da die (damaligen) Radeon Treiber einen Start des Spiels verhinderten .(Edit: ist inzwischen gefixed

.(Edit: ist inzwischen gefixed  )

)

Dafür habe ich Company of Heroes 2 und F1 2015 mit aufgenommen.

COH2 fand ich überraschend gut und es hat einen integrierten Benchmark. Leider hat der sich als notorisch unzuverlässig erwiesen.

Es gibt fast jedes mal im Benchmark heftige Frametimeausreißer, die aber eben nicht jedes Mal auftreten und machmal auch häufiger als üblich.

Ich musste also statt 6 Messungen je Durchgang eher 8-9 machen um dann nachträglich die zu guten und zu schlechten auszusortieren.

Dazu sind die Ladezeiten in den Benchmark und auch ins Menü quälend langsam...kurz gesagt werde ich das nicht nochmal testen .

.

F1 2015 wird bleiben...eine Startphase vom Ende des Feldes, bei Sturm, liefert eine hohe CPU Last und kann gut reproduzierbar sein...man darf nur keinen Unfall bauen oder sich von der KI abschießen lassen.

Auch die anderen Spiele habe ich öfter als vorher getestet(7-9 mal je Messreihe) und habe aktiv Ausreißer eliminiert um die "normalsten 5" in das Programm zu füttern. Das führ dazu, das jedes Set an Messungen in sich sehr zuverlässig wird.

Um auf 10 Messungen zu kommen habe ich das zweite Set an Messungen an einem anderen Tag oder zumindest mit Pause/Neustart/usw dazwischen durchgeführt.

Wenn die Auswertung von Set 1 zu Set 2 dann unterschiedliche Ergebnisse gezeigt haben, habe ich mir das notiert und an einem dritten Tag nochmal gemessen...oder noch an einem vierten Tag....um sicher zu gehen, das ich keine versaute Messreihe dazwischen habe.

Ausnahme ist Ashes of the Singularity, wo ich einfach 2x5 Messungen genommen habe ohne zusätzliche Messungen und manuelle Auswahl. Denn der integrierte Benchmark ist einfach mal gut und mal schlecht....mit ca. 40% Chance auf gut...und dann dauert er 3 min.....Ich habe ihn drin weil er große Unterschiede zeigt, dafür habe ich hier bei der Genauigkeit geschludert.

Bei ein paar Spielen habe ich die Messdauer verlängert.(Cities Skylines von 40 auf 50s, Prison Architect von 90 auf 120s)

Hitman hatte bei meinen Tests im März noch einen FPS limiter eingebaut. Dieser ist inzwischen rausgepatched und ich bin gleichzeitig von der Testszene in Paris auf eine Szene in Marrakesh umgestiegen. Die hat noch mehr NPCs auf einem Haufen und noch höhere CPU Last, die teilweise 8 Kerne voll auslastet.

Das alles über 13 Spiele hat mich sehr viel Zeit gekostet! ....über 1800 Messungen und da sind noch nicht die "Vormessungen" drin, die ich nicht aufgezeichnet habe und auch nicht die bei denen was schief gelaufen ist, so dass ich sie direkt gelöscht habe.

Zusammenfassung der Verbesserungen:

-Win10 neu installiert und auf Neustarts geachtet.

-Teils länger und immer mehr als doppelt bis dreimal so oft gemessen.

-CPU Threads festgelegt wo es Sinn ergeben hat.

-Messungen bei Bedarf von Hand sortiert.

-Vega am heruntertakten gehindert..

Spiel Einstellungen:

Hierbei habe ich mich nicht auf maximale FPS durch niedrige Auflösungen und Einstellungen konzentriert, sondern die Auflösung auf 1440p gelassen und nur in komplett CPU limiterten Spielen die maximalen Details genutzt.

Wo die Grafikkarte eine Rolle spielt, habe ich die Optionen individuell angepasst um einen guten Kompromiss aus Grafik und FPS um die 80-100 pro Sekunde zu finden.

Ich habe die Spiele also so eingestellt, wie ich sie selbst spielen würde und dann getestet welche Unterschiede sich bei diesen realen Situationen ergeben.

Die getesteten Szenen waren dabei natürlich so gewählt, dass sie für die CPU, typisch bis besonders anspruchsvoll, sind.

Dann habe ich die erste Messung("Vormessung") verworfen, da sie in vielen Spielen mit Nachladerucklern zu kämpfen hat und dabei teilweise sogar höhere Durchschnitts-FPS liefert. Ein Mysterium, das ich auf polygonärmere/fehlende Strukturen und schlechtere Texturen schiebe, die bis zum hereinladen der besseren Versionen höhere FPS ermöglichen....oder durch mehr Platz im Cache weil dieser noch nicht so voll ist.....außerdem sind in Spielen, die die GPU stark beanspruchen, kurz nach dem Spielstart die Temperaturen besser und damit der Boost-Takt leicht höher.

Von den fünf verbleibenden Messungen hatte ich mit einem eigenen Auswertungsprogramm die Frametimes über diverse statistische Methoden analysiert.

Um bis zu zwei Ausreißer zu eliminieren bildet das Programm dann nur einen Mittelwert der jeweils besten drei Werte und eine empirische Standardabweichung dieser drei.

Ich denke, dass diese Methode bereits deutlich bessere Ergebnisse lieferte als die der meisten anderen CPU/Ram orientierten Spieletests.

Jedoch musste ich herausfinden, dass die Reproduzierbarkeit trotzdem nicht gut genug für meine Ansprüche war.

Bei den älteren Tests, wo ich Ryzen gegen einen ivy i5 oder 2133 gegen 3200MhzRam getestet habe, waren die Abstände in der Regel deutlich genug um Unterschiede klar zu erkennen.

Lediglich mein Versuch mit einer 2+2 gegen eine 4+0 Konfiguration des Ryzen bei unterschiedlichen Ram Frequenzen die Einflüsse des IF zu untersuchen scheiterte an der Genauigkeit.

Nun sollte es also deutlich genauer werden!

Also habe ich mein Programm erweitert um einen zweiten Satz von 5 Frametime Messungen einlesen und verarbeiten zu können.

Das Programm wertet beide Messungen erst getrennt voneinander aus, so wie schon vorher, und dann nimmt es aus beiden, jeweils die 3 Besten und kombiniert diese.

Es werden jetzt also von 10 Messungen, der Mittelwert von 6 Auserwählten gebildet.

Was sich dabei gezeigt hat, ist wie oft die Messungen einen systematischen Fehler bekommen. Auch wenn die einzelnen Messreihen in sich eine geringe statistischen Schwankung haben, können sie von Tag zu Tag merklich abweichen. Teils sogar sehr deutlich.

Ich bin auf Ursachenforschung gegangen und habe die verschiedenen Spiele mit aktivem OSD getestet. Habe festgestellt, dass das OSD selbst schon überraschend viel Leistung zieht...egal.... es ist bei den späteren Messungen aus.

Es war aber weiterhin schwer die teils einige % betragenden Abweichungen zu ergründen.

Bei einigen Spielen hat die Arbeit des Schedulers den Ausschlag gegeben. Manchmal wurde die Last auf einzelnen Kernen festgehalten...am nächsten Tag eher hin und her geschoben.....dann haben einige Spiele einzelne Kerne überlastet, indem zwei Threads des gleichen CPU Kerns gleichzeitig stark belastet wurden.

Mal wurden Threads des gleichen CCX benutzt und mal gemischt.

Kurz gesagt macht der Windows Scheduler, (vor allem bei älteren Spielen) einen miesen Job auf Ryzen CPUs!

Um dies reproduzierbarer zu machen, habe ich in allen Spielen, die nur wenige Threads benutzen die zugewiesenen CPU-Threads angepasst.

Heroes of the Storm, Starcraft 2, Prison Architect, The Witcher 2, Thief und Frostpunk wurden nur die Threads 0, 2, 4 und 6 zugewiesen.

Also nur 4 echte Kerne eines CCX. Keine Inter-core-Kommunikation über den Infinity Fabric und keine Probleme mit SMT.

Rome TW habe ich die Threads 0 und 1 zugewiesen, also beide Threads des gleichen Kerns und Company of Heroes hat alle Threads eines CCX bekommen also 0-7...auch wenn es besser läuft mit mehr Kernen und ohne SMT.

Ich versuche den Großteil meiner Tests im CPU limit zu machen und da versucht meine Vega64 natürlich Strom zu sparen und niedrigere PStates zu nutzen. Leider schätzt sie die Last immer mal unterschiedlich ein und taktet dann unterschiedlich weit runter und geht auch beim HBM2 mal auf 500MHz und mal nicht.

Um diese Verhalten zu stabilisieren, habe ich für die Benchmarks den P6 als niedrigsten PState festgelegt.

Da die Karte wassergekühlt ist, kommt sie nie in Situationen, wo sie zu heiß läuft. Da die Taktrate aber die Temperatur als ständigen Faktor in die Berrechnung einbezieht, kann ich nicht ausschließen, das der Takt von Messung zu Messung weiterhin leicht unterschiedlich ist. Die Unterschiede sind aber gering und werden im CPU Limit keine Rolle spielen.

Ein weiterer Punkt bei Ryzen ist der "sleep-Bug". Etwas das beim Wechsel in den Standby oder auch beim Herunterfahren unter Windows 10 passieren kann. Danach läuft der Timer falsch und da Frametimemessungen Zeitmessungen sind, fallen die Ergebnisse falsch aus.

Um dem vorzubeugen, habe ich den PC jeweils erst aus und wieder an gemacht und dann noch einen Neustart hinterhergeschoben.

Das an/aus bietet eine gleiche Ausgangsbasis und der Neustart behebt einen eventuell auftretenden Sleep Bug.

Interessanterweise konnte ich mehrere Male feststellen, das nach dem Prozedere die Messungen typische Werte ergaben, bei einem zweiten Neustart, die Ergebnisse jedoch viel zu gut ausgefallen sind. Und nach mehr und mehr Neustarts nährt man sich dann wieder immer mehr dem "Normalfall" an.

Sehr strange

Ich habe eine saubere 1803 Win10 Installation aufgespielt.

Nur die Treiber und nötigsten Programme installiert und die HDD abgekoppelt um nur SSDs im System zu haben.

Ich musste Elex aus meiner Spieleauswahl streichen, da die (damaligen) Radeon Treiber einen Start des Spiels verhinderten

Dafür habe ich Company of Heroes 2 und F1 2015 mit aufgenommen.

COH2 fand ich überraschend gut und es hat einen integrierten Benchmark. Leider hat der sich als notorisch unzuverlässig erwiesen.

Es gibt fast jedes mal im Benchmark heftige Frametimeausreißer, die aber eben nicht jedes Mal auftreten und machmal auch häufiger als üblich.

Ich musste also statt 6 Messungen je Durchgang eher 8-9 machen um dann nachträglich die zu guten und zu schlechten auszusortieren.

Dazu sind die Ladezeiten in den Benchmark und auch ins Menü quälend langsam...kurz gesagt werde ich das nicht nochmal testen

F1 2015 wird bleiben...eine Startphase vom Ende des Feldes, bei Sturm, liefert eine hohe CPU Last und kann gut reproduzierbar sein...man darf nur keinen Unfall bauen oder sich von der KI abschießen lassen.

Auch die anderen Spiele habe ich öfter als vorher getestet(7-9 mal je Messreihe) und habe aktiv Ausreißer eliminiert um die "normalsten 5" in das Programm zu füttern. Das führ dazu, das jedes Set an Messungen in sich sehr zuverlässig wird.

Um auf 10 Messungen zu kommen habe ich das zweite Set an Messungen an einem anderen Tag oder zumindest mit Pause/Neustart/usw dazwischen durchgeführt.

Wenn die Auswertung von Set 1 zu Set 2 dann unterschiedliche Ergebnisse gezeigt haben, habe ich mir das notiert und an einem dritten Tag nochmal gemessen...oder noch an einem vierten Tag....um sicher zu gehen, das ich keine versaute Messreihe dazwischen habe.

Ausnahme ist Ashes of the Singularity, wo ich einfach 2x5 Messungen genommen habe ohne zusätzliche Messungen und manuelle Auswahl. Denn der integrierte Benchmark ist einfach mal gut und mal schlecht....mit ca. 40% Chance auf gut...und dann dauert er 3 min.....Ich habe ihn drin weil er große Unterschiede zeigt, dafür habe ich hier bei der Genauigkeit geschludert.

Bei ein paar Spielen habe ich die Messdauer verlängert.(Cities Skylines von 40 auf 50s, Prison Architect von 90 auf 120s)

Hitman hatte bei meinen Tests im März noch einen FPS limiter eingebaut. Dieser ist inzwischen rausgepatched und ich bin gleichzeitig von der Testszene in Paris auf eine Szene in Marrakesh umgestiegen. Die hat noch mehr NPCs auf einem Haufen und noch höhere CPU Last, die teilweise 8 Kerne voll auslastet.

Das alles über 13 Spiele hat mich sehr viel Zeit gekostet! ....über 1800 Messungen und da sind noch nicht die "Vormessungen" drin, die ich nicht aufgezeichnet habe und auch nicht die bei denen was schief gelaufen ist, so dass ich sie direkt gelöscht habe.

Zusammenfassung der Verbesserungen:

-Win10 neu installiert und auf Neustarts geachtet.

-Teils länger und immer mehr als doppelt bis dreimal so oft gemessen.

-CPU Threads festgelegt wo es Sinn ergeben hat.

-Messungen bei Bedarf von Hand sortiert.

-Vega am heruntertakten gehindert..

Spiel Einstellungen:

Hierbei habe ich mich nicht auf maximale FPS durch niedrige Auflösungen und Einstellungen konzentriert, sondern die Auflösung auf 1440p gelassen und nur in komplett CPU limiterten Spielen die maximalen Details genutzt.

Wo die Grafikkarte eine Rolle spielt, habe ich die Optionen individuell angepasst um einen guten Kompromiss aus Grafik und FPS um die 80-100 pro Sekunde zu finden.

Ich habe die Spiele also so eingestellt, wie ich sie selbst spielen würde und dann getestet welche Unterschiede sich bei diesen realen Situationen ergeben.

Die getesteten Szenen waren dabei natürlich so gewählt, dass sie für die CPU, typisch bis besonders anspruchsvoll, sind.

Benchmark Ergebnisse und neue Testsequenzen

Ich habe mich dazu entschieden die absoluten Frametimedaten und die Vorstellung der neuen Testsequenzen in einen extra Artikel auszulagern.

Dann kann ich mich hier auf die prozentualen Unterschiede von dual zu single ranked konzentrieren.

Ramtest-Session Juli/August 2018

.......................

Synthetische Benchmarks(Aida64)

An dieser Stelle nochmal ein kurzer Überblick über das verwendete System und die verwendeten Ramtimings:

Ein Ryzen 1800X mit Pstate OC auf 3,8GHz. 100.2MHz BCLk(für die optik). Ich musste für die sommerlichen Temperaturen etwas undervolting zurücknehmem und komme unter IBT Last auf 1,3-1,312V.

Asus Crosshair VI Hero @ Bios 6002

Vega64 LC mit custom Wasserkühlung für CPU und GPU. PT+50%, P7 = 1702MHz, 1050mV(resultiert in ca 1610MHz bei 1V),

HBM2@1050MHz, P6 als min gesetzt

2x16GB DR und 2x8GB SR DDR4 mit Samsung B-die

Sämtliche im Bios einstellbaren Timings wurden für die höchste effektive Ram Taktrate des DR Kits optimiert und manuell festgesetzt.

Und dann für das SR Kit gleich gewählt.

Die Timings für 2933 CL16 habe ich aus verschiedenen Angaben aus dem Internet für Aegis 3000 CL16er Ram entnommen und bei widersprüchlichen Angaben den Mittelwert eingestellt. Die Subtimings sind dabei ganz in Ordnung aber natürlich weit von "optimiert" entfernt....eben das was man bekommt wenn man das docp Profil lädt und es so lässt.

Kommen wir jetzt zu den Bandbreiten und Latenzen, die Aida misst:

Wie man sieht zeigen sich bei 3200MHz effektivem Ramtakt minimale aber reproduzierbare Vorteile für den SR Ram(1%) aber etwas Nachteile bei den Kopier-Werten(6,6%). Die Schreibraten waren praktisch im Bereich der Messungenauigkeit und daher als gleich anzusehen.

Ein ähnliches Bild zeigt sich bei 2133Mhz. Hier kann sich SR zwar nicht beim lesen absetzen und verliert minimal beim Schreiben, der deutliche Unterschied bleibt jedoch wieder der Kopierwert(7,1%).

Warum sich das Bild leicht verschiebt, könnte daran liegen, das sich die absoluten "Arbeitsschrittzeiten" gegeneinander unterschiedlich verschieben, sobald die Ram Frequenz geändert wird. Die Verhältnisse bleiben gleich, aber manche Subtimings sind bei 5 und andere bei 12.

Multipliziert mit der Zeit für einen Takt, wird der absolute Abstand größer und hat damit eventuell andere Einflüsse, wenn die Ram Frequenz sinkt.

Wenn die 8GB Riegel im single channel Modus gesteckt sind, sieht man wie sich die Bandbreiten fast halbieren. Ein erwartbares Ergebnis.

Die 2933 mit Cl 16 18 18 38er Timings positioniert sich mittig zwischen 2133 und 3200 Cl14.

Die Aufspaltung zwischen read und copy ist deutlich größer, was ich auf die Timings zurückzuführen würde.

Anders als bei den Bandbreiten, scheinen hier SR und SC keine Nachteile zu haben.

Der SC Betrieb hat bei 3200 sogar die besten Werte, wobei man hier praktisch im Bereich der Messungenauigkeit liegt.

Die 2933 Cl16 liegen wieder im Mittelfeld. Ich hatte aufgrund der schlechteren Timings schlimmeres erwartet und bin positiv überrascht.

Die erhobenen Daten sind aus dem Juli/August 2018 und sind sicher gegen Meltdown und Spectre(nach aktuellem Wissensstand).

Windows 10 und Treiber waren aktuell, HPET aus, Energieoptionen auf Höchstleistung.

Mit diesen "theoretischen" Werten im Hinterkopf können wir und jetzt an die Auswertung der Spieleergebnisse machen....

Spieletests: Dual ranked vs. single ranked

Trotz meines enormen Aufwandes, sind nicht alle Daten so zuverlässig, dass sie eine Aussagekraft haben. Ich zeige daher erstmal nur die Daten die mir zuverlässig erscheinen und wer alles sehen möchte muss den Spoiler öffnen.

DR vs. SR bei 3200 Cl14:

Ich musste The Witcher 2 komplett rausnehmen und auch viele der 1% und 0.1% low Werte.

Die übrig gebliebenen Daten, zeigen ein paar Spiele, die durchaus gute Vorteile aus dual ranked Ram ziehen.

Ashes of the Singularity, Hitman und F1 2015 profitieren mit grob 3-6% in dem Bereich, in dem der Vorteil von DR beim Aida copy Test lag(6,6%).

Starcraft 2, CoH2 und Thief(vier) profitieren mit ungefär 1,5%.

ROTTR gewinnt minimal bei den avg FPS und wenn man die großen Fehlerbalken ignoriert(siehe spoiler) dann auch bei den Frametimes.

HotS und Rome BI verlieren leicht an Leistung. Eventuell eine Mischung aus den minimal besseren read und Latency Werten des SR Kits.

Bei Prison Architect sieht man einen winzigen Vorteil für DR bei den avg FPS aber leichte Nachteile bei den 1% low Werten.

Klingt erstmal nach einem Messfehler, aber dieser Zusammenhang zeigt sich auch in einer Reihe der ausgeblendeten Daten.

AotS, Cities Skylines, Prison Architect, Rome BI, Witcher 2 und witcher 3 zeigen alle stärkere Nachteile für DR bei den Frametimes in Vergleich zu den avg FPS!

Die ausgeblendeten Daten sind nicht ohne Grund ausgeblendet(große Fehlerbalken), aber in der Summe halte ich das durchaus für ein legitimes Ergebnis.

Aber schauen wir uns erst einaml den Vergleich bei 2133Mhz an:

DR vs. SR bei 2133 Cl14:

Bei 2133 sehen wir praktisch nur Siege für den DR Ram.

Auch die Frametimes zeigen jetzt öfter größere Vorteile für DR als bei den avg FPS.

Lediglich The Witcher 3 hat schlechtere 0.1% low Werte, die jedoch auch mit einem sehr großen Fehler verbunden sind.

Und Rome ist noch minimal schlechter bei den avg Werten, jetzt aber tendenziell besser bei den Frametimes.

AotS, Hitman und F1 2015 sind weiterhin große Profitöre von dual ranked Ram. Die 5-8% sind wieder im Bereich der Aida copy Werte(7,1%).

Bis auf die Witcher 3/Rome Ausnahmen profitieren hier alle Spiele mehr oder weniger von DR.

Verglichen mit den Aida64 Ergebnissen passt das zusammen. Da hatte es mit 3200MHz noch leichte Vorteile für SR bei read und latency gegeben.

Mit 2133MHz waren diese Vorteile verschwunden und DR war in jedem Punkt besser, wenn auch nur bei Copy in einem signifikanten Bereich.

Bewertung der "dual ranked Mythen" und Fazit:

Die Antwort auf die Frage nach Vorteilen durch DR Ram bei Ryzen ist wie so oft: "Es kommt darauf an!"

Es ist deutlich geworden, das DR Vorteile bietet wenn es um das kopieren von Daten im Ram geht.

Das ist logisch, den mit mehr "ranks"(vier statt zwei bei DC Betrieb) die angesprochen werden können, (besteht einfacher die Möglichkeit direkt von einem in einen anderen rank zu kopieren.)Edit: bin mir nicht mehr sicher ob das so geht.

Was ein Vorteil ist, ist die Anzahl an Bank Groups, die dann die Wahrscheinlichkeit erhöhen zwei Operationen auf unterschiedlichen Gruppen durchzuführen, was deutlich schneller geht.

Verschiedene Spiele haben sicherlich verschiedene Anforderungen an den Ram und sobald oft/viele Daten kopiert werden müssen, kann der DR Ram seine Stärke ausspielen.

Eigentlich sollte DR Ram zusätzlich den Vorteil haben, seine ranks abwechselnd aufzufrischen.

Wenn ich das richtig verstanden habe wurde das Feature von AMD, in späteren Agesa Versionen, jedoch in Form von "BankgroupSwap" generell deaktiviert und durch BankGroupSwapAlt ersetzt. Warum man das gemacht hat ist mir schleierhaft. Zum release von Ryzen hatte ich mit meinem DR Ram größere Vorteile für enabled gesehen.

Test aus dem Internet haben mit SR Ram Nachteile gesehen und daher wurde es wohl abgeschaltet.

Edit: mit den neuesten Bios Versionen mit Agesa 0.0.7.2 ist die Option wieder einstellbar.

Man kann nun GBS enabled nutzen, wenn man dafür GBSAlt disabled.

Ich habe es noch nicht ausreichend getestet, aber bis jetzt waren die Unterschiede gering bis nicht vorhanden.

Das muss ich aber noch weiter testen um hier eine zuverlässige Aussage treffen zu können, wie es sich aktuell auswirkt.

Nicht ganz klar ist, warum der SR Ram bei 3200 in Aida64 leicht besser bei den read und latency Werten ist, bei 2133 aber nicht.

Dies zeigt sich jedoch auch in den Spielen, die in einigen Beispielen bessere Frametimes für SR 3200er Ram zeigen.

Der Zusammenhang scheint logisch, so sind es doch gerade die Lese- und Reaktionszeiten die wichtig sind um unvorhergesehene Berechnungen mit Daten zu versorgen. Um so schneller dies geht um so weniger Nachteile hat es in den Frametimes.

Alles in allem kann ich die Mythen "Ryzen mag dual ranked Ram." und "Dual ranked Ram kann man nicht so hoch takten" bestätigen.

Vermutlich mag Intel ebenfalls DR Ram und auch bei Intel kann man DR nicht so hoch takten....bei Ryzen ist die Taktgrenze aber schneller erreicht.

Es stimmt auf jeden Fall, dass man auf Ryzen/AM4 DR nur schwer über 3200- eventuell 3333 bekommt. SR aber auf 3400- eventuell 3600MHz.(passenden Ram und Einstellungen vorausgesetzt)

Gerade bei 2133 aber auch bei 3200MHz zeigten sich Vorteile für DR in Spielen. Die Vorteile/Nachteile hängen stark von den vewendeten Spielen ab, weshalb ich nicht auf die durchschnittlichen Unterschiede eingehen möchte.

Der Durchschnitt hängt zu stark von meiner Spieleauswahl ab!

Wenn ich die Spiele in Kategorien einteile und versuche Muster zu erkennen, dann würde ich folgendes schlussfolgern:

- Größtenteils GPU limitierte Spiele wie The Witcher 3 und ROTTR mit 3200er Ram zeigen logischerweise keine sinnvollen Unterschiede.

- Moderne Spiele, die große Mengen an Textur und Effekt-Daten in und aus dem Ram kopieren, profitieren stärker von DR Ram.

Beispiele sind bei mir AotS, Hitman und F1 2015....und irgendwie auch Thief.....das sind all die Spiele, die in meinem Test zum single channel Betrieb die größten Einbußen hatten, also auf hohe Bandbreiten angewiesen sind.

-Die restlichen Spiele zeigen mal geringe Vorteile mal Nachteile.... Ich nehme an, dass es hier nicht den einen Faktor gibt der ausschlaggebend ist, es also eher eine undurchsichtige Mischung aus read, copy und latency ist.

- Alle Spiele haben bei 2133, im Vergleich zu 3200, eher DR bevorzugt. Oder anders gesagt verschwinden die Vorteile von DR zu hohen Ram Frequenzen immer mehr und Nachteile treten stärker hervor.

Was ist mit dem Mythos, das DR, je nachdem wen man fragt, mal "eine Frequenzstufe schneller" ist oder gar "2666 cl16 DR gleichauf mit 3200 CL14" sein soll?

Eine Taktstufe(266MHz) mehr ist sicherlich je nach Spiel drin.

Da das aber nur wenige Spiele sind wo DR deutlich profitiert!

Aber fast alle, CPU limitierten Spiele, profitieren generell von schnellerem Ramtakt. Daher sehe ich diesen Punkt nicht als wichtig an.

Ich kann besser 266MHz mehr Ram Speed bei SR haben und bei vielen Spielen besser und in manchen Spielen "nur" gleichauf mit DR sein,

als manchmal gleich gut und dann oft langsamer zu sein.

Ich habe nicht explizit DR 2666 CL16 getestet aber es wird sich grob in der Mitte zwischen 2133 und 3200 CL14 einfinden.

Schaue ich nur die Spiele an, wo DR 3-8% schneller ist bei gleichem Takt und gleichen Timings, und gucke wie viel diese von 2133 bis 3200MHZ CL14 profitiert haben, dann liege ich da im worst case von 2133 DR auf 3200 SR bei 19,1-25.9%. Die Hälfte davon wäre 9,5-12,9% und damit weit mehr als die 3-8%.

Die Daten von Golem.de halte ich also für falsch gemessen oder durch schlechte Subtimings bei deren 3200 CL14 SR Kit verfälscht.

3 von 4 Mythen bestätigt ist besser als meine Erwartungen an diese Testreihe.

Kaufberatung:

Als Kaufempfehlung bezüglich DR oder SR Ram komme ich zu folgender Einschätzung:

Wenn ihr schnelle 32GB Ram haben wollt, dann seid ihr mit 2x16GB DR bis 3200MHz gut bedient.

4x8GB SR habe ich inzwischen selbst besorgt und sie zeigen das gleiche Verhalten wie die 2x16GB.

Denn zwei single ranked Module pro Ram-Channel ergeben, aus Sicht der Ramkontrollers, auch wieder "dual ranked".

Ich konnte auf meinem Crosshair VI Hero die 4x8GB auf 3466 cl14 bringen. Die 2x16GB nur auf 3266 CL14.

Jedoch ist mein Mainboard mit sogenannter T-Topology aufgebaut...diese Art der Datenverbindung zum Ram hat die bessere Signalqualität bei Vollbestückung....und schlechterer bei nur zwei Modulen.

Fast alle X470er und wohl auch die kommenden X570er Mainboards haben einen Daisychain Aufbau, welcher zwei Module bevorzugt.

Wenn ihr den maximalen Ramtakt wollt und euch 16GB reichen, dann nehmt ein Daisychain Mainboard mit 2x8GB SR.

Wenn ihr 32GB wollt, dann solltet ihr bei einem Daisychain Board 2x16GB und bei T-Topology 4x8GB wählen.

Hohe Ramtakte zu erreichen ist jedoch immer eine Herausforderung und das anpassen der Timings eine langwierige Aufgabe. Ohne Spaß an der Sache lohnt sich das ausloten des maximal möglichen nicht unbedingt.

Der Ryzen DRam Calculator kann euch helfen schnell gute Ergebnisse zu erreichen.

Mit den kommenden Zen2 CPUs und den neueren X570 Mainboards sagen die Gerüchte ein besseres OC Potential vorraus. Im Moment gibt es

Curios meinte das man 4x SR sogar auf 3600MHz hoch bekommen kann, was ich noch bei keinem DR Kit gesehen habe. Dementsprechend scheinen dies durchaus die schnellsten 32GB zu sein, gesetzt den Fall dass man sie zum laufen bekommt....bei mir leider nicht.

Mischbestückungen von DR und SR waren für mich nur schwer zum laufen zu bringen...48GB aus meinen beiden Kits konnte ich irgendwann mit 3200 zum laufen bringen, aber mit Einbußen bei den Timings und nicht 100% stabil. 4x16GB haben hier im Forum auch schon Leute bei 3200MHz stabil bekommen. Aber auch da mit sehr viel Arbeit.

Wenn ihr die maximale Leistung aus eurem Ryzen System quetschen wollt, empfehle ich hoch taktenden 2x8GB SR 3600 CL15er Ram.

Erwartet nicht, diesen auch mit 3600 zum laufen zu bekommen aber ich konnte 3466 mit guten Subtimings aus diesem Test zum laufen bringen. Das ist in jeder Hinsicht schneller als DR 3200.

Wenn euer Budget nicht nach oben hin offen ist und ihr nicht Stunden bis Tage mit dem Einstellen und testen eures Ram verbringen wollt, machen diese Optionen allerdings keine Sinn. Dann solltet ihr nach günstigeren Alternativen Ausschau halten.

3200 Cl16 ist in der Regel kein Samsung B-die Ram und läuft daher oft nicht problemlos auf 3200.

Man kann also gleich noch mehr Geld sparen und lieber 3000 CL15/16 SR kaufen. Mit neuen Bios Versionen sehe ich nur noch sehr selten Probleme mit 2933/3000MHz. Diese laufen fast immer durch laden des XMP/docp Profils und wie meine Tests gezeigt haben, ist man selbst mit schlechten Cl 16 18 18 38, mittig zwischen 2133 und 3200MHz mit optimiertem Samsung B-die Ram...im Schnitt zwar grob 9% langsamer, dafür über 70€ und vielen Stunden Ram einstellen günstiger.

Ein guter Kompromis, denn die 70€ kann man in eine bessere Grafikkarte stecken, die in neuen Spielen eh mehr bringt und die Zeit kann man mit Spielen verbringen.

Will man aus irgend einem Grund nur eine bestimmte niedrigere Ram Frequenz(z.B. 2666). Dann sollte der Preis entscheiden ob 2x8GB DR oder SR gekauft wird. DR wäre aus meiner Sicht ein paar € mehr Wert aber meiner Meinung nach kann man dann besser schnelleren SR Ram kaufen.

Wer stark aufs Geld achten muss, der sollte zumindest 2666 CL15 oder 16 kaufen!

Vermeiden sollte man meiner Meinung nach teuren Samsung B-die zu kaufen und dann nicht die Timings und Subtimings zu optimieren!

Wer also sowas wie 3200 CL14 gekauft hat, der sollte sich zumindest eine Weile mit optimieren beschäftigen. Denn die docp Profile für 3200 stellen nur so mittelmäßige Subtimings ein. Dann liegt man Leistungstechnisch nur auf halbem Weg zwischen 2933 CL16 und optimierten 3200. Dann lieber das Geld sparen^^.

Es gibt für Ryzen inzwischen viele Hilfsmittel zum optimieren. Der Ryzen Timing Checker(RTC) ließt alles wichtige unter Windows aus und ihr könnt einen Screenshot im Forum posten damit andere euch helfen können. Vorher solltet ihr versuchen euch selbst zu helfen .

.

Und das oben genannte Tool namens Ryzen Dram calculator, das euch auf Erfahrungswerten und Berechnungen basierend save, fast und extreme Timings sowie weitere Einstellungen vorschlägt. Man kann das Programm das XMP Profil auslesen lassen, eintragen ob man DR oder SR Ram hat und die fast Werte probieren. Bei mir gingen nicht alle der extrem Timings aber oft eine Mischung aus fast und Extrem. Da fängt dann die Arbeit an für die letzten paar Funken Leistung...stellt man die fast Timings ein, ist das aber auch schon eine tolle Sache und schnell gemacht...diese Zeit sollte man investieren.

Und dann kommt das wichtigste! Auf Stabilität testen!

Memtest86 kann den kompletten Ram testen, verursacht aber keine so große Last wie andere Tests und findet daher nur schwer kleine Instabilitäten.

Ich bin ein Fan von HCI Memtest(trial version). Das muss man aber so oft aufmachen wie man CPU Kerne hat, damit es auch eine hohe Ram Belastung verursacht. Je Instanz sollte man möglichst viel Ram zuweisen aber es geht nicht über 2000MB(trial version) und insgesamt darf nicht mehr Ram getestet werden als vorhanden(sonst hagelt es Fehler).

Schlimme Instabilitäten kommen dann unter 10% und leichte bis 200%. Wenn dann noch nichts war dann ging es bei mir auch über 800% gut. Aussagen wie "mindestens bis 10000% testen" halte ich für übertrieben....da dann besser Doppelbelastung mit anderen Programmen verursachen.

Natürlich sollte erstmal sicher sein, dass die CPU voll stabil ist, wobei man aufpassen muss, da schnellerer Ram auch die CPU besser auslastet und ein CPU OC das mit langsamem Ram stabil war wird mit Ram OC eventuell instabil.

Zusammenfassung zur Kaufberatung:

Will ich 16GB:

-bei weniger Budget 2x8GB 3000 Cl15 oder 16.

-bei großem Budget 2x8GB 3200 Cl14 oder andere Samsung B-die Riegel, die sich aber nur lohnen, wenn man manuell an den Subtimings anfasst.

-Alternativ gibt es auch vermehrt Berichte, von anderen schnellen Ram Riegeln, die auf Ryzen gute Leistungen durch OC erzielen....

Will ich 32GB:

Je nach Board(T-topology oder Daisy chain) 2x16 DR oder 4x8GB SR

-bei kleinem Budget würde ich 3200 Cl16 kaufen und versuchen 3000 CL16 damit zum laufen zu bringen.

-bei großem Budget würde ich 3200 Cl14 nehmen und manuell die Subtimings anpassen.

-Alternativ gibt es inzwischen auch 16GB Riegel die SR sind.... die gibt es noch nicht mit so guten Timings zu kaufen(nur 3200 Cl16) und ich habe noch keine Erfahrungen zur Übertaktbarkeit gefunden.

2x16GB SR klingen für hohe Taktraten mit 32GB aber gut.

Will ich 64GB:

Dann sollte Geld egal sein.

Ohne es selbst getestet zu haben, würde ich das nur mit einem T-Topology Board und 4x16GB SR machen.

Auch 4x16GB DR können auf 3200MHz gehen, wenn man viel Zeit investiert, aber eigentlich würde ich davon abraten das mit AM4 zu machen. Dann lieber den Aufpreis zu Threadripper zahlen.

Wenn die Zen2 CPUs kommen dürfte sich die Situation nochmal ändern.

Dann könnte es auch wichtig werden, wie die Ramriegel aufgebaut sind.

Dabei gibt es verschiedene Varianten.

So ist A2 eine Variante mit zwei Blöcken a vier Ramchips rechts und links auf dem Riegel...… Diese Variante soll bessere Taktraten, aber eher schlechtere Timings schaffen.

A0/A1 hat alle Ram Chips gleichmäßig über die Breite der Riegels verteilt und soll bessere Timings, aber eher schlechteren Takt schaffen....

Wenn Zen2 höhere Taktraten erreichen kann, könnte A2 die bessere Variante sein....im Moment sehe ich das eher als unwichtig an, aber da kenne ich mich auch zu wenig im Detail aus.

Wenn ihr schnelle 32GB Ram haben wollt, dann seid ihr mit 2x16GB DR bis 3200MHz gut bedient.

4x8GB SR habe ich inzwischen selbst besorgt und sie zeigen das gleiche Verhalten wie die 2x16GB.

Denn zwei single ranked Module pro Ram-Channel ergeben, aus Sicht der Ramkontrollers, auch wieder "dual ranked".

Ich konnte auf meinem Crosshair VI Hero die 4x8GB auf 3466 cl14 bringen. Die 2x16GB nur auf 3266 CL14.

Jedoch ist mein Mainboard mit sogenannter T-Topology aufgebaut...diese Art der Datenverbindung zum Ram hat die bessere Signalqualität bei Vollbestückung....und schlechterer bei nur zwei Modulen.

Fast alle X470er und wohl auch die kommenden X570er Mainboards haben einen Daisychain Aufbau, welcher zwei Module bevorzugt.

Wenn ihr den maximalen Ramtakt wollt und euch 16GB reichen, dann nehmt ein Daisychain Mainboard mit 2x8GB SR.

Wenn ihr 32GB wollt, dann solltet ihr bei einem Daisychain Board 2x16GB und bei T-Topology 4x8GB wählen.

Hohe Ramtakte zu erreichen ist jedoch immer eine Herausforderung und das anpassen der Timings eine langwierige Aufgabe. Ohne Spaß an der Sache lohnt sich das ausloten des maximal möglichen nicht unbedingt.

Der Ryzen DRam Calculator kann euch helfen schnell gute Ergebnisse zu erreichen.

Mit den kommenden Zen2 CPUs und den neueren X570 Mainboards sagen die Gerüchte ein besseres OC Potential vorraus. Im Moment gibt es

Curios meinte das man 4x SR sogar auf 3600MHz hoch bekommen kann, was ich noch bei keinem DR Kit gesehen habe. Dementsprechend scheinen dies durchaus die schnellsten 32GB zu sein, gesetzt den Fall dass man sie zum laufen bekommt....bei mir leider nicht.

Mischbestückungen von DR und SR waren für mich nur schwer zum laufen zu bringen...48GB aus meinen beiden Kits konnte ich irgendwann mit 3200 zum laufen bringen, aber mit Einbußen bei den Timings und nicht 100% stabil. 4x16GB haben hier im Forum auch schon Leute bei 3200MHz stabil bekommen. Aber auch da mit sehr viel Arbeit.

Wenn ihr die maximale Leistung aus eurem Ryzen System quetschen wollt, empfehle ich hoch taktenden 2x8GB SR 3600 CL15er Ram.

Erwartet nicht, diesen auch mit 3600 zum laufen zu bekommen aber ich konnte 3466 mit guten Subtimings aus diesem Test zum laufen bringen. Das ist in jeder Hinsicht schneller als DR 3200.

Wenn euer Budget nicht nach oben hin offen ist und ihr nicht Stunden bis Tage mit dem Einstellen und testen eures Ram verbringen wollt, machen diese Optionen allerdings keine Sinn. Dann solltet ihr nach günstigeren Alternativen Ausschau halten.

3200 Cl16 ist in der Regel kein Samsung B-die Ram und läuft daher oft nicht problemlos auf 3200.

Man kann also gleich noch mehr Geld sparen und lieber 3000 CL15/16 SR kaufen. Mit neuen Bios Versionen sehe ich nur noch sehr selten Probleme mit 2933/3000MHz. Diese laufen fast immer durch laden des XMP/docp Profils und wie meine Tests gezeigt haben, ist man selbst mit schlechten Cl 16 18 18 38, mittig zwischen 2133 und 3200MHz mit optimiertem Samsung B-die Ram...im Schnitt zwar grob 9% langsamer, dafür über 70€ und vielen Stunden Ram einstellen günstiger.

Ein guter Kompromis, denn die 70€ kann man in eine bessere Grafikkarte stecken, die in neuen Spielen eh mehr bringt und die Zeit kann man mit Spielen verbringen.

Will man aus irgend einem Grund nur eine bestimmte niedrigere Ram Frequenz(z.B. 2666). Dann sollte der Preis entscheiden ob 2x8GB DR oder SR gekauft wird. DR wäre aus meiner Sicht ein paar € mehr Wert aber meiner Meinung nach kann man dann besser schnelleren SR Ram kaufen.

Wer stark aufs Geld achten muss, der sollte zumindest 2666 CL15 oder 16 kaufen!

Vermeiden sollte man meiner Meinung nach teuren Samsung B-die zu kaufen und dann nicht die Timings und Subtimings zu optimieren!

Wer also sowas wie 3200 CL14 gekauft hat, der sollte sich zumindest eine Weile mit optimieren beschäftigen. Denn die docp Profile für 3200 stellen nur so mittelmäßige Subtimings ein. Dann liegt man Leistungstechnisch nur auf halbem Weg zwischen 2933 CL16 und optimierten 3200. Dann lieber das Geld sparen^^.

Es gibt für Ryzen inzwischen viele Hilfsmittel zum optimieren. Der Ryzen Timing Checker(RTC) ließt alles wichtige unter Windows aus und ihr könnt einen Screenshot im Forum posten damit andere euch helfen können. Vorher solltet ihr versuchen euch selbst zu helfen

Und das oben genannte Tool namens Ryzen Dram calculator, das euch auf Erfahrungswerten und Berechnungen basierend save, fast und extreme Timings sowie weitere Einstellungen vorschlägt. Man kann das Programm das XMP Profil auslesen lassen, eintragen ob man DR oder SR Ram hat und die fast Werte probieren. Bei mir gingen nicht alle der extrem Timings aber oft eine Mischung aus fast und Extrem. Da fängt dann die Arbeit an für die letzten paar Funken Leistung...stellt man die fast Timings ein, ist das aber auch schon eine tolle Sache und schnell gemacht...diese Zeit sollte man investieren.

Und dann kommt das wichtigste! Auf Stabilität testen!

Memtest86 kann den kompletten Ram testen, verursacht aber keine so große Last wie andere Tests und findet daher nur schwer kleine Instabilitäten.

Ich bin ein Fan von HCI Memtest(trial version). Das muss man aber so oft aufmachen wie man CPU Kerne hat, damit es auch eine hohe Ram Belastung verursacht. Je Instanz sollte man möglichst viel Ram zuweisen aber es geht nicht über 2000MB(trial version) und insgesamt darf nicht mehr Ram getestet werden als vorhanden(sonst hagelt es Fehler).

Schlimme Instabilitäten kommen dann unter 10% und leichte bis 200%. Wenn dann noch nichts war dann ging es bei mir auch über 800% gut. Aussagen wie "mindestens bis 10000% testen" halte ich für übertrieben....da dann besser Doppelbelastung mit anderen Programmen verursachen.

Natürlich sollte erstmal sicher sein, dass die CPU voll stabil ist, wobei man aufpassen muss, da schnellerer Ram auch die CPU besser auslastet und ein CPU OC das mit langsamem Ram stabil war wird mit Ram OC eventuell instabil.

Zusammenfassung zur Kaufberatung:

Will ich 16GB:

-bei weniger Budget 2x8GB 3000 Cl15 oder 16.

-bei großem Budget 2x8GB 3200 Cl14 oder andere Samsung B-die Riegel, die sich aber nur lohnen, wenn man manuell an den Subtimings anfasst.

-Alternativ gibt es auch vermehrt Berichte, von anderen schnellen Ram Riegeln, die auf Ryzen gute Leistungen durch OC erzielen....

Will ich 32GB:

Je nach Board(T-topology oder Daisy chain) 2x16 DR oder 4x8GB SR

-bei kleinem Budget würde ich 3200 Cl16 kaufen und versuchen 3000 CL16 damit zum laufen zu bringen.

-bei großem Budget würde ich 3200 Cl14 nehmen und manuell die Subtimings anpassen.

-Alternativ gibt es inzwischen auch 16GB Riegel die SR sind.... die gibt es noch nicht mit so guten Timings zu kaufen(nur 3200 Cl16) und ich habe noch keine Erfahrungen zur Übertaktbarkeit gefunden.

2x16GB SR klingen für hohe Taktraten mit 32GB aber gut.

Will ich 64GB:

Dann sollte Geld egal sein.

Ohne es selbst getestet zu haben, würde ich das nur mit einem T-Topology Board und 4x16GB SR machen.

Auch 4x16GB DR können auf 3200MHz gehen, wenn man viel Zeit investiert, aber eigentlich würde ich davon abraten das mit AM4 zu machen. Dann lieber den Aufpreis zu Threadripper zahlen.

Wenn die Zen2 CPUs kommen dürfte sich die Situation nochmal ändern.

Dann könnte es auch wichtig werden, wie die Ramriegel aufgebaut sind.

Dabei gibt es verschiedene Varianten.

So ist A2 eine Variante mit zwei Blöcken a vier Ramchips rechts und links auf dem Riegel...… Diese Variante soll bessere Taktraten, aber eher schlechtere Timings schaffen.

A0/A1 hat alle Ram Chips gleichmäßig über die Breite der Riegels verteilt und soll bessere Timings, aber eher schlechteren Takt schaffen....

Wenn Zen2 höhere Taktraten erreichen kann, könnte A2 die bessere Variante sein....im Moment sehe ich das eher als unwichtig an, aber da kenne ich mich auch zu wenig im Detail aus.

Was sind eure Meinungen dazu?

Habt ihr Verbesserungsvorschläge oder wollt ihr besimmte Sachen sehen, die ich hier nicht behandelt habe?

Zuletzt bearbeitet: