Freiheld

Lieutenant

- Registriert

- Sep. 2009

- Beiträge

- 630

Gude zusammen !

In meinem Bericht beschreibe ich euch, wie ich auf die Idee gekommen bin, mein altes AMD FX-8350 System, durch ein solchen Kampfzwerg zu ersetzen und welche Überraschungen seit Juni auf mich warteten. Dabei gehe ich auf die Konfiguration und vor allem die technische Umsetzung der externen Grafiklösung ein, die quasi das Herzstück dieses Berichts ist.

1. Motivation und Ansprüche

Da nun mein in die Jahre gekommenes System weder leistungsmäßig schnell, noch effizient arbeitete, ich auch ein klein wenig Angst vor Greta T. habe, fasste ich mir an die Geldbörse und schmiedete einen Schlachtplan für mein neues System. Ich habe die letzten Jahre reflektiert und aufgelistet mit was ich meine Zeit am Rechner verbrannt/verbracht hatte. Dabei stellte ich fest, zocken war nicht mehr meine primäre Beschäftigung und alles andere wie zB Slicen von 3D-Print-Modellen oder etwas simples CAD, brauchte ich nicht viel Rohleistung. Zudem bin ich auch geduldiger bei Wartezeiten geworden.

Diese Erkenntnisse ließen folgende Ansprüche übrig:

- keine große Rohleistung

- selten komplexes Multitasking

- geringe Grafikleistung, sollte für LoL und Retro-Games aber ausreichend sein

- kompaktes Gehäuse

- gering angesetztes Budget, da andere Hobbies auch am Geldbeutel zerren

- irgendwann mal vielleicht eine externe GPU

2. Zusammenstellung, Konfiguration, Ausgaben

- ASRock DeskMini A300 AMD Ryzen HDMI//DP/D-Sub USB3.1 retail

- AMD Ryzen 5 2400G 4x 3.60GHz So.AM4 BOX

- Noctua NH-L9a-AM4 Topblow Kühler

- 16GB (2x 8192MB) G.Skill RipJaws DDR4-3000 SO-DIMM CL16-18-18-43 Dual Kit

- Samsung SSD 960 EVO 250GB, M.2 (MZ-V6E250BW)

Seit Anfang Dezember 2019

- ADT-Link PCIe x16 to M.2 NVMe eGPU Adapter

- XFX Radeon RX 5700 DD Ultra, 8GB GDDR6

- Dell DA-2 8PIN 12V/18A/220W PSU

- Coba Nitrox 600 Watt IT-7600SG ATX

Warenkorb auf Geizhals

2.1 Ausgaben

Meine Ausgaben beliefen sich auf ca. 395€ Warenkorb + 309€ GPU + 70€ Adapter u. ext PSU = 774€ (brutto, inkl. VSK, Stand Mai 2019, GPU aus Dezember 2019).

Adapter habe ich auf eBay geschossen für ca. 50€, gleiches gilt für das Dell Netzteil für ca. 20€ (Privat, nach Preisverhandlung), das Coba Nitrox hatte ich noch im Regal.

2.2 Detailbeschreibungen

Um allen meiner Ansprüche gerecht zu werden, habe ich zuvor verifiziert wo mein Leistungsdurchschnitt lag, wo kann ich Abstriche machen und auf was kann ich nicht verzichten.

2.2.1 Gehäuse – Asrock A300

Ich muss gestehen, als ich den ersten Bericht über dieses Gehäuse gelesen habe, war mir schon klar dass ich diesen irgendwann eine Chance geben werde. Dass ich es am Ende selbst war, der es sein Eigen nennen durfte, war mir damals nicht klar.

Es bietet auf engstem Raum viele Anschlussmöglichkeiten von zB zwei NVMe Steckplätzen bis hin zu den zwei zusätzlichen 2.5“ Festplattenrahmen, zudem spielte ich schon damals mit dem Gedanken einer externen GPU (wenn ich sie bräuchte). Mit seinen Ausbaumöglichkeiten, Anschlüssen und Kompaktheit war es entschieden.

2.2.2 CPU – AMD Ryzen 5 2400G

Da ich mich bereits in das A300 verliebt hatte, kam ich eigentlich kaum noch um eine APU herum, somit las ich Berichte und schaute unzählige Videos von Benchmarks. Ich bin/war mit bewusst, dass der Leistungsunterschied sehr gering zur 2200G ist, aber genau diesen wollte ich haben bzw nicht missen, obwohl ich ihn wahrscheinlich nie bemerkt hätte.

In meinen Games und Anwendung erreichte diese die erwartete Leistung und übertrifft diese des Öfteren sogar. So konnte ich LoL bei Mid-Settings auf FHD bei avg ~ 100 fps+ spielen und Slicer haben die 3D-Modell schnell in GCode verwandelt. Somit wanderte auch diese in den Warenkorb.

2.2.3-5 RAM, SSD, Kühler

Bei diesen Komponenten habe ich mich ehrlich gesagt an Reviews orientiert und wurde von blanken Zahlen geführt. Die Kompatibilität war gegeben und bot sogar gute Werte. Zudem waren diese auch beim Händler lagern. Die SSD wurde aus meinem alten System übernommen.

2.2.6 Grafiklösung – XFX RX 5700 DD 8GB und Adapter

Nach reichlichen Massagen und guten Einreden auf meinen Geldbeutel, konnte ich diesem den einen oder anderen Groschen entlocken. Somit hatte ich ein Limit welches nicht überschritten werden durfte, auch wiederum las ich Benchmarks und schaute Videos um genau auszuloten auf welches Modell meine Wahl fällt. Die RX5700 bot genau das ideale Paket aus Preis, annehmbarer Lautstärke und Leistung, der wichtigste Punkt jedoch sind die angegeben TDP von 180 Watt um sie auch am Dell PSU betrieben zu können.

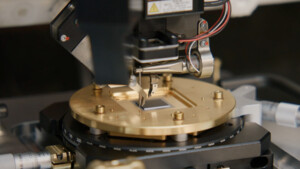

Beim Adapter habe ich mich von dem Komplettpaket des ADT-Link R43SG überzeugen lassen. Dieser bringt alles mit was ein solches Projekt verlangt, eine super Verarbeitung, alle nötigen Kabel, zahlreiche Dokumentationen und vor allem Plug&Play ohne basteln.

3. Zusammenbau

Der Zusammenbau ging leicht von der Hand, hierzu gibt es bereits etliche Berichte vom Rechner zB von sini beschrieben. Ich gehe hier nur auf die Erweiterung der GPU ein.

Aufgrund der fest verbauten/verlöteten Kabel am R43SG Adapters musste ich mir was einfallen lassen, wie ich am besten das Kabel verlege. Dabei ergaben sich zwei Möglichkeiten, diese habe ich auch gleich getestet und folgendes festgestellt.

3.3 Montagevariante #1

NVMe-Slot auf der unteren Seite des Boards verlangt ein Schlitz am Gehäuse Nähe der Blende, kann dann an der Hinterseite herausgeführt werden.

- aufbohren / fräsen einer Gehäuseöffnung

- geringer Wiederverkaufswert des Gehäuses

Im ersten Bild seht ihr im roten Kreis den Slot mit meiner primären SSD drin, im zweiten die etwaige Stelle für das Loch.

3.3 Montagevariante #2

- NVMe-Slot auf der oberen Seite des Board verlangt ein Biegen des Kabels Nähe des Kühlers, kann durch entfernen der Ausstanzung für einen zusätzlich VGA/Seriellen-Port am Gehäuse herausgeführt werden.

+ keine Manipulation des Gehäuse

-/+ verbiegen des Kabels

- Erreichbarkeit des WLAN-Moduls

3.4 Variation in den Netzteil (Ergänzung zum Bericht, 16.01.2020)

Da ich nun meine Konstellation länger testen konnte, hat sich eine weitere Variante in der Stromversorgung ergeben, die Verwendung eines ATX Netzteils.

3.4.1 Variante #1 - Brick Netzteil - Dell DA-2 8PIN 12V/18A/220W

Zu Beginn meines Projekts hatte ich gleich das Dell DA-2 ins Auge gefasst, es bietet genug Leistung um eine aktuelle und leistungsstarke Karte zu betreiben, zudem erweckte es nicht den Anschein eine Bastellösung und suggerierte eine modulare aufgeräumte Lösung. Der Flaschenhals hier jedoch ist die maximale Leistung von 180 Watt. Hier muss ich auch gestehen habe ich etwas blauäugig gehandelt. Meine Tests haben ergeben, sobald die GPU Luft holt, weil man zB minimal an den Taktraten gedreht hat, und die Leistung auf über 180 Watt schnellt, ist Ende im Gelände. Das Netzteil steigt aus, schaltet sich ab und der PC läuft ohne Bildschirm weiter. In eingetroffenen Fall ist sogar ein kompletter Neustart erforderlich inklusive eine kleinen Pause, dass sich das Netzteil akklimatisieren kann.

wenn ihr also eine kleinere Karte habt und eine saubere Lösung wollte, seid ihr mit diesem Netzteil an der richtigen Stelle. Jenseits der 180+ Watt Marke könnt ihr dieses jedoch getrost vergessen.

3.4.2 Variante #2 - ATX Netzteil - Coba Nitrox 600 Watt IT-7600SG ATX

Aufgrund dass ich mit den Taktraten meiner Karte gespielt habe und es zu Problemen gekommen ist, habe ich mich auf den Wechsel eines ATX Netzteils entschieden. Dieses bzw jedes anderes welches die benötigte Leistung erfüllt kann dazu verwendet werden. Es bedarf keiner hässlichen Bastelbrücken an den Konnektoren, speziellen Verdrahtungen oder ähnlichen. Der Adapter bietet auch die Buchsen für einen 24Pin-Stecker und einen 4Pin-Board-Stecker, über diese wird die Grafikkarte direkt vom Adapter versorgt, natürlich über das zusätzliche 2mal 8/6Pin-Kabel vom Adapter zur Karte.

Solltet ihr euch also für eine stärkere Karte entscheiden die die Leistung von 180 Watt überschreitet, benötigt ihr zwangsläufig die ATX-Variante. Wenn ihr wie ich ein modulares verwendet, kann man auch eine saubere Verkabelung hinkriegen. In meinem Fall habe ich das Netzteil an die Unterseite meine Tische verschraubt und angeschlossen. An der Installation des Ganzen ändert sich nichts !

3.5.1 Ergebnis

Auf den Bildern könnt ihr hoffentlich die Vor-/und Nachteile der beiden Varianten erkennen. Final habe ich mich für die zweite Variante entschieden, um primär den Wert zu erhalten und so auf das zusätzliche werkeln zu verzichten.

3.4 Installation

Die Installation ist definitiv keine Raketentechnik und kann von jedem durchgeführt werden, der auch fähig ist einen Rechner bzw diesen Rechner zusammen zu bauen. Man muss weder am Adapter selbst, noch am Rechner spezielles umstellen oder gar modifizieren.

Kurz beschriebener Ablauf meiner Installation:

- “Zusammenbau des Adapter, die beiliegenden Schrauben und Kabel am Adapter montieren

- Variante #1 Anstecken des Netzteils, dabei leuchtet die LED am Netzteil orange und keine auf dem Adapter.

- Variante #2 Anstecken des Netzteils, 24-Pin Stecker und den 4-Pin Stecker in die vorgesehene Buchse, Beschriftung auf dem PCBs des Adapters ist zu beachten.

- Einstecken der GPU und Fixierung mit den Schrauben.

- Anschließen der Stromstecker an GPU, dabei die gut leserliche Beschriftung an den Buchsen beachten.

- Öffnen des Gehäusedeckels des Rechner

- Entfernen des Stückchen Blechs über der Mainboardblende, ähnelt einem VGA-/Seriellen-Anschlusses.

- Durchführen der Steckkarte durch das entstandene Loch.

- Einstecken der Steckkarte in einem der beiden NVMe-Slots, beide haben tadellos funktioniert, dabei die Verdrehung des Kabel beachten. Etwas Vorsichtig ist geboten um dieses nicht zu beschädigen.

- Verschrauben der Steckkarte in Slot.

- Schließen des Gehäuses.

- Einschalten des Rechners, ich musste KEINE Einstellung im BIOS ändern, dieses erkannte sofort die zusätzliche GPU.

- Herunterladen des aktuellen Treiber von AMD Homepage, ich musste keinen speziellen Treiber auswählen.

- Installation des Treibers

- Neustart

- Fertig

Wie ihr lest benötigte ich keine Ausbildung bei der NASA und konnte innerhalb 30 Minuten mein System um die GPU erweitern.

4. Benchmarks

Die Hardwaredaten des Rechners seht ihr ja oben, softwareseitig stelle ich es euch hier zusammen:

BIOS - 3.60

Windows 10 Pro - 1903 - 18362.535

Grafikkartentreiber - 19.12.3 - 26.20.15003.5016

Games sind stets auf dem aktuellen Stand

wurde in 2560x1080 21:9, alles auf High, Online-Match

APEX - wurde in 2560x1080 21:9, alle Regler bis Anschlag, Online-Match

Overwatch - wurde in 2560x1080 21:9, alles auf Episch u. ohne FPS-Deckelung, Online-Match

League of Legends

3D Mark - TimeSpy Free - Settings alles "Auto" bei 2560x1080

Dabei waren die Temperaturen in etwa bei 50° Idle (Lüfter sind aus), in Apex und Overwatch dreht die Lüfter hörbar aber nicht störend auf, dabei nahm sich die GPU bis zu max. 163 Watt. Für genauere Werte bei den Szenarie könnt ihr mir gerne schreiben, ich liefere diese gerne nach.

5. Fazit

Ich muss zugeben, selbst bevor ich die externe GPU eingebaut hatte, war ich mehr als Zufrieden mit dem Rechner und konnte alle Dinge erledigen. Vom Zocken (mit Abstrichen) bis CAD/Slicen erfüllte er jede Erwartung. Nur durch meinen Basteltrieb und dem etwas gestiegenen Anspruchs an Grafikleistung habe ich dieses Projekt in Angriff genommen und bin überglücklich es getan zu haben. Die Leistung der GPU ist einfach stark und kommt selten ins Schwitzen, auch die Lautstärke, wenn die Lüfter dann mal drehen ist erträglich.

Am Ende hatte ich viel Spaß bei der Umsetzung und bin mehr als Zufrieden!

Danke für eure Aufmerksamkeit und noch einen schönen Abend!

Euer

Freiheld

Zuletzt bearbeitet:

(Netzteil Updates !)