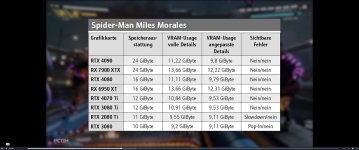

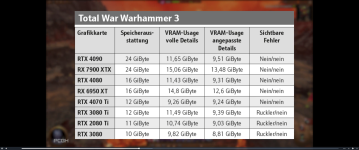

Völliger Humbug.Schau dir doch mal z.B. bei Techpowerup den Speicherverbrauch AMD vs.NVidia an. AMD Verbraucht etwas mehr, das ist aber ein Vergleich von 10GB vs. 10,5GB.Floppy5885 schrieb:AMD Karten kann man pauschal 25-30% Vram wieder abziehen,

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Fortschritte bei Raytracing und AI: AMD bestätigt Radeon RX 8000 für Anfang 2025

- Registriert

- Juli 2021

- Beiträge

- 3.038

Es gibt sehr viele Menschen, die auf einer iGPU spielen. Alleine in meinem Bekanntenkreis gibt es einige, dienen Laptop nur mit den kleinen Radeons oder Iris-GPUs haben und entsprechend auch da ihren Spaß haben.Tharan schrieb:Man sieht ja, dass von AMD und auch Intel viele davon drin sind und das verzerrt das Bild.

Klar, hier im Forum werden das wenige verstehen, aber viele spielen auch mit minimalen Details oder unter 60 fps.

Wir sind hier schon an einer etwas anderen Position.

Eine Freundin wird jetzt Dragon Age 4 auf einer 680M spielen.

Tharan

Lt. Commander

- Registriert

- Sep. 2007

- Beiträge

- 1.059

Ja, auch hier und im Freundeskreis reicht unterwegs halt eine 780M o.ä. locker aus um den kleinen Hunger zu stillen oder wenn man auf dem Sofa liegt. Gibt ja auch genug Spiele die wirklich gut sind und wenig Anforderungen haben.

Was ich da in Bezug aufs Gaming interessant finde durch die Stärke der iGPUs: Wenn das nun nicht alles die Zocker mit ihren Zweitnotebooks sind ist der dGPU-Markt doch eigentlich irgendwie gefühlt doch "klein" nur mit dem Bereich Gaming. Somit ist der Hype rüber zu KI und anderen professionellen Anwendungen sehr verständlich. Schade, dass man die iGPUs nicht rausnehmen kann damit die Prozentzahlen weniger verzerrt werden.

Was ich da in Bezug aufs Gaming interessant finde durch die Stärke der iGPUs: Wenn das nun nicht alles die Zocker mit ihren Zweitnotebooks sind ist der dGPU-Markt doch eigentlich irgendwie gefühlt doch "klein" nur mit dem Bereich Gaming. Somit ist der Hype rüber zu KI und anderen professionellen Anwendungen sehr verständlich. Schade, dass man die iGPUs nicht rausnehmen kann damit die Prozentzahlen weniger verzerrt werden.

Dedenne1987

Lt. Junior Grade

- Registriert

- Nov. 2022

- Beiträge

- 272

Ja in 2025 sind 12 GB nicht optimal.Clonedrone schrieb:Die Karte wird trotzdem 12 GB VRAM haben. Zu wenig für die Mittelklasse.

Aber wenn AMD max 16 bringt, wo ist dann das Problem wenn Nvidia in der Mittelklasse nur 12 bringt?

Davon ab ist es nicht bestätigt.

AMD benötigt die Fertigung N3E, nur hier sind Apple, Intel und nvidia fast exklusive Kunden.Couch-Potatoe schrieb:Was hingegen tatsächlich ein Problem ist: AMD ist zu spät. Etwa ein halbes Jahr. Sie müssen mal wieder vor Nvidia launchen und das ausnutzen, um Marktanteile zurückzugewinnen. Wenn sie gegen Karten auf GB205-Basis im Markt stehen, die dann schon GDDR7 nutzen werden, hat es Navi 48 schwer.

GDDR7 ist wichtig für die High End Karten, aber auch Mittelklasse mit 128 Bit, was Fertigungskosten senkt.

A

Aisn

Gast

Danke für deine Erläuterungen, die rein akademischer Natur sind und wenig zielführend, hättest du meine Ausführung nicht nur überflogen, sondern gelesen und den Sinn verstanden (Spulenfiepen, Monitorsetup, Stabilität im Alltag,...). Kurzfassung: Ich ersetze nichts, das für mich 100%ig die Aufgaben erfüllt!Duran schrieb:@Aisn

Früher aufrüsten ist kein verbranntes Geld, du erhälst direkt mehr Leistung und ganz wichtig: Längere Nutzbarkeit.

Wenn das Upgrade 1,5 - 2 Jahre zusätzlich hält, ist das auf den Preis runtergebrochen sehr günstig.

Jetzt bekommst du noch fast 400 € für das Altmodell. Wenn die 8700/8800 raus sind, sinkt das rapide.

So schlecht finde ich die Mehrleistung nicht, weil sie immer weiter ansteigt mit jedem Monat bzw. Titel.

Und viel größer wird sie dann, wenn die Speichermenge von 16 GB "genutzt" wird, dann können die 4 GB mehr widerum den Unterschied machen. Ich rechne hier mal mit 30-50 % extra die hinzu kommen.

Die technischen Daten mal abgecheckt, die 8800 XT kann nicht so viel besser werden, dafür hat sie zu wenige Shader. Nicht mal mit 20 % mehr Takt (=Stromverbrauch) würde die wirklich attraktiver aussehen.

Anderen Vorteil den du hast: Garantiezeit verlängert sich. Nichts ist ärgerlicher als 600 € Schrotteile zu besitzen.

Hier mal kurz ein paar Werte:

Last of Us, 4K Ultra

7900 XT 57fps

6950 XT 46fps

15 Games average:

7900 XT 185fps

6800 127fps

Jetzt 30% und im nächsten Jahr vielleicht 40 bis 60 %. Kann sich sehen lassen.

Alles unter dem Gesichtspunkt das die kommende Januarwelle nicht besonders ausfällt.

Warum sollte ich in dem Spiel von dir mehr FPS haben, wenn ich a) das Spiel überhaupt nicht besitze oder spiele und b) keinen 4k-Monitor habe? Danke, dass du eine 7900XT mit einer 6800, die mal "minimal" schwächer" als meine 6900XT ist, vergleichst. Der Unterschied zwischen einer 7900XT und einer 6900XT düfte im 20%-Bereich sein, und wahrscheinlich wieder bei Spielen, die ich überhaupt nicht spiele! Alle Spiele, die ich nutze, sind auf 144FPS festgetackert, alle, und zwar ausnahmlos, laufen mit diesen 144FPS. Und ich sehe maximal Civ7 als neues Spiel für mich! Eine potentere GPU lieferte FPS >144, wird von mir dazu allerdings nicht genötigt, also liegt die Leistung brach! Und dafür soll ich Geld ausgeben? Sry, but rofl...

Es mag nicht deine Meinung sein, aber, etwas zu für ca. 500,-€ Invest kaufen, das für mich keinen Mehrwert erzeugt, ist gleichzusetzen mit Geldverbrennung, alles andere, was du anführst, ist für mich vollkommen irrelevant, da es mich Null betrifft.

Btw: Keine Sorge, ich halte mich dem PC als Hobby das BIP schon hoch, nur kaufe ich keinen "Für-mich-Unsinn"!

My2Centz

Zuletzt bearbeitet von einem Moderator:

Northstar2710

Admiral

- Registriert

- Aug. 2019

- Beiträge

- 7.848

Ich spiele Drabon Age: the Veilguard auf dem SteamDeck. Ist zwar nur mit 30fps, aber läuft und macht spassDevPandi schrieb:Eine Freundin wird jetzt Dragon Age 4 auf einer 680M spielen.

@Aisn

Die Aussagen sind nicht akademisch, sondern technisch.

Ja du brauchst es nicht, aber sinnvoll ist es dennoch zum aktuellen Zeitpunkt ein Upgrade zu fahren.

Die Preise für die Karten werden erheblich im Preis rutschen sobald die 8000-Serie da ist.

Weil du fragst wegen der Monitore: Ich nutze meist auch kein 4K, aber was ist wenn du 2 oder 3 Monitore angeschlossen hast so wie Streamer oder ich? Jeder Pixel braucht Leistung.

3440x1440 spielen + 1440p Nebenbild zieht schon ordentlich. Und ein dritter Bildschirm beim Racing ergibt auch absolut Sinn.

Wie kommst du auf 500€ Invest? Ich rechne es dir mal aus. Bestpreis war: 649 € - 400 € = 249€ Aufpreis.

Dafür erhälst du: Neue Garantie (fullpreis), mehr Leistung sofort und später, längere Nutzbarkeit wegen Leistung/VRAM. Also nicht mal 10 € im Monat kann man sagen.

Du verbrennst Geld wenn du dabei bleibst und zum Beispiel riskierst, das die Garantie der Karte abläuft.

Ich sehe das nicht als Verschwendung. Die 4090 wäre das, weil sie 3mal so viel Kostet aber nicht die Leistung.

144fps ist auch nur dein Weltbild. Was machst du bei 200 oder 240 Hz? Genau, du verschenkst was.

Die Aussagen sind nicht akademisch, sondern technisch.

Ja du brauchst es nicht, aber sinnvoll ist es dennoch zum aktuellen Zeitpunkt ein Upgrade zu fahren.

Die Preise für die Karten werden erheblich im Preis rutschen sobald die 8000-Serie da ist.

Weil du fragst wegen der Monitore: Ich nutze meist auch kein 4K, aber was ist wenn du 2 oder 3 Monitore angeschlossen hast so wie Streamer oder ich? Jeder Pixel braucht Leistung.

3440x1440 spielen + 1440p Nebenbild zieht schon ordentlich. Und ein dritter Bildschirm beim Racing ergibt auch absolut Sinn.

Wie kommst du auf 500€ Invest? Ich rechne es dir mal aus. Bestpreis war: 649 € - 400 € = 249€ Aufpreis.

Dafür erhälst du: Neue Garantie (fullpreis), mehr Leistung sofort und später, längere Nutzbarkeit wegen Leistung/VRAM. Also nicht mal 10 € im Monat kann man sagen.

Du verbrennst Geld wenn du dabei bleibst und zum Beispiel riskierst, das die Garantie der Karte abläuft.

Ich sehe das nicht als Verschwendung. Die 4090 wäre das, weil sie 3mal so viel Kostet aber nicht die Leistung.

144fps ist auch nur dein Weltbild. Was machst du bei 200 oder 240 Hz? Genau, du verschenkst was.

Ich würde erst einmal selber vergleichen, bevor Du das als Humbug abstust. Es kann durchaus erheblich mehr sein.DiePalme schrieb:Völliger Humbug.Schau dir doch mal z.B. bei Techpowerup den Speicherverbrauch AMD vs.NVidia an. AMD Verbraucht etwas mehr, das ist aber ein Vergleich von 10GB vs. 10,5GB.

Bei TLOU konnte ich selber einen Unterschied (beide optimiert) von ~4GB VRam feststellen.

Zuletzt bearbeitet:

A

Aisn

Gast

Keine Ahnung, auf welchem Kreuzzug du dich befindest, aber ich hoffe inständig, du verdienst dein Geld nicht als jemand, der verkauft. Die Karte frisst 35W im Multimonitorbetrieb, man, da muss eine 7900xtx her!?. Ich habe keinen 240Hz Monitor, ich verschenke nichts. Längere Laufzeit, was für ein Bockmist, als garantierte eine neuere Karte dieses, zumal ich deinem Ansatz gemäß bestehtig jedes Upgrade mitmachen müsste, da ich ansonsten etwas verschenkte. Man, haben die 4+Gig Ram in der Zeit seit den 7k-Karten mir gefehlt, NICHT. Und die neuen 8k-Karten sollen in HW die RT-/Upscaling-Schwäche beheben, WAS DIE 7K-REIHE NICHT KANN.Duran schrieb:@Aisn

Die Aussagen sind nicht akademisch, sondern technisch.

Ja du brauchst es nicht, aber sinnvoll ist es dennoch zum aktuellen Zeitpunkt ein Upgrade zu fahren.

Die Preise für die Karten werden erheblich im Preis rutschen sobald die 8000-Serie da ist.

Weil du fragst wegen der Monitore: Ich nutze meist auch kein 4K, aber was ist wenn du 2 oder 3 Monitore angeschlossen hast so wie Streamer oder ich? Jeder Pixel braucht Leistung.

3440x1440 spielen + 1440p Nebenbild zieht schon ordentlich. Und ein dritter Bildschirm beim Racing ergibt auch absolut Sinn.

Wie kommst du auf 500€ Invest? Ich rechne es dir mal aus. Bestpreis war: 649 € - 400 € = 249€ Aufpreis.

Dafür erhälst du: Neue Garantie (fullpreis), mehr Leistung sofort und später, längere Nutzbarkeit wegen Leistung/VRAM. Also nicht mal 10 € im Monat kann man sagen.

Du verbrennst Geld wenn du dabei bleibst und zum Beispiel riskierst, das die Garantie der Karte abläuft.

Ich sehe das nicht als Verschwendung. Die 4090 wäre das, weil sie 3mal so viel Kostet aber nicht die Leistung.

144fps ist auch nur dein Weltbild. Was machst du bei 200 oder 240 Hz? Genau, du verschenkst was.

Ein Upgrade wäre eine Xtx, die kostet ca. 900,-. Mein Gehirn ergibt da 500,- Invest, keine Ahnung, was dir dein Taschenrechner rausschmeißt.

Was verstehst du nicht an "eine neue Grafikkarte ist für mich aktuell Geldverbrennung"? Ist das Pronomen das Problem. Dann zur Klarstellung für dich: ICH SPRECHE VON MEINEM PERSÖNLICHEN BEDARF!

Racing, 240Hz, Längere Nutzungsdauer, liest du eigentlich die Antworten anderer?

Mir ist das echt zu dumm jetzt, ignoriere die Antworten von anderen und schwadoniere die zu, mir reicht dein *********.

DrFreaK666

Captain

- Registriert

- Dez. 2011

- Beiträge

- 3.801

Weltspartag war vorgestern; was soll also das gekürzte Zitat?Clonedrone schrieb:Die Karte wird trotzdem 12 GB VRAM haben. Zu wenig für die Mittelklasse.

Und Nvidia hat noch keine RTX5000-Karten offiziell mit Daten angekündigt

Clonedrone

Lieutenant

- Registriert

- Apr. 2024

- Beiträge

- 738

Willst du das jetzt noch 20 x wiederholen?DrFreaK666 schrieb:

Zig übereinstimmende Leaks sagen 12 GB. Das ist für mich glaubwürdig genug.

DrFreaK666

Captain

- Registriert

- Dez. 2011

- Beiträge

- 3.801

@Clonedrone Leaks sind keine offizielle Ankündigung von Nvidia.

RDNA3 sollte angeblich auch ein 4090 Killer werden

RDNA3 sollte angeblich auch ein 4090 Killer werden

rg88

Fleet Admiral

- Registriert

- Feb. 2015

- Beiträge

- 35.266

Jeder der nicht High-End kauft,Nuklon schrieb:Nur Mittelklasse, nur Fokus auf KI und Raytracing? Wer soll da die Zielgruppe sein?

Das "Mittelklasse" bezieht sich ja nicht auf die aktuelle Gen sondern auf die Konkurrenz 2025 und das ist RTX5000.

Also im Grunde ist die Zielgruppe der Massenmarkt, nicht der Enthusiast, dem der Preis egal ist und der sowieso Nvidia kaufen wird.

Ergänzung ()

sind es 20 Leaks oder ist es ein Leak und 19 andere haben die einfach einfach weiterkopiert?Clonedrone schrieb:Zig übereinstimmende Leaks sagen 12 GB. Das ist für mich glaubwürdig genug.

Discovery_1

Rear Admiral

- Registriert

- März 2018

- Beiträge

- 5.761

Ghostfacekalle

Lieutenant

- Registriert

- Okt. 2020

- Beiträge

- 1.021

Aha. Da spricht die Weisheit.zeedy schrieb:Und schlechtere Treiber hat AMD ja sowieso.

Ich bin ja aktuell ein ziemlicher Freund von Nvidia und wenig überzeugt von den AMD Karten. Zumindest aktuell würde ich eine Nvidia immer einer AMD vorziehen. Aber das, was du hier schreibst, ist auch quatsch.zeedy schrieb:Und schlechtere Treiber hat AMD ja sowieso.

Ich verstehe nicht, wie es sein kann, dass die neue Generation, die nicht einmal die Vorgängergeneration übertrifft, 2 Jahre später immer noch nicht marktreif ist.

Das die AMD Treiber murks sind, stimmt einfach nicht. Die Probleme bei AMD und Nvidia sind mehr oder weniger gleich in der Anzahl. Die AMD Treiber waren mal gaaaaaaaaaaanz früher oft Murks. Heute nicht mehr. Nvidia ist nur meistens etwas schneller mit einem optimierten Treiber für ein Spiel. Aber oft auch nur um ein paar Tage. Und die UI Oberfläche der Treibereinstellung ist bei AMD weitaus schicker und einfacher in der Handhabung als bei Nvidia die gefühlt in den 90igern stehen geblieben sind.

Die 7XXX übertrifft die RTX 3XXX Reihe. Auch mit RT wenn man in den gleichen Preisklassen (UVPs) vergleicht. Das DLSS besser ist als FSR, liegt nicht an der Hardware. Muss man hier gesondert werten.

Deine Aussage, dass die neuen Karten zu spät sind, halte ich ebenfalls für quatsch. AMD hat frühzeitig angekündigt, sich nicht mit Nvidias Topmodellen anlegen zu wollen. Das ist auch eine recht interessante Ausrichtung Seitens AMD in die man so einiges reininterpretieren könnte. Nüchtern betrachtet, hat AMD das High Performance Rennen vorerst aufgegeben. Vermutlich gibt die Architektur es einfach nicht her oder wäre zu teuer/kompliziert für das High End Segment. Es kann auch andere Gründe haben. Eventuell wollte man sich erstmal voll auf die MI3XX Reihe für KI und Server konzentrieren.

Es würde ja Sinn machen den Weg von Nvidia zu gehen. Hier stehen ebenfalls Serverkarten bei der Entwicklung im Vordergrund und man geht von dort Schritte zurück zu Gamerkarten. Eventuell scheint dies für die Entwicklung einfacher zu sein. Zumindest funktioniert es ja bei Nvidia schon länger sehr gut. Wer weiß, ist aber auch nicht wichtig.

Aber so eine Umstellung kann man nicht von heute auf morgen machen. Das kann durchaus eine Generation dauern.

Jedenfalls scheint das Ziel der neuen Generation zu sein, Effizienter zu werden mit besserer RT Leistung um im Mittelfeld gut präsent zu sein. Warum auch nicht, hier ist der Markt ebenfalls groß. Die 7XXX Reihe ist ja auch noch nicht wirklich alt.

Child

Commander

- Registriert

- Sep. 2006

- Beiträge

- 2.153

DiePalme schrieb:Nüchtern betrachtet, hat AMD das High Performance Rennen vorerst aufgegeben. Vermutlich gibt die Architektur es einfach nicht her oder wäre zu teuer/kompliziert für das High End Segment. Es kann auch andere Gründe haben. Eventuell wollte man sich erstmal voll auf die MI3XX Reihe für KI und Server konzentrieren.

Ist jetzt aber auch nicht beispiellos. Das Halo-Produkt 4090 hatte AMD ja nie als Ziel und auch schon mit früheren Generationen hat man im High-End "mit Absicht" kein Vergleichsprodukt zu Nvidia gehabt (RDNA1 - RX5700XT und Co.).

@Child

Das ist richtig. Aber auch hier muss man nüchtern betrachtet sehen, dass AMD sicherlich sehr gerne Konkurrenz anbieten würde, es aber oft einfach nicht konnte.

Was für mich wiederum folgendes heißen kann (meine Meinung muss nicht richtig sein).

1. Man hat die falschen Leute in der Entwicklung sitzen.

2. Man steckt zu wenig Geld rein, weil man es wo anders benötigt und daher nicht hat.

3. Man Entwickelt in die falsche Richtung und sieht das Resultat erst am Ende.

4. Die eigenen bzw. angemieteten Fertigungsmöglichkeiten und/oder Kapazitäten reichen nicht oder sind falsch.

5. Das Management, welches mit der Planung beauftragt ist, versagt.

Oder eben alles zusammen. Aus strategischer Sicht, macht es eigentlich keinen Sinn auf High End freiwillig zu verzichten.

Wie auch immer. Als Kunde mache ich mir über das alles so oder so eigentlich keine Gedanken. Wenn ich eine neue Karte brauche habe ich erstmal ein Budget. Danach suche ich die beste Karte für mich raus und schaue ob es sich wirklich lohnt damit meine Alte zu ersetzen. Da schaut man eben noch neben der Leistung auf die Features und den Verbrauch. Je nach dem, welche Punkte einem selbst am wichtigsten sind. Ob das am Ende AMD, Nvidia oder gar Intel ist, kann einem doch völlig gleich sein.

Das ist richtig. Aber auch hier muss man nüchtern betrachtet sehen, dass AMD sicherlich sehr gerne Konkurrenz anbieten würde, es aber oft einfach nicht konnte.

Was für mich wiederum folgendes heißen kann (meine Meinung muss nicht richtig sein).

1. Man hat die falschen Leute in der Entwicklung sitzen.

2. Man steckt zu wenig Geld rein, weil man es wo anders benötigt und daher nicht hat.

3. Man Entwickelt in die falsche Richtung und sieht das Resultat erst am Ende.

4. Die eigenen bzw. angemieteten Fertigungsmöglichkeiten und/oder Kapazitäten reichen nicht oder sind falsch.

5. Das Management, welches mit der Planung beauftragt ist, versagt.

Oder eben alles zusammen. Aus strategischer Sicht, macht es eigentlich keinen Sinn auf High End freiwillig zu verzichten.

Wie auch immer. Als Kunde mache ich mir über das alles so oder so eigentlich keine Gedanken. Wenn ich eine neue Karte brauche habe ich erstmal ein Budget. Danach suche ich die beste Karte für mich raus und schaue ob es sich wirklich lohnt damit meine Alte zu ersetzen. Da schaut man eben noch neben der Leistung auf die Features und den Verbrauch. Je nach dem, welche Punkte einem selbst am wichtigsten sind. Ob das am Ende AMD, Nvidia oder gar Intel ist, kann einem doch völlig gleich sein.

Ähnliche Themen

- Antworten

- 161

- Aufrufe

- 13.381