wtfNow schrieb:

und AMD ist knauserig mit der Raytracing Performance

wobei der aktuelle große 50+ Spiele Vergleich von 7900xt und 4070ti bei Hardware Unboxed da einen interessanten Punkt aufweist, was Unreal Engine 5 bei, soweit mir bekannt, einem

der Unreal Engine 5 Vorzeigetitel angeht, einer Engine von der bei RDN3 Release hier einige sehr wenige Stimmen nach einem sehr tiefen tiefen Blick in die Kristallkugel meinten äußern zu müssen, dass AMD da völlig untergehen würde, spätestens wenn dann auch noch Ray Tracing dazu kommt.

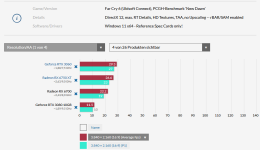

Die

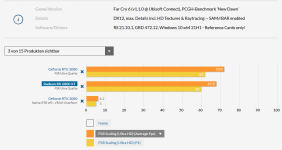

Epic Quality, Hardware Ray Tracing, TSR Epic, Super Res Quality, Lumen Epic, Nanite Unreal Engine 5.0 "mit immer dem neuesten Scheiß" Fortnite Benches in UHD und WQHD, sagen da wohl aber eher was anderes

Natürlich muss man beachten, dass das jetzt erst mal nur 1 Titel ist, soweit mir bekannt auch noch einer, bei dem die Entwickler wohl laufend Hand an die Engine anlegen, um die Performance zu steigern. Entsprechend kann man vermutlich da erst mal

nichts bis bestenfalls

wenig auf zukünftige (andere) Spiele (anderer Entwickler) mit der Unreal Engine 5 bzgl. der allgemeinen Performance übertragen.

Auch ändert sich dadurch derzeit erst mal an der grundsätzlichen Aussage bestenfalls wenig, dass man besser zu Nvidia Karten aus dem oberen Preissegment (mit den kleinen "günstigen" Karten wird man bei Ray Tracing derzeit im allgemeinen wohl eher nicht wirklich froh, auch dann nicht, wenn sie von Nvidia kommen) greift, sobald man als Gamer jetzt bereits Ray Tracing Ambitionen bei bereits veröffentlichten Spielen mit den unterschiedlichsten Engines hat. Bei diesen Spielen steht ja auch noch oft genug die Frage im Raum, ob die Hardware für die eher schwache bis durchwachsene Ray Tracing Performance verantwortlich ist, oder ob die Software es einfach an den falschen / unnötigen Stellen übertreibt und die Entwickler einfach noch nicht den Dreh raus haben, wie man Rasterizer Grafik sinnvoll mit Ray Tracing Elementen aufwertet (

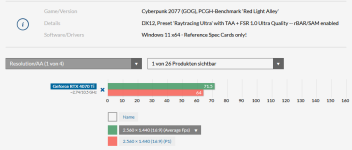

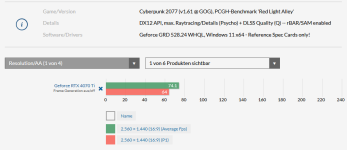

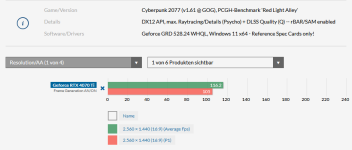

Siehe Cyberpunk 2077 mit Lichteffekten an Ecken und Enden, wo es gar keine derartigen Lichteffekte geben kann. Siehe Hogwarts Legacy, wo dunkle selbst stumpfe Steinböden in gar nicht mal so hellen Räumen das Licht reflektieren, als seien sie der Spiegel vom James Webb Weltraumteleskop. Oder um mal etwas aus der "Historie" zu verweisen, die ersten Spiele mit Tesselation, die mit absolut lächerlich hohen Tesselation Werten daher kamen, einfach nur damit die Hardwarehersteller sich profilieren konnten - Spieleentwickler lassen sich an der Stelle einfach immer wieder als Crashtestdummy mit völlig übertriebenen Vorgaben missbrauchen, weil es ja Geld bringt. Womöglich gute und natürlich kostenpflichtige Spiele werden im Gegenzug dadurch erst mal unspielbar, wenn man nicht die eine Einhorn-GPU hat, mit der man dann mit Glück und vielen Kniffen und Tricks auf grad mal so 60FPS kommt. Fuck the Techdemo!)