Wieso verbraucht das Gesamtsystem mit der 290X weniger als mit der 290 non-X ohne dass darüber ein Wort verloren wird?[/QUOTE9

Das ist eine Eigenheit der Referenzkarten. Da AMD bei der 290 die Lüfter höher drehen lässt als bei der 290X, taktet die 290 durchweg höher als die 290X - und hat zugleich eine höhere Leistungsaufnahme. Die 290X kann den Taktunterschied dann durch die zusätzlichen Einheiten kompensieren.

Und wenn hier im Test die Taktraten stehen würden, könnten sie Fragen provozieren, z.B. warum 10 von 15 Karten von Hand umgetaktet wurden. (und damit den ganzen Test ad absurdum führen)

Hö? DIe Taktraten stehen indirekt zig mal im Test, weil wir den "So testen Wir"-Artikel zig mal verlinkt haben. Das das System nicht jedem gefallen kann ist klar, aber deine extreme Haltung und auch einfach nur falsche Kritik kann ich nicht nachvollziehen.

Aber dann müssten man den anderen 3 bis 5 Herstellern erklären, warum genau diese Karte ausgewählt wurde und entsprechend mehr Außenwirkung bekommt.

Glaub mir, das ist überhaupt nicht der Grund für das ausgewählte System.

Bei euch schafft eine GTX780 in FHD mit MSAA4x und FXAA und 16x AA mal eben so zwischen 38 und 42 FPS? Das entspricht in keinster Weise der Realität. Ich habe noch nicht einmal so schlechte min Frames. Da stimmt irgendwas nicht.

Assetto Corsa hat zig Regler, und manche schmecken den GeForce-Karten nicht (und manche den AMDs nicht). Bei volle Details ist Motion Blur aktiv, was den GeForce-Karten zum Beispiel gar nicht schmeckt (um erlich zu sein, vielleicht warens auch die Reflektionen. Eins schmeckt AMD nicht, das andere Nvidia nicht; weiß ncht mehr genau wie rum).

Zwischen den OC-Modellen ist doch ebenfalls nur 4% Differenz. Die sollten ja bessere Customkühler besitzen, oder nicht?

Das PRoblem ist, dass das Hawaii Front-End offenbar die zusätzlichen Einheiten nicht schnell genug mit Daten füttern kann, sodass die zusätzlichen Einheiten nicht so viel bringen wie sie könnten. Das ist z.B. eine Herausforderung, die sie bei Fiji angehen müssen.

Das Spiel hätte ich hier auch gerne gesehen. Gerade auch noch in Bezug auf die Mantle-Performance.

Es sind ja zwei Mantle-Spiele drin - ich finde, das ist genug Vorteil für die API

Ja, bitte! OC ist eben relativ. Meine Asus 290er sollen laut AMD mit 947MHz laufen, Asus mit ein Werks-OC auf glatte 1.000MHz und ich kann sie locker auf 1.100 ohne Vcore-Erhöhung bringen, mit mehr Voltage sind 1.200 MHz drin. Was ist nun OC?

Wie schon mehrmals im Thread verlinkt: Hier steht genau, was das OC-Modell ist.

https://www.computerbase.de/artikel/grafikkarten/grafikkarten-testverfahren-testsystem.48423/

Das Lob fällt aber spätestens gegen Ende des Berichts wieder ins Nirvana: Wieso wird die Temp/Lautstärke nicht an die CB-Empfehlung gekoppelt? Du sagst selber die Serien-290 sind nicht mehr zu Marktpreisen erhältlich und führst diese trotzdem als Referenz im Vergleich an. Ich finde , da gehört ebenfalls eine OC/Partnerkarte rein, alleine um der Sache einen roten Faden zu verteilen. Sicherlich haben die Kapazitäten nicht gereicht, aber ein wenig Gemeinwohl hätte nicht geschadet an dieser Stelle ;-) VG

Um ehrlich zu sein, verstehe ich dich gerade nicht. Was meinst du genau?

In welchem Setting von Ryse wurde die Leistungsaufnahme ermittelt? Mit oder ohne SSAA?

3.840x2.160, maximale Detils, SMAA, kein SSAA

Die hohe Auflösung deswegen, um bei zukünftigen High-End-Karten nicht ins CPU-Limit zu geraten.

Zum Takt:

Getesteter Takt 970 .. 1184Mhz

Takt OC-Modell 970 ...1266Mhz.

1266 kann unmöglich der Schnitt der erhältlichen Karten sein, der muss höher liegen.

Schau mal hier

Mit den Daten haben wir auch gearbeitet.

https://www.computerbase.de/artikel....46742/seite-3#abschnitt_taktraten_unter_last

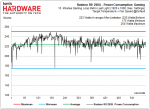

Schade, daß absichtlich 290X Referenz weggelassen wurde. Deren Stromverbrauch ist natürlich deutlich besser und näher an der 970 dran...und ein viel besseres PLverhältnis...

mhm? Schaue dir bitte nochmal die Diagramme an