Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News GT300: 3 Mrd. Transistoren und bis zu 6 GB GDDR5?

- Ersteller Volker

- Erstellt am

- Zur News: GT300: 3 Mrd. Transistoren und bis zu 6 GB GDDR5?

weissbrot

Commander

- Registriert

- Juni 2007

- Beiträge

- 2.640

also hab jetzt ned alle 18 seiten gelesen, aber bezüglich Fermi steht was auf der Nvidia GPU Technology Conference seite

http://www.nvidia.com/object/io_1254288141829.html

also dass C, Java und Fortran demnächst unterstützt werden soll find i scho krass..

und die 512 Cuda Cores scheinen die 512 Shader Einheiten wohl zu bestätigen. Ich denke dass Nvidia vor allem mit GPU Computing ATI ausstechen will! und ich denke, dass das gerade im wissenschaftlichen/beruflichen Bereich in den nächsten Jahren stark kommen wird!

Ich mag zwar ATI auch gern und die 58xx Serie scheint echt gelungen zu sein - vor allem für Homeuser die gerne mal spielen! aber die Nvidias werden ihnen in sachen GPU Computing wie gesagt auf und davon ziehen...

btw die 6GB VRAM wären gerade für GPU Computing sicher durchaus angebracht

http://www.nvidia.com/object/io_1254288141829.html

As the foundation for NVIDIA’s family of next generation GPUs namely GeForce®, Quadro® and Tesla® − “Fermi” features a host of new technologies that are “must-have” features for the computing space, including:

* C++, complementing existing support for C, Fortran, Java, Python, OpenCL and DirectCompute.

* ECC, a critical requirement for datacenters and supercomputing centers deploying GPUs on a large scale

* 512 CUDA Cores™ featuring the new IEEE 754-2008 floating-point standard, surpassing even the most advanced CPUs

* 8x the peak double precision arithmetic performance over NVIDIA’s last generation GPU. Double precision is critical for high-performance computing (HPC) applications such as linear algebra, numerical simulation, and quantum chemistry

* NVIDIA Parallel DataCache™ - the world’s first true cache hierarchy in a GPU that speeds up algorithms such as physics solvers, raytracing, and sparse matrix multiplication where data addresses are not known beforehand

* NVIDIA GigaThread™ Engine with support for concurrent kernel execution, where different kernels of the same application context can execute on the GPU at the same time (eg: PhysX® fluid and rigid body solvers)

* Nexus – the world’s first fully integrated heterogeneous computing application development environment within Microsoft Visual Studio

also dass C, Java und Fortran demnächst unterstützt werden soll find i scho krass..

und die 512 Cuda Cores scheinen die 512 Shader Einheiten wohl zu bestätigen. Ich denke dass Nvidia vor allem mit GPU Computing ATI ausstechen will! und ich denke, dass das gerade im wissenschaftlichen/beruflichen Bereich in den nächsten Jahren stark kommen wird!

Ich mag zwar ATI auch gern und die 58xx Serie scheint echt gelungen zu sein - vor allem für Homeuser die gerne mal spielen! aber die Nvidias werden ihnen in sachen GPU Computing wie gesagt auf und davon ziehen...

Ergänzung ()

btw die 6GB VRAM wären gerade für GPU Computing sicher durchaus angebracht

nekro1

Lt. Commander

- Registriert

- Feb. 2007

- Beiträge

- 1.904

Fortran Schnittstelle jo genial! Dann ist ja klar was der Haupteinsatz sein wird! Fortran ist eine Prgrammiersprache speziell für matematischen Berechnungen hin optimiert. Wer mal drin programmiert hat, der weiss was ich meine ;-)

Dann kann NVIDIA sich schmücken, das die weltweiten PRIMZAHL Rechner neue Primzahlen gefunden haben dnak NVIDAS GGPU! Anscheindend scheint es im S&D Bereich die grösseren Gewinne einzufahren. Wenn mein Primzahlsuch Algo in JAVA noch von der GFX unterstützt wird find ich bald auch neue Primzahlen ;-)

Viele vergessen auch das einfach der CPU limitiert, ein CF Gespann der HD5XXX Reihe ist noch nicht ausgereizt worden. Was wollen wir mit einer GTX395 , was ich hier so oft gelesen habe?! Wofür brauchen wir eine dearte Grafikpower? RICHTIG! Gar nicht!

In ein paar Jahren haben wir sowieso eine Hybrid Lösung (all in one CHIP) Ich hoffe es doch, dann ist endlich schluss mit dem scheiss FANBOY gelaber!

Wenn nun die neue NVIDA eine Mischung aus Mittelklasse CPU und einer high end GPU ist , was wird aus Intel? Meines wissens fummelt Intel auch an CPU Einheiten rum die Grafikelemente implementieren. Ein Krieg der Hybridlösungen in den nächsten Jahren?

Dann kann NVIDIA sich schmücken, das die weltweiten PRIMZAHL Rechner neue Primzahlen gefunden haben dnak NVIDAS GGPU! Anscheindend scheint es im S&D Bereich die grösseren Gewinne einzufahren. Wenn mein Primzahlsuch Algo in JAVA noch von der GFX unterstützt wird find ich bald auch neue Primzahlen ;-)

Viele vergessen auch das einfach der CPU limitiert, ein CF Gespann der HD5XXX Reihe ist noch nicht ausgereizt worden. Was wollen wir mit einer GTX395 , was ich hier so oft gelesen habe?! Wofür brauchen wir eine dearte Grafikpower? RICHTIG! Gar nicht!

In ein paar Jahren haben wir sowieso eine Hybrid Lösung (all in one CHIP) Ich hoffe es doch, dann ist endlich schluss mit dem scheiss FANBOY gelaber!

Wenn nun die neue NVIDA eine Mischung aus Mittelklasse CPU und einer high end GPU ist , was wird aus Intel? Meines wissens fummelt Intel auch an CPU Einheiten rum die Grafikelemente implementieren. Ein Krieg der Hybridlösungen in den nächsten Jahren?

Zuletzt bearbeitet:

Leistung kann man doch nie genug haben!.

Nehmen wir mal an die GPU würde bei Spiel X 150 fps schaffen, jedoch die CPU bei 100 limitiert. Klar, dann kann man auch nur mit 100 zocken. Ein Jahr später kommt aber ein Spiel bei dem die Karte nur noch 100 fps schafft und die CPU bei 80 limitiert. Immer noch alles super zockbar. Wieder ein Jahr später schafft die GPU noch 50 fps und die CPU 60 fps...

Mit dicker Leistung kann man eben auch länger zocken und muss nicht ständig nachrüsten. Ist jetzt halt geschmacksache. Ich kann mir jede Jahr ne Karte um die 150€ holen und anständig zocken, oder ich hol mir eben alle 2 Jahre eine für 300. Das ist einfach Geschmackssache.

Nehmen wir mal an die GPU würde bei Spiel X 150 fps schaffen, jedoch die CPU bei 100 limitiert. Klar, dann kann man auch nur mit 100 zocken. Ein Jahr später kommt aber ein Spiel bei dem die Karte nur noch 100 fps schafft und die CPU bei 80 limitiert. Immer noch alles super zockbar. Wieder ein Jahr später schafft die GPU noch 50 fps und die CPU 60 fps...

Mit dicker Leistung kann man eben auch länger zocken und muss nicht ständig nachrüsten. Ist jetzt halt geschmacksache. Ich kann mir jede Jahr ne Karte um die 150€ holen und anständig zocken, oder ich hol mir eben alle 2 Jahre eine für 300. Das ist einfach Geschmackssache.

nekro1

Lt. Commander

- Registriert

- Feb. 2007

- Beiträge

- 1.904

Mal abgesehen das deine Zahlen nicht realistisch sind und Du bringst hier ein Abhängigkeitsverhältniss rein zwischen GPU & CPU, wo die CPU eine Konstante darstellt)

Warum Leistung haben die man nicht abruft! Oder kaufst dir auch ein 300 PS Auto , wenn du in der 30iger Zone wohnst? Weil könnte ja sein das in Zukunft (1-2 Jahren) ne Autobahn gebaut wird vor deinem Block?

Dann überlege doch mal a) werte verlust der GFX, du bezahlst für leistung die du nicht abrufst! (ökonomisch) b) dein Beitrag zur Umwelt (ökologisch)

Normalerweise (ohne die ganzen Freaks die einfach nur haben wollen zum 3D Schwa..Markvergleich) kauft man doch das was man wirklich braucht oder aber man hat einfach nur Genug Geld und weiss nicht wohin damit und geilt sich an Zahlen auf

Ausseraber man brauch die Power wirklich weil man Multidisplay hat und oder das für seine Programme braucht

viele schwenken um und denken mehr und mehr ökologisch! Gott Sei dank

Warum Leistung haben die man nicht abruft! Oder kaufst dir auch ein 300 PS Auto , wenn du in der 30iger Zone wohnst? Weil könnte ja sein das in Zukunft (1-2 Jahren) ne Autobahn gebaut wird vor deinem Block?

Dann überlege doch mal a) werte verlust der GFX, du bezahlst für leistung die du nicht abrufst! (ökonomisch) b) dein Beitrag zur Umwelt (ökologisch)

Normalerweise (ohne die ganzen Freaks die einfach nur haben wollen zum 3D Schwa..Markvergleich) kauft man doch das was man wirklich braucht oder aber man hat einfach nur Genug Geld und weiss nicht wohin damit und geilt sich an Zahlen auf

Ausseraber man brauch die Power wirklich weil man Multidisplay hat und oder das für seine Programme braucht

viele schwenken um und denken mehr und mehr ökologisch! Gott Sei dank

Zuletzt bearbeitet:

White_Eagle

Lt. Commander

- Registriert

- Okt. 2006

- Beiträge

- 1.775

Also, das Teil wird nen Konkurrenzprodukt zum Intel Larrabee: Kombinierte CPU/GPU enttäuscht

IDF: Larrabee-GPU soll in künftige Intel-Prozessoren einziehen

Also, für die Nvidia-Fans, mit Graka hat das hier absolut nix zu tun, das ist nicht zum Zocken gedacht (wohl ev. geeignet ala wie der Larrabee-GPU von Intel, welcher sich noch in der Entwicklung befindet, wenn dann mal in der Zukunft, in späteren Entwicklungen, mit neuartigen Grafikdarstellungen...), sondern wohl für Anwendungen u. wird wohl mind. ü. 700,-€-1000,-€ kosten, für best. Wissenschaftliche- u. Forschungs- u. Entwicklungsbereiche ala Herstellerentwicklungen (fürn Flugzeugbau, NASA, Filmindustrie, Fahrzeug-, Motorenbau, Medizientechnik, Genetik... usw.).

Damit ist nix zocken.

Euer Graka Chip kommt doch erst als umgemodelte Version, dann halt im 2.Quartal, frühestens 1.Q 2010.

IDF Intel hat auf dem IDF Larrabee erstmals offiziell in Aktion gezeigt. Die Chiparchitektur soll Basis einer neuen Generation von Grafikkarten sein.

Auch zum Marktstart von Larrabee gab es keine konkreten Aussagen. "Im nächsten Jahr", also 2010, ist Intels einzige Angabe dazu.

siehe auch auf Computerbase: Intel Larrabee kommt Ende 2009 für „Gaming“

IDF: Larrabee-GPU soll in künftige Intel-Prozessoren einziehen

Also, für die Nvidia-Fans, mit Graka hat das hier absolut nix zu tun, das ist nicht zum Zocken gedacht (wohl ev. geeignet ala wie der Larrabee-GPU von Intel, welcher sich noch in der Entwicklung befindet, wenn dann mal in der Zukunft, in späteren Entwicklungen, mit neuartigen Grafikdarstellungen...), sondern wohl für Anwendungen u. wird wohl mind. ü. 700,-€-1000,-€ kosten, für best. Wissenschaftliche- u. Forschungs- u. Entwicklungsbereiche ala Herstellerentwicklungen (fürn Flugzeugbau, NASA, Filmindustrie, Fahrzeug-, Motorenbau, Medizientechnik, Genetik... usw.).

Damit ist nix zocken.

Euer Graka Chip kommt doch erst als umgemodelte Version, dann halt im 2.Quartal, frühestens 1.Q 2010.

IDF Intel hat auf dem IDF Larrabee erstmals offiziell in Aktion gezeigt. Die Chiparchitektur soll Basis einer neuen Generation von Grafikkarten sein.

Mit so viel Vorschusshype, der nun auch von Intel angefacht wurde, war das erste öffentliche Auftreten von Larrabee umso ernüchternder. Die wenigen bewegten Objekte der Szene ruckelten über die Leinwand, was erkennbar nicht am Beamer lag. Schon die im Juni gezeigten Vorführungen desselben Spiels, und dabei noch auf nur acht CPU-Kernen, waren wesentlich eindrucksvoller.

Auch zum Marktstart von Larrabee gab es keine konkreten Aussagen. "Im nächsten Jahr", also 2010, ist Intels einzige Angabe dazu.

siehe auch auf Computerbase: Intel Larrabee kommt Ende 2009 für „Gaming“

Zuletzt bearbeitet:

nekro1

Lt. Commander

- Registriert

- Feb. 2007

- Beiträge

- 1.904

White_Eagle schrieb:Also, das Teil wird nen Konkurrenzprodukt zum Intel Larrabee: Kombinierte CPU/GPU enttäuscht

IDF: Larrabee-GPU soll in künftige Intel-Prozessoren einziehen

Also, für die Nvidia-Fans, mit Graka hat das hier absolut nix zu tun, das ist nicht zum Zocken gedacht (wohl ev. geeignet ala wie der Larrabee-GPU von Intel, welcher sich noch in der Entwicklung befindet, wenn dann mal in der Zukunft, in späteren Entwicklungen, mit neuartigen Grafikdarstellungen...), sondern wohl für Anwendungen u. wird wohl mind. ü. 700,-€-1000,-€ kosten, für best. Wissenschaftliche- u. Forschungs- u. Entwicklungsbereiche ala Herstellerentwicklungen (fürn Flugzeugbau, NASA, Filmindustrie, Fahrzeug-, Motorenbau, Medizientechnik, Genetik... usw.).

Damit ist nix zocken.

Euer Graka Chip kommt doch erst als umgemodelte Version, dann halt im 2.Quartal, frühestens 1.Q 2010.

So isses , als ich die Interfaces der GGPU gesehen habe, war mir direkt klar was NVIDIA vorhat

Bin echt sehr gespannt was die nächsten Steps von Intel in der Richtung sind!

Ich sehs schon kommen am ende haben wir 8 CPUS wie in den Consolen die alles können und dann heist es ATI ? Nöööööööööö brauchen wir nicht! Oder! GEIL ATI helft uns mal ;-) Wobei ATI ja an der gleichen Entwicklung sitzt

Mit Sandy Bridge, so Maloney, geht die Integration einen Schritt weiter: CPU und GPU sitzen dann auf demselben Die, so wie es AMD mit den "echten" Fusion-Chips wie Orochi und Llano ab 2011 ebenfalls plant.

Zuletzt bearbeitet:

Luxmanl525

Admiral

- Registriert

- Mai 2007

- Beiträge

- 9.197

Hallo zusammen,

nachfolgend ein Artikel von Golem.de, welcher nun definitiv die Eckdaten des G300 oder wie er nun genannt wird, "Fermi" GPU-Chips offiziell darlegt. Und um das gleich vorweg zu Nehmen, von Spielen ist seitens Nvidia nicht die Rede bei diesem Chip!

Hier der Link, viel Spaß beim Lesen:

http://www.golem.de/0909/70179.html

An der Stelle möchte ich anmerken, daß Golem.de eine sehr verläßliche Quelle ist, auf zumindest ähnlichem Niveau wie Heise.de.

So long....

nachfolgend ein Artikel von Golem.de, welcher nun definitiv die Eckdaten des G300 oder wie er nun genannt wird, "Fermi" GPU-Chips offiziell darlegt. Und um das gleich vorweg zu Nehmen, von Spielen ist seitens Nvidia nicht die Rede bei diesem Chip!

Hier der Link, viel Spaß beim Lesen:

http://www.golem.de/0909/70179.html

An der Stelle möchte ich anmerken, daß Golem.de eine sehr verläßliche Quelle ist, auf zumindest ähnlichem Niveau wie Heise.de.

So long....

Luxmanl525 schrieb:Und um das gleich vorweg zu Nehmen, von Spielen ist seitens Nvidia nicht die Rede bei diesem Chip!

und? sagt genau nichts über die spieleperformance.

intressiert auch auf der konferenz nicht (vorerst).

nvidia will ja erstmal nur die absoluten neuheiten vorstellen.

spieleperformance ist einfach schon dabei, werden wir aber auch noch genauer sehen.

mit der zeit wird auch sowas noch angesprochen werden.

die gpu-tech is ja auch nochnet zuende.

nekro1

Lt. Commander

- Registriert

- Feb. 2007

- Beiträge

- 1.904

@white_eagle

Das wird die Jahre richtig interessant und wenn dann noch die Raytray engine kommt (aus deinem Link)! Bin ja fast vom Hockergefallen was die aus Q3 udn Q4 gemacht haben ;-) Hrr wird das ein spass.

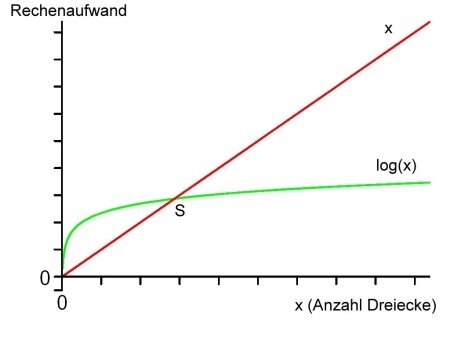

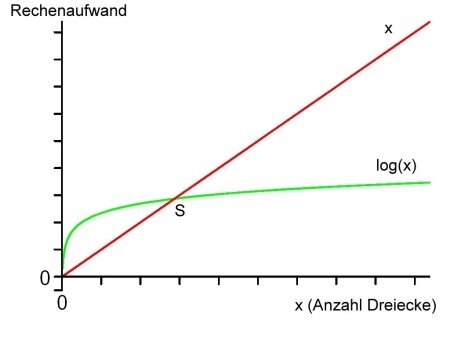

Wenn man sich die Komplexität anschaut! einfach nur toll. O(log n) *g* Meine Algos waren nie so gut ;-)

Ich kenn jetzt nicht die Komplexitsklassen und die zugehöriegen Ordnungen der anderen Engines, aber das klingt sehr viel versprechend

Letzten Gerüchten zu Folge besitzt das Produkt mindestens 16 Prozessorkerne, wobei jeder Kern 4-faches Multithreading unterstützt.

Das wird die Jahre richtig interessant und wenn dann noch die Raytray engine kommt (aus deinem Link)! Bin ja fast vom Hockergefallen was die aus Q3 udn Q4 gemacht haben ;-) Hrr wird das ein spass.

Wenn man sich die Komplexität anschaut! einfach nur toll. O(log n) *g* Meine Algos waren nie so gut ;-)

Ich kenn jetzt nicht die Komplexitsklassen und die zugehöriegen Ordnungen der anderen Engines, aber das klingt sehr viel versprechend

Zukunft

Raytracing hat das Potenzial, die weitläufig eingesetzte Rendering-Technologie auf Desktop-PCs zu werden. Die Anzahl der CPU-Kerne steigt und Prototypen einer Spezialhardware für Raytracing zeigen beeindruckende Ergebnisse bezüglich der Geschwindigkeit: Mit einem mit 90 MHz getakteten Prototypen konnte in etwa die Geschwindigkeit eines virtuellen Pentium 4 mit 10 GHz erreicht werden. Eine für den Massenmarkt angefertigte Karte könnte höher getaktet werden, mehrere Raytracing-Cores in einer GPU enthalten, mehrere GPUs auf einer Karte besitzen und man könnte mehrere dieser Karten in einen Rechner einbauen. Schon ist man sehr schnell bei flotten Frameraten in hohen Auflösungen.

Zuletzt bearbeitet:

Mizukag3

Lt. Junior Grade

- Registriert

- Feb. 2007

- Beiträge

- 336

wenn der chip rein theoretisch (in 55 mn gedacht) um (annahme) >40% - 50% größer ist als der G200 dann wird nvidia die leistungsaufnahme mit unter 200 W (selbiger in 40 nm) noch beziffern was ja dann im vergleich zu den "alten" karten nicht soviele Watt mehr wären.

find ich cool wenn die da son dickes rechenwerk rausbringen.. wenn ich jetzt ne anwendung hätte die ich darauf sinnvoll laufen lassen könnte was sich für mich lohnen würde dann würd ich die vllt auch kaufen

find ich cool wenn die da son dickes rechenwerk rausbringen.. wenn ich jetzt ne anwendung hätte die ich darauf sinnvoll laufen lassen könnte was sich für mich lohnen würde dann würd ich die vllt auch kaufen

mediamaxx

Cadet 4th Year

- Registriert

- Jan. 2009

- Beiträge

- 125

GPU Computing, ich lach mich schlapp! Wie hier einige Fanboys sich am GPU-Computing aufgeilen und meinen Desktop CPUs seien jetzt überflüssig, das ganze erinnert mich jetzt schon an das Cell-Prozessor-Gedöns, der ja angeblich 1000mal schneller sein soll als jede andere X86 CPU- ja ja. Letztenendes entscheidet das meist verbreitete Betriebssystem wo's lang geht und da wird Intel/AMD auch in Zukunft den Ton angeben. GPUs/CPUs die in irgendwelchen theoretischen Umgebungen theoretische Phantasieleistungen ala CELL erreichen sind höchstens interessannt für Marketing-Abteilungen und aufnahmewillige Fanboys, die sich dann damit brüsten können die schnellstmögliche CPU ihr eigen zu nennen, rein theoretisch natürlich (siehe Playstation 3 Fanboys, die haben den Doktortitel was Theorie betrifft mittlerweile errungen  )

)

Zuletzt bearbeitet:

Motkachler

Lt. Commander

- Registriert

- Sep. 2004

- Beiträge

- 1.563

Ich hoffe nur das wenigstens ATI weiter Graphikkarten zum spielen baut und nicht mit solchen eierlegenden Wollmilchsäuen gegen Itel anstinken will. Ziemlich sicher würde man da sonst genauso den kürzeren ziehen wies NV gehen wird. Bleibt nur zu hoffen das NV auch ne reine Gamerkarte bringen wird sonst seh ich schwarz für die grünen.

.xXASUSXx.

Banned

- Registriert

- Sep. 2008

- Beiträge

- 1.494

Ähnliche Themen

- Antworten

- 120

- Aufrufe

- 23.245