Aber das passiert doch nicht, wenn man Tone-Mapping im TV deaktiviert hat, oder? Dann müssten doch die Farben einfach nur auf die Maximalhelligkeit geclippt werden ohne Rolloff (welche dann je nach beanspruchter Fläche auf dem Bildschirm dann zu Dimming führen kann). Mir geht es ja im Endeffekt nur darum, die korrekten EDID-Werte einzutragen. Das Dimming ist halt wie es ist. Und wenn sich der Peak-Wert auf 10 % Weiß bezieht, dann muss ich da ja auch nur den Wert bei 10 % Weiß messen. Oder liege ich da falsch?SeniorWitti schrieb:Ja aber das macht ja dein TV von Haus aus. Der hat ein ToneMapping.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

HDR unter Windows, Howto

- Ersteller Blackfirehawk

- Erstellt am

Stagefire

Lt. Commander

- Registriert

- Feb. 2008

- Beiträge

- 1.197

SeniorWitti schrieb:Kein LG OLED schafft die Anforderungen von Display HDR True Black. Die 600er wird nicht erreicht. Die 500er wird auch nicht erreicht. Selbst die 400er wird um ca. 30% verfehlt, da LG OLEDs keine 250 nits bei vollflächigem Weiß halten können. Die schaffen noch nicht einmal 200nits.

Bei 100 % weiss sind OLEDs bei so 140 Nits ... die Frage is halt reicht es 1 Sache von den 3 Minimum Luminance Leveln zu schaffen ? Zb bei HDMI 2.1 reicht es auch 1 Sache von HDMI 2.1 zu können von mehreren Dingen die es gibt und schon darf sich der Anschluss HDMI 2.1 nennen obwohl es garnich voll umfänglich unterstüzt wird.

10 % packen sie ja die über 800 Nits ... beim 100 % Flash Test kann ich mir auch vorstellen das sie die 350 Nits und mehr für diese Zeit halten können da ABL ja etwas brauch zum Abdunkeln. Nur unten der Letzte Test da schaffen sie die 350 Nits nicht dort sacken sie dann auf so 140 Nits ab.

Aber vielleicht reicht ja auch 1/3 oder 2/3 sachen schon aus um zu bestehen kein plan.

Wenn nich erklärt das aber dann warum LG damit nich wirbt.

Aber dann Frage ich mich warum gibt es diese Kategorien überhaupt wenn kein OLED sie besteht ?

Und warum wurde im Jahr 2021 diese Kategorie erweitert um True Black 600 ?

Wenn die OLEDs True Black 400 und 500 schon nich schaffen brauch man doch dann

keine Erweiterrung auf True Black 600 wenn kein OLED das schafft ... und diese

Kategorie is ja extra für OLED .... schon seltsam oder ?

https://www.computerbase.de/news/monitore/oled-vesa-fuehrt-displayhdr-true-black-600-ein.77860/

https://www.heise.de/news/Konstrast...lack-600-als-hoechste-Einstufung-6181782.html

Am Ende isses aber eh egal .. wichtig is das die Helligkeit passt die man sieht ... für mich könnten

OLEDs aber definitiv nochmal so gute 300 Nits mehr haben ... bin auf 2022 gespannt

ob LG dann auch entlich den Heatsink verbaut wie es Panasonic mit dem Panasonic JZ2000

schon macht damit LG dann die 1000 Nits knackt.

VaniKa schrieb:Oder liege ich da falsch? Wie hell das Bild dann wirklich ist, spielt ja eigentlich keine Rolle, wenn es um die Software-Konfiguration einer Obergrenze geht, damit das Tone-Mapping sich in einem Bereich bewegt, den der Bildschirm noch differenziert darstellen kann.

Ne du liegst da schon richtig denk ich ... aber ich hab mich da was das Test Pattern Ding angeht schon vor ner Weile ausgeklingt .. ich hab da nun bei CRU stehen :

Max Lumi = 128

Max Frame AVG = 128

Min Lumi = Blank

Und lass das nun auch so .. den SDR Slider hab ich mom auf 20 stehen und passt sschon so ...

Finds aber gut wenn Leute wie du sich da noch mehr reinsteigern und vielleicht noch das eine

oder andere rausfinden.

Ergänzung ()

VaniKa schrieb:Aber das passiert doch nicht, wenn man Tone-Mapping im TV deaktiviert hat, oder?

Dynmaisches Tone Mapping is was anderes als das normale Tone Mapping es is eben Dynamisch und verändert dann das Normale Tone Mapping was hinterlegt wurde.

Dynamisches Tone Mapping heisst das der TV von sich aus jedes Bild einzelnt analysiert

und die Helligkeitswerte verteilt.

HGIG wiederrum basiert auf ein Angepastes Tone Mapping ( Falls im Spiel Kompatible )

was die HGIG Group erstellt hat. Und HGIG Clipped auch bei so 700 - 800 Nits ... HGIG is sehr beliebt im

AVS Forum und Konsolen Spielern und für HGIG sind diese CRU Änderungen auch am wichtigsten.

Dynamisches Tone Mapping aus heisst er nutzt Stur die Meta Daten die im Spiel / Film hinterlegt wurden

ohne etwas anzupassen und damit wird dann das Normale Tone Mapping genutzt.

Diese 3 Arten haben wir ja bei unseren OLEDs zur Auswahl im TV Menu

Zuletzt bearbeitet:

D.h. es gibt auch einen sanften Rolloff bei der Tone-Mapping-Einstellung auf "Aus"? Ich hatte jetzt gedacht, dass die Helligkeit dann linear verläuft und sich dann einfach hart den Kopf an der Obergrenze anstößt, ab wo es nicht mehr heller werden kann, zumindest sofern die Software selbst kein Tone-Mapping betreibt. Wenn der TV natürlich trotzdem sanft limitiert, ist das Ergebnis eines Test-Patterns möglicherweise weniger akkurat. Dann werden ja auch Werte, die eigentlich jenseits der darstellbaren Helligkeit liegen, noch unterschiedlich hell dargestellt. Dann frage ich mich, wie man da optimal den Punkt erkennt, an dem eigentlich die maximale Helligkeit liegt. Das geht wohl nur über eine Messkurve über ein externes Messgerät, das die realen Helligkeitswerte misst und man dann die eingestellten Nit-Werte mit den tatsächlich wiedergegebenen Werten abgleicht und schaut, ab wann es nicht mehr (hinreichend) linear ist. Aber das geht mir dann auch zu weit.Stagefire schrieb:Dynamisches Tone Mapping aus heisst er nutzt Stur die Meta Daten die im Spiel / Film hinterlegt wurden

ohne etwas anzupassen und damit wird dann das Normale Tone Mapping genutzt.

Vielleicht ist das aber auch nicht nötig. Dann ist es halt nicht linear und 700 Nits unterscheiden sich vielleicht viel weniger von 750 Nits als 550 von 600 beim B1, aber immerhin erkenne ich ja so wie der TV eben arbeitet dennoch einen Unterschied und kann diesen Bereich noch irgendwie nutzen. Würde ich eine Obergrenze wählen, die darunter liegt, würde es bei dieser ja auch dunkler sein als eben bei der höheren Obergrenze. Highlights könnten also dann bei 750 versus 600 Nits zwar vielleicht nicht wirklich mit 150 Nits mehr aufwarten, aber vielleicht ja doch noch mit 50. Und warum sollte man darauf freiwillig verzichten? Insofern bleibt ja eigentlich alles beim alten. Solange man noch einen Unterschied sehen kann in der Helligkeit, ist es auch sinnvoll, diesen Bereich zu nutzen, außer man möchte einen möglichst linearen Verlauf ermöglichen auf Kosten von maximaler Helligkeit.

Stagefire

Lt. Commander

- Registriert

- Feb. 2008

- Beiträge

- 1.197

VaniKa schrieb:D.h. es gibt auch einen sanften Rolloff bei der Tone-Mapping-Einstellung auf "Aus"?

Ich muss ehrlich sagen ich komm da nich mehr ganz mit

Du scheinst da schon recht tief in der Materie drinn zu sein.

Was Tone Mapping angeht kenn ich mich nur recht oberflächlich aus

und weiss halt nur das es da diese Unterschiede gibt.

Falls du Englisch kannst oder mit dem Google Translator umgehen kannst

schau doch mal im AVS Forum vorbei dort wurde im CX Gaming Thread

schon recht viel bzgl der CRU Werte und Clipping usw gesprochen

und vergleiche angestellt mit Test Patterns .. aber die gehen halt hart auf HGIG.

Hier findest du zb Jasons Test Pattern Tests die er mit verschiedenen CRU Werten gemacht hat

https://www.avsforum.com/threads/20...onsoles-and-pc.3138274/page-683#post-61103794

Aber wie gesagt .. ich hab da die Werte stehen die ich genannt hatte in CRU und geb mich

damit einfach zufrieden. Aber ich achte auch nich so auf diese Clipping und Test Pattern sachen

sondern Zocke einfach. Hatte ja hier im Thread nur ne kurze Phase gehabt wo ich mir auch

mal diese Vierecke da angeschaut hab .. aber bei mir passte da im Grunde alles.

Zuletzt bearbeitet:

Eigentlich gar nicht. Ich hab den TV jetzt gut eine Woche und hatte eigentlich gedacht, alles richtig eingestellt zu haben. Bis ich dann, ich weiß gar nicht mehr weshalb, über das Thema der EDID-Nit-Angaben gestolpert bin und dass Windows die beim Fehlen falsch ermittelt. Und das hat mich dann nicht losgelassen. 😉 Aber ich schaue mal im AVS-Forum rein! 👍Stagefire schrieb:Du scheinst da schon recht tief in der Materie drinn zu sein.

- Registriert

- Dez. 2018

- Beiträge

- 2.394

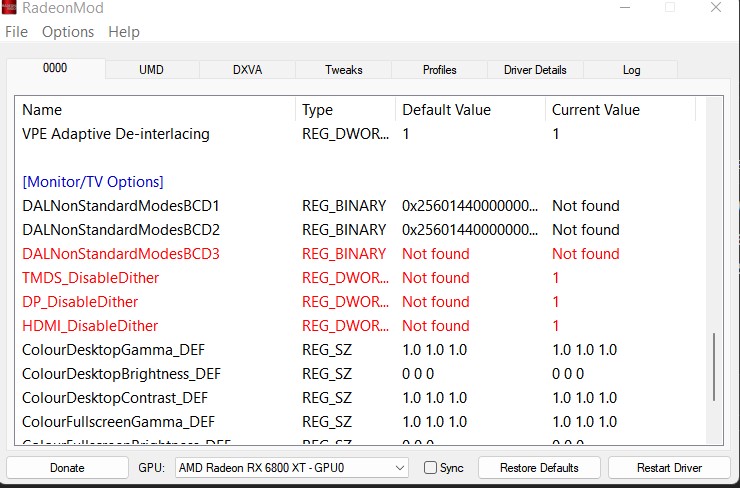

so mal was interessantes für AMD Nutzer

ihr braucht das Tool RadeonMod

https://forums.guru3d.com/threads/radeonmod-tweak-utility.403389/

das startet ihr im Administrator Modus:

hier könnt ihr Global Dithering Ausschalten.. es wird also nicht erst berechnet und hin und her konvertiert..

es überlässt dem Monitor das Dithering via FRC

danach den Rechner neu Starten..

Vorsicht RESTART DRIVER ist Buggy in dem programm.. und die AMD software mag das gar nicht!

lieber den Rechner neu starten

ihr braucht das Tool RadeonMod

https://forums.guru3d.com/threads/radeonmod-tweak-utility.403389/

das startet ihr im Administrator Modus:

hier könnt ihr Global Dithering Ausschalten.. es wird also nicht erst berechnet und hin und her konvertiert..

es überlässt dem Monitor das Dithering via FRC

danach den Rechner neu Starten..

Vorsicht RESTART DRIVER ist Buggy in dem programm.. und die AMD software mag das gar nicht!

lieber den Rechner neu starten

@Stagefire

Ich muss zugeben, dass mich das AVS-Forum etwas überfordert, weil es einfach zu viel ist. Ich kann oder eher möchte nicht mehrere hundert Seiten lesen. Ich habe aber dennoch ein paar neue Erkenntnisse. Und zwar scheint der HGiG-Modus dazu da zu sein, um im Monitor sämtliches Tone-Mapping abzuschalten, um das eben der Software zu überlassen, also dem jeweiligen Spiel, den Windows-Einstellungen oder der Konsole. Somit ist das auch der beste Modus, um Testmuster zu nutzen.

Was die Testmuster angeht, so habe ich herausgefunden, dass das Testmuster mit 100 % weißer Fläche beim gleichen eingestellten Nit-Wert sein Maximum erreicht wie beim 10-%-Test. Vielleicht ist das der Grund, warum inzwischen empfohlen wird, bei CRU den zweiten Wert (AVG) identisch zum ersten Wert (Peak) zu setzen. Natürlich erreicht man da punktuell nicht die gleiche Helligkeit, man erreicht aber bis zum gleichen Wert eine Differenzierbarkeit der Helligkeiten, kann also das Logo noch vom Hintergrund unterscheiden. In meinem Fall beim LG OLED B1 war das Test-Logo jeweils ab 750 Nits (CRU-Wert 125) komplett unsichtbar im 10-%- und 100-%-Test. Das ist in der Form vielleicht auch OLED-spezifisch, weil andere Technologien ja nicht diese Abdunklung haben.

Und dann ist mir noch etwas aufgefallen. Es geht hier im Thread ja auch darum, den HDR-Modus unter Windows dauerhaft als Alternative zum SDR-Modus zu benutzen und HDR und SDR möglichst aneinander anzugleichen. Ich hatte erst nicht gesehen, dass der TV für den SDR- und HDR-Modus auch zwei verschiedene Einstellungen speichert. Nachdem ich beides angeglichen hatte, habe ich festgestellt, dass der Standardwert von 40 bei der SDR/HDR-Helligkeit in Windows beide Modi auch so weit es ging gleich aussehen ließ. Bei HDR-SDR waren die Farben zwar im Detail leicht anders als im nativen SDR, aber grundsätzlich passte das bei 40. Es wird also wohl seinen Grund haben, dass das der Standardwert ist, was auch immer die Zahl 40 da genau aussagen soll. Verglichen habe ich das bei 100 OLED-Helligkeit und 100 Kontrast in beiden Modi. Wenn man das SDR dunkler haben will als das HDR, dann kann man den Wert natürlich senken, auch um den Bildschirm zu schonen, aber dabei muss man auch berücksichtigen, dass der Slider auch Spiele betrifft, die kein natives HDR verwenden, z.B. auch Auto-HDR-Spiele. Ich bin mir nur noch nicht sicher, ob grundsätzlich alle, oder ob das nur Spiele betrifft, die keinen echten Vollbildmodus verwenden und daher die Desktop-Einstellungen dort greifen. Wenn ich aber Screenshots bei einem nativen HDR-Spiel mit einem Auto-HDR-Spiel vergleiche, dann stelle ich fest, dass die Screenshots bei Ersterem total ausgewaschen sind, da das Mapping von HDR zu SDR da offenbar gar nicht klappt, aber bei den Auto-HDR-Spielen sehen die Screenshots normal aus, was mich vermuten lässt, dass die Spiele eigentlich für sich weiter in SDR laufen und lediglich "oben drauf" erweitert werden, was dann in Screenshots nicht berücksichtigt wird. Das würde auch erklären, warum der SDR/HDR-Slider diese Spiele betrifft. Wenn man diese Spiele also in ihrer (Auto-)HDR-Ausdruckskraft nicht schwächen will, sollte man den Slider auf 40 lassen.

Ich muss zugeben, dass mich das AVS-Forum etwas überfordert, weil es einfach zu viel ist. Ich kann oder eher möchte nicht mehrere hundert Seiten lesen. Ich habe aber dennoch ein paar neue Erkenntnisse. Und zwar scheint der HGiG-Modus dazu da zu sein, um im Monitor sämtliches Tone-Mapping abzuschalten, um das eben der Software zu überlassen, also dem jeweiligen Spiel, den Windows-Einstellungen oder der Konsole. Somit ist das auch der beste Modus, um Testmuster zu nutzen.

Was die Testmuster angeht, so habe ich herausgefunden, dass das Testmuster mit 100 % weißer Fläche beim gleichen eingestellten Nit-Wert sein Maximum erreicht wie beim 10-%-Test. Vielleicht ist das der Grund, warum inzwischen empfohlen wird, bei CRU den zweiten Wert (AVG) identisch zum ersten Wert (Peak) zu setzen. Natürlich erreicht man da punktuell nicht die gleiche Helligkeit, man erreicht aber bis zum gleichen Wert eine Differenzierbarkeit der Helligkeiten, kann also das Logo noch vom Hintergrund unterscheiden. In meinem Fall beim LG OLED B1 war das Test-Logo jeweils ab 750 Nits (CRU-Wert 125) komplett unsichtbar im 10-%- und 100-%-Test. Das ist in der Form vielleicht auch OLED-spezifisch, weil andere Technologien ja nicht diese Abdunklung haben.

Und dann ist mir noch etwas aufgefallen. Es geht hier im Thread ja auch darum, den HDR-Modus unter Windows dauerhaft als Alternative zum SDR-Modus zu benutzen und HDR und SDR möglichst aneinander anzugleichen. Ich hatte erst nicht gesehen, dass der TV für den SDR- und HDR-Modus auch zwei verschiedene Einstellungen speichert. Nachdem ich beides angeglichen hatte, habe ich festgestellt, dass der Standardwert von 40 bei der SDR/HDR-Helligkeit in Windows beide Modi auch so weit es ging gleich aussehen ließ. Bei HDR-SDR waren die Farben zwar im Detail leicht anders als im nativen SDR, aber grundsätzlich passte das bei 40. Es wird also wohl seinen Grund haben, dass das der Standardwert ist, was auch immer die Zahl 40 da genau aussagen soll. Verglichen habe ich das bei 100 OLED-Helligkeit und 100 Kontrast in beiden Modi. Wenn man das SDR dunkler haben will als das HDR, dann kann man den Wert natürlich senken, auch um den Bildschirm zu schonen, aber dabei muss man auch berücksichtigen, dass der Slider auch Spiele betrifft, die kein natives HDR verwenden, z.B. auch Auto-HDR-Spiele. Ich bin mir nur noch nicht sicher, ob grundsätzlich alle, oder ob das nur Spiele betrifft, die keinen echten Vollbildmodus verwenden und daher die Desktop-Einstellungen dort greifen. Wenn ich aber Screenshots bei einem nativen HDR-Spiel mit einem Auto-HDR-Spiel vergleiche, dann stelle ich fest, dass die Screenshots bei Ersterem total ausgewaschen sind, da das Mapping von HDR zu SDR da offenbar gar nicht klappt, aber bei den Auto-HDR-Spielen sehen die Screenshots normal aus, was mich vermuten lässt, dass die Spiele eigentlich für sich weiter in SDR laufen und lediglich "oben drauf" erweitert werden, was dann in Screenshots nicht berücksichtigt wird. Das würde auch erklären, warum der SDR/HDR-Slider diese Spiele betrifft. Wenn man diese Spiele also in ihrer (Auto-)HDR-Ausdruckskraft nicht schwächen will, sollte man den Slider auf 40 lassen.

Stagefire

Lt. Commander

- Registriert

- Feb. 2008

- Beiträge

- 1.197

VaniKa schrieb:Ich muss zugeben, dass mich das AVS-Forum etwas überfordert, weil es einfach zu viel ist. Ich kann oder eher möchte nicht mehrere hundert Seiten lesen.

Das is anfangs immer so wenn man in einen laufenden Thread neu einsteigt ... aber der Post wo der Link hinführte war ja schonmal aussagekräftig. Der Verfasser des Post "Jason" is auch der der den Reddit OLED Post erstellt hat der immer verlinkt wird wenn Leute nach einstellungen fragen ... die CRU Sache wurde dort auch schon übernommen.

https://www.reddit.com/r/OLED_Gamin...urce=share&utm_medium=ios_app&utm_name=iossmf

Jedenfalls reicht es die Seiten zu lesen ab dem Post den ich verlinkte .. sind dann nur ein paar Seiten bis man aktuell is. ( 40 Seiten ) in den 40 Seiten geht es natürlich auch noch um andere Dinge is ja ein

Allgemeiner Thread für CX Gaming.

Dennoch empfehle ich ihn da es dort einige Kluge Köpfe gibt.

VaniKa schrieb:Und zwar scheint der HGiG-Modus dazu da zu sein, um im Monitor sämtliches Tone-Mapping abzuschalten, um das eben der Software zu überlassen, also dem jeweiligen Spiel, den Windows-Einstellungen oder der Konsole. Somit ist das auch der beste Modus, um Testmuster zu nutzen.

HGIG is bei einigen Games auch besser bezüglich Highlights .. kostet aber in manchen Games allgemeine Bildhelligkeit und sieht aus wie Dyn. Mapping aus. Daher mag ich das nich so gerne ... nutze meisst Dynamisches Tone Mapping an ... das hellt aber leider auch das Gesamte Bild auf und auch die Highlights sodass die Highlights weniger gut hervorstechen können vom Gesamtbild.

Aber ich bin halt jemand der Helligkeit brauch ( bin halt von den HDR 1000 versaut worden ) daher nutz ich zu 80 % Dyn. Mapping on und nur zu 20 %

HGIG.

Auf Konsolen läuft HGIG aber Prinzipiel besser. Das hat auch was mit den Games zu tun.

VaniKa schrieb:Was die Testmuster angeht, so habe ich herausgefunden, dass das Testmuster mit 100 % weißer Fläche beim gleichen eingestellten Nit-Wert sein Maximum erreicht wie beim 10-%-Test. Vielleicht ist das der Grund, warum inzwischen empfohlen wird, bei CRU den zweiten Wert (AVG) identisch zum ersten Wert (Peak) zu setzen.

Das haben wir uns damals im Verlinkten AVS Thread erarbeitet ... Jason hat Tests gemacht und in Vicents Video sah man auch das beides auf 800 das beste ergebniss brachte für HGIG ... auf den Konsolen kann man das

einstellen im Menu ohne sowas wie CRU zu nutzen .. dort gibt es so ein Calibrations Screen das haben wir bei Windows nicht.

Da war dieses Video was ich hier glaub ich auch schonmal verlinkt hatte : ( dort sieht man auch die 800 , 800 , 0 aber halt im Xbox Kalibrirungs Menu aber eben für HGIG .. achte mal was er ausserhalb von HGIG wählt )

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Ausserhalb von HGIG profitiert man aber nich von den CRU einstellungen.

Auch das wurde im AVS besprochen.

VaniKa schrieb:Ich hatte erst nicht gesehen, dass der TV für den SDR- und HDR-Modus auch zwei verschiedene Einstellungen speichert.

Jepp ... HDR sowie SDR Profil im TV kann man unterschiedlich einstellen.... gleiches gilt auch für den Filmmaker Mode , Cinema Mode , Cinema Home Mode usw.

Man kann bei jedem Profil andere TV EInstellungen einstellen ... bei den neuen 2021 Modellen kann man aber auch zusätzlich soweit ich weiss auch einstellen das einstellungen für alle Profile übernommen werden sodass man nich jedes Provfiel einzelnt einstellen muss.

VaniKa schrieb:Nachdem ich beides angeglichen hatte, habe ich festgestellt, dass der Standardwert von 40 bei der SDR/HDR-Helligkeit in Windows beide Modi auch so weit es ging gleich aussehen ließ.

Ich muss auf Windows SDR Slider 20 gehen im HDR Mode um die selbe Helligkeit zu haben wie in SDR mit OLED Light 35

VaniKa schrieb:Bei HDR-SDR waren die Farben zwar im Detail leicht anders als im nativen SDR, aber grundsätzlich passte das bei 40.

Ja .. das is ein Punkt den ein User im Luxx immer aufführt der strickt auf "Akkuratheit" aus is.

Ich merke davon aber nix ... bei mir is irgendwie beides gleich.

Bin auch noch im HWLuxx OLED Thread unterwegs

https://www.hardwareluxx.de/communi...s-pc-bildschirm-hdmi-2-1-vrr.1246942/page-357

Dort is das auch grad Thema ... es ging Gestern zb um den Stromverbrauch vom OLED im SDR Mode und im HDR Mode weil wir ja mit der CRu Änderung und dem SDR Slider im HDR Mode bleiben ... TZGamer is dort ein schlauer Bursche er ist Mr Akkurat

VaniKa schrieb:aber dabei muss man auch berücksichtigen, dass der Slider auch Spiele betrifft, die kein natives HDR verwenden, z.B. auch Auto-HDR-Spiele.

Klar ... jegliches SDR Material wird vom Windows SDR Slider beeinflusst.

VaniKa schrieb:Wenn ich aber Screenshots bei einem nativen HDR-Spiel mit einem Auto-HDR-Spiel vergleiche, dann stelle ich fest, dass die Screenshots bei Ersterem total ausgewaschen sind, da das Mapping von HDR zu SDR da offenbar gar nicht klappt

Ne das liegt daran das man nich so easy HDR Screenshots machen kann ... hab mich damit auch schon befasst. Mit Ansel bekommt man zb 2 Bilder die man mit Photoshop erst irgendwie zusammenfügen muss.

Mit der "Druck" Taste auf der Tastatur und dann in Paint einfügen bringt immer ein zuhelles Bild bei HDR hervor.

Hab noch kein Weg gefunden der easy is ein HDR Bild zu erstellen.

VaniKa schrieb:aber bei den Auto-HDR-Spielen sehen die Screenshots normal aus, was mich vermuten lässt, dass die Spiele eigentlich für sich weiter in SDR laufen und lediglich "oben drauf" erweitert werden was dann in Screenshots nicht berücksichtigt wird.

Korrekt .. da das Spiel ja ein SDR Game is und Auto HDR ja mit hilfe einer AI ein Tone Mapping macht

Das du die Auto HDR Helligkeit aber nochmal gesondert einstellen kannst weisst du oder ?

Win Taste + G für das neue Win 11 Overlay

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Zuletzt bearbeitet:

Ich denke, die Änderungen per CRU zu machen, wird auch nur an bestimmten Stellen greifen. Vielleicht wird das für Auto-HDR genutzt (würde Sinn ergeben, da es ja sonst keine Kalibrierung dafür gibt). Und Spiele könnten es theoretisch auch nutzen. Aber wenn man im Spiel eine eigene Kalibrierung hat, hat man dasselbe Ergebnis. HGiG deaktiviert eben einfach nur das Tone-Mapping und überlässt der Software alles. Und wenn man die Software eben richtig kalibriert hat, dann sollte man damit eigentlich ein optimales Ergebnis haben. Es geht halt darum, dass man nicht doppelt Tone-Mapping anwendet, erst per Software und dann nochmal per Monitor. Wenn man HGiG beim TV auswählt, muss man aber auch sicherstellen, dass das Tone-Mapping korrekt per Software erfolgt, sonst ist das Bild entweder zu lasch oder übersteuert.Stagefire schrieb:auf den Konsolen kann man das

einstellen im Menu ohne sowas wie CRU zu nutzen .. dort gibt es so ein Calibrations Screen das haben wir bei Windows nicht.

Liegt das vielleicht daran, dass du unterschiedliche TV-Einstellungen für SDR und HDR verwendest? Ich hatte sie ja maximal aneinander angeglichen und dabei eben auch die Intensität maximiert (SDR ist damit eben auch sehr hell). Wenn man den SDR-Modus dunkler einstellt als den HDR-Modus, muss man bei HDR-SDR per Regler die Helligkeit natürlich runter stellen, um so hell wie natives SDR zu sein. Es kommt also am Ende vor allem auf die Einstellungen am TV an, wie man den Regler einstellen muss. Meine Erfahrung ist eben, wenn beides quasi synchron ist, dass 40 dann beides (im Rahmen der unterschiedlichen Farbräume) gleich aussehen lässt. Ich sehe mich zumindest dadurch bestätigt, dass es eigentlich kein Zufall sein kann, dass es sich dabei um den Standardwert handelt.Stagefire schrieb:Ich muss auf Windows SDR Slider 20 gehen im HDR Mode um die selbe Helligkeit zu haben wie in SDR mit OLED Light 35

Ich habe übrigens auch mal mit den mittels CRU zusätzlich aktivierten Farbräumen herumgespielt und konnte keinerlei Effekt feststellen. Für mich ist das insofern eher Schlangenöl und ich nutze CRU ausschließlich für die Nit-Werte.

Bisher bin ich mir nicht mal sicher, ob die Nit-Werte überhaupt einen Effekt haben. Bei Software, die eine eigene Kalibrierung mitbringt, wohl ohnehin nicht. Wie gesagt, am ehesten bei Auto-HDR. Aber ich konnte eigentlich auch da keinen wirklichen Unterschied sehen. Und es war bei mir eben auch nicht so, dass nach der passenden Setzung der CRU-Werte SDR und HDR-SDR beim Slider-Wert 100 genau übereinstimmten. Es blieb bei 40, wo es passte. Die CRU-Werte hatten eigentlich gar keinen Einfluss auf den Slider. Es kann aber sicher nicht schaden, wenn die Werte grundsätzlich stimmen. Vielleicht kommt das erst noch, dass mehr und mehr Programme und Spiele diese Werte nutzen, möglicherweise auch nur, um einen Default-Wert zu setzen, den man trotzdem noch ändern kann im Spiel. Immerhin handelt es sich dabei ja um etwas, das es erst ab Windows 11 gibt.

Der Grund, warum Windows beim Fehlen der CRU-Werte den Default so hoch (1500 Nits) ansetzt, erschließt sich mir übrigens nach den ganzen Betrachtungen. Denn wenn die Werte genutzt werden, übersteuert die Software die Helligkeiten und das Tone-Mapping des Bildschirms regelt die wieder runter (sofern man nicht HGiG ausgewählt hat). Wären die Helligkeiten zu gering, würde das Bild hingegen dunkel und blass bleiben. Daher muss der Default höher sein als bei allen im Markt üblichen Geräten. Sollten die Werte genutzt werden und entsprechen den tatsächlichen Eigenschaften des Bildschirms, hat das den Vorteil, dass die Werte nicht unnötig hoch geboostet werden, um dann wieder entsprechend stark runtergeregelt werden zu müssen. Und es würde eben mit HGiG dann optimal funktionieren, weil die Helligkeitsmaxima dann genau den Möglichkeiten des Bildschirms entsprächen. Damit könnten Spiele auch viel besser selbst steuern, wie sie aussehen sollen.

Was insofern lediglich PC und Konsole voneinander unterscheidet, ist eine zentrale Kalibrierung. Aber wenn jedes HDR-Spiel eine eigene Kalibrierung mitbringt, ist das ja am Ende genau so gut, zumindest wenn man in der Lage ist, die jeweils vorzunehmen. Da ich den TV noch nicht lange habe, konnte ich bisher erst ein Spiel mit nativem HDR testen. Ich gehe aber davon aus, dass der Schlüssel immer in einer korrekten Kalibrierung im jeweiligen Spiel liegt und die CRU-Werte in dem Fall keinerlei Rolle spielen.

Eigentlich sollte Microsoft es so machen: Eine HDR-Kalibrierung bereit stellen, die die EDID-Werte ausliest und als Default nutzt. Man kann dann aber noch die Kalibrierung von Hand vornehmen und die Werte ändern. Spiele und andere Programme könnten dann diese Kalibrierung nutzen, unabhängig davon, ob ein Monitor diese Werte via EDID bereitgestellt hat oder nicht. Dann müsste auch niemand mit CRU herumspielen.

Von dem dynamischen Tone-Mapping werde ich mich wohl fernhalten, weil ich den Effekt aus dem Audiobereich kenne. Das ist so, als würde man alles nochmal durch einen Dynamik-Kompressor schicken und das verbessert nie die Klangqualität, sondern macht es zwar lauter, aber auf Kosten der Dynamik. Auf Bild übertragen erklärt das, warum dadurch alles heller wird. Das wirkt dann zwar alles oberflächlich krass, vermatscht aber auch die Kontraste. Zumal dann ja auch bei OLED eher eine Abdunklung getriggert wird, wenn alles immer so hell geboostet wird.

Warum HGiG übrigens bei dir dann vielleicht etwas zu schlapp wirkt im Vergleich zu dynamischem Tone-Mapping, liegt möglicherweise daran, dass du bei den Nit-Werten eigentlich noch etwas höher gehen könntest. So wie in meinem Fall ja auch. Laut RTINGS.com messen die ca. 600 Nits Peak beim B1, aber ich ermittle mittels Kalibrierung 750. Vielleicht wäre dann bei dir ein Wert von 950 passender. Das könntest du eigentlich ganz einfach mit der App "DisplayHDR Test" überprüfen (wenn HGiG aktiviert ist). Wenn du die Spiele auf den Wert kalibrierst, dürften die Highlights da auch heller ausfallen. Und sollte Auto-HDR das nutzen, würde das eben auch automatisch besser aussehen. 150 Nits sind ja schon eine deutliche Steigerung. Du bekommst auf jeden Fall mit HGiG und einer korrekten Kalibrierung die objektiv bessere Bildqualität. Ob dir das dann auch subjektiv besser gefällt, ist eine andere Sache.

Zuletzt bearbeitet:

Stagefire

Lt. Commander

- Registriert

- Feb. 2008

- Beiträge

- 1.197

VaniKa schrieb:Vielleicht wird das für Auto-HDR genutzt (würde Sinn ergeben, da es ja sonst keine Kalibrierung dafür gibt).

Eben für Auto HDR ist das Wichtig da Auto HDR sonst mit den Windows Default Werten arbeiten würde

was dann die falschen 1499 Nits währen. Alle anderen Mapping Arten werden ja vom TV gemaneget bzw durch HGIG oder den Meta Daten des Spiels / Films .. diese Meta Daten hat ein SDR Game ja nicht daher isses dann wichtig das Windows die Richtigen Nits Werte hat und keine Zauberwerte.

VaniKa schrieb:Aber wenn man im Spiel eine eigene Kalibrierung hat, hat man dasselbe Ergebnis.

Das weiss ich nich .... zum einen gibts es ne Handvoll Games die keine Kalibrierung in HDR haben .. spontan fällt mir da grade Metro Exodus ein sowie eben SDR Games.

VaniKa schrieb:HGiG deaktiviert eben einfach nur das Tone-Mapping und überlässt der Software alles. Und wenn man die Software eben richtig kalibriert hat, dann sollte man damit eigentlich ein optimales Ergebnis haben

Auch da bin ich mir nich sicher wie genau HGIG arbeitet ... soweit ich weiss is HGIG eine Gruppe von Entwicklern die Games anpassen daher sind es meist auch Konsolen Games die von HGIG Profitieren.

Aber so 100% bin ich da auch noch nich drinn.

Ich glaube aber nich das HGIG das Tone Mapping Deaktiviert sondern eher sein eigenes Tone Mapping macht.

Ich Persönlich hab halt eine leichte abneigung gegen HGIG weil es das Bild nich heller macht sondern nur die Highlights verbessert während das Dynamische Tone Mapping das Gesamte Bild Heller macht worunter

aber leider die Highlights leiden ... ich will halt so nah wie möglich an die HDR 1000 kommen und das komm ich mit Dyn. Mapping eher als mit HGIG.

Nur überstrahlen Highlights leider mit Dyn. Mapping hin und wieder und dann wähle ich HGIG.

VaniKa schrieb:. Es geht halt darum, dass man nicht doppelt Tone-Mapping anwendet, erst per Software und dann nochmal per Monitor. Wenn man HGiG beim TV auswählt, muss man aber auch sicherstellen, dass das Tone-Mapping korrekt per Software erfolgt, sonst ist das Bild entweder zu lasch oder übersteuert.

Ja das macht Sinn wenn ich das so lese ... aber warum sollte ein doppeltes Tone Mapping stattfinden ?

Das Dynamische Tone Mapping läuft doch so das der TV jedes Bild einzelnt analysiert und die Helligkeit

der Bereich selbst anpasst ohne auf die Meta Daten zuzugreifen.

HGIG macht auch sein eigenes Ding

Und Dyn. Mapping aus greift auch nur auf die normalen Meta Daten zu

Wo wird denn da was doppelt gemacht ?

VaniKa schrieb:Liegt das vielleicht daran, dass du unterschiedliche TV-Einstellungen für SDR und HDR verwendest?

Logischerweise .. so sollte man das auch machen.

SDR :

OLED Light 35 - 45 und Kontrast 90 und Helligkeit auf 50

HDR :

OLED Light 100 und Kontrast 100 und Helligkeit auf 50 lassen ( wichtig sonst passt das Mapping nich )

Mit dem SDR Slider auf 20 bin ich in HDR bei SDR Material wieder in dem Helligkeits Bereich wo

ich mit OLED Light 35 im SDR Mode bin ... das is ja der Sinn von dem SDR Slider das man die HDR Helligkeit von SDR Material so anpasst das es so is wie in SDR und dadurch kann man dann ja 24/7 HDR anlassen.

VaniKa schrieb:Ich hatte sie ja maximal aneinander angeglichen und dabei eben auch die Intensität maximiert (SDR ist damit eben auch sehr hell).

Wie gesagt .. bleibt man im alten Schema ohne SDR Slider und schaltet von HDR Mode auf SDR Mode hin und her je nach Game dann sollte man natürlich auch im SDR Mode mit seinem OLED Light runter gehen da man sonst riskiert am OLED früher einen Burn Out zu haben. Das is aber das 1mal1 der OLED Nutzung am PC.

VaniKa schrieb:Ich habe übrigens auch mal mit den mittels CRU zusätzlich aktivierten Farbräumen herumgespielt und konnte keinerlei Effekt feststellen. Für mich ist das insofern eher Schlangenöl und ich nutze CRU ausschließlich für die Nit-Werte.

Konnte ich sowie Leute aus dem AVS auch nich ... blieb alles gleich daher wird im Reddit Thread auch nur die 800 Nits Sache gezeigt.

VaniKa schrieb:Bisher bin ich mir nicht mal sicher, ob die Nit-Werte überhaupt einen Effekt haben. Bei Software, die eine eigene Kalibrierung mitbringt, wohl ohnehin nicht.

Also laut AVS im HGIG Mode mit passenden Games soll es da schon ein Unterschied geben

mir Persönlich is da aber auch noch nix aufgefallen ausser das die 800 nun in der Kallibierung von Games passen.

Bei HDR Games kann man ja zu 95 % die HDR Nit Helligkeit einstellen ... die hatte bei mir irgendwie nie gepasst. Bei Borderlands 3 musste ich auf 950 - 1000 Nits gehen und bei BF5 manchmal auf 2000 Nits damit

beide Seiten Gleichhell sind. Nun mit der CRU Änderung passt die Helligkeit der BF5 HDR Kalibrierung

zumindest so bei 800 - 900 Nits schon statt wie vorher ohne CRU Änderung erst mit 1400 - 2000 Nits.

Im Schnitt musste ich die Nits in der Game HDR Kalibierung immer so auf 1000 stellen statt auf die richtigen 800 Nits damit beide Seiten des Vierecks gleich hell sind.

VaniKa schrieb:Die CRU-Werte hatten eigentlich gar keinen Einfluss auf den Slider.

Sollten sie auch nich ... der Slider is ja wie gesagt nur zur Anpassung von SDR Material da wenn man im HDR Mode is.

Vor 1 - 2 Jahren war der HDR Mode in Windows noch arg Buggy ... stellte man den Monitor auf HDR

wurde alles viel zu hell dargestellt ... daher hat Microsoft den SDR Slider eingebaut vor einigen Jahren um diesen Fehler auszugleichen.

VaniKa schrieb:Immerhin handelt es sich dabei ja um etwas, das es erst ab Windows 11 gibt.

Was ? Den SDR Slider ? Den gabs schon in Win 10

VaniKa schrieb:Der Grund, warum Windows beim Fehlen der CRU-Werte den Default so hoch (1500 Nits) ansetzt, erschließt sich mir übrigens nach den ganzen Betrachtungen.

Windows nimmt die Default 1499 Nits weil Win nich auf die EDID des Monitors zugreifen kann wo diese Daten hinterlegt sind. Die X Box kann das aber wie man ja in dem Video sieht was ich verlinkt hatte von Vince.

Da muss Entweder LG mit ihrer EDID oder Microsoft mit ihrere Monitor Erkennung dran arbeiten

dann ändert sich das auch und man muss die CRU Änderung nich mehr machen.

VaniKa schrieb:Denn wenn die Werte genutzt werden, übersteuert die Software die Helligkeiten und das Tone-Mapping des Bildschirms regelt die wieder runter (sofern man nicht HGiG ausgewählt hat). Wären die Helligkeiten zu gering, würde das Bild hingegen dunkel und blass bleiben. Daher muss der Default höher sein als bei allen im Markt üblichen Geräten.

Achso meinst du das .. ja das macht absolut sinn.

VaniKa schrieb:Und es würde eben mit HGiG dann optimal funktionieren, weil die Helligkeitsmaxima dann genau den Möglichkeiten des Bildschirms entsprächen. Damit könnten Spiele auch viel besser selbst steuern, wie sie aussehen sollen.

HGIG is halt mehr so ein Konsolen Ding .. das hat Microsoft auf dem PC noch garnich so auf dem Schirm.

Sowas gibts ja auch bei normalen PC Monitoren nicht.

VaniKa schrieb:Ich gehe aber davon aus, dass der Schlüssel immer in einer korrekten Kalibrierung im jeweiligen Spiel liegt und die CRU-Werte in dem Fall keinerlei Rolle spielen.

Schon möglich ... das Spiel sollte man aber so oder so nochmal richtig Kalibrieren im Game Menu.

VaniKa schrieb:Eigentlich sollte Microsoft es so machen: Eine HDR-Kalibrierung bereit stellen, die die EDID-Werte ausliest und als Default nutzt. Man kann dann aber noch die Kalibrierung von Hand vornehmen und die Werte ändern. Spiele und andere Programme könnten dann diese Kalibrierung nutzen, unabhängig davon, ob ein Monitor diese Werte via EDID bereitgestellt hat oder nicht. Dann müsste auch niemand mit CRU herumspielen.

Ja das währe Perfekt ... aber HDR hängt halt noch hinterher am PC .. die Konsolen und TVs sind da halt schon ne ecke weiter als PCs und PC Monitore. HDR hat ja generell auf dem PC länger gebraucht um in die puschen zu kommen als auf den Konsolen wo es zb Auto HDR auch schon länger gibt und die nun auch ein Auto Dolby Vision Mode haben.

VaniKa schrieb:Von dem dynamischen Tone-Mapping werde ich mich wohl fernhalten, weil ich den Effekt aus dem Audiobereich kenne. Das ist so, als würde man alles nochmal durch einen Dynamik-Kompressor schicken und das verbessert nie die Klangqualität, sondern macht es zwar lauter, aber auf Kosten der Dynamik. Auf Bild übertragen erklärt das, warum dadurch alles heller wird. Das wirkt dann zwar alles oberflächlich krass, vermatscht aber auch die Kontraste. Zumal dann ja auch bei OLED eher eine Abdunklung getriggert wird, wenn alles immer so hell geboostet wird.

Is richtig ... das meinte ich weiter oben damit das Dyn. Mapping die Highlights manchmal überstrahlt weil das Gesamt Bild heller wird .. aber ich mag ein helleres Bild lieber als ein Dunkleres daher bin ich mehr

im Lager Dynamisches Tone Mapping An mit nur minimalen tendenzen zu HGIG an.

VaniKa schrieb:Warum HGiG übrigens bei dir dann vielleicht etwas zu schlapp wirkt im Vergleich zu dynamischem Tone-Mapping, liegt möglicherweise daran, dass du bei den Nit-Werten eigentlich noch etwas höher gehen könntest.

Ne das liegt daran das HGIG halt nur Highlights heller erstrahlen lässt aber nich das Gesamtbild wie eben Dyn. Mapping an. Und ich mag halt ein helleres Bild .. wenn ich von Dyn. Mapping an auf HGIG wechsel

sieht HGIG dagegen halt ziemlich düster aus.

Das is halt Geschmackssache worauf man mehr wert legt.

Am liebsten würde ich halt beides haben wollen .. mehr gesamthelligkeit und bessere Highlights .. aber ich wähle dann halt lieber mehr Gesamthelligkeit weil ich HDR 1000 im Februar 2020 am PG43UQ schon erlebt habe was mich dahingehend etwas versaut hat und da will ich wieder hin.

Und deswegen bin ich leicht scharf auf den 42" LG OLED der 2022 kommt.

Der hat dann mit viel Glück das EVO Panel + Heatsink ... der 2021 Panasonic OLED hat schon das Heatsink drinn aber kein EVO Panel und kommt auf über 900 Nits Peak. Packt man dann noch das EVO Panel dazu kann LG 2022 mit ihrem 42" OLED die 1000 Nits knacken.

VaniKa schrieb:(wenn HGiG aktiviert ist). Wenn du die Spiele auf den Wert kalibrierst, dürften die Highlights da auch heller ausfallen.

Das is richtig ... aber ich will halt auch ein helleres Bild haben und nich nur hellere Highlights und das gibts halt nur mit Dyn. Mapping an

Geschmackssache halt

Zuletzt bearbeitet:

Ist das denn wirklich so, dass Windows die Werte für Auto-HDR verwendet? Hat das jemand mal nachgewiesen? Wäre natürlich super, wenn es so wäre.Stagefire schrieb:Eben für Auto HDR ist das Wichtig da Auto HDR sonst mit den Windows Default Werten arbeiten würde

was dann die falschen 1499 Nits währen.

Dann benötigt man für so ein Spiel eigentlich auch grundsätzlich ein Hardware-Tone-Mapping im Bildschirm.Stagefire schrieb:zum einen gibts es ne Handvoll Games die keine Kalibrierung in HDR haben .. spontan fällt mir da grade Metro Exodus ein sowie eben SDR Games.

Soweit ich das eben verstehe, macht HGiG eben gar nichts. Es ist auch kein Modus, den eine Software irgendwie erkennen könnte. Das Tone-Mapping wird einfach komplett der Software überlassen, bei der die Kalibrierung dann essenziell ist, und das kann bei einer Konsole eben an zentraler Stelle erfolgen. Die "Unterstützung" für HGiG besteht insofern darin, dass die Software eben diese Kalibrierung unterstützt und sich nicht einfach blind auf das Tone-Mapping des Bildschirms verlässt. Finde den Artikel dazu ganz gut:Stagefire schrieb:Auch da bin ich mir nich sicher wie genau HGIG arbeitet ... soweit ich weiss is HGIG eine Gruppe von Entwicklern die Games anpassen daher sind es meist auch Konsolen Games die von HGIG Profitieren.

Aber so 100% bin ich da auch noch nich drinn.

Ich glaube aber nich das HGIG das Tone Mapping Deaktiviert sondern eher sein eigenes Tone Mapping macht.

https://hifi.de/ratgeber/hgig-hdr-gaming-48312

Weil die Software Tone-Mapping vornimmt, sofern sie eine Kalibrierungsfunktion hat, und dann nochmal der Bildschirm Tone-Mapping auf dieses bereits kalibrierte Bild vornimmt. Das Ergebnis ist dann halt alles andere als originalgetreu. Es wird in Anbetracht der Gerätevielfalt weitgehend dem Zufall überlassen.Stagefire schrieb:aber warum sollte ein doppeltes Tone Mapping stattfinden ?

Eben nicht, aber dazu schrieb ich ja bereits etwas. HGiG ist in dem Sinne das eigentliche "Off".Stagefire schrieb:HGIG macht auch sein eigenes Ding

Ich verstehe den Sinn dahinter, SDR dunkler darzustellen, auch um den OLED-Bildschirm zu schonen, aber Spiele in SDR oder Auto-HDR werden dann eben auch abgedunkelt. Wenn ich also nicht immer den SDR-Slider verändern will, wenn ich ein Spiel ohne natives HDR starte, und diese Spiele aber möglichst in der HDR-Helligkeit angezeigt werden sollen und eben nicht dunkel, dann muss ich eben auch das SDR in voller Helligkeit betreiben. In meinem Fall dient der PC, an dem der OLED-TV angeschlossen ist, nur dem Spielen und dem Schauen von Videos. Beides möchte ich hell haben. Also ist ein dunkler SDR-Modus für mich nur wenig sinnvoll. Ich verlasse mich da auf die Funktionen des TVs, dem Burn-in-Problem zu begegnen.Stagefire schrieb:Mit dem SDR Slider auf 20 bin ich in HDR bei SDR Material wieder in dem Helligkeits Bereich wo

ich mit OLED Light 35 im SDR Mode bin ... das is ja der Sinn von dem SDR Slider das man die HDR Helligkeit von SDR Material so anpasst das es so is wie in SDR und dadurch kann man dann ja 24/7 HDR anlassen.

Das entspricht doch genau dem, was ich vermutet hatte. Dass eben eher 950 als 800 Nits zutreffen, so wie bei mir eben 750 statt 600. 1000 liegt dann knapp drüber, sodass das Kalibrierungssymbol so gerade eben verschwindet, wie es soll.Stagefire schrieb:Im Schnitt musste ich die Nits in der Game HDR Kalibierung immer so auf 1000 stellen statt auf die richtigen 800 Nits damit beide Seiten des Vierecks gleich hell sind.

Nein, diese Nit-Angabe in Windows, die wir nun mittels CRU manipulieren. Unter Windows 10 kann das ja daher noch keine Rolle gespielt haben.Stagefire schrieb:Was ? Den SDR Slider ? Den gabs schon in Win 10

Stagefire

Lt. Commander

- Registriert

- Feb. 2008

- Beiträge

- 1.197

VaniKa schrieb:Ist das denn wirklich so, dass Windows die Werte für Auto-HDR verwendet? Hat das jemand mal nachgewiesen? Wäre natürlich super, wenn es so wäre.

würde ich vermuten .. und vermuten leute im AVS auch.

Macht auch Sinn wenn es so is da das Tone Mapping durch die AI ja auf irgendwelche

Nits Werten Basieren muss und da auf die EDID des OLEDs sowie eben manch andere PC Monitore nicht

zugegriffen werden kann .. warum auch immer das nun so is ... werd die AI wohl auf die

Default Werte zurückgreifen wenn man die CRU Werte nich anpasst.

Also Für HGIG und für Auto HDR sind die CRU Werte nach momentanen Test Stand

wichtig.. was den Rest angeht sagen die Jungs im AVS das die CRU Werte nich so wichtig sind.

Aber ich weiss da ingesamt zu wenig drüber um da nun selbst eigene "Beweise" zu Presentieren.

Das is nur Stand AVS.

VaniKa schrieb:Dann benötigt man für so ein Spiel eigentlich auch grundsätzlich ein Hardware-Tone-Mapping im Bildschirm.

Also HDR Games kenn ich nur 2 wo man im Spielmenu nichts einstellen kann. Bzw 3

Das eine weiss ich grad nich mehr die anderen beiden sind :

1. Metro Exodus ( geht nur HDR an und aus im Menu )

2. Battlefield 2042 ( geht nur HDR an und aus im Menu aber man kann per Ini die Nit einstellen )

3. fällt mir leider nich mehr ein .. vielleicht war das Divinity: Original Sin 2 .. kann aber auch sein das

es ein anderes neueres Game war .. weiss ich grad nich mehr.

da hat man dann kein Einfluss auf die HDR Helligkeit ( ausser bei BF2042 durch die Ini )

sondern kann dann nur per TV/Monitor die Helligkeit einstellen.

Aber bei all den vielen anderen HDR Nativ Games die ich am PC bisher gespielt hab kann man mindestens immer die HDR Nits einstellen.

Klassen Primus is Doom Eternal .. das Game hat bisher die meisten HDR Optionen aller PC Spiele :

Nunja und SDR Games haben halt keine Meta Daten aber da macht das Auto HDR ja durch die AI.

Und dort kann man mit dem Auto HDR Helligkeitsslider auch die HDR Helligkeit einstellen wie du ja in meinem Video gesehen hast.

Somit eigentlich kein Problem bei SDR Games bzw Auto HDR Games.

VaniKa schrieb:Soweit ich das eben verstehe, macht HGiG eben gar nichts. Es ist auch kein Modus, den eine Software irgendwie erkennen könnte. Das Tone-Mapping wird einfach komplett der Software überlassen, bei der die Kalibrierung dann essenziell ist, und das kann bei einer Konsole eben an zentraler Stelle erfolgen. Die "Unterstützung" für HGiG besteht insofern darin, dass die Software eben diese Kalibrierung unterstützt und sich nicht einfach blind auf das Tone-Mapping des Bildschirms verlässt. Finde den Artikel dazu ganz gut:

Dort siehst du wie HGIG Funktioniert : ( Dein Link basiert auch auf infos aus dem Link )

http://www.hgig.org/doc/ForBetterHDRGaming.pdf

Und dort findest du auch mehr Infos zu : MaxTML, MinTML and MaxFFTML ( 800 , 800 , 0 )

musst etwas runterrscrollen.

Aber auch da siehst du nur den Bezug zur Konsole und nich dem PC in dieser HGIG PDF

HGIG is mehr so Konsolen Land.

Ich hatte damals Auszüge aus dem PDF hier schonmal als Bild verlinkt als

wir noch in der Findungs Phase wahren.

VaniKa schrieb:Eben nicht, aber dazu schrieb ich ja bereits etwas. HGiG ist in dem Sinne das eigentliche "Off".

naja nich nur off .. off is off und off lässt die highlights nich so hell erscheinen wie mit HGIG.

HGIG macht so sein eigenes Tone Mapping und is somit was anderes als Dyn. Mapping Off.

Bei Red Dead 2 zb bekommen die Wolken einen leicht helleren Bereich mit HGIG und überstrahlen aber nicht .. mit Dyn. Mapping off sehen sie wieder schwächer aus und mit Dyn. Mapping an überstrahlen die Wolken.

Bei BF5 zb in der SP Map Nordlys ganz am Anfang... da startet man im Dunkeln auf ner verschneiten Map.

Dort gibt es Wachtürme mit Scheinwerfer .. auch diese Scheinwerfer werden mit HGIG heller während der Rest des Bildes so is wie mit Dyn. Mapping off. HGIG arbeitet Highlights besser aus ohne das Gesamtbild heller werden zu lassen.

Dynamisches Tone Mapping Off = Normales Meta Daten Tone Mapping welches nicht vom TV beinflusst wird ... hat das dunkelste Bild.

Dynamisches Tone Mapping on = TV Analysiert jedes Bild einzelnt und passt es an deinen TV an .. das Komplette Bild wird heller und Highlights gehen leicht unter weil das Bild insgesamt Heller wird und weniger Nits übrig sind um die Highlights besser zu betonen vom Restlichen Bild.

HGIG = Das Gesamt Bild bleibt so Dunkel wie mit Dyn. Mapping off aber Highlights wie Wolken oder

Lichter werden betont. Es ändert somit das Normale Tone Mapping etwas und is somit was anderes als Dyn. Mapping Off.

Und Dolby Vision is in etwa so wie HGIG nur dass das Bild noch etwas Dunkler wird als mit Off um Highlights noch besser zu betonen. Auch dazu hatte Vince letztens ein Video gemacht.

Aber Dolby Vision is tot am PC... aber geht grad an der X Box voll ab. Die haben dort Auto Dolby Vision.

Und auch generell Dolby Vision support. Am PC hat Microsoft Dolby aber fallen gelassen.

Und es gibt nur 3 Dolby Vision PC Games

1. Battlefield 1 ( 2016 )

2. Mass Effect Andromeda ( 2017 )

3. NFS Heat ( 2019 )

Athem hatte Dolby Vision .. aber nur in der Beta .. in der Finalen Version wurde es gestrichen.

Man kann diese Spiele auch noch in Dolby Schalten am PC aber bekommt dann ein Buggy Bild.

Dazu findet man auch sehr viel wenn man per Google Sucht. Meist ist von einem Pinken Bild

die rede.

Ich hab schon einige versuche gemacht Dolby Vision am PC wieder zum laufen zu bringen ... kann man

auch alles im AVS sowie im HWLuxx Thread nachlesen.

Mit Dolby fällt das Kalibrieren weg .. das macht Dolby alles Automatisch.

da bekommt man dann nur das Bild zu sehen :

Beispiel Mass Effect Andromeda :

Dolby macht dann alles für einen .. man brauch keine Regler mehr verstellen

VaniKa schrieb:Ich verstehe den Sinn dahinter, SDR dunkler darzustellen, auch um den OLED-Bildschirm zu schonen, aber Spiele in SDR oder Auto-HDR werden dann eben auch abgedunkelt.

Bei Auto HDR will man das nich aber bei SDR Games will man das.. man muss das natürlich nich machen

aber es wird überall empfohlen dies zu tun. Im SDR Mode ( ob surfen , SDR Gaming , SDR Film oder Serie )

sollte man mit dem OLED light im Bereich 35 bis max 60 ... hab dir doch vorhin auch den Reddit Thread verlinkt dort siehst du das auch.

Im HDR Mode und OLED Light auf 100 und SDR Slider auf 20 is man aber wieder in dem Bereich

wo man vorher im SDR Mode auch mit OLED light 35 war.

Daher steht mein SDR Slider auf 20 und nich wie bei dir auf 40.

Die OLEDs brauchen im SDR Mode nich auf 100 .. 100 sollte man nur nehmen bei HDR ( Auto HDR )

Weil dadurch ja das gesamte Bild heller wird ... bei HDR is das nich schlimm weil es dort Tone Mapping gibt was die Helligkeit in Bereiche aufteilt und eben nich alles heller wird ( also schon aber da machts halt schon sinn )

Daher wenn HDR Mode dann SDR Slider runter auf 20 oder so... is aber nur ne gut gemeinte Empfehlung das is nun kein Muss.

VaniKa schrieb:Wenn ich also nicht immer den SDR-Slider verändern will, wenn ich ein Spiel ohne natives HDR starte, und diese Spiele aber möglichst in der HDR-Helligkeit angezeigt werden sollen und eben nicht dunkel, dann muss ich eben auch das SDR in voller Helligkeit betreiben. In meinem Fall dient der PC, an dem der OLED-TV angeschlossen ist, nur dem Spielen und dem Schauen von Videos. Beides möchte ich hell haben. Also ist ein dunkler SDR-Modus für mich nur wenig sinnvoll. Ich verlasse mich da auf die Funktionen des TVs, dem Burn-in-Problem zu begegnen.

Das kannst du halten wie du möchtest ... es is nur ein Guter Rat von vielen Erfahrenen Leuten die sagen das man wenn man im SDR Mode is das OLED Light nich auf 100 lassen sollte sondern im Bereich 35 bis max 60.

damit die OLEDs nich unnötig altern.

kleiner Auszug aus dem Reddit Beitrag den ich vorhin hier verlinkt hatte :

Nun mit dem SDR Slider auf zb 20 und OLED Light 100 muss man schauen welchen Einfluss dieser SDR Slider auf den OLED alterrungs Prozess hat. Das haben wir im Luxx nur leicht angekratzt und haben uns dort mehr auf den Watt Verbrauch versteift zwischen SDR Mode und HDR Mode da TZGamer das Thema dorthin gelenkt hat. ( Mr. Akkurat )

Der SDR Slider hat zumindest Einfluss auf den Verbrauch ... im HDR Mode

verbraucht ein 77" OLED beim anzeigen einer Website im Dark Mode

https://www.hardwareluxx.de/communi...s-pc-bildschirm-hdmi-2-1-vrr.1246942/page-357

Also man kann wohl mit dem SDR Slider den Verbrauch in HDR so hinbekommen das er so is wie in SDR zumindest wenn man grad SDR Material anschaut ... Mit HDR Material wird der SDR Slider ja von Windows Ignoriert.

VaniKa schrieb:Das entspricht doch genau dem, was ich vermutet hatte. Dass eben eher 950 als 800 Nits zutreffen, so wie bei mir eben 750 statt 600. 1000 liegt dann knapp drüber, sodass das Kalibrierungssymbol so gerade eben verschwindet, wie es soll.

Die Frage is halt woran das liegt ... ich hatte das damals im Februar 2020 aber mit dem PG43UQ und HDR 1000 auch schon ... das Ding is das es irgendwie auch beeinflusst wurde .. damals passten mal die 1000 und mal musste ich auf 2000 gehen ... aber das war noch Win 10 vielleicht konnte Win 10 noch weniger Nit Daten auslesen als nun Win 11 ... zumindest is das nun mit Win 11 und CRU Änderung konstanter in dem Bereich wo es sein sollte.

VaniKa schrieb:Nein, diese Nit-Angabe in Windows, die wir nun mittels CRU manipulieren. Unter Windows 10 kann das ja daher noch keine Rolle gespielt haben.

Ich meinte nich die Nit Werte von CRU sondern den SDR Slider .. den gabs schon in Win 10 .. das is ja was anderes als die CRU Änderrung. Der SDR Slider wurde ja wegen etwas anderem eingeführt was ich schon erklärt hatte.

Zuletzt bearbeitet:

Blackfirehawk schrieb:so mal was interessantes für AMD Nutzer

ihr braucht das Tool RadeonMod

https://forums.guru3d.com/threads/radeonmod-tweak-utility.403389/

das startet ihr im Administrator Modus:

Anhang anzeigen 1149472

hier könnt ihr Global Dithering Ausschalten.. es wird also nicht erst berechnet und hin und her konvertiert..

es überlässt dem Monitor das Dithering via FRC

danach den Rechner neu Starten..

Vorsicht RESTART DRIVER ist Buggy in dem programm.. und die AMD software mag das gar nicht!

lieber den Rechner neu starten

Wozu ist diese Funktion genau da? bzw. hast du die Änderung vorgenommen und einen Unterschied festgestellt?

Ich würde sagen, es ist genau umgekehrt. Das "Off" in den TV-Einstellungen bezieht sich ja nur auf das dynamische Tone-Mapping. Statisches Tone-Mapping bleibt mit "Off" aktiviert. Erst HGiG deaktiviert es komplett. Dieses irreführende Wording ist vermutlich der Tatsache geschuldet, dass deaktiviertes Tone-Mapping ursprünglich eigentlich nicht vorgesehen war und jetzt so ein Gaming-Feature darstellt und somit auch einen Namen braucht.Stagefire schrieb:naja nich nur off .. off is off und off lässt die highlights nich so hell erscheinen wie mit HGIG.

HGIG macht so sein eigenes Tone Mapping und is somit was anderes als Dyn. Mapping Off.

Die Werte, die RTINGS.com misst, sind ja externe Messwerte mit Messgerät. Da geht es um die realen Helligkeiten und da kommen die Displays offenbar nicht über die genannten Werte von 600 (B1) bzw. 800 (C1). Aber das ist eben nur das. Worum es bei den Nit-Obergrenzen auch geht, ist, wann man wirklich die Maximalhelligkeit erreicht hat, sodass beim Logo-Test das Logo vollständig verschwindet. Das können ja messtechnisch gesehen weniger Nits sein, aber dennoch kann man das Bild bis soviel Nits treiben, bis es ins Clipping geht. Das sind also zwei verschiedene Betrachtungsweisen. Wenn man 800 Nits beim Testbild einstellt, dann bedeutet das nicht, dass auch 800 Nits von außen gemessen werden. Messtechnisch gesehen würde man einfach 10 % Weiß mit maximaler Helligkeit (z.B. 10.000 Nits) ausgeben und messen, wie hell die Fläche dann tatsächlich ist. So kommt man auf die 600 bzw. 800 Nits. Aber bei welchem Soll-Nit-Wert wird diese Helligkeit wirklich (ohne Clipping) erreicht? Möglicherweise erst mit den 750 bzw. 950 Nits, die man in der Software angibt. Und dann sollte man ja diesen Bereich auch tunlichst nutzen, wenn man eben die realen 600 bzw. 800 Nits auch erreichen will. Mit (dynamischem) Tone-Mapping kann es sein, dass das Signal eh verstärkt wird und an die Grenze stößt. Aber mit HGiG würde man da Helligkeit verschenken. Und das stellt man dann im direkten Vergleich möglicherweise auch fest und empfindet daher das HGiG als unterlegen. Ganz einfach, weil man falsch kalibriert hat und da noch Luft nach oben ist.Stagefire schrieb:Die Frage is halt woran das liegt

Kurz: Eingabe-Nit-Wert (via Software eingestellt) ≠ Ausgabe-Nit-Wert (an der Hardware gemessen)

Was allein schon dadurch klar wird, dass die Bildschirmeinstellungen ja die gemessene Helligkeit stark beeinflussen, obwohl der Wert in der Software identisch bleibt. Wenn man das Bild wärmer einstellt oder die OLED-Helligkeit reduziert, misst man natürlich auch weniger. Was bei HGiG wirklich zählt, ist der Eingabe-Nit-Wert und dass dieser so weit getrieben werden kann, bis eben die Clipping-Grenze erreicht ist - bei den konkreten aktuellen Bildschirmeinstellungen. Der Logo-Test ist insofern das einzig probate Mittel, den korrekten Nit-Wert zu ermitteln. Wie hell das Bild da wirklich ist, spielt keine Rolle. Wenn man es richtig kalibriert hat, dann ist der Wert so hoch, wie er maximal bei dem Bildschirm sein kann, aber kein Stück drüber, da es sonst zu Clipping kommt.

PS: Die EDID-Werte sind insofern eigentlich eh nur Schall und Rauch. Denn in welchem Szenario sind die denn aussagekräftig? Bei Bildschirm-Defaults? Insofern frage ich mich, wie sinnvoll es wirklich ist, diese Werte auszulesen. Eigentlich wäre eine Kalibrierung mit Logo-Test immer zu bevorzugen. Vielleicht fehlen diese Werte ja bei OLED-Bildschirmen auch nicht ohne Grund.

PPS: Ich sehe eigentlich diese zwei Szenarien:

1. Ohne Kalibrierungsmöglichkeit. Da ist dann das Tone-Mapping des Bildschirms gefragt (entweder dynamisch oder statisch). Hier ist das Ergebnis komplett vom Gerät abhängig. Hier findet das Tone-Mapping beim Gerät statt.

2. Mit Kalibrierungsmöglichkeit. Da sollte man dann HGiG nutzen und das Bild kalibrieren. Da liegt die Kontrolle dann komplett bei der Software. Hier findet das Tone-Mapping in der Software statt.

Wenn Filme eh nicht so extrem hell sind, dann sprechen wir eigentlich nur noch über Spiele. Und die haben eben häufig eine Kalibrierungsfunktion. Wenn man unter Windows dann HGiG verwendet und der Video-Player keine Kalibrierung unterstützt, muss man darauf hoffen, dass das Videomaterial nicht die Clipping-Grenze erreicht, aber das ist ja möglicherweise bei HDR-400-fähigen Geräten bereits gegeben. So eine Sonne mit 10.000 Nits hat man ja dann eher nur in Spielen, oder?

Ja, ich aber. 😉 Und dann fragtest du, ob ich den Slider meinte, worauf ich dann sagte, dass ich die Nit-Anzeige meinte. Also ich sprach ursprünglich von der Nit-Anzeige als neuem Feature von Windows 11 und dass daher die Nit-Werte aus den EDID-Informationen wahrscheinlich erst seit Windows 11 überhaupt verwertet werden.Stagefire schrieb:Ich meinte nich die Nit Werte von CRU sondern den SDR Slider

Zuletzt bearbeitet:

- Registriert

- Dez. 2018

- Beiträge

- 2.394

Ich muss sagen ich stand jetzt am Samstag im Saturn vor den Dingern..

Leider blicke ich bei den Bezeichnungen nicht ganz durch.. A und B sind die billigen 60hz

C1 und CX..sind die besseren das weiß ich.. was bedeutet die Zahl dahinter? C17 irgentwas

Gefallen hat mir vom Bild der 55g1la war das glaub ich..

Ich hab da aber keinen 48er gefunden nur den 48C17.. obwohl sehr gut war der 55G1 noch n Tick besser

Naja.. und obwohl sie das Bild super fand hat meine Frau Nein gesagt.. als ich ihr sagte ich will damit zocken hat sie mich für komplett bescheuert erklärt

Das dürfte Arbeit sein und mich einiges Kosten.. Frau wünscht sich so langsam n neues Auto...-__-

Leider blicke ich bei den Bezeichnungen nicht ganz durch.. A und B sind die billigen 60hz

C1 und CX..sind die besseren das weiß ich.. was bedeutet die Zahl dahinter? C17 irgentwas

Gefallen hat mir vom Bild der 55g1la war das glaub ich..

Ich hab da aber keinen 48er gefunden nur den 48C17.. obwohl sehr gut war der 55G1 noch n Tick besser

Naja.. und obwohl sie das Bild super fand hat meine Frau Nein gesagt.. als ich ihr sagte ich will damit zocken hat sie mich für komplett bescheuert erklärt

Das dürfte Arbeit sein und mich einiges Kosten.. Frau wünscht sich so langsam n neues Auto...-__-

Stagefire

Lt. Commander

- Registriert

- Feb. 2008

- Beiträge

- 1.197

VaniKa schrieb:Ich würde sagen, es ist genau umgekehrt. Das "Off" in den TV-Einstellungen bezieht sich ja nur auf das dynamische Tone-Mapping. Statisches Tone-Mapping bleibt mit "Off" aktiviert. Erst HGiG deaktiviert es komplett.

Ja so meinte ich das eigentlich auch ... off = Dynamisch off aber normal on

Ich bin halt nur nich von deiner HGIG Theorie überzeugt das mit HGIG dann garkein

Tone Mapping gemacht wird. Weil dann auch nix heller und dunkler währe sondern alles gleichhell wie bei SDR. So könnte dann auch die von mir beschriebenen Scheinwerfer in BF5 auch nich heller werden mit HGIG.

Daher geh ich eher davon aus das HGIG eben sein eigenes Tone Mapping macht bzw auf das Normale Tone Mapping aufbaut.

VaniKa schrieb:Die Werte, die RTINGS.com misst, sind ja externe Messwerte mit Messgerät. Da geht es um die realen Helligkeiten und da kommen die Displays offenbar nicht über die genannten Werte von 600 (B1) bzw. 800 (C1). Aber das ist eben nur das. Worum es bei den Nit-Obergrenzen auch geht, ist, wann man wirklich die Maximalhelligkeit erreicht hat

Würde heissen das ich bei BF5 die Maximal Helligkeit bei 2000 Nits erreiche

Also ich meinte nun mit "Die frage is halt woran das liegt" das ich halt manchmal erst bei so 1400 - 2000 Nits

auf beiden Seiten ein Gleich helles Viereck bei BF5 hab und manchmal passt dann aber 1000 nits obwohl mein TV ja nur so 800 Nits hat.

Auch bei Borderlands 3 muss ich auf so 950 - 1000 Nits gehen damit beide Seiten gleich sind.

Egal ob nun Win 11 oder Win 10 .... mit der CRU Änderung müsste ich erstmal noch ein paar mehr Games testen da ich da bisher erst bei BF5 eine verbesserung gesehen hab und dort nun so 950 - 1000 ausreichen statt 1400 - 2000.

Also entweder is die Kalibrierung in den Games fürn Arsch oder werden durch etwas anderes beeinflusst

da das Ergebeniss teilst unterschiedlich is. Weil viel mehr als 800 Nits hab ich nich.

Ich hab schon 1000 Nits erlebt beim Asus PG43UQ und die sind heller als die Nits die ich am

48CX sehe ... also mein OLED is schon im Bereich 800 Nits und nich bei 2000 Nits wie es mir BF5

manchmal weiss machen will.

VaniKa schrieb:Aber mit HGiG würde man da Helligkeit verschenken. Und das stellt man dann im direkten Vergleich möglicherweise auch fest und empfindet daher das HGiG als unterlegen. Ganz einfach, weil man falsch kalibriert hat und da noch Luft nach oben ist.

Nein weil HGIG halt einfach nich das Gesamtbild heller macht sondern nur die Highlights betont .. das is fakt

Das is ja der Grund warum viele Konsolen Gamer HGIG lieben ... die wollen ( im gegensatz zu mir )

nicht dass das Gesamte Bild heller wird sondern die wollen nur bessere Highlights und das gibts mit HGIG.

Ich finde HGIG halt unterlegen weil es das Gesamt Bild nich heller macht sondern eben nur die Highlights

und ich will richtung HDR 1000 das bekomm ich mit HGIG aber nich aber mit Dynamisches Tone Mapping an

geht es so langsam in die Richtung aber auf kosten der Highlights.

Die Geschichte is einfach ne Geschmackssache.

VaniKa schrieb:PS: Die EDID-Werte sind insofern eigentlich eh nur Schall und Rauch. Denn in welchem Szenario sind die denn aussagekräftig? Bei Bildschirm-Defaults? Insofern frage ich mich, wie sinnvoll es wirklich ist, diese Werte auszulesen. Eigentlich wäre eine Kalibrierung mit Logo-Test immer zu bevorzugen. Vielleicht fehlen diese Werte ja bei OLED-Bildschirmen auch nicht ohne Grund.

Der Werte fehlen nur auf dem PC .... die XBOX kann auf die in der EDID Hinterlegten Nit Daten zugreifen

nur Windows is da zum Dumm für.

Hatte dir doch das Video von VInce verlinkt wo man sah das die XBox auf die EDID Nits Daten vom OLED zugreifen kann. Und auf der XBox gibts ein Logo Test ... ich glaub du schaust dir die ganzen sachen

garnich an die ich hier so verlinke.

Und die sind halt hinterlegt damit man die Arbeitsrange in Nits des Monitors/TVs hat in dem dann

das Tone Mapping stattfinden kann.

VaniKa schrieb:So eine Sonne mit 10.000 Nits hat man ja dann eher nur in Spielen, oder?

Gibt es in Filmen niemals eine Sonne zu sehen ? oder ein Laser Strahl oder ein Lagerfeuer ?

VaniKa schrieb:Ja, ich aber. 😉 Und dann fragtest du, ob ich den Slider meinte, worauf ich dann sagte, dass ich die Nit-Anzeige meinte. Also ich sprach ursprünglich von der Nit-Anzeige als neuem Feature von Windows 11 und dass daher die Nit-Werte aus den EDID-Informationen wahrscheinlich erst seit Windows 11 überhaupt verwertet werden.

OK also du meinst die Nit ANzeige wo eben vorher die 1499 nits standen.

Soweit ich weiss gabs die bei Win 10 nich .... aber 100 % sicher bin ich mir grad nich.

Kann sein das die im Insider Build wo auch Auto HDR für Win 10 dabei war auch schon enthalten war.

Ob die Nit Werte vorher nich verwendet wurden von Windows weiss ich aber nich ... da kann man nun nur raten.

Blackfirehawk schrieb:Leider blicke ich bei den Bezeichnungen nicht ganz durch.. A und B sind die billigen 60hz

C1 und CX..sind die besseren das weiß ich..

Jepp ... CX is von 2020 und C1 von 2021 ... C9 is von 2019 und C8 von 2018

Blackfirehawk schrieb:was bedeutet die Zahl dahinter? C17 irgentwas

Ich hab den 48CX8LC

Die "8" steht dann wohl in dem Fall für Deutschland/Europa

Das "L" für DVB T/T2/T2HD/C/S/S2

und das "C" für für die Standfuss Farbe ( "C" für Helles Silber und "B" für Dunkles Silber )

also bei dem Model was du gesehen hast stand die 1 nach dem C1 für Deutschland.

Ignorier die letzten 3 Buchstaben/Zahlen .. achte nur auf 48C1 , 48CX , 55C9 , 55CX , 55C1 usw.

also erstmal nur auf die ersten 4 Dinger achten

Blackfirehawk schrieb:Gefallen hat mir vom Bild der 55g1la war das glaub ich..

55G1 hat das EVO Panel drinn .... bei den 2021 Modellen hat nur die G Serie das EVO Panel

das wird 2022 hoffentlich anders.

Das EVO Panel liefert ein paar Nits mehr Peak und is Langlebieger was gegen Burn Out hillft.

Sprich :

Heller und dennoch Langlebiger.

Daher hoffe ich beim 42" OLED ja auf EVO Panel + Heatsink = 1000 Nits

Die G Serie hat 2021 kein 48"

Wir sollten vielleicht mal klären, was Tone-Mapping genau macht. Da ist ja das Ausgangssignal, noch ohne Tone-Mapping und ohne das Ausgabegerät zu berücksichtigen, also auch ohne Kalibrierung. Das Original sozusagen.Stagefire schrieb:Ich bin halt nur nich von deiner HGIG Theorie überzeugt das mit HGIG dann garkein

Tone Mapping gemacht wird. Weil dann auch nix heller und dunkler währe sondern alles gleichhell wie bei SDR.

Es kann nun je nach Signal sein, dass dort Nit-Werte erreicht werden, die (weit) jenseits der Darstellungsmöglichkeiten des Ausgabegeräts liegen, wie z.B. eine Sonne mit 10.000 oder gar 20.000 Nits. Tone-Mapping sorgt nun dafür, dass diese zu hohen Werte, die außerhalb der darstellbaren Skala liegen, heruntergeregelt werden, sodass sie in den darstellbaren Bereich des Geräts passen, und zwar abhängig von ihrer Stärke, sodass bei einem Gerät mit bis zu 1.000 Nits 10.000 Nits trotzdem noch etwas dunkler dargestellt werden als 20.000 Nits. D.h. 10.000 Nits werden z.B. auf 950 Nits heruntergestuft und 20.000 Nits auf nahezu 1.000 Nits. Das hängt von der Tone-Mapping-Kurve ab, die das Gerät anwendet.

Mit HGiG passiert das nicht. Dort wird alles linear bis zum Maximum dargestellt und alles eigentlich Hellere ist dann einfach gleich (maximal) hell, unabhängig davon, wie weit es die Obergrenze überschießt. Das ist dann Clipping und sieht schlechter aus, wenn es passiert, weil alle Nuancen ab Erreichen der Obergrenze verschwinden. Und um das zu vermeiden, benötigt man eine Kalibrierung, um der Software von vornherein zu sagen, wie hoch sie gehen kann, damit z.B. eine Sonne gar nicht erst mit 10.000 Nits zum Ausgabegerät kommt, sondern bereits heruntergeregelt auf maximal die kalibrierte Obergrenze. Das kann man dann Software-Tone-Mapping nennen. Und mit korrekt kalibriertem Software-Tone-Mapping benötigt man dann kein (statisches) Geräte-Tone-Mapping mehr und es wäre sogar kontraproduktiv, weil es das Signal daran hindert, die 100 % Helligkeit zu erreichen.

Das dynamische Tone-Mapping macht nun noch etwas Weiteres, nämlich das Signal je nach Content boosten, wodurch es zu dem allgemein helleren Bild kommt. Aber eigentlich dient Tone-Mapping dazu, das Bild für ein bestimmtes Gerät zu "mastern", um mal einen Begriff aus dem Audiobereich zu verwenden. Bei HGiG werden also keine Highlights geboostet, sie werden aber anders als beim statischen Tone-Mapping des Geräts auch nicht gedimmt. Wenn die Highlights also bei statischem Tone-Mapping (dynamisches Tone-Mapping auf "Off") schwächer wirken als mit HGIG, dann liegt das daran, dass in den höheren Helligkeitsbereichen bereits die sanfte Limitierung des (statischen) Tone-Mappings greift, die das harte Clipping verhindern soll.

Dynamisches Tone-Mapping könnte man im Audiobereich mit einem Lautheits-Normalisierer vergleichen, wie es z.B. beim Radio eingesetzt wird. Man sagt dem Tone-Mapper (Loudness-Normalizer), dass er eine gewisse Helligkeit (Lautheit) produzieren soll und dadurch wird dann je nach Eingangssignal verstärkt oder abgeschwächt, wobei bei der Verstärkung zusätzlich durch einen Limiter (das, was ein statisches Tone-Mapping macht) vor Clipping geschützt wird. Das Ergebnis ist in beiden Fällen ein helleres (lauteres) Signal, in dem aber der Kontrast (Dynamikumfang) reduziert wurde. Bei Audio bedeutet das, dass leise (dunkle) Bereiche lauter (heller) gemacht werden und zu laute (zu helle) Bereiche leiser (dunkler). Das geht immer Zulasten der Originalqualität, denn es führt, wie du ja selbst festgestellt hast, dazu, dass Dunkel und Hell nicht mehr so weit auseinander liegen. Der Helligkeitsdurchschnitt wird erhöht.

Und für mich liegt der Reiz von HDR auch im starken Kontrast zwischen Hell und Dunkel und nicht in einem extrem hellen Bild an sich, wie beispielsweise intensiv leuchtende Rücklichter bei Autos in der Nacht. Und gerade für die dunklen Bereiche habe ich ja auch einen OLED-TV. Also wie man es dreht und wendet, ich kann dem dynamischen Aufhellen nicht wirklich etwas abgewinnen, jedenfalls nicht in dunkler Umgebung. 😉

Schon, aber hat die auch 10.000+ Nits? Ich las irgendwo, dass Filme in der Regel nicht mit so hohen Werten "gemastert" werden. Spiele erzeugen das Bild ja on-the-fly, bei Video ist es fest kodiert und von vornherein für einen bestimmten Bereich ausgelegt.Stagefire schrieb:Gibt es in Filmen niemals eine Sonne zu sehen ? oder ein Laser Strahl oder ein Lagerfeuer ?

PS: Okay, eine kurze Recherche hat ergeben, dass viele Filme wohl bis zu 4000 Nits unterstützen. Da wäre dann HGiG von Nachteil, zumindest wenn die Filme von den hohen Nit-Werten regulär Gebrauch machten. Sofern es beim Player keine Software-Kalibrierung gibt, die das einfängt, sollte man da auf jeden Fall Tone-Mapping am Gerät verwenden. Ich weiß aber auch gar nicht, ob es für Video-Player Kalibrierungsmöglichkeiten gibt. Bin in dem ganzen Videothema zu wenig drin. Ich starte einfach nur die Netflix-App. 😉

Zuletzt bearbeitet:

- Registriert

- Dez. 2018

- Beiträge

- 2.394

Ist ja doof.. na dann warte ich Mal auf den 42er wenn nur der 55er das für mich interessante Panel zur Zeit hat.. trotzdem danke für die Aufklärung

Stagefire

Lt. Commander

- Registriert

- Feb. 2008

- Beiträge

- 1.197

VaniKa schrieb:.D.h. 10.000 Nits werden z.B. auf 950 Nits heruntergestuft und 20.000 Nits auf nahezu 1.000 Nits. Das hängt von der Tone-Mapping-Kurve ab, die das Gerät anwendet.

Jepp soweit war ich bisher.

VaniKa schrieb:Mit HGiG passiert das nicht..... wie hoch sie gehen kann, damit z.B. eine Sonne gar nicht erst mit 10.000 Nits zum Ausgabegerät kommt, sondern bereits heruntergeregelt auf maximal die kalibrierte Obergrenze.

HGIG macht bei 800 bzw 700 Nits dicht ( bei unseren OLEDS ) das is das was die im AVS immer sagen und daher is da auch die CRU sache wichtig.

Ich hatte da auch was aufgeschnappt das man wenn man HIGIG nehmen will und es im Spiel eine HDR Helligkeitskalibrierung gibt man diese ans Maximum packen soll zb bei BF5 2000 Nits und erst dann

HGIG wählen soll weil HGIG dann ab 800 Nits dicht macht.

Kann aber auch sein das es andersrum war .. das man erst im Game auf 800 Nits stellen soll und erst dann HGIG wählen soll

Ich hab mich damit aber nun nich groß befasst weil ich kein Fan von HGIG bin aber hab da im AVS halt immer mal wieder was aufgeschnappt weil die dort voll die HGIG Fans sind und nix anderes nutzen.

VaniKa schrieb:Das dynamische Tone-Mapping macht nun noch etwas Weiteres, nämlich das Signal je nach Content boosten, wodurch es zu dem allgemein helleren Bild kommt.

Jepp und als HDR 1000 Fan is das für gut weil es mich näher dahinbringt.

VaniKa schrieb:Aber eigentlich dient Tone-Mapping dazu, das Bild für ein bestimmtes Gerät zu "mastern", um mal einen Begriff aus dem Audiobereich zu verwenden.

Filme werden auch gemastert ... PC Spiele soweit ich weiss aber nicht auch wenn das einige im AVS manchmal sagen.

VaniKa schrieb:Und für mich liegt der Reiz von HDR auch im starken Kontrast zwischen Hell und Dunkel und nicht in einem extrem hellen Bild an sich, wie beispielsweise intensiv leuchtende Rücklichter bei Autos in der Nacht. Und gerade für die dunklen Bereiche habe ich ja auch einen OLED-TV. Also wie man es dreht und wendet, ich kann dem dynamischen Aufhellen nicht wirklich etwas abgewinnen, jedenfalls nicht in dunkler Umgebung. 😉

Weil du den zusammenhang zu meinen HDR 1000 die ich haben will mal wieder übersiehst.

Ich versteh dich .. und ja das will ich auch aber ich will eigentlich beides ... einmal ein helleres Bild was mich näher an die HDR 1000 des PG43UQ ranbringt und bessere Highlights .. beides geht mit meinem 48CX nich gleichzeitig also hab ich mich für das Hellere Bild entschieden aufkosten der Highlights. ( das erwähnte ich ja schon ein paar mal )

Nur ab und zu wähle ich HGIG da wird dann das Gesamtbild leider wieder dunkler aber die Highlights setzen sich dadurch wieder besser vom Restlichen Bild ab.

Daher sagte ich schon so 2 oder 3 mal das es eben Geschmackssache is und das ich mich daher auf den 42" OLED freue da dieser eventuell beides vereint wenn er das EVO Panel + Heatsink bekommt

damit hat man dann ein Helleres Gesamtbild und dennoch gute Highlights da man dann mit dem

42" OLED im Bereich 1000 Nits is.

Der Panasonic OLED mit Heatsink packt ja auch schon die 900 Nits bei 10 % Weiss

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Packt man da dann noch das neue EVO Panel mit dazu sind die 1000 Nits in Reichweite.

HDR Gesamt Helligkeit is für mich der größte Schwachpunkt vom OLED und das versuche ich halt

mit Dyn. Mapping on etwas auszugleichen.

VaniKa schrieb:Schon, aber hat die auch 10.000+ Nits? Ich las irgendwo, dass Filme in der Regel nicht mit so hohen Werten "gemastert" werden.PS: Okay, eine kurze Recherche hat ergeben, dass viele Filme wohl bis zu 4000 Nits unterstützen.

Filme werden meist mit 100 - 200 Nits gemastert ... das heisst aber nich das die Sonne in diesen Film dann nur 200 Nits hat. Ein paar Filme werden auch zb mit 1000 Nits oder 4000 Nits gemastert.

Aber viel mehr weiss ich da auch nich drüber.

Das Mastern heisst ja nich das es eine Absolute Limitierung auf diesen Wert gibt .. das kann man ja zb mit Dyn. Mapping on ändern im dem der TV das Tone Mapping übernimmt und man dann halt dennoch seine 800 Nits sieht statt nur 200 Nits.

VaniKa schrieb:Die HDR-Highlights kommen deutlich besser rüber mit niedrigerer SDR-Helligkeit. Ich hab den Wert jetzt auf 20 gestellt. Zu weit möchte ich auch nicht runter gehen, weil es dann zu dunkel wird, vor allem bei SDR-Videos. Da ist von Weiß ja sonst nicht mehr wirklich die Rede, sondern eher von einem Grau.

Wie gesagt .. das sind nett gemeinte Ratschläge von Erfahrenen OLED Usern und eben Erfahrungswerte

von Leuten die Burn Outs hatten.

Was man daraus macht bleibt jedem selbst überlassen.

Wenn ich im SDR Mode bin bleibt mein OLED Light auf 35 nur ab und zu geh ich auf 50.

Und im HDR Mode bleibt der SDR Slider für SDR Material auf 20.

Aber das kann ja jeder für sich selbst entscheiden.... aber der jenige der es höher stellt hat dann hinterher

kein Recht zu nölen das er ein Burn Out hatte .. da isser dann absolut selber Schuld.

Zuletzt bearbeitet:

Slipknot79

Lieutenant

- Registriert

- Feb. 2006

- Beiträge

- 547

Wieso ist eigentlich Divinity 2 in HDR am PC grau ausgewaschen? Ja, HDR ist in Windows 11 aktiviert.

Ich muss dann immer mit Nvidia Freestyle nachhelfen um den "HDR-look" zu bekommen.

Gamma runter, etwa tiefere Schatten, Hochpunkte rauf und Kontrast dezent erhöhen. Erst dann sieht es top aus, aber irgendwie Shice Beigeschmack wenn man selbst als Laie "remastern" muss ohne zu wissen, wie es "richtig" aussehen sollte. 👍

Horizon Zero Dawn hingegen funzt in HDR out of the box, da reichts nur die beiden ingame Regler zu bedienen und geht schon alles qool. 🤘

(Habe nen HDR1000 Monitor)

Ich muss dann immer mit Nvidia Freestyle nachhelfen um den "HDR-look" zu bekommen.

Gamma runter, etwa tiefere Schatten, Hochpunkte rauf und Kontrast dezent erhöhen. Erst dann sieht es top aus, aber irgendwie Shice Beigeschmack wenn man selbst als Laie "remastern" muss ohne zu wissen, wie es "richtig" aussehen sollte. 👍

Horizon Zero Dawn hingegen funzt in HDR out of the box, da reichts nur die beiden ingame Regler zu bedienen und geht schon alles qool. 🤘

(Habe nen HDR1000 Monitor)

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 13

- Aufrufe

- 648

- Antworten

- 15

- Aufrufe

- 1.334

- Antworten

- 24

- Aufrufe

- 5.183

- Antworten

- 29

- Aufrufe

- 1.206