ich überlege gerade doch eine SSD einzubauen, unabhängig ob das Caching oder sonst was sinnvoll sind.

wenn ich richtig gesehen habe läuft das OS zwar nicht von den Festplatten, aber die Programme

Und das kann zum Teil dann so langsam werden, dass das NAS nicht wirklich nutzbar/erreichbar ist....

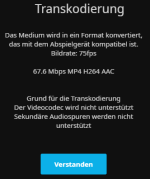

Jetzt gerade aktualisiert Jellyfin zum Beispiel im Hintergrund die Metadaten zur Medienbibliothek.

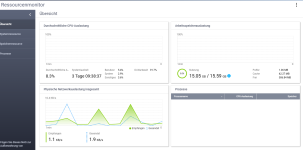

Und die Auslastung ist wohl so hoch, dass das NAS nicht mehr erreichbar ist...

Deswegen kann ich leider nicht einsehen, was genau so ausgelastet ist.

Ist nur die Frage, ob SSDs da helfen und ob ich das noch im Nachhinein machen kann.

Ich durchsuche mal das Internet.

EDIT:

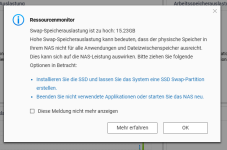

Ah, das NAS hat es geschafft selber eine Meldung rauszugeben...

also doch RAM der voll ausgelastet ist?

hätte ich nicht gedacht

wenn ich mich nicht irre war bei der Initialisierung der Haken bei der Kompromierung gesetzt

wahrscheinlich ist das der Grund für die hohe Auslastung, daran hab ich nicht gedacht

mehr RAM oder SSD einbauen...

EDIT2:

endlich hat er es mal aktualisiert