Richthofen schrieb:Da wäre erstmal zu definieren was "selbe Leistung" heißt.

Bei einer Gaming Grafikkarte definiere ich natürlich die Framerate als Leistung. Natürlich sind auch andere Faktoren wie Stromverbrach, Lautstärke und Treiber wichtig. Aber das ist bei AMD doch nicht zwangsläufig schlechter... Ich zB stand 2012 vor der Entscheidung HD7870 oder GTX660, sie war damals noch fast so schnell wie die Radeon. Vor jedem Grafikkartenkauf gucke ich mir an, was es für mein Budget, meist gut 200€, auf dem Markt so gibt. Und da war die HD7870 einfach das bessere Angebot, mindestens genauso effizient, sehr leise und FC3 gabs kostenlos auch noch dazu.

Ein Bekannter hatte sich für eine GTX660 Ti entschieden, obwohl eine 7950 schneller ist und 3 kostenlose Spiele beinhaltet... Er hat die Nvidia Karte genommen, weil sich die meisten für eine Nvidia entscheiden. So plump war sein Kaufgrund.

Es wird ja immer so getan, als ob es bei AMD keine leisen, kühlen, effizienten oder kurzen Karten gäbe. Da sehen sich die Noobs einen Test der HD7970 GHz Edt im Ref Design an und schließen daraus, dass das halt eben AMD ist.

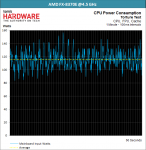

AMD's größtes Problem ist das schlechte Image. Sie müssten mal ein exzellentes Produkt veröffentlichen und dieses gut vermarkten. So ein Desaster wie bei der R9 290X darf nicht noch einmal passieren. Keine Ahnung wer da enschieden hat, einen so guten Chip mit einem so schlechten Kühler auszustatten. Furchtbar laut, 95°C und hohe Leistungsaufnahme. Als ob man das schlechte Abschneiden der 7970 GHz Edt im Ref toppen wollte.

Hätte man einen guten DHE Kühler drauf geschnallt oder gleich Sapphire damit beauftragt, wäre die Karte ein großer Erfolg geworden. So schnell wie die absurd überteuerte GTX Titan, unter 80°C bei ca. 250W.