Cokebei3Grad

Lt. Junior Grade

- Registriert

- Apr. 2006

- Beiträge

- 262

Wer das nicht weiß, kann eben keinen Rechner selbst zusammenbauen.

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.

Ach stimmt weil jeder Mainboard Käufer Gamer ist... ach ne warte das sind die wenigsten.

Was meinst du wie 90% der Boards im OEM bzw. Business Markt aussehen? Ja genau so.

Als ob man das bei AMD News nicht gewohnt seiCokebei3Grad schrieb:Man kann auch aus ner Mücke nen Elefanten machen!

Es geht um die 125W-Modelle ... und ja, es gibt ein 125W-Modell: FX-8150 Zambezi Black Edition FD8150FRW8KGU(BE).HominiLupus schrieb:Der 8150 hatte ja auch keine Probleme: ...

MiesMosel schrieb:...Wenn das Board genug Zug über die Gehäusebelüftung bekam, gab es meistens gar keine Probleme...

grobmotoriker ist keine ausrede und ein paar mm reinplumsen ist ok. ich kipp sie rein und lass den letzten mm auch fallen. die alten Pins brachen da wesentlich schneller ab, das neue System ist eindeutig besser als Pins.Kudel schrieb:Ja, die CPU ist aber nicht sehr griffig, ich lasse sie immer aus ein paar Millimetern Entfernung reinplumpsen um sie ja nicht zu verkanten.

Bei meinem ersten Intelboard hab ich die "Federn" beim Sockel öffnen mit dem Fingernagel gestreift und schon wars vorbei.

dafür gibt's ja "kraftseitenschneider"Kudel schrieb:Naja, als "Schlosser" ist man halt etwas "grobmotorischer". Wenn ein Elektroniker einen 3mm Draht mit dem Seitenschneider durchknipsen soll, kriegt der wahrscheinlich Probleme ;p

ist ja nur 20 jahre her ... o m g ...Joshua2go schrieb:Mein erster K6 war ein Traum gegen Intel.

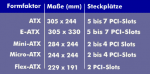

MichaG schrieb:Kleine Korrektur: Das HP-Board ist nicht Micro-ATX (obwohl HP "uATX" schreibt).

Das waren noch gaaanz alte Zeiten...da war pc noch niescheBrötchenesser schrieb:...ich weiss noch damals Anfang der 83iger da hat so nen uralter XT mal locker 5-6000 DM gekostet !

incurable schrieb:Mein Fehler, war beim letzten Mal nicht ganz so krass, sondern beim K7:

K7 600 - $699

K7 650 - $849

K7 700 - $849

K7 750 - $799

K7 850 - $849

K7 900 - $899

K7 950 - $999

K7 1000 - $1299 (+86%)

Beim K8 waren sie dann leicht zurückhaltender:

FX-51 - $733

FX-53 - $799

FX-55 - $827

FX-57 - $1031

FX-60 - $1031

FX-62 - $1031 (+41%)

Die Tendenz bleibt, wenn AMD die Leistungsführung hat, zahlen die Kunden drauf.

Den Pentium III gab es zur gleichen Zeit ebenfalls als Slot 1 und Socket 370 Versionen. Wenn Dir in der Liste CPUs fehlen findest Du sie sicher bei der später verlinkten Seite mit launch date und Preis.derbiber842 schrieb:Das ist jedoch sehr unvollständig. Die K7 waren Slotprozessoren und in der Herstellung teuer.

Der K7 650 war $180 über den PIII 600, der K7 700 rund $100 über dem PIII 700, später war auch der K7 750 teurer als der PIII 700. Die 800er lagen auf beiden Seiten pari, bevor es schlussendlich zum Rennen um das volle GHz kam, bei dem AMD mal eben $300 / 30% mehr verlangte, weil Intel nicht in ausreichenden Mengen liefern konnte.derbiber842 schrieb:Die K7 teile waren aber immer noch gut 50 Dollar billiger als die Intelpedanten.

Ist das jetzt der richtige Moment, um mich als Besitzer besagten PII 300s (Klamath) zu outen? Daher weiß ich auch noch, dass der zitierte erste Listenpreis von $1981 schlichtweg Intels Eingeständnis war, dass zum Launch des Pentium II praktisch keine 150-MHz-SRAMs aus der Produktion kamen. Mit verbesserter Yield und tatsächlicher Verfügbarkeit fiel auch der Preis wieder ins alte Schema. (und meiner lief dann auch über Jahre stabil mit 337,5 MHzderbiber842 schrieb:Und wenn du 1300 Dollar schon viel findest, sieh doch mal nach was Intel für die ersten dickeren Modelle der Pentium II so haben wollte (kleiner Hinweis vorweg es waren keine 1300 und keine 1500)?

http://m.heise.de/newsticker/meldung/CPU-Preiskrieg-naechster-Akt-9618.html

So ist es und wenn man die CPU entnimmt, packt man gleich den Deckel wieder auf den Sockel und die Pins darin können dann auch gar nicht verbiegen. Außerdem hält der Bügel die CPU fest, es kann also nicht wie bei den AMD CPUs passiere, dass man bei der Demontage des Kühler gleich noch die CPU aus dem Sockel zieht, wenn diese wegen der WLP zu sehr am Kühler festklebt.Darkblade08 schrieb:Bei Intel muss man den Sockel eigentlich nicht berühren. Halteklammer auf, CPU rein, Halteklammer zu und der Plastikschutz vom Sockel löst sich von alleine.

Aufgrund der Fotos eines OEM Boards, kann man weder bestätigen noch widerlegen, ob die Gerüchte stimmen wonach AM4 für CPUs (APUs) bis zu 95W TDP ausgelegt ist. Dieses Board ist auch nur für bis zu 65W und es ist ein OEM Board, da sollte man bzgl. Aufrüstungen seine Ambitionen sowieso auf Festplatten und allenfalls das RAM beschränken. Das BIOS der Boards unterstützt meist nur die HW, vor allem die CPUs, die ab Werk lieferbar waren und auch bei den Grakas kommt es vor, dass andere als die konfigurierbaren einfach ausgesperrt werden. OEM Rechner sind nicht für Bastler, die konfiguriert man wie man sie braucht, nutzt sie und schickt sie dann irgendwann so in Rente. Die Hersteller verhindern auch lieber das irgendwelche andere HW dort läuft als es zu unterstützen und dann Supportanfragen zu bekommen.emeraldmine schrieb:Die eine EATX12Volt Steckbuchse am Mainboard sagt uns doch sicher dass die TDP der kommenden CPUs unterhalb der 95 Watt Marke liegen wird, oder kann man das an den Spawas ausmachen ?

Wobei es auch die Möglichkeit gibt nur die LGA Sockel auf dem Mainboard zu tauschen bzw. tauschen zu lassen, denn ein Lötkolben recht dafür nicht aus.incurable schrieb:Mir ging es auch eher darum, dass man im Fall der Fälle bei Intel das Board austauschen muss, bei AMD die CPU.

Welche konkreten Modelle es von Zen wann geben wird, mit wie vielen Kernen und welche TDP, ist noch gar nicht bekannt.emeraldmine schrieb:Stehen die 65 Watt für den 8/16 Core oder gibts wieder Einstiegsmodelle ?

Welches konkrete Modell? Die i7 und Xeon E5 oder die Broadwell-DE wie den Xeon-D 1541? Das ist auch ein 8 Kerner mit HT und der braucht auch wirklich nur die maximal 45W TDP, zumindest war es bei den großen Brüder Xeon-D 1557 und 1581 im Review bei Anandtech so, dass Peak vs. Idle Power nur um 1W über deren TDP lagen. Beim Xeon E5-2640 v4 mit 90W TDP waren es gar nur 67W und damit deutlich weniger als die TDP, während der Xeon E5-2690 v3 mit 135W TDP in der Spitze sogar 170W genommen hat. Die TDP sagt über die reale Leistungsaufnahme einer CPU eben nicht wirklich viel aus, der E5-2690 v3 dürfte nämlich demnach nur 50% mehr Leistung als der E5-2640 v4 brauchen, in Wahrheit sind es aber 170W zu 67W und damit mehr als das 2.5 fache.emeraldmine schrieb:noch nicht auszumachen was der 8/16 Core für Leistung verbraten wird. :/ equivalent zum Intel Pedanten....

Das auf jeden Fall.Brötchenesser schrieb:seit doch alle froh das AMD noch entwickeln kann..das ist für alle Computer User von Vorteil.

Das sicher nicht, denn es gibt auch einen Markt für PCs die deutlich weniger kosten und den würde Intel nicht alleine ARM überlassen wollen. Die würden auch ein breites Angebot aufrecht erhalten, so wie es heute vom kleinen Atom bis zum dicken Xeon ist und würden die CPUs auch weiter entwickeln um den Kunden den Umstieg auf neue Systeme schmackhaft zu machen, die Sorgen es würde dann die total Stagnation geben und die Preise würden durch die Decke gehen, halte ich für unberechtigt. Aber Konkurrenz belebt das Geschäft und davon haben wir alle was.Brötchenesser schrieb:hätte Intel die alleinige Macht müssten wir heute für einen PC bestimmt 1000 € bezahlen.

Das die Preise damals so hoch waren und so gefallen sind, hat aber vor allem andere Gründe als alleine den Wettbewerb der CPU Hersteller. Was damals aus vielen Teilen bestand, passt heute in einen günstigen, weil mit modernen Methoden und in großen Mengen gefertigten Chip.Brötchenesser schrieb:ich weiss noch damals Anfang der 83iger da hat so nen uralter XT mal locker 5-6000 DM gekostet !

Wenn es wirklich dringend ist, muss Du das nehmen was es heute gibt, wenn Du warten kannst, warte ab und schau was kommt. Es kommt sowieso immer wieder was Neues, leistungsstärkeres und einfach geilers, da kommt man nie zum Aufrüsten, wenn man immer schon auf die als nächsten angekündigte HW schielt. Nach Zen kommt Zen+, der dürfte schon mal die gröbsten Macken bei Zen beheben, die man offenbar auch schon erkannt hat. Es ist doch normal, dass man bei einer neuen Architektur nicht gleich alles optimal hinbekommt und bei der ersten Überarbeitung gleich noch mal einen größeren Schritt machen kann, als bei allen folgenden.Ball_Lightning schrieb:Die Frage ist, wann sie nun wirklich kommen. Ich müsste wirklich dringend aufrüsten und möchte echt ungern auf Intel und Nvidia umsteigen.

Bristol Ridge ist nur ein Knochen, nämlich der alte Carrizo Chip bei dem nun ein paar damals nicht freigegebene Funktionen genutzt werden können. Da der erstmal nur für OEMs kommt, recht wohl selbst AMD nicht wirklich damit, mit diesen abgekauten 28nm Knochen im Retailmarkt viele Hunde hinter dem Ofen hervorlocken zu können.emeraldmine schrieb:Ich bin mir sicher, da wirft man uns wieder nur die "Knochen" hin

Das ist im Mainstream nicht nötig und der Preis sind einmal eine hohe Leistungsaufnahme und zum anderen trotzdem eher geringe Taktraten, selbst beim Turbo und damit wäre so eine CPU für die meisten Heimanwender langsamer. Wer viel CPU Leistung will, das sind eben meist die Profinutzer und die müssen eben auch dafür bezahlen, es war nie anderes und wird nie anderes werden. Aber die verdienen mit den Systemen eben auch Geld und können sie sich daher auch leisten.emeraldmine schrieb:entwickelt doch mal Rechenpower für den Mainstream ist das denn so teuer zu entwickeln !?

Das ist eben auch ein OEM Board. Meine Schwester hat mal gesagt, nachdem ich bei meiner Mutter die Küche tapeziert hatte: Sieht ja aus wie eine KüchentapeteCandy_Cloud schrieb:Das gezeigte HP Board lässt einem die Füße einschlafen. OEM Sch....

Null nicht, aber nicht viel.Candy_Cloud schrieb:Der Sockel selbst sagt leider immer noch Null über die mögliche Leistung aus

Warum wollen alle AMD CPUs nur, wenn die vor allem günstig sind? So kann AMD dann aber nie das Geld verdienen, welches sie dringend brauchen um die Zukunft zu sichern. Die arabischen Investoren werden denen nicht ewig Geld hinterherwerfen, damit sparsam veranlagte Kunden günstige CPUs bekommen.Candy_Cloud schrieb:Denn ein echter Angriff auf Intel ist nur, was Intel wirklich schlägt. Also schneller & günstiger ist.

Das ist klar, die Plattform gehört immer dazu, die Zeiten wo es andere Anbieter von Chipsätzen gab oder man sogar noch wählen konnte von welchem Anbieter man die CPU für sein Board gekauft hat, sind vorbei.Candy_Cloud schrieb:Besonders wichtig neben der reinen CPU Leistung ist auch das Feature Level. Was bring später eine 10-15% schnellere CPU wenn die Boards nicht genügend PCIe Lanes bekommen für M.2/U.2, PEG, etc.

Was soll das bringen? Die iGPUs der APU sind zwangsweise eher schwach, weil einfach die Resourcen dafür nicht so üppig sind. Dies mit einer leistungsstarken Graka zu verbinden, bringt daher vor allem Probleme, aber nur wenig Mehrleistung.Chillaholic schrieb:Ich würde evtl. auch eine größere ZEN APU kaufen, wenn AMD es gebacken kriegt, dass diese mit einer kommenden Vega zusammen als "Dual Graphics" verwendet werden kann. So etwas gab es ja schon mal bei den A10 APUs, aber das war leider nur bis zur AMD R7 250 kompatibel

Dann ist man doch wieder nicht weit vom Verschleudern.Chillaholic schrieb:Damit mein ich nicht verschleudern, sondern einfach Intel gegenüber die Preise wieder zurechtrücken.

Welche Preis sind hoch? Die der Mainstream CPUs von Intel sind es sicher nicht, der Euro ist nur im Moment eher schwach. Der hat einen empfohlenen Verkaufspreis von 339-350$, der i7 4790K kostet 2013 339$, der i7-2700K war 2011 mit 332$ nur 7$ günstiger und ein i7 870 2009 mit 562$ sogar weitaus teurer, der Core2Quad Q9650 2008 mit 530$ kaum billiger und auch der Core2Quad Q6600 war 2007 mit 530$ so teuer wie sein Nachfolger. 2006 hat schon ein Core2Duo E6600 mit 2 Kernen und 2,4GHz mit 316$ fast so viel gekostet wie heute der schnellste S. 1151 i7.Chillaholic schrieb:Die aktuellen Preise von Intel sind ja nur so hoch, weil es aktuell keine Konkurrenz gibt.

Klar, die sind doch nicht die Führsorge und gehören nicht der Heilsarmee, die müssen Geld verdienen und wenn sie entsprechende Produkte haben und damit hohe Preis durchsetzen können, werden sie das auch machen.incurable schrieb:Die Tendenz bleibt, wenn AMD die Leistungsführung hat, zahlen die Kunden drauf.

Wobei dies Anbindung beim S.1511 kaum auf die Latenz schlägt, die 4k Werte der 950 Pro sind bei denen auch nicht schlechter als bei meiner 950 Pro die im ASRock Z97 Extreme 6 direkt an den Lanes der CPU hängt. Der Vorteil beim S. 1151 wäre dann immer noch, dass man dort mehr Lanes hat und damit auch mehr PCIe SSDs daran betreiben kann. Klar müssen die sich die Bandbreite des DMI Flaschenhalses teilen, aber das ist ja nur ein Problem, wenn mehrere in die gleiche Richtung Daten übertragen, also vor allem im RAID 0. über deren Sinnhaftigkeit man sowieso streiten kann. Da PCIe bidirektional Daten übertragen kann, ist es beim Kopieren von einer auf die andere, kein Nachteil.YforU schrieb:SR auf AM4 hat 16 für PEG (teilbar auf 8+8), 4 für die Anbindung der externen SB und 4 für NVMe (3.0). Über die externe SB (Promontory) gibt es je nach Ausbaustufe für weitere Controller/Ports bis zu 8 GPP 2.0 Lanes. Das reicht denn im Gegensatz zu Intel (LGA 1151) hängt NVMe Storage direkt an der CPU (und nicht an der SB).

Das sollte dann aber hoffentlich auch der Vergangenheit angehören, denn die Effizienz der CPUs wie die der Plattform müsste auch endlich mal besser werden.Lord B. schrieb:Gekühlte Spannungswandler haben gerade bei AMD Sockel/ Boards schon ihre Daseinsberechtigung. Einfach mal die Forum-SuFu nutzen. Ist ja nicht so als gäbe es nicht genügend Beispiele!

Nicht so viel besser? Der bietet 40 statt 16 PCIe Lanes und Quad-Channel statt Dualchannel RAM.Compo schrieb:Klar, mehr Kontakt bedeutet wohl auch mehr Signale. Aber Intels Sockel 2011 mit seinen 2011 Pins ist nicht soooo viel besser als der Sockel 15xx.

Nein, schau Dir die Broadwell-DE an, da geht es vom kleinen Pentium-D 1507 Dualcore SoC bis zum schon erwähnten Xeon-D 1581 16 Kerner und alle haben FCBGA1667 "Sockel" (sind gelötet). Intel könnte auch problemlos eine 8 Kern oder gar 16 Kerner in einen S.1151 packen, nur müsste der eben dann beim Takt zurückhaltend sein, damit die maximale TDP des Sockels nicht überschritten wird und es würde bei so mancher Anwendung zu Bandbreitenproblemen beim RAM kommen, Dual Channel RAM ist dann eben schnell ein begrenzender Faktor und so viele PCIe Lanes bietet der Sockel auch nicht. Es hat schon Gründe warum Intel sich bei den CPUs mit vielen Kernen auf den großen Sockel beschränkt, denn so ein Monster will auch gefüttert werden, mit Daten wie mit Strom.Ravenstein schrieb:Fur den 2011er Sockel gibts 8kerner fur den 1151 nicht

Das durfte mit ein Grund fur die höhere Pin Anzahl sein

So ist es, Pins braucht man für I/O und Spannungsversorgung, denn jeder kann nur einen bestimmte Strom übertragen und daher braucht umso mehr parallel, je mehr Leistung die CPUs aufnimmt und je geringer deren Betriebsspannung ist. I/O dürfte aber den Löwenanteil ausmachen, die Broadwell-DE haben ja FCBGA1667 und damit wohl auch etwa 1667 Pins (Lötkontakte) und brauchen dabei maximal 65W, aber die haben eben 6 SATA Ports, 8 USB Ports, 32 PCIe Lanes und 2 NICs.incurable schrieb:Es gibt zwei bestimmende Größen für die Anzahl der Pins: I/O und Stromversorgung.

Wobei von den 44 und 20 jeweils 4 für die Anbindung des Chipsatzes sind, DMI ist technisch PCIe x4.incurable schrieb:Die zusätzlichen Pins beim 2011er Sockel (ggü den 115xern) erklären sich sowohl aus den zusätzlichen I/O-Schnittstellen (4 statt 2 Speicherkanäle, bis zu 44 statt 20 PCIe lanes, ggf QPI, allerdings auch fehlendes Grafikmodul) als auch durch die höhere maximal unterstützte Verlustleistung pro Sockel. (165W vs. 95W in der Spitze)

Was bei den meisten Anwendungen auch Sinn macht, bei vielen Kernen müssen ja auch die I/O Bandbreite stimmen, sonst müssen sie bei den meisten Anwendungen immer nur auf I/O warten, Klar gibt es auch Anwendungen wo I/O weniger relevant ist, aber solche CPUs werden nicht nur für ein oder zwei Anwendungen gemacht, sondern sollen über viele Anwendungen hinweg eine gute Performance liefern. Die Broadwell-DE sind für spezielle Anwendungen im Bereich Netzwerk und Storage optimiert, die haben weniger RAM Channels und weniger L3 Cache und leiden bei den critical jOPS im SPECjbb 2015 JAVA Benchmark im Vergleich zur reinen SPECint Performance schon darunter.Compo schrieb:Wer sagt, dass Intel nicht bewusst diese Wahl getroffen hat um die Leute zum teureren Sockel zu bewegen ?

Wieso wird da immer auf Intel gezeigt? Der FM1 Sockel hat nur eine Generation gehalten und war nur ein Jahr aktuell. Es bringt auch nichts bei CPU Sockeln Pins für späteren Gebraucht vorzusehen, die aktuellen Boards könnten sie dann nicht nutzen und man müsste sich sowieso ein neuen Board holen und ob das nun den gleichen Sockel oder einen anderen hat, ist doch dann auch egal. Die Hersteller müssen auch regelmäßig neue Sockel bringen um den Anforderung für neuen I/O Schnittstellen gerecht zu werden, wie sie z.B. mit PCIe 4.0 sicher kommen werden. Es könnte also durchaus sein, dass AM4 nur ein kurzes Leben haben wird und dann der Nachfolger schon 2018 mit Zen+ und PCIe 4.0 kommt, oder wäre es Dir lieber, wenn AMD dann auf PCIe 4.0 verzichtet um den alten AM4 weiter nutzen zu können? Ist wäre doch auch nicht wirklich eine tolle Lösung.Vitec schrieb:Kann es sein das einfach bei erscheinen der ersten CPU`s für Sockel AM4 diese noch nicht unbedingt alle Pins benötigen, sondern AMD hier gleich etwas mehr designt hat, sodass man den Sockel wie bei AMD gewohnt länger nutzen wird können als nur 2 Generationen wie bei Intel ?

Tripple Channel wird es wohl eher nie wieder geben, wenn dann dürfte es auf Quad Channel raus laufen und könnte ich mir schon vorstellen, dass auch AMD einen Enthusiasten Sockel anbieten wird, der dann von den Naples Enterprise Sockel abstammt, in dem dann nur eine CPU passt und die durchaus bis zu 16 Kerne und Quad Channel haben könnte. Die Bandbreite zwischen den 8 Kernen von Zen und den 32 der dicken Server CPUs ist ja sehr groß, da dürfte noch etwas dazwischen passen, für kleinere Server und Workstations, was auch für Enthusiasten passen würde.Vitec schrieb:Ich träume ja noch immer von einem High-End-Chipsatz und CPU`s bei AMD für Consumer mit TrippleChannel .

Erstmal abwarten was die 8 Kerne (von 6 habe ich bisher wenig aus halbwegs serösen Quellen gelesen) leisten werden und wie hoch sie takten, dann wird man sehen, wie sie sich im Vergleich zu Intel schlagen.Vitec schrieb:So etwas würde nicht nur mit den APU`s super harmonieren, sondern auch zu den 6 und 8 Kernern gut passen, als alternative zu den 2011er Sockeln.

Das ist eben das Problem eines langledigen Sockels, die Spannungsversorgung muss für viele CPUs unterschiedlicher Fertigungstechniken und mit unterschiedlichen Betriebsspannungen, Energiespartechnologien und damit einhergehen Verläufen der Leistungsaufnahme ausgelegt werden.HominiLupus schrieb:Der 8150 hatte ja auch keine Probleme: dafür hat Asrock seine minderwertigen Boards gebaut und das konnten die auch ab. Das Problem entstand erst mit Vishera FX-8350.

Die haben ja auch eine deutlich geringere maximal Leistungsaufnahme, da braucht man nicht so viele Pins, weil nicht so viel Strom fließt.HominiLupus schrieb:Mehr Pins sind eben mehr Pins für z.B. Masse und Versorgungsleitungen. Das _kann_ helfen, muss aber nicht. Z.B. sind bei Notebook CPUs von Intel immer deutlich weniger Pins vorhanden als bei den Desktop CPUs.

Die Zen für den AM4 werden nur Dualchannel haben, intern könnten die vielleicht mehr, aber bei nur 1331 Pins und dem ganze I/O, die sind ja im Grunde SoCs, dürften für Quadchannel nicht genug Pins vorhanden sein. Außerdem haben die großen 32 Kerner, die aus mehr als einem Die bestehen, 8 RAM Kanäle entweder sind da zwei Dies mit je 16 Kernen und Quadchannel drauf, oder sogar 4 mit je 8 Kernen und Dual Channel, jedenfalls würde auch dort dann das Verhältnis von 2 RAM Kanälen zu 8 Kernen passen.HominiLupus schrieb:Zen hat doch einen Quadchannel RAM Bus oder? Wie sie den in 1331 Pins gequetscht haben wenn Intel dafür 2011 nutzt?

Eher freigeschaltet als aufgebohrt.Deep:Blue schrieb:Man darf aber nicht vergessen, dass Bristol Ridge eigentlich ein aufgebohrter Carrizo ist

AMD sieht da eben nicht so viel Potential und wird die Konzentration eher auf Zen richten wollen. Ich verstehe auch nicht so wirklich, wieso man nun noch die alten APUs für den neuen AM4 Sockel gebracht hat, die führt am Ende nur zu solchen Verwirrungen wie das Rebranding bei den GPUs, wo dann plötzlich alten Chips mit neuen Nummer in die aktuelle Generation eingereiht werden. Am Ende dürfte so mancher der Zen haben wollte aber nicht gut informiert war, dann einen Bristol-Ridge in seinem OEM Rechner vorfinden. Es wäre klarer gewesen, wenn man die AM4 Plattform nur für Zen basierte CPUs reserviert hätte.Deep:Blue schrieb:Da AMD sich was BR angeht aber sehr bedeckt hält, wird wohl am Ende nicht soviel Mehrleistung übrig bleiben, aber genau dies gilt es mit aussagekräftigen Tests herauszufinden.

Fujistu hat sowas beim D3417-B auch, Geizhals schreibt da "reduced µATX" wenn es ist im Grunde mit 9,6"x8,4" (243,8 x 213,4mm) nur auf einer Seite etwas kleiner, passt aber von den Bohrungen zu µATX mit seinen 9,6" x 9,6". Bis auf das eine Befestigungsloch rechts oben scheinen die anderen 4 auch dazu zu passen.MichaG schrieb:Kleine Korrektur: Das HP-Board ist nicht Micro-ATX (obwohl HP "uATX" schreibt). Erkennt man an den fehlenden Bohrungen am unteren Rand.

Auch Intel hatte damals Slotprozessoren. Es geht ja auch vor allem darum, dass eben auch AMD keine supergünstigen Preise aufruft, wenn die Leistungsfähigkeit der Produkte stimmt und sie daher eben auch mehr dafür verlangen können.derbiber842 schrieb:Das ist jedoch sehr unvollständig. Die K7 waren Slotprozessoren und in der Herstellung teuer.

Schwer zu sagen, aber wenn Zen+ dann schon PCIe 4.0 bekommen wird, dann wohl eher nicht. Es gab mit FM1 auch bei AMD schon sehr kurzlebige Sockel, kurzlebigere als bei Intel üblich. Aber warte doch erstmal Zen ab und dann betrachte CPU und Board als eine Einheit die man zusammen kauft und zusammen tauscht. Der Wechsel von einer CPU auf den direkten Nachfolger lohnt sich doch sowieso meist nicht und nach ein paar Generationen ist dann schon wegen der neuen Features sowieso ein Sockel und ein neues Board fällig. Stell Dir vor Du müsstest noch ein Board von vor über 10 Jahren nutzen, mit DDR (1) RAM wo die Mudulte maximal 512MB (oder gab es auch 1GB?) hatten, AGP und PCI Slot statt PCIe und PATA statt SATA für den Anschluss der Platten.Chismon schrieb:Ob AM4 auch als Sockel erhalten bleiben wird für Zen+?

pipip schrieb:Auch gäbe es die Möglichkeit TSMC 10nm Prozess zu nützten (obwohl das wohl eher für Grafikkarten der Fall sein könnte). Allgemein soll aber der 14/16nm Prozess der Hersteller länger am Markt verbleiben und ob da so schnell ein "10nm" NV GPU kommt, ist eher fraglich. Prozess ist zu mindestens nicht alles, sondern es kommt ebenso auf die Architektur an, ebenso nicht zu vergessen, was AMD mit den High-Density Libs mit Carrizo/Bristol Ridge noch alles aus den 28nm "bulk" Prozess geholt hat.

Holt schrieb:So ist es und wenn man die CPU entnimmt, packt man gleich den Deckel wieder auf den Sockel und die Pins darin können dann auch gar nicht verbiegen. Außerdem hält der Bügel die CPU fest, es kann also nicht wie bei den AMD CPUs passiere, dass man bei der Demontage des Kühler gleich noch die CPU aus dem Sockel zieht, wenn diese wegen der WLP zu sehr am Kühler festklebt.