Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test State of the Arc: A770 & A750 im zweiten Duell gegen RTX 3000 und RX 6000

- Ersteller Wolfgang

- Erstellt am

- Zum Test: State of the Arc: A770 & A750 im zweiten Duell gegen RTX 3000 und RX 6000

- Registriert

- Nov. 2002

- Beiträge

- 9.037

Netter Versuch, aber leider falschmkl1 schrieb:Das letzte mal als ich das getestet habe, waren es genau 2 Einstellungen im Bios, die ich ändern musste. Und weil das eine einmalige Änderung ist, ist das auch überhaupt kein Problem. Aber klar, bei AMD würde man sowas eher durchgehen lassen als bei Intel. Bei AMD hätte Computerbase das wahrscheinlich schon selber mal getestet, bei Intel wird es gar nicht erst versucht.

Laut Intels Anleitung sind es 4 Einstellungen, überprüft habe ich es aber nicht. Einfach deswegen, weil aktuell dazu überhaupt keine Zeit ist. Und wenn AMD von einem so etwas verlangen würde für einen simplen Idle-Modus, hätten wir das sicherlich auch links liegen lassen und genauso kritisiert.

Ein Idle-Modus hat out of the box zu funktionieren ohne das man Sachen im BIOS ändern muss. Warum muss man das hier überhaupt diskutieren, das sollte selbstverständlich sein. Wir Reden hier nicht von irgendeinem Special Feature was ganz neu ist. Sondern vom Nichtstun im Endeffekt.

Easy1991 schrieb:Die rx 6900 xt konnte sich auch gegen die rtx 3090 behaupten und vega war nie so schlecht, nur als stock. Meine vega 56 ließ sich auf 1500 mhz übertakten und auf 0.95v gleichzeitig Undervolten.

Amd hatte sie besser einstellen müssen da, sich fast alle vegas so verhalten haben

Dennoch haben die auch gerne getrunken, aber gut - heutzutage sind die alle Stromsüchtig. Was damals klein begann entwickelte sich zur Abhängigkeit und jetzt brauchen die Karten statt 200W mal eben 300W.

Ich erinnere mich da an die HD7970. Standard lief die mit 925mhz und ohne Probleme konnte man damit auch 1.200mhz GPU Takt fahren. Das war durchaus spürbar.

BelneaHP

Lt. Junior Grade

- Registriert

- Okt. 2007

- Beiträge

- 439

Da stimmt was nicht"Und dort wirkt die Lage eher wieder vergleicht mit der im Oktober."

TCHAMMER

Lt. Commander

- Registriert

- Aug. 2007

- Beiträge

- 1.264

AwesomSTUFF

Rear Admiral

- Registriert

- Juli 2011

- Beiträge

- 5.458

Ich hätte gern ne A380 für PCIE 1x zum AV1 encoden.

whynot?

Lt. Junior Grade

- Registriert

- Dez. 2005

- Beiträge

- 381

+1TCHAMMER schrieb:

Vor allem CS:GO würd mich interessieren

R

Ragnarök88

Gast

Ja, 17,2 TF eine 3070 hat über 20 TF, AMD aufgrund Eigenheiten weniger.Rockstar85 schrieb:Schau dir die Rohleistung an...

Was letztendlich zählt ist Packdichte, Chipgröße und Strombedarf, da hat Intel sicher das Nachsehen.

Aber High End mit 256 Bit Interface, 190 Watt TDP und 400mm2 Chipfläche ist definitiv nie angepeilt gewesen. Intel peilte eine 3070 an. Die ist höchstens Midrange bis Performance.

Bei Raytracing kommt man sogar stellenweise an eine 6800XT heran.Rockstar85 schrieb:Nein war es nicht, Wir reden hier über einen Vollausbau der mal eben 17,2TFlops auf die PCIE Lanes drückt und dabei nicht mal souverän an einer wesentlich schlankeren ~10Tflops AMD vorbei kommt ..

So schwach ist das nicht. Intels Problem sind vorrangig die Treiber, wenn die einwandfrei funktionieren liegt man bei einer 3060 Ti/ 6700XT und letztere ist in 7N auch 322mm2 groß.

Rockstar85 schrieb:. Machen wir es mal anders:

N6 ACM G10 mit 406 mm² und 21 Mrd Transistoren zu

N7 Navi 23 KXT mit 237 mm² und 11 Mrd Transistoren.

Der Vergleich ist so nicht zulässig.Rockstar85 schrieb:Beide Prozesse sind N7, und der Navi ist fast halb so Groß und leistet dennoch mehr..

Gerade wenn der Treiber Overhead in höheren Auflösungen reduziert ist, sieht man die Karte 10 bis 15% hinter 3060 Ti und 6700XT und letztere ist über 300mm2 groß. Bei RT ist der Intel Chip zudem überlegen.

50% mehr kommt etwa hin, rein von Raster ausgehend.Rockstar85 schrieb:Um es mal klar zu sagen: Intel braucht derzeit fast 50% mehr Fläche, für die Leistung einer RDNA2 Salvage GPU..

RT ist Intel eher auf Augenhöhe.

Ich finde das vs AMD extrem beeindruckend.

Deine Meinungsbildung halte ich für extrem unausgewogen.Rockstar85 schrieb:Das ist nicht nur Traurig, das ist ernüchternd.

ARC wurde deutlich als Karte für Medienanwendungen platziert. Intel hat frühzeitig Davinci, Adobe, Handbrake und andere Entwickler ins Boot geholt.Gerithos schrieb:Trotzdem hat Intel diese Karte als gaming Karte platziert. Ist ungefähr so, als würd man nen neuen Sportwagen vorstelle, der weniger Leistung bringt als die Konkurrent aber Dafür ein riesen Infotainment hat. Spielt in der kernkompetenz keine Rolle oder man platziert sie halt als creator Karte, hat Intel aber nicht getan. Und ich sagte bewusst 95 Prozent und nicht 100,keine Ahnung warum man sich da dann angegriffen fühlt.

https://community.intel.com/t5/imag...C17073D547260FAE/image-size/large?v=v2&px=999

Später wurde das Marketing wegen der Stückzahlen und Aufmerksamkeit um Gaming erweitert. Data center und media waren immer die Kernmärkte.

Gerithos

Lt. Commander

- Registriert

- Mai 2020

- Beiträge

- 1.778

Und dnan muss man sich auch mit diesem Markt messen. Kein creator braucht ki upscsling oder RGB. Das Argument zieht also nicht, Intel hat sich dazu entschieden, die gpu primär an Spieler zu vermarkten. Das die gpu super in AV1 ist ändert daran nichts. Allenfalls an Intels Entscheidung, sie als eierlegende wollmilchsau zu designen, wobei sie anscheinend nur beim encoding taugt und beim Rest noch signifikant Nachholbedarf hat.Combine schrieb:Später wurde das Marketing wegen der Stückzahlen und Aufmerksamkeit um Gaming erweitert

Ich finde auf meinem Asus Crosshair VII Hero diese Einstellung nicht.xexex schrieb:Ich würde aber noch zusätzlich mindestens dahin gehen und ebenfalls ASPM aktivieren oder gleich alle Punkte.

[IMG]https://www.computerbase.de/forum/attachments/1670247154245-png.1292598/[/IMG]

Das Problem an dieser Stelle ist halt, dass vermutlich diverse/meisten OC Boards ASPM abgeschaltet haben. Es hat schon seine Gründe wieso mit solchen Boards regelmäßig Verbräuche von 50W+ im Idle gemessen werden.

Asus hat diese Funktion auf AM4 einfach weggelassen. Zumindestens finde ich keinerlei Infos das es das gibt oder wo man das auf einem Asus Board einstellt.

Diese Karte ist nur eine Variante des Chips. Gaming ist nicht der primäre Markt nur weil einer von Tausenden, Millionen Chips in einer RGB-beleuchteten Hülle steckt. Intel kann offensichtlich auch im Gamingsegment Karten verkaufen.

Beide Märkte bilden Schnittmengen. Nvidia vermarktet die Encodingfähigkeiten der RTX als Feature Gameplays online zu stellen.

Intel wollte mutmaßlich die grüne Dominanz in Notebooks brechen. Ryzen 6xxx und Intel 13xxx werden noch mit einer Nvidia 16xx verheiratet.

Im ct-Notebooktest hat die kleinere A730M weitaus besser abgeschnitten und konnte mit der RTX3060m mithalten welche eine aufgebohrte Variante der Desktop3060 ist. Notebooks können nur als Gesamtsystem mit individueller TDP etc. getestet werden.

Abstürze gab es keine, Grafikfehler in einigen der 30 Spielen, genannt wurde CS DX9.

Der Fortschritt bei den Treibern ist deutlich erkennbar. Bis ML könnte Intel eine performante APU ableiten.

Beide Märkte bilden Schnittmengen. Nvidia vermarktet die Encodingfähigkeiten der RTX als Feature Gameplays online zu stellen.

Intel wollte mutmaßlich die grüne Dominanz in Notebooks brechen. Ryzen 6xxx und Intel 13xxx werden noch mit einer Nvidia 16xx verheiratet.

Im ct-Notebooktest hat die kleinere A730M weitaus besser abgeschnitten und konnte mit der RTX3060m mithalten welche eine aufgebohrte Variante der Desktop3060 ist. Notebooks können nur als Gesamtsystem mit individueller TDP etc. getestet werden.

Abstürze gab es keine, Grafikfehler in einigen der 30 Spielen, genannt wurde CS DX9.

Der Fortschritt bei den Treibern ist deutlich erkennbar. Bis ML könnte Intel eine performante APU ableiten.

Traumsucher

Cadet 1st Year

- Registriert

- Dez. 2012

- Beiträge

- 10

Echt jetzt? Wenn ich rBAR nicht einschalte ändert das aber nix an der grundsätzlichen Funktionsfähigkeit, der Chip funktioniert sowohl bei nvidia als auch bei AMD wie beworben - ich verzichte nur auf optionale Leistung. Schon das funktioniert bei Intel ja so überhaupt nicht. Und ganz ehrlich, Intel jetzt als armes Hascherl darzustellen und den bösen, bösen Mainboardherstellern die Schuld zuzuschieben das Intel nicht stromsparend kann - das sind die selben Hersteller bei denen Intel es wohlwollend abnickt das die Powertargets bei ihren Core i´s quasi nonexistent sind ab Werk. Wie denn nun? Man kann ja Hersteller von mir aus lieben oder auch nicht, aber die Maßstäbe sollte man nicht jedesmal wechseln mMn.xexex schrieb:Das "Problem" an dieser Stelle ist, dieselbe Funktion bleibt auch bei Nvidia und AMD deaktiviert, falls sie das Board nicht von selbst per Default aktiviert. Es hat auch schon so ihre Gründe wieso dem so ist, allerdings sind diese Karten nicht von der Einstellung abhängig.

https://www.computerbase.de/forum/t...l1-pcie-maximale-energieeinsparungen.2105750/

Dabei gibt es ASPM schon bestimmt seit gut 10 Jahren und eigentlich sollten alle aktuellen Boards, GPUs und Betriebssysteme damit zurechtkommen. Die meisten "OC" Boards werden aber aus verschiedenen Gründen bis heute leider mit vielen stromfressenden Settings ausgeliefert. Das fängt bei den ACPI States an, die meist maximal bis C1 begrenzt werden, zieht sich durch VRM Settings weiter und hört bei PCIe nicht auf.

Der einzige "Fehler" den Intel hier gemacht hat ist, sie haben nicht so einen Trommelwirbel um zwei Einstellungen gemacht wie AMD damals mit rBAR. Dort sind auch nur zwei Einstellungen im UEFI notwendig, aber man hat so viel Rummel drum gemacht, dass diese Funktion überall vorkonfiguriert wird und einen prominenten Platz in den Einstellungen bekommen hat.

Ich sehe vom Aufwand hier jedenfalls keinen größeren Unterschied als bei rBAR, wo man im schlimmsten Fall überhaupt erst ein UEFI Update machen und das komplette System im UEFI Bootmodus versetzen musste. Für ASPM reichen wirklich nur die Einstellungen und die gibt es seit einem guten Jahrzehnt.

Wenn du rBAR nicht einschaltest verzichtest du bei AMD GPUs auf etwas Leistung, wenn du ASPM nicht einschaltest, verzichtest du bei Intel GPUs auf etwas Effizienz. Scheinbar ist Leistung den meisten viel wichtiger, Computerbase hat es sogar geschafft mehrere Artikel zu diesem Thema zu veröffentlichen, Effizienz wurde hingegen kritisiert, aber sonst mit keinem Artikel bedacht.Traumsucher schrieb:Echt jetzt? Wenn ich rBAR nicht einschalte ändert das aber nix an der grundsätzlichen Funktionsfähigkeit, der Chip funktioniert sowohl bei nvidia als auch bei AMD wie beworben - ich verzichte nur auf optionale Leistung. Schon das funktioniert bei Intel ja so überhaupt nicht.

https://www.computerbase.de/artikel/grafikkarten/amd-sam-radeon-rx-6800-xt-test.75469/

https://www.computerbase.de/artikel/grafikkarten/geforce-rtx-3080-resizable-bar-test.76216/

Die meisten Seiten testen die Effizienz im Idle nicht einmal, ein größer Shitstorm ist jedenfalls dadurch nirgendwo entstanden, während man mit der rBAR Sache ganze Foren gefüllt hatte. Bei diesem Thema wurde definitiv mit zweierlei Maß gemessen, die Aktivierung von rBAR hat nicht nur bei einigen zu Problemen geführt, sie bedurfte auch BIOS Updates oder auf manchen Systemen gar eine Windows Neuistallation. ASPM zu aktivieren sind hingegen nur ein paar UEFI Einstellungen, das Feature ist selbst auf 10+ Jahre alten Boards vorhanden.

Ergänzung ()

Vielleicht ein altes BIOS im Einsatz?LukS schrieb:Ich finde auf meinem Asus Crosshair VII Hero diese Einstellung nicht.

https://www.computerbase.de/forum/t...gt-x570-chipsatz-das-stromsparen-bei.1906494/

Das Thema betrifft ja nicht nur Intel, weshalb ich die Aussage von @Wolfgang im Artikel überhaupt nicht verstehen kann. Man sollte sich grundsätzlich mit diesem Thema befassen und nicht als "schlechte Eigenschaft der Intel GPUs" abhaken. Vielleicht könnte jemand den guten Leseartikel aber einfach mal wieder hochholen, wäre in Anbetracht der aktuellen Energiesituation und der Intel GPUs keine so schlechte Idee.

Zuletzt bearbeitet:

Jetzt bin ich komplett verwirrt @Wolfgang. ^^

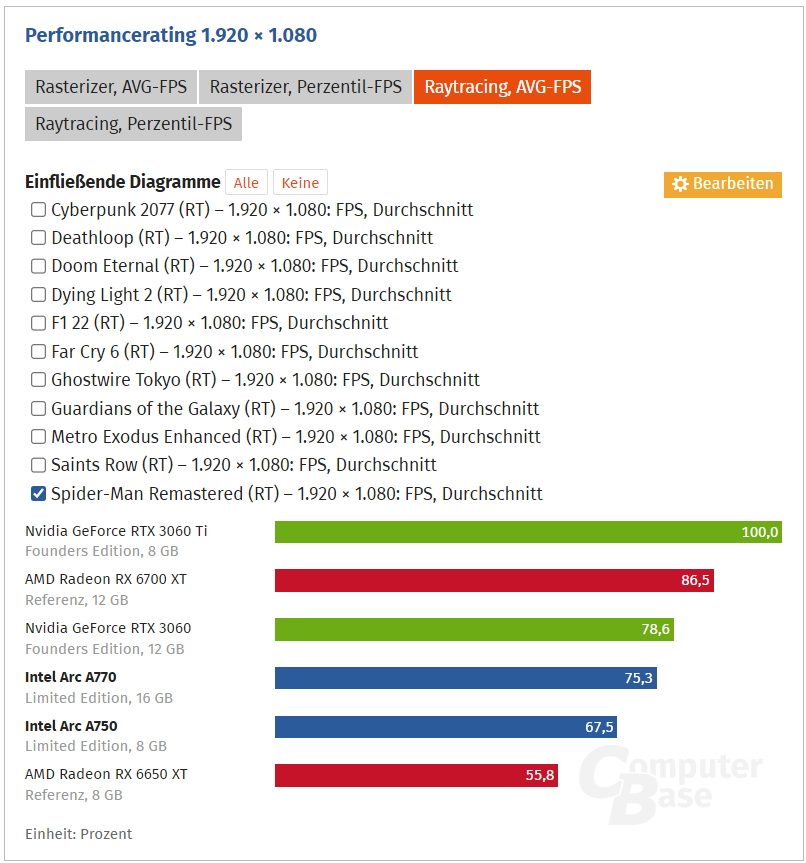

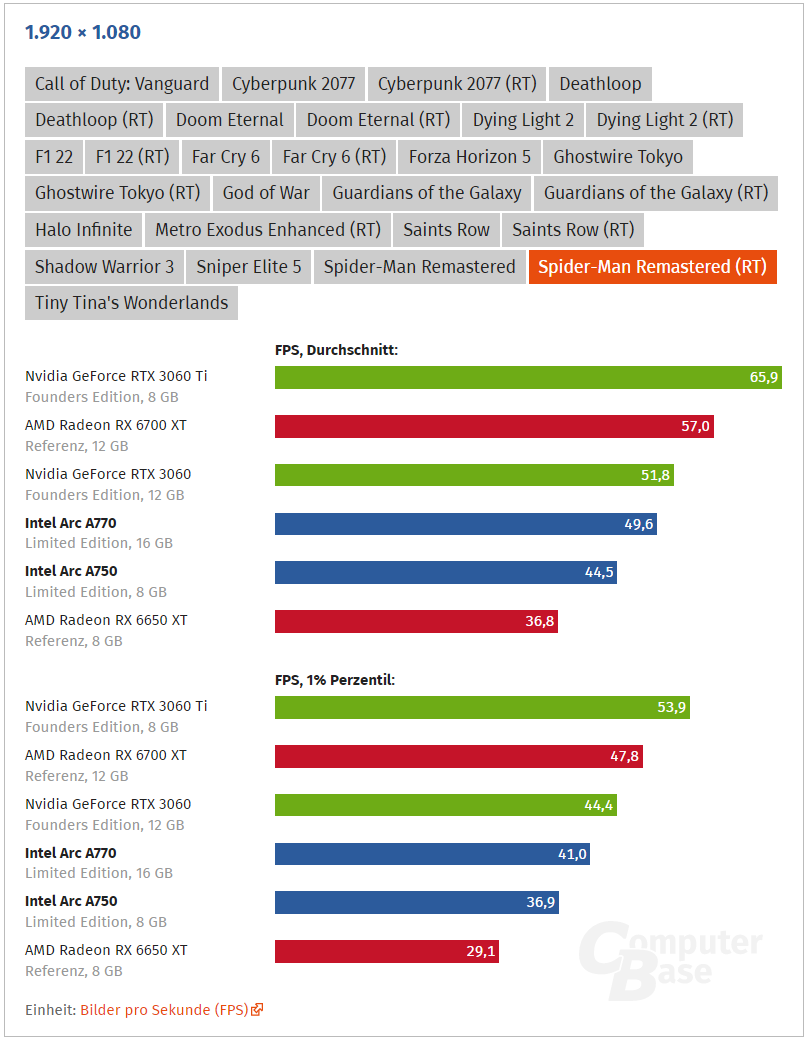

In der Gesamtauswertung liegt die Arc A770 mit RT bei 75,3 FPS Avg.

In der Einzelauswertung aber bei 49,6 FPS im Mittel.

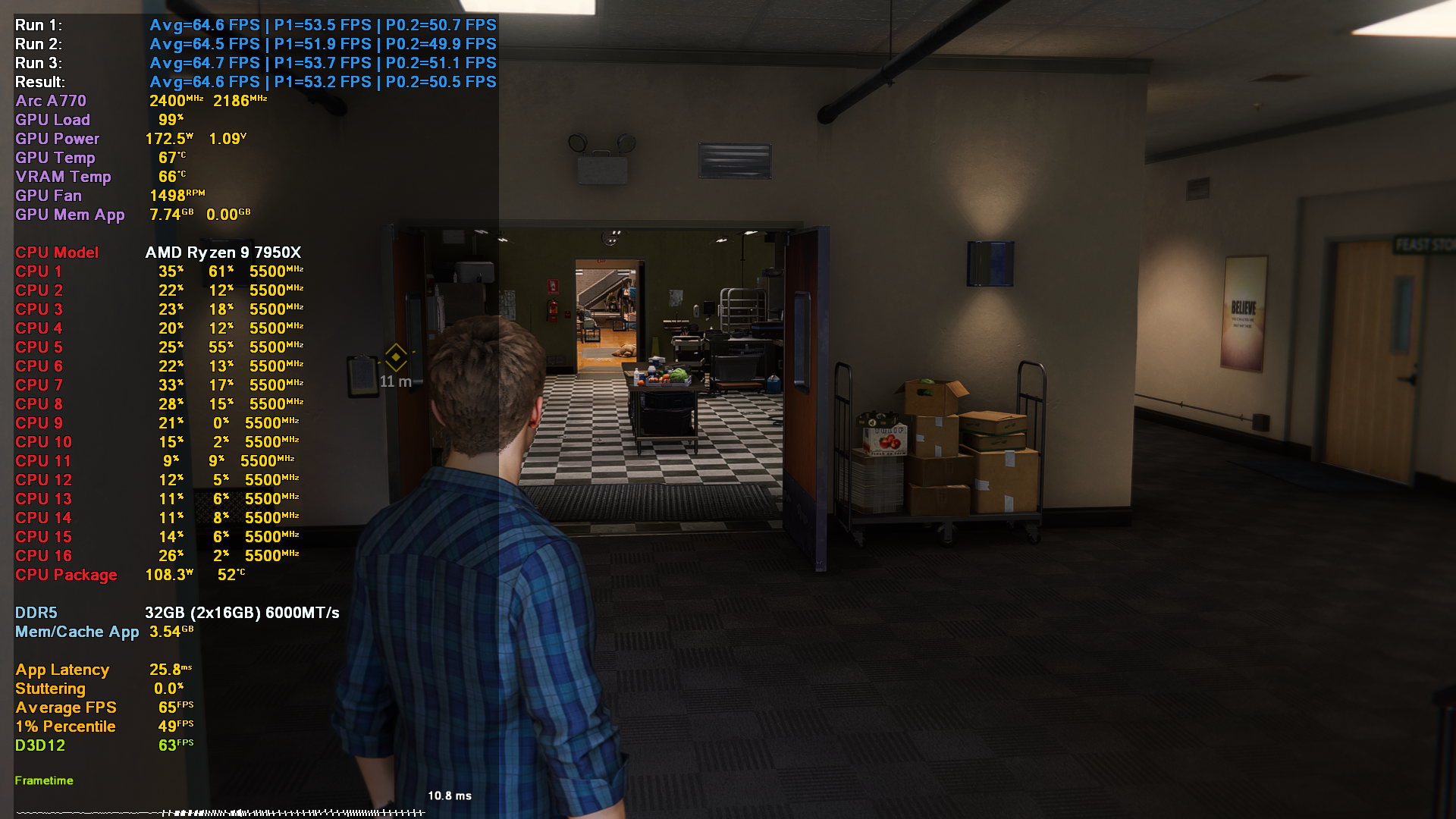

Ich komme in eurer Szene auf fast 65 FPS, was der RTX 3060 Ti entspricht. Das läuft also letztlich auf das hinaus, was PCGH und ich vom Verhältnis her auch rausbekommen haben in anderen Szenen.

Meine Settings zum Vergleich.

In der Gesamtauswertung liegt die Arc A770 mit RT bei 75,3 FPS Avg.

In der Einzelauswertung aber bei 49,6 FPS im Mittel.

Ich komme in eurer Szene auf fast 65 FPS, was der RTX 3060 Ti entspricht. Das läuft also letztlich auf das hinaus, was PCGH und ich vom Verhältnis her auch rausbekommen haben in anderen Szenen.

Meine Settings zum Vergleich.

Zuletzt bearbeitet:

therealcola

Lt. Commander

- Registriert

- Sep. 2020

- Beiträge

- 1.918

Offtopic ,aber hui! @Zer0Strat

Gar nicht mitbekommen das der 7950x mal eben 5,5 ghz auf 16 kernen packt. Oo

Fühlt sich für mich so an als hat man mittlerweile nach allen 1-2 Jahren Alteisen verbaut

Gar nicht mitbekommen das der 7950x mal eben 5,5 ghz auf 16 kernen packt. Oo

Fühlt sich für mich so an als hat man mittlerweile nach allen 1-2 Jahren Alteisen verbaut

"Der Gerät schläft nie!"therealcola schrieb:Gar nicht mitbekommen das der 7950x mal eben 5,5 ghz auf 16 kernen packt. Oo

Hab' ein wenig mit dem Curve Optimizer nachgeholfen.

DerkleineGrisu

Lt. Commander

- Registriert

- Okt. 2015

- Beiträge

- 1.285

Irrlicht_01 schrieb:Die Arc-Karten sind jedoch rar gesäht - außer Löschzwerg und Eisenoxid (wie ich jetzt gerade gemerkt habe) und mir sind da nicht viele, die tatsächlich mal ein Game spielen mit den Dingern....

Wink , Ich habe auch eine Arc 770 16GB und benutze das Teil nur für Gaming

Wobei ich da eh "Spiele , spiele " die kaum einer auf dem Schirm hat.

Bis jetzt habe ich nur beim Spiel Dual Univers das "lustige" problem das die Voxel texturen nicht geladen werden und wenn doch diese " Random" dann sind. da kann es schon mal sein das ein Voxel das normal aussehen soll wie Plastik dann die Textur von "Geschuppter Stahl" oder "Holzoptik hat ". Das ist zwar am Anfang schon lustig aber wenn man was bauen will doch schon zu Problemen führen kann.

Problem habe ich zwar dem Spieleentwickler gemeldet , der reagiert nicht. Besser ist das schon der Intel Support auf github . Der hat doch glatt sogar einen Monat Spielezeit " gekauft " bei Dual Univers und schaut wie sie den Fehler gefixt bekommen. Und natürlich zeigt sich der Spieleentwickler von der besten seite weil da beim Kaufen der spielzeit über steam ein fehler passiert ist wodurch sie das spiel nicht starten können da die SPielzeit nicht aktiv ist

ToflixGamer

Lt. Commander

- Registriert

- Dez. 2013

- Beiträge

- 1.590

konkretor schrieb:Wo bleibt die Neugierde etwas auszuprobieren? Mal wieder basteln.

Neues zu probieren.

Wo sind die Nerds und Geeks nur geblieben von früher, die diverse Karten von verschiedenen Herstellern im Rechner hatten. Sich in Foren darüber auszutauschen.

Ich hatte die Karte eigentlich bestellt, aber irgendwie lief dann bei der Bezahlung was schief und daher hab ich sie jetzt nicht - wenn ich mir aber durchlese, was da noch so läuft, stimmt mich nicht gerade positiv.

Google hat auch monatelang erzählt, Stadia würde natürlich nicht abgeschaltet werden - nur um dann 3 Monate später doch zu erzählen, dass es nicht mehr läuft.

Ich möchte nicht in 2 Jahren mit Hardwareschrott dastehen, weil Intel da keine Lust mehr drauf hat und den Treibersupport einstellt, weil nicht lukrativ - oder irgendwelche Versprechungen nicht gehalten werden. Daher bin ich da auch noch ziemlich vorsichtig - auch wenn es mich extrem reizen würde, weil die Karte sich verdammt spannend liest!

Ähnliche Themen

- Antworten

- 614

- Aufrufe

- 96.363

- Antworten

- 64

- Aufrufe

- 13.781