Den refresh hat eine SSD, die im täglich laufenden PC verbaut ist, selbstständig zu tun. Andrer SSDs können das schließlihc auch, auf meiner Crucial M500 960GB von 12/2013 sind die Dateien teils 3101 Tage alt und sie sind fast alle mit 300 MB/s und mehr durch das Tool lesbar.Luthredon schrieb:Bin ich alleine, oder finden andere das Problem auch 'erwartbar'?

Ich würde mir nie mehr eine HDD in den PC einbauen. Und selbst im NAS mit 10 GBit/s Anbindung müsste man schon eine SSD als Cache nutzen, um auch nur ansatzweise auf die Geschwindigkeit einer lokalen SATA SSD zu kommen.Luthredon schrieb:Ich würde niemals eine SSD als klassisches Datengrab verwenden.

Was soll außerdem ein Datengrab sein? Installierst Du alle paar Wochen Windows/Linux inkl. aller Programme neu, weil es sonst genügend Dateien gibt, die einmal bei der Installation geschrieben und danach nur noch gelesen werden?

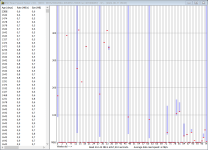

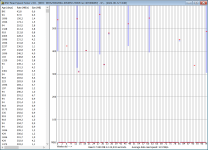

Schau Dir einfach die Screenshots an. Ganz links steht das Alter der Dateien (vermutlich das Erstellungsdatum gemäß Dateisystem, es muss also weder für die gesamte Datei stimmen noch muss es das Datum sein, an dem die Datei real auf die SSD geschrieben wurde), danaben die Leserate und die Dateigröße.ThommyDD schrieb:Könnten diejenigen, die hier fleißig Screenshots posten, bitte auch dazu schreiben, wann sie ihr System aufgesetzt haben bzw. wann die Daten auf die SSD geschrieben wurden?

Es scheint das Erstellungsdatum der Dateien gemäß Dateisystem zu sein. Das lässt sich bekanntlich, wie alle anderen Zeitstempel, beliebig ändern und es wird von einem Kopierprogramm u.U. aus der Quelle übernommen.LukS schrieb:Irgendwas stimmt mit dem auslesen beim Alter der Dateien nicht. Das mit den 8-12 Jahre alten Dateien glaub ich weder der MX300 (Mai 17 gekauft) noch der MP510 (Nov 19 gekauft)...

Bei meiner 2TB Datei gilt:

Änderungsdatum: 01.01.2020

Erstellungsdatum: 22.06.2020

Lieferdatum SSD: 21.06.2020

Reale letzte Änderung der Datei (Veracrypt-Container): 09.06.2022

Testdatum: 10.06.2020

Angabe des Tools: Alter der Datei 717 Tage