Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Weitere Hinweise zur Leistung der HD 4870 X2

- Ersteller Jan

- Erstellt am

- Zur News: Weitere Hinweise zur Leistung der HD 4870 X2

duplex_5 schrieb:überflüssiges Zitat entfernt *klick*z

Nene, da verwechselste was. Ne HD4850 soll etwa so schnell sein wie ne 9800GTX und ne HD4870 etwa 25% schneller wie ne 9800GTX.

Zuletzt bearbeitet von einem Moderator:

(Fullquote entfernt, bitte Regeln lesen.)

Neocroth

Ensign

- Registriert

- Aug. 2007

- Beiträge

- 190

BullRun schrieb:Zumindestens die GTX280 ist derart ueberlegen das auch die X2 nicht rankommt(es sei denn sie ist annaehernd doppelt so schnell wie als SIngle GPU) .Das glaubt jetzt natuerlich keiner und wird hier gleich als Schwachsinn abgetan ,aber der Beweis kommt in wenigen Tagen...Ich weiss nicht wie und warum aber irgendwas sagt mir das die 280GTX doppelt so schnell ist wie eine 8800GTX, ein gewaltiges Uebertaktungspotenzial hat und dabei noch weniger Strom als die 8800GTX braucht. War vielleicht auch ein zwitscherndes Voegelchen....

Klingt wie aus dem Kaffeesatz gelesen.

dazu mal meine eigenen Vermutungen:

1. das gewaltige Übertaktungspotential kann ich mir kaum vorstellen. Der Chip ist weiterhin in 65nm, er ist verdammt groß, massig Transistoren und eine TDP von 236 Watt.

2. aus 1. resultiert logischerweise ein höherer Stromverbrauch. nVidia selbst gibt zwar an, dass die GTX 280 unter Volllast 147 Watt benötigt - dann frage ich mich aber, warum die TDP so dermaßen hoch liegt? Es wäre dann sinnvoller gewesen, einen schwächeren, dafür aber leiseren Kühler zu verbauen. Ergo - der Stromverbrauch ist exorbitant hoch und die Karte wird verdammt heiß - das die Karte sehr heiß wird wurde ja bereits von einigen Tech-Tabloids, die die Karte in Aktion sehen durften, bestätigt. Und von irgendwoher muss die Hitze ja kommen.

BullRun schrieb:@Killermuecke

aeh ja die Zukunft gehoert den MultiCore CPU&GPU`s , aber anderst als bei der CPU werden es bei der GPU nicht identische Rechenkerne sein sondern spezialisierte Prozessoren ala PhysX usw.

Der X2 und GX2 Schrott zeigt ja deutlich das GPU`s noch schlechter skalieren als CPU`s. Mehrere Kerne sollen letztendlich immer etwas parallelisieren . Spiele, das Haupteinsatzgebiet von HighEnd GPU`s, lassen sich am Schlechtesten ueberhaupt in dieser Art optimieren.Schon allein die riesige Menge von noetigen Usereingaben innerhalb kuerzester Zeit zum Steuern usw verhindern das sinnvolle Vorberechnen irgendwelcher Werte...

X2&GX2 sind genau der falsche Weg und bringen trotz doppeltem Aufwand nicht annaehernd doppelte Leistung...gut das nvidia davon weg ist

Ein Spezialprozessor wie der PhysX dagegen macht sicher einen Riesen Unterschied zu einer reinen GPU oder gar einer Softwareemulation.Dazu noch ein Prozessor der auf Berechnung der Gegner KI bzw auf kuenstliche neuronale Netze spezialisiert ist.Fuer die allermeisten sind Spiele die einzige Anwendung bzw einziger Bedarf fuer eine KI.Also das Ganze mit auf die SPielegrafikkarte,zusammen mit einem PhysX-Core der auch nur in Spielen benutzt wird und der eigentlichen GPU die viele Sachen auch nur fuer Spiele braucht.Sowas bringt sicher erheblich mehr als der immer wieder gleiche Kram den es momentan gibt.Selbes Prinzip wie in den letzten 10 Jahren seit Erfindung der 3D-Beschleunigung ,aber mit noch schnellerem Speicher,noch schnellere Anbindung,doppelt so grossem Cache ,dreimal soviel Shader usw ...

Multi Core ja,aber mit diskreten Spezial-Prozessoren ...das ist meiner Meinung nach die Zukunft , mit dem Erscheinen der 4870X2 macht ATI einen weiteren Schritt in die falsche Richtung . GX2&X2 funktionieren nach dem Motto : "1+1= 1,3",was heutzutage vorallem aus finanzieller Hinsicht voellig sinnlos ist .

Eine GPU ist bereits ein hochspezialisierter, in höchstem Maße parallelisierter Chip - da gibt es nicht mehr allzuviel zu "spezialisieren".

Zu dem Argument, dass nVidia "weg" ist von der Idee der Multi-GPU-Lösungen:

http://www.golem.de/0804/59074.html

Es wird ja gemunkelt, dass der GTX280 der letzte monolithische Chip von nVidia sein wird und man sich danach ebenfalls auf Multi-GPU-Chiplösungen konzentrieren wird. Dazu gibt es aber meines Wissens keine eindeutige Stellungnahme von nVidia.

EDIT:

Übrigens ist es aus finanzieller Sicht sogar weit effizienter, 2 kleine GPUs auf ein Board zu pappen anstatt eines monolithischen Monsters. Die Ausbeute des Wafers sinkt mit jedem mm², den der Die wächst - es passen einfach weniger drauf, dazu kommt noch der Verschnitt am Rand. Weiters steigt mit der Größe des Dies die Wahrscheinlichkeit eines Defektes - knapp 600mm² wegzuschmeißen schmerzt mehr als runde 260mm² (GTX280 - RV770).

Das ist übrigens der Grund, warum ich denke, dass es klug war von Intel, 2 Dualcores zu einem Quad zusammen zu pappen - intelligenter kann man aus finanzieller Sicht wohl kaum einen Quad fertigen.

Zuletzt bearbeitet:

BullRun

Lt. Junior Grade

- Registriert

- Aug. 2004

- Beiträge

- 406

@33

Das hat sich vielleicht eben so angehoert aber ich bin kein nvidia Fanboy .... eher Leistungsfanboy .Jahrelang hab ich hin - und hergewechselt ,je nachdem wer das Schnellste zur Zeit hatte. Hatte die X800,9800XT usw aber seit der 7900GTX hat ATI nichts mehr zu bieten und habe seit dem nur noch nvidia.Die komplette HD Reihe von Anfang bis Ende nur Murks (im High End Segment) .Ich kann,darf und will das jez nicht beweisen aber es geht mit den neuen Karten munter so weiter,vertraut mir Ist die X2 nicht knapp doppelt so schnell wie die EInzelkarte kann sie der GTX280 gar nichts ,und der GTX260 nicht viel mehr. Durch den niedrigen Standardtakt laesst sich das Ganze offenbar noch gewaltig uebertakten.Sogar die GTX280 ist trotz gleicher Hardware wie beim Vorgaenger deutlich niedriger getaktet als dieser und entsprechende Reserven fuer ne Ultra sind vorhanden.Selbes Prinzip wie bei NetburstPentiums und Core2Duos .... halber Takt,trotzdem schneller .... Das macht Sinn , nicht "Doppelt so viel reinstecken und bestenfalls ein Drittel mehr kommt raus "...

Ist die X2 nicht knapp doppelt so schnell wie die EInzelkarte kann sie der GTX280 gar nichts ,und der GTX260 nicht viel mehr. Durch den niedrigen Standardtakt laesst sich das Ganze offenbar noch gewaltig uebertakten.Sogar die GTX280 ist trotz gleicher Hardware wie beim Vorgaenger deutlich niedriger getaktet als dieser und entsprechende Reserven fuer ne Ultra sind vorhanden.Selbes Prinzip wie bei NetburstPentiums und Core2Duos .... halber Takt,trotzdem schneller .... Das macht Sinn , nicht "Doppelt so viel reinstecken und bestenfalls ein Drittel mehr kommt raus "...

Eine saftig uebertaktete GTX280 duerfte einem Quantensprung gleichen und ich freu mich schon drauf ...

Bisher ging da ja kaum was ,die wenigen moeglichen ZusatzMegaHertz haben so gut wie nichts gebracht und eine eh schon am Limit laufende Kuehlung dann komplett zum Kotzen gebracht. Das koennte sich jez aendern , entsprechenden OC-Kuehler usw vorrausgesetzt natuerlich.Der neue Kuehler ist bestimmt derselbe Murks wie fast immer auf origjnal "Werks"karten. Geradeso ausreichend ,laut und haesslich .....

Das PCB entspricht haargenau einer fruehen G80 8800GTX Karte ,keinerlei sichtbare Unterschiede. Ich koennte wetten das ist derselbe Kuehler und das gleich PCB wie beim G80.Die 6 ungewoehnlich (4 im Quadrat und 2 etwas abseits) angeordneten SchraubLoecher einer G80 sind genau wieder da wo sie waren. G800 und G200 haben dieselbe Leistungsaufnahme , verwenden denselben Speicher ... warum das Rand neu erfinden wenn man was erprobtes verwenden kann. Der zum groessten Teil hohle bzw leere Heatspreader wird vom GT200 lediglich mehr ausgefuellt , die grosse Chipflaeche hat nicht einen erwaehnenswerten Nachteil als Kaeufer ....ist voellig Wurst ...

#43

Nunu alles klar hab ja bereits geschrieben wie meine Worte gewertet werden wuerden .... trotz klarer Fakten,die du nur noch nicht weisst. 17 Juni ist Judgement Day,naechsten Dienstag wirds ernst fuer ATI,sehr ernst sogar...trau mir

Nur kurz zu deinen Vermutungen :

1.Chip wieder in 65nm bei gleicher Hardware und aehnlicher Leistungsaufnahme ... die Logik gebietet das GT200 mindestens so schnell getaktet werden kann wie der vorgaenger. Allein das schiesst die Karte von Platz 1 auf Wolke 7

2.aus 1. resultiert dann eben auch zwei , durch die niedrigere Taktung bei ansonsten gleicher Hardware verbraucht die Karte auch aehnlich viel wie eine 8800GTX...

Eine GPU ist nicht im Mindesten spezialisiert oder gar parallelisiert. Die ist rein auf Grafik ausgelegt , ich will Karten haben die auf Spiele spezialisiert sind . Ich bin Spieler , kein Grafiker. KI,Physik,Sound gehoeren mit zum Spiel dazu und werden momentan mit voellig ungeeigneten Prozessoren berechnet.

Ahso hab mich uebrigens gewundert das du die Quads von Intel gut findest und die X2 von Ati auch. Das ist was ,was wirklich Sinn macht. AMD/ATI Fanatiker haben normalerweise die komische Ansicht X2 von ATI toll zu finden und den 2x2 Quad von Intel nicht Die Intel sind ja auch nicht nur wirtschaftlicher zu produzieren , sie sind obendrein noch schneller ... geniales Produkt ,ganz meine Meinung!

Die Intel sind ja auch nicht nur wirtschaftlicher zu produzieren , sie sind obendrein noch schneller ... geniales Produkt ,ganz meine Meinung!

Das hat sich vielleicht eben so angehoert aber ich bin kein nvidia Fanboy .... eher Leistungsfanboy .Jahrelang hab ich hin - und hergewechselt ,je nachdem wer das Schnellste zur Zeit hatte. Hatte die X800,9800XT usw aber seit der 7900GTX hat ATI nichts mehr zu bieten und habe seit dem nur noch nvidia.Die komplette HD Reihe von Anfang bis Ende nur Murks (im High End Segment) .Ich kann,darf und will das jez nicht beweisen aber es geht mit den neuen Karten munter so weiter,vertraut mir

Eine saftig uebertaktete GTX280 duerfte einem Quantensprung gleichen und ich freu mich schon drauf ...

Bisher ging da ja kaum was ,die wenigen moeglichen ZusatzMegaHertz haben so gut wie nichts gebracht und eine eh schon am Limit laufende Kuehlung dann komplett zum Kotzen gebracht. Das koennte sich jez aendern , entsprechenden OC-Kuehler usw vorrausgesetzt natuerlich.Der neue Kuehler ist bestimmt derselbe Murks wie fast immer auf origjnal "Werks"karten. Geradeso ausreichend ,laut und haesslich .....

Das PCB entspricht haargenau einer fruehen G80 8800GTX Karte ,keinerlei sichtbare Unterschiede. Ich koennte wetten das ist derselbe Kuehler und das gleich PCB wie beim G80.Die 6 ungewoehnlich (4 im Quadrat und 2 etwas abseits) angeordneten SchraubLoecher einer G80 sind genau wieder da wo sie waren. G800 und G200 haben dieselbe Leistungsaufnahme , verwenden denselben Speicher ... warum das Rand neu erfinden wenn man was erprobtes verwenden kann. Der zum groessten Teil hohle bzw leere Heatspreader wird vom GT200 lediglich mehr ausgefuellt , die grosse Chipflaeche hat nicht einen erwaehnenswerten Nachteil als Kaeufer ....ist voellig Wurst ...

#43

Nunu alles klar hab ja bereits geschrieben wie meine Worte gewertet werden wuerden .... trotz klarer Fakten,die du nur noch nicht weisst. 17 Juni ist Judgement Day,naechsten Dienstag wirds ernst fuer ATI,sehr ernst sogar...trau mir

Nur kurz zu deinen Vermutungen :

1.Chip wieder in 65nm bei gleicher Hardware und aehnlicher Leistungsaufnahme ... die Logik gebietet das GT200 mindestens so schnell getaktet werden kann wie der vorgaenger. Allein das schiesst die Karte von Platz 1 auf Wolke 7

2.aus 1. resultiert dann eben auch zwei , durch die niedrigere Taktung bei ansonsten gleicher Hardware verbraucht die Karte auch aehnlich viel wie eine 8800GTX...

Eine GPU ist nicht im Mindesten spezialisiert oder gar parallelisiert. Die ist rein auf Grafik ausgelegt , ich will Karten haben die auf Spiele spezialisiert sind . Ich bin Spieler , kein Grafiker. KI,Physik,Sound gehoeren mit zum Spiel dazu und werden momentan mit voellig ungeeigneten Prozessoren berechnet.

Ahso hab mich uebrigens gewundert das du die Quads von Intel gut findest und die X2 von Ati auch. Das ist was ,was wirklich Sinn macht. AMD/ATI Fanatiker haben normalerweise die komische Ansicht X2 von ATI toll zu finden und den 2x2 Quad von Intel nicht

Zuletzt bearbeitet:

Neocroth

Ensign

- Registriert

- Aug. 2007

- Beiträge

- 190

BullRun schrieb:die grosse Chipflaeche hat nicht einen erwaehnenswerten Nachteil ....ist voellig Wurst ... Mahlzeit

hab ich oben bereits geschrieben, welche Nachteile sich dadurch ergeben

BullRun schrieb:Nunu alles klar hab ja bereits geschrieben wie meine Worte gewertet werden wuerden .... trotz klarer Fakten,die du nur noch nicht weisst. 17 Juni ist Judgement Day,naechsten Dienstag wirds ernst fuer ATI,bitterboeser,toedlicher Ernst....glaub mir

das klingt genau wie die ATi-Anhänger, die prophezeit haben, dass der R600 alles in Grund und Boden stampfen wird...

aber natürlich kennst du nicht nur die kompletten Leistungsdaten von nVidia, sondern auch die von ATi und hast Benches vor dir liegen, die uns allen vorenthalten werden...

cosmicparty

Banned

- Registriert

- Aug. 2007

- Beiträge

- 843

ne 4870x2 mit 1024GDDR5, die auch wirklich von beiden benutzt werden können und man echte 1024 hat und nicht im endeffekt nur 512 wie im moment, verspricht schon sehr viel.

und wenn dann das problem microruckler auch vom tisch ist, ja dann liegt ati in der entwicklung bestimmt ein jahr vor nvidia.

also ich würd nvidiaaktien verkaufen, deren marktanteil wird einbrechen.

leistungsspitze wird an ati gehen und im mittelfeld sieht die 9er reihe von nvidia auch keine sonne gegen die 4er von ati.

tja, so ist das immer, wenn einer gewinnt, muß der andere verlieren und ich würd fürs nächste jahr keinen cent auf nvidia setzen, auch wenn nun wieder fanboys erscheinen in form des nividiaKriegers *ggg*

PS: wie nervös nvidia wird zeigt auch die neuste meldung, dass nvidia ati cuda und phyx umsonst anbietet.

und wenn dann das problem microruckler auch vom tisch ist, ja dann liegt ati in der entwicklung bestimmt ein jahr vor nvidia.

also ich würd nvidiaaktien verkaufen, deren marktanteil wird einbrechen.

leistungsspitze wird an ati gehen und im mittelfeld sieht die 9er reihe von nvidia auch keine sonne gegen die 4er von ati.

tja, so ist das immer, wenn einer gewinnt, muß der andere verlieren und ich würd fürs nächste jahr keinen cent auf nvidia setzen, auch wenn nun wieder fanboys erscheinen in form des nividiaKriegers *ggg*

PS: wie nervös nvidia wird zeigt auch die neuste meldung, dass nvidia ati cuda und phyx umsonst anbietet.

Zuletzt bearbeitet:

QwertyQwertz

Ensign

- Registriert

- Mai 2008

- Beiträge

- 145

Wenn das Microruckler-Problem bei Dual-GPU-Karten durch die "Speicher-Lösung" gelöst wäre, dann kann eigentlich die herkömmliche Crossfire-Verwendung dies prinzipbedingt nicht leisten.

Interessant wäre dann auch die Crossfire-Lösung mit zwei Dual-GPU-Karten.

Sind die Ruckler dann wieder da oder in einen unmerkbaren Bereich verschoben?

Offene Fragen - ich bin skeptisch...

Interessant wäre dann auch die Crossfire-Lösung mit zwei Dual-GPU-Karten.

Sind die Ruckler dann wieder da oder in einen unmerkbaren Bereich verschoben?

Offene Fragen - ich bin skeptisch...

Unyu

Banned

- Registriert

- Okt. 2004

- Beiträge

- 6.891

Die 4870 X2 hat eine TDP von 240-250W, kein Vorteil durch Dual Die.Neocroth schrieb:aus 1. resultiert logischerweise ein höherer Stromverbrauch. nVidia selbst gibt zwar an, dass die GTX 280 unter Volllast 147 Watt benötigt - dann frage ich mich aber, warum die TDP so dermaßen hoch liegt?

Die TDP ist immer weitaus höher als der tatsächliche Verbrauch, vergleiche mal aktuelle Karten ...

Ach ne lieber nicht, G200 hat einen IHS, bei gleichen Verbrauch muss die TDP schon mal höher angegeben sein.

Es wird wohl fast keine fehlerfreien G200 geben. Aber zum Glück ist der Chip recht parallel aufgebaut. -> Kein Argument.Neocroth schrieb:Weiters steigt mit der Größe des Dies die Wahrscheinlichkeit eines Defektes - knapp 600mm² wegzuschmeißen schmerzt mehr als runde 260mm² (GTX280 - RV770).

Bleibt einzig der Verschnitt am Waferrand, da zwitschern meine Vögel von:

- 450mm Wafern in ein paar Jahren

- Einem Dieshrink nach 55nm

Was ist wohl komplizierter?

Einen Chip zu verdoppeln (von einem kleinen Die zu einem großen Die) oder eine tolle Logik zu designen, um mehrere Dice effizient miteinander arbeiten zu lassen?

PS: Ich glaube nicht an das Mikroruckel Fix Design.

Warum? Damit ich meine Fans nicht entäusche.

BullRun

Lt. Junior Grade

- Registriert

- Aug. 2004

- Beiträge

- 406

#45

ich sagte es ergeben sich keine Nachteile fuer den ___Kaeufer___ und genauso ist es ,Rest interessiert mich nicht. Ganz offentsichtlich scheinen die "Nachteile" nicht die Vorteile aufzuwiegen sonst waere das nicht so konstruiert worden ... logisch oder .... Leute an soner Karte arbeiten die weltweit fuehrenden Spezialisten dutzendweise und auch nicht von heute auf morgen. nvidia steht in jeder Hinsicht glaenzend da und brauch keine Not-Zwangs- oder Bastelloesungen anzubieten . Wenn etwas irgendwie ist dann ist das so aus einem bestimmten Grund...

Die Infos habe ich von einer zuverlaessigen Quelle die keinerlei Anlass hat zu luegen oder zu uebertreiben .Das grosse Geheimnis ist eigentlich gar keins mehr, in Kreisen die mit Herstellung und Transport der Hardware zu tun haben sind die Karten unter der Hand unterwegs und die kleinste Kleinigkeit ist bekannt.Bevor das Verschwiegenheitsabkommen am Launchtag nicht hinfaellig wird , wird man aber im Netz nichts dazu finden , der Verfasser eines Vorabtests wuerde ja dann selbst die Beweise fuer ein kommendes Verfahren liefern. Solche Schadensersatzverfahren koennen gewaltig teuer werden , deswegen werden sich alle daran halten. So einfach ist das . Weils dort(Taiwan) alle Spatzen von den Daechern pfeifen und ich dort zufaellig voruebergehend einen Kontakt habe weiss ich manche Sachen die hier noch nicht so bekannt sind.Der Kontakt ist nach Ende seiner Arbeit dort wieder abgerissen und ich weiss wieder soviel wie alle anderen,also nix mit VGA-Geheimbund oder sowas Ich waere gerne immer so gut informiert ueber solche Sachen,an der Boerse kann man richtig Geld machen mit solchen Infos.

Ich waere gerne immer so gut informiert ueber solche Sachen,an der Boerse kann man richtig Geld machen mit solchen Infos.

@unyu

Auch der Hersteller ist nicht sonderlich im Nachteil. Die grossen Chips werden im bekannten 65nm Prozess gefertigt den nvidia im Laufe der Zeit immer besser in der griff gekriegt hat und somit auch einem hohen yield hat .der shrink auf 55mm haette die flaeche zwar verkleinert aber einen neuen Prozess erfordert der erst anlaufen muss und anfangs meist gar und gar nicht rundlaeuft .Die Verluste waeren also vermutlich noch hoher

ich sagte es ergeben sich keine Nachteile fuer den ___Kaeufer___ und genauso ist es ,Rest interessiert mich nicht. Ganz offentsichtlich scheinen die "Nachteile" nicht die Vorteile aufzuwiegen sonst waere das nicht so konstruiert worden ... logisch oder .... Leute an soner Karte arbeiten die weltweit fuehrenden Spezialisten dutzendweise und auch nicht von heute auf morgen. nvidia steht in jeder Hinsicht glaenzend da und brauch keine Not-Zwangs- oder Bastelloesungen anzubieten . Wenn etwas irgendwie ist dann ist das so aus einem bestimmten Grund...

Die Infos habe ich von einer zuverlaessigen Quelle die keinerlei Anlass hat zu luegen oder zu uebertreiben .Das grosse Geheimnis ist eigentlich gar keins mehr, in Kreisen die mit Herstellung und Transport der Hardware zu tun haben sind die Karten unter der Hand unterwegs und die kleinste Kleinigkeit ist bekannt.Bevor das Verschwiegenheitsabkommen am Launchtag nicht hinfaellig wird , wird man aber im Netz nichts dazu finden , der Verfasser eines Vorabtests wuerde ja dann selbst die Beweise fuer ein kommendes Verfahren liefern. Solche Schadensersatzverfahren koennen gewaltig teuer werden , deswegen werden sich alle daran halten. So einfach ist das . Weils dort(Taiwan) alle Spatzen von den Daechern pfeifen und ich dort zufaellig voruebergehend einen Kontakt habe weiss ich manche Sachen die hier noch nicht so bekannt sind.Der Kontakt ist nach Ende seiner Arbeit dort wieder abgerissen und ich weiss wieder soviel wie alle anderen,also nix mit VGA-Geheimbund oder sowas

@unyu

Auch der Hersteller ist nicht sonderlich im Nachteil. Die grossen Chips werden im bekannten 65nm Prozess gefertigt den nvidia im Laufe der Zeit immer besser in der griff gekriegt hat und somit auch einem hohen yield hat .der shrink auf 55mm haette die flaeche zwar verkleinert aber einen neuen Prozess erfordert der erst anlaufen muss und anfangs meist gar und gar nicht rundlaeuft .Die Verluste waeren also vermutlich noch hoher

Zuletzt bearbeitet:

Antimon

Commander

- Registriert

- Nov. 2007

- Beiträge

- 2.614

Unyu schrieb:Die 4870 X2 hat eine TDP von 240-250W, kein Vorteil durch Dual Die.

Es besteht grundsätzlich ein Vorteil von DualDie gegenüber dem SingleDie die Wärmelast wird verteilt, ich habe bei 2 GPUs 2 Spots mit je ~130 - 150W TDP anstelle eines großen Hotspots mit ~240W TDP und somit schonmal ganz andere Vorgaben um die Kühlung zu dimensionieren.

Es wird wohl fast keine fehlerfreien G200 geben. Aber zum Glück ist der Chip recht parallel aufgebaut. -> Kein Argument.

Je nach Zahl der Fehler im einzelnen Chip ist das sehr wohl n Argument, im Moment wird Gemunkelt, dass 1 Wafer 100 2x0 GTX Chips liefern kann, allerdings knappe 60% davon Ausschuss sind (hier kann man sich nun streiten was unter Ausschuss zu verstehen ist, da auf dieses nicht näher eingegangen wird, sprich Ausschuß im sinne von kein 280GTX dafür als 260 GTX verwertbar oder eben Ausschuss im Sinne von gar nicht verwendbar.) und solche Zahlen kann sich ein gewinnorientiertes Unternehmen auf längere Frist nicht erlauben (und Nvidia gehört zu der Sparte gewinnorientiertes Unternehmen ! )

Bleibt einzig der Verschnitt am Waferrand, da zwitschern meine Vögel von:

- 450mm Wafern in ein paar Jahren

- Einem Dieshrink nach 55nm

Der Dieshrink ist ja noch zu akzetpieren aber die 450mm Wafer sind im Moment noch graue Theorie und somit nicht wirklich als Argument zu sehen, wenn im Moment ca jedes halbe Jahr eine neue GPU in den Startlöchern steht, der GT200 wird mit sicherheit nicht mehr auf 450mm Wafern produziert werden.

Was ist wohl komplizierter?

Einen Chip zu verdoppeln (von einem kleinen Die zu einem großen Die) oder eine tolle Logik zu designen, um mehrere Dice effizient miteinander arbeiten zu lassen?

Dürfte vom Fertigungsverfahren des Chips bzw. dessen Aufbau und den Programmiermöglichkeiten abhängen, pauschal eher schlecht zu beantworten.

PS: Ich glaube nicht an das Mikroruckel Fix Design.

Warum? Damit ich meine Fans nicht entäusche.

Immerhin Einsicht ist der erste Weg der Besserung

Pantherfibel

Lt. Junior Grade

- Registriert

- Nov. 2007

- Beiträge

- 510

@BullRun:

Sollen wir dir jetzt für deine tollen Kontakte und Informationen gratulieren.

Hieß es nicht schon das die HD 3870 X2 kein Problem mehr mit Microrucklern haben sollte?

Ich würde es mir für AMD wünschen wenn sie das Problem gelöst haben.

MfG Pantherfibel

Sollen wir dir jetzt für deine tollen Kontakte und Informationen gratulieren.

Hieß es nicht schon das die HD 3870 X2 kein Problem mehr mit Microrucklern haben sollte?

Ich würde es mir für AMD wünschen wenn sie das Problem gelöst haben.

MfG Pantherfibel

BullRun

Lt. Junior Grade

- Registriert

- Aug. 2004

- Beiträge

- 406

@Pantherfibel

ja fuer diesen zufaelligen , gluecklichen aber leider voruebergehenden Kontakt koennte man sich gratulieren lassen....

Wollte hier mal ein paar Fakten zu den Mutmaßungen beisteuern und somit vielleicht jemanden helfen einen Fehler zu vermeiden..... waer ich nur still gewesen ... passiert nicht nochmal... ich will hier nicht aufn Putz hauen oder gar jemanden ueberzeugen nvidia zu kaufen... im Gegenteil,genau der Typ kauft mir dann vielleicht die letzte Karte weg .... je weniger Leute nvidia kaufen umso besser ist das fuer mich....

3870X2 von ASUS hatte auf jeden Fall mit Microrucklern zu kaempfen und teilweise so schlimm das ich die Karte nach 8 Wochen wieder gegen meine alte 8800gtx getauscht habe. Den Messwerten nach eine sehr schnelle Karte und vor allem fast die einzige mit 4 DVI Anschluessen .Sowas gibt normal nur an Profi Open GL CAD Karten die aber zu nichts anderem taugen. Das Filter- und Samplingverfahren bei ATI gefaellt mir optisch auch besser als das von nvidia und so dachte ich es kann nichts schiefgehen und ich wechsel mal wieder zu ATI.Aber die staendigen Mini-Ruckler sind nicht zu ertragen... wer richtig spielt und nicht nur bencht kriegt ne Macke.4870 kann dank des gleichen Aufbaus nicht viel anderst sein. Hab vor wenigen Wochen erst was bei THG gelesen das noch gar nicht richtig klar ist wo die Ruckler herruehren .... jetzt kann das Problem nicht schon geloest sein .

ja fuer diesen zufaelligen , gluecklichen aber leider voruebergehenden Kontakt koennte man sich gratulieren lassen....

Wollte hier mal ein paar Fakten zu den Mutmaßungen beisteuern und somit vielleicht jemanden helfen einen Fehler zu vermeiden..... waer ich nur still gewesen ... passiert nicht nochmal... ich will hier nicht aufn Putz hauen oder gar jemanden ueberzeugen nvidia zu kaufen... im Gegenteil,genau der Typ kauft mir dann vielleicht die letzte Karte weg .... je weniger Leute nvidia kaufen umso besser ist das fuer mich....

3870X2 von ASUS hatte auf jeden Fall mit Microrucklern zu kaempfen und teilweise so schlimm das ich die Karte nach 8 Wochen wieder gegen meine alte 8800gtx getauscht habe. Den Messwerten nach eine sehr schnelle Karte und vor allem fast die einzige mit 4 DVI Anschluessen .Sowas gibt normal nur an Profi Open GL CAD Karten die aber zu nichts anderem taugen. Das Filter- und Samplingverfahren bei ATI gefaellt mir optisch auch besser als das von nvidia und so dachte ich es kann nichts schiefgehen und ich wechsel mal wieder zu ATI.Aber die staendigen Mini-Ruckler sind nicht zu ertragen... wer richtig spielt und nicht nur bencht kriegt ne Macke.4870 kann dank des gleichen Aufbaus nicht viel anderst sein. Hab vor wenigen Wochen erst was bei THG gelesen das noch gar nicht richtig klar ist wo die Ruckler herruehren .... jetzt kann das Problem nicht schon geloest sein .

Zuletzt bearbeitet:

Vulture_Culture

Lt. Commander

- Registriert

- Jan. 2008

- Beiträge

- 1.307

ballert. Hoffe mal auf ne leistungskrone für ATi. natürlich erstmal auf die (heißersehnten) banches waten. Das mit der GDDR3 Version finde ich eine gute Idee. Da ist für jeden Geldbeutel dann was dabei

Unyu

Banned

- Registriert

- Okt. 2004

- Beiträge

- 6.891

Deshalb wird man erst mal gucken wie sich G92b verhält.BullRun schrieb:der shrink auf 55mm haette die flaeche zwar verkleinert aber einen neuen Prozess erfordert der erst anlaufen muss und anfangs meist gar und gar nicht rundlaeuft

Die 55nm sollten bald gut genug laufen, TSMC hat jetzt schon einige Zeit 55nm Wafer am Start.

Das G200b auch bald kommt wissen wir ja.

Natürlich.Antimon schrieb:Es besteht grundsätzlich ein Vorteil von DualDie gegenüber dem SingleDie die Wärmelast wird verteilt

Aber da muss man noch genauer werden, der Single Die hat den Vorteil groß zu sein.

Sein Nachfolger auch nicht.Antimon schrieb:GT200 wird mit sicherheit nicht mehr auf 450mm Wafern produziert werden.

Aber es zeigt wo die Reise hingeht: Die Die werden größer.

Guck dir mal die Die Größen der Vergangenheit an und vergleiche das mit aktuellen Die Größen:

Heute gibts vollwertige 334mm² auf einer 150€ Karte. Das wäre vor nicht all zu langer Zeit absolut undenkbar gewesen.

Ohne diese Angabe bringt das schonmal nichts.Antimon schrieb:(hier kann man sich nun streiten was unter Ausschuss zu verstehen ist, da auf dieses nicht näher eingegangen wird, sprich Ausschuß im sinne von kein 280GTX dafür als 260 GTX verwertbar oder eben Ausschuss im Sinne von gar nicht verwendbar.)

Bleibt die Zahl 130$ pro GPU im Raum stehen.

Bei 500$ für eine Karte nicht so das Problem.

Zuletzt bearbeitet:

M

MixMasterMike

Gast

Wenn BullRun seine GTX280 "saftig" übertakten will habe ich Angst das er damit einen Riss im Raumzeitkoninuum erzeugt :X

PS: ATI hat doch super Treiber, warum jammern da einige Leute rum? Weil sie vor 10 Jahren mit ner Rage 128Pro mal nen Absturz hatten oder wie ^^

PS: ATI hat doch super Treiber, warum jammern da einige Leute rum? Weil sie vor 10 Jahren mit ner Rage 128Pro mal nen Absturz hatten oder wie ^^

drago-museweni

Admiral Pro

- Registriert

- März 2004

- Beiträge

- 9.310

Na das währe doch mal was wenn das beseitigt würde,a ber so schlimm sind die Mikroruckler auch nicht gewesen, aber viele sind darauf rummgeritten als währe dann alles unspielbar ob es andauernd mit 20Frames Dahinnruckeld oder flüssig mit 35 dahinnläuft dann ist mir das mit mit Mikroruckler lieber.

Aber wenigtens hört dann das geheule über die bösen "Mikroruckler" auf das sollte das Unwort 2008 werden.

Aber wenigtens hört dann das geheule über die bösen "Mikroruckler" auf das sollte das Unwort 2008 werden.

Unyu

Banned

- Registriert

- Okt. 2004

- Beiträge

- 6.891

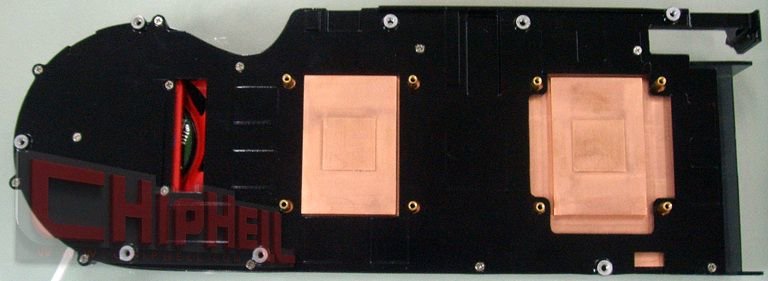

CB-News schrieb:dass die Kommunikation der beiden GPUs nicht über einen Bridge-Chip sondern den Grafikkartenspeicher stattfinden soll

Ich seh da die Ausparung für den Bridge Chip in der Mitte.

Hm?

Ähnliche Themen

- Antworten

- 89

- Aufrufe

- 11.617

- Antworten

- 54

- Aufrufe

- 11.913

- Antworten

- 56

- Aufrufe

- 8.939

- Antworten

- 4

- Aufrufe

- 1.581

- Antworten

- 8

- Aufrufe

- 2.236