Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News AMD Radeon RX 6800: Navi 21 XL auf über 2,5 GHz stabil übertaktet

- Ersteller SVΞN

- Erstellt am

- Zur News: AMD Radeon RX 6800: Navi 21 XL auf über 2,5 GHz stabil übertaktet

GERmaximus

Rear Admiral

- Registriert

- Sep. 2015

- Beiträge

- 5.452

Shoryuken94 schrieb:Aber wäre echt super, wenn AMD noch einiges an Luft für OC hätte.

Zumindest wenn die Ergebnisse auf der Folie noch Luft haben.

Wenn die 6900Xt an die Werte meiner alten 3090@2Ghz ran kommt (ich glaube es nicht) wäre das genial.

Wobei, evtl. bekommen wir auch ein gemischtes Ergenis, je nach Engine.

Muss da gerade an @.Sentinel. denken. (FP16 VS FP32)

FP16 = AMD

FP32 = Nvidia

wenn ich es so richtig verstanden habe!

[wege]mini

Banned

- Registriert

- Juli 2018

- Beiträge

- 8.357

Ichthys schrieb:Ich liebe es, wenn ihr so tun müsst, als wüsstet ihr nicht, wann das NDA endet.

Eigentlich ist es schon ein Verstoß gegen das NDA, wenn man vor dem Tage des Ablaufes über die Tatsache redet, dass man unter NDA steht.

btt:

schön, dass die Architektur das hält, was man beim Bauen erzielen wollte.

So ab 3Ghz wird das Ding immer noch schnell(er) sein. Leider dann erst mit 5nm und weniger.

mfg

karl_laschnikow

Lieutenant Pro

- Registriert

- Okt. 2010

- Beiträge

- 513

Also ich finde es richtig cool das der @Taxxor und @ZeroStrat durch deren Entwickelten Tool Einblicke auf den Ergebnissen vorab haben. Das muss doch schon eine kleine Belohnung sein wenn ihr durch eure Arbeit mehr wisst als die meisten anderen. Und das ihr uns da kleine Einblicke gibt ist noch besser. Vielen Dank

Nur jetzt überholt langsam ein neuer Hypetrain den alten. Ich hatte vorher auch nur geglaubt das AMD mit der 6800xt nur an der 3080 ankratzt. Jetzt sagt AMD selbst sie haben ja noch eine 6900 und wir wurden überrascht.

Doch jetzt kommt der neue Hypetrain und da bin ich doch vorsichtiger.

Aber ich lasse mich gerne positiv überraschen und das alles trifft für die neuen Radeons zu. Also das hohe Takt Potenzial.

Zum Thema RT bei der Xbox und die damit verbundenen Leistung der RX 6800 (xt)

Bei der Xbox kann eine CU vier Textur Operationen machen oder 4 Raytraycing Operationen.

So wie ich das ( aus Gerüchten) verstanden habe haben die Radeons pro CU zwei RT Kerne. ( klärt mich auf Falls dort mehr bekannt ist)

Wenn das stimmt wäre die RT Performance eh nicht vergleichbar.

Edit: Das mit den RT wird beim Beitrag #468 aufgeklärt. Danke

Nur jetzt überholt langsam ein neuer Hypetrain den alten. Ich hatte vorher auch nur geglaubt das AMD mit der 6800xt nur an der 3080 ankratzt. Jetzt sagt AMD selbst sie haben ja noch eine 6900 und wir wurden überrascht.

Doch jetzt kommt der neue Hypetrain und da bin ich doch vorsichtiger.

Aber ich lasse mich gerne positiv überraschen und das alles trifft für die neuen Radeons zu. Also das hohe Takt Potenzial.

Zum Thema RT bei der Xbox und die damit verbundenen Leistung der RX 6800 (xt)

Bei der Xbox kann eine CU vier Textur Operationen machen oder 4 Raytraycing Operationen.

So wie ich das ( aus Gerüchten) verstanden habe haben die Radeons pro CU zwei RT Kerne. ( klärt mich auf Falls dort mehr bekannt ist)

Wenn das stimmt wäre die RT Performance eh nicht vergleichbar.

Edit: Das mit den RT wird beim Beitrag #468 aufgeklärt. Danke

Zuletzt bearbeitet:

Endless Storm

Commander

- Registriert

- Dez. 2008

- Beiträge

- 2.158

Kauft euch ruhig alle die teuren Modelle, so hoffe ich noch drauf, eine <300€ Karte mein Eigen nennen zu können in ein paar Wochen... hoffentlich werden da keine Monate draus

So kann ich in aller Ruhe die Leistung von RDNA2 studieren und muss dann, wenn Karten <300€ kommen, keine Tests mehr lesen^^ Für mich sind die 50% mehr Leistung/Watt einfach ein zu krasser Unterschied um noch auf RDNA1 zu setzen...

Alternativ wäre noch eine 3060 oder 3050 was für meinen Geldbeutel, aber 300€ für 6GB VRam? Hmm...

Anders herum hoffe ich noch immer, dass sich die Preise von Vermeer beruhigen und zur Abwechslung a) verfügbar sind und b) [viel Wichtiger] unter die UVP klettern^^

So kann ich in aller Ruhe die Leistung von RDNA2 studieren und muss dann, wenn Karten <300€ kommen, keine Tests mehr lesen^^ Für mich sind die 50% mehr Leistung/Watt einfach ein zu krasser Unterschied um noch auf RDNA1 zu setzen...

Alternativ wäre noch eine 3060 oder 3050 was für meinen Geldbeutel, aber 300€ für 6GB VRam? Hmm...

Anders herum hoffe ich noch immer, dass sich die Preise von Vermeer beruhigen und zur Abwechslung a) verfügbar sind und b) [viel Wichtiger] unter die UVP klettern^^

- Registriert

- Aug. 2012

- Beiträge

- 7.496

Durchschnittlich sollen jeweils 2,1 (Full HD) bis 2,25 GHz (4K/UHD) angelegen haben.

Also diesmal lesen sich die Vorab-Infos der Radeons wirklich sehr, sehr gut.

Selbst wenn es nur ein wenig in die Richtung gehen wird, sind die Karten schon ein voller Erfolg in meinen Augen.

Tolle Basisleistung mit ordentlich bemessener Speichermenge. Endlich mal eine echte Alternative auch im Highend Gaming, von AMD.

Richtig schade, dass ich einen G-sync Monitor habe.

- Registriert

- Feb. 2012

- Beiträge

- 9.432

Endless Storm schrieb:Kauft euch ruhig alle die teuren Modelle, so hoffe ich noch drauf, eine <300€ Karte mein Eigen nennen zu können in ein paar Wochen... hoffentlich werden da keine Monate draus

Da brauchst du dir keine Hoffnung machen. Dieses Jahr wird es keine kleinen RDNA2 Karten mehr geben. Da es mit Leaks dazu auch recht ruhig ist, dürfte das noch einige Zeit dauern, bis wir hier was sehen. Die Mittelklasse RDNA2 Karten die als nächsten kommen werden auch eher Richtung 400-450€ gehen. Die ganz kleinen Karten werden wir ziemlich sicher erst in einigen Monaten sehen. Wenn AMD in etwa seinen Rythmus beibehält, dann sprechen wir eher von Ende Q1-Q2 2021. Aber ich drücke dir die Daumen, dass du nicht so lange warten musst.

- Registriert

- Mai 2011

- Beiträge

- 22.757

karl_laschnikow schrieb:Zum Thema RT bei der Xbox und die damit verbundenen Leistung der RX 6800 (xt)

Bei der Xbox kann eine CU vier Textur Operationen machen oder 4 Raytraycing Operationen.

So wie ich das ( aus Gerüchten) verstanden habe haben die Radeons pro CU zwei RT Kerne. ( klärt mich auf Falls dort mehr bekannt ist)

Wenn das stimmt wäre die RT Performance eh nicht vergleichbar.

Der Aufbau ist gleich, es ist je ein RT Accelerator pro CU bzw. zwei pro WGP ( enthält 2 CUs) und diese Einheit kann 4 RT Operationen ausführen.

Hier auch noch mal das Bild einer Dual-CU in der Xbox

Links sind die TMUs, die jetzt je eine Texture und eine Ray Accel Einheit enthalten, jede für sich kann 4 Operationen durchführen, aber es können nicht beide gleichzeitig arbeiten.

Zuletzt bearbeitet:

GerryB

Rear Admiral

- Registriert

- Sep. 2016

- Beiträge

- 5.157

Und INT net vergessen. Jo, die Engine entscheidet wieviel prozentual als INT+FP16+FP32 abgearbeitet wird.GERmaximus schrieb:Zumindest wenn die Ergebnisse auf der Folie noch Luft haben.

Wenn die 6900Xt an die Werte meiner alten 3090@2Ghz ran kommt (ich glaube es nicht) wäre das genial.

Wobei, evtl. bekommen wir auch ein gemischtes Ergenis, je nach Engine.

Muss da gerade an @.Sentinel. denken. (FP16 VS FP32)

FP16 = AMD

FP32 = Nvidia

wenn ich es so richtig verstanden habe!

Vorraussichtlich wird es wieder Studios geben, die weniger/mehr FP16 einsetzen, warum auch immer.

dito AC (Deine 3090 sollte auch von reichlich AC profitieren, wg. der mehr CU´s ggü. der 3080.)

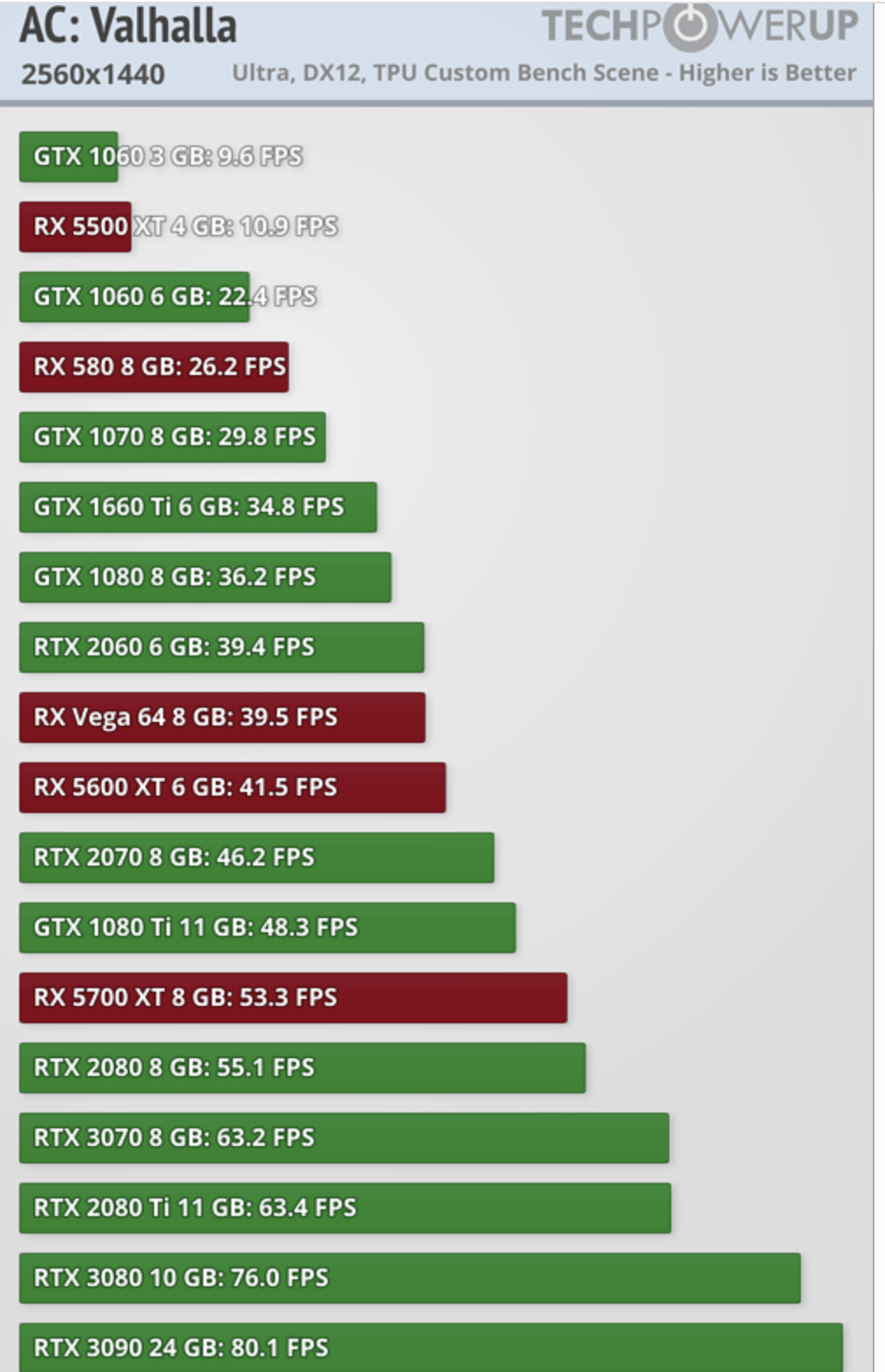

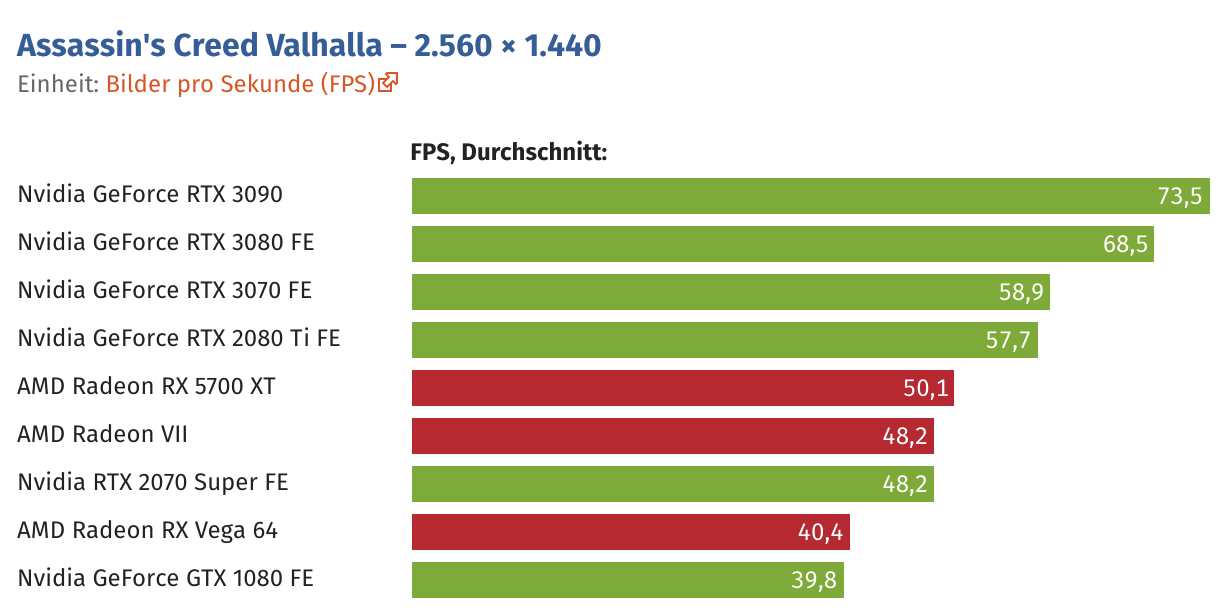

im Optimalfall kanns ganz schöne Überraschungen geben:

(weiss net, ob der Reviewtreiber schon anders ist in ACV)

edit: Weiss net ob OC3D z.Bsp. HDR@LPM(FP16) benutzt.

edit2: AOTS scheint stark am GPU-Takt zu hängen: deswegen 3090<3080?<<RX6800xt

" Deswegen ist vielleicht auch noch mal der Blick auf "2160p, crazy" interessant, wo die Radeon 6800 XT zulegt und 9.200 Punkte abliefert. Eine RTX 3080 liefert 8.800 Punkte, eine RTX 3090 8.700 Punkte und eine RTX 3070 6.800 Punkte. Daraus könnte man folgern, dass die Radeon zumindest in diesem Szenario weniger Leistung unter höheren Auflösungen verliert."

Radeon RX 6800 XT: Werte aus dem AOTS-Benchmark

Anhänge

Zuletzt bearbeitet:

F

foo_1337

Gast

Wie erklärst du dir dann das (5700XT vs 2080ti/3070) bei ACV im vergleich zu deinem Screenshot?

Zuletzt bearbeitet von einem Moderator:

Excel

Lieutenant

- Registriert

- Juli 2011

- Beiträge

- 798

Shoryuken94 schrieb:Ist aber sehr ungewöhnlich, dass in Full HD ein niedrigerer Takt anliegt. Ist eigentlich genau umgekehrt bei allen Karten, da UHD die Shader deutlich stärker auslastet. Da kann man nur spekulieren, was da nun dran ist...

Vermutlich liegt man in Full HD im Durchschnitt öfter im CPU Limit. Daher taktet die GPU hier niedriger.

GerryB

Rear Admiral

- Registriert

- Sep. 2016

- Beiträge

- 5.157

Benutz mal bitte die Möglichkeit für Anhänge.(man muss net den Thread so zupflastern)foo_1337 schrieb:Wie erklärst du dir dann das (5700XT vs 2080ti/3070) bei ACV im vergleich zu deinem Screenshot?

Wir wissen nicht Wo genau Steve gespielt hat und ob der Review-Treiber anders ist.

edit:

Zu WDL meinte Steve übrigens, das die 3090 net im CPU-Limit ist, evtl. demnächst an ner anderen Graka zu sehen.

(mal schauen, ob 5700 x2 drin ist)

Interessant finde ich in dem Zusammenhang die Ansicht von Wolfgang:Taxxor schrieb:Also ich kenne mittlerweile ne Zahl die bei der Ref 6800XT gemessen wurde.

Die genaue Zahl werd ich natürlich nicht sagen, aber ich denke wenn man die Messmethodik und den Abstand zur Karte beachtet, den CB verwendet, da bewegt man sich im Test schon Richtung Radeon VII.

"... im Gegensatz zu früheren Referenzdesigns – wie zuletzt bei der Radeon VII – nicht komplett ummantelt ist. Bei den Radeon RX 6000 sollte die erwärmte Abluft also mit weniger durch die Lüfter erzeugten Druck und damit leiser abtransportiert werden können." (-->weniger Drehzahl und andere Lü.blätter ähnlich F8?)

edit: Wird sicher auch interessant, Was sich AMD zum Airflow überlegt hat.

Anhänge

Zuletzt bearbeitet:

Vitec

Commodore

- Registriert

- Okt. 2006

- Beiträge

- 4.921

Kommt darauf an wie strikt das NDA aussieht.[wege]mini schrieb:Eigentlich ist es schon ein Verstoß gegen das NDA, wenn man vor dem Tage des Ablaufes über die Tatsache redet, dass man unter NDA steht.

HBM war böse gesprochen, das einzige was man bei Fury und Vega als inovativ sehen konnte. Aber geholfen hat es nicht. Trotzdem tut es vielen weh, wenn neue Gamingkarten diese "AMD-Innovation" fallen lassen.

HBM2 wird nur für Instinct-Karten verwendet. Weil es dort nicht so stark auf die Kosten ankommt und die Vorteile von HBM2 tatsächlich genutzt werden.

Warten wir doch die unabhängigen Benchmarks ab. Dann kann man sinnieren was zu tun ist.

Hier würde ich mich vor allem interessieren, wie die Navi 21 mit der Anzahl der CUs skaliert.

Wenn AMD der RTX 3090 wirklich zusetzen will, muss AMD für eine bessere Softwareunterstützung für ihre Karten durch Anwendungsoftware sorgen. Hier ist viel mehr (aufzu)holen als mit größerer Speicherbandbreite.

Wieso sollte AMD 2 Memoryinterfaces auf Navi 21 implementieren? Für 1 % der Karten?

Eine 2. Variante von Navi 21 mit HBM-Interface zu produzieren ergibt ebensowenig Sinn.

Es gibt in der nächsten Zeit keinen Chip über Navi 21.

Alleine schon die Tatsache, dass AMD in ihren High-End-Karten den GDDR6-VRAM mit 256-Bit anbindet, zeigt, dass es kein HBM2 für die Radeon-Grafikkarten geben wird.

Zu welchen Kosten?

Diese Gerüchte ergeben keinen Sinn. Wenn mehr Bandbreite etwas bringen würde, wäre es für AMD sinnvoller gewesen, die GDDR6-Anbindung breiter zu machen.

Die Frage ist, wie viele Chips AMD für die RX6900XT überhaupt bekommt. Alle CUs müssen gut sein und hohe Frequenzen gehen können. Es ist immer so, für die obersten % der Leistung, muss überproportional viel bezahlt werden

Man kann sich vieles ausmalen. Das ganze muss aber im Chip implementiert werden.

Die VRAM-Ausstattung von 16 GByte ist momentan kein Problem. Man hat momentan leider nur die beiden Optionen, 1- oder 2-GByte-GDDR6-Chips. Da jeder Chip mit 32 Bit angebunden wird, hat man mit 256-Bit Speicheranbindung nur die Wahl zwischen 8 oder 16 GByte VRAM.

Nvidia hat wie bekannt das Problem, dass aktuell nur 1-GByte-GDDR6X-Chips verfügbar sind.

HBM2 wird nur für Instinct-Karten verwendet. Weil es dort nicht so stark auf die Kosten ankommt und die Vorteile von HBM2 tatsächlich genutzt werden.

Warten wir doch die unabhängigen Benchmarks ab. Dann kann man sinnieren was zu tun ist.

Hier würde ich mich vor allem interessieren, wie die Navi 21 mit der Anzahl der CUs skaliert.

Wenn AMD der RTX 3090 wirklich zusetzen will, muss AMD für eine bessere Softwareunterstützung für ihre Karten durch Anwendungsoftware sorgen. Hier ist viel mehr (aufzu)holen als mit größerer Speicherbandbreite.

peru3232 schrieb:@ETI1120

um mich der Spekulatius auch noch anzuschließen:

ebenso steht ja noch das Gerücht im Raum, dass Navi 21 auch mit HBM könnte... auch das wäre noch durchaus eine Option der den Chip eine Klasse darüber heben kann - Infinity Cache hin oder her.

Wieso sollte AMD 2 Memoryinterfaces auf Navi 21 implementieren? Für 1 % der Karten?

Eine 2. Variante von Navi 21 mit HBM-Interface zu produzieren ergibt ebensowenig Sinn.

Es gibt in der nächsten Zeit keinen Chip über Navi 21.

Alleine schon die Tatsache, dass AMD in ihren High-End-Karten den GDDR6-VRAM mit 256-Bit anbindet, zeigt, dass es kein HBM2 für die Radeon-Grafikkarten geben wird.

Vitec schrieb:Wollte ich auch schreiben, dass auch Gerüchte kursieren, dass der max. Ausbau 6900XT mit nur 8 CU`s mehr, dann noch paar Prozent über HBM rausholen könnte.

Zu welchen Kosten?

Diese Gerüchte ergeben keinen Sinn. Wenn mehr Bandbreite etwas bringen würde, wäre es für AMD sinnvoller gewesen, die GDDR6-Anbindung breiter zu machen.

Die Frage ist, wie viele Chips AMD für die RX6900XT überhaupt bekommt. Alle CUs müssen gut sein und hohe Frequenzen gehen können. Es ist immer so, für die obersten % der Leistung, muss überproportional viel bezahlt werden

Vitec schrieb:Evtl. kann AMD dann den IF per Treiber den Shadern zuordnen, sodass diese dann den Cache als L4 für Rasterberrechnungen nutzen. Und dann wären mit HBM auch verschiedene VRAM Ausstattungen möglich, ne nach chips/stacks.

Man kann sich vieles ausmalen. Das ganze muss aber im Chip implementiert werden.

Die VRAM-Ausstattung von 16 GByte ist momentan kein Problem. Man hat momentan leider nur die beiden Optionen, 1- oder 2-GByte-GDDR6-Chips. Da jeder Chip mit 32 Bit angebunden wird, hat man mit 256-Bit Speicheranbindung nur die Wahl zwischen 8 oder 16 GByte VRAM.

Nvidia hat wie bekannt das Problem, dass aktuell nur 1-GByte-GDDR6X-Chips verfügbar sind.

Visionmaster

Cadet 4th Year

- Registriert

- Dez. 2017

- Beiträge

- 115

Der heutige Bildvergleich der Referenzkarten zeigt ja leider, dass die 6800 nen abgespeckten Kühler im Vergleich zur 6800XT hat - erstmal ein Minuspunkt für zu erwartende Lautstärke und OC-Potential. Und die offizielle Preisdifferenz ist ja nicht sooo hoch.

AlcAida

Lt. Junior Grade

- Registriert

- März 2009

- Beiträge

- 322

Maggolos schrieb:Anhang anzeigen 994067

igorsLABvor 1 Stunde

Nicht zu viel hineininterpretieren... oder doch? Wer weiß..

Quelle: (https://www.youtube.com/c/igorsLAB/community)https://www.youtube.com/channel/UC_ul0EiEc49bTtQ1GAoUylA)

Also sind die 6800/6800XT wohl doch über ihrem jeweiligen Nvidia-Pendant

Ohje die Karten paaren sich.

Freut mich das endlich wieder Konkurrenz und somit Wettbewerb einkehrt.

Schade das mein Vater damals keine 1000€ auf AMD setzen wollte und ich nicht konnte, den sterben lassen hätte niemand die Firma.

Vielleicht war es gut das Conduri etc. Gegangen sind und so frisches denken rein kam.

Hoffe das AMD diesmal alles direkt hinbekommt und es kein Treiber Debakel gibt damit endlich dieses AMD Treiber gebashe verschwindet....

Ähnliche Themen

- Antworten

- 93

- Aufrufe

- 30.762

- Antworten

- 515

- Aufrufe

- 75.041