Dai6oro

Admiral

- Registriert

- Okt. 2006

- Beiträge

- 9.880

Finde die 24GB von AMD wesentlich besser.notnitro schrieb:Finde die 12GB VRAM von nVidia schon sehr freundlich.

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.

Finde die 24GB von AMD wesentlich besser.notnitro schrieb:Finde die 12GB VRAM von nVidia schon sehr freundlich.

Und wie sind die Umstände jetzt?Dai6oro schrieb:Alle Hersteller haben dann bei weiteren Releases die UVP deutlich erhöht damit nicht nur die Händler den Gewinn einstreichen. Beispiel die 3080ti mit UVP weeeeeit über einer 3080. Das sind Beispiele die nicht für einen Vergleich taugen, weil die Umstände ganz andere waren.

DrFreaK666 schrieb:Für mich eher uninteressant.

Leider lassen 7700XT und 7800XT noch länger auf sich warten

Dass stimmt und was viele vergessen dort wird am meisten verkauft.Dai6oro schrieb:Man sieht ja auch das die Produkte zu viel kosten. Das mag im Enthusiastenlevel noch recht egal sein ob die 300€ mehr oder weniger kosten aber im Entrylevel schauen die Leute ganz genau auf den Preis.

Moritz Velten schrieb:Wieso leider?

Der Fortschritt ist nun mal nicht aufzuhalten.

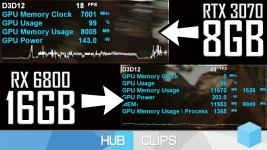

Mach den Test mal in 1080p ohne DLSS.Samuelz schrieb:Ich sehe ehrlich gesagt, überhaupt keine Probleme mit 8GB Karten weder in 1440p noch 4K.

hätte das freundlich vlt in " " setzen sollen.Dai6oro schrieb:Finde die 24GB von AMD wesentlich besser.

Das wäre in der Tat so. Aber, das sollte ja schon den Worst Case darstellen. 1080p wurde nochmal einige hundert MB einsparen, vermutlich so 500MB-1GB.Cerebral_Amoebe schrieb:Mach den Test mal in 1080p ohne DLSS.

Das wäre schließlich die Auflösung, für die die RX 7600 geeignet sein soll.

Das stimmt, Aber was ist der Entry Level ? FHD Ultra Preset? Oder Fhd hoch? Häufig ist es Mittlerweile, das das reduzieren der Auflösung nicht wirklich, viel mehr Performance beschert. Da auch in Fhd Leistung gefragt wird , von der Technik des Spieles.Dai6oro schrieb:aber im Entrylevel schauen die Leute ganz genau auf den Preis.

Mag sein. Ich habe kein Bock schon wieder die Games anzuschmeißen und das zu Posten. Kann ja auch jemand anderes machen, obwohl ich da kaum was erwarte, denn die meisten CB User halten an ihren VRAM "Wahnsinn" fest. Liefern aber selbst nie "Beweise"Cerebral_Amoebe schrieb:DLSS verringert doch auch den VRAM-Verbrauch, deswegen der Test ohne DLSS

Nur Frame Generation erhöht wieder den VRAM-Verbrauch, was ich mangels RTX4000 nicht testen kann.

Samuelz schrieb:Die ganze VRAM Diskussion wird von den Foren Usern total übertrieben dargestellt. Wahrscheinlich um seinen Frust über teure Preise auszudrücken. Ich sehe ehrlich gesagt, überhaupt keine Probleme mit 8GB Karten weder in 1440p noch 4K.

VRAM Verbrauch/Belegung @ 3080 Ti 12GB.

Last of Us, Ultra, Außer Schatten, 4K DLSS Q

7,7 Belegung, wirklich genutzt 7,3

Anhang anzeigen 1355974

God of War, Ultra, 4K, DLSS Q

7,2 Belegung, wirklich genutzt 5,7

Anhang anzeigen 1355975

Doom Eternal, Ultra, RT ON, 4K DLSS P

8,2GB, 7,8 wirklich genutzt

Anhang anzeigen 1355983

Dying Light 2 Max mit allen RT Optionen 4K, DLSS Q

6,8 GB Belegung, 6,3 tatsächlich genutzt

Anhang anzeigen 1355985

RDR2, Max paar Optionen auf High, DLAA 4K + diverse Mods

8,6 Belegung, 8GB wirklich genutzt

Anhang anzeigen 1355990

Dead Space Remake 2023 Max mit RTAO On, 4K, DLSS Q

8,1GB Belegung, 7,4 tatsächlich gebraucht

Anhang anzeigen 1355995

Miles Morales. Ultra mit RT Spiegelungen @ Ultra, reichtweite 7, 4K DLSS Q

10,3GB Belegung, tatsächlich gebraucht 9,9GB VRAM

Anhang anzeigen 1355997

Ist das so, ja ?Samuelz schrieb:Ich sehe ehrlich gesagt, überhaupt keine Probleme mit 8GB Karten weder in 1440p noch 4K.

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ist natürlich der aktuellste Patch. Ist so. Sry. Kannst ja gerne selber nachsehen.C0rteX schrieb:

Tja, da kann ich dir auch nicht helfen? Soll ich vlt. ein Video mit GeForce Experience aufnehmen? Oder schau es dir selbst an....Ich mach jetzt ein Video.C0rteX schrieb:Ich glaub dir kein Wort.🤣 Ich bin raus. Viel Glück noch mit deinen Lebenszielen. 😉

Ich glaub dir kein Wort.🤣 Ich bin raus. Viel Glück noch mit deinen Lebenszielen. 😉Samuelz schrieb:Ist natürlich der aktuellste Patch. Ist so. Sry. Kannst ja gerne selber nachsehen.

@gustlegga Sry, mit Hogwarts kann ich nicht dienen, das Spielt tangiert mich nicht.