AM4 – 4 Generationen für ein Halleluja

Als 2017 die ersten Ryzen Prozessoren – also Zen 1 – erschienen, war bereits klar, dass AMD den Sockel AM4 länger nutzen wird, ähnlich wie die Vorgänger AM2 und AM3. Auf vielen Boards von 2017 und 2018 laufen die aktuellen Ryzen 5000 Prozessoren. Für mich optimal, um meinen betagten PC von 2018 auf einen neuen Stand zu heben.Fangen wir jedoch von Anfang an und ich möchte euch damit zeigen, wie sich der Rechner in den 4 Jahren seit 2018 gewandelt hat. Die Ausgangsbasis des heutigen PCs ist ein Asus ROG Strix B450-E Mainboard auf dem damals ein Ryzen 2700X seinen Platz fand. Eine schöne Kombination, die anfangs von einem Noctua NH-D15 gekühlt wurde, der dann wegen einiger Umbauarbeiten durch einen Noctua NH-U12A ausgetauscht wurde. Etwas weniger Kühlleistung, gleichzeitig viel MEHR PLATZ! Als RAM wurden damals 32 GiB von G.Skill eingebaut, genauer die Aegis DDR4 3000 CL-16 Module, ein guter Kompromiss aus Leistung und Preis. Als Grafikkarte wurde eine Saphire Radeon RX Vega 64 Nitro+ ausgewählt, die konnte man damals nämlich günstig kaufen. Zur Speicherung von Daten wurde ein SSD-Unterbau aus Samsung 970 Pro 512 GB ausgewählt, dazu 2 SATA-SSD – eine Samsung 860 Evo und eine Crucial MX500 mit je einem TB. Damit besitzt das System 2,5 TB an Speicherplatz. Als Netzteil ist ein Seasonic Prime Ultra Titan 650 W verbaut gewesen. Damals ohne Frage ein schönes schnelles System, dass auch keine Wünsche offenließ, gleichzeitig aber auch schon mit 350 W bei der Grafikkarte kämpfen musste – daher schrecken mich die 350 – 400 W* jetzt nicht so ganz ab. Es fehlt als Information also nur noch das Gehäuse: ein Fractal Design Define R6 in Grau – oder für mich ein etwas helleres Schwarz. Als Gehäuselüfter kommen 3 Noctua NF-A14 zum Einsatz, und zwar im bekannten nougatbraun, ob ich hier das System mal auf Schwarz umstelle? Verdammt, jetzt ist der Wunsch geweckt!

Das System hat mir in dieser Form bis Mitte 2020 gute Dienste geleistet und ich habe im April 2020 eine 5700 XT – dieses mal eine XFX Radeon RX 5700 XT Thicc II – gekauft. Damals für unschlagbare 300,- € im Angebot, die Treiberprobleme** der 5700 XT waren zu diesem Zeitpunkt langsam Geschichte und es fühlte sich einfach richtig an, der Leistungsschub von 20 % war auch gerade richtig, bei VIEL weniger Verbrauch. Diese Iteration des Systems hat bis nun zum November 2022 bestand und in Vorbereitung auf eine neue Grafikkarte – und dem Wegfall eines Mördersytems, dass ich einem Freund geschenkt habe – wurde der 2700 X durch einen 5800X3D ersetzt, was die 5700 XT sogar leicht beflügelte. Um den Infinity Fabric Beine zu machen, wurde auch noch der RAM ausgetauscht und es werkelnjetzt 32 GiB Kingston FURY Beast DDR4 3600 CL-18 im System, sodass sich auch die Latenz leicht verbessert hat von 10,66 ns auf 10 ns. Nicht viel, aber immerhin etwas, auch wenn der 5800X3D nicht wirklich von der Latenz profitiert, so wirkt sich zumindest der IF-Takt positiv aus.

In der jetzigen Ausbaustufe – man könnte sie als Phase 4 bezeichnen – wird nun die ehrwürdige 5700 XT in den Ruhestand versetzt, auch diese Grafikkarte wird einem Freund zu gesendet, der nicht sehr viel hat. Die Nachfolgerin ist eine XFX Radeon RX 7900 XTX Merc 310 Black Edition. Natürlich ist der Umbau und die Erneuerung des Systems damit noch NICHT abgeschlossen, denn mein Ziel ist es am Ende wirklich ein neues System unter dem Schreibtisch stehen zu haben. Aber mit dem Geldbeutel vereinbar - ja die 1300 € für die XFX sind viel Geld gewesen, deswegen aber in Häppchen erneuert.

Es stehen also noch drei Erneuerungen an bis zum Sommer: Das Mainboard soll durch ein B550-Board getauscht werden, damit auch die Vorzüge von PCIe4 zur Geltung kommen. Die NVMe-SSD soll gegen ein PCIe4 Exemplar getauscht werden und auch ein neues Gehäuse steht an – mit mehr Luftzufuhr für die Grafikkarte und – ihr seid schuld daran – eben die Gehäuselüfter und vielleicht sogar der CPU-Lüfter, ich mag Schwarz!

Jetzt aber auch kurz zu den beiden Asterisk im Text, um ein paar Gedanken noch zu veranschaulichen:

* Ich weiß, dass ich mich sowohl bei der 4090 als auch der 3090 Ti negativ über den gesamten Stromverbrauch geäußert habe und es wirkt in diesem Moment auch etwas scheinheilig, dass ich jetzt eine 7900 XTX mit 350 – 400 W in meinem System einbaue. Ich nannte eine 3090 Ti und eine 4090 aber bereits mein Eigen, beide verschenkt an Freunde oder Studenten. Beide Karten habe ich auf 300 – 350 W limitiert und es zeigte sich bei beiden, dass für ca. 3 – 6 % Performance übermäßig viel mehr maximale Energie zugeschossen wurde und beide Karten OHNE Not entsprechend auf diesen Verbrauch geprügelt wurden. Die 4090 verliert ca. 7 – 10 % an Leistung, wenn man sie von 450 auf 300 W limitiert. Ich spiele zudem mit einem relativ starken FPS-Limit bei 72, sodass die meisten Spiele nicht wirklich darüber hinaus kommen – wobei ich überlege es auf 90 anzuheben, mal sehen.

** Die Treiberprobleme von RDNA sind mit einer Umstellung des Treibers von Wave64 auf Wave32 zu erklären. Mit RDNA wurden die 4 * Vec16 durch 2 * Vec32 ersetzt. Bis RDNA war der Treiber auf Wave64 ausgelegt. Solche Umbauten sind immer fehleranfällig. Auch dieses Mal hat AMD an den CU einiges umgebaut und ich werde im späteren Verlauf darauf eingehen.

Die Kontrahenten – die Überraschung gegen die Enttäuschung

Die 5700 XT – also Navi10 – war 2019 eine Überraschung, hat doch AMD damit gezeigt, dass sie noch nicht auf verlorenem Posten kämpfen und gute Grafikkarten – wir lassen mal die Treiberprobleme weg – designen können. Die 7900 XTX – Navi30 – ist hier dann schon eher eine kleine Enttäuschung, die Gerüchteküche brodelte ordentlich, was auch mich zu falschen Einschätzungen verleitet hat und auch die Folien waren – mindestens – stark durch eine rosarote Brille gefärbt. Alles eigentlich ein Grund, die Karte nicht zu kaufen. Warum habe ich die Karte dennoch gekauft? Weil ich das Konzept des Chiplet mag und ich die neuen CUs interessant finde und denke, dass AMD hier noch einiges machen kann.Ja, scheinbar hat 7900 XTX einen Hardwarebug beim Prefetching von Shadern – siehe dazu den Mesa3D-Code – gleichzeitig sind die Auswirkungen mit ca. 2 % nicht wirklich gravierend. Probleme mit der Leistungsaufnahme lassen sich in der Regel im Treiber und der Firmware beheben, da einfach gewisse Parameter falsch eingestellt sind, man wird hier auf die Treiber warten müssen. Dass RDNA3 schlechter abschneidet als erwartet, liegt primär an einem noch nicht ausgereiften Shadercompiler und damit auch am Treiber. Etwas, dass man aussitzen kann und es könnte spannend sein, die Karte über die Zeit auch zu beobachten – also wird dieser Artikel ein Mehrteiler, freut euch darauf.

Jetzt aber zu den beiden Chips, die sich in diesem Test dem Duell im Ring stellen:

| Bezeichnung | Navi10 | Navi30 |

|---|---|---|

| Transistoren | 10,3 Mrd. | 45,7 Mrd. + 12 Mrd. (57,7 Mrd) |

| Fertigung | N7 | N5 + N6 |

| WGP/CU | 20/40 | 48/96 |

| Shader | 2560 | 6144 (12288) |

| RT-Kerne | 0 | 96 |

| Matrix-Kerne | 0 | 192 |

| TMU | 160 | 384 |

| ROP | 64 | 192 |

| SI | 256 Bit | 384 Bit |

| Cache (L2 + L3) | 8 MiB + 0 | 6 MiB + 96 MiB |

| Takt | 1605 - 1905 MHz | 1900 - 2500 MHz |

Die Konkurrenz – 4090 oder 4080?

Bevor wir aber zu dem eigentlichen Test kommen, möchte ich kurz ein paar Kommentare aus der Community aufgreifen – nicht angreifen –, die meinen, dass Navi30 eigentlich die Konkurrenz zur 4090 ist und AMD nur aus Not die 4080 als Konkurrenz ausgewählt hat: Nein, das sehe ich an der Stelle ein Stück anders. Ich muss an der Stelle andeuten, dass die ursprünglichen Gerüchte diesen Schluss zu lassen, es ist allerdings anders gekommen. Navi30 bewegt sich von allen Eckdaten viel eher zwischen AD102 und AD103 und in bestimmten Spielen – nicht nur den CB-Test nehmen – kann Navi30 es mit AD102 aufnehmen, in anderen Spielen unterliegt man deutlich und auch AD103 kann schneller sein*.Sieht man sich aber die Daten aller drei GPUs an, dann fällt auf, dass Navi30 sich genau zwischen AD102 und AD103 bewegt. Entsprechend ist auch das Ziel, besser muss das Ziel von AMD sein, sich zwischen AD102 und AD103 zu platzieren, dieses Ziel hat AMD – in meinen Augen – aktuell nicht erreicht. Es ist also umso wichtiger, dass AMD wirklich am Treiber arbeitet und am Shader-Compiler.

| Bezeichnung | AD103 | Navi30 | AD102 |

|---|---|---|---|

| Transistoren | 45,9 Mrd. | 57,7 Mrd. | 76,3 Mrd. |

| Fertigung | 4N (optimierter N5) | N5 | 4N |

| CU/SM | 80 | 96 | 144 |

| Shader | 10240 | 6144 (12888)* | 18432 |

| RT-Kerne | 80 | 96 | 144 |

| Matrix | 320 | 192 | 576 |

| TMU | 320 | 384 | 576 |

| ROP | 112 | 192 | 192 |

| SI | 256 Bit | 384 Bit | 384 Bit |

| Cache (L2 + L3) | 64 MiB | 6 MiB + 96 MiB | 96 MiB |

| Takt | 2210 - 2505 MHz | 1900 - 2500 MHz | 2230 - 2520 MHz |

* AMD hat die CU stärker umgebaut, als ich anfangs angenommen habe und hier liegt auch das Problem. Ich habe in vielen Kommentaren die Auslastungsprobleme von Ampere/Ada gegenüber RDNA2 erläutert, ich gehe darauf im nächsten Abschnitt ein.

** Die Angabe von 12888 Shadern ist in diesem Fall die ehrlichere und man muss AMD hier sogar sagen, dass sie bei der Verdoppelung der Shader auf der einen Seite intelligenter vorgegangen sind als NVIDIA bei Ampere, gleichzeitig haben sie sich damit die Entwicklung des Shadercompilers komplizierter gemacht. Auch dazu im nächsten Abschnitt mehr.

Die neuen CU – Genialer Wahnsinn!

Warum sich Ampere von RDNA2 nicht wirklich absetzen konnte, obwohl sie fast doppelt so viele Shader hatte, ist relativ einfach erklärt: NVIDIA hat bei Ampere die Anzahl der Shader „nominell“ von 64 auf 128 erhöht – es waren bei Turing bereits 128. Es istallerdings so, dass nicht jeder dieser 128 Shader einfach ein Programm ausführt, sondern die 128 Shader werden als SIMD (Single Instruction, Multiple Data) organisiert. So etwas spart Schaltungen zur Kontrolle usw. Das bedeutet, dass immer eine gewisse Anzahl an Shadern die gleiche Operation auf verschiedene Werte ausführen müssen. NVIDIA nutzt für diese Verwaltung die Datenpfade in der SM und in Ampere und Ada gibt es zwei Datenpfade für 128 Shader, also jeder Datenpfad fasst 64 Werte und hier liegt der Knackpunkt: Ampere/Ada benötigen für eine optimale Auslastung 2 Tasks pro SM zu 64 Werten, damit die Rechenleistung auch auf die Straße gebracht werden kann. Die Menge an Werten pro Task wird bei einer GPU heute in der Regel von der Auflösung bestimmt und mit steigender Auflösung kommen pro Thread mehr Werte zusammen und Ampere und Ada können ihre Rechenleistung besser auf die Straße bringen.AMD – ich werde auf GCN nicht mehr eingehen – benötigt bei RDNA pro CU auch bereits 2 Threads/Task, jedoch nur 32 Werte, da in jeder CU zwei Vec32-Einheiten vorhanden sind. In modernen Engines sind Task/Shader nicht mehr so problematisch, da immer mehr Shader in einem Bild angewendet werde, dafür sind die Shader kleinteiliger und genau hier konnte RDNA1 und RDNA2 dann auftrumpfen: Die Auslastung der CU war besser als die Auslastung der SM bei NVIDIA.

Gleichzeitig zeigt sich bei einer CU ab 4K aber auch, dass ein Thread für Operationen tendenziell einen zweiten Takt benötigen, da mehr als zwei Wave32-Befehle benötigt werden. In 4K ist das noch nicht so gravierend, in höheren Auflösungen wird das aber immer wahrscheinlicher. Die Umstellung von Wave64 auf Wave32 war – bis einschließlich 4K – also 2019 eine gute Wahl, um das Auslastungsproblem von GCN zu beseitigen, gleichzeitig zeigt sich jetzt, dass es wieder notwendig sein kann auf Wave64 – bei Bedarf – umzustellen.

AMD bohrt – nicht wie NVIDIA – einfach die Vec32 zu Vec64-Einheiten auf – was auch möglich gewesen wäre – sondern geht einen anderen Weg, der eine gewisse Flexibilität ermöglicht: Sie fügen einen zweiten Vektor-Pfad in die Vec32 ein, so werden aus den Vec32 nun (vereinfacht) Vec32+32 Einheiten und AMD nähert sich hier ein Stück NVIDIA und Ampere/Ada an.

AMDs Lösung ermöglicht nun zwei Optionen – die NVIDIA bei Ampere und ADA nicht hat, dafür hat das NVIDIA-Design andere Vorteile*:

- AMD kann zwei Wave32-Befehle mit dem gleichen Operator auf einer Vec32+32 ausführen.

- AMD kann einen Wave64-Befehl innerhalb eines Taktes auf einer Vec32+32 ausführen.

AMD muss ihren Shader-Compiler innerhalb von 3 Generationen erneut umbauen und dieses Mal wird es knackig. Es ist nicht einfach nur eine Umstellung von Wave64 auf Wave32 – was schon zu einigen Problemen führte – sondern AMD muss dem Shadercompiler beibringen, dass er sowohl gleiche aber dennoch unabhängige Operatoren im Shader in zwei Wave32-Befehlen zusammen fasst. Oder, dass der Shader bei Bedarf entscheiden kann, statt einem Wave32-Befehl einen Wave64-Befehl zu nutzen. Möglich ist das – AMD hat Erfahrung mit VLIW-Architekturen, ich schreibe nur TeraScale – gleichzeitig ist das aber aufwendig und komplex.

Ein Beispiel, um euch die Möglichkeiten zu veranschaulichen:

Code:

A = B + C

D = A + E

F = G + HA = B + C als auch F = G + H können hier zusammengefasst werden, beide Zeilen sind voneinander nicht abhängig, haben aber den gleichen Operator. A = B + C kann aber nicht mit D = A + E zusammengefasst werden, es gibt in diesem Beispiel noch eine zweite Möglichkeit: D = A + E sowie F = G + H können zusammengefasst werden. Und hier liegt der Knackpunkt für AMD, der Shadercompiler muss mit der Zeit um verschiedene Analysetechniken – Flussanalyse wäre hier eine – erweitert werden, die entsprechende Operatoren-Paare im Shader finden. Das ist in dem Fall eine Möglichkeit.Die zweite Möglichkeit, die Vec32+32 besser auszulasten, liege im Treiber, denn dieser verwaltet die Tasks und Befehle und weiß in der Regel, welche Befehle über den verschiedenen Tasks an die GPU übermittelt werden. AMD hat hier also sehr viel Potenzial im Treiber und im Shadercompiler und anders als zu Vega-Zeiten ist dieses Mal das Potenzial auch wirklich vorhanden, denn die neuen Befehle für die Vec32+32 können genutzt werden und sind nicht Broken, denn die neuen Befehle werden schon beim RayTracing genutzt.

Zum Abschluss dieses Abschnittes wieder das Asterisk:

* NVIDIA organisiert ihre SM in 4 Tiles zu je 16 + 16 Shadern, NVIDIA ist es dadurch möglich nicht benötigte Shader einfach „ruhen“ zu lassen, so dass diese bei der Ausführung des Befehls nicht schalten müssen. Das bedeutet, wenn in einem Datenpfad statt 64 Werte nur 32 Werte zusammenkommen, dann müssen nur 2 der 4 Tiles arbeiten und die anderen Beiden „drehen Däumchen“. Das ist ein Vorteil, den AMD mit den Vec32+32 nicht so hat. AMD ist an dieser Stelle – ähnlich wie zu Zeiten zu Vega – also deutlich stärker davon abhängig, dass die Einheiten möglichst perfekt ausgelastet werden, damit die Karten effizient sind. Hier muss AMD dringend ran, dass sie nicht benötigte ALUs wirklich „trocken“ legen.

Merc 310 Black Edition gegen die Thicc 2

Ich will euch an dieser Stelle aber nicht länger auf die Folter spannen. Ich habe im groben beschrieben wie sich das System seit 2018 gewandelt hat. Wie Navi10 und Navi30 aussehen und wo sich Navi30 im Duell gegen AD102 und AD103 einordnet, jetzt kommen wir zu den harten Zahlen der realen Hardware und hier kann ich nur schreiben: BOAH! Ich habe das Paket von meinen Nachbarn abgeholt – der Postbote war mal wieder früher da, als erwartet – und hab ein ziemlich dickes Paket ausgehändigt bekommen und das Paket ist auch schwer! Leider fehlt mir eine Waage zum Vergleich – ich sollte mir aber mal eine Küchenwaage kaufen – allerdings: die Merc 310 ist schwer, laut Post wiegt das Paket 3,20 Kilogramm. Ein großer, fetter Klopper.

Vorweg, Fotos werden auf meinem Bett gemacht, das ist einfacher, als jetzt den Tisch freizuräumen, um da gute Bilder zu machen, ich habe kein professionelles Studio und mache solche Tests ja nicht regelmäßig.

Öffnet man den Karton, zieht man den schwarzen inneren Karton heraus und kann diesen aufklappen und was dann zum Vorschein kommt, ist erst mal der Hammer und es schwant einem schon: Hier wird ein Supportrahmen benötigt und dieser liegt auch bei. Die Karte kommt dann auf knapp 35 cm in der Länge, ist drei Slots dick – mit der Halterung, sonst sind es knapp 4 - und etwas höher als die üblichen Slots. Die Karte ist Respekt einflößend und die 5700 XT Thicc dagegen schon zierlich, auch wenn diese nicht gerade kurz war.

Mit dem Supportrahmen erinnert die Merc 310 an die Vega 64 Nitro+ von Sapphire und ist etwas einschüchternd, gleichzeitig wird aber klar, dass die Karte so vermutlich etwas ruhiger sein wird als die Thicc 2, die sich gerne mal bemerkbar gemacht hat. Ein neues Gehäuse muss in der nächsten Zeit auf jeden Fall her.

Egal von welcher Seite man nun ein Foto schießt, die Merc ist ein Monster im Vergleich zur Thicc, schade, dass ich die Nitro+ nicht mehr hier habe, das wäre spannend. Nun gut, sie ist nicht mehr da, also bleibe ich zumindest diesen Vergleich schuldig.

Das Duell – welche Spiele sind es geworden?

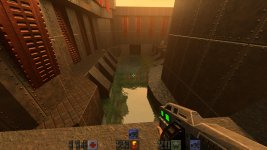

Kommen wir also zum eigentlichen Test und ich kann jetzt schon schreiben: Ich bin positiv überrascht – wobei ich vermutlich von einer 4080 oder gar 4090 noch positiver überrascht wäre. Direkt aber vor weg: Alle Tests wurden in 1440p ausgeführt, ja ich habe nur einen 27“ Monitor, dieser ist sehr gut und ich habe noch keinen Bedarf einen 4K-Monitor zu kaufen. Warum also diese Karte? Weil ich es will, ganz einfach. Ich spiele gerne immer wieder Klassiker und alte Spiele, allerdings auch neue und aus meinem aktuellen Katalog habe ich 11 Spiele ausgesucht und auf der 7900 XTX gibt es sogar ein Bonusspiel - wird nachgereicht.Folgende Spiele sind es geworden: BlackMesa, Cyberpunk, Tiny Tina, WarHammer 40k: Dark Tide, Diablo 2 Resurrected, Final Fantasy 14, Total War: WarHammer 3, Doom Eternal, Doom 2016, World of WarCraft, Metro Exodus (normal wegen der Vergleichbarkeit) und als Bonus auf der 7900 XTX Quake 2 RTX.

Ich habe jedes Spiel in drei verschiedenen Szenarien getestet: DevPandi, DevPandi No-Limit und Max-Out. Das DevPandi-Setting ist so ausgelegt, dass das Spiel FÜR mich sich angenehm auf meinem Monitor anfühlt. Gleichzeitig wird das Spiel auf maximal 72 FPS limitiert – bei einem 144 Hz Monitor für mich ein guter Kompromiss. No-Limit erklärt sich von selbst und Max-Out: Die ganzen Regler nach rechts, daher werde ich in diesem Test nur die Dev-Pandi-Settings genauer erläutern.

Für mich wichtig ist bei diesem Test auch, dass ich mir nicht eine beliebige Szene heraussuche, auch wenn sie fordernd ist, sondern dass ich eine reale Spielsituation nachstellen kann. Da sich Spiele jedoch nicht vorhersehbar verhalten, führe ich in jedem der Settings drei Durchläufe aus und mittel diese.

Wie angemerkt, ist für mich ein realistischer Test wichtiger als ein optimierter Test, der das theoretische Maximum oder Minimum an Leistung aufzeigt, daher laufen auch verschiedene Alltagsprogramme während des Tests, bei mir sind das folgende: Battle.net Client, BoxCryptor, HiDrive, Java Updater, Steam, TwinkleTray, Discord, Overwolf und GOG Galaxy. Manche dieser Programme werden bei den meisten von euch auch laufen und werden daher nicht deaktiviert, denn auch auf euren Systemen werden die Grafikkarten nicht in optimalen Umgebungen laufen.

Auf Bitte von @ComputerJunge schiebe ich an dieser Stelle noch kurz einen Benchmark mit Affinity Photo ein – die Benchmarks laufen mit Version 2.0.0: In

Nun zu den einzelnen Tests in den Spielen – noch anzumerken ist, dass ich bei Spielen, die in DevPandi keine 72 FPS erreichen, mir den No-Limit Durchlauf spare.

Cyberpunk

In Cyberpunk besteht der Benchmark-Lauf durch eine Fahrt durch Night City (Zentral) zu einem Apartment. Der Lauf dauert in der Regel 01:30, je nach Situation mit den NPCs können es auch einmal 02:30 werden.| Option | Wert |

|---|---|

| AMD FidelityFX Super Resolution 2.1 | Qualität |

| Sichtfeld | 100 |

| Filmkörnung | An |

| Chromatische Aberration | An |

| Schärfentiefe | An |

| Bledflecke | A |

| Kontaktschatten | An |

| Verbesserte Gesichtsbeleuchtungsgeometrie | An |

| Ansitropie | 16 |

| Lokale Schatten-Meshqualität | Hoch |

| Lokale Schattenqualität | Hoh |

| Entfernte Schatten Auflösung | Hoch |

| Volumetric Fog Auflösung | Hoch |

| Volumentische Wolkenqualität | Ultra |

| Maximale Dynamic Decals | Ultra |

| Qualität der Screen Space Reflections | Ultra |

| Volumenstreuung | Hoch |

| Umgebungsverdeckung | Mittel |

| Farbpräzision | Hoch |

| Spiegelqualität | Hoch |

| Detailgrad (LOD) | Hoch |

BlackMesa

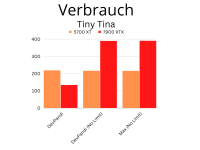

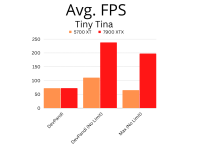

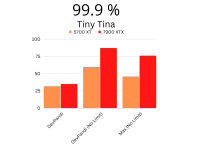

Die Einstellungen kann ich mir in diesem Spiel sparen, DevPandi ist bereits Max-Out, als Testszene dient der Reaktor-Unfall, da hier doch einiges los ist auf dem Bildschirm und es eine konstante Last erzeugt.TinyTina

In diesem Spiel wird dir Voreinstellung Hoch verwendet und die Anistrope Filterung auf 16 gestellt. In DevPandi kommt dazu noch AMD FSR2 mit Qualität zum Einsatz. Als Benchmark kommt ein Kampf in einem der Feldlager auf der Oberfläche zum Einsatz. Da hier sich die Umgebung ändern kann, werden eben in drei Lager die Kämpfe aufgenommen und gemittelt.Final Fantasy 14

Auch in diesem Spiel gilt: DevPandi ist bereits Max-Out, daher gibt es da nicht viel zu berichten zu den Einstellungen. Als Test-Sequenz wird eine Instanz als Druidin/Weißmagierin gespielt, und zwar eine der beiden Experten Instanzen. Jeder Abschnitt wird als eigener Lauf gewertet.World of WarCraft

Bei den Einstellungen ist es einfach: Das Spiel läuft im DevPandi-Setting in der Voreinstellung 5 ohne Anpassungen. Als Testlauf dient hier ein Drachenrennen, dass fordernd sein kann und auch Framedrops in manchen Situationen erzeugt.WarHammer 40K: DarkTide

DevPandi ist die Qualitätsvoreinstellung Mittel, zusammen mit FSR 2 in Qualität. Gespielt wird der Prolog.Diablo 2 Resurrected

Hier wird für DevPandi die Einstellung hoch gewählt und gespielt wird das erste Gebiet Hölle Akt 5.Total War: WarHammer 3

Für DevPandi gilt die Einstellung Hoch ohne weitere Anpassungen, es wird eine Schlacht gespielt. Der Ansturm erfolgt im Schnellvorlauf, dann wird gemetzelt für den Blutgott!Doom 2016

Nicht viel zu erklären: Alles auf Max, das schafft die 5700 XT, erste Mission vom Aufzug aus zur ersten Arena und gemetzelt.Doom Eternal

Auch nicht viel zu erklären: Ultra – oder Mittel, wenn es nach uns geht – erste Mission bis zur ersten Arena und auch hier gemetzelt.Metro Exodus

Einstellungen Ultra, das Intro mit der Fahrt über die Stadt bis einschließlich den ersten Kampf.Der Überblick

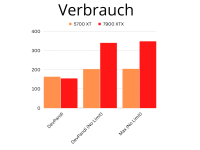

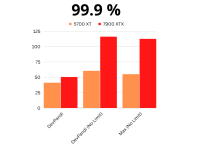

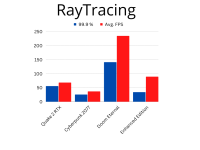

Wie in einem kleinen Teaser bereits angekündigt, ich bin von der 7900 XTX positiv überrascht, was meine Spiele angeht. Natürlich war es ein Stück weit zu erwarten. Gleichzeitig ist es dennoch erschreckend, wenn man eigentlich nur maximal 200 – 220 W bei der GPU gewohnt ist, plötzlich auch mal 400 W auf der Uhr zu haben. Ich muss aber zu geben, die 400 W – eigentlich sind es 390 – fühlen sich schon seltsam an, aber die Sapphire RX Vega64 Nitro hatte auch mal 350 W auf der Uhr. Da ich nach diesem Test wieder das FPS-Limit bei 72 ziehe und bei ausgewählten Spielen auch zu 90 verschiebe, komme ich unter dem Strich aber auf ähnlich, teilweise auch mal niedriger Werte als mit der 5700 XT. Bevor ich hier noch mehr Text fabriziere, hier einmal der erste Überblick:

In den bisher gespielten Einstellungen nähert sich die 7900 XTX den 72 FPS an, die 5700 XT erreichte in der Regel – gerade auch wegen Cyberpunk – nur 63,9 FPS im Mittel. Dabei verbraucht die 7900 XTX etwas weniger, nur 154 W gegen 163 W. Hier macht sich also primär gestiegene Rohleistung bemerkbar. Auch bei den 99.9 % FPS gibt es eine Verschiebung nach oben von 41 FPS auf 50,3 FPS. Die 7900 XTX ist also bei den AVG FPS im ganzen Test ca. 12 % schneller, bei den 99,9 % sind es 22 % und der Verbrauch fällt ca. 6 % geringer aus, nach dem Test auf Computerbase ist das für mich eine kleine aber auch positive Überraschung.

Nehmen wir das Limit heraus, dann genehmigt sich die 5700 XT ca. 40 Watt mehr und kommt auf 203 W, die Avg. FPS steigen auf 114,4 und die 99,9 % auf 60,5. Interessanter ist die 7900 XTX aber an dieser Stelle, denn die kommt bei den Avg. FPS auf 240,5, die 99,9 % auf 116 und der Verbrauch steigt auf 339 W an. Prozentual stehen 110 %, 92 % und 66 % auf der Uhr und auch an dieser Stelle hätte ich im ersten Moment schlimmeres erwartet in meinen Spielen, es ist ein netter Leistungssprung.

Sieht man sich dann noch Max-Out an, wird das Ganze noch interessanter, denn hier legt die 7900 XTX wirklich ordentlich zu und schafft zur 5700 XT fast immer die doppelten FPS, ohne dass der Stromverbrauch auch um das doppelte ansteigt. Hier ist aber die Betrachtung einzelner Spiele wesentlich interessanter. Für die Effizient ergibt sich in diesem Test aber auch kein „überragendes“ Bild im Mittel.Ich gehe nur auf Max-Out an dieser Stelle ein, steigt die Effizienz über alle Spiele nur um ca. 20 % an, wobei sich bei mir im FPS-Limit (DevPandi) auch mal 25 – 30 % ergeben, das hängt aber von den Spielen ab - es geht auch deutlich mehr.

Ich möchte im weiteren Verlauf jedoch nicht auf jedes Spiel eingehen – der Test ist schon sehr lang – sondern ich gehe auf bestimmte Spiele ein, die ich wirklich aktuell regelmäßig spiele und daher eine Bewertung auch am sinnvollsten ist.

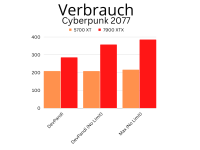

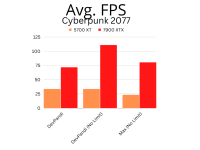

Cyberpunk 2077 – Hier wird es wirklich spannend

Ja, Cyberpunk 2077 ist jetzt seit zwei Jahren auf dem Markt, bald kommt allerdings das Addon und gerade in diesem Spiel gab es bei mir teilweise mit die deutlichsten Veränderung. Gleichzeitig läuft das Spiel bei mir auch relativ effizient mit der 7900 XTX.Im Setting DevPandi erreichte ich mit der 5700 XT ca. 33,6 fps im Mittel und für 99,9 % sind es gerade mal magere 20,4 fps bei 208 W. Die 7900 XTX liefert 71,6 und 49,3 fps bei 285 W, ich erhalte also zwischen 110 – 140 % mehr FPS – gerade die 99,9 % ziehen stark an – und der Strombedarf steigt nur um 37 %. Das ist beachtlich.

Tiny Tina – die Überraschung

Dass die Entwicklung mit „mehr FPS“ und „mehr Verbrauch“ auch anders ausgehen kann, zeigt in diesem Vergleich Tiny Tina. Hier schafft die die 5700 XT in meinen Einstellungen bisher zwar 72 fps im Mittel, gleichzeitig benötigt die 5700 XT dafür auch 202 W. Die 7900 XTX schafft im ganzen deutlich mehr FPS – im Max Out steigen die Avg. FPS von 64,9 auf 197,3 und am Ende reicht es in meinem limitierten Setting dazu, dass die 7900 XTX sogar ca. 70 Watt weniger benötigt, also ca. 30 % weniger! Eine positive Entwicklung. Ein ähnliches Verhalten konnte ich bei den DevPandi-Settings auch in WarHammer 40k: Dark Tide beobachten, ich gehe an dieser Stelle aber nicht gesondert darauf ein.

In den anderen Settings steigen die FPS wie erwartet an, gleichzeitig aber auch der Energiebedarf. Das Schöne an diesem Spiel ist aber, dass ich nun die Einstellungen höherstellen kann und im weiteren Verlauf dennoch etwas weniger Energie benötige bei einem 72 FPS-Limit. Anzumerken ist jedoch, dass die Frames in Tiny Tina, gerade ohne FSR, etwas unrund laufen, das Problem hatte ich auf der 5700 XT nicht.

Total War: WarHammer 3 – Bitte was?

Wir kommen zum letzten Spiel in der Detail-Auswertung, nämlich Total War: WarHammer 3 und hier muss ich sagen, hier bin ich wirklich überrascht, was da so zustande kommt, denn über alle Settings hinweg beobachte ich bei den 99.9 % Steigerungen von über 350 % - 12,7 fps auf 57,3 fps im DevPandi-Setting, dagegen sind die 90 % bei den Avg. Fps schon zu vernachlässigen. Nimmt man die Limitierung heraus, läuft die 7900 XTX sogar 750 % schneller bei den 99.9 % und auch bei den Avg. Fps beobachte ich eine Steigerung von gut 350 %, das ist heftig, der Verbrauch steigt am Ende dafür allerdings kräftig an in den beiden anderen Modi – ohne Limit und Max Out, aber hier trumpft das Spiel wirklich auf.

Das ist wirklich erstaunlich und entweder lag das Spiel RDNA nicht so wirklich oder RDNA3 besonders gut, denn solche Zuwächse hätte ich nicht erwartet!

Fazit und Ausblick

Über das Wochenende ist meine anfänglich trotzige Haltung zur 7900 XTX ein wenig der Begeisterung über diese Karte gewichen, besonders, wenn man die 5700 XT als Ausgangsbasis nimmt und man merkt, was da an Leistung dazu kommt. Es macht schon Spaß Cyberpunk nun mit maximalen Details zu spielen und auch die RT-Effekte hinzuzuschalten. Genauso ist es toll, wenn man in Dark Tide nicht mehr auf Mittel mit FSR mit Ach und Krach zwischen 30 – 60 fps hat, sondern man einfach in vielen Spielen die Effekte höherschrauben kann und doch 50 - 72 Frames bekommt. Toll!Gleichzeitig zeigen aber Spiele wie Cyberpunk 2077 auch, wie unvernünftig die 7900 XTX sein kann, denn 390 W bei der Merc 310 sind eine Hausnummer, die ich bereits bei der 3090 berechtigterweise kritisiert habe und die ich auch bei der 7900 XTX Merc 310 kritisieren muss. Man gewinnt zu 350 W einfach zu wenig hinzu, benötigt aber ca. 10 % mehr Energie. Und damit auch gleich vorweg: Dieser Test ist der erste Teil. Ich mache solche Tests nicht hauptberuflich und habe nicht die Zeit viele Tests auf einen Schlag zu machen. Es wird aber mindestens noch einen weiteren Test geben, der dann weniger Spiele umfasst, dafür genauer auf die einzelnen Spiele eingeht.

AMD macht mit RDNA3 in meinen Augen nicht viel falsch, leider tritt AMD aber mit der Karte in weiten Teilen auf der Stelle, da manche Neuerungen einfach noch nicht zünden. Auch – und das nehme ich AMD sowohl bei Zen 4 und nun auch RDNA 3 krumm – wird die Brechstange ausgepackt. Inwieweit das notwendig ist? Kann ich zum jetzigen Zeitpunkt noch nicht sagen, aber man merkt es an allen Ecken und Enden.

Genauso – und auch das muss man zugeben – ist der Treiber auch abseits des Shader-Compilers noch nicht fertig, denn so manche Einstellung wird nicht sauber übernommen. AMD muss also nicht nur am Compiler arbeiten, sondern allgemein am Treiber und so bleibt zu diesem Thema zu schreiben: AMD hätte hier noch mindestens ein paar Wochen, besser vielleicht sogar 2 – 3 Monate sich Zeit nehmen müssen.

AMD ist mit der 7900 XTX und XT zu früh auf den Markt gekommen und sie standen vermutlich unter Zugzwang durch NVIDIA. Manchmal sollte man sich nicht unter Zugzwang setzen lassen, denn die schlechte Presse, die teilweise dann auch zu Recht folgt, bleibt in den Köpfen der Anwender hängen. So kann man nur schreiben: Selbst schuld, AMD!

Positiv hervorzuheben ist an dieser Stelle, dass es während des Tests aber zu keinen Abstürzen, BlackScreens und andere Unschönheiten gekommen ist, was wiederum dafür spricht, dass der Shader-Compiler nicht massiv umgebaut wurde und die Anpassungen für RDNA1 und RDNA2 als Fallback vorhanden sind.

-- Erweiterung des Tests 28.12.2022 --

Effizienz - Zwischen Erwartungen und Realität

Es kommt, wie es kommen muss: Ich gehe noch mal gesondert auf die Effizienz der 7900 XTX im Vergleich zur 5700 XT ein. Ebenso bereite ich einen weiteren Test vor. Aber zuerst:50 % + 50 % sind keine 100 % - sondern etwas mehr

AMD versprach von RDNA zu RDNA2 die Effizienz um 50 % zu heben und auch jetzt wurde versprochen, dass man ca. 50 % Effizienz anpeilt - und angeblich erreichte man 54 %. Nur wie das mit der Effizienz so ist, es kommt auf die Ausgangsbasis an und auch auf andere Einstellungen. Daher müssen wir in diesem Abschnitt erst mal mit ein paar Sachen aufräumen: Eine GPU - auch CPU - benötigen eine gewisse Mindestspannung (V), damit die Transistoren schalten können. Viele "Schlafmodi" moderner GPUs und CPUs reduzieren nicht nur den Takt, sondern deaktivieren ganze Gruppen an Schaltungen, damit man Strom(stärke) (A) spart. (Entschuldigt die allgemeine Ausdrucksweise, das ist hier einfacher.) Das heißt, dass eine gewisse mindeste Last immer anliegt, auch wenn diese nicht ausgeschöpft wird. In solchen Fällen liegt dann Leistung wirklich brach, die genutzt werden könnte.Sobald Spiele gestartet werden, müssen immer mehr Teile aus diesen Schlafmodi zurückgeholt werden und entsprechend steigt auch der Bedarf an Strom an. Eine GPU hat also einen Grundbedarf an Spannung und Strom. Es kann also sein, dass gerade in niedrigen FPS-Limits (wie eben 72 FPS) die neue GPU überhaupt nicht effizienter sein kann, weil einfach eine entsprechende Grundlast erzeugt wird. Ich habe - ohne direkte Testläufe - deswegen in Final Fantasy 14 die Probe gemacht: Im 72 FPS-Limit ist die 7900 XTX weniger effizient mit 0,53 fps/Watt als die 5700 XT mit 0,59 fps/Watt (die 5700 XT ist 11 % effizienter). Testweise habe ich das FPS-Limit auf 90 FPS angehoben, der Verbrauch der 7900 XTX lag weiterhin bei 136 Watt (gemittelt) und die fps/Watt heben sich auf 0,66 fps/Watt an, jetzt ist sie 11 % effizienter. Die 11 % sind jedoch MEILENWEIT entfernt von AMDs Versprechen, denn theoretisch müsste die Effizient bei ca. 125 % liegen oder in diesem Beispiel:

0,59 * 1,5 * 1,5 = 1,32 fps/Watt oder anders ausgedrückt die 7900 XTX dürfte maximal 68 Watt verbrauchen.Daher gehe ich an dieser Stelle auch noch auf die drei ausgesuchten Spiele für die Detailbetrachtung ein.

Cyberpunkt 2077 - Ein Auf und Ab

Cyberpunk ist in diesem Fall ein schönes Beispiel, was man erwarten kann. Im 72fps-Limit steigt der Verbrauch von 208 W auf 285 W - 37 % an - gleichzeitig aber auch die fps von 33,6 auf 71,6 (113 %). Die 5700 XT erreichte also 0,16 fps/Watt, die neue 7900 XTX 0,25 fps/Watt - die 7900 XTX ist also 59 % effizienter - immer noch weit weg von den theoretischen 125 %.Nimmt man nun das Limit heraus oder wählt die maximalen Einstellungen, dreht sich das Bild bei der Effizienz zugunsten der 7900 XTX. Die 5700 XT erreicht 0,16 fps/Watt, die 7900 XTX 0,31 fps/Watt und ist damit 93 % effizienter, bei maximalen Einstellungen sind es 0,11 fps/Watt zu 0,21 fps/Watt - 90 %. Wir erreichen hier also fast die doppelte Effizienz, was ein guter Schritt zwischen zwei Generationen ist.

Tiny Tina - Irgendwo dazwischen

Kommen wir zu Tiny Tina - ich mag sie seit Borderlands 2. Manchmal bin ich auch so drauf und will alles in die Luft sprengen. Sind wir nicht alle ein wenig Tina? (Haha, Bluna Werbung!). Hier ist das Bild ähnlich wie bei Cyberpunk und doch ist die Situation anders. Im limitierten Setting liegen beide Karten gleich auf - 72 fps - es stehen aber einmal 202 W und einmal nur 137 W auf der Uhr - 33 % weniger Energie - und die Effizienz steigt entsprechend an: 0,35 fps/Watt zu 0,52 fps/Watt (48 %). In diesem Spiel zeigt sich ein etwas andere Bild. Nimmt man das FPS-Limit heraus, kommt die 5700 XT au 0,51 fps/Watt, die 7900 XTX auf 0,61 und ist nur 20 % effizienter. Erst wenn man die Einstellungen maximiert, steigt die Effizienz wieder an: 0,30 fps/Watt zu 0,51 fps/Watt, was in 70 % resultiert.Total War: WarHammer 3 - Pandis Augen werden immer größer.

Die Überraschung bei der Effizienz ist - wie zu vor schon - Total War: WarHammer 3 und das ist kein Scherz. Um eines vorwegzunehmen: Bisher und auch jetzt wird für die Effizienzbetrachtung die durchschnittlichen fps herangezogen, hier gehe ich aber auch auf die 99.9 % - fps ein, denn hier wird es regelrecht Paradox!Zuerst die Effizienzwerte für die durchschnittlichen fps: 0,21 fps/Watt gegen 0,38 fps/Watt resultieren in 80 % beim limitierten Setting. Nimmt man die Limitierung heraus, stehen 0,21 fps/Watt gegen 0,46 fps/Watt und die 7900 XTX ist nun 119 % effizienter - nahe am theoretischen Maximum. Die maximalen Einstellungen sind mit 0,19 fps/Watt zu 0,38 fps/Watt und einer Steigerung um 100 % bei der Effizienz gerade zu harmlos.

Gehen wir aber mal auf die 99.9 % fps ein - und nun das Extrem. Hier habe ich 0,07 fps/Watt mit der 5700 XT und die 7900 XT kommt auf 0,31 fps/Watt, das sind überragende 342 %, die die 7900 XTX effizienter arbeitet.

Am Ende entscheidet das Szenario

AMD hat dieses Jahr in ihren Folien oft die Wörter "up to" verwendet, was so viel bedeutet wie "bis zu". Mancher in der Community haben das bereits als schlechtes Omen gewertet und damit hatten sie - in diesem speziellen Fall auch recht - bei Zen 4 hat es sich ja etwas anders verhalten.Allgemein sind Angaben, egal ob mit "up to" oder gemittelt, mit einer gewissen Portion Vorsicht zu genießen und noch wichtiger ist, dass sich die Leser klar werden, dass die realen Ergebnisse um diese Werte streuen können. Ich habe in diesem Test absichtlich so einige Begleiter laufen lassen und auch 3 Testdurchläufe durchgeführt und die Werte gemittelt, weil sich jeder Lauf anders verhalten kann. Und so ist das auch mit der Effizienz und den Spielen.

Ich habe es bereits mit FF XIV angedeutet, dass der Verbrauch zwischen 72 fps und 90 fps nicht ansteigt, aber aus 11 % weniger Effizienz dann doch 11 % mehr werden können. Auch in Cyberpunk beobachte ich, dass das Spiel im Limit zwar effizienter wird, aber erst ohne Limit nähert man sich den 100 % an. Das ist auch verständlich und ich habe es eingangs erwähnt. Eine GPU benötigt, um zu schalten, eine gewisse Grundspannung, Bauteilgruppen lassen sich nur in Gruppen abschalten und nicht so fein, wie es manchmal notwendig wäre. Solche Faktoren spielen in die Effizienz mit rein und man merkt an dieser Stelle, dass gewisse Lasten einen gewissen minimalen Bedarf haben.

Die fps/W Werte sind im Anhang angefügt.

Temparaturen und der Hotspot

Da hier eine XFX Radeon RX 7900 XTX Merc310 Black Edition arbeitet, kann in diesem Test keine allgemeingültige Aussage zu Problemen des Referenz-Designs von AMD abgeben werden. Die Merc 310 - siehe auch Computerbase-Test - hält die GPU in einem Fractal Define R6 auf relativ kühlen 62 °C, während der Hotspot sich zwischen 76 °C und 82 °C bewegt. Die 5700 XT davor wurde wärmer und zeigte auch mal 90 °C an.110 °C als Hotspot konnte nicht gemessen werden und hier scheint ein Problem bei manchen Referenz-Designs zu herrschen. Mögliche Ursachen sind bereits vielfältig benannt, darunter auch geringe Abweichungen in der Höhe der Chiplets. Am Ende sollte sich allerdings jeder bewusst sein: Bei solchen Bauteilen kann man immer das Pech haben und ein Montagsmodell bekommen. Ich hatte auch schon Grafikkarten - egal ob NVIDIA oder AMD - die teilweise ungewöhnliches Verhalten an den Tag legten oder erst gar nicht starten wollten. Solche Sachen sind unschön, aber in diesem Fall ist mein Ratschlag relativ simpel: Schickt die Karte zurück oder lasst sie austauschen. Ihr müsst nicht mit einem schlechten Produkt euch zufriedengeben.

-- Erweiterung des Tests 30.12.2022 --

Ein kurzes Intermezzo – Wie teuer ist eigentlich RDNA 3

Bevor wir uns den Ergebnissen der 7900 XTX in RT widmen, will ich aber erst einmal auf die möglichen Kosten einer 7900 XTX eingehen, besser des Chips. Natürlich kann ich die genauen Preise für Wafer von AMD und NVIDIA nicht kennen, daher sind die hier genannten Zahlen eher am oberen Ende verortet und nur eine grobe Orientierung.Kommen wir zuerst zu den groben Zahlen – und in diesem Fall werden Dollar-Zahlen genommen, damit die Vergleichbarkeit gewahrt bleibt, denn der Wechselkurs kann hier die Bilder verfälschen: Ein 300 mm Wafer in der 5 nm - Klasse (N5, N4, 4N) kostet ca. 17.000 $, in der 7 nm - Klasse (N7, N6) werden 9.000 $ angesetzt. Natürlich unterliegen jetzt alle weiteren Zahlen gewissen Rundungsfehlern und sollten nicht zu ernstgenommen werden und dienen nur der Orientierung.

Für die weitere Einschätzung benötigen wir noch die Größe des GCD und der MCD: 306 mm² und 37 mm². Es gibt jetzt ein paar Wege, wie man an die maximalen Chips pro Wafer herankommt – das ganze habe ich einmal grob in einem Thema berechnet – oder man nutzt entsprechende Werkzeuge.

Bei dem GCD komme ich so auf ca. 185 Chips pro Wafer, bei einer Yield-Rate von ca. 90 % (die Zahlen schwanken bei den fatalen Fehlern zwischen 8 – 12 %) kommen so am Ende 166 Chips heraus. Bei 17.000 $ pro Wafer kostet das GCD 103 $. Beim MCD kommt man pro Wafer auf ca. 1650 Chips, mit den üblichen Yields sind das 1485 und damit – 9.000 $ - 6,10 $. Für Trägermaterial und Zusammenbau veranschlage ich pauschal 20 $ und komme auf 160 $. Für die 7900 XT sinken die Kosten um 12,20 $ und man landet bei 147,80 $.

Bei einer UVP von 999 $ für die 7900 XTX entfallen damit 16 % auf den Chip, bei der 7900 XT sind es etwas Höhere 16,5 %. Diese Zahlen sind ohne weiteren Kontext aber nicht so Aussagekräftig, wir müssen uns noch NVIDIA ansehen. AD102 ist 608 mm² groß und AD103 379 mm². NVIDIA bekommt auf einem Wafer ca. 91 Chips unter, davon sind 82 in der Regel funktionsfähig und ein Chip kostet NVIDIA 208 $. AD103 sind ca. 147 Chips auf dem Wafer, 132 kommen heraus und man landet 128 $. Die Relationen zu den UVPs: 13 % und 10 %.

AMD lässt an dieser Stelle ohne Frage „Marge“ liegen, gleichzeitig liegt AMD aber auch bei den Kosten genau zwischen AD102 und AD103. Zu bedenken ist, dass ich mit den 20 $ für den Zusammenbau sehr hochgreife, der Preisfaktor liegt hier vermutlich zwischen 140 – 160 $ und damit bei 14 – 16 % des UVP.

In der Community gibt es natürlich ein paar Stimmen, die schreiben, dass AMD mit dem Chiplet-Design nicht günstiger produziert, andere behaupten genau das Gegenteil. Beide Seiten haben sowohl recht als auch unrecht, denn es kommt auf die Rechenweise an und welche Daten man zugrunde legt.

Die Chipgröße für einen monolithischen Navi31 schwankt zwischen 384 mm² (unrealistisch, da der Cache als auch der Memory-Controller nicht so eng gepackt werden können) bis hinzu 476 mm² (realistischer). Navi31 würde damit ca. 165 $ kosten. Nimmt man die niedrigsten Produktionskosten von 140 $ an, spart AMD 18 %, bei den teuersten Kosten sind es nur 3 %, für die 7900 XT ändert sich das Bild aber, weil hier im günstigsten Fall 130 $ anstehen, im teuersten 150 $, hier also 26 % im besten Fall und 10 % im ungünstigsten Fall.

Es gibt hier aber auch andere Faktoren, die eine Rolle spielen können, so kann AMD auch weiterhin bereits bestellte N6/N7-Wafer abnehmen, ohne Vertragsstrafen zu zahlen. All das sind Faktoren, die wir nicht kennen. Wichtig ist aber, dass wir hier von großen Mengen sprechen, sodass hier auch Skaleneffekte auftreten und wir reden bei 1000 Einheiten schon von 5000 $, die AMD einspart. Zudem sollte man bedenkt: Diese Zahlen sind nur Annäherungen.

Jetzt kommen wir zu einem – für uns Spieler – unschönen Abschnitt und auch ich hatte ja die Hoffnung, dass AMD und NVIDIA einfach nur ihre Margen hochschrauben wollten, deswegen habe ich auch noch GP102 mir angesehen – GeForce GTX 1080 Ti. Für 10nm Wafer werden ca. 6000 $ genannt und der GP102 hatte damals 471 mm². NVIDIA zog damals ca. 117 Chips, davon 105 funktionierend, aus jedem Wafer und ein Chip kostete damit 58 $, nehmen wir die UVP von 699 $, machte der Chip davon gerade einmal 8 % aus. Sind die 1599 $ für die RTX 4090 viel Geld? Keine Frage, aber wenn man realisiert, dass AD102 heute ca. 13 % der UVP ausmacht, dann hat hier NVIDIA die Kostensteigerungen von N5 zum Teil auf die eigene Kappe genommen. Auch bei AD103 nimmt man ein Teil der Kosten auf die eigene Kappe, so wie es auch AMD tut.

An dieser Stelle sollte man vielleicht auch mal einen Blick auf TSMC werfen, die seit Jahrzehnten Gewinnmargen von 40 % – 50 % einfahren und auch entsprechende Dividenden an die Aktionäre ausschütten. Ob TSMC diese Marge für Investitionen benötigt, darüber kann man dabei wunderschön streiten, am Ende ist es aber die Buchhaltung, die Kosten für Investitionen über Jahre vom Umsatz abzieht.

Warum dieser Abschnitt? Weil ich es an dieser Stelle machen wollte, denn mir brennt die Frage nach den hohen Grafikkartenpreisen auch etwas auf der Seele, auch wenn ich hier die 7900 XTX gekauft habe. Schande über das Haupt von Pandi. Gehen wir auf das Thema RT ein:

Ray Tracing, der alte neue heiße Scheiß

Zuerst möchte ich an dieser Stelle ein wenig auf Ray Tracing eingehen – ohne Bilder oder Diagramme, ich versuche mich kurzzufassen – ob ich das schaffe?Ray Tracing – grob umrissen – beschreibt eine mögliche Form der Bildsynthese, die andere Form kennen wir heute als Rasterisation, der Standard, der sich in den 90er bei Computerspielen durchgesetzt hat. Beide Verfahren unterscheiden sich in ihrer Ausführung, gleichzeitig haben sie aber eine Gemeinsamkeit: Die Kamera, die eine gewisse Auflösung hat, danach unterscheiden sich aber die Verfahren grundlegend.

Bei der Rasterisation ist die Kamer ein Pixelraster und Polygone werden mit anhand ihrer Koordinaten von X und Y ermittelt. Dann wird der Farbwert ermittelt und im Bild gespeichert. Bei vielen Polygonen kann es dabei schnell unübersichtlich werden und bei Objekten im 3d-Raum wäre es ein Kuddelmuddel, weswegen es den Z-Buffer gibt, der dabei hilft zu ermitteln, welches Polygone denn diesen Kampf gewinnt. Früher wurden daher auch oft alle Polygone im Bild gerastert, selbst wenn diese eigentlich nicht sichtbar sind, ein Umstand den sich Power VR damals mit der Kyro annahm und einen Tiled-Based-Renderer entwickelte, ein Bild in kleine Kacheln zerlegte. Diese Form der Grafiksynthese ist schnell und effizient und sorgte auch für den Durchbruch der 3d-Grafik.

Ein Ray Tracer arbeitet anders. Hier wird kein Raster über eine Szene gelegt und einfach anhand der Koordinaten bestimmt ob da etwas sein müsste, sondern für jeden Bildpunkt der Kamera wird ein oder mehrere Strahlen ausgesendet und geprüft, ob diese im Raum auf ein Objekt treffen. Ist das der Fall, wird der Strahl geschluckt und wird „zurück“ geworfen mit den entsprechenden Farbwerten für diesen Bildpunkt.

Ray Tracing ist dabei nicht gleich Ray Tracing. Allen Ray Tracern gemein ist, dass sie mit Strahlen arbeiten – deswegen kann man frühe 3d-Engines wie Wolfenstein 3D,

Um Schatten und Beleuchtung zu berechnen, müssen weitere Strahlen abgesetzt werden, dieses Mal aber nicht von der Kamera aus, sondern von dem Punkt aus, an dem unser Strahl der Kamer auftritt. Um Schatten zu berechnen, muss man von der Stelle einen Strahl absetzen, der zur nächsten Lichtquelle geht. Trifft dieser Strahl auf dem Weg zur Lichtquelle auf ein Objekt – wird also blockiert – weiß man, dass hier ein Schatten vorliegt und entsprechend kann man diese Stelle abdunkeln. Es kann nun dank der Schattenstrahlen direkte Lichtquellen und eben Schatten berechnet werden.

Wir haben also jetzt den direkten Strahl der Kamera und einen Licht- bzw. Schattenstrahl und damit einen primären und sekundären Strahl. In einem nächsten Schritt kann von der Stelle, in der unser Strahl verschluckt wurde, noch einen weiteren Primärstrahl abgesetzt werden, sofern eine Oberfläche als „Spiegelnd“ deklariert wird. Wir berechnen jetzt Reflexionen. Physikalisch nach dem Eintritt ist gleich Austritt, sucht dieser Strahl ein Objekt. Ist ein Objekt gefunden, folgt von dort ein neuer Sekundärstrahl zur Lichtquelle und vielleicht ein neuer Primärstrahl. Das Absenden von weiteren Primärstrahlen nennt man auch Rekursives Ray Tracing. Wir haben jetzt einen Ray Tracer, der bereits direkte Beleuchtung und Reflexionen berechnen kann und ihr ahnt wohl, worauf es hinausläuft: Je mehr Effekte man umsetzten will, umso mehr primäre und sekundäre Strahlen werden benötigt.

Um den Arbeitsaufwand „überschaubar“ zu halten und doch möglichst alle Effekte zu erlangen – direkte und indirekte Beleuchtung, gerichtete und diffuse Reflexionen, harte und weiche Schatten, Umgebungsverdeckung und Co – haben findige Entwickler in den 80er das Path Tracing entwickelt. Hier kommen Techniken aus der Stochastik – genauer die Monte-Carlo-Simulation – zum Einsatz , womit die Anzahl an Strahlen drastisch reduziert wird. Um nämlich alle Effekte zu berechnen, muss man bei einem Ray Tracer nicht nur einen sekundären Strahl zur jeder Lichtquelle absetzen, sondern zu jedem Objekt in der Umgebung und von dort dann wieder zur jeder Lichtquelle. Erst dann wird die Beleuchtung und alle Reflexionen richtig dargestellt. Um hier Strahlen zu sparen, wird ein Zufallsprinzip eingeführt und es wird beim Auftreffen des primären Strahles entschieden, ob überhaupt Sekundärstrahlen abgesetzt werden und auch wie viele. Das führt am Ende dazu, dass man ein Bild mit einem starken Rauschen bekommt, dass dann mit einem Denoiser entfernt wird.

Path Tracer mit der Monte-Carlo-Simulation sind also die aktuellste Ausbaustufe der Ray Tracer und wenn wir heute von Ray Tracing sprechen, meinen wir eben einen Path Tracer. Und für die unter euch, die gerne behaupten, dass Path Tracer ja kein echtes Ray Tracer wäre oder nur eine Schmalspurlösung: Nein, einfach nur NEIN!

Welche Spiele im RayTracing Test und warum?

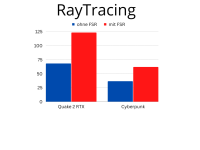

Um die Leistung der 7900 XTX in RayTracing zu testen, habe ich mich für Cyberpunk, Doom Eternal, Metro Exodus und Quake 2 RTX entschieden. Cyberpunk bietet – neben Metro Exodus Enhanced Edition – eine der besten aktuellen RT-Integrationen und auch eine der vollständigsten. Doom Eternal wiederum gewinnt durch RT auch an Grafikqualität, aber im weiten nicht so wie die anderen beiden Spiele.Für Quake 2 RTX habe ich mich entschieden, weil dieses Spiel – neben Minecraft RTX – das einzige wirkliche Path Tracer Spiel aktuell auf dem Markt ist. Die RT-Implementierungen in allen anderen Spielen folgt einem Hybrid-Ansatz, der zum Teil auch Leistung brach liegen lässt. So kostet RT in Spielen wie Cyberpunk, Metro und Co oft mehr Leistung, als notwendig wäre, weil Effekte teils doppelt berechnet werden. In Quake 2 RTX und Minecraft RTX ist das nicht der Fall.

Warum aber dann kein Minecraft RTX? Weil Minecraft von der ganzen Engine her einfach nur unglaublich schlecht ist, auch wenn ich Minecraft als Spiel liebe.

Die 7900 XTX und RayTracing – Für jetzt reicht die Leistung

Machen wir es kurz: Wer sich eine 7900 XTX gekauft hat oder kaufen will, kann in den meisten Spielen bedenkenlos RT aktivieren, in der Regel bleibt die Framerate spielbar, wobei aber jeder selbst entscheiden muss, was spielbar ist.

In Cyberpunk erreicht die 7900 XTX – ohne FSR – 36,4 fps im Durchschnitt und die 99.9 % liegen bei 25,4. Das ist nicht viel, man muss aber dazu schreiben, dass Cyberpunk auf der 7900 XTX – genauso wie auf der 5700 XT – auch mit RT-Effekt sehr sauber läuft und sich die 25,4 – 36,4 fps sehr gleichmäßig anfühlen. Gegenüber dem Max-Out büßt Cyberpunk mit allen RT-Effekten (maximiert) ca. 55 % ein (80,3 fps). Aktiviert man FSR2, erreicht die 7900 XTX 61,8 fps – (-23 %). FSR 2 wurde dabei in Qualität verwendet. Der Bildeindruck ist während des Spieles gleichwertig.

Der zweite Titel ist Doom Eternal, hier erreicht die 7900 XTX in 1440p 234,3 fps. Da hier eine andere Testszene verwendet wurde – mit wesentlich mehr Lichteffekten und Spiegelungen – ist ein direkter Vergleich mit den ursprünglichen Ergebnissen ist nicht möglich. Ich habe die gleiche Szene aber auch ohne RT vermessen und komme auf 370,4 fps und damit büßt die 7900 XTX hier knapp 37 % ein.

Kommen wir – Metro Exodus spare ich mir an der Stelle, dazu sind die Grafiken da – zu Quake 2 RTX. Hier erreicht die 7900 XTX bei allen möglichen Effekten 68,0 fps und bei den 99.9 % 55,4 und ist gut spielbar.

Mit FSR 1 erhöhen sich die FPS auf 123,2 und 76,0, was auch gut ist. Und der Sprung bei der Grafik ist gewaltig, wenn man mal Texturen und Modelle nicht beachtet.

Lautstärke und Verbrauch

Als vorletzter Abschnitt dieses Tests: Die Lautstärke habe ich natürlich jetzt auch ermittelt und kann sagen, dass die Merc 310 eine kleine Radaumacherin ist, aber im Vergleich zur Thicc 2 sehr leise agiert.Unter voller Last in Cyberpunk – Gehäuse offen – erreicht die Merc 310 39 dB(A), ist das Gehäuse geschlossen sind es 35 – 36 dB(A). Hat die Grafikkarte nichts zu tun, geht sie im restlichen vollkommen unter, dass mit 29 – 31 dB(A) vor sich hinarbeitet.

Kommen wir zu den Verbräuchen: Bei einem „ruhendem“ Desktop benötigt die Merc zwischen 18 – 27 W, das Mittel liegt bei 22 W. Hier muss man bedenken, dass Discord und Co natürlich kleinere Spitzen erzeugen. Bei YouTube (4k, 60 FPS) liegt der Verbrauch zwischen 38 – 55 W (46 W im Mittel). Immer noch nicht gut, aber auch nicht mehr SO katastrophal wie zu Anfang.

Bei einem aktiven Desktop liegt der Verbrauch der Grafikkarte zwischen 25 W – 45 W, im Mittel bei ca. 35 W. Getestet wurden die Verbräuche mit dem Treiber 22.12.2.

Abschließendes Fazit und Ausblick auf Phase 5

Kommen wir nach nun gut 2 Wochen des Testens zu einem vorläufigen Fazit zur 7900 XTX: Es hat sich für mich aktuell nicht viel geändert und wenn man die Ausgangsbasis – die 5700 XT – nimmt, dann bin ich von der 7900 XTX begeistert. Gleichzeitig bin ich mir aber der Schwächen der Karte bewusst und habe diese auch bewusst in Kauf genommen. Ich finde das Chiplet-Design toll und genauso spannend für mich ist der Umbau der Compute Units und genau da liegt auch für mich der Kaufgrund. Ich bin ein Spielpandi und liebe Technik und für mich liefert AMD mit RDNA 3 die interessantere Technik ab.Die 7900 XTX ist jedoch durch und durch eine unvernünftige Spielkameradin. Sie benötigt bis zu 390 W – was echt viel ist. Sie ist auch nicht die effizienteste Karte. Bei Rasterisation kann die 7900 XTX mit der RTX 4080 mithalten und bei modernen Spielen auch manchmal in Schlagdistanz zur RTX 4090 kommen, in Ray Tracing ist sie allerdings unterlegen. Man merkt auch an vielen Ecken und Enden, dass weder die Treiber, an manchen Stellen aber auch die Partnerkarten noch nicht so ganz im Einklang sind und an diesen Stellen noch gearbeitet werden muss. Auch der Shader-Compiler ist noch eine Baustelle.

Wer – aktuell – die schnellste Karte, egal in welchen Lebenslagen haben will, greift zur RTX 4090, an dieser führt kein Weg vorbei. Wer eine klasse Tiefer schaut und wenn RT wichtig ist, sollte der Griff zur RTX 4080 gehen. Wer die effizienteste Karte haben will, greift auch zur RTX 4080 oder RTX 4090.

Für wen ist die 7900 XTX also empfehlenswert? Nun, eigentlich für alle – wenn wir ehrlich sind. Klar, man muss schon ein wenig verrückt sein, man muss auch gewisse Schwächen akzeptieren, aber wie in der vorherigen Generation, man macht weder mit AMD noch mit NVIDIA viel falsch, vor allem wenn man von einer älteren Karte kommt. Gleichzeitig muss man aber auch schreiben: Im Gegensatz zu mir solltet ihr noch 2 – 3 Monate warten, bis viele der kleinen Fehler und Probleme behoben sind und AMD auch weiter am Treiber und Shadercompiler arbeiten konnte.

Benötigt ihr jetzt eine schnelle Karte, dann kauft die RTX 4080, denn diese ist aktuell das rundere Produkt!

Und was mache ich jetzt? Ich plane die Phase 5 und bereite den nächsten Test vor, dann geht es um PCIe3 und PCIe4 bei der 7900 XTX und wie viel Leistung wohl brach liegt durch PCIe3. Freut euch, der Test ist für den Sommer während meines Jahresurlaubes geplant.

P.S. Das Shader Prefetching scheint wohl zu funktionieren!

Anhang - Absolute Werte

Zusammenfassung

| Modus | Avg. (5700 XT) | 99.9 (5700 XT) | Verbrauch (5700 XT) | Avg. (7900 XTX) | 99.9 (7900 XTX) | Verbrauch (7900 XTX) |

|---|---|---|---|---|---|---|

| DevPandi | 63,9 | 41,0 | 163 W | 71,8 | 50,3 | 154 W |

| DevPandi - No Limit | 114,4 | 60,5 | 203 W | 240,5 | 116,0 | 339 W |

| Max-Out | 99,2 | 55,0 | 204 W | 211,7 | 112,4 | 347 W |

Black Mesa

| Modus | Avg. (5700 XT) | 99.9 (5700 XT) | Verbrauch (5700 XT) | Avg. (7900 XTX) | 99.9 (7900 XTX) | Verbrauch (7900 XTX) |

|---|---|---|---|---|---|---|

| DevPandi | 71,7 | 62,3 | 134 W | 71,7 | 60,9 | 90 W |

| DevPandi - No Limit | 280,7 | 153,5 | 213 W | 294,7 | 185,9 | 218 W |

| Max-Out | 280,7 | 153,5 | 213 W | 294,7 | 185,9 | 218 W |

Cyberpunk

| Modus | Avg. (5700 XT) | 99.9 (5700 XT) | Verbrauch (5700 XT) | Avg. (7900 XTX) | 99.9 (7900 XTX) | Verbrauch (7900 XTX) |

|---|---|---|---|---|---|---|

| DevPandi | 33,6 | 20,4 | 208 W | 71,6 | 49,3 | 285 W |

| DevPandi - No Limit | 33,6 | 20,4 | 208 W | 110,7 | 52,2 | 356 W |

| Max-Out | 23,3 | 15,4 | 216 W | 80,3 | 46,1 | 385 W |

Tiny Tina

| Modus | Avg. (5700 XT) | 99.9 (5700 XT) | Verbrauch (5700 XT) | Avg. (7900 XTX) | 99.9 (7900 XTX) | Verbrauch (7900 XTX) |

|---|---|---|---|---|---|---|

| DevPandi | 71,7 | 31,5 | 202 W | 71,9 | 34,7 | 137 W |

| DevPandi - No Limit | 110,1 | 59,7 | 216 W | 237,7 | 86,9 | 388 W |

| Max-Out | 64,9 | 45,7 | 215 W | 197,3 | 75,9 | 347 W |

WarHammer 40k: DarkTide

| Modus | Avg. (5700 XT) | 99.9 (5700 XT) | Verbrauch (5700 XT) | Avg. (7900 XTX) | 99.9 (7900 XTX) | Verbrauch (7900 XTX) |

|---|---|---|---|---|---|---|

| DevPandi | 58,2 | 31,9 | 208 W | 71,8 | 58,4 | 148 W |

| DevPandi - No Limit | 58,2 | 31,9 | 208 W | 163,6 | 86,7 | 387 W |

| Max-Out | 30,3 | 24,1 | 211 W | 102,2 | 64,7 | 390 W |

Diablo 2 Resurrected

| Modus | Avg. (5700 XT) | 99.9 (5700 XT) | Verbrauch (5700 XT) | Avg. (7900 XTX) | 99.9 (7900 XTX) | Verbrauch (7900 XTX) |

|---|---|---|---|---|---|---|

| DevPandi | 71,3 | 34,5 | 189 W | 72,0 | 36,1 | 188 W |

| DevPandi - No Limit | 80,8 | 34,2 | 207 W | 234,2 | 93,4 | 385 W |

| Max-Out | 74,1 | 30 | 201 W | 243,3 | 120 | 387 W |

Final Fantasy 14

| Modus | Avg. (5700 XT) | 99.9 (5700 XT) | Verbrauch (5700 XT) | Avg. (7900 XTX) | 99.9 (7900 XTX) | Verbrauch (7900 XTX) |

|---|---|---|---|---|---|---|

| DevPandi | 71,9 | 59,9 | 122 W | 72 | 66,4 | 136 W |

| DevPandi - No Limit | 127,7 | 68,1 | 208 W | 315,6 | 191,5 | 375 W |

| Max-Out | 127,7 | 68,1 | 208 W | 315,6 | 191,5 | 375 W |

Total War: WarHammer 3

| Modus | Avg. (5700 XT) | 99.9 (5700 XT) | Verbrauch (5700 XT) | Avg. (7900 XTX) | 99.9 (7900 XTX) | Verbrauch (7900 XTX) |

|---|---|---|---|---|---|---|

| DevPandi | 37,8 | 12,7 | 182 W | 71,7 | 57,3 | 187 W |

| DevPandi - No Limit | 37,8 | 12,7 | 182 W | 177,5 | 108,5 | 388 W |

| Max-Out | 35,1 | 14,3 | 183 W | 145,8 | 92,7 | 388 W |

World of WarCraft

| Modus | Avg. (5700 XT) | 99.9 (5700 XT) | Verbrauch (5700 XT) | Avg. (7900 XTX) | 99.9 (7900 XTX) | Verbrauch (7900 XTX) |

|---|---|---|---|---|---|---|

| DevPandi | 71,6 | 24,5 | 133 W | 71,7 | 23,0 | 134 W |

| DevPandi - No Limit | 127,0 | 33,2 | 199 W | 253,6 | 50,6 | 245 W |

| Max-Out | 87,7 | 24,2 | 191 W | 142,8 | 31,6 | 294 W |

Doom Eternal

| Modus | Avg. (5700 XT) | 99.9 (5700 XT) | Verbrauch (5700 XT) | Avg. (7900 XTX) | 99.9 (7900 XTX) | Verbrauch (7900 XTX) |

|---|---|---|---|---|---|---|

| DevPandi | 72,0 | 53,9 | 129 W | 72,0 | 67,4 | 121 W |

| DevPandi - No Limit | 136,3 | 84,0 | 190 W | 423,6 | 214,8 | 387 W |

| Max-Out | 117,7 | 72,6 | 193 W | 410,8 | 226,1 | 389 W |

Doom (2016)

| Modus | Avg. (5700 XT) | 99.9 (5700 XT) | Verbrauch (5700 XT) | Avg. (7900 XTX) | 99.9 (7900 XTX) | Verbrauch (7900 XTX) |

|---|---|---|---|---|---|---|

| DevPandi | 72,0 | 61,2 | 113 W | 72 | 58,9 | 118 W |

| DevPandi - No Limit | 176,4 | 118,3 | 208 W | 199,6 | 119,0 | 209 W |

| Max-Out | 176,4 | 118,3 | 208 W | 199,6 | 119,0 | 209 W |

Metro Exodus

| Modus | Avg. (5700 XT) | 99.9 (5700 XT) | Verbrauch (5700 XT) | Avg. (7900 XTX) | 99.9 (7900 XTX) | Verbrauch (7900 XTX) |

|---|---|---|---|---|---|---|

| DevPandi | 71,4 | 58,7 | 176 W | 71,8 | 40,7 | 148 W |

| DevPandi - No Limit | 90,0 | 49,0 | 199 W | 234,7 | 86,1 | 387 W |

| Max-Out | 73,6 | 39,1 | 206 W | 195,9 | 82,8 | 387 W |

Anhang 2 - RayTracing

| Spiel | Avg. FPS | 99.9 % | Avg. FPS (FSR) | 99.9 % (FSR) |

|---|---|---|---|---|

| Quake 2 RTX | 68,0 | 55,4 | 123,2 | 76 |

| Cyberpunk 2077 | 36,4 | 25,4 | 61,8 | 36,8 |

| Doom Eternal | 234,3 | 140,9 | - | - |

| Metro Exodus Extended | 89,0 | 34,1 | - | - |

Anhang 3 - FPS/Watt

Zusammenfassung

| Modus | Avg. (5700 XT) | Avg. (7900 XTX) | 99.9 (5700 XT) | 99.9 (7900 XTX) |

|---|---|---|---|---|

| DevPandi | 0,39 | 0,47 | 0,25 | 0,33 |

| DevPandi - No Limit | 0,56 | 0,71 | 0,30 | 0,34 |

| Max-Out | 0,49 | 0,61 | 0,27 | 0,32 |

Black Mesa

| Modus | Avg. (5700 XT) | Avg. (7900 XTX) | 99.9 (5700 XT) | 99.9 (7900 XTX) |

|---|---|---|---|---|

| DevPandi | 0,53 | 0,80 | 0,46 | 0,68 |

| DevPandi - No Limit | 1,32 | 1,35 | 0,72 | 0,85 |

| Max-Out | 1,32 | 1,35 | 0,72 | 0,85 |

Cyberpunk 2077

| Modus | Avg. (5700 XT) | Avg. (7900 XTX) | 99.9 (5700 XT) | 99.9 (7900 XTX) |

|---|---|---|---|---|

| DevPandi | 0,16 | 0,25 | 0,10 | 0,17 |

| DevPandi - No Limit | 0,16 | 0,31 | 0,16 | 0,15 |

| Max-Out | 0,11 | 0,21 | 0,07 | 0,12 |

Tiny Tina

| Modus | Avg. (5700 XT) | Avg. (7900 XTX) | 99.9 (5700 XT) | 99.9 (7900 XTX) |

|---|---|---|---|---|

| DevPandi | 0,35 | 0,52 | 0,16 | 0,25 |

| DevPandi - No Limit | 0,51 | 0,61 | 0,28 | 0,22 |

| Max-Out | 0,30 | 0,51 | 0,21 | 0,19 |

WarHammer 40K: Dark Tide

| Modus | Avg. (5700 XT) | Avg. (7900 XTX) | 99.9 (5700 XT) | 99.9 (7900 XTX) |

|---|---|---|---|---|

| DevPandi | 0,28 | 0,48 | 0,15 | 0,39 |

| DevPandi - No Limit | 0,28 | 0,42 | 0,15 | 0,22 |

| Max-Out | 0,14 | 0,26 | 0,11 | 0,17 |

Diablo 2: Ressurrected

| Modus | Avg. (5700 XT) | Avg. (7900 XTX) | 99.9 (5700 XT) | 99.9 (7900 XTX) |

|---|---|---|---|---|

| DevPandi | 0,38 | 0,38 | 0,18 | 0,19 |

| DevPandi - No Limit | 0,39 | 0,61 | 0,17 | 0,24 |

| Max-Out | 0,37 | 0,15 | 0,63 | 0,31 |

Final Fantasy 14

| Modus | Avg. (5700 XT) | Avg. (7900 XTX) | 99.9 (5700 XT) | 99.9 (7900 XTX) |

|---|---|---|---|---|

| DevPandi | 0,59 | 0,53 | 0,49 | 0,49 |

| DevPandi - No Limit | 0,61 | 0,84 | 0,33 | 0,51 |

| Max-Out | 0,61 | 0,84 | 0,33 | 0,51 |

Total War: WarHammer 3

| Modus | Avg. (5700 XT) | Avg. (7900 XTX) | 99.9 (5700 XT) | 99.9 (7900 XTX) |

|---|---|---|---|---|

| DevPandi | 0,21 | 0,38 | 0,07 | 0,31 |

| DevPandi - No Limit | 0,21 | 0,46 | 0,07 | 0,28 |

| Max-Out | 0,19 | 0,38 | 0,08 | 0,24 |

World of WarCraft

| Modus | Avg. (5700 XT) | Avg. (7900 XTX) | 99.9 (5700 XT) | 99.9 (7900 XTX) |

|---|---|---|---|---|

| DevPandi | 0,54 | 0,53 | 0,18 | 0,17 |

| DevPandi - No Limit | 0,64 | 0,17 | 1,04 | 0,21 |

| Max-Out | 0,46 | 0,49 | 0,13 | 0,11 |

Doom Eternal

| Modus | Avg. (5700 XT) | Avg. (7900 XTX) | 99.9 (5700 XT) | 99.9 (7900 XTX) |

|---|---|---|---|---|

| DevPandi | 0,56 | 0,59 | 0,46 | 0,56 |

| DevPandi - No Limit | 0,72 | 1,09 | 0,44 | 0,56 |

| Max-Out | 0,61 | 1,06 | 0,38 | 0,58 |

Doom 2016

| Modus | Avg. (5700 XT) | Avg. (7900 XTX) | 99.9 (5700 XT) | 99.9 (7900 XTX) |

|---|---|---|---|---|

| DevPandi | 0,64 | 0,61 | 0,54 | 0,50 |

| DevPandi - No Limit | 0,85 | 0,96 | 0,57 | 0,57 |

| Max-Out | 0,85 | 0,96 | 0,57 | 0,57 |

Metro Exodus

| Modus | Avg. (5700 XT) | Avg. (7900 XTX) | 99.9 (5700 XT) | 99.9 (7900 XTX) |

|---|---|---|---|---|

| DevPandi | 0,40 | 0,49 | 0,33 | 0,28 |

| DevPandi - No Limit | 0,45 | 0,61 | 0,25 | 0,22 |

| Max-Out | 0,36 | 0,51 | 0,19 | 0,21 |

Anhänge

Zuletzt bearbeitet: