Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News GPU-Gerüchte: GeForce RTX 4070 ab 13. April ab 599 US-Dollar im Handel

- Ersteller MichaG

- Erstellt am

- Zur News: GPU-Gerüchte: GeForce RTX 4070 ab 13. April ab 599 US-Dollar im Handel

B

ben12345

Gast

Gebe dir absolut Recht. Auch das Nvidia immer wegen der Namensgebung angegangen wird ist zwar absolut richtig und nachvollziehbar aber was sagt das denn dann über AMD aus. Wenn die 4070 ti nur ne 4070 oder wie manche sagen nur ne 4060ti ist was ist denn dann die 7900xt die in eine ähnliche Leistung hat. Man sollte dann schon so fair sein und beide Hersteller entsprechend kritisieren. Die Namensgebung sollte doch schon der ungefähren Leistungsklasse entsprechen und wenn Nvidia da ihre Karten "zu hoch benennt" dann muss man schon darauf hinweisen das selbst mit dieser frechen Namensgebung seitens Nvidia ihre Karten mit der jeweils HÖHEREN Leistungsklasse der AMD Karten konkurrieren (4080vs 7900xtx oder noch krasser 4070ti vs7900xt). In der letzten Generation war das nicht der fall. Hier muss sich AMD mit der Namensgebung dann auch was überlegen oder man gesteht sich ein das sie in Sachen performance MASSIV zurückgefallen sind, und zwar um eine ganze Leistungsklasse (laut der eigenen Namensgebung...) Da können sie noch so viel Speicher auf die Karten pappen, schneller werden die dadurch auch nicht.HaRdWar§FreSseR schrieb:Das mag sein, aber halte von GPU OC wenig, da es kaum Vorteile hat für mich eher negativ da mehr wärme und die Lautstärke zu nimmt.

Zurück zum Thema"

Würden wir alle endlich verstehen, das eine 4070 Ti nicht gegen eine 7900 XT konkurriert, hätten wir diese Debatten nicht.

Die Konkurrenz zu der 7900 XT ist die RTX 4080 und die 7900 XTX steht der 4090 gegenüber.

Der wahre Gegenspieler der 4070 Ti ist die 7800 XT, wenn die mal kommt.

Was ich euch sagen will, ist Nvidia haut einfach eine Mittelklasse karte für 900 Euro raus, die nur 8 % langsamer ist wie AMDs zweit schnellste karte.

Das müsst ihr euch mal auf der Zunge vergehen lassen Nvidia nimmt AMD nicht mehr ernst besser gesagt sieht sie nicht auf Augen höhe.

Solange dies sein sollte, wird sich auch nicht an den Preisen ändern.

Ich hoffe, AMD kommt mit so einem riesen Ding, wo keiner damit gerechnet hat und haut alles weg wie damals mit der 64 Bit Architektur das wäre was sage ich euch. ^^

Ergänzung ()

Ich meine Crysis remasterd genannt zu haben und nicht Crysis 3. Der erste teil hatte vor allem mit raytracing eine sehr sehr schlechte performance.GerryB schrieb:

Poati

Captain

- Registriert

- Okt. 2009

- Beiträge

- 3.606

Naja eine gewisse Optik rechtfertigt eben auch entsprechende Hardwareanforderungen. The last of us läuft bis auf ein paar Probleme rund und hat eine super Grafik. Also das kann man schon differenzierter betrachten. Das war jetzt speziell auf den Speicherbedarf bezogen. Wenn ein Spiel sehr viel Speicher verlangt aber auch von vielen schon als neue Referenz bezeichnet wurde, dann ist der Speicherbedarf aus meiner Sicht legitim. Gibt genug Spiele wo das nicht der Fall ist, also viel Speicherbedarf und mittelmäßige Optik.ben12345 schrieb:Eine Top Optik hat doch nichts mit der Optimierung zu tun.

Poati

Captain

- Registriert

- Okt. 2009

- Beiträge

- 3.606

Ah okay! Wir sind alle nur zu doof Preisschilder zu lesen... Na gut wenn ich die Wahl zwischen einer 4090 für 1750€ und einer 7900XTX für 999€ habe, hmm was nehm ich dann. Die eine leistet wesentlich mehr, kostet dementsprechend mehr. Schwierig. Kaufe ich mir eine S-Klasse oder doch einen Arteon. Beides die größte Limousine eines Herstellers, demnach konkurrieren die ja.HaRdWar§FreSseR schrieb:Würden wir alle endlich verstehen, das eine 4070 Ti nicht gegen eine 7900 XT konkurriert, hätten wir diese Debatten nicht.

Die Konkurrenz zu der 7900 XT ist die RTX 4080 und die 7900 XTX steht der 4090 gegenüber.

Radeon 5700XT war eigentlich auch die Konkurrenz zur 2080ti oder? Glaube das haben wir auch alle falsch verstanden.

Sie hat mehr vramben12345 schrieb:was ist denn dann die 7900xt die in eine ähnliche Leistung hat.

Naja nvidia hat halt einfach zu wenig vramben12345 schrieb:Man sollte dann schon so fair sein und beide Hersteller entsprechend kritisieren. Die Namensgebung sollte doch schon der ungefähren Leistungsklasse entsprechen und wenn Nvidia da ihre Karten "zu hoch benennt" dann muss man schon darauf hinweisen.

Eben...und je nach Benchmark kommst Du auch mit einer 400W RX 7900XT nicht an eine RTX 4070TI mit 150W ran.HaRdWar§FreSseR schrieb:Das mag sein, aber halte von GPU OC wenig, da es kaum Vorteile hat für mich eher negativ da mehr wärme und die Lautstärke zu nimmt.

Im Grunde ist es mir völlig egal zu wem Karte XY Konkurrent ist. Meine Karten sind deswegen kein einziges FPS langsamer oder schneller.

Beide...die RX 6800 und die RTX 4070Ti machen in ihrem jeweilligen Aufgabengebiet ein super Jop...ich bin bis jetzt rundum zufrieden.

Verak Drezzt

Fleet Admiral

- Registriert

- Jan. 2020

- Beiträge

- 10.348

dann hast du einfach von der Materie keine Ahnung, ich hab meine 6800XT von 1150mv auf 1050mv undervoltet und diese verbraucht mit über 250MHz OC nun genauso viel oder gar weniger als im Standard Modus mit 1150mv bei 2280MHz und komme damit fast an die Leistung einer 3090Ti mit 97FPS bei Cyberpunk im ultra Preset unter WQHD und knapp 21500 Grafikpunkte im TimespyHaRdWar§FreSseR schrieb:Das mag sein, aber halte von GPU OC wenig, da es kaum Vorteile hat für mich eher negativ da mehr wärme und die Lautstärke zu nimmt.

Ergänzung ()

was sind das wieder für qualifizierte Antworten von dir hier ? und wo bitte zieht eine 7900XT 400W während zeitgleich bei selbig geforderter Leistung eine 4070Ti 150W zieht ? geballte Fachkompetenz wieder am StartDaHell63 schrieb:Eben...und je nach Benchmark kommst Du auch mit einer 400W RX 7900XT nicht an eine RTX 4070TI mit 150W ran.

Ergänzung ()

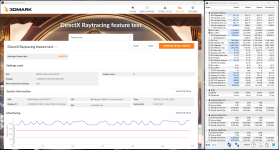

hatte dir doch erst vor paar Tagen diesbezüglich geantwortet gehabt, was die RT Leistung der beiden Karten betrifft, schon wieder vergessen ?

Verak Drezzt schrieb:@DaHell63 hab mir gerade mal die Mühe gemacht im oben geposteten 4070Ti Test, den Benchmark FPS Schnitt der 4070Ti und der 7900XT der 11 getesteten RT Games zu ermitteln und kam dabei, auf/abgerundet hinter der Kommastelle, auf folgendes WQHD Ergebnis

7900XT: 85FPS

4070Ti: 99FPS

Zuletzt bearbeitet:

sikarr

Vice Admiral

- Registriert

- Mai 2010

- Beiträge

- 6.769

Bin auch super zu frieden (bis auf den Preis), ob der Ram zum Problem wird, wird die Zukunft zeigen bisher rennt bei mir alles wie Sau. CP2077 alles auf Anschlag mit RT usw. ohne DLSS oder FSR bei WQHD mit ca. 45FpsDaHell63 schrieb:Beide...die RX 6800 und die RTX 4070Ti machen in ihrem jeweilligen Aufgabengebiet ein super Jop...ich bin bis jetzt rundum zufrieden.

Mironicus1337

Banned

- Registriert

- März 2023

- Beiträge

- 65

Es ist halt schwierig eine Bewertung einer Grafikkarte zu treffen, wenn man relevante Kennziffern weglässt.ShiftC schrieb:Das mag durchaus sein, meine Bewertung bezieht sich auf die Rasterleistung. Der 30-40%ige Performancevorsprung mit RT=ON verlangt hier allerdings auch einen 30-40%igen Aufpreis.

Der Grund wieso die Radeons so absacken liegt ja unter anderem auch daran.

DrFreaK666

Captain

- Registriert

- Dez. 2011

- Beiträge

- 3.756

ben12345 schrieb:Und ja ich ich finde die Speicherausstattung nach wie vor ok bei Nvidia

Ist sie aber nicht. Die 4050 kommt angeblich mit 6GB. Wie willst du das verteidigen? "Dafür hat man schnelleres RT"?

ben12345 schrieb:ich finde das nur merkwürdig eine 70ger mit einer 80ger Karte zu vergleichen.

lol. Man sollte gleich teure Karten vergleichen und nicht weil sie Max und Moritz heißen. Die 6800 und 3070 sind preislich nunmal nah beieinander.

JobbbbbDaHell63 schrieb:ein super Jop

B

ben12345

Gast

Das ist jetzt der fall, ich beziehe mich da eher auf die uvp Preise zu release egal wie realitätsfern sie damals auch waren bei beiden Herstellern. Heute hast du recht da liegen die Preislich näher beisammen.DrFreaK666 schrieb:lol. Man sollte gleich teure Karten vergleichen und nicht weil sie Max und Moritz heißen. Die 6800 und 3070 sind preislich nunmal nah beieinander.

Ergänzung ()

Ich habe mich auf die 70ger/80ger/90ger Karten bezogen . Von einer 6 gig 4050 habe ich bisher noch keine offizielle Ankündigung oder Daten gesehen, schick mal bitte deine Quelle. 6 Gig finde ich absolut nicht mehr angemessen bei einer neuen Grafikkarte es sei denn sie kostet unter 100 Euro was ich stark bezweifle bei der 4050. Das sollten mindestens 8 gig sein für 1080p mit mittleren Details ( da sehe ich den Anwendungsbereich so einer Karte).DrFreaK666 schrieb:st sie aber nicht. Die 4050 kommt angeblich mit 6GB. Wie willst du das verteidigen? "Dafür hat man schnelleres RT"?

DrFreaK666

Captain

- Registriert

- Dez. 2011

- Beiträge

- 3.756

ben12345 schrieb:Von einer 6 gig 4050 habe ich bisher noch keine offizielle Ankündigung oder Daten gesehen, schick mal bitte deine Quelle

Es gibt keine offizielle Quelle, sonst hätte ich nicht von "angeblich" geschrieben 😉

Was man nicht vergessen sollte, ist dass die 7700XT laut Gerüchten auch nur mit 8GB kommt. AMD begeht also den gleichen Fehler (bzw. die Käufer dieser Karten)

Haben wir mal wieder Probleme mit lesen und verstehen?Verak Drezzt schrieb:was sind das wieder für qualifizierte Antworten von dir hier ? und wo bitte zieht eine 7900XT 400W während zeitgleich bei selbig geforderter Leistung eine 4070Ti 150W zieht ? geballte Fachkompetenz wieder am Start

Meinen 150W Bench habe ich gezeigt und an meiner Aussage, dass das eine RX 7900 XT mit ~400W nicht schaft halte ich fest.

Und die zieht ihre ~400W

https://www.computerbase.de/forum/t...ollar-im-handel.2129577/page-30#post-28053734

Was hat ein Index über X Spiele mit der Leistung zu tun?Verak Drezzt schrieb:hatte dir doch erst vor paar Tagen diesbezüglich geantwortet gehabt, was die RT Leistung der beiden Karten betrifft, schon wieder vergessen ?

Durch anti Raytracing Spiele wie Far Cry und co wird die Leistung starker Raytracing Karten total verwässert.

Um die Multi Core Leistung einer CPU zu messen wird ja auch CB 23 genommen und keine Anwendung die nur wenig Kerne unterstützt.

Genauso wird die Raytracing Leistung mit einer Anwendung getestet die Raytracing exessiv nutzt.

Das muss ja nichts mit dem Spieledurchschnitt zu tun haben.

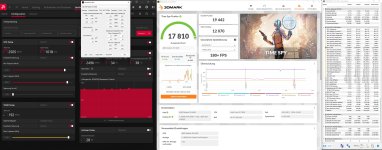

Das halte ich mal, gelinde gesagt,....äh nein doch...gelogen.Verak Drezzt schrieb:dann hast du einfach von der Materie keine Ahnung, ich hab meine 6800XT von 1150mv auf 1050mv undervoltet und diese verbraucht mit über 250MHz OC nun genauso viel oder gar weniger als im Standard Modus mit 1150mv bei 2280MHz und komme damit fast an die Leistung einer 3090Ti mit 97FPS bei Cyberpunk im ultra Preset unter WQHD und knapp 21500 Grafikpunkte im Timespy

Die 213xxx hast Du letztes Jahr erreicht und das ist gleichzeitig dein höchstes Ergebnis.

74° Durchschnittstemperatur...da kannste unter Luft gut 20% auf max dazu rechnen...da gehts dann schon Richtung 90° Chip und ~110° Hotspot.

Ich gehe mal davon aus, dass da ~340W verbraten werden.

Du kannst ja gerne mal einen Aussagekräftigen Scrren zeigen...mit Ergebnis und HWI und das online Ergebnis zum Abgleich.

https://www.3dmark.com/spy/29981795

Zuletzt bearbeitet:

Verak Drezzt

Fleet Admiral

- Registriert

- Jan. 2020

- Beiträge

- 10.348

ja mit entsprechend starken oc wenn man mal von 26K Standard Timespy Punkten der 7900XT spricht, gegenüber den dort erreichten 31.150 und wo soll da jetzt der Kontext zu deinem tollen Raytracing Screenshot sein ?DaHell63 schrieb:

und was die tolle RT Leistung der 4070Ti angeht, mag diese 150% besser sein laut CB hier bei Cyberpunk, am Ende sind es aber trotz alledem nur 13FPS mehr unter WQHD, joa mal schauen was bei deinen tollen 150W dann noch übrig bleibt, ohne Worte - https://www.computerbase.de/artikel...chmarks_mit_und_ohne_raytracing_in_2560__1440

Zuletzt bearbeitet:

SonyFriend

Commander

- Registriert

- Jan. 2006

- Beiträge

- 2.168

Meine Gerüchteküche schreibt von 12 GB für die 7700xt.DrFreaK666 schrieb:Es gibt keine offizielle Quelle, sonst hätte ich nicht von "angeblich" geschrieben 😉

Was man nicht vergessen sollte, ist dass die 7700XT laut Gerüchten auch nur mit 8GB kommt. AMD begeht also den gleichen Fehler (bzw. die Käufer dieser Karten)

Bei dessen Vorgänger wäre es auch plausibel.

Verak Drezzt

Fleet Admiral

- Registriert

- Jan. 2020

- Beiträge

- 10.348

kannst gerne vorbei kommen, oder reicht dir ein Screenshot vom Ergebnis ?DaHell63 schrieb:Das halte ich mal, gelinde gesagt,....äh nein doch...gelogen.

Ergänzung ()

@DaHell63 hier nur für dich

Ergänzung ()

und wenn ich das FPS Limit von 120FPS rausnehme sind dann sogar noch paar FPS mehr drinne und hier auch die ultra Einstellung, die davor nicht angezeigt wurde da ich zum zocken FSR auf Auto nutze um konstante 120FPS zu haben sowie den Stromverbrauch zu senken und es dann deshalb auf angepasste Einstellung wechselt wenn ich es de- oder aktiviere

Anhänge

Zuletzt bearbeitet:

Ich hab doch geschrieben was mir reichen würde...der Screen vom internen Benchmark mit angepassten Settings gehört da sicher nicht dazu.Verak Drezzt schrieb:kannst gerne vorbei kommen, oder reicht dir ein Screenshot vom Ergebnis ?

Ich steh wenigstens zu jedem Geblubber mit einem nachvollziehbaren Ergbnis dahinter...egal ob von der RTX 3070/RX 6800 oder jetzt der RTX 4070Ti.

Wenn Du das nicht kannst, oder willst, dann verarsch auch die Leute nicht.

Verak Drezzt

Fleet Admiral

- Registriert

- Jan. 2020

- Beiträge

- 10.348

hab ich schon entsprechend aktualisiert und erklärt, genau ich blubber hierDaHell63 schrieb:Ich steh wenigstens zu jedem Geblubber mit einem nachvollziehbaren Ergbnis dahinter

Ergänzung ()

bei ihm hier macht übrigens eine 3090Ti in WQHD laut ihm ultra Details 101FPS

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

@DaHell63 wobei ich seh grad sobald man ultra Preset wählt macht er automatisch FSR auf Quality rein, also war das Ergebnis mit FSR off doch korrekt mit den 98FPS

Zuletzt bearbeitet: