News GPU-Gerüchte: RTX 4090 und RX 7900 sollen (fast) 100 TFLOPs erreichen

- Ersteller MichaG

- Erstellt am

- Zur News: GPU-Gerüchte: RTX 4090 und RX 7900 sollen (fast) 100 TFLOPs erreichen

Firstdim

Commander

- Registriert

- Dez. 2019

- Beiträge

- 2.066

Uff...wusste ich.ThirdLife schrieb:Dann hast du im Ergebnis aber dennoch dasselbe, nur einfach in längeren Intervallen. Ob ich jetzt 2x50% Steigerung habe in in vier Jahren aber alle zwei Jahre oder ob ich alle vier Jahre einmal 100% habe macht ja im Endeffekt keinen Unterschied.

Nein, das wäre naiv von mir das nur zeitlich zu verschieben.

Ich bleibe mit der Absicht bei AMD und der gleichen Modellen.

Wir haben eine 6900XT die laut mein Plan nicht erscheinen sollte, dann springt erst die 7700XT mit gleicher Leistung, dafür aber 60% an Energiebedarf.

Als die 7700XT erscheint, werden klar genauso die 7900 in der Tonne landen und weiter entwickelt werden. Irgendwann ist ein würdiger umweltfreundlicher 7900 Nachfolger, der 300W TDP oder weniger hat.

Es ist nicht nur zeitlich verschoben, es wird so lange verzögert oder abgewartet mit der Entwicklung, bis die Effizienz stimmt.

Und es muss nicht bedeuten, dass irgendwann kommen wir an 500TDP nur wie du meinst "zeitlich verschoben".

Es wird so lange nachgeforscht bis ales passt und gewisse Vernunft Verbrauch Maximum nicht überschritten wird .

Die Autos leisten doch immer mehr Leistung und verbrauchen immer weniger und ich meine hier nicht unbedingt PS pro LTR.

Keine Ahnung wer hat das geschrieben mit 3h zocken am Tag als unmögliche Geschichte.

Familie 2+2, seit paar Jahren keine Haushaltshilfe mehr und trotz, dass wir beide Vollzeitbeschäftigung ausüben, gepflegte Haus mit zwei Tieren und ich habe mittlerweile 1500h BF V auf'm Tacho 🤫

Schlafe aber maximal 6h, mehr brauche ich auch nicht. Um 6 frühstücken, 12 Mittagessen und 18 Abendessen deutsches Model, würde mir als Südländer ein Kugel durch die 🍐 jagen.

ThePlayer

Captain

- Registriert

- Aug. 2011

- Beiträge

- 3.397

Man das wird ja immer spannender mit den Gerüchten. Dachte eigentlich das es so ca. 6 Monate vor release etwas Konkreter und Handfester wird. Aber wenn AMD bei einem GPU Chiplet und einem MCD bleibt dann könnte der verbrauch auch nur moderat steigen 50-100W. Frage mich wie es mit der RT Leistung aussieht bei RDNA3.

- Registriert

- Jan. 2018

- Beiträge

- 685

Doch.ThirdLife schrieb:Ob ich jetzt 2x50% Steigerung habe in in vier Jahren aber alle zwei Jahre oder ob ich alle vier Jahre einmal 100% habe macht ja im Endeffekt keinen Unterschied.

Prozentrechnung:

1x(1+0,5)x(1+0,5)=1x1,5x1,5=2,25

1x(1+1)=1x2=2

Sorry aberFirstdim schrieb:ein würdiger umweltfreundlicher 7900 Nachfolger, der 300W TDP oder weniger hat.

Umweltfreundlich wäre es nur, wenn es gar keine Grafikkarten geben würde. Ob die neuen nun 300 oder 450 brauchen, ist dabei völlig Hupe. Und Umweltfreundlich ist nicht die TDP sondern wie der Strom erzeugt wird.

Im Endeffekt läuft es doch darauf hinaus, braucht man sowas oder will man sowas. Es ist ein Hobby und es wird vielen, auch in DE, völlig egal sein was die Teile verbrauchen, denn man will ja brachiale Leistung.

Ich hoffe ja dass es in Zukunf auf ein Multichip/Core Design rausläuft, evtl. hilft das ja beim Verbrauch und Leistung.

Naja, wir spekulieren hier ja auch erstmal nur. Wer weiß was noch passiert.

Eidgenosse

Banned

- Registriert

- Nov. 2012

- Beiträge

- 645

Ich muss mal schauen wie ob das unter Linux auch funktioniert. Danke dir auf alle Fälle für den Hinweis!Gaspedal schrieb:-Komplettzitat entfernt-

Zuletzt bearbeitet von einem Moderator:

Übrigens @MichaG :

https://www.duden.de/rechtschreibung/gebrandmarkt

Da hatte ich gerade beim Lesen gezuckt.

als nicht korrekt gebranntmarkt.

https://www.duden.de/rechtschreibung/gebrandmarkt

Da hatte ich gerade beim Lesen gezuckt.

Zur Not kann man auch das Bios der Grafikkarte patchen (also auslesen, ändern, dann wieder einspielen). Dann hat man diese Einstellungen immer Fix egal was für Betriebssystem.Eidgenosse schrieb:Ich muss mal schauen wie ob das unter Linux auch funktioniert. Danke dir auf alle Fälle für den Hinweis!

Grundgütiger

Lt. Commander

- Registriert

- Aug. 2017

- Beiträge

- 1.047

Bei Gleicher Ausnutzung wie bisher würde Navi 33 bei N5 auf 21-22mrd Transistoren und ca. 250mm2 einnehmen.

L3 Cache müsste auf 64mb wachsen, eventuell mehr.

Auf jeden Fall ergeben 256 und oder 512mb bei 3 Chiplets keinen Sinn.

Also 192 bis 384mb L3 Cache wenn es den. 3 Chiplets sind.

Nur wie kommunizieren die 3 Chiplets?

Nach aktuellen Design( CDNA )würde AMD nur 2 Chiplets nehmen.

Also 2x Navi 32. welcher mit dem Wechsel auf N5 in etwa soviel Einheiten wie Navi 21 hätte. Bei ca. 330-350mm2

Dann ergeben auch die 256 bis 512mb L3 Cache Sinn.

Braucht ja Dank N5 kaum Fläche.

L3 Cache müsste auf 64mb wachsen, eventuell mehr.

Auf jeden Fall ergeben 256 und oder 512mb bei 3 Chiplets keinen Sinn.

Also 192 bis 384mb L3 Cache wenn es den. 3 Chiplets sind.

Nur wie kommunizieren die 3 Chiplets?

Nach aktuellen Design( CDNA )würde AMD nur 2 Chiplets nehmen.

Also 2x Navi 32. welcher mit dem Wechsel auf N5 in etwa soviel Einheiten wie Navi 21 hätte. Bei ca. 330-350mm2

Dann ergeben auch die 256 bis 512mb L3 Cache Sinn.

Braucht ja Dank N5 kaum Fläche.

Natürlich können sies nicht.ETI1120 schrieb:Sie haben ein großes F&E-Budget. Prägen seit Jahren die Entwicklung bei den GPU wieso sollten sie nicht in diese Richtung forschen?

Außerdem liegt ein Großteil des erforderlichen Knowhow bei den Foundries oder Packaging Dienstleistern. Bei Apple ging das Ganze auch überraschend flott über die Bühne.

Es ist ein riesen Unterschied CPUs, GPUs und Speicher auf ein Package zu packen wie Apple oder mehrere GPUs Slices und diese Syncron an einem Bild/Problem rechnen zu lassen und vermutlich über Infinity Fabric (sowas brauchts auch) jeweils an ein IO Die zu verbinden bzw über dessen Cache zu Syncen bzw dort drüber ein Bild auszugeben.

Das ist Stand jetzt nur AMD zuzutrauen.

Ausserdem auch was Package angeht hat AMD bzw TSMC oder die Kombi davon Jahre an Vorsprung mit den Microbumbs auch im Vergleich zu Intels Foevros.

AMD hat mit der aktuellen CDNA sowas schon am Markt und NV soll das Knowhow dafür einfach hervorzaubern? Dran forschen tun sie garantiert.

Vor der übernächsten Gen kann NV das aber schlicht nicht umsetzen!

Zuletzt bearbeitet:

Was zählt ist was an Performance rauskommt und was man an Die-Fläche, Packaging-Kosten und Power reinstecken muss. Und wenn Nvidia liefert ist es egal wie.modena.ch schrieb:Natürlich können sies nicht.

AMD musste bei den CPUs den Weg über die Chiplets gehen, weil sie nur so die Chance hatten auf dem Servermarkt Fuß zu fassen. Nvidia ist der uneingeschränkte Marktführer, die müssen keine riskanten neue Wege gehen, solange die alten zum Erfolg führen.

Und noch eine böse Bemerkung: Nvidia ist nicht Intel. Wenn Nvidia feststellt, dass sie auf den alten Wegen nicht die erforderlichen Performancesteigerungen hinbekommen, suchen die sich neue Wege.

Meiner Meinung wird es ein Kopf an Kopf rennen. Einen Vorsprung für Nvidia halte ich für wahrscheinlicher als ein Vorsprung von AMD. Nvidia überspringt einen 1 1/2 Nodes während AMD nur einen Node weiter springt. Ich halte das Potential über Taktsteigerung mehr Leistung herauszuholen bei Nvidia für größer als bei AMD.

Bei AMD und Nvidia ist es die eigentliche Herausforderung die theoretische Leistung auf die Straße zu bringen. Das ist IMO bei einem monolithischen Design einfacher.

Apple verbindet zwei M1 Maxx per TSMC Info-LSI (LSI steht für eine mit Halbleiterprozessen gefertigte Brücke) in einen M1 Ultra zusammen. Apple behauptet der M1 Ulta hat eine GPU.modena.ch schrieb:Es ist ein riesen Unterschied CPUs, GPUs und Speicher auf ein Package zu packen wie Apple oder mehrere GPUs Slices und diese Syncron an einem Bild/Problem rechnen zu lassen und vermutlich über Infinity Fabric (sowas brauchts auch) jeweils an ein IO Die zu verbinden bzw über dessen Cache zu Syncen bzw dort drüber ein Bild auszugeben.

Nvidia hat mit NVLink ebenfalls einen Highspeed Interconnect. Sie haben massives Know How über NVLink GPUs in Supercomputern zusammen zu schalten. Natürlich ist es noch aufwändiger zwei GPUs so eng zu koppeln, dass sie wie eine agieren.

Ich denke der Schlüssel zu RDNA3 ist der InfinityCache der jetzt laut Patent zwischen den GPUs sitzt. Da habe ich von Nvidia noch nichts gesehen. Aber das bedeutet nicht dass sie gar nichts haben. Vielleicht gehen sie einen anderen Weg.

AMD muss es aber erst noch liefern.modena.ch schrieb:Das ist Stand jetzt nur AMD zuzutrauen.

Eine Instinct MI200 besteht aus zwei logischen 2 GPUs.

Die werden meines Wissens bei ASE zusammengepackt, nicht bei TSMC.

Nvidia ist Großkunde von TSMC CoWoS. Dass Hopper jetzt als Monolith rauskommen soll, schließt keine spätere Dual-Version aus.modena.ch schrieb:Ausserdem auch was Package angeht hat AMD bzw TSMC oder die Kombi davon Jahre an Vorsprung mit den Microbumbs auch im Vergleich zu Intels Foevros.

Nach allem was ich gelesen habe erwarte ich dass RDNA3 auf TSMC SoIC setzt. Ich denke dass Milan-X und der 58003DX der Testlauf waren. Zur Zeit habe ich das massive Problem dass die Leaks und die AMD-Patente nicht zusammenpassen.

Ich habe mir die beiden Videos der HotChips 33 zum Workshop Advanced Packaging angesehen. Die Beiträge von Intel waren mit die besten. Die Beiträge von TSMC und von AMD fielen massiv ab. Was natürlich nicht bedeutet, dass dies auch für die Technik gilt.

TSMC SoIC hat den Vorteil, dass eseine Directbonding Technologie ist. Sie ermöglicht ein extrem hohe Dichte an Verbindungen. TSMC SoIC benötigt keine Microbumps sondern kann die TSV direkt mit der nächsten Ebene verbinden.

Aber TSMC SoIC ist Know How von TSMC und steht somit früher oder später anderen Kunden zur Verfügung.

Wie gesagt sind es bei CDNA 2 GPUs in einem Package.modena.ch schrieb:AMD hat mit der aktuellen CDNA sowas schon am Markt und bei NV soll das Knowhow dafür

einfach hervorzaubern?

Wir werden sehen.modena.ch schrieb:Dran forschen tun sie garantiert.

Vor der übernächsten Gen kann NV das schlicht nicht umsetzen!

owned139 schrieb:Scheinbar kommst du nicht damit klar, dass du Kontra bekommst und fängst an mir Worte in den Mund zu legen

Bitte? Ich erinnere dich gerne wer hier wem direkt im ersten Beitrag Worte in den Mund gelegt hat:

Ich habe dich jetzt schon zwei mal aufgefordert diese wirklich dreiste Unterstellung zu belegen, aber das hast du natürlich bewusst ignoriert, denn du kannst es nicht. Stattdessen willst du dich jetzt auch noch als Opfer inszenieren, also wer kommt da nicht klar wenn er Kontra bekommt weil man ihm seinen erdachten Blödsinn nicht einfach durchgehen lässt?owned139 schrieb:du bist nicht der Mittelpunkt des Universums der zu bestimmen hat, wer was produzieren/kaufen darf.

Wenn sich in diesem Thread jemand wegen zu hohem Verbrauch beschwert ist das zumindest On-Topic. Dein Gejammere dass dir die immer gleichen Beiträge anderer auf den Nerv gehen ist es hingegen nicht, denn das ist tatsächlich nur Gejammere und darüber solltest du mal nachdenken!owned139 schrieb:aber im Gegenteil zu dir bzw. einigen anderen, welche du mit deinem Post verteidigst, mache ich das nicht unter jeder News mit den selben Phrasen aufs neue.

War aber auch für mich jetzt genug Off-Topic, führt sowieso zu nichts.

Zuletzt bearbeitet:

Makkaroni

Lieutenant

- Registriert

- Sep. 2010

- Beiträge

- 783

calippo schrieb:Vielleicht ist das hier der Grund, warum viele so weit aneinander vorbei reden. Im Schnitt 3h am Tag richtig unter Last zocken, also über 1000h pro Jahr ist rein gar nichts? Ein Durchschnittsmensch schläft 8h, arbeitet/lernt 8h, braucht ca. 4h für Körperpflege, Essen, Wege, sonstiges. Da bleiben vielleicht 4h zur komplett freien Verfügung, wie will man das noch steigern?

Zumindest aus Kostensicht ist der Mehrverbrauch/Kosten an Strom auch bei intensivster Nutzung überschaubar, wie die Rechenbeispiele zeigen.

Selbst wenn jemand sein Leben komplett Gaming widmen würde, also 16h am Tag dauerzocken bei 1000 Watt und die kWh 40 Cent kostet, sind das 6,4€ Stromkosten am Tag, so viel wie eine Schachtel Zigaretten.

Ja, es gibt Gründe, das nicht gutzuheißen. Der Kostenfaktor für den Stromverbrauch ist es eher kein Argument.

Ich persönlich schaffe nur 5-6 Stunden! Hast du Tipps, wie ich 8 Stunden schaffe?calippo schrieb:... Ein Durchschnittsmensch schläft 8h,

Ein 8-Stunden-Arbeitstag ist in Deutschland nicht mehr aktuell. Als Schüler war lag meine Unterrichtszeit zwischen 8:00 u. 14:00 Uhr (max!), Das sind 6 Stunden (max.). Berücksichtigt man die Wochenenden, wird dieser Wert noch kleiner.calippo schrieb:... arbeitet/lernt 8h ...

In meinem Fallcalippo schrieb:... ca. 4h für Körperpflege, Essen, Wege, sonstiges. ...

Körperpflege: 30 Minuten max! (u. ich stinke nicht!)

Essen: 10 Minuten (hier nutze ich Multitasking! Ich esse und arbeite gleichzeitig! Wenn jemand wissen will wie das geht, könnte ich auch ein YouTube Video zur Verfügung stellen. Allerdings braucht es auch Zeit die Brotkrümel u. Haferflocken hinter den Tastaturtasten zu entfernen)

Hinter Sonstiges kann sich natürliches vieles verbergen ...calippo schrieb:... ca. 4h ... Wege, sonstiges. ...

Ähm, ich bin seit 2 Jahren im HomeOffice. Der Penny-Markt ist in weniger als 10 Minuten zu Fuss erreichbar!

Also ich finde deine Kalkulation nicht schlüssig ... Ich habe deutlich mehr als 4h zur freien Verfügung!

Hier solltest du nochmal in dich gehen und die Zeiträume relativieren.

In meinem Fall (Zeitangaben pro Tag in Stunden(h)):

Spielen: 4

Arbeiten: 4 (an Wochenenden muss ich nicht arbeiten)

Die Kalkulation bezieht sich auf einen Durchschnittmenschen. Dass es Extreme gibt, ist doch klar.Makkaroni schrieb:Also ich finde deine Kalkulation nicht schlüssig ...

Ich kenne übrigens auch einige Extreme in Sachen wesentlich höherer Arbeitszeit.

Hier ging es ursprünglich ja um die Mehrkosten durch die erhöhte Stromaufnahme solcher Karten und wie wir gesehen haben, sind die Mehrkosten selbst im Extrembereich vergleichsweise gering. Da zitiere ich mich selbst

Ich bleibe aber dabei, im Durchschnitt spielen selbst Käufer von High-End Grafikkarten nicht 4h am Tag, für die sind die zusätzlichen Kosten noch überschaubarer. Das es Phasen mit erhöhter Spielzeit gibt, ist auch klar. Normalerweise gefolgt von Phasen, in denen man weniger spielt. Das muss man über die Lebenszeit der Karte nivellieren, z.B. über 5 Jahre.calippo schrieb:Selbst wenn jemand sein Leben komplett Gaming widmen würde, also 16h am Tag dauerzocken bei 1000 Watt und die kWh 40 Cent kostet, sind das 6,4€ Stromkosten am Tag, so viel wie eine Schachtel Zigaretten.

Äh nein, das will ich nicht wissen. Ich esse ganz gerne am Tisch und zwar in Gesellschaft und Sachen, die ich selbst gekocht habe. Das dauert dann halt etwas länger.Makkaroni schrieb:Wenn jemand wissen will wie das geht, könnte ich auch ein YouTube Video zur Verfügung stellen.

Aber wenn es für Dich passt, ist doch gut.

Bei mir sind 150W das Ziel und 200W die Schmerzgrenze. Mit FullHD ja mittlerweile sogar gut machbar, aber dummerweise steigen die Ansprüche bezüglich Monitorgröße und -auflösung.Schultzie schrieb:Mir würde eine vernünftige Lösung kleiner 200 Watt schon reichen :-)

Flare

Commander

- Registriert

- Aug. 2010

- Beiträge

- 2.068

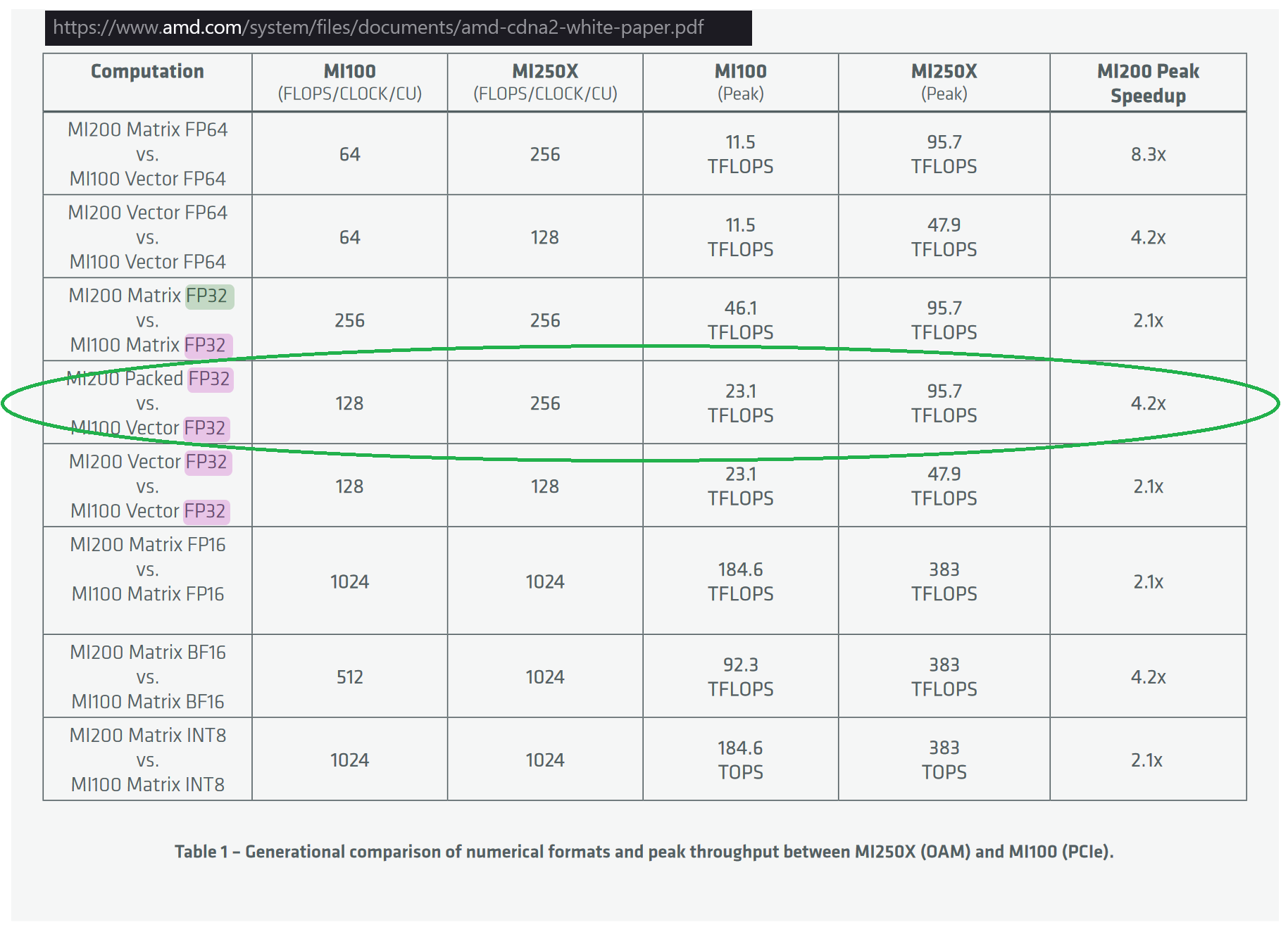

ähh nur ganz nebenbei CDNA2 kann "Packed FP32" warum soll RDNA3 das nicht auch können

der pro Kern und Takt Zuwachs wäre x2

hier Seite 10 https://www.amd.com/system/files/documents/amd-cdna2-white-paper.pdf

der pro Kern und Takt Zuwachs wäre x2

hier Seite 10 https://www.amd.com/system/files/documents/amd-cdna2-white-paper.pdf

So wie ich es verstehe sind die Packed FP32 ein Nebenprodukt der FP64 Einheiten. Diese können eine FP64 Operation oder 2 FP32 Operationen parallel ausführen. Das sind dann die Packed.Flare schrieb:ähh nur ganz nebenbei CDNA2 kann "Packed FP32" warum soll RDNA3 das nicht auch können

der pro Kern und Takt Zuwachs wäre x2

RDNA3 hat FP32 Einheiten und die können je Einheit nur eine FP32 Operation.

Wie @ETI1120 schon sagte klappt das nur in AMDs Datacenter-GPUs, die deutlich ausgebaute FP64-Einheiten haben. Die brauchen aber jede Menge Die-Fläche, da ist es sinnvoller, wenn man die Anzahl an FP32-Shader verdoppelt.Flare schrieb:ähh nur ganz nebenbei CDNA2 kann "Packed FP32" warum soll RDNA3 das nicht auch können

der pro Kern und Takt Zuwachs wäre x2

Kraeuterbutter

Admiral

- Registriert

- Nov. 2007

- Beiträge

- 7.781

4090, rx7900 - für die meisten doch wohl eh uninteressant

spannender wäre: was wird 3090-Leistung mit der 4000-Serie kosten, verbrauchen

'

wird es eine 4070 geben mit der Leistung einer 3090, aber zu deutlich günstigerem Preis ?

wenn nicht, ist die ganze 4000er-Geschichte eh schon weit weniger interessant

ja, toll was möglich ist, mit 900Watt und 2800Euro für ne Grafikkarte - relevant für die meisten hier? eher nein

spannender wäre: was wird 3090-Leistung mit der 4000-Serie kosten, verbrauchen

'

wird es eine 4070 geben mit der Leistung einer 3090, aber zu deutlich günstigerem Preis ?

wenn nicht, ist die ganze 4000er-Geschichte eh schon weit weniger interessant

ja, toll was möglich ist, mit 900Watt und 2800Euro für ne Grafikkarte - relevant für die meisten hier? eher nein

Ähnliche Themen

- Antworten

- 516

- Aufrufe

- 96.173

- Antworten

- 187

- Aufrufe

- 40.305