branhalor schrieb:

Naja, die Frage ist ja immer: Wer enrtscheidet, was nötig ist und was unnötig...?

Ich würde ja sagen, das sollte jeder für sich selbst entscheiden, aber man sieht ja, wenn man sich umschaut, wohin das die Gesellschaft bringt

branhalor schrieb:

Selbst den Tiefkühler bräuchte es nicht unbedingt, wenn wir anders haushalten würden.

Vermutlich auch eine Grundsatzdebatte, was klimafreundlicher ist: täglicher Einkauf oder ein Tiefkühler? Aber das ist glaub eine Grundsatzdiskussion, die hier definitiv nichts verloren hat

branhalor schrieb:

Raytracing [...] VR [...]

Hat irgendjemand auf diesem Planeten einen konkreten Nutzen davon: Ja, u.a. die Medizintechnik.

Raytracing und VR haben ihren Einsatz in Wirtschaft und Wissenschaft, und da finde ich persönlich es nicht ganz so kritisch, wenn ein Mehrwert daraus entsteht. Wenn etwa durch RT-Cores die Renderzeit eines Films auf gleicher Hardware theoretisch halbiert werden kann, ist das gut. Wenn Ärzte an VR-Headsets besser ausgebildet werden können, ist auch das ein Mehrwert für die Gesellschaft.

Die Frage ist ja nur, ob sich die Spielzeit für einen reduziert, weil man Raytracing benutzen kann. Hier kann man argumentieren, dass es die Spieleentwicklung beschleunigen würde, weil man vorgefertigte APIs hat für Reflektionen, aber, wenn wir ehrlich sind, bräuchten die meisten Spiele eher mehr als weniger Entwicklungszeit

branhalor schrieb:

Da bin ich rein theoretisch absolut Deiner Meinung.

Aber auch da ist das System als ganzes "Schuld" dran, der Kapitalismus (und nein: Ich bin kein Kommunist

) und damit auch wir als Konsumenten: Heute gilt ausschließlich "schneller, höher, weiter".

Darum braucht es ja Regulationen

Ich persönlich bin ohnehin der Meinung, dass wir global betrachtet ohnehin von keinem freien Markt mehr sprechen können, wenn wir Staaten wie China, aber auch die USA, haben, welche den Markt entweder durch Investitionen oder Zahlungssperren lenken können, wie sie möchten. Anderes Thema für andere Zeiten.

branhalor schrieb:

Aber - um es mal wieder in einem Bild auszudrücken - wenn unsere Straße den "Preis der saubersten Straße" gewinnen will, nutzt es nichts, wenn ich vor meiner Tür auch noch die letzten drei Moosklumpen und Laubblätter wegfege, solange andere in der Nachbarschaft absolut keinen Handschlag rühren. Der Gesamtlevel und die Gesamteffizienz - die ersten 80% - müssen erstmal gewuchtet werden, bevor ich mir um die letzten 20 und insb. die letzten 20 bei Otto-Normalverbraucher Gedanken mache.

Ich würde das jetzt mal als fatalistischen Utilitarismus bezeichnen

Aber genau das bringt ja auch nicht weiter. Wir können nicht den Saubersten-Straße-Preis gewinnen, wenn wir nur darauf warten, dass der Nachbar sich bewegt. Und ja, ich hab gelesen, dass du dich selbst zurückhältst. Das Problem ist halt nur, dass von (zu) vielen Leuten die selbe Meinung vertreten wird, die sich aber dennoch nicht zurückhalten.

branhalor schrieb:

=> Ich tue, was ich kann, bis zu einem gewissen Punkt, s. oben - aber dann haben Politik und Wirtschaft bitte ihrerseits erst einmal dafür zu sorgen, daß auch andere Bereiche nachziehen - und zwar global - nicht nur in NRW, Bayern oder Deutschland.

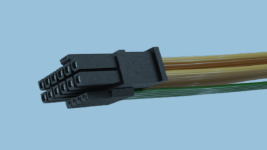

Und entsprechend finde ich einen Stecker, welcher für eine Dauerlast von 600W ausgelegt ist, als kritisch. Weil im Endkonsumentenbereich wird es sicherlich nicht lange dauern, bis es Karten gibt, welche das ausreizen. Schlicht und einfach, weil sie es können. Wie gesagt, 500+W Peaks sind jetzt schon real. Entsprechend wird es auch Leute geben, die diese Karte verbauen müssen, schlicht und einfach, weil sie es können.

Und dann minen, schlicht und einfach, weil sie es können.

Es ist einfach ein Teufelskreis, der sich hier auftut: GPUs mit steigendem Verbrauch, CPUs mit steigendem Verbrauch, SSDs mit steigendem Verbrauch, alles will und will mehr verbrauchen...

Eigentlich ist es doch absurd, dass gerade eine Firma wie Apple es schafft, effiziente Prozessoren zu produzieren, welche die Workflows minimal langsamer als Highend-Maschinen hinbekommen, bei zeitgleich massiv geringerem Energiebedarf.

Wechhe schrieb:

Eben auch die Monsterkarten mit 600 Watt. Und da sind 600 Watt vielleicht sogar noch knapp bemessen.

Wenn du von Data Center GPUs sprichst, die haben sowieso ganz andere Anschlüsse. Da kommst mit deinem ATX-Netzteil nicht weit.