Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

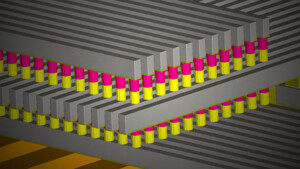

News Intel zeigt Projekt „Wolfenstein: Ray Traced“

- Ersteller MichaG

- Erstellt am

- Zur News: Intel zeigt Projekt „Wolfenstein: Ray Traced“

SilentBTBK

Lt. Junior Grade

- Registriert

- Aug. 2005

- Beiträge

- 421

Interessanter Beitrag. Der Typ der hats wohl auch drauf.

Aber BITTE schickt ihn für minimum ein halbes Jahr nach England oder in die USA

Aber BITTE schickt ihn für minimum ein halbes Jahr nach England oder in die USA

N

noman_

Gast

Die Technik ist vor allem für den Filme und Animations-bereich interessant!

Einige Bilder lassen sich sicher noch an der Workstation über Nacht rendern.

Aber ein 30 Sekunden Clip mit 840 Bildern und 4k Auflösung ist eine Angelegenheit für mehrere Tage.

So schickt man es einfach direkt aus seiner Anwendung zu einem Cluster (Cloud Service), geht Mittagessen und hat nach 30 Minuten (anstatt Stunden) das Ergebnis.

Jyskall ist gerade online Antwort

Ich habe mal ein Interview mit James Cameron gelesen, in dem er meinte, dass er Avatar gerne mit 48FPS rendern hätte lassen (statt der heute üblichen 24FPS) - doch das hätte natürlich den Rechenaufwand verdopppelt und hätte damit zu lange gedauert bzw. wäre zu teuer gewesen. Wenn Intel da in Zukunft etwas verbessern kann dann immer her mit der neuen Technik

T

Techlogi

Gast

Man hätte lieber Nägel mit Köpfen machen sollen und somit Crysis mit mster-config nehmen.MixMasterMike schrieb:Wirklich toll aussehen tut das alles nicht.

TomTurbro

Lieutenant

- Registriert

- Sep. 2009

- Beiträge

- 927

Dude-01 schrieb:Schöne Entwicklung die meiner Meinung nach aber langsam in die falsche Richtung geht! Wie die meisten hier schon geschrieben haben, ist es ihnen egal ob das Licht zu 100% realistisch vom Glasgebrochen wird oder ob es eine vorgerenderte Szene ist!

Sag sowas nicht, es gibt immerhin PhysX und das verkauft sich auch spitze!

Farcrei

Commander

- Registriert

- Aug. 2006

- Beiträge

- 2.076

Nuerne89 schrieb:Wolfenstein - wie geil is das denn?

Is zwar zensiert, aber dennoch echt kultig^^

KAOZNAKE

Captain

- Registriert

- Aug. 2007

- Beiträge

- 3.844

SilentBTBK schrieb:Interessanter Beitrag. Der Typ der hats wohl auch drauf.

Aber BITTE schickt ihn für minimum ein halbes Jahr nach England oder in die USA

Der lebt da

Im Jahr 2008 zog er von Deutschland ins sonnige Kalifornien, wo er die Arbeit an spiele-relevantem Raytracing bei Intel fortsetzt.

@topic: IMO dauert das noch minimum 10 Jahre, bevor wir davon auch nur annähernd was auf unseren PCs zu sehen bekommen. Evtl. wird eine neue (nicht die nächste!!) Konsolengeneration den Zeitenwechsel einläuten, denn auf so einer geschlossenen Plattform geht sowas ja bekanntlich leichter.

Rasterisierung bleibt ja auch nicht stehen, so dass wir wohl noch 20 Jahre oder mehr auf Raytracing@home warten dürfen...

Vidy_Z

Lieutenant

- Registriert

- Okt. 2009

- Beiträge

- 851

Meine anfängliche Begeisterung für die RT Arbeiten von Intel ist einer Enttäuschung Gewischen. Ü 10 Jahre Auseinandersetznug mit der Thematik, und als Ergebnis nicht mal einen eigenständige Engine, sondern nur eine Modifizierte Wolfensteinengine aus der Steinzeit, welche als Hightlight gerade mal Spiegelungen und Refraktionen physikalisch korrekt darstellt? Was ist mit dem, was Raytracing erst wirklich attraktiv macht, der Global Illumination? Was ist mit den Tonnen an anderen Futures, welche man von einem modernem Spiel erwartet: Bump- bzw. Displacemantmaping, Tesselation, Physik, Partikelsystemen welche ihren Namen auch wirklich verdiehnen, DOV, Motion Blur, usw. usw. Was ist eigentlich das Ziel dieser Entwicklung? Will Intel damit wirklich eine konkurrenzfähige Gameengine auf die Beine Stellen? Mir kommt das so vor, wie eine ewige Grundlagenforschung, die einfach nicht in die Gänge kommen will.

Außerdem: die Konkkurenz schläft nicht. Als Beispiel sei mal die Beast Engine genannt.

Außerdem: die Konkkurenz schläft nicht. Als Beispiel sei mal die Beast Engine genannt.

Karre

Retro-PC Admiral

- Registriert

- Apr. 2010

- Beiträge

- 8.483

was hat die engine mit raytracing zu tun?!

die spiegelungen sind absoluter wahnsinn .. so exakt kann es derzeit kein spiel darstellen ... genauso ist die polygonanzahl des kronleuchters ebenso exorbitant hoch .. für jede glasmurmel an dem ding wird die lichtbrchung exakt berechnet ... das ganze ist nur eine machbarkeitsstudie .. und keine engine die zum spielen gedacht ist -.- ..

mal davon abegsehen, das es um die performance der intelkarte geht und nicht um spiele

die spiegelungen sind absoluter wahnsinn .. so exakt kann es derzeit kein spiel darstellen ... genauso ist die polygonanzahl des kronleuchters ebenso exorbitant hoch .. für jede glasmurmel an dem ding wird die lichtbrchung exakt berechnet ... das ganze ist nur eine machbarkeitsstudie .. und keine engine die zum spielen gedacht ist -.- ..

mal davon abegsehen, das es um die performance der intelkarte geht und nicht um spiele

Zuletzt bearbeitet:

Vidy_Z

Lieutenant

- Registriert

- Okt. 2009

- Beiträge

- 851

Das es machbar ist, wissen wir doch nach über 10 Jahren Machbarkeitsstudie. Wo geht also die Reise hin?

Im Endefekt kann das Ziel doch nur Realismus sein. Und das was Intel zeigt, macht nicht den Eindruk von Realismus. Die ganze schöne Perfektion in der Strahlenverfolgung durch das Glas und über die verspiegelten Flächen, wird doch kompromitiert durch die veraltete und absolut unrealistische Szenenausleuchtung. Nach dieser langen Forschungszeit, wäre es da nicht mal angebracht, die GI in die Frage der Machbarkeit mit einzubeziehen? Ohne GI interessiert Raytrace eigentlich doch kaum noch jemanden. Die Zeiten sind lange vorbei.

Noch ein Beispiel in dem Das Licht nicht vorberechnet und auf die Texturen gemapt wird, sondern in Echzeit berechnet: Enlight.

Im Endefekt kann das Ziel doch nur Realismus sein. Und das was Intel zeigt, macht nicht den Eindruk von Realismus. Die ganze schöne Perfektion in der Strahlenverfolgung durch das Glas und über die verspiegelten Flächen, wird doch kompromitiert durch die veraltete und absolut unrealistische Szenenausleuchtung. Nach dieser langen Forschungszeit, wäre es da nicht mal angebracht, die GI in die Frage der Machbarkeit mit einzubeziehen? Ohne GI interessiert Raytrace eigentlich doch kaum noch jemanden. Die Zeiten sind lange vorbei.

Noch ein Beispiel in dem Das Licht nicht vorberechnet und auf die Texturen gemapt wird, sondern in Echzeit berechnet: Enlight.

iliketurtles

Lieutenant

- Registriert

- Mai 2010

- Beiträge

- 612

wenn es vernünftige intel gpus gibt , bin ich warscheinlich schon in der kiste

balanceKeeper

Cadet 4th Year

- Registriert

- Juni 2008

- Beiträge

- 75

Daniel hat eben gesagt, dass es gestreamt wird.. Hab mich auch zuerst gewundert, warum das so ruckelt, liegt wohl an der Internetverbindung dort...

Zumindest haben die schon deutlichen Vorsprung seit der letzen Ankündigung dort erzielt und das erfreut mich. Es geht hierbei um die Erforschung der fürs Echtzeit-Raytracing erforderlichen Einsatz notwendigen Algorithmen und Techniken.

Für die Grafik-Liebhaber heißt es in ein Paar Jahren: deutlich mehr Realismus und verdammt geile Grafik.

Für die Grafik-Programmierer, für die 3D-Künstler, etc... heißt es mehr Möglichkeiten und leichtere Handhabung, um Größeres zu erzielen.

Bald wird man wohl auch einige Physik-Kurse für die Grafikprogrammierung nehmen müssen...

So Optik und Co. =)

freue mich auf dich weitere Entwicklung, yeah!

Zumindest haben die schon deutlichen Vorsprung seit der letzen Ankündigung dort erzielt und das erfreut mich. Es geht hierbei um die Erforschung der fürs Echtzeit-Raytracing erforderlichen Einsatz notwendigen Algorithmen und Techniken.

Für die Grafik-Liebhaber heißt es in ein Paar Jahren: deutlich mehr Realismus und verdammt geile Grafik.

Für die Grafik-Programmierer, für die 3D-Künstler, etc... heißt es mehr Möglichkeiten und leichtere Handhabung, um Größeres zu erzielen.

Bald wird man wohl auch einige Physik-Kurse für die Grafikprogrammierung nehmen müssen...

So Optik und Co. =)

freue mich auf dich weitere Entwicklung, yeah!

JokerGermany

Banned

- Registriert

- März 2009

- Beiträge

- 1.546

Lol, Intel nutzt ne AMD Grafikkarte XD

@Topic:

In nem Jahrzehnt ist es Marktfähig

@Englischmoserer:

Man sollte schon am Anfang des Videos zuhören.

Dann kennt man den Namen und kann Googlen und dann brauch man keinen Stuss labern

PS:

Der Laptop war entweder nagelneu oder gut gereinigt...

@Topic:

In nem Jahrzehnt ist es Marktfähig

@Englischmoserer:

Man sollte schon am Anfang des Videos zuhören.

Dann kennt man den Namen und kann Googlen und dann brauch man keinen Stuss labern

PS:

Der Laptop war entweder nagelneu oder gut gereinigt...

Dark Thoughts

Fleet Admiral

- Registriert

- Aug. 2007

- Beiträge

- 10.218

Wieso sind trotz Raytracing trotzdem noch Kanten beim Zielfernrohr zu sehen?

Bei einem Rundbogen kann man es ja noch verstehen, hier wird real ja auch so gearbeitet teilweise aber bei einem Objekt was Rund sein soll?

Bei einem Rundbogen kann man es ja noch verstehen, hier wird real ja auch so gearbeitet teilweise aber bei einem Objekt was Rund sein soll?

darkarchon

Commander

- Registriert

- Jan. 2007

- Beiträge

- 2.429

@I-HaTeD2, die haben die ganzen Models fuer das Spiel nicht umgeschrieben, wohl nur die ganzen Shader die verwendet wurden. Rein theoretisch ist mit Raytracing aber weit Maechtigeres moeglich... beliebig viele Polygone bei fast konstanter Last und so.

Dark Thoughts

Fleet Admiral

- Registriert

- Aug. 2007

- Beiträge

- 10.218

Ich dachte in Raytracing würde man weg von Polygonen gehen?

Und die Anzahl der Polygone ist durch die jeweilige GPU limitiert?

Das mehr möglich ist, ist schon klar - teilweise sehr realistisch was aber auch einen extremen Rechenaufwand bedeutet. Wenn man aber zeigen will wie Wolfenstein oder Spiel XYZ in Raytracing aussieht sollte man schon ein wenig mehr das nutzen was man ja anpreist.

Und die Anzahl der Polygone ist durch die jeweilige GPU limitiert?

Das mehr möglich ist, ist schon klar - teilweise sehr realistisch was aber auch einen extremen Rechenaufwand bedeutet. Wenn man aber zeigen will wie Wolfenstein oder Spiel XYZ in Raytracing aussieht sollte man schon ein wenig mehr das nutzen was man ja anpreist.

Blutschlumpf

Fleet Admiral

- Registriert

- März 2001

- Beiträge

- 20.414

Warum ?SilentBTBK schrieb:Aber BITTE schickt ihn für minimum ein halbes Jahr nach England oder in die USA

Imo spricht der verständlicher als fast alle Amis oder Tommies die man in so Filmen sieht/hört.

Vidy_Z

Lieutenant

- Registriert

- Okt. 2009

- Beiträge

- 851

Raytracing basiert nach wie vor auf Poligonen. Selbst profesionelle non realtime Renderer überwinden das Problem der Kantenglättung mit darauf ausgerichteten Rechenalgorythmen. Ganz ohne Poligone arbeiten Voxelgraphiken. So wie ich das verstanden habe, teilt eine Voxelengine eine Szene in Räume auf, ähnlich wie Photoshop ein Bild in Pixel zerlegt, das ganze aber in 3d.

MilchKuh Trude

Captain Pro

- Registriert

- Dez. 2006

- Beiträge

- 3.230

@Blutschlumpf: Ich fand es hört sich grausam an. Ich habe zwar auch immernoch den deutschen Dialekt, aber nach 2 jahren Amerika sollte sich das schon besser anhören.

Ähnliche Themen

- Antworten

- 51

- Aufrufe

- 5.820