matzep schrieb:

Ich denke wir kommen in Regionen in denen Cloudgaming günstiger wird wie die eigene Hardware zu nutzen

Welche Leistung wird denn per Cloudgaming zur Verfügung gestellt?

Bei Xbox Cloud Gaming meines Wissens maximal ein 1080p-Stream. Selbst wenn da am anderen Ende Xbox Series X die native Grafik berechnen, kommt beim Spieler eine deutlich verringerte Bildqualität an (1080p mit Streaming-Artefakten), die noch unter einer Xbox Series S liegt.

Da können vermutlich eine RTX 1070 / 2060 / 3050 oder eine RX 5700 / RX 6600 bereits eine bessere Kombination aus Bildqualität und Performance liefern. Eine zukünftige RTX 4050 und RX 7600 auf jeden Fall.

Bei PS Now / PS+ Premium sieht es noch übler aus. 720p bis 1080p, maximal PS4-Spiele.

PS5-Spiele lassen sich nicht streamen:

https://www.play3.de/2022/05/24/ps-plus-premium-ps5-spiele-koennen-nicht-gestreamt-werden/

Somit maximal eine Leistung/Bildqualität, die ein Steam Deck mit 5 -15 Watt TDP-Limit (ca. 15 - 25 Watt für das komplette Gerät inkl. Display je nach Spiel und Settings) abdecken kann. Oder neuere PC-Handhelds mit AMD 6800U, die (bei ein paar Watt mehr) noch etwas schneller sind.

Bei Shadow-PC für mtl. 29,99 € (jährlich 360 €) ist man meines Wissens auf GTX1080-Performance stehengeblieben.

Stadia ist bald Geschichte.

Von Nvidia bekommt man maximal die Leistung einer RTX 3080, da gibt es noch keine Ankündigung, dass es für mtl. 19,99 € (jährlich 240 €) zukünftig mehr Leistung gibt. Aber warum sollten sie da die Performance für einen gleichbleibenden Preis weiter erhöhen ohne Streaming-Konkurrenz bei Performance über GTX 1080?

Mit einer zukünftigen RTX 4060 oder RX 7700 wird man vermutlich nahe an die RTX-3080-Streaming-Performance herankommen und bei Bildqualität (keine Streaming-Artefakte) und Input-Lag punkten... insgesamt vermutlich das bessere Spielerlebnis.

Und sowohl RTX 4060 als auch RX 7700 dürften effizienter und günstiger als eine RTX 3080 oder RX 6800 XT in den letzten Jahren sein, wogegen ich bei Geforce Now keine Preissenkuing für RTX-3080-Leistung sehe.

tidus1979 schrieb:

Wo ist denn der Mehrwert dieser Dinosaurier? All das für Videospiele? Die man auch vergleichbar gut auf einem Mini-PC ("Konsole") spielen kann? Mir kommt es so vor, als ob die Spieleindustrie und die Hardwareindustrie sich da aus Faulheit und Gier gegenseitig hochschaukeln. Spielentwickler sparen sich Optimierungen und verlangen von den Spielern nach immer stärkerer Hardware.

Wo schaukelt denn die Spieleindustrie derzeit mit?

Auch zwei Jahren nach dem Start von PS5 + Xbox Series X gibt es bisher kaum Spiele, die nicht auch auf PS4, Xbox One oder vergleichbarem PC laufen... selbst ein Cyberpunk läuft grundsätzlich auf dem Steam Deck mit über 30 fps.

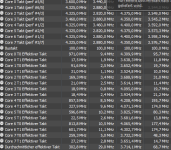

Und was ist in den letzten zwei Jahren groß hardwareforderndes herausgekommen, was eine 4 Jahre alte Mittelklassekarte (RTX 2060 / RX 5600 XT) oder eine 6 Jahre alte Oberklassekarte (GTX 1080 / Vega 56/64) mit 1080p/60 fps auf "medium/high"-Preset nicht packt?