Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Nvidia GeForce GTX 280 im Idle bei 25 Watt

- Ersteller Tommy

- Erstellt am

- Zur News: Nvidia GeForce GTX 280 im Idle bei 25 Watt

Das ganze wird noch einmal zurückfeuern, denn so wenig Verbrauch bei solch einem Monsterchip ist... nun, manchmal muß man eben Glauben haben, der ja Berge versetzen (und PC-Hardware beschönigen) kann. Laut der Marketingabteilung war bestimmt auch einst der R600 ein echter Stromsparer.

Tinpoint

Admiral

- Registriert

- Okt. 2007

- Beiträge

- 9.986

@orbmu2k

wie einige hier aber schon erwähnt haben sind die angaben der 9800 GTX zweifelhaft die verbraucht bissel mehr als 80W im 3DMark

unterschied könnte durch optimierungen im Hybrid sli erreicht werden ( natürlich geraten )

aber ich würde mal die ganzen angaben dort hinterfragen !!

wie einige hier aber schon erwähnt haben sind die angaben der 9800 GTX zweifelhaft die verbraucht bissel mehr als 80W im 3DMark

unterschied könnte durch optimierungen im Hybrid sli erreicht werden ( natürlich geraten )

aber ich würde mal die ganzen angaben dort hinterfragen !!

Kasmopaya

Banned

- Registriert

- Mai 2007

- Beiträge

- 12.285

@bullethunter69

Stimmt, das haben sie auch schon beim G80 so gemacht, echt fies von Nvidia: (2006 CEO:die GF8 hat keine unified Shader; Launch des G80 CEO: oh doch das hat sie und sie ist verdammt schnell)

Die gleiche Situation wie beim G80 2006: Die GT200 der nächste Brute-Force-Chip wird einschlagen wie eine Bombe...

MfG Kasmo

Stimmt, das haben sie auch schon beim G80 so gemacht, echt fies von Nvidia: (2006 CEO:die GF8 hat keine unified Shader; Launch des G80 CEO: oh doch das hat sie und sie ist verdammt schnell)

Die gleiche Situation wie beim G80 2006: Die GT200 der nächste Brute-Force-Chip wird einschlagen wie eine Bombe...

Bei CF und SLI Systemen schon, stimmtim PC bereich heißt das glaube ich aber immer noch Plug & Pray

MfG Kasmo

Zuletzt bearbeitet:

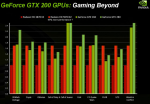

bensch87 schrieb:Traue keiner Statistik, die du nicht selbst gefälscht hast. Die untere Grafik ist typisch Konkurrenz schlecht dastehen lassen: durch die absichtlich ungünstige Balkendarstellung siehts auf den ersten Blick so aus, als ob die neue GeForce gleich 10 mal schneller als die X2er Radeon wird. Echt lächerlich dieses Statistikgemanipuliere.

viel interessanter als der vergleich zur 3870x2 ist der vergleich von gtx280 zu gtx260. diese scheint ja etwa 20 prozent langsamer zu sein. ausgenommen CoJ und WiC

... Darauf hab ich schon lange gewartet. Das wäre der einzige Grund fuer mich von der gf8800gts umzusteigen, würde ich noch genug zocken :/

Ich persöhnlich finde es extrem nervig das mein CPU mit 10w vor sich hin idlet mit 1ghz und fast alles machen kann während die Grakka fröhlich vor sich hinschmorrt.

Absolut top : -)

Hoffentlich koennen sie's in Zukunft noch weiter optimieren und den Verbrauch senken, aber der anfang hört sich auf jedenfall mal gut an.

Ich persöhnlich finde es extrem nervig das mein CPU mit 10w vor sich hin idlet mit 1ghz und fast alles machen kann während die Grakka fröhlich vor sich hinschmorrt.

Absolut top : -)

Hoffentlich koennen sie's in Zukunft noch weiter optimieren und den Verbrauch senken, aber der anfang hört sich auf jedenfall mal gut an.

drago-museweni

Admiral Pro

- Registriert

- März 2004

- Beiträge

- 9.207

Wahnsinn super Nachrichten wenn das wirklich so ist ist, wird die GTX280/260 wieder sehr interesant, und es wird für ATI doch nicht so leicht trotz des besseren Preises.

Aber mehr wissen wir erst nach Opjektiven Tests von CB zb, usw.

Aber mehr wissen wir erst nach Opjektiven Tests von CB zb, usw.

Zuletzt bearbeitet:

T

towa

Gast

Na da sollte man mal abwarten wie sich das im Vergleich anstellt 240W sind ja nicht umsonst die TDP,d as die nie bzw. selten erreicht wird ist ja klar aber da sollte man abwarten was NV da zu bieten hat.

Am besten kommen se dann nun auch noch mit DX10.1 ;D

Am besten kommen se dann nun auch noch mit DX10.1 ;D

Unyu

Banned

- Registriert

- Okt. 2004

- Beiträge

- 6.891

3DMark06 ist heftig CPU limitiert. -> Nicht 100% Volllast.KonKorT schrieb:Xbitlabs hat bei der 9800 GTX unter Last 108 Watt gemessen, Nvidia gibt auf seiner Folie 80 Watt an - das sagt schon so einiges.

Ja, diese 2 Posts sind echt Schwachsinn.Sgt.Speirs schrieb:Ich zitiere mal 2 Kommentare zum gleichen Bild, dass im "Die-Plot"-Thread auch aufgetaucht ist.

Es geht hier nicht ums Gesamtsystem.

Eine 3870 verballert im Idle 19W.

MacroWelle

Commander

- Registriert

- Apr. 2006

- Beiträge

- 2.239

Seufz...also:

Kein Mensch weiß irgendwas über die Umstände, unter denen die Testwerte entstanden sind. Dass die Idle-Werte der GTX 280 mit Hybrid-SLI entstanden sein könnten, ist nur der Anfang.

Bei etwa doppelt so großen Chips, einem breiterem Speicherinterface und 65nm-Fertigung geht da nicht viel. Die HD4xxx-Serie soll - wie schon der Vorgänger - im Idle zwischen fünf und zehn Watt brauchen. PowerPlay und auch UVD (-> Blueray) wurden angeblich verbessert.

Also...warten auf Tests, unabhängige Messungen werden dann die Wahrheit hervorzaubern - ich sage nicht, dass die Werte garantiert geschönt sind. Aber, die letzte Grafik in der News geht an die Grenzen der Seriosität (auch wenn die Konkurrenz sicher ebenfalls trickst). Da hätte CB ruhig was zu sagen können, die ersten (temporären) Propaganda-Opfer schlugen hier ja schon im Forum auf. Oder noch besser - die Werte aus der Grafik in ein eigenes, wahrheitsgetreues Diagramm übersetzen.

Kein Mensch weiß irgendwas über die Umstände, unter denen die Testwerte entstanden sind. Dass die Idle-Werte der GTX 280 mit Hybrid-SLI entstanden sein könnten, ist nur der Anfang.

Bei etwa doppelt so großen Chips, einem breiterem Speicherinterface und 65nm-Fertigung geht da nicht viel. Die HD4xxx-Serie soll - wie schon der Vorgänger - im Idle zwischen fünf und zehn Watt brauchen. PowerPlay und auch UVD (-> Blueray) wurden angeblich verbessert.

Also...warten auf Tests, unabhängige Messungen werden dann die Wahrheit hervorzaubern - ich sage nicht, dass die Werte garantiert geschönt sind. Aber, die letzte Grafik in der News geht an die Grenzen der Seriosität (auch wenn die Konkurrenz sicher ebenfalls trickst). Da hätte CB ruhig was zu sagen können, die ersten (temporären) Propaganda-Opfer schlugen hier ja schon im Forum auf. Oder noch besser - die Werte aus der Grafik in ein eigenes, wahrheitsgetreues Diagramm übersetzen.

KAOZNAKE

Captain

- Registriert

- Aug. 2007

- Beiträge

- 3.844

Dazu fällt mir nur ein, das NVDIA schon immer ganz groß war im Statistiken fälschen. Die haben auch schon behauptet, das die 2900 kein 2560x1600 HD Zeugs abspielen kann.

http://www.theinquirer.net/gb/inquirer/news/2007/10/25/nvidia-slides-reveal-masterhood

Folie 20. Sonst auch ganz lustig.

Ehrlich, der Verein wird mir immer unsympathischer. Dann schon wieder sone komische Folie wo der Gegner auf den ersten Blick so schlecht abschneidet, das man schon weinen möchte. Und dann kein Wort über Testbedingungen, Treiber (wie man hört neuester NV-Treiber, was ja auch logisch ist, aber dann nur den 8.3 Catalyst, wer weiß, wahrscheinlich ists der 7.12). Wahrscheinlich sind jeweils die ungünstigsten Testbedingungen für die 3870X2 rausgesucht.

Und so weiter...

Sag niemals nie, aber ich werd nie wieder ne NVIDIA Graka kaufen. Da kauf ich eher ne INTEL Graka.

So long...

Stromsparfolie kannste genauso vergessen, ist wahrscheinlich eh nur der Onboard-Grafikchip, und bei der 98GTX ist Hybrid SLI natürlich deaktiviert

LOL

Naja und die ersten fallen schon wieder drauf rein.

http://www.theinquirer.net/gb/inquirer/news/2007/10/25/nvidia-slides-reveal-masterhood

Folie 20. Sonst auch ganz lustig.

Ehrlich, der Verein wird mir immer unsympathischer. Dann schon wieder sone komische Folie wo der Gegner auf den ersten Blick so schlecht abschneidet, das man schon weinen möchte. Und dann kein Wort über Testbedingungen, Treiber (wie man hört neuester NV-Treiber, was ja auch logisch ist, aber dann nur den 8.3 Catalyst, wer weiß, wahrscheinlich ists der 7.12). Wahrscheinlich sind jeweils die ungünstigsten Testbedingungen für die 3870X2 rausgesucht.

Und so weiter...

Sag niemals nie, aber ich werd nie wieder ne NVIDIA Graka kaufen. Da kauf ich eher ne INTEL Graka.

So long...

Stromsparfolie kannste genauso vergessen, ist wahrscheinlich eh nur der Onboard-Grafikchip, und bei der 98GTX ist Hybrid SLI natürlich deaktiviert

LOL

Naja und die ersten fallen schon wieder drauf rein.

mapel110

Lieutenant

- Registriert

- März 2003

- Beiträge

- 990

Alles spricht dafür, dass nvidia kein D3D10.1 bieten wird. Schade, aber sowas gabs schon öfters.

ATI hat ja auch SM2 geboten, als nvidia schon SM3 auf dem Markt hatte und das war ein ganzer Technologielevel und nicht bloß ein paar Features wie es ein .1 bei D3D10 bietet.

Ansonsten natürlich gut, dass der Idle-Verbrauch sinkt, aber im 3DCenter läuft gerade eine Diskussion zum Switch zwischen Idle und Volllast. Dabei könnten viele Netzteile streiken.

http://www.forum-3dcenter.org/vbulletin/showpost.php?p=6550177&postcount=9

ATI hat ja auch SM2 geboten, als nvidia schon SM3 auf dem Markt hatte und das war ein ganzer Technologielevel und nicht bloß ein paar Features wie es ein .1 bei D3D10 bietet.

Ansonsten natürlich gut, dass der Idle-Verbrauch sinkt, aber im 3DCenter läuft gerade eine Diskussion zum Switch zwischen Idle und Volllast. Dabei könnten viele Netzteile streiken.

http://www.forum-3dcenter.org/vbulletin/showpost.php?p=6550177&postcount=9

Dass Hybrid SLI jetzt schlecht da steht sehe ich übrigens nicht so. Wenn man 3 Karten im SLI betreibt (für SLI benötigt man eh nen NV Board) dann hat man eben 0 Verbrauch von den 3 Karten im Rechner. Dem hat AMD/ATI aktuell mit Crossfire nichts entgegenzusetzen.

Für mich passt das alles zusammen.

Das ganze "im November mit 55nm" würde den Idle Verbrauch weiter senken.

So kurz vorm Release sind solche Angaben eigentlich fast nicht mehr nur Gerüchte. Ich glaube die Karte wird, bei Leute wie mir, die endlos soviel Power und ein grosses SI benötigen (30" TFT etc) richtig guten Absatz finden. Für den Otto-Normal Gaming Rechner wird die ATI natürlich der Preis Leistungssieger.

Für mich passt das alles zusammen.

Das ganze "im November mit 55nm" würde den Idle Verbrauch weiter senken.

So kurz vorm Release sind solche Angaben eigentlich fast nicht mehr nur Gerüchte. Ich glaube die Karte wird, bei Leute wie mir, die endlos soviel Power und ein grosses SI benötigen (30" TFT etc) richtig guten Absatz finden. Für den Otto-Normal Gaming Rechner wird die ATI natürlich der Preis Leistungssieger.

.p0!$3n.

Lieutenant

- Registriert

- März 2007

- Beiträge

- 739

Es ist doch allgemein bekannt das gerne einmal Gerüchte vor Erscheinen einer Neuen Grafikkarte Gestreut werden: Und über einen hohen Stromverbrauch, in Energiesparzeitenzeiten, zerreißen sich die Presse das Mundwerk. Solange, bis es ein sicheren Fakt gibt, das es nicht so ist.

Denn hoher Stromverbrauch bei hoher Leistung (laut Nvidia-Grafik) ist nur logisch, doch wenigstens im Idel kann man sparen, da die meiste zeit die hohe Leistung gar nicht von Nöten ist. Das ärgert mich ja auch an meiner 8800GTS

Lob an Nvidia, so wirds gemacht (sollte eigendlich auch keine Kunst sein, oder?).

Freu mich schon auf den CB Test^^ -> Die NV-Grafik und die Leistungseckdaten lassen

ja auf, na sagen wir mal , auf eine recht flotte Karte schätzen (jaja, war nicht anders zu erwarten )

)

Denn hoher Stromverbrauch bei hoher Leistung (laut Nvidia-Grafik) ist nur logisch, doch wenigstens im Idel kann man sparen, da die meiste zeit die hohe Leistung gar nicht von Nöten ist. Das ärgert mich ja auch an meiner 8800GTS

Lob an Nvidia, so wirds gemacht (sollte eigendlich auch keine Kunst sein, oder?).

Freu mich schon auf den CB Test^^ -> Die NV-Grafik und die Leistungseckdaten lassen

ja auf, na sagen wir mal , auf eine recht flotte Karte schätzen (jaja, war nicht anders zu erwarten

KAOZNAKE

Captain

- Registriert

- Aug. 2007

- Beiträge

- 3.844

So da hat einer mal ein aussagekräftigeres Bild gemalt.

Dann denkt noch dran das NVIDIA lügt und sich die besten Settings aussucht, natürlich immer schön für jedes Game einzeln und das der Catalyst 8.5 noch mal ne ganze Latte Leistung darauflegt.

EDIT: Hier nochmal die news dazu:

https://www.computerbase.de/2008-05/ati-catalyst-8.5-arbeitet-effizienter-mit-dx10/

Dann denkt noch dran das NVIDIA lügt und sich die besten Settings aussucht, natürlich immer schön für jedes Game einzeln und das der Catalyst 8.5 noch mal ne ganze Latte Leistung darauflegt.

EDIT: Hier nochmal die news dazu:

https://www.computerbase.de/2008-05/ati-catalyst-8.5-arbeitet-effizienter-mit-dx10/

Anhänge

Zuletzt bearbeitet:

holdrio

Lt. Commander

- Registriert

- Juli 2005

- Beiträge

- 1.790

The_one_G36 schrieb:im Gegensatz zu einigen hier habe ich keinerlei vorurteile gegen ati/amd (die vor ein paar jahren deutlich bessere chips wie nvidia hatten).

Du sagst es, "hatten" und "vor paar jahren", vielleicht kommen die "Vorurteile" einfach nur von den nackten Leistungdaten seither?

Ati ist seit der X1950XTX schlicht zu lahm, sonst nix.

Und mit der erfreulichen Meldung hier siehts daneben auch noch düster aus, das kann doch unmöglich ein Fake sein.

Nvidia würde sich total lächerlich machen, wenn sie dann doch den eben noch befürchteten Hardcorestromfresser ausliefern.

Tjs Nvidia konkurrenzlos auf dem Gipfel auch weiterhin, auf grössere Preissenkungen der 280 braucht man dann gar nicht erst hoffen bis Ende 09..., 8800GTX lässt grüssen.

Ähnliche Themen

- Antworten

- 102

- Aufrufe

- 13.919

- Antworten

- 5

- Aufrufe

- 1.581

- Antworten

- 80

- Aufrufe

- 15.859

- Antworten

- 12

- Aufrufe

- 14.718

- Antworten

- 13

- Aufrufe

- 2.368