Apocalypse

Vice Admiral

- Registriert

- Okt. 2012

- Beiträge

- 6.303

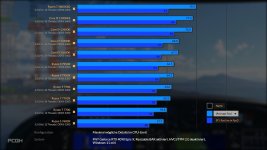

RDNA 2 Abverkauf läuft ja schon eine Weile, der Gebrauchtmarkt war mit Mining Karten geflutet gewesen.Philste schrieb:Tun Sie eben nicht, siehe Earnings Call von Q2. Nur weil MF und andere Einzelhändler viele verkaufen, müssen das auf den gesamten Markt nicht viele sein. Das selbe gilt bei CPUs, bei MF hat AMD im Moment wieder 85% Anteil, stimmt aber im Gesamtmarkt nie im Leben.

irgendwo muss nach der Blase der letzten Jahre ja auch jeder mal eine neue GPU abbekommen haben. RDNA3 setzt sich nun auch nicht deutlich von RDNA 2 im Abverkauf ab. 600€ für eine 6900xt / 6950xt ist jetzt irgendwo auch hart zu schlagen gewesen, aber die Karten mussten halt weg, man hat die Produktion ja tatsächlich stark steigern können im Mining Boom, der Markt der dann halt zusammen gebrochen ist.

Zuletzt bearbeitet: