SELBST WENN die RX 7900 XTX jetzt in den meisten Games im reinen Raster die 4090 schlagen würde, wird sie diese im nächsten Jahr und spätestens bei der Unreal Engine 5 nicht mehr das Wasser reichen können! Die RTX 4090 hat den besseren Chip (N4 vs 5nm), den schnelleren Speicher (DDR6X vs DDR6) und einfach mal das dreifache an Shader Codes! Auch die übrigen Teile sind um einiges reicher vorhanden, sodass die RX 7900 XTX schon in ihrer rein technischen Zusammensetzung sehr viel schwächer ausfällt!

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Radeon RX 7900 XTX: Erste Benchmarks sind mit Vorsicht zu genießen

- Ersteller Vitche

- Erstellt am

- Zur News: Radeon RX 7900 XTX: Erste Benchmarks sind mit Vorsicht zu genießen

Benji18

Rear Admiral

- Registriert

- Jan. 2005

- Beiträge

- 5.380

Glaskugel? Warum bei der UE5? Wie kommst denn auf sowas eigentlich?Serandi schrieb:SELBST WENN die RX 7900 XTX jetzt in den meisten Games im reinen Raster die 4090 schlagen würde, wird sie diese im nächsten Jahr und spätestens bei der Unreal Engine 5 nicht mehr das Wasser reichen können!

Es sei dir gesagt du musst dir den Kauf einer völlig Überteuerten Karte nicht schön Reden.

AMD hat meines Wissens die RX7900XTX als Konkurrenz zur 4080 hingestellt. In den Bereich wirds auch bleiben.

Ich beziehe mich rein auf die techische Ausstattung der Karten. Von nichts kommt nichts. Nicht, dass die RX 7900 XTX nichts zu bieten hätte! Würde mir sogar eine gerne holen, wenn ich keine 4090 hätte, konnte bloß nicht mehr warten. Die reine Anzahl der Shaderkerne, RT cores usw lassen eine RX 7900 XTX ganz klar im Schatten.

Hat natürlich nicht direkt zu bedeuten, dass die in Spielen grundsätzlich dadurch VIEL besser performt, es spielen viele weitere Faktoren eine sehr wichtige Rolle dennoch kann man das nicht außer Acht lassen.

Hat natürlich nicht direkt zu bedeuten, dass die in Spielen grundsätzlich dadurch VIEL besser performt, es spielen viele weitere Faktoren eine sehr wichtige Rolle dennoch kann man das nicht außer Acht lassen.

Benji18

Rear Admiral

- Registriert

- Jan. 2005

- Beiträge

- 5.380

Wie gesagt, Navi 1 hat die schwachpunkte von GCN angegangen. Der weg den AMD beschreitet ist gut und Sie holen auf, jahre der Durststrecke kannst nicht von heute auf morgen aufholen.

Man wirds sehen^^ ich bin Optimistisch das die Karten was werden ;-)

Man wirds sehen^^ ich bin Optimistisch das die Karten was werden ;-)

nutzername

Ensign

- Registriert

- Juli 2014

- Beiträge

- 224

Hast du dir deinen Screenshot mal angeschaut?MrHeisenberg schrieb:Dass das "light RT" Workloads sind, wurde dir mit Sicherheit doch auch schon öfter gesagt?

Ampere ist bei der reinen RT Leistung doppelt so schnell wie RDNA2, also ja, in RT kackt RDNA2 ab.

Siehe z.B.:

https://www.guru3d.com/news-story/r...o-rtx-3080-in-vulkan-ray-tracing-tests,3.html

https://www.pcgameshardware.de/Rayt...cials/ART-Mark-Raytracing-Benchmarks-1371125/

Anhang anzeigen 1292971

Das Problem ist, dass AMD nur mit der letzten Arch. aufschließen konnte, obwohl sie die Möglichkeit hatten, mehr zu machen und die Konkurrenz schläft nicht.

Mal davon abgesehen dass Control sponsored by Nvidia war und grundsätzlich schlechter auf AMD performte... Statt 18 auf einer 6900 32 auf einer 3090. Unspielbar also auf beiden.

Dazu kommt dann jedoch dass Nvidia die RT Leistung im Verhältnis zu RT bei den 40er nur geringer steigern konnte.

Ich sehe also ehrlich gesagt eher das AMD hier nur aufschließen wird.

Nicht nur reicht die Performance für Games mit massiven RT uplift auch bei 40er nicht aus - gerade einmal 4 Jahre alte Spiele wie Control lassen sich jetzt endlich mal sinnvoll daddeln. Und das nicht einmal bei einer 4090 und das ist schon die Speerspitze.

Auch für den Stromverbrauch ist es fraglich für etwas das man oft in der Bewegung nicht einmal wahrnimmt.

Aber klar, ist sicher Klasse bei Spielen in 2024 dann mit RTX on einen Screenshot machen zu können oder nach wie vor auf 1440 zu landen oder Artefakte von FSR, DLSS und co. zu genießen.

"Heavy RT", wie du es nennst, wird auch noch in naher Zukunft im Grundsatz vollkommener Unsinn bleiben wenn die Effekte nicht sinnvoll gewählt und platziert werden.

Und ja, es gibt defacto auch kein fully Raytrace. Es gibt nur RT Effekte - Nvidia versucht natürlich diese zu pushen die auf ihrer Hardware sehr gut laufen - das ist eigentlich schon alles.

Gut designte Games laufen auch mit RT auf AMD extrem gut - und über die Jahre altern AMD Karten eh besser als Nvidia Karten.

Was viele nicht wirklich wahrnehmen ist dass der Compute Overhead von Nvidia eigentlich nur die Datacenter Produkte querfinanzieren soll. Fürs Gaming ist das bis zur 50er Serie nach wie vor nur in absoluten Grenzfällen wirklich sinnvoll - es sei denn einem ist Kosten / Nutzen wirklich komplett egal. Nur dann ist auch eine relative Einordnung in Benchmarks egal. Einfach das schnellste Top-Tier Produkt kaufen, schön in die Signatur packen damit auch alle wissen wen sie vor sich haben und gut ist.

MrHeisenberg

Lt. Commander

- Registriert

- Okt. 2022

- Beiträge

- 1.713

Dein Post strotzt nur so vor Fanboygeblubber.nutzername schrieb:Hast du dir deinen Screenshot mal angeschaut?

Mal davon abgesehen dass Control sponsored by Nvidia war und grundsätzlich schlechter auf AMD performte... Statt 18 auf einer 6900 32 auf einer 3090. Unspielbar also auf beiden.

In erster Linie ging es mir um den reinen Leistungsvergleich und da spielt es keine Rolle, ob es 1 FPS vs 2 FPS oder 18 FPS vs 32 FPS sind. Fakt ist, dass Ampere schon doppelt so schnell in RT ist.

Bis zu 90% mehr RT Performance bezeichnest du als geringe Steigerung? Das alleine zeigt schon, dass jegliche Diskussion mit dir hinfällig ist:nutzername schrieb:Dazu kommt dann jedoch dass Nvidia die RT Leistung im Verhältnis zu RT bei den 40er nur geringer steigern konnte.

Die 90% bei Ada sind für dich gering, aber 50% mehr bei AMD bezeichnest du dann als "aufschließen"?nutzername schrieb:Ich sehe also ehrlich gesagt eher das AMD hier nur aufschließen wird.

Witzigerweise ist das genaue Gegenteil der Fall. Der Abstand wird hier immer größer.

In 4K 60 FPS sind nicht spielbar? Was soll man bei solch dämlichen Argumenten noch sagen?nutzername schrieb:Nicht nur reicht die Performance für Games mit massiven RT uplift auch bei 40er nicht aus - gerade einmal 4 Jahre alte Spiele wie Control lassen sich jetzt endlich mal sinnvoll daddeln. Und das nicht einmal bei einer 4090 und das ist schon die Speerspitze.

Vor Pascal waren mit ach und krack gerade mal 30 FPS in 4K möglich und jetzt reichen nicht mal 4K 60 FPS.

Ich habe Crysis damals in 22 FPS mit der schnellsten single Chip GPU von AMD durchgezockt und es geliebt.

Sorry, aber den Dünnpfiff kann ich nicht für voll nehmen.

Blöd nur, dass die 4090 effizienztechnisch alles andere in den Schatten stellt. Selbst die kommende 7900XTX.nutzername schrieb:Auch für den Stromverbrauch ist es fraglich für etwas das man oft in der Bewegung nicht einmal wahrnimmt.

Bla bla. Ich spiele jedes Spiel mit DLSS und hatte noch nie "Artefakte". Selbst DLSS3 läuft 1a. bei NFS Unbound und A Plague Tale. Klar, wenn du dir ein Standbild mit der Lupe anschaust, dann wirst du was finden, aber während du spielst, fällt dir das absolut nicht auf.nutzername schrieb:Aber klar, ist sicher Klasse bei Spielen in 2024 dann mit RTX on einen Screenshot machen zu können oder nach wie vor auf 1440 zu landen oder Artefakte von FSR, DLSS und co. zu genießen.

Gibt aber scheinbar Leute wie dich, die Standbilder untersuchen, um sich an Grashalmen hochzuziehen.

Kleiner Tipp von mir: schau dir niemals an, wie Rasterization im Detail funktioniert, denn dann wirst du feststellen, dass sehr vieles gefaket, falsch oder fehlerhaft ist. Wenn du mir also mit dem Argument kommst, dürftest du gar nichts spielen.

Beispiel:

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Das Ergebnis ist falsch, aber es ist so nah am korrekten Ergebnis, dass man es, aufgrund der Performance, trotzdem genutzt hat.

Im ersten Punkt hast du recht, aber der Grund ist falsch. Bis sich RT grundlegend durchsetzt, muss der Großteil der Spielerschaft eine RT fähige Graka besitzen.nutzername schrieb:"Heavy RT", wie du es nennst, wird auch noch in naher Zukunft im Grundsatz vollkommener Unsinn bleiben wenn die Effekte nicht sinnvoll gewählt und platziert werden.

Doch gibt es: Path Tracing.nutzername schrieb:Und ja, es gibt defacto auch kein fully Raytrace. Es gibt nur RT Effekte - Nvidia versucht natürlich diese zu pushen die auf ihrer Hardware sehr gut laufen - das ist eigentlich schon alles.

Spiele wie CyberPunk, Far Cry oder CoD sind Hybride, welche Rasterization in Verbindung mit RT nutzen.

Minecraft, Portal, Quake und Metro Exodus Enhanced setzen hingegen für die komplette Beleuchtung auf Path Tracing.

Was Path Tracing angeht fällt mir da nur ein Spiel ein: Metro.nutzername schrieb:Gut designte Games laufen auch mit RT auf AMD extrem gut - und über die Jahre altern AMD Karten eh besser als Nvidia Karten.

Wenn man sich die Kommentare von Leuten mit Ahnung (@.Sentinel., @Zer0Strat) anschaut, dann stellt man fest, dass diese den AMD Karten viel weniger rohe RT Power zusprechen. Ich vertraue den Aussagen dieser User eher, als einem wie dir, der sich persönlich angegriffen fühlt, wenn seine Hardware gegen die Konkurrenz abstinkt.

Diverse Tools und Tests untermauern ihre Aussagen auch. Es steht dir aber frei, mich vom Gegenteil zu überzeugen. Allerdings will ich dafür Beweise/Fakten und keinen Kommentar in dem du nur sagst: "Ist so".

Mit RDNA2 war AMD effizienter, günstiger und gleich schnell wie die Konkurrenz. Das wurde in sämtlichen Threads jeden Tag rauf und runter breitgetreten und die Effizienz war auf einmal das wichtigste Kriterium überhaupt.

Jetzt haut Nvidia einen Hammer raus und auf einmal spielen Effizienz und Leistung für genau diese User keine Rolle mehr und man versucht sich krampfhaft an irgendwelchen Grashhalmen hochzuziehen wie jetzt in diesem Thread an einer kostenlosen Techdemo, die nur zeigen soll, was möglich ist.

AMD hat mit RDNA3 nur noch einen in einer Kategorie die Oberhand: der Preis. In allen anderen überwiegt Nvidia, wenn man neutral an die Sache rangeht. Warum können das User wie du nicht einfach hinnehmen? Es ist nur Hardware.

Weil die UE4 schon besser mit Nvidia zurechtkam. Das las man doch immer wieder als Argument unter sämtlichen Tests von irgendwelchen UE4 spielen. Warum sollte es bei der UE5 also anders sein?Benji18 schrieb:Glaskugel? Warum bei der UE5? Wie kommst denn auf sowas eigentlich?

Sie haben mit RDNA2 gleichgezogen und liegen jetzt wieder hinten. Wo ist das aufholen?Benji18 schrieb:Wie gesagt, Navi 1 hat die schwachpunkte von GCN angegangen. Der weg den AMD beschreitet ist gut und Sie holen auf, jahre der Durststrecke kannst nicht von heute auf morgen aufholen.

Zuletzt bearbeitet:

die N31 steht P/L gegen AD103 war in der letzten Gen nicht so da war P/L N21 vs GA102Serandi schrieb:Ich beziehe mich rein auf die techische Ausstattung der Karten. Von nichts kommt nichts. Nicht, dass die RX 7900 XTX nichts zu bieten hätte! Würde mir sogar eine gerne holen, wenn ich keine 4090 hätte, konnte bloß nicht mehr warten. Die reine Anzahl der Shaderkerne, RT cores usw lassen eine RX 7900 XTX ganz klar im Schatten.

Rein von der Hardware ohne Cash & Speicher hat Nvidia AD103/GA102 -8% Hardware vs N31/N21 +26% bei Speicher & Bandbreite sieht es auch Pro AMD aus hat jeweils mehr zu weniger bei Nvidia.

je nachdem wie das Chiplet performed könnte es auch im RT reichen um mit der 4080 gleichzuziehen sehen wir ja am Mo dann endlich

wer sagt das es bei RDNA3 anders ist ?MrHeisenberg schrieb:Mit RDNA2 war AMD effizienter, günstiger und gleich schnell wie die Konkurrenz.

sagst aber auch nur Du!MrHeisenberg schrieb:AMD hat mit RDNA3 nur noch einen in einer Kategorie die Oberhand: der Preis. In allen anderen überwiegt Nvidia, wenn man neutral an die Sache rangeht. Warum können das User wie du nicht einfach hinnehmen? Es ist nur Hardware.

Navi31 steht gegen AD103 und wer und wo die Oberhand hat sehen wir alle wohl erst morgen denn rein von der Hardware und P/L stellt AMD aktuell ja nichts gegen die RTX4090 die bleibt das non plus Ultra bis AMD vielleicht ja doch noch irgendwann einen Konter mittels 2xNavi31 nachschiebt.

(Aber zugegeben das ist mehr Wunsch, nicht aus Fanboy sondern Shareholder sicht

Hoffe aber das die RX7900xtx die 4080 im Raster schlägt und RT gleich kommt.

Warte aber eigentlich nur sehnsüchtig drauf eine RTX3070/6700XT oder leistungsmässig vergleichbares mit min 12-16GB für unter 300taler, und hoffe sowas kommt 2023 oder aber die Preise der alten karten fallen im Abverkauf auf 30-50% unter ehemalige UVP wie es früher eigentlich immer war sonnst bleibt meine RX590 eben noch bis es sowas gibt aktuell reicht sie mir noch

MrHeisenberg

Lt. Commander

- Registriert

- Okt. 2022

- Beiträge

- 1.713

AMD selbst. Es gibt genug Hochrechnungen.Icke-ffm schrieb:wer sagt das es bei RDNA3 anders ist ?

Den Marketingfolien von AMD nach zu urteilen, ist die Karte ~15% langsamer als die 4090.

Wenn ich die 4090 auf 350W bremse, verliert sie 1-2% Leistung. Lass es 5% sein, bei 300W.

Damit wäre sie bei 300W immer noch ~10% schneller und die 7900XTX wird sehr wahrscheinlich die 300W knacken.

Navi 31 ist der vollausbau. AD102 ebenfalls.Icke-ffm schrieb:sagst aber auch nur Du!

Navi31 steht gegen AD103 und wer und wo die Oberhand hat sehen wir alle wohl erst morgen denn rein von der Hardware und P/L stellt AMD aktuell ja nichts gegen die RTX4090 die bleibt das non plus Ultra bis AMD vielleicht ja doch noch irgendwann einen Konter mittels 2xNavi31 nachschiebt.

Zwar ist die 4090 nicht der vollausbau, aber die schnellste Karte von Nvidia auf dem Markt und sie wird zum Releasezeitpunkt der 7900XTX auch die effizienteste highend Karte sein.

AMD höchst selbst hat gesagt das RX7900 nicht die Antwort auf RTX4090 sondern der RTX4080 ist.MrHeisenberg schrieb:AMD selbst. Es gibt genug Hochrechnungen.

Den Marketingfolien von AMD nach zu urteilen, ist die Karte ~15% langsamer als die 4090.

Du sagst es, zum release Zeitpunkt. AMD hat aber soweit ich weis noch nirgends gesagt das es keinen RTX4090 Konter geben wird, und wenn die Rx7900xtx raster wie Du oben schreibst wirklich nur 15% hinter der 4090 liegt “könnte” AMD auch noch mit einem 2xN32 diesen bringen. keiner weis was noch kommt, und wenn denn wirklich die RTX4090 nur 15% vor der RX7900xtx liegt solle das auch reichen um die 4090 zu toppen klar bringt Nvidia dann den Vollausbau und behält die Leistungsspitze, aber zu welchem Preis?MrHeisenberg schrieb:Navi 31 ist der vollausbau. AD102 ebenfalls.

Zwar ist die 4090 nicht der vollausbau, aber die schnellste Karte von Nvidia auf dem Markt und sie wird zum Releasezeitpunkt der 7900XTX auch die effizienteste highend Karte sein.

2x200mm2 in5nm zzgl. 6x37,5mm2 in 6nm dürften mit ziemlicher sicherheit billiger sein wie ein AD102 mit 600mm2 5nm.

mich interessiert der Profit nicht die Leistungsspitze auch wenn ich hoffe das AMD auch da Nvidia wenn nicht mit Navi3x zumindest dem Nachfolger topt. High end brauche ich beim zocken nicht, Auto und Urlube sind mir wichtiger und die werden Durch meine Investments bezahlt, da bin ich aktuell immer noch knapp1000% bei AMD gut bedient wenn auch unglücklich will wieder +2000% sehen

AMD verfolgt doch eine ganz andere Strategie mit ihren Architekturen. Nvidia geht auf ganze, was RT betrifft. Sie wollen es pushen, während AMD zusieht, dass das Feature grundsätzlich supported wird, ohne zu viel Die-Fläche dafür zu verschwenden.MrHeisenberg schrieb:dass diese den AMD Karten viel weniger rohe RT Power zusprechen

.Sentinel.

Admiral

- Registriert

- Okt. 2007

- Beiträge

- 8.650

AMD hat absehbar und offiziell nichts im Köcher gegen die 4090?Icke-ffm schrieb:und wenn denn wirklich die RTX4090 nur 15% vor der RX7900xtx liegt solle das auch reichen um die 4090 zu toppen

Wenn AMD kontert, kontert nVidia.

nVidia hat sich noch nie auf den Lorbeeren ausgeruht.

Der cycle ist im Augenblick, dass nVidia immer vorlegt und AMD hinterherhechelt.

Gegenteiliges würde bei mir Jubel auslösen.

Zuletzt bearbeitet:

Illithide

Ensign

- Registriert

- Juli 2017

- Beiträge

- 173

Imho auch eine gut nachvollziehbare Entscheidung, solange es bei den Gameentwicklern nicht nennenswert angenommen und genutzt wird.Zer0Strat schrieb:AMD verfolgt doch eine ganz andere Strategie mit ihren Architekturen. Nvidia geht auf ganze, was RT betrifft. Sie wollen es pushen, während AMD zusieht, dass das Feature grundsätzlich supported wird, ohne zu viel Die-Fläche dafür zu verschwenden.

BTW.:

https://wccftech.com/amd-shipping-2...for-radeon-rx-7900-xtx-rx-7900-xt-in-q4-2022/

Für ausreichend Vorrat an 7900er-Karten sollte gesorgt sein. Lässt dann auch auf gute Preise ohne zu große Aufschläge hoffen.

ThirdLife

Captain

- Registriert

- Aug. 2019

- Beiträge

- 3.468

So viel ist das nichtmal und verteilt sich auf beide Modelle.

nVidia hat im ersten Monat glaub über 130k Einheiten allein 4090er bereitgestellt und die sind auch quasi ausverkauft oder nur erhältlich zu Mondpreisen. Und da sich sicherlich mehr Leute für die Radeon Karten interessieren (schon rein preislich) als eine 4090 stell ich mir die Verfügbarkeit eher schlechter vor als besser.

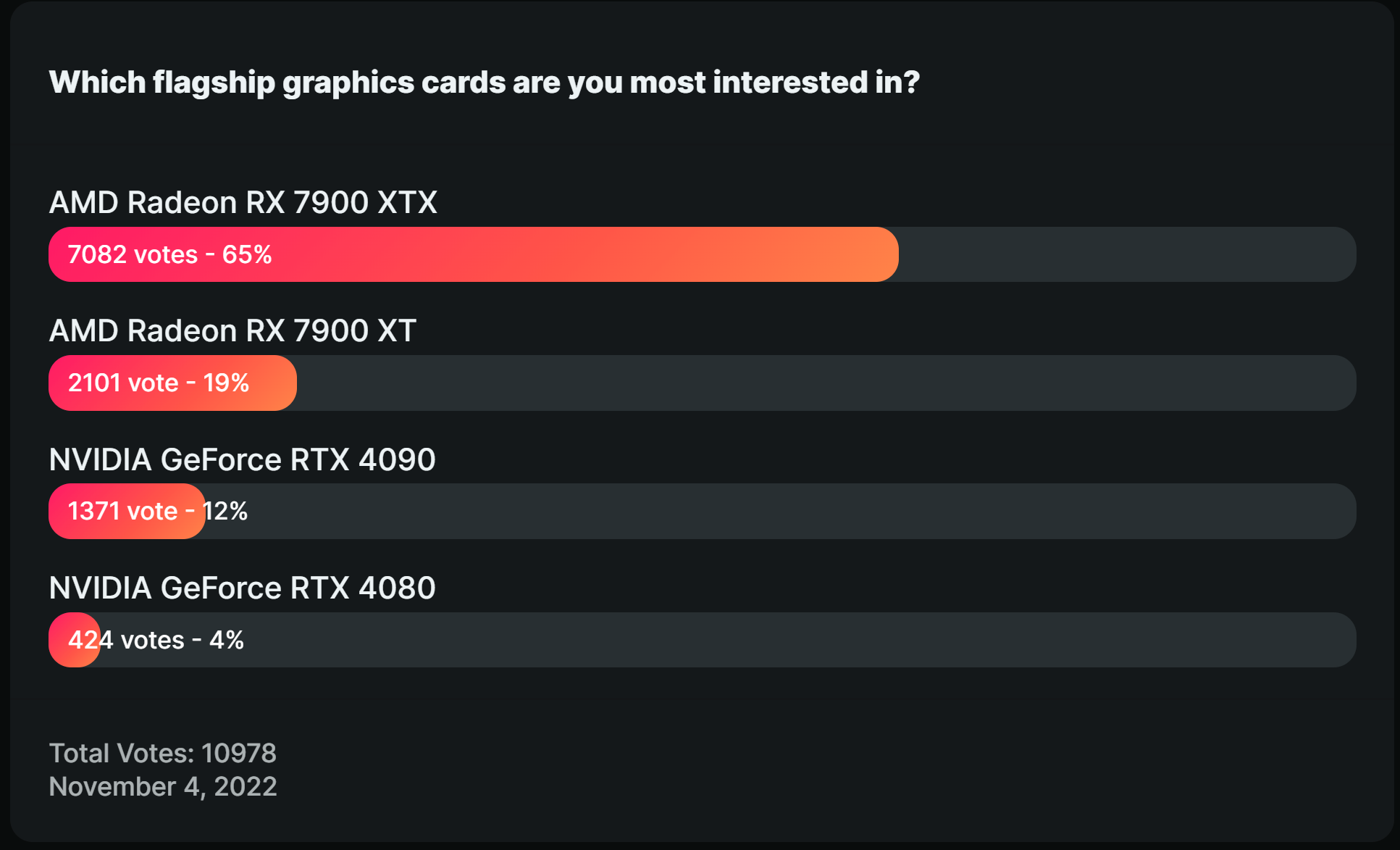

Wenn sie beides gleich aufgesplittet haben sind das 100k Einheiten pro Karte, somit 30 weniger als Team Grün was das Topmodell angeht und wenn man den Umfragen glauben darf wollen die meisten genau die XTX haben. Was bei etwas über 70% dann von 200k Einheiten 141.640 macht. 41% höherer Demand als für die XT. Wenn selbst die laut Umfrage relativ ungewünschte 4090 sich so gut verkauft hat und die niedrigste neue AMD Karte schon fast doppelt so viel Käuferinteresse weckt...

Fröhliche Scalpnachten dann.

nVidia hat im ersten Monat glaub über 130k Einheiten allein 4090er bereitgestellt und die sind auch quasi ausverkauft oder nur erhältlich zu Mondpreisen. Und da sich sicherlich mehr Leute für die Radeon Karten interessieren (schon rein preislich) als eine 4090 stell ich mir die Verfügbarkeit eher schlechter vor als besser.

Wenn sie beides gleich aufgesplittet haben sind das 100k Einheiten pro Karte, somit 30 weniger als Team Grün was das Topmodell angeht und wenn man den Umfragen glauben darf wollen die meisten genau die XTX haben. Was bei etwas über 70% dann von 200k Einheiten 141.640 macht. 41% höherer Demand als für die XT. Wenn selbst die laut Umfrage relativ ungewünschte 4090 sich so gut verkauft hat und die niedrigste neue AMD Karte schon fast doppelt so viel Käuferinteresse weckt...

Fröhliche Scalpnachten dann.

Illithide

Ensign

- Registriert

- Juli 2017

- Beiträge

- 173

noch zum Zeitvertreib vor den Tests heute (7900XTX vs. 4080):

bzw. 7900XTX vs. 4090:

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

bzw. 7900XTX vs. 4090:

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

na das schaut doch schon garnicht mal schlechtr aus  hoffe mal auf 15Uhr heute das da dann endlich was offizielles kommt

hoffe mal auf 15Uhr heute das da dann endlich was offizielles kommt

Ergänzung ()

na die Umfrage ist für die tonne, die Daten der RTX sind ja schon bekannt, daher nur logisch das alle auf daten der AMD Karten wartenThirdLife schrieb:Wenn sie beides gleich aufgesplittet haben sind das 100k Einheiten pro Karte, somit 30 weniger als Team Grün was das Topmodell angeht und wenn man den Umfragen glauben darf wollen die meisten genau die XTX haben. Was bei etwas über 70% dann von 200k Einheiten 141.640 macht. 41% höherer Demand als für die XT. Wenn selbst die laut Umfrage relativ ungewünschte 4090 sich so gut verkauft hat und die niedrigste neue AMD Karte schon fast doppelt so viel Käuferinteresse weckt...

Zuletzt bearbeitet:

ThirdLife

Captain

- Registriert

- Aug. 2019

- Beiträge

- 3.468

Da steht nicht "wer wartet auf die Daten" sondern "wer ist interessiert an was". Schau dir doch den Tenor hier im Forum an, ausser ein paar ungeduldigen Hardwaregeilen ist kaum wer an der 4090 interessiert, an der 4080 schon garnicht, was bleibt da noch ? 7900 XT und XTX.Icke-ffm schrieb:na die Umfrage ist für die tonne, die Daten der RTX sind ja schon bekannt, daher nur logisch das alle auf daten der AMD Karten warten

Und wenn jetzt all die Wartenden so eine Karte wollen und das natürlich vor Weihnachten zum Weihnachtsurlaub etc. was denkst du was passiert ? Man hat ja gesehen was mit 130k Karten passiert für die sich nur ein Bruchteil der Menschen interessiert (siehe Steam Charts).

Ich würd jedem der eine will empfehlen hart F5 zu spammen in den bevorzugten Shops, weil lang und breit verfügbar werden die wohl kaum sein bei soviel Interesse.

ja schon klar, aber die Umfrage wurde gestartet wo die Daten & Leistung der RTX bereits bekannt waren.ThirdLife schrieb:Da steht nicht "wer wartet auf die Daten" sondern "wer ist interessiert an was". Schau dir doch den Tenor hier im Forum an, ausser ein paar ungeduldigen Hardwaregeilen ist kaum wer an der 4090 interessiert, an der 4080 schon garnicht, was bleibt da noch ? 7900 XT und XTX.

von daher ist egal was da steht es kennt niemand die Daten der RX daher sind auch die Nvidia jünger wohl an diesen interessiert lassen sich ja eventuell noch paar euro spaaren wenn denn die Leistung stimmt

ThirdLife

Captain

- Registriert

- Aug. 2019

- Beiträge

- 3.468

Dann wären sie ja keine Jünger ?🤔 Oder ist jeder, der mal ne grüne Karte hatte und einfach nach für sich bestem PLV kauft ein Jünger ? Wären dann im Umkehrschluss nicht alle die regelmäßig AMD kaufen auch Jünger ? Oder ist Markenfetischismus nur bei einer Marke ok ? 🤔Icke-ffm schrieb:daher sind auch die Nvidia jünger wohl an diesen interessiert lassen sich ja eventuell noch paar euro spaaren wenn denn die Leistung stimmt

Fragen über Fragen.😂

Ähnliche Themen

- Antworten

- 345

- Aufrufe

- 35.915

- Antworten

- 516

- Aufrufe

- 33.406

- Antworten

- 39

- Aufrufe

- 7.103

- Antworten

- 17

- Aufrufe

- 1.088

- Antworten

- 186

- Aufrufe

- 23.729