- Registriert

- Mai 2010

- Beiträge

- 581

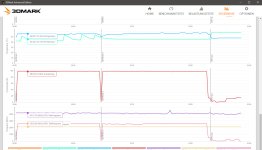

Da ich nirgends etwas aussagekräftiges gefunden habe, habe ich mal wieder selbst Tests gemacht. Und zwar habe ich die Auswirkung des Infinity Fabric Takts (FCLK) auf die Performance gemessen.

Standardmäßig läuft der mit 1940MHz und ich hatte ihn auch schon erfolgreich auf 2000MHz übertaktet. Dafür war etwas mehr Spannung als bei meinem vorher eingestellten UV nötig. Die Spannung die den FCLK stabilisiert ist übrigens ebenfalls die SoC Spannung.

Die +60MHz waren in FPS kaum messbar und für mehr Takt müsste ich übervolten, was ich vermeide. Untertakten war aber eine Option und deswegen habe ich einfach mal 1000MHz vs 2000MHz getestet.

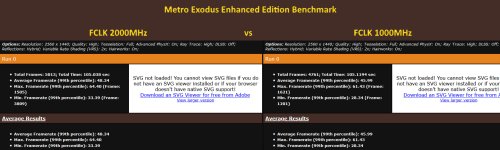

In Metro Exodus Enhanced Edition war mir zuvor bereits die starke Auslastung des Titels auf die SoC Spannung aufgefallen, da meine UV Anläufe die sonst schon stabil waren hier scheiterten. Deswegen habe ich natürlich direkt Metro herangezogen, da der Einfluss hier groß zu sein scheint. Gemessen habe ich auf "Hoch" in WQHD mit RT da das für mich realistische Alltagseinstellungen sind. Aber wahrscheinlich wäre die Auswirkung in 4k noch größer und ich vermute, dass mit höherem Chip Takt auch wieder mehr Profit durch die höhere Bandbreite entstehen würde. Meine Karte lief aber nur mit 2,4GHz.

Ich habe jeweils 3 Durchläufe gemacht und mich für den Vergleich für das jeweils durchschnittlichste Ergebnis entschieden. So kann man Messfehler und Ausreißer halbwegs ausschließen und die Messung auf den reinen Unterschied durch den FCLK auslegen.

Grob kann man sagen, dass man im Durchschnitt 3-4 FPS verliert, bei den maximalen sind es 4 und bei den minimalen sind es 5 FPS. Dafür dass ich den Takt halbiert habe finde ich das erstaunlich wenig. Das bedeutet aber auch, dass hier mit OC kaum noch Perfomance zu holen ist. Mit klassischem Speicher OC erreicht man mehr

Die beste Effizienz hat man wohl bei 1800MHz, da reichen 1000mv auf dem SoC.

Standardmäßig läuft der mit 1940MHz und ich hatte ihn auch schon erfolgreich auf 2000MHz übertaktet. Dafür war etwas mehr Spannung als bei meinem vorher eingestellten UV nötig. Die Spannung die den FCLK stabilisiert ist übrigens ebenfalls die SoC Spannung.

Die +60MHz waren in FPS kaum messbar und für mehr Takt müsste ich übervolten, was ich vermeide. Untertakten war aber eine Option und deswegen habe ich einfach mal 1000MHz vs 2000MHz getestet.

In Metro Exodus Enhanced Edition war mir zuvor bereits die starke Auslastung des Titels auf die SoC Spannung aufgefallen, da meine UV Anläufe die sonst schon stabil waren hier scheiterten. Deswegen habe ich natürlich direkt Metro herangezogen, da der Einfluss hier groß zu sein scheint. Gemessen habe ich auf "Hoch" in WQHD mit RT da das für mich realistische Alltagseinstellungen sind. Aber wahrscheinlich wäre die Auswirkung in 4k noch größer und ich vermute, dass mit höherem Chip Takt auch wieder mehr Profit durch die höhere Bandbreite entstehen würde. Meine Karte lief aber nur mit 2,4GHz.

Ich habe jeweils 3 Durchläufe gemacht und mich für den Vergleich für das jeweils durchschnittlichste Ergebnis entschieden. So kann man Messfehler und Ausreißer halbwegs ausschließen und die Messung auf den reinen Unterschied durch den FCLK auslegen.

Grob kann man sagen, dass man im Durchschnitt 3-4 FPS verliert, bei den maximalen sind es 4 und bei den minimalen sind es 5 FPS. Dafür dass ich den Takt halbiert habe finde ich das erstaunlich wenig. Das bedeutet aber auch, dass hier mit OC kaum noch Perfomance zu holen ist. Mit klassischem Speicher OC erreicht man mehr

Die beste Effizienz hat man wohl bei 1800MHz, da reichen 1000mv auf dem SoC.

Anhänge

Zuletzt bearbeitet: