Nur um's nochmal genau zu verstehen, weil der Thread ein bisschen durcheinander geht und ich aus dem Startpost mit den unterschiedlichen Varinaten auch nicht ganz schlau geworden bin. Dein Problem, das du aktuell besprechen möchtest, ist jetzt das hier, oder?

gidra schrieb:

Von Anfang an. (...) Dennoch fiel es mir auf, dass sie weniger Leistung liefert als manche 6800XT.

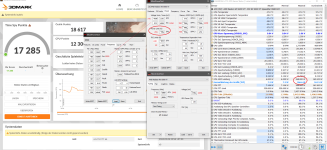

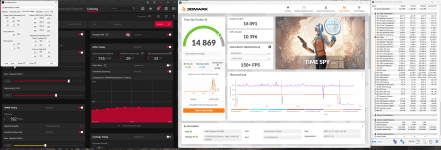

Hier der Screen, den ich jetzt mit Wasserkühlung gemacht habe. Nichts verändert, so wie von XFX ausgeliefert. MCT resetet.

[IMG]https://pics.computerbase.de/forum/attachments/1351/1351872-034c6afc5594ce94f75cc23156de00eb.jpg[/IMG]

Bei dem Screenshot jetzt ist die Karte softwareseitig (Treibereinstellungen und BIOS, kein MPT aktiv,...) im Auslieferungszustand, hardwareseitig hat sie die Wasserkühlung darauf montiert?

Die Punktzahl für Stock ist in der Tat ziemlich niedrig. Nicht so, dass gar nichts funktioniert, aber

auch PCGH gibt für die 6900xt 20250 Time Spy Punkte an und die Werte sind jetzt nicht unbedingt ausoptimiert, wer eine OC Karte hat oder ein sehr gutes Sample oder besonders gute Bedingungen, der liegt da tendenziell eher drüber.

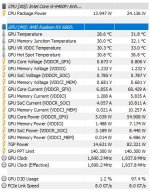

Die Max-Temperatuten in HW info sind niedrig genug, nicht nur Hotspot, sondern auch VRAM, also gehen wir davon aus, dass der WaKü-Umbau in dem Fall nicht das Problem für eine gegenüber Ausgangszustand reduzierte Leistung ist.

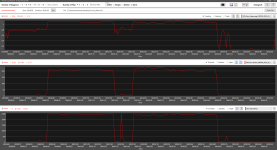

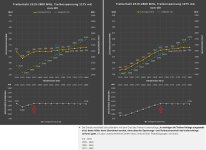

PCGH gibt für ihren Run ca 2,32 GHz an, das sieht eigentlich ungefähr ähnlich aus wie in deinem Chart aus 3D Mark...

Hast du mal probiert, ob sich etwas ändert, wenn du das OC der anderen Komponenten (v.a. RAM) testweise herausnimmst?

Ansonsten wäre mein nächster Vorschlag, die Grafikbenchmarkszene mal mit CapFrameX mitzumessen und zu schauen ob man in der Messung etwas sieht, oder auch das Overlay von Intel Presentmon mal mitlaufen zu lassen, um genauer zu checken ob die GPU konstant gut beliefert wird:

In einem rein GPU-limitierten Benchmark sollte GPU Busy nur minimal kleiner sein als die Frametime, wenn da häufig oder dauerhaft deutliche Lücken sind, hakt es irgendwo davor.