pilzbefall schrieb:

@Milchwagen

extra für dich

http://geizhals.at/deutschland/?phist=516970&age=365

Die Marktlogik ist was feines, denn wenn niemand mehr die alten Karten kauft, fallen sie umso mehr weiterhin im Preis.

Die fallenden Preise in letzter Zeit liegen vor allem am erstarkenden €, an der steigenden Verfügbarkeit bzw. wenn man so will "Überproduktion" und natürlich an der Konkurrenz. Das Erscheinen der HD6k hat damit so gut wie nix zu tun. Höchstens seitens NVIDIA, die noch schnell ein paar Grakas verkloppen wollen, bevor sie gar nix mehr dafür bekommen...

Karol_ schrieb:

Welchen Fehler? Weder die Radeon 3000, 4000 noch die 5000 Serie haben jemals x900er Modelle geführt! In den letzten drei Generationen waren die jeweils stärksten Karten immer als x800er Serie geführt während Dual-GPU-Karten zusätzlich noch als X2 bezeichnet wurden.

Der Fehler war die 58x0 nicht als 59x0 zu vermarkten (und die dual GPU dann von mir aus als X2). 3870~200€, 4870~200€ Startpreis, die 5870 dann 300€, lange deutlich teurer.

Wenn also die AMD Logik ist, die Karten nach Preisklassen zu sortieren (x8x0 = 200€, x9x0 >300€, 100 < X7x0 <200€, so oder so ähnlich, wie gesagt die 58x0 war ne Ausnahme) sollte man das akzeptieren können.

IMMERHIN heißen die Grakas ja auch NICHT MEHR ATI Radeon, sondern AMD Radeon... AMD könnte die 68x0 als 62x0 bringen...dürfte sich auch keiner beschweren.

Tom2e schrieb:

Na Hofentlich nicht! Es gibt so viele games da reicht 1 GB hinten und vorne nicht mehr.

Aber wäre auch egal dann kaufe ich mir erstmal eine 460 GTX mit 2gb relativ günstig und ne Neue Graka muss man sowieso min 1X mal an nen Pc neu aufrüsten. In so 2 jahren wird 2gb Standard sein!

Zu den 1GB: Das mag bei den alten NVIDIAs so gewesen sein, das die ein schlechtes Speichermanagement hatten (Fermi nicht mehr AFAIK), aber bei ATI langt 1GB locker, ist ja nicht so das man kein Spiel mehr starten könnte, geschweige denn dass zu wenig VRAM der Hautpgrund für schlechte Performance ist.

Solange man auf AA verzichtet, würde ich sogar so weit gehen, das heutzutage 256MB immer noch ausreichend sind, schließlich müssen die ganzen Konsolenports mit weniger(?) auskommen.

Zum Aufrüsten: Ich habe von einer Geforce 3 mehr oder weniger auf ne 7800GT aufgerüstet, dann auf ne 3870. Seitdem warte ich auf 28nm.

Kann nicht behaupten, dass man 1x im Jahr ne neue Graka bräuchte, läuft alles wunderbar, zogge allerdings auch nicht mehr die neuesten Games und selbst wenn weiß ich noch wozu die ganzen Grafikregler gut sind

Jenergy schrieb:

"starker" Euro... Das meinst du nicht ernst oder? Sowohl der Dollar als auch der Euro sind zurzeit äusserst schwach

ähhhh FAIL? € wieder so stark wie lange nicht....

kisser schrieb:

Marketing ist schon was geiles, AMD vergleicht die Die Größe der teildeaktivierten 5850 (334 mm²) mit der Die Größe der (vermutlich) nicht teildeaktivierten 6870 (255 mm²).

So kann man natürlich alles schönrechnen. Am besten hätte AMD die 5830 zum Vergleich herangezogen, da könnte man dann mit noch mehr Performance pro mm² protzen.

Eine 5830 hat den selben Chip drinne wie eine 5850 oder 5870-->Cypress. Die sind alle gleich groß, ich hoffe ich missverstehe deine Aussage nicht.

Die 6870 ist mit Sicherheit nicht teildeaktiviert, falsches Camp

Seppuku schrieb:

@ Sascha L

Ich kann beim besten Willen in deinem Beitrag keine Erklärung für die unlogische Nomenklatur finden...

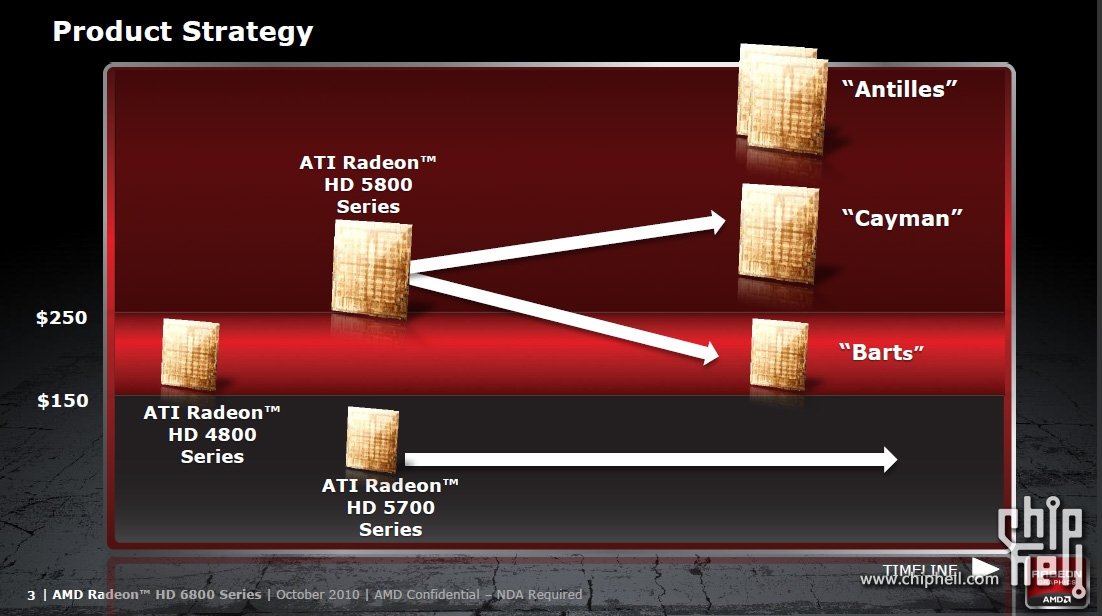

Siehe oben. Kannst dir auch nochmal die Folie hier anschauen, vielleicht verstehst dus dann

https://pics.computerbase.de/3/1/2/7/4/20-1080.465612252.jpg

https://pics.computerbase.de/3/1/2/7/4/20-1080.465612252.jpg

Glaub mir mir fällt es auch schwer, aber wenn AMD das unbedingt so machen will, müssen sies halt irgendwann durchziehen. Was liegt da näher als nach der Entsorgung von ATI? Mir erschließt sich die Einteilung nach dem Preis allerdings auch nicht, weil Geld ja "dynamisch" ist. Sprich es verliert an Wert oder wird auch wertvoller.

Sinnvoller wäre es IMO gewesen, die Single-GPU Performance einfach bei x8xx zu belassen, die Dual-Karten bei X9xx und alles andere entsprechend nach unten. Will man aber nicht-->so what??? So schlimm wie bei NVIDIA (G92 in 13 Grakas verbaut über verschiedene Generationen hinweg) isses lange nicht...

Mit LLano hat das IMO auch nix zu tun, denn die werden wohl ganz anders bezeichnet werden...

KainerM schrieb:

Und bzgl. Taktraten und Chipleistung: Als der GF104 kam, war AMD schon zu weit mit Barts um noch grundlegende Änderungen im Design zu machen. Das das Ding jetzt doch so gut ist macht ihnen das Leben schwer. Ansonsten wäre Barts ziemlich sicher eine minimal schnellere HD5770 geworden, mit Taktraten im Bereich der HD6850 jetzt.

Dafür hätte man die Die-Size aber nicht dermaßen erhöhen müssen (ca. 50% AFAIK).

An dem Refresh arbeitet AMD schon seit mindestens 2 Jahren --> Tapeout von Barts war vor einem Jahr!! (Tapeout = fertig entwickelten Chip zur Fabrik schicken zur ersten Fertigung)

Tomahawk schrieb:

Das Namenswirwarr missfällt, Performance geringer als beim Vorgänger. Jetzt muss es wohl der Preis tun.

Die 6870 ist aber quasi der Nachfolger der 5770

Nachfolger vom Cypress wird der Cayman, der wieder ne ordentliche Schippe drauf legen wird