- Registriert

- Apr. 2008

- Beiträge

- 13.347

Hi,

Vor ein paar Wochen habe ich auf einen 2700X und ein zweites 2x8GB 3600 Cl15er Kit aufgerüstet.

Nachdem ich die 4x8GB erfolgreich zu meiner Zufriedenheit übertaktet hatte, habe ich mich letzte Woche daran gemacht auch mal in die Welt der schlechteren Timings zu gucken.

Vorwort:

System und Ram Settings:

Synthetische Werte von Aida64:

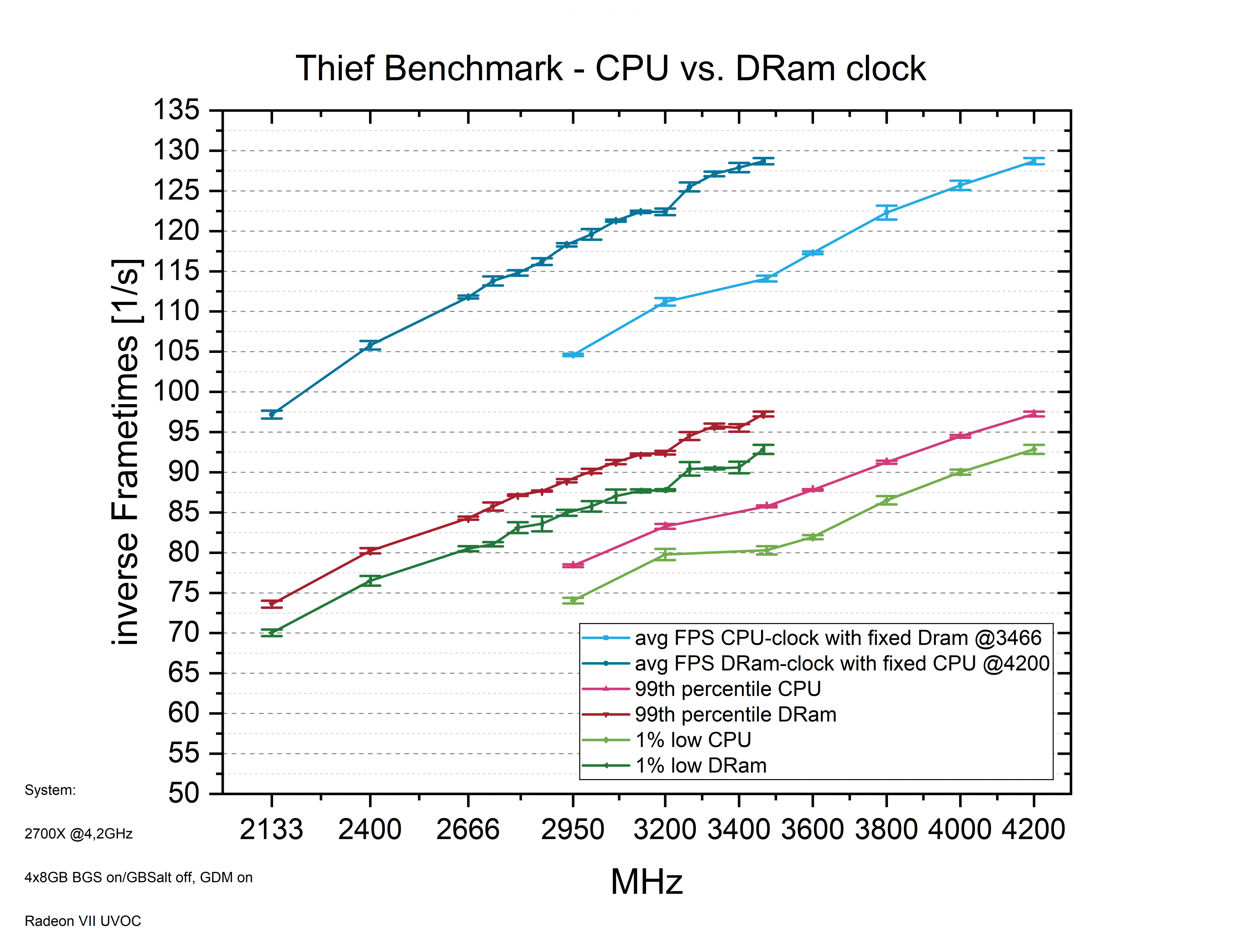

Spieleperformance in Thief

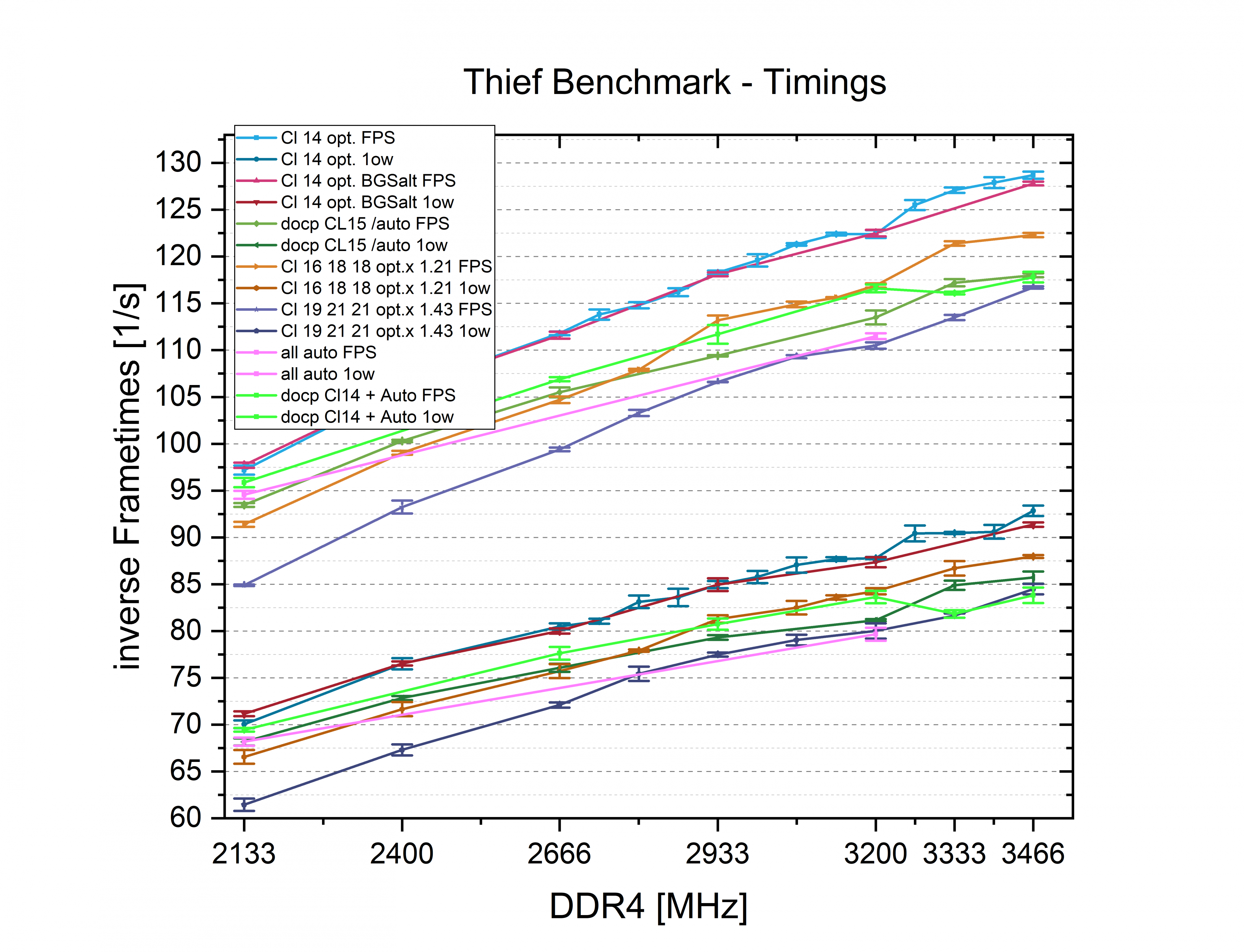

Die Werte beruhen jeweils auf der zweiten bis sechsten Messung aus den integrierten Benchmark, der einen ganz guten worst case des Spiels präsentiert.

Ich messe ab dem Punkt wo die Kamera an dem großen Schild der Wache vorbei gleitet an für 40s.

Wenn eine Messung aus der Reihe tanzt, verwende ich stattdessen die siebte Messung.

Von den fünf Messungen wertet mein C++ Programm die Frametimemessungen aus und mittelt dann jeweils die drei besten Werte um Ausreißer auszuschließen..... Obwohl ich mir bei den weiteren Ramsettings immer mehr Ramteiler gespart hatte, waren es insgesamt über 500 Messungen.

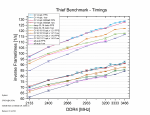

Im oberen Bereich sieht man die avg FPS und der untere Block an Messungen zeigt den Durchschnitt der schlechtesten 1% der Frametimes.

Wie man sieht hat das verwenden des GBSalt in diesem Spiel keinen wirklichen Nachteil....bei 3466 scheint es zwar einen kleinen Nachteil zu geben. Bei 3200MHz habe ich mal wieder einen Durchhänger, den ich schon öfter in anderen Spielen beobachtet habe.

Der GDM mag diesen Ramteiler scheinbar nicht....wobei sich das nicht perfekt reproduzieren lässt.

Insgesamt kann ich nicht sagen, das die andere BGS hier einen Unterschied macht.

Die 21 und 43% schlechteren Timings haben hier einen deutlichen Leistungsverlust zur Folge.

Die 21% Unterschied in den Timings resultieren im Schnitt bei 5,7% Unterschied in den avg FPS.

Die 43% Unterschied in den Timings resultieren im Schnitt bei 11,8% Unterschied in den avg FPS.

Die docp und all Auto Timings machen sich bei 2133MHz noch ganz gut, lassen zu höheren Taktraten aber immer mehr nach.

Edit: Die neu eingefügten docp Cl14 zeigen sich meist minimal besser als die docp CL15 und CL16 18 18 optx1.21 .....Wie bei den Latenzmessungen schwächeln sie etwas wenn es an die hohen Frequenzen geht.

Hier werden ein paar Subtimings von der Automatik schlechter gewählt....das diese leichten Veränderungen diesen Leistungsverlust erklären sollen finde ich jedoch komisch.... Da das System Probleme hatte mit diesen Einstellungen erfolgreich zu Booten könnte ich mir hier auch ein Eingreifen von Fehlerkorrektur oder ähnlichem denken.

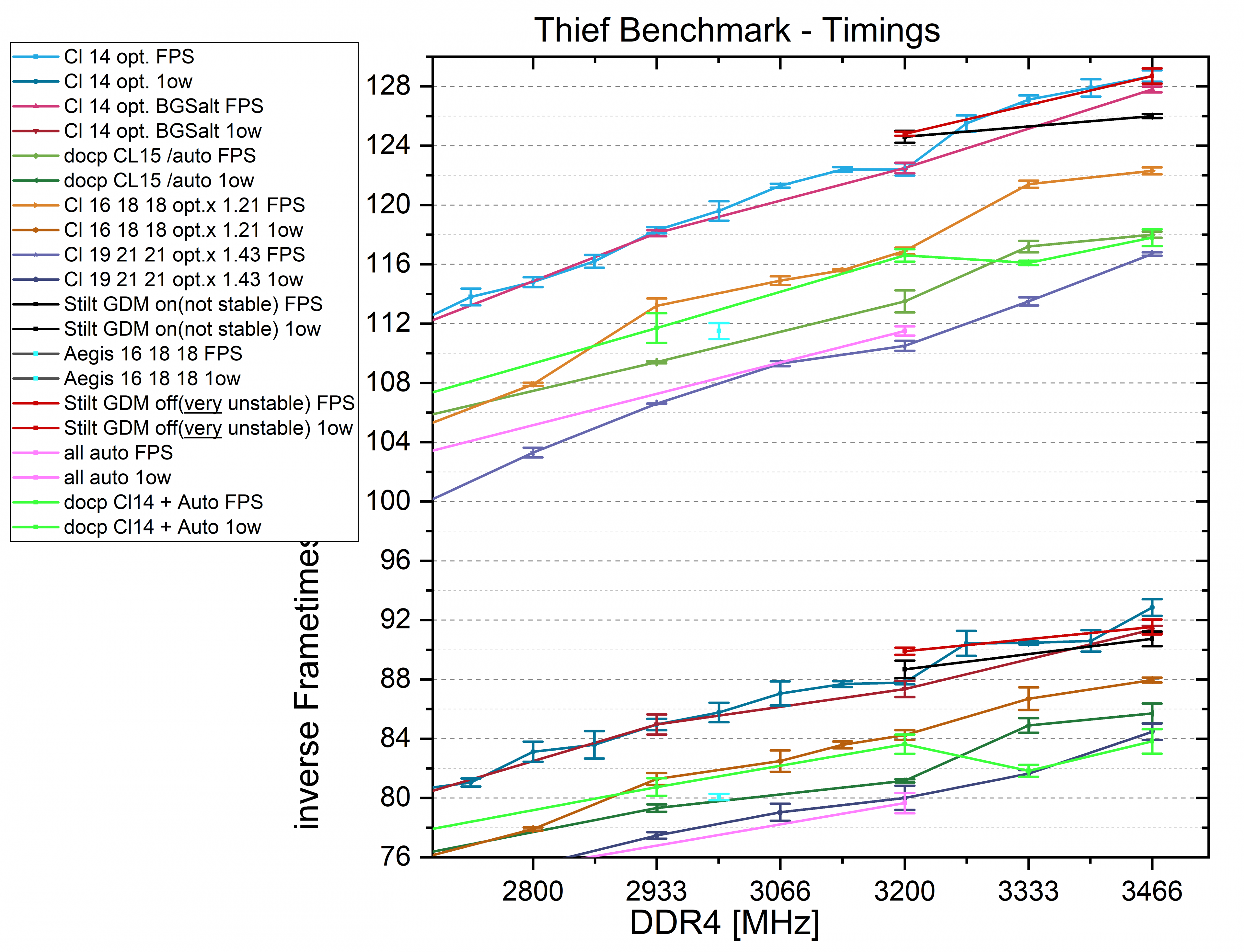

Zoomen wir wieder rein und gucken auch auf die Stilt und Aegis Timings:

Die Aegis Timings sind durchaus ein gutes Stück von den optimierten Timings entfernt(7,3%).

Sie wären noch weiter entfernt, wenn ich die Timings auch auf 3000MHz und nicht auf 3466 optimiert hätte.

Sie sind aber besser als die automatischen und die docp Timings.

Warum die Stilt Timings mit GDM Richtung 3466 schlechter werden ist etwas komisch...aber wir erinnern uns, das auch die Latenz hier ungewöhnlich war. Ansonsten sind die Werte erwartbar gut, wenn auch nicht unbedingt stabil...oder sogar sehr instabil.

Insgesamt bin ich überrascht, wie wenig sich die Timings in den Bandbreiten bemerkbar gemacht haben, und wie deutlich sie hier in diesem Spiel eine Rolle spielen.

Laut dem CB Testparcour hat ein 9900K in 1080p Spielen 26% mehr avg FPS.

Und hier machen optimierte Ramtimings bei 3200MHz verglichen mit docp(CL15) einen Unterschied von 7,8%.

Von 2933 CL16 15 15 auf 3466 CL14 opt. sind es 17,6% mehr avg FPS.

Und es ist davon auszugehen, das der Ram den CB verwendet mit 2933 Cl16 16 16 noch schlechter ausfällt.

Dann würden die CPUs nur noch 8% trennen...ein durchaus gutes Ergebniss, wenn man nur den Ram verändert.

Insgesamt haben sich die avg FPS von 2133 all Auto, auf 3466 Cl14 opt. um 36% verbessert und die 1%low um 16,6%.

Edit: Wie schon in dem vorherigen Diagramm beschrieben, habe ich die docp Cl14 hinzugefügt und ich habe auch die Stilt Messung bei 3466MHz wiederholt.

Die neuen Stilt Messungen zeigen jetzt 1,7 1/s bessere FPS und 0,8 1/s bessere 1%low Frametimes.

Auch schwanken die Messungen ungewöhnlich hoch und runter....es sind immer wieder Messungen dazwischen die die gleichen Ergebnisse wie die erste Messeihe dazu zeigten...und ein paar bessere.

Ich denke in beiden Fällen könnten die Ergebnisse bei diesen Ramfrequenzen durch eine leichte Instabilität beeinträchtigt sein...oder der GeardownMode macht in diesen Fällen was komisches....es ist mir nicht ganz klar.

Ich habe noch einen weiteren Test gemacht, der den Ram auf den 3466 CL14 opt. lässt, und stattdessen den allcore CPU Takt senkt.

Die farblich dunkeren Verläufe, die von 2133 bis 3466 gehen sind dem verändern der effektiven Ramfrequenz zugeordnet und die helleren Verläufe von 2950MHz bis 4200MHz sind der CPU Takt.

Wie man sieht ist die Steigung der Verläufe sehr ähnlich...das Spiel profitiert also in gleicher Weise von mehr Ram MHz wie von mehr CPU MHz.

Die etwas ungewöhnlichen CPU Frequenzen 2950 und 3475 sollten einen vergleich zu den um 21 und 43% unterschiedlichen Timings ziehen....vergleichen wir also CPU/DRAM Takt und Timings miteinander:

Faktor 1,21;

weniger CPU Takt = 12,8% avg FPS

weniger DRam Takt = 10,8% avg FPS

höhere Timings = 5,2% avg FPS

Faktor 1,43;

weniger CPU Takt = 23% avg FPS

weniger DRam Takt = 21,6% avg FPS

höhere Timings = 10,3% avg FPS

Der CPU Takt bringt also schon etwas mehr als der DRam Takt, und die Timings wirken sich nur halb so stark aus.

Fazit:

Viele Messungen und hoffentlich für manche eine jetzt etwas klarere Datenlage.

Was bringen die Timings, was bringt der Takt usw.

Der GDM ist mit mehr als einer rank pro Channel für hohe Taktraten alternativlos.

Eine genauere Untersuchung zu seinem Einfluss würde noch ausstehen.

Die BankGrouSwap Option ist zumindest in diesem Spiel nicht von Bedeutung.

Ich müsste noch testen, wie es da in anderen Spielen aussieht.....hat da schon jemand aktuelle Erfahrungen?

Die Stilt timings waren schnell, aber nicht stabil....helfen dem unbedarften Nutzer als nicht wirklich.

Aber eventuell wären sie stabil wenn ich 2x8GB und nicht 4x8GB nutzen würde.

Der Vergleich mit den Aida64 Werten legt nahe, dass die Spieleperformance vor allem durch die Latenzen gegeben ist und eventuell etwas durch die copy Leistung.

Dieses Spiel profitiert fast so gut von Ramgeschwindigkeit wie es von CPU Takt profitiert. Das ist sicherlich nicht gewöhnlich, aber auch das müsste man mal in anderen Spielen gegenüberstellen.

Mir ging es in diesem Test weniger um das verwendete Spiel an sich....das wird wohl kaum jemand spielen und es lief auch mit dem schlechtesten Ram noch ganz gut.

Mir ging es darum die Auswirkungen von Ram Takt und Ram Timings irgendwie gemeinsam darzustellen...deshalb auch die unübersichtlichen Diagramme mit zu vielen Daten.

Meine Idee war es, das jemand der sich z.B. fragt ob er seinen Ram von 2933 auf 3333 übertakten sollte, wenn er dafür schlechtere Timings in Kauf nehmen muss.

Oder ob sich jemand überhaupt mit besseren Timings beschäftigen sollte.

Dann kann er im Diagramm die am bestem zu seiner Situation passenden Verläufe heraussuchen und eine grobe Abschätzung machen.

Ich hoffe das ist mir halbwegs gelungen.

Wie jemand dies interpretiert ist sicherlich sehr subjektiv.

Der eine sagt sich..."Was sind schon 5%?" und der andere sieht in 5% den Aufpreis zur nächst besseren CPU....und ich denke mir..."Mir macht Ram OC Spaß...ich nehme auch jedes halbe % mit wenn ich kann!"

Was meint ihr zu den Ergebnissen?

Habt ihr Verbesserungsvorschläge oder Einwände...Fragen?

Edit: es sind jetzt Messungen mit docp CL14 14 14 34 eingefügt und die problematischen 3466MHz Messungen mit den Stilt Timings sind wiederholt und bestätigt.

Die Haupttimings sind überraschenderweise kaum besser als die docp CL15 Messungen, oder die CL16 18 18 Messungen mit opt.x1.21er Timings.

Und zu höheren Frequenzen sacken die FPS sogar wieder ab oder stagnieren..... eventuell eine Eigenheit des GDM oder von Fehlerkorrektur aufgrund von Instabilitäten.

Wobei die Timings eigentlich alle schlechter sind als meine stabilen manuellen Timings und nur tWTRS bei mir eigentlich auf 6 ausgelotet war und von der Automatik auf 5 gesetzt wird.....ob dieses eine instabile Timings solche Auswirkungen hat ist komisch....

Edit2: Ich habe nochmal meine optimierten Timings mit tWTRS auf 5 getestet...Die Messungen haben deutlich mehr geschwankt als mit tWTRS auf 6 und auch das Booten hatte lange gebraucht...und Thief wollte sich erst nicht schließen lassen...ich würde sagen es könnte wirklich an diesem Timing liegen, das die CL14 dopc Timings hier so komisch sind.

Vor ein paar Wochen habe ich auf einen 2700X und ein zweites 2x8GB 3600 Cl15er Kit aufgerüstet.

Nachdem ich die 4x8GB erfolgreich zu meiner Zufriedenheit übertaktet hatte, habe ich mich letzte Woche daran gemacht auch mal in die Welt der schlechteren Timings zu gucken.

Vorwort:

Es ist hoffentlich den meisten klar, dass schneller Ram in CPU limitierten Spielen einen deutlichen Unterschied machen kann und auch in eigentlich GPU limitierten Spielen, gibt es oft Bereiche, wo die Leistung ohne schnellen Ram deutlicher einbricht.

In der Vergangenheit habe ich viele Spieletests einmal bei 2133 und einmal bei 3200MHz bei gleichen Timings gemacht und damit getestet, ob das Spiel in dieser Situation von Ram profitiert oder nicht.

Das beantwortet zwar die Frage, ob das Spiel von schnellem Ram profitiert, aber nicht wie es bei verschiedenen Ramsettings und Timings profitieren würde.

Und diesem komplexen Punkt wollte ich mich etwas annähern.

Einige meiner alten Tests:

https://www.computerbase.de/forum/t...kussion-zu-spieletests.1728575/#post-20678303

Ich lege viel Wert auf die Qualität der Messungen...daher habe ich meine Methoden immer weiter optimiert.

Teilweise basierte ein Ergebniss auf 20+ Messungen verteilt auf mehrere Tage......und ich habe eine breite Auswahl an Spielen getestet um ein vollständiges Bild zu erhalten.

Aus Zeitgründen und um die Benchmarks nebenbei durchführen zu können habe ich mich hier etwas eingeschränkt...die Ergebnisse basieren nur noch auf 6-7 Messungen(außer sie waren unlogisch, dann habe ich sie wiederholt).

...und ich habe nur Theoriewerte mit Aida64 und mit Thief nur ein einziges Spiel getestet.

Thief an sich ist dabei uninteressant....es war einfach ein Spiel, das mit meiner Radeon VII auch mit 1440p und maximalen Details(außer SSAA), komplett CPU limitiert ist und das schnell startet und einen brauchbaren ingame Benchmark hat.

Statt einzelne Ergebnisse wie 3466MHz CL14 ganz genau zu vermessen habe ich mich für Verläufe abhängig vom Takt entschieden....die einzelnen Werte mögen etwas schwanken, aber der Verlauf an sich gibt einen guten Eindruck.

Um die Messungen besonders zuverlässig zu machen, ist der 2700X auf feste 4,2GHz allcore getaktet.

Die Radeon VII ist auf 992mV bei 1831MHz undervolted, der HBM2 leicht auf 1050MHz übertaktet und die Lüftersteuerung ist agressiver eingestellt, um auf keinen Fall durch die Temperatur gedrosselt zu sein.

Windows 10 ist aktuell und der AMD Treiber ist der 19.4.3

In der Vergangenheit habe ich viele Spieletests einmal bei 2133 und einmal bei 3200MHz bei gleichen Timings gemacht und damit getestet, ob das Spiel in dieser Situation von Ram profitiert oder nicht.

Das beantwortet zwar die Frage, ob das Spiel von schnellem Ram profitiert, aber nicht wie es bei verschiedenen Ramsettings und Timings profitieren würde.

Und diesem komplexen Punkt wollte ich mich etwas annähern.

Einige meiner alten Tests:

https://www.computerbase.de/forum/t...kussion-zu-spieletests.1728575/#post-20678303

Ich lege viel Wert auf die Qualität der Messungen...daher habe ich meine Methoden immer weiter optimiert.

Teilweise basierte ein Ergebniss auf 20+ Messungen verteilt auf mehrere Tage......und ich habe eine breite Auswahl an Spielen getestet um ein vollständiges Bild zu erhalten.

Aus Zeitgründen und um die Benchmarks nebenbei durchführen zu können habe ich mich hier etwas eingeschränkt...die Ergebnisse basieren nur noch auf 6-7 Messungen(außer sie waren unlogisch, dann habe ich sie wiederholt).

...und ich habe nur Theoriewerte mit Aida64 und mit Thief nur ein einziges Spiel getestet.

Thief an sich ist dabei uninteressant....es war einfach ein Spiel, das mit meiner Radeon VII auch mit 1440p und maximalen Details(außer SSAA), komplett CPU limitiert ist und das schnell startet und einen brauchbaren ingame Benchmark hat.

Statt einzelne Ergebnisse wie 3466MHz CL14 ganz genau zu vermessen habe ich mich für Verläufe abhängig vom Takt entschieden....die einzelnen Werte mögen etwas schwanken, aber der Verlauf an sich gibt einen guten Eindruck.

Um die Messungen besonders zuverlässig zu machen, ist der 2700X auf feste 4,2GHz allcore getaktet.

Die Radeon VII ist auf 992mV bei 1831MHz undervolted, der HBM2 leicht auf 1050MHz übertaktet und die Lüftersteuerung ist agressiver eingestellt, um auf keinen Fall durch die Temperatur gedrosselt zu sein.

Windows 10 ist aktuell und der AMD Treiber ist der 19.4.3

R7 2700X@4,2GHz

Crosshair VI Hero

4x8GB 3600cl15 Samsung B-Die

Radeon VII UVOC

Ramsettings:

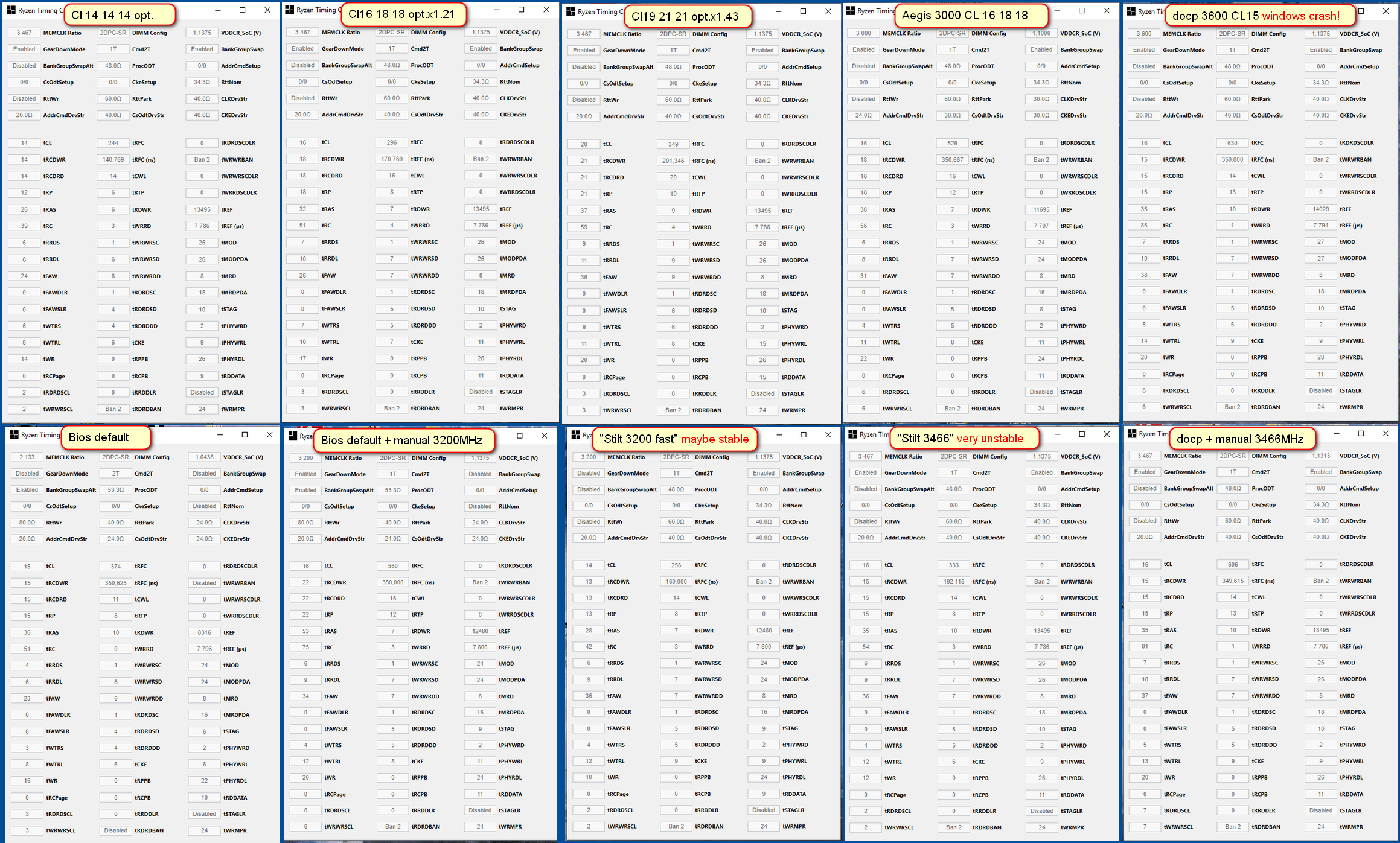

Ich habe verschiedene Kombinationen ausprobiert und ich möchte hier auf die Abkürzungen eingehen.

BGS und GBSalt Diese stehen für BankGroupSwap und ist eine Einstellung, die mit der Art des Memory Managements zu tun hat.

Ursprünglich gab es bei Ryzen nur BGS und es war automatisch on(enabled). Dies hatte sich als nachteilig für die Verwendung von zwei single ranked Modulen herausgestellt und die Option wurde in weiteren Bios Versionen deaktiviert und dafür wurde BankGroupSwapAlt

aktiviert. In Starkraft 2 hatte ich damals mit meinen 2x16GB dual ranked Modulen einen leichten Nachteil gemessen.

Die verbreitete Meinung zu dieser Einstellung ist es, das sie für 2x16 oder 4x8GB aktiviert und GBSAlt deaktiviert sein sollte.

Mit dem neusten Bios kann ich diese Settings wieder selbst wählen und ich habe mich für BGS on und BGSalt off entschieden.

GDM steht für GearDownMode und beschreibt eine spezielle Version der comand rate(überschreibt sie). Eigentlich wählt man die Comand Rate als 1T oder 2T...wobei 1T die Befehle einmal sendet und 2T sie zweimal sendet, für den Fall, das der erste Befehl nicht verstanden wurde.

Der GDM arbeitet selektiv und fängt zu höheren Taktfrequenzen an, kritische Befehle mit halber Frequenz zu senden um die Stabilität zu erhöhen. Das kostet etwas Leistung, erhöht aber auch stark die Stabilität und es war mir ohne diesen Modus nicht möglich effektive Ramtakte über 3266 stabil zu bekommen.

Daher ist er in meinen Messungen(wenn nicht anders gekennzeichnet) aktiv.

Für Leute die Ram unterhalb von 3200MHz verwenden, würde ich empfehlen den GDM auszuschalten.

CL 14 14 14 opt. Diese Timings sind die Timings, die ich auf 3466MHz bei 14er Haupttimings optimiert habe.

Sie stellen also die schnellste Option dar, die ich stabil betreiben konnte...alle Timings die das Bios bietet sind fest gewählt und werden bei niedrigeren Frequenzen nicht geändert.

CL 16 18 18 opt.x1,21 Diese Timings sind eine Abwandlung der 14er Timings. 16 18 18 sind die typische nächste Empfehlung für Timings wenn keine 3200 CL14er Samsung B-die benutzt werden. Deshalb habe ich mich für diese Haupttimings entschieden.

Der mittlere Unterschied von 14 zu 16 und 14 zu 18 ist der Faktor 1,21, den ich auf die optimierten Timings angewendet habe und durch auf- und abrunden neue Subtimings gefunden habe, die alle ungefär 21% schlechter sind als vorher.

Cl 19 21 21 opt.x1,43 Die gleiche Idee wie bei CL16 18 18....Ram mit hohen Frequenzen wie 4000+ kommt oft mit 19 21 21er Haupttimings. Die 1,43 sind wieder der Faktor für die Subtimings verglichen mit CL14 opt.

Aegis 3000 bezieht sich auf den beliebten 2x8GB CL16 18 18er Ram mit 3000MHz. Die Timings hierzu habe ich aus zwei verschiedenen Quellen aus dem Internet, wo Leute das docp Profil für den Ram geladen hatten und einen RTC Screenshot gepostet hatten. Deren Timings wichen leicht ab, weshalb ich hier eine Mischung verwende.

docp ist bei Asus der Name für das Ramprofil(XMP). Hierbei habe ich das Ramprofil geladen, was die Haupttimings einstellt und die anderen Timings auf Auto lässt. Da 3600 überhauptnicht stabil waren, habe ich dann schrittweise den Takt von 3466 bis 2133 gesenkt.

Mein Ramprofil sieht 15 15 15 vor, aber wegen dem GDM wird für die Cas-latency keine geraden Werte zugelassen, so dass es in 16 15 15 mündet.

Bios Default/all Auto hier lasse ich das Bios alles inklusive der Haupttimings wählen...ich habe nur 2133 also die Basis, die eingestellt ist, wenn man nichts am Ram verstellt und 3200MHz getestet...also wenn jemand nur den Takt ändert ohne was anderes zu machen.

Stilt Mein Asus Board hat Ramprofile des Übertakters Stilt im Bios hinterlegt. Diese sind eigentlich für 2x8GB Samsung B-Die ausgelegt und nicht für meine 4x8GB aber ich habe zwei der Profile hier getestet. Einmal "Stilt 3200 fast", ein Satz niedriger Timings für 3200MHz. Mir kommen tWRTS und tWR zu niedrig vor...ich habe aber nicht auf Stabilität getestet.

Und "Stilt 3466" ein Satz Timings für den gleichen Ram aber mit 3466MHz. Diese Timings waren absolut instabil...ich hatte einige Abstürze...Steam wollte manchmal nicht starten...Aida64 ging manchmal nicht und ich brauchte einige Versuche bis ich genügend Messungen in Thief überstanden hatte.

Das Ramprofil deaktiviert auch den GDM, was die Stabilität torpediert...dehalb habe ich auch Messungen mit GDM on gemacht....stabil waren die trotzdem nicht da tWRTS und tWR weiterhin zu niedrig waren.

Hier die Screenshots der verschiedenen Timings:

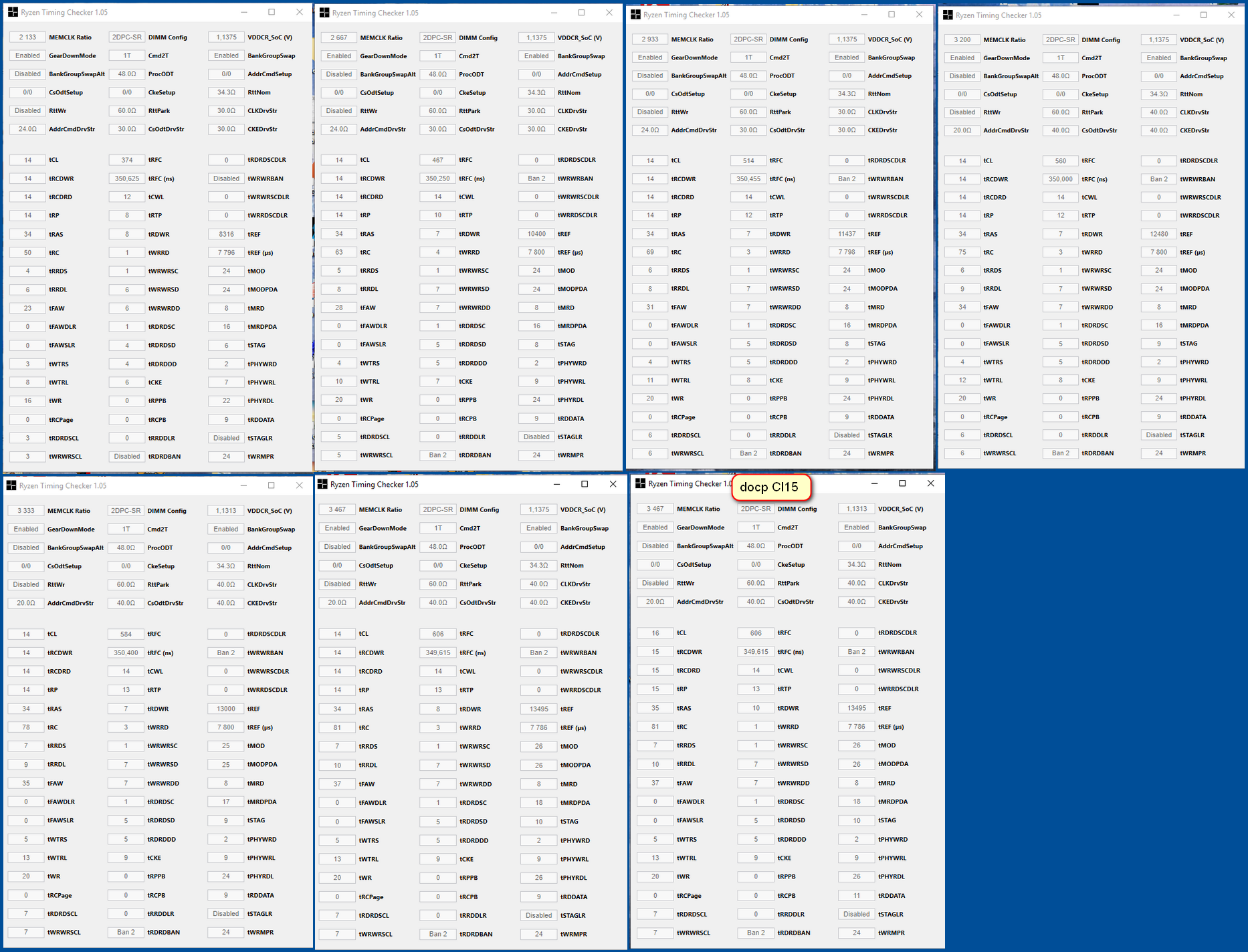

Und hier die RTC Screenshots bei docp Haupttimings aber automatischen Subtimings...der letzte Screeshot sind meine optimierten Timings:

Edit: hier die nachträglich eingefügten cl14 14 14 34er Haupttimings mit den automatischen Subtimings:

Sie scheinen fast das gleiche zu machen wie die docp CL15er Timings, jedoch ist die wichtige twrrd hier oft auf 3 statt auf 1.

Crosshair VI Hero

4x8GB 3600cl15 Samsung B-Die

Radeon VII UVOC

Ramsettings:

Ich habe verschiedene Kombinationen ausprobiert und ich möchte hier auf die Abkürzungen eingehen.

BGS und GBSalt Diese stehen für BankGroupSwap und ist eine Einstellung, die mit der Art des Memory Managements zu tun hat.

Ursprünglich gab es bei Ryzen nur BGS und es war automatisch on(enabled). Dies hatte sich als nachteilig für die Verwendung von zwei single ranked Modulen herausgestellt und die Option wurde in weiteren Bios Versionen deaktiviert und dafür wurde BankGroupSwapAlt

aktiviert. In Starkraft 2 hatte ich damals mit meinen 2x16GB dual ranked Modulen einen leichten Nachteil gemessen.

Die verbreitete Meinung zu dieser Einstellung ist es, das sie für 2x16 oder 4x8GB aktiviert und GBSAlt deaktiviert sein sollte.

Mit dem neusten Bios kann ich diese Settings wieder selbst wählen und ich habe mich für BGS on und BGSalt off entschieden.

GDM steht für GearDownMode und beschreibt eine spezielle Version der comand rate(überschreibt sie). Eigentlich wählt man die Comand Rate als 1T oder 2T...wobei 1T die Befehle einmal sendet und 2T sie zweimal sendet, für den Fall, das der erste Befehl nicht verstanden wurde.

Der GDM arbeitet selektiv und fängt zu höheren Taktfrequenzen an, kritische Befehle mit halber Frequenz zu senden um die Stabilität zu erhöhen. Das kostet etwas Leistung, erhöht aber auch stark die Stabilität und es war mir ohne diesen Modus nicht möglich effektive Ramtakte über 3266 stabil zu bekommen.

Daher ist er in meinen Messungen(wenn nicht anders gekennzeichnet) aktiv.

Für Leute die Ram unterhalb von 3200MHz verwenden, würde ich empfehlen den GDM auszuschalten.

CL 14 14 14 opt. Diese Timings sind die Timings, die ich auf 3466MHz bei 14er Haupttimings optimiert habe.

Sie stellen also die schnellste Option dar, die ich stabil betreiben konnte...alle Timings die das Bios bietet sind fest gewählt und werden bei niedrigeren Frequenzen nicht geändert.

CL 16 18 18 opt.x1,21 Diese Timings sind eine Abwandlung der 14er Timings. 16 18 18 sind die typische nächste Empfehlung für Timings wenn keine 3200 CL14er Samsung B-die benutzt werden. Deshalb habe ich mich für diese Haupttimings entschieden.

Der mittlere Unterschied von 14 zu 16 und 14 zu 18 ist der Faktor 1,21, den ich auf die optimierten Timings angewendet habe und durch auf- und abrunden neue Subtimings gefunden habe, die alle ungefär 21% schlechter sind als vorher.

Cl 19 21 21 opt.x1,43 Die gleiche Idee wie bei CL16 18 18....Ram mit hohen Frequenzen wie 4000+ kommt oft mit 19 21 21er Haupttimings. Die 1,43 sind wieder der Faktor für die Subtimings verglichen mit CL14 opt.

Aegis 3000 bezieht sich auf den beliebten 2x8GB CL16 18 18er Ram mit 3000MHz. Die Timings hierzu habe ich aus zwei verschiedenen Quellen aus dem Internet, wo Leute das docp Profil für den Ram geladen hatten und einen RTC Screenshot gepostet hatten. Deren Timings wichen leicht ab, weshalb ich hier eine Mischung verwende.

docp ist bei Asus der Name für das Ramprofil(XMP). Hierbei habe ich das Ramprofil geladen, was die Haupttimings einstellt und die anderen Timings auf Auto lässt. Da 3600 überhauptnicht stabil waren, habe ich dann schrittweise den Takt von 3466 bis 2133 gesenkt.

Mein Ramprofil sieht 15 15 15 vor, aber wegen dem GDM wird für die Cas-latency keine geraden Werte zugelassen, so dass es in 16 15 15 mündet.

Bios Default/all Auto hier lasse ich das Bios alles inklusive der Haupttimings wählen...ich habe nur 2133 also die Basis, die eingestellt ist, wenn man nichts am Ram verstellt und 3200MHz getestet...also wenn jemand nur den Takt ändert ohne was anderes zu machen.

Stilt Mein Asus Board hat Ramprofile des Übertakters Stilt im Bios hinterlegt. Diese sind eigentlich für 2x8GB Samsung B-Die ausgelegt und nicht für meine 4x8GB aber ich habe zwei der Profile hier getestet. Einmal "Stilt 3200 fast", ein Satz niedriger Timings für 3200MHz. Mir kommen tWRTS und tWR zu niedrig vor...ich habe aber nicht auf Stabilität getestet.

Und "Stilt 3466" ein Satz Timings für den gleichen Ram aber mit 3466MHz. Diese Timings waren absolut instabil...ich hatte einige Abstürze...Steam wollte manchmal nicht starten...Aida64 ging manchmal nicht und ich brauchte einige Versuche bis ich genügend Messungen in Thief überstanden hatte.

Das Ramprofil deaktiviert auch den GDM, was die Stabilität torpediert...dehalb habe ich auch Messungen mit GDM on gemacht....stabil waren die trotzdem nicht da tWRTS und tWR weiterhin zu niedrig waren.

Hier die Screenshots der verschiedenen Timings:

Und hier die RTC Screenshots bei docp Haupttimings aber automatischen Subtimings...der letzte Screeshot sind meine optimierten Timings:

Edit: hier die nachträglich eingefügten cl14 14 14 34er Haupttimings mit den automatischen Subtimings:

Sie scheinen fast das gleiche zu machen wie die docp CL15er Timings, jedoch ist die wichtige twrrd hier oft auf 3 statt auf 1.

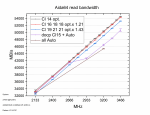

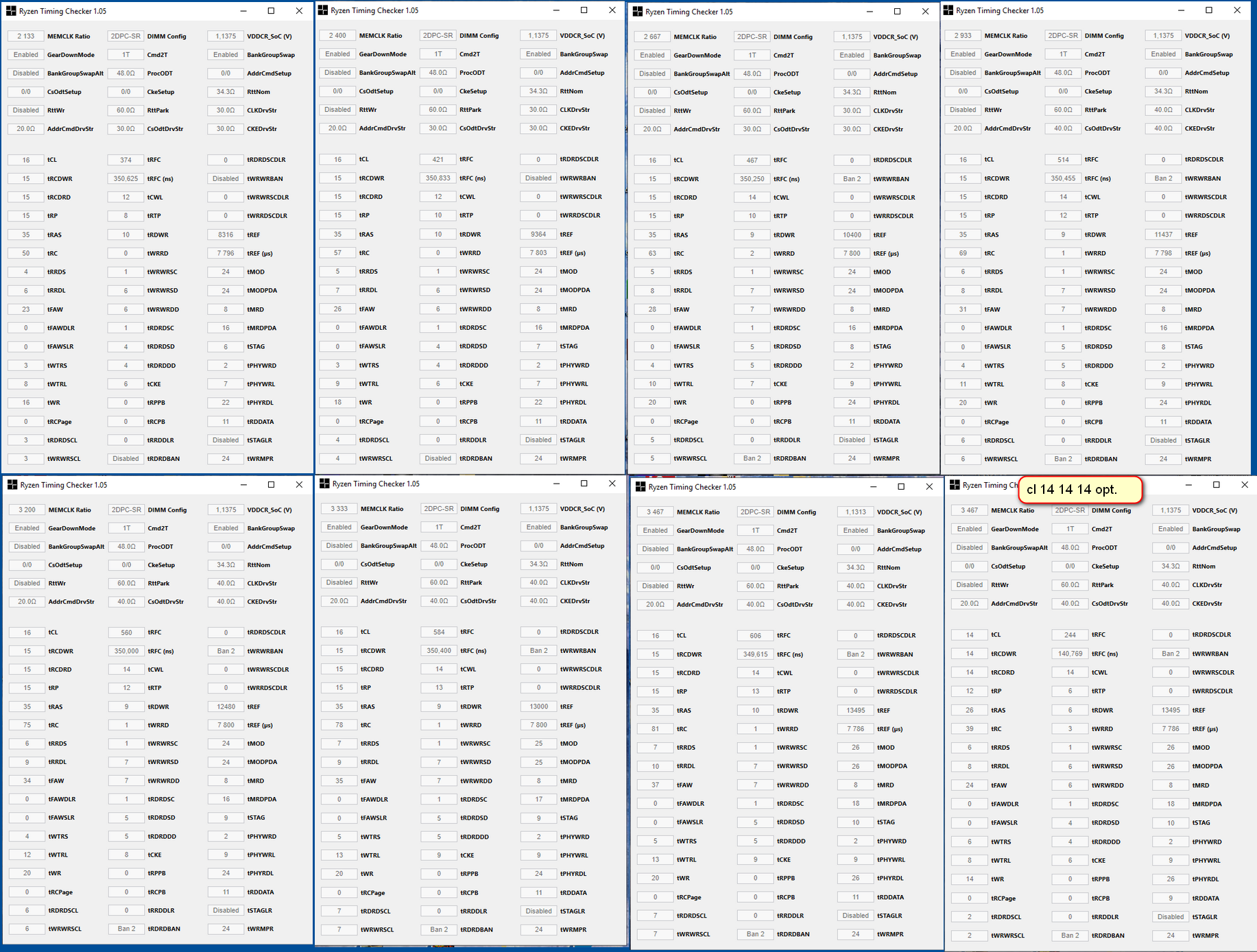

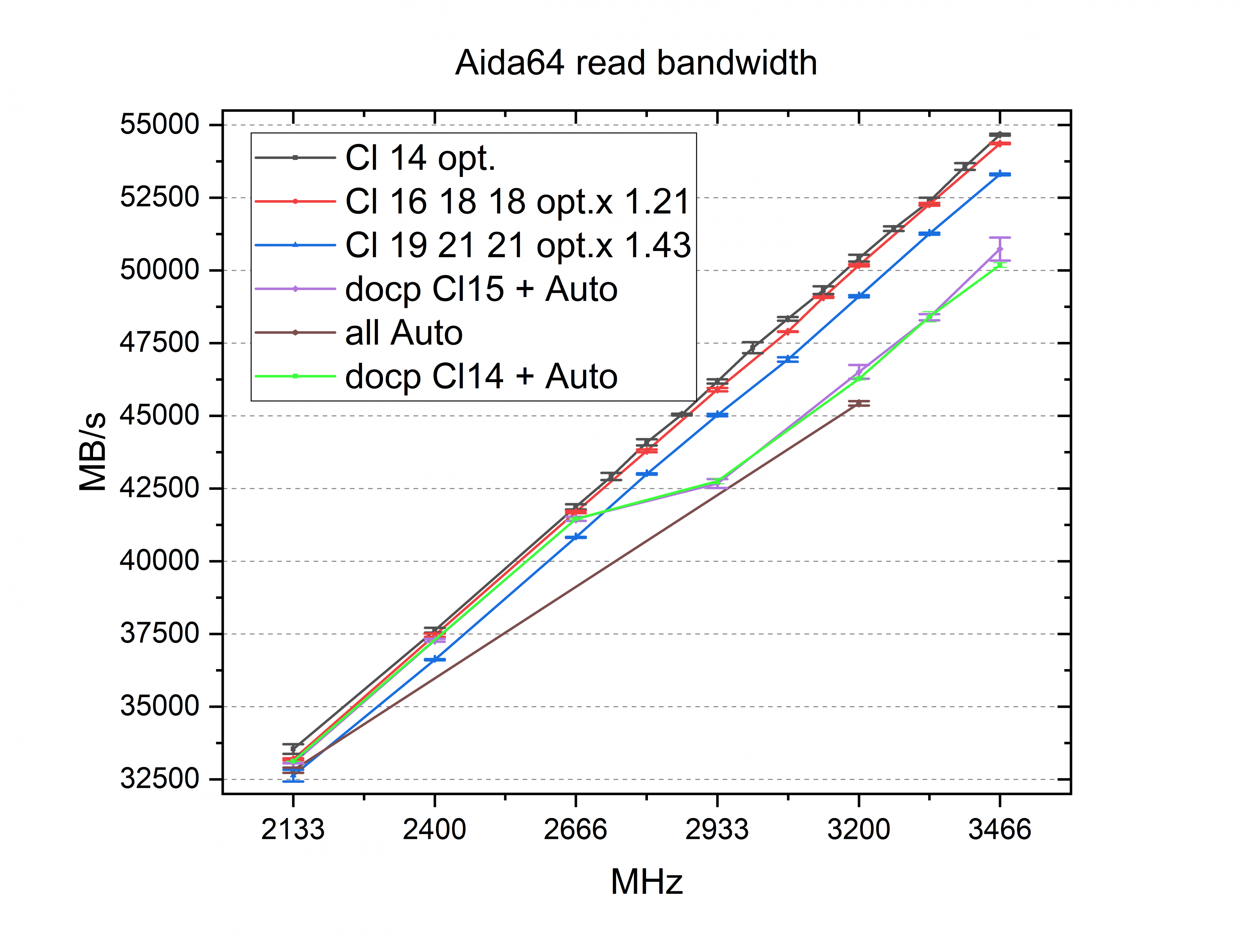

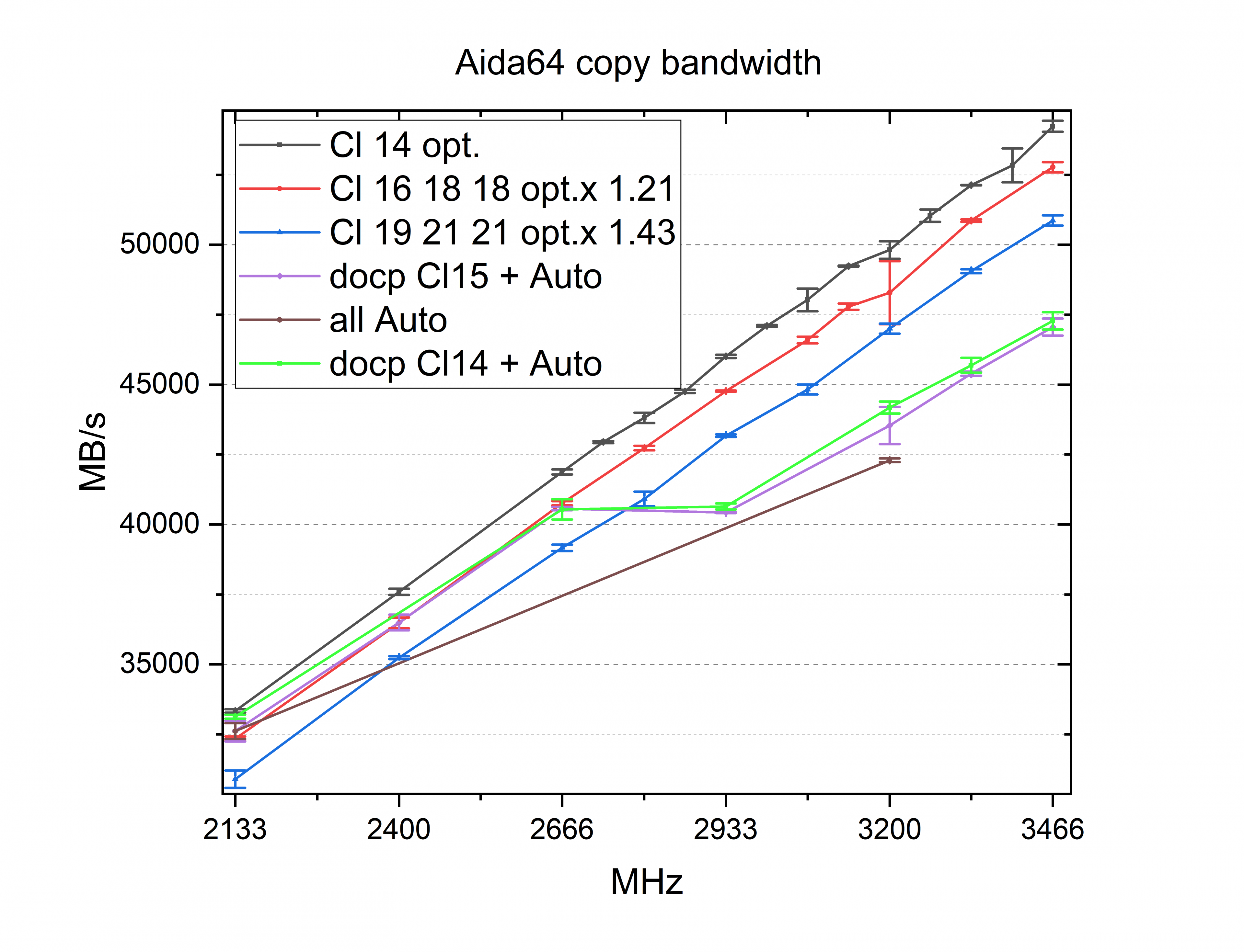

Ich habe jeden Wert drei mal gemessen und bei zu starken Abweichungen, eine vierte oder fünfte Messung ergänzt...die Werte hier sind also immer der Mittelwert aus drei Messungen und die Fehlerbalken sind die empirische Standardabweichung.

Wie man sieht sind die 21% schlechteren Timings gar nicht so weit entfernt was die Lesebandbreite angeht.

Die docp Timings halten erst ganz gut mit, weil sie mit CL15 15 15 auch gute voraussetzungen haben, aber ab 2666MHz sind sie plötzlich deutlich abgeschlagen was ich mir nicht so richtig erklären kann, da die Timings zwar schlechter werden, hier aber keine besonderen Sprung aufweisen.

Die Timings komplett auf Auto zu lassen führt bei 3200MHz zu insgesamt schlechten Timings und daher auch der schlechtesten 3200MHz Leistung.

Edit: ich habe jetzt auch docp CL14 14 14 34 eingefügt und es unterscheidet sich überhaupt nicht von den 16 15 15 35 aus dem docp CL15.

Obwohl die Haupttimings besser geworden sind und fast alle Subtimings gleich geblieben sind ist das Ergebnis das gleiche.

Im Grunde hat sich nur tWRRD von 1 auf 3 verschlechtert...dieses TImings hat schon in der Vergangenheit große Leistungs und Stabilitätseinflüsse gezeigt...das es die Haupttimings ausgleicht hätte ich nicht gedacht.

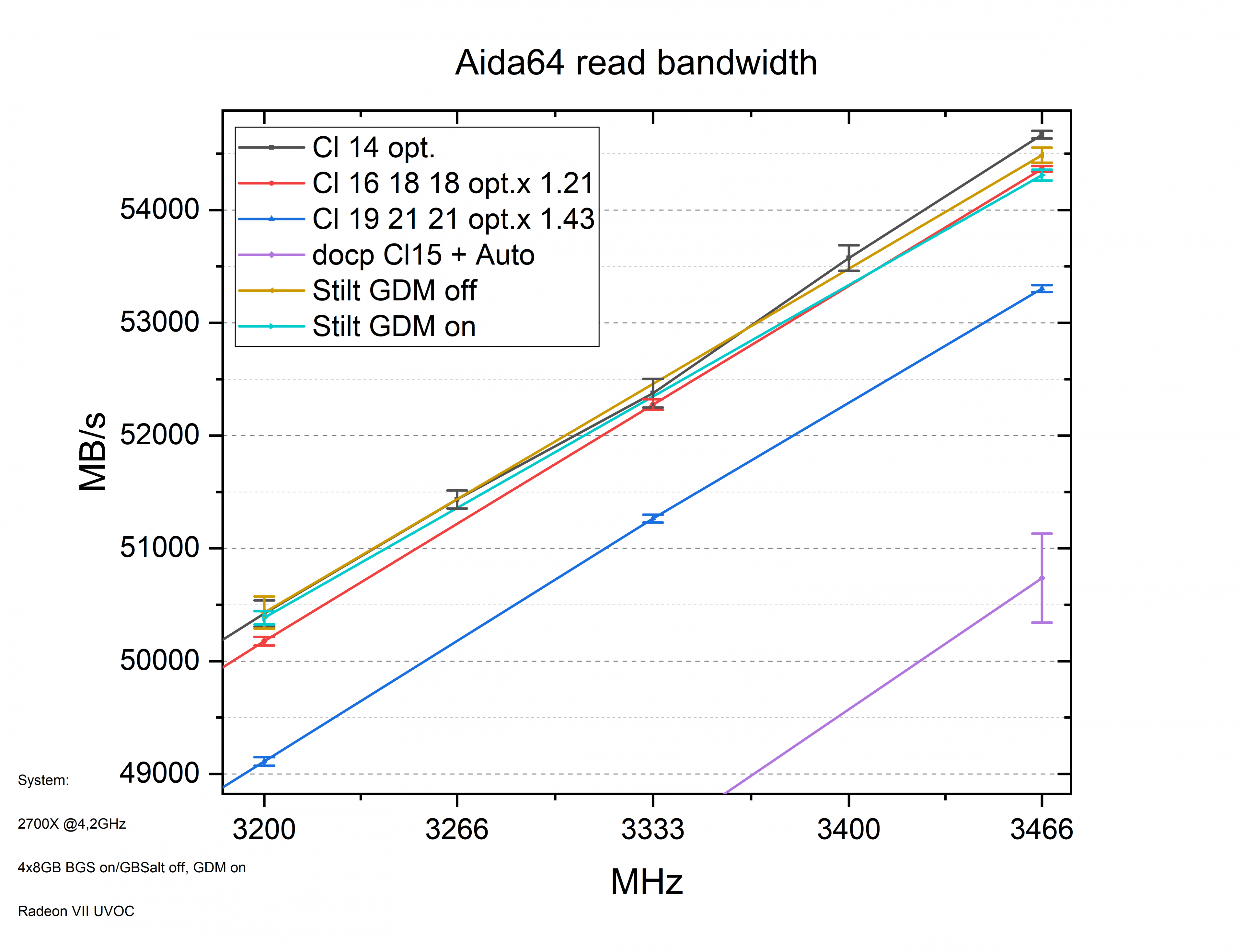

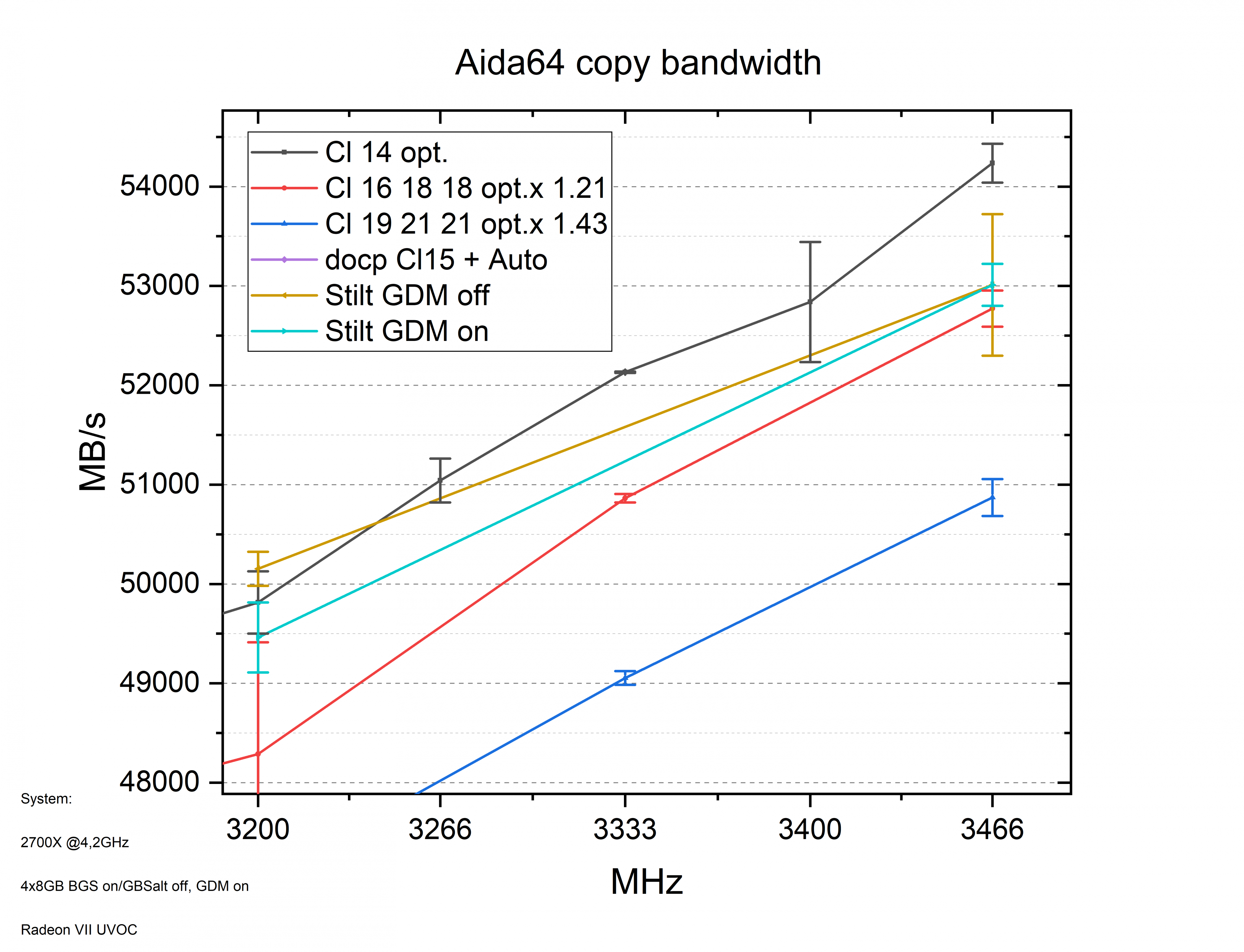

Zoomen wir auf den oberen Bereich und blenden noch die Stilt Timings ein:

Die Stilt Timings sind ohne GDM bei 3200 die besten und auch bei 3466 nicht weit entfernt...allerdings nicht stabil.

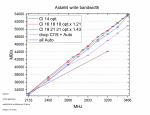

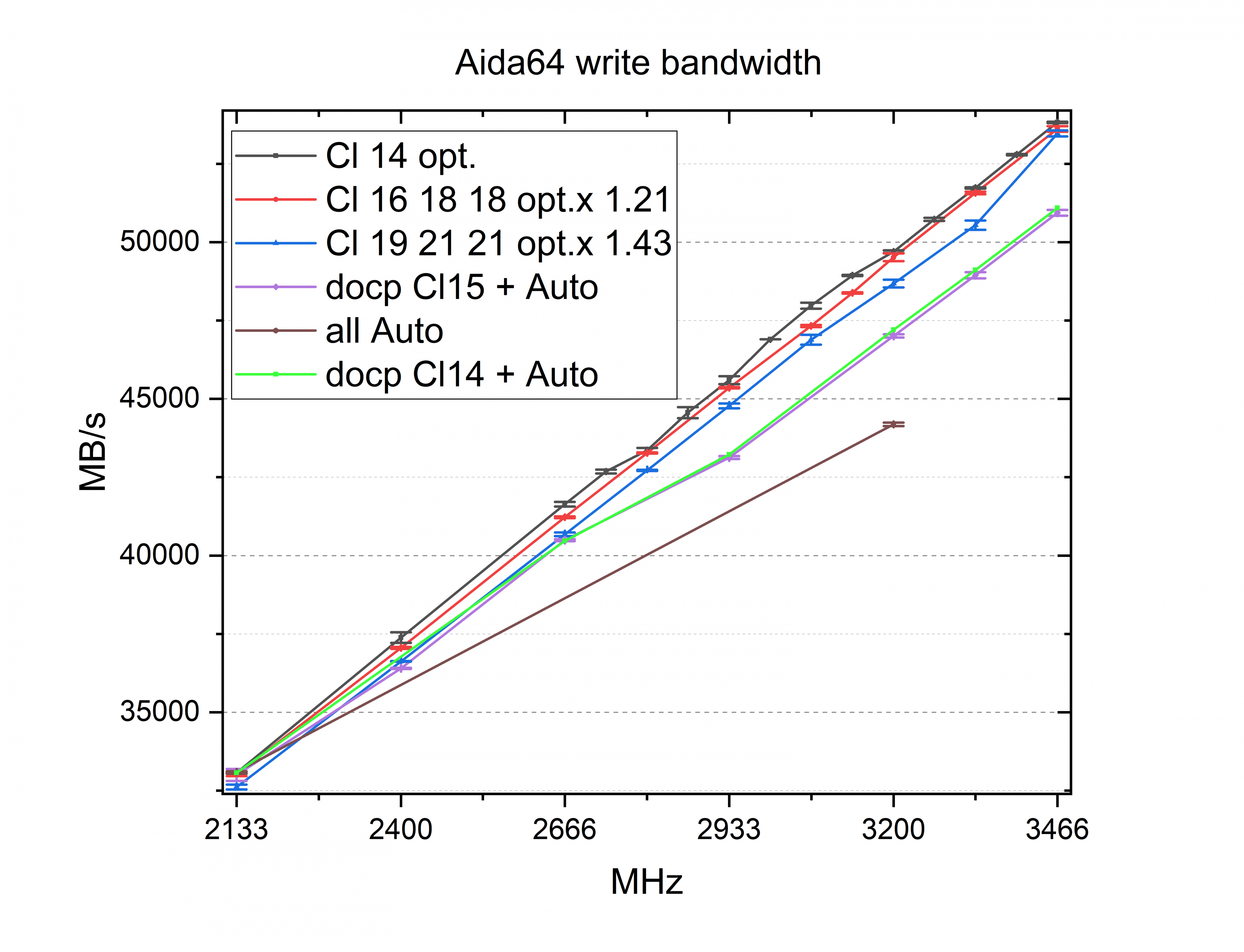

Ein ähnliches Bild zeigt sich bei der write Bandbreite.

Das Schreiben ist jedoch etwas schlechter zu reproduzieren als das Lesen.

Edit: gleiches Bild wie bei read für die neu eingefügten docp Cl14.

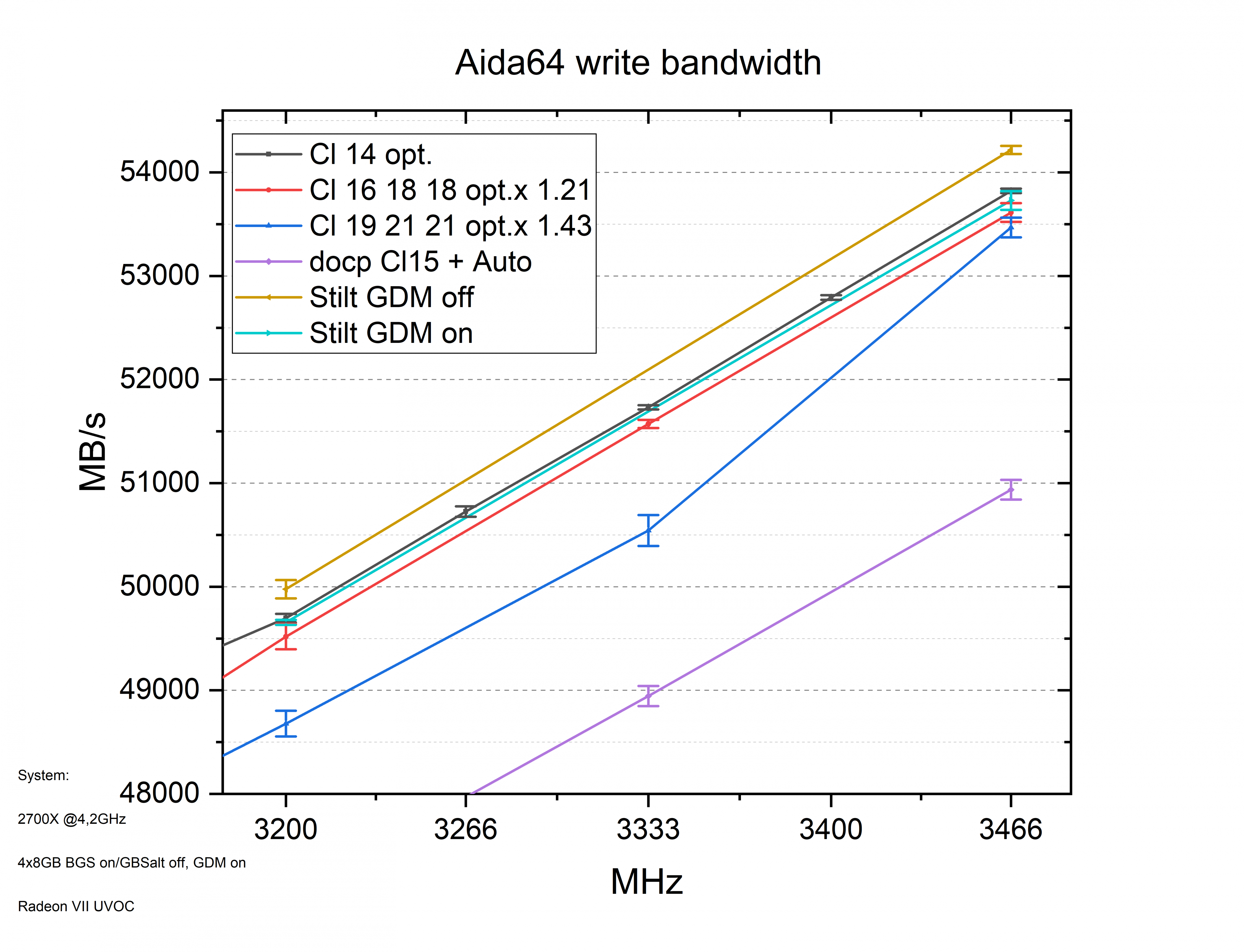

Der GDM macht für die Stilt Timings hier einen großen Unterschied. Da sie nicht stabil sind, ist das jedoch keine große Sache.

Warum die 43% schlechteren Timings bei 3466 wieder aufschließen kann ich mir nicht erklären...eventuell waren die drei Messungen einfach glücklicher.

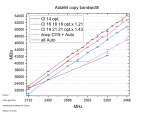

Die automatischen Timings verlieren besonders in der Copy Bandbreite an Leistung.

Auch lässt sich copy noch schlechter zuverlässig messen.

Edit: und auch für Copy das gleiche Verhalten der docp CL14

Bei 3466 machen sich die Stilt Timings hier nicht so gut.

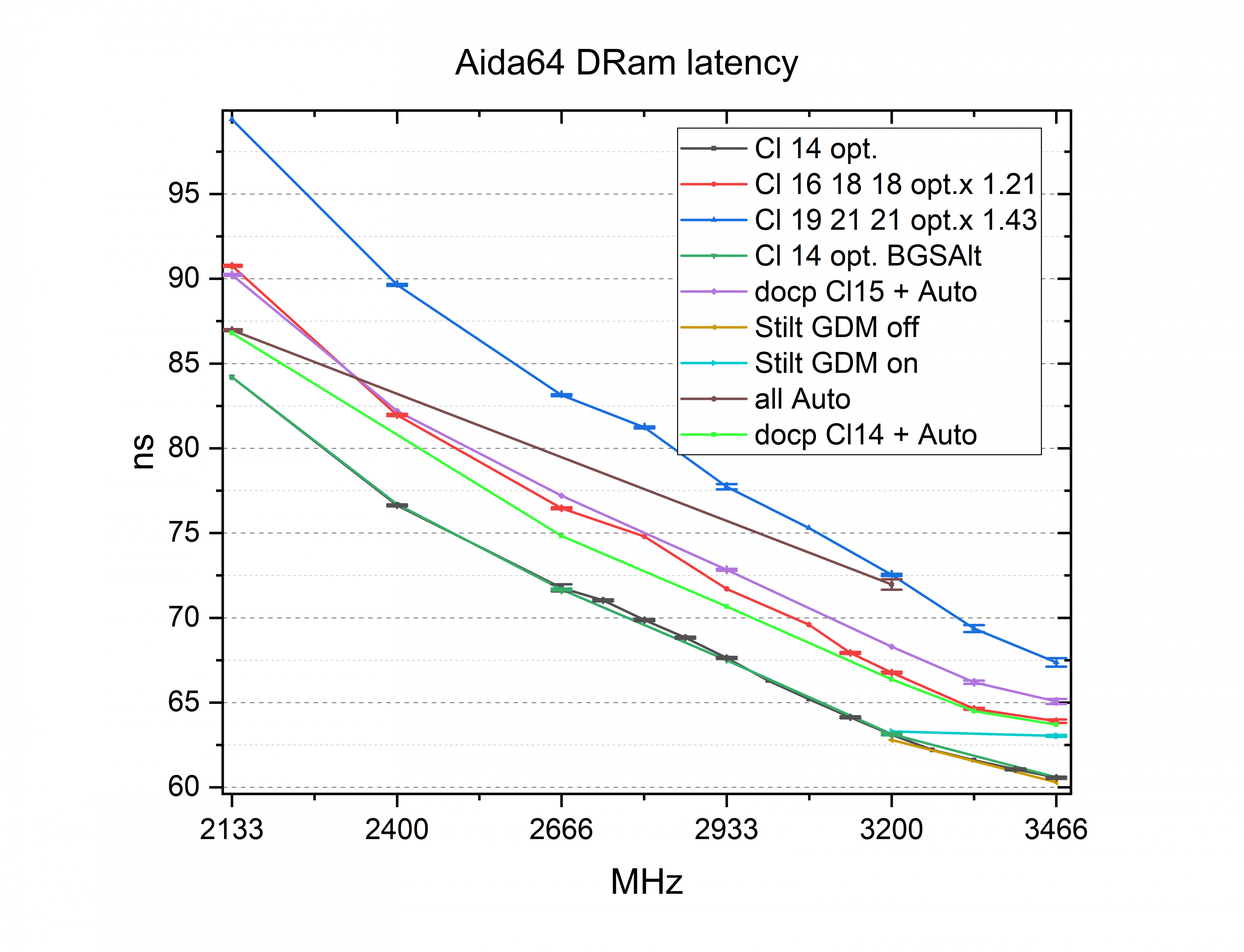

Hier habe ich noch Messungen der CL14er Timings mit deaktivertem BGS und aktiviertem BGSAlt eingefügt. Wie man sieht ist der Unterschied vernachlässigbar und das galt auch schon für die Bandbreiten.

Wir sehen deutlich größere Einflüsse durch die schlechteren Timings.

docp hält sich jedoch nicht schlecht im Vergleich zu CL16 und die Stilt Timings sind mit 3466MHz überraschend schlecht....jedoch nur wenn der GDM eingeschaltet ist. Eventuell arbeitet hier schon eine Fehlerkorrektur oder die Messung hatte Probleme.

Edit: Die Aida64 Werte für den komischen Stilt 3466 GDM on Wert habe ich wiederholt und konnte sie alle gestätigen. Laut der neuen Messungen waren die Bandbreiten im Bereich der Messungenauigkeit gleich und die Latenz nur 0,133ns besser.

Die docp Cl14er Messungen zeigen sich in der Latenz etwas besser als in den Bandbreiten.

Sie liegen bei den hohen Taktraten allerdings nur gleich mit den CL16 18 18 mit manuellen Subtimingsx1,21.

Wie man sieht sind die 21% schlechteren Timings gar nicht so weit entfernt was die Lesebandbreite angeht.

Die docp Timings halten erst ganz gut mit, weil sie mit CL15 15 15 auch gute voraussetzungen haben, aber ab 2666MHz sind sie plötzlich deutlich abgeschlagen was ich mir nicht so richtig erklären kann, da die Timings zwar schlechter werden, hier aber keine besonderen Sprung aufweisen.

Die Timings komplett auf Auto zu lassen führt bei 3200MHz zu insgesamt schlechten Timings und daher auch der schlechtesten 3200MHz Leistung.

Edit: ich habe jetzt auch docp CL14 14 14 34 eingefügt und es unterscheidet sich überhaupt nicht von den 16 15 15 35 aus dem docp CL15.

Obwohl die Haupttimings besser geworden sind und fast alle Subtimings gleich geblieben sind ist das Ergebnis das gleiche.

Im Grunde hat sich nur tWRRD von 1 auf 3 verschlechtert...dieses TImings hat schon in der Vergangenheit große Leistungs und Stabilitätseinflüsse gezeigt...das es die Haupttimings ausgleicht hätte ich nicht gedacht.

Zoomen wir auf den oberen Bereich und blenden noch die Stilt Timings ein:

Die Stilt Timings sind ohne GDM bei 3200 die besten und auch bei 3466 nicht weit entfernt...allerdings nicht stabil.

Ein ähnliches Bild zeigt sich bei der write Bandbreite.

Das Schreiben ist jedoch etwas schlechter zu reproduzieren als das Lesen.

Edit: gleiches Bild wie bei read für die neu eingefügten docp Cl14.

Der GDM macht für die Stilt Timings hier einen großen Unterschied. Da sie nicht stabil sind, ist das jedoch keine große Sache.

Warum die 43% schlechteren Timings bei 3466 wieder aufschließen kann ich mir nicht erklären...eventuell waren die drei Messungen einfach glücklicher.

Die automatischen Timings verlieren besonders in der Copy Bandbreite an Leistung.

Auch lässt sich copy noch schlechter zuverlässig messen.

Edit: und auch für Copy das gleiche Verhalten der docp CL14

Bei 3466 machen sich die Stilt Timings hier nicht so gut.

Hier habe ich noch Messungen der CL14er Timings mit deaktivertem BGS und aktiviertem BGSAlt eingefügt. Wie man sieht ist der Unterschied vernachlässigbar und das galt auch schon für die Bandbreiten.

Wir sehen deutlich größere Einflüsse durch die schlechteren Timings.

docp hält sich jedoch nicht schlecht im Vergleich zu CL16 und die Stilt Timings sind mit 3466MHz überraschend schlecht....jedoch nur wenn der GDM eingeschaltet ist. Eventuell arbeitet hier schon eine Fehlerkorrektur oder die Messung hatte Probleme.

Edit: Die Aida64 Werte für den komischen Stilt 3466 GDM on Wert habe ich wiederholt und konnte sie alle gestätigen. Laut der neuen Messungen waren die Bandbreiten im Bereich der Messungenauigkeit gleich und die Latenz nur 0,133ns besser.

Die docp Cl14er Messungen zeigen sich in der Latenz etwas besser als in den Bandbreiten.

Sie liegen bei den hohen Taktraten allerdings nur gleich mit den CL16 18 18 mit manuellen Subtimingsx1,21.

Die Werte beruhen jeweils auf der zweiten bis sechsten Messung aus den integrierten Benchmark, der einen ganz guten worst case des Spiels präsentiert.

Ich messe ab dem Punkt wo die Kamera an dem großen Schild der Wache vorbei gleitet an für 40s.

Wenn eine Messung aus der Reihe tanzt, verwende ich stattdessen die siebte Messung.

Von den fünf Messungen wertet mein C++ Programm die Frametimemessungen aus und mittelt dann jeweils die drei besten Werte um Ausreißer auszuschließen..... Obwohl ich mir bei den weiteren Ramsettings immer mehr Ramteiler gespart hatte, waren es insgesamt über 500 Messungen.

Im oberen Bereich sieht man die avg FPS und der untere Block an Messungen zeigt den Durchschnitt der schlechtesten 1% der Frametimes.

Wie man sieht hat das verwenden des GBSalt in diesem Spiel keinen wirklichen Nachteil....bei 3466 scheint es zwar einen kleinen Nachteil zu geben. Bei 3200MHz habe ich mal wieder einen Durchhänger, den ich schon öfter in anderen Spielen beobachtet habe.

Der GDM mag diesen Ramteiler scheinbar nicht....wobei sich das nicht perfekt reproduzieren lässt.

Insgesamt kann ich nicht sagen, das die andere BGS hier einen Unterschied macht.

Die 21 und 43% schlechteren Timings haben hier einen deutlichen Leistungsverlust zur Folge.

Die 21% Unterschied in den Timings resultieren im Schnitt bei 5,7% Unterschied in den avg FPS.

Die 43% Unterschied in den Timings resultieren im Schnitt bei 11,8% Unterschied in den avg FPS.

Die docp und all Auto Timings machen sich bei 2133MHz noch ganz gut, lassen zu höheren Taktraten aber immer mehr nach.

Edit: Die neu eingefügten docp Cl14 zeigen sich meist minimal besser als die docp CL15 und CL16 18 18 optx1.21 .....Wie bei den Latenzmessungen schwächeln sie etwas wenn es an die hohen Frequenzen geht.

Hier werden ein paar Subtimings von der Automatik schlechter gewählt....das diese leichten Veränderungen diesen Leistungsverlust erklären sollen finde ich jedoch komisch.... Da das System Probleme hatte mit diesen Einstellungen erfolgreich zu Booten könnte ich mir hier auch ein Eingreifen von Fehlerkorrektur oder ähnlichem denken.

Zoomen wir wieder rein und gucken auch auf die Stilt und Aegis Timings:

Die Aegis Timings sind durchaus ein gutes Stück von den optimierten Timings entfernt(7,3%).

Sie wären noch weiter entfernt, wenn ich die Timings auch auf 3000MHz und nicht auf 3466 optimiert hätte.

Sie sind aber besser als die automatischen und die docp Timings.

Warum die Stilt Timings mit GDM Richtung 3466 schlechter werden ist etwas komisch...aber wir erinnern uns, das auch die Latenz hier ungewöhnlich war. Ansonsten sind die Werte erwartbar gut, wenn auch nicht unbedingt stabil...oder sogar sehr instabil.

Insgesamt bin ich überrascht, wie wenig sich die Timings in den Bandbreiten bemerkbar gemacht haben, und wie deutlich sie hier in diesem Spiel eine Rolle spielen.

Laut dem CB Testparcour hat ein 9900K in 1080p Spielen 26% mehr avg FPS.

Und hier machen optimierte Ramtimings bei 3200MHz verglichen mit docp(CL15) einen Unterschied von 7,8%.

Von 2933 CL16 15 15 auf 3466 CL14 opt. sind es 17,6% mehr avg FPS.

Und es ist davon auszugehen, das der Ram den CB verwendet mit 2933 Cl16 16 16 noch schlechter ausfällt.

Dann würden die CPUs nur noch 8% trennen...ein durchaus gutes Ergebniss, wenn man nur den Ram verändert.

Insgesamt haben sich die avg FPS von 2133 all Auto, auf 3466 Cl14 opt. um 36% verbessert und die 1%low um 16,6%.

Edit: Wie schon in dem vorherigen Diagramm beschrieben, habe ich die docp Cl14 hinzugefügt und ich habe auch die Stilt Messung bei 3466MHz wiederholt.

Die neuen Stilt Messungen zeigen jetzt 1,7 1/s bessere FPS und 0,8 1/s bessere 1%low Frametimes.

Auch schwanken die Messungen ungewöhnlich hoch und runter....es sind immer wieder Messungen dazwischen die die gleichen Ergebnisse wie die erste Messeihe dazu zeigten...und ein paar bessere.

Ich denke in beiden Fällen könnten die Ergebnisse bei diesen Ramfrequenzen durch eine leichte Instabilität beeinträchtigt sein...oder der GeardownMode macht in diesen Fällen was komisches....es ist mir nicht ganz klar.

Ich habe noch einen weiteren Test gemacht, der den Ram auf den 3466 CL14 opt. lässt, und stattdessen den allcore CPU Takt senkt.

Die farblich dunkeren Verläufe, die von 2133 bis 3466 gehen sind dem verändern der effektiven Ramfrequenz zugeordnet und die helleren Verläufe von 2950MHz bis 4200MHz sind der CPU Takt.

Wie man sieht ist die Steigung der Verläufe sehr ähnlich...das Spiel profitiert also in gleicher Weise von mehr Ram MHz wie von mehr CPU MHz.

Die etwas ungewöhnlichen CPU Frequenzen 2950 und 3475 sollten einen vergleich zu den um 21 und 43% unterschiedlichen Timings ziehen....vergleichen wir also CPU/DRAM Takt und Timings miteinander:

Faktor 1,21;

weniger CPU Takt = 12,8% avg FPS

weniger DRam Takt = 10,8% avg FPS

höhere Timings = 5,2% avg FPS

Faktor 1,43;

weniger CPU Takt = 23% avg FPS

weniger DRam Takt = 21,6% avg FPS

höhere Timings = 10,3% avg FPS

Der CPU Takt bringt also schon etwas mehr als der DRam Takt, und die Timings wirken sich nur halb so stark aus.

Fazit:

Viele Messungen und hoffentlich für manche eine jetzt etwas klarere Datenlage.

Was bringen die Timings, was bringt der Takt usw.

Der GDM ist mit mehr als einer rank pro Channel für hohe Taktraten alternativlos.

Eine genauere Untersuchung zu seinem Einfluss würde noch ausstehen.

Die BankGrouSwap Option ist zumindest in diesem Spiel nicht von Bedeutung.

Ich müsste noch testen, wie es da in anderen Spielen aussieht.....hat da schon jemand aktuelle Erfahrungen?

Die Stilt timings waren schnell, aber nicht stabil....helfen dem unbedarften Nutzer als nicht wirklich.

Aber eventuell wären sie stabil wenn ich 2x8GB und nicht 4x8GB nutzen würde.

Der Vergleich mit den Aida64 Werten legt nahe, dass die Spieleperformance vor allem durch die Latenzen gegeben ist und eventuell etwas durch die copy Leistung.

Dieses Spiel profitiert fast so gut von Ramgeschwindigkeit wie es von CPU Takt profitiert. Das ist sicherlich nicht gewöhnlich, aber auch das müsste man mal in anderen Spielen gegenüberstellen.

Mir ging es in diesem Test weniger um das verwendete Spiel an sich....das wird wohl kaum jemand spielen und es lief auch mit dem schlechtesten Ram noch ganz gut.

Mir ging es darum die Auswirkungen von Ram Takt und Ram Timings irgendwie gemeinsam darzustellen...deshalb auch die unübersichtlichen Diagramme mit zu vielen Daten.

Meine Idee war es, das jemand der sich z.B. fragt ob er seinen Ram von 2933 auf 3333 übertakten sollte, wenn er dafür schlechtere Timings in Kauf nehmen muss.

Oder ob sich jemand überhaupt mit besseren Timings beschäftigen sollte.

Dann kann er im Diagramm die am bestem zu seiner Situation passenden Verläufe heraussuchen und eine grobe Abschätzung machen.

Ich hoffe das ist mir halbwegs gelungen.

Wie jemand dies interpretiert ist sicherlich sehr subjektiv.

Der eine sagt sich..."Was sind schon 5%?" und der andere sieht in 5% den Aufpreis zur nächst besseren CPU....und ich denke mir..."Mir macht Ram OC Spaß...ich nehme auch jedes halbe % mit wenn ich kann!"

Was meint ihr zu den Ergebnissen?

Habt ihr Verbesserungsvorschläge oder Einwände...Fragen?

Edit: es sind jetzt Messungen mit docp CL14 14 14 34 eingefügt und die problematischen 3466MHz Messungen mit den Stilt Timings sind wiederholt und bestätigt.

Die Haupttimings sind überraschenderweise kaum besser als die docp CL15 Messungen, oder die CL16 18 18 Messungen mit opt.x1.21er Timings.

Und zu höheren Frequenzen sacken die FPS sogar wieder ab oder stagnieren..... eventuell eine Eigenheit des GDM oder von Fehlerkorrektur aufgrund von Instabilitäten.

Wobei die Timings eigentlich alle schlechter sind als meine stabilen manuellen Timings und nur tWTRS bei mir eigentlich auf 6 ausgelotet war und von der Automatik auf 5 gesetzt wird.....ob dieses eine instabile Timings solche Auswirkungen hat ist komisch....

Edit2: Ich habe nochmal meine optimierten Timings mit tWTRS auf 5 getestet...Die Messungen haben deutlich mehr geschwankt als mit tWTRS auf 6 und auch das Booten hatte lange gebraucht...und Thief wollte sich erst nicht schließen lassen...ich würde sagen es könnte wirklich an diesem Timing liegen, das die CL14 dopc Timings hier so komisch sind.

Anhänge

Zuletzt bearbeitet: