Mr.Seymour Buds schrieb:

Schon komisch, dass hier kaum wer meckert, dass der Speichercontroller verkleinert wurde. Bei Nvidia Maxwell gabs nen riesen Aufschrei.

Sry, nimm das nicht persönlich, aber du bist echt ein Beispiel, wieso ein Hobby schnell zur Zeitverschwendung wird.

Vorhin hast du begonnen über die Rohleistung zu reden und hast hier falsche Eindrücke wieder gegeben. Eben, dass Rohleistung gleich Performance der Karte ist (für Instruction per Clock bei Shader immer 2 genommen wird und somit die theoretische Performance berechnet), dabei wurde das schon auf den ersten Seiten "besprochen".

Und jetzt fangst du mit dem Speicher-Interface an, dass schon seit Wochen im Munde ist. Wieso glaubst du hat die Karte nur 2 oder 4 GB ? Klar hängt das mit dem Speicher-Interface zusammen.

Übrigens, ich liebe ja Verallgemeinerungen (nein tu ich nicht), du beweist, dass du das gut drauf hast. Schon mal gemerkt, dass nicht die Kürzung des Speicher-Interface der NV Karten selbst bemängelt worden ist, sondern dass viele angemerkt hatten, dass man die 750TI dann eventuell schlechter OC kann ? (hat soviel ich weiß ja nur ein 128bit Speicher-Interface)

Jetzt ist man klüger und sieht, trotz kleinerer Speicherbandbreite und weniger Shader, kann die 750 TI schneller sein als der Vorgänger.

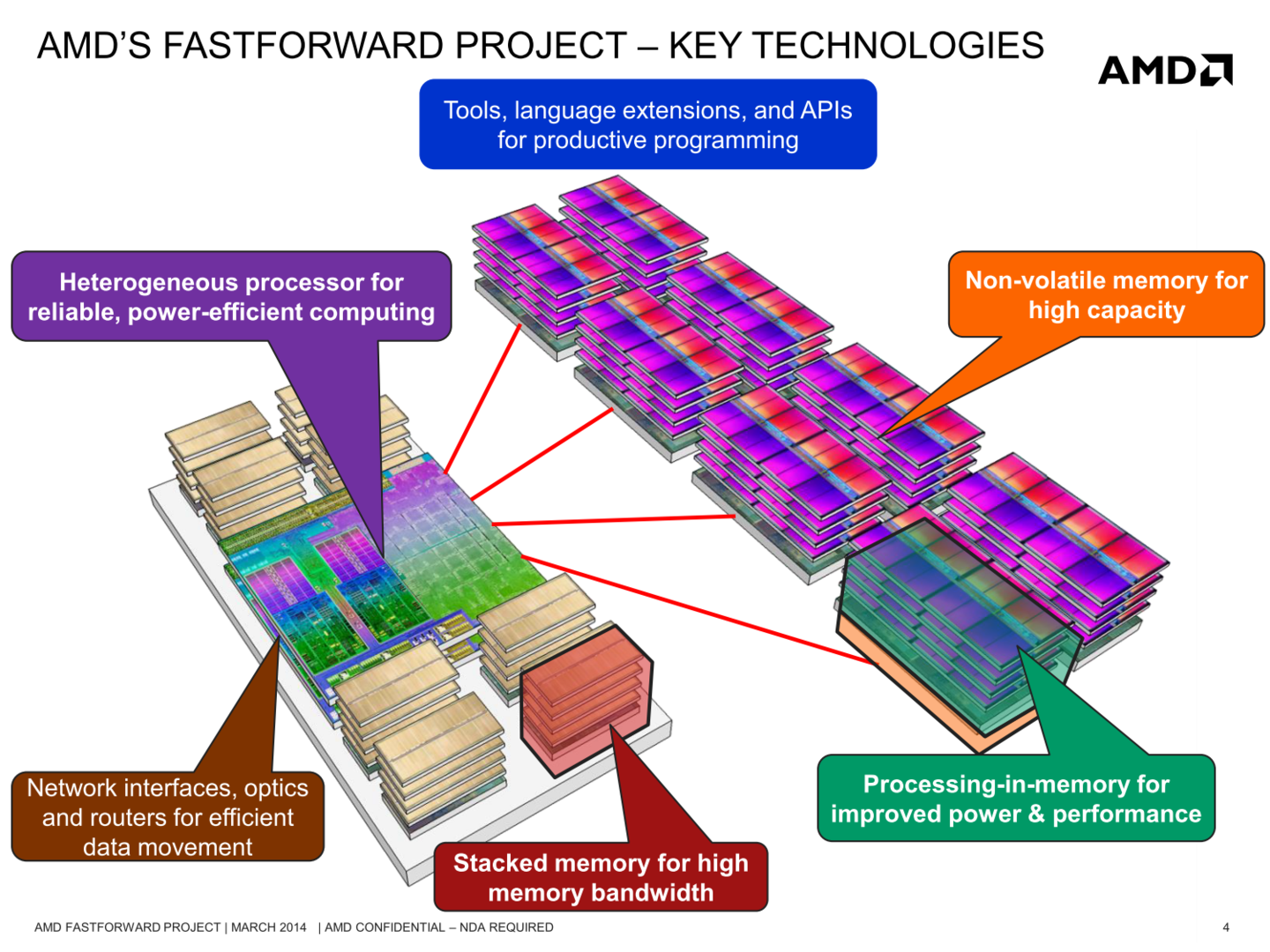

(Das liegt ja daran, dass der L2 Cache ziemlich groß ist und das darf bei der nächsten Grafikkarten Architektur von NV und AMD sehr interessant werden wenn Techniken wie HBM dazu kommen.

Hier mal ein interessanter Link :

https://www.computerbase.de/news/prozessoren/amd-mit-stacked-memory-und-pim-bei-zukunfts-apus.45765/

Ups, da habe ich mich doch etwas geirrt. Viele User sind nicht klüger geworden, denn selbe falschen voreiligen Schlüsse, die man bei der 750TI gemacht hatte, wollen scheinbar hier viele bei dieser GPU wiederholen.

Vllt einfach mal Ball flach halten und abwarten. Eventuell wird Tonga kein großer Wurf, aber schlechter als sein Vorgänger muss diese Karte deshalb nicht gleich werden und wenn dann wird sie früher oder später billiger werden als sein Vorgänger.

Es fehlen aber schlicht und einfach noch Puzzel-Teile, nämlich unter anderen ob das GCN 1.1 ist oder vllt schon 1.2 oder ähnliches. Wäre ja nichts neues, dass AMD mit kleineren GPUs, bessere Fertigung oder hier "Architektur" testet und dann später mit größeren GPUs nach zieht.

Die Kürzung des Speicher-Interface zeigt sich in erster Linie daran, wieviel Grafikspeicher man auf die Platine löten kann und deshalb eine Karte mit 2GB weniger anbietet als der Vorgänger mit 3Gb. Dafür wird es aber offensichtlich eine 4GB Version ebenso geben.

Somit den großen Aufschrei, denn damals bei GM 107 war, wo ist dieser hier nicht vorhanden ?

Aber eventuell ließt du hier im Thread gar nicht mit, aber wieso stellst du dann solche Fragen ?