Eigentlich wollte ich diesen Artikel längst geschrieben haben, aber private Umstände ließen es leider nicht zu. Weitere Projekte mit Igor´s Lab, Prad und Gamestar musste ich auch aufschieben. Vielleicht tröstet es etwas zu wissen, dass ComputerBase nicht als einzige Anlaufstelle zu kurz kam.

Und natürlich ergibt so ein Beitrag am meisten zu Lebzeiten einer Hardware Generation Sinn. Nun sind bei AMD und Nvidia leider schon die neuen 4000er und 7000er Serien auf dem Markt und die 6000er Serie ca. 2 Jahre alt. Doch sind die neusten Karten nicht nur teuer und haben jeweils so ihre Kinderkrankheiten oder sind vergriffen, die 6000er Serie von AMD bietet nach wie vor viel Leistung für´s Geld und ist eigentlich auch erst jetzt zu vernünftigen Preisen verfügbar, so dass das Thema sicher noch relevant ist. Sofern man seine 6000er Karte optimal einstellt läuft die auch sehr effizient, was ebenfalls so wichtig wie nie zu vor ist. Im Fall einer 6900XT bekommt man auch so viel Leistung, dass man praktisch auf nichts verzichten muss und zukunftssicher ist.

Um diese Karten soll es in diesem Artikel gehen, wobei sich hier prinzipell die Geschichte der Artikel zur 6700XT und 6600XT wiederholt.

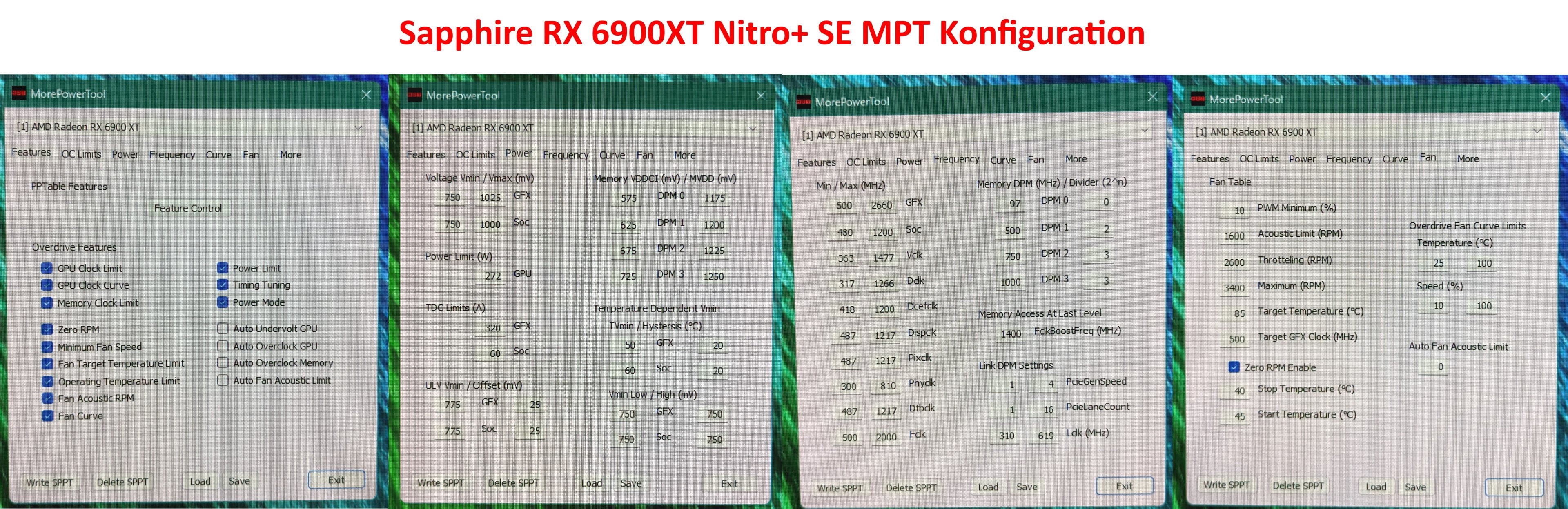

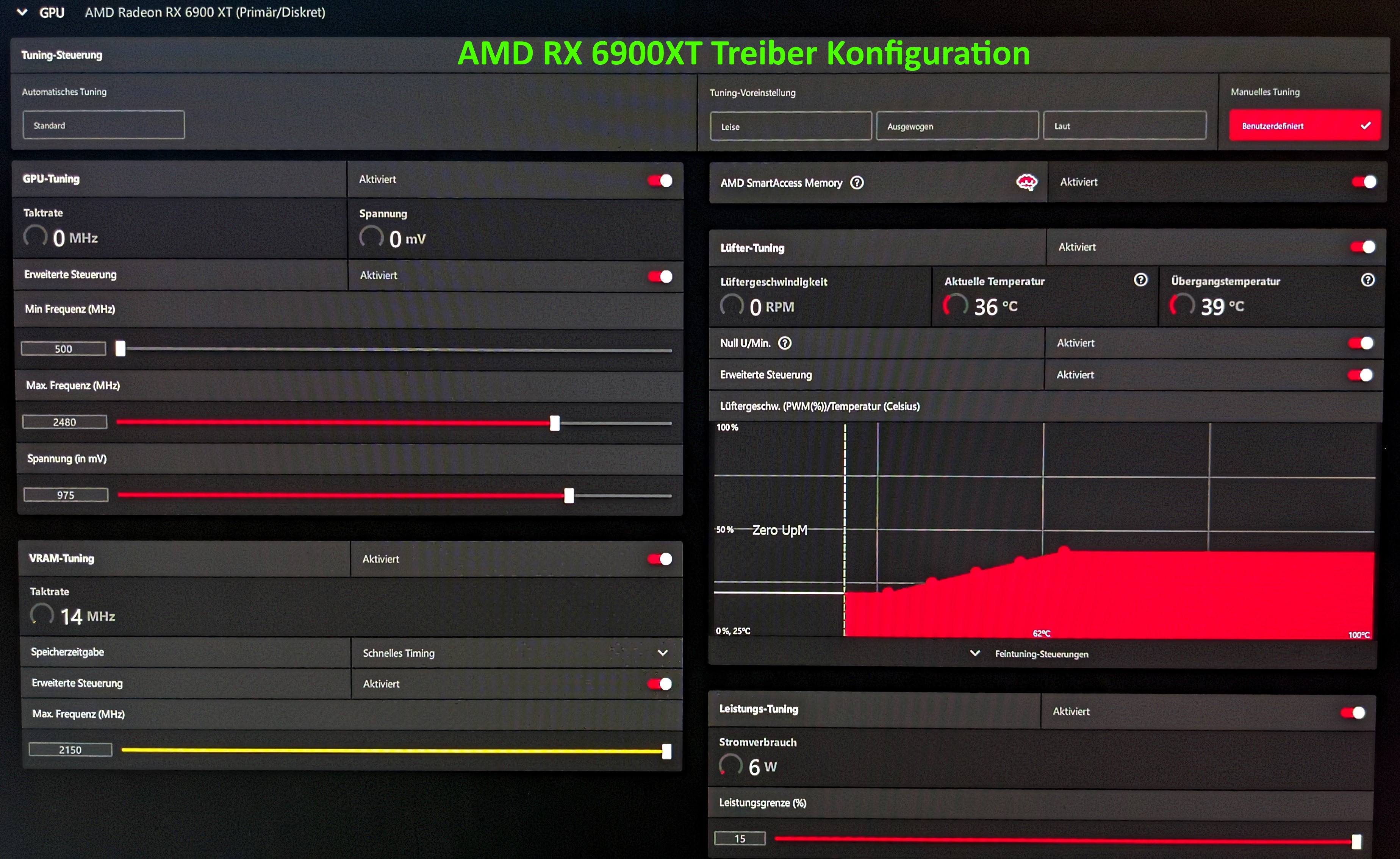

Wie damals beschrieben arbeite ich mit dem MPT, dem RadeonSoftwareSlimmer und der Leistungskonfiguration des AMD Adrenalin Treibers.

Im MPT lege ich die Minimal- und Maximalspannung der jeweiligen Komponente auf der Grafikkarte fest. Mit dem Treiber stelle ich dann die Taktraten und das Spannungs-Offset, sowie die Lüfterkurve ein. Der RadeonSoftwareSlimmer hilft mir das Ryzen Master SDK und Automatisierungen des Treibers garantiert zu unterbinden.

Während die 6700XT relativ üppig dimensionierten Speicher und Cache hat und mehr vom Speicher-OC als dem OC des Infinity-Caches profitiert, verhält sich die 6900XT ähnlich wie die 6600XT, die von größerem und schnellerem Cache deutlicher profitiert. Insofern habe ich die 6900XT´s die ich bisher einstellen konnte auf einen FCLK-Takt von 2000MHz gebracht und den Speicher auf die jeweils erlaubten 2150MHz gestellt. Die dadurch gesteigerte Bandbreite versorgt den großen Chip besser mit Daten, weshalb bei gleichem Kerntakt in vielen Fällen die Rechenleistung steigt und vorallem die Minimum-FPS besser werden und damit auch der Frameverlauf homogener.

Hauptsächlich holt auch AMD aus dieser Erkenntnis die Mehrleistung einer 6950XT im Gegensatz zu einer 6900XT, die es teilweise auch mit dem hochwertigen Binning in Form des XTXH Chips gibt. Ursprünglich hätte man neben dem Cache auch gerne HBM2 Speicher verbaut, doch aus Kostengründen hatte man das verworfen.

In Benchmarks und Spielen mit RayTracing limitieren öfter die eigentliche Architektur und der Kerntakt, weswegen die Leistungsvorteile des Speicher- und Cache-OC hier nicht ganz so stark durchschlagen. Bemerkenswert bleibt in diesen Fällen aber immer noch der gesunkene Stromverbrauch.

In Summe sorgen die Optimierungen dafür, dass wenn die Karte mit Standarteinstellungen ins PowerLimit laufen würde, sie ihren Takt voll halten kann und so konstant Leistung abgibt, nicht schwankt und dann auch mehr Punkte holt. Noch mehr Leistung wäre dann über echtes Übertakten des Kerns möglich, aber Effizienz ist mir wichtig und das was dann noch an Leistung zu holen ist, steht in keinem Verhältnis zum dafür nötigen Stromverbrauch. Der brächte dann auch wieder höhere Temperaturen und lautere Lüftergeräusche mit sich. 2,4GHz sehe ich also auch bei den großen Karten wie bei der 6700XT als den Sweetspot an.

Diese Angabe beziehe ich auf die konstant erreichte minimale Taktgeschwindigkeit unter voller Auslastung. Boost-Taktraten liegen in der Regel höher. Als Realtakt habt ihr in solchen Situationen übrigens ca. 80MHz weniger Takt als vom Treiber angepeilt. 2480MHz ergeben also einen Realtakt unter Last von etwas über 2400MHz. Man könnte die 2480 respektive 80MHz also als Boost-Spielraum für weniger Last oder als Offset beschreiben.

Sollte die Rechenleistung bei diesem Takt nicht ausreichen, werden auch 2,5 oder 2,6 GHz keinen so großen Unterschied machen, als dass man um den Austausch der Karte herrum käme. Vernünftig, sofern man das sein möchte, ist es also an Speicher und Cache zu gehen, alles zu undervolten und die Taktrate des Kern zu stabilisieren, anstatt sie selbst noch weiter zu erhöhen.

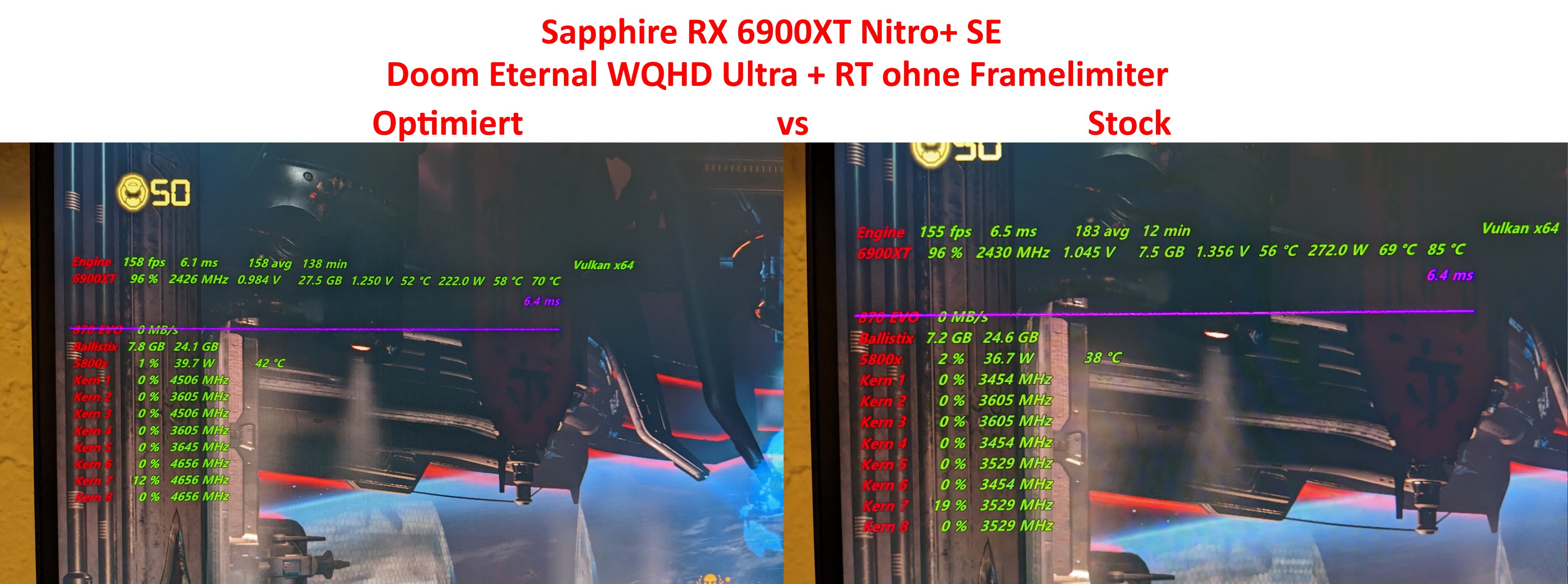

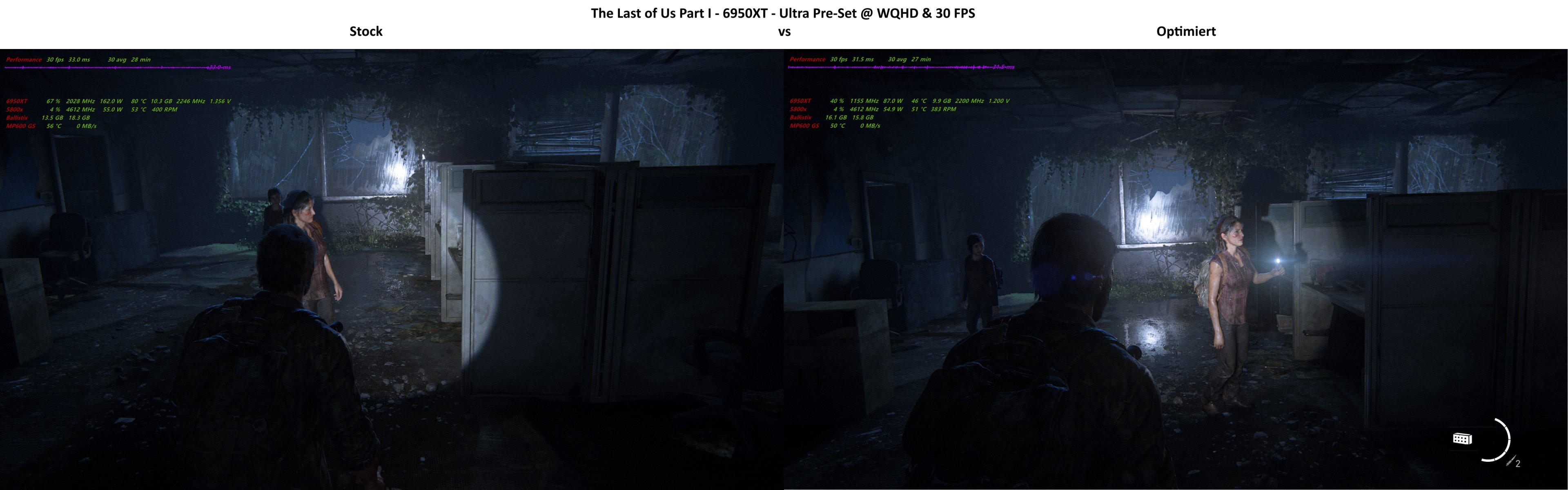

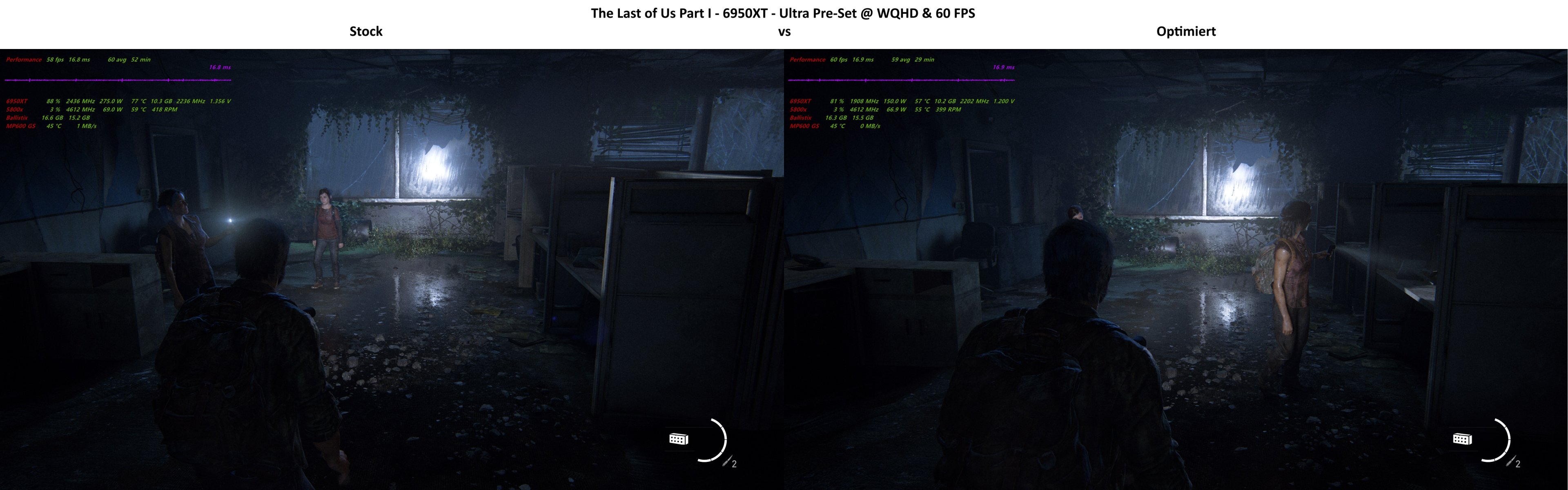

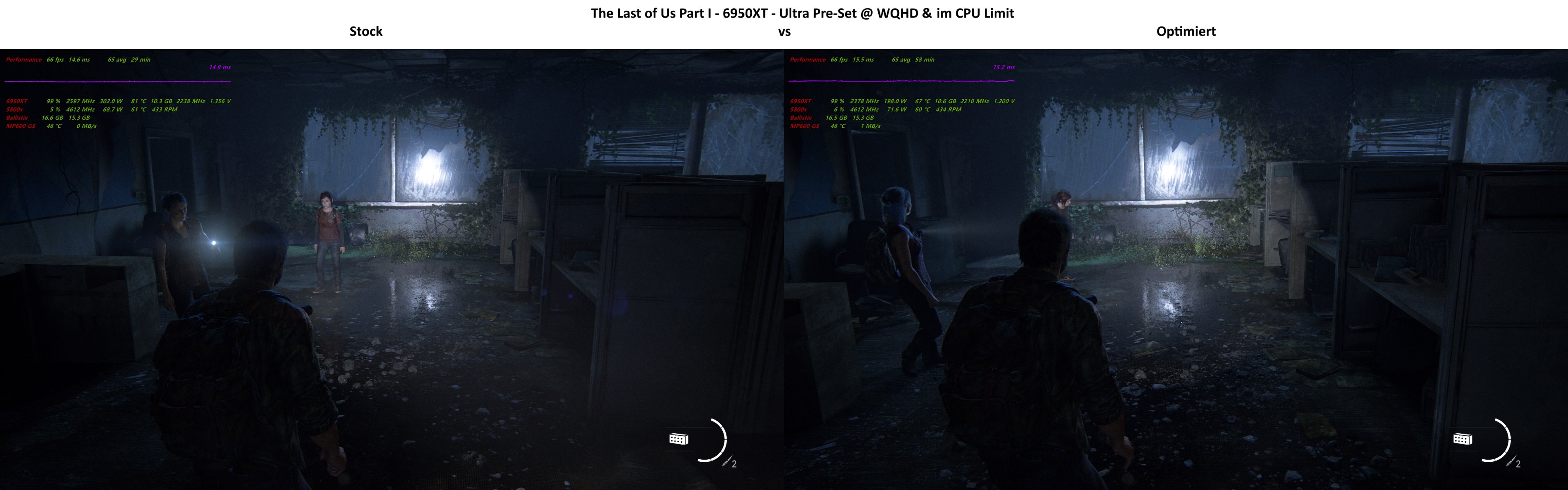

Die folgenden Fotos belegen z.B. schon eine Ersparnis von ca. 50 Watt unter voller Auslastung bei höher Leistung und im Durchschnitt, bei besseren Frametimes ca. 30 Watt Ersparnis. Vorallem senkt das UV auch die Stromspitzen, die über Fotos schwer darstellbar sind. Das hat teilweise drastische Folgen für die Temperaturen und die Lüfterkurve, die nun flacher verlaufen kann und die Karte unauffällig macht. Vorallem das Delta zwischen Gesamttemperatur des Kerns und HotSpot-Temperatur verbessert sich.

Im CyberPunk 2077 Vergleich zwischen Stock und Optimiert seht ihr mit jeweils 87 vs 70°C auf dem HotSpot eine Differenz von 17 Grad. Die Kerntemperatur differiert dabei um 12 Grad zwischen 69 und 57°C. Und das bei weniger Lüfterdrehzahl.

Eine Legende, zum Verständnis für die Messwerte von FPS-Monitor, findet ihr im Anhang des Artikels.

Beachtet bitte auch, dass die Grafikeinstellungen der Spiele nur für die Vergleichbarkeit gewählt wurden.

Tatsächlich spiele ich immer mit einem Mix aus Einstellungen, je nach optischem Vorteil und damit einhergehenden Kosten.

Hier ging es nicht darum, die maximale Leistung der GPU zu demonstrieren, oder RT und Ultra Einstellungen als immer sinnvoll darzustellen

Dies sind die Einstellungen die ich für die 6900XT verwendet habe. Leser können sie gerne als Orientierung verwenden, 1 zu 1 übertragen lassen sich die Einstellungen in der Regel nicht, da jeder Karte und sogar die einzelnen Chips darauf sich individuell voneinander in ihrer Güte unterscheiden. Einen guten Hinweis wie ihr noch mehr Energie sparen könnt findet ihr auch hier: https://www.computerbase.de/forum/t...fizienz-getrimmt.2123443/page-8#post-27884580

Generell empfehle ich den GANZEN Thread chronologisch zu lesen. Viele Fragen erübrigen sich dann und ihr könnt noch weiter ins Thema einsteigen

Nachtrag: Da mir in The Last of Us Part I die Differenzen zwischen der Standartkonfiguration und meiner Optimierung besonders dramatisch aufgefallen sind, hier noch ein weiterer Vergleich, den ich relativ aufwendig gemacht habe Spielversion war die 1.0.4.1 und genutzt wurde der 23.4.3 Treiber.

Spielversion war die 1.0.4.1 und genutzt wurde der 23.4.3 Treiber.

Einen ähnlichen Test habe ich mit Cyberpunk 2.0 und der 6950XT gemacht, auch dort sind die Unterschiede im Verbrauch ganz deutlich: https://www.computerbase.de/forum/t...er-als-ihr-denkt.2129358/page-4#post-28642262

Und natürlich ergibt so ein Beitrag am meisten zu Lebzeiten einer Hardware Generation Sinn. Nun sind bei AMD und Nvidia leider schon die neuen 4000er und 7000er Serien auf dem Markt und die 6000er Serie ca. 2 Jahre alt. Doch sind die neusten Karten nicht nur teuer und haben jeweils so ihre Kinderkrankheiten oder sind vergriffen, die 6000er Serie von AMD bietet nach wie vor viel Leistung für´s Geld und ist eigentlich auch erst jetzt zu vernünftigen Preisen verfügbar, so dass das Thema sicher noch relevant ist. Sofern man seine 6000er Karte optimal einstellt läuft die auch sehr effizient, was ebenfalls so wichtig wie nie zu vor ist. Im Fall einer 6900XT bekommt man auch so viel Leistung, dass man praktisch auf nichts verzichten muss und zukunftssicher ist.

Um diese Karten soll es in diesem Artikel gehen, wobei sich hier prinzipell die Geschichte der Artikel zur 6700XT und 6600XT wiederholt.

Wie damals beschrieben arbeite ich mit dem MPT, dem RadeonSoftwareSlimmer und der Leistungskonfiguration des AMD Adrenalin Treibers.

Im MPT lege ich die Minimal- und Maximalspannung der jeweiligen Komponente auf der Grafikkarte fest. Mit dem Treiber stelle ich dann die Taktraten und das Spannungs-Offset, sowie die Lüfterkurve ein. Der RadeonSoftwareSlimmer hilft mir das Ryzen Master SDK und Automatisierungen des Treibers garantiert zu unterbinden.

Während die 6700XT relativ üppig dimensionierten Speicher und Cache hat und mehr vom Speicher-OC als dem OC des Infinity-Caches profitiert, verhält sich die 6900XT ähnlich wie die 6600XT, die von größerem und schnellerem Cache deutlicher profitiert. Insofern habe ich die 6900XT´s die ich bisher einstellen konnte auf einen FCLK-Takt von 2000MHz gebracht und den Speicher auf die jeweils erlaubten 2150MHz gestellt. Die dadurch gesteigerte Bandbreite versorgt den großen Chip besser mit Daten, weshalb bei gleichem Kerntakt in vielen Fällen die Rechenleistung steigt und vorallem die Minimum-FPS besser werden und damit auch der Frameverlauf homogener.

Hauptsächlich holt auch AMD aus dieser Erkenntnis die Mehrleistung einer 6950XT im Gegensatz zu einer 6900XT, die es teilweise auch mit dem hochwertigen Binning in Form des XTXH Chips gibt. Ursprünglich hätte man neben dem Cache auch gerne HBM2 Speicher verbaut, doch aus Kostengründen hatte man das verworfen.

In Benchmarks und Spielen mit RayTracing limitieren öfter die eigentliche Architektur und der Kerntakt, weswegen die Leistungsvorteile des Speicher- und Cache-OC hier nicht ganz so stark durchschlagen. Bemerkenswert bleibt in diesen Fällen aber immer noch der gesunkene Stromverbrauch.

In Summe sorgen die Optimierungen dafür, dass wenn die Karte mit Standarteinstellungen ins PowerLimit laufen würde, sie ihren Takt voll halten kann und so konstant Leistung abgibt, nicht schwankt und dann auch mehr Punkte holt. Noch mehr Leistung wäre dann über echtes Übertakten des Kerns möglich, aber Effizienz ist mir wichtig und das was dann noch an Leistung zu holen ist, steht in keinem Verhältnis zum dafür nötigen Stromverbrauch. Der brächte dann auch wieder höhere Temperaturen und lautere Lüftergeräusche mit sich. 2,4GHz sehe ich also auch bei den großen Karten wie bei der 6700XT als den Sweetspot an.

Diese Angabe beziehe ich auf die konstant erreichte minimale Taktgeschwindigkeit unter voller Auslastung. Boost-Taktraten liegen in der Regel höher. Als Realtakt habt ihr in solchen Situationen übrigens ca. 80MHz weniger Takt als vom Treiber angepeilt. 2480MHz ergeben also einen Realtakt unter Last von etwas über 2400MHz. Man könnte die 2480 respektive 80MHz also als Boost-Spielraum für weniger Last oder als Offset beschreiben.

Sollte die Rechenleistung bei diesem Takt nicht ausreichen, werden auch 2,5 oder 2,6 GHz keinen so großen Unterschied machen, als dass man um den Austausch der Karte herrum käme. Vernünftig, sofern man das sein möchte, ist es also an Speicher und Cache zu gehen, alles zu undervolten und die Taktrate des Kern zu stabilisieren, anstatt sie selbst noch weiter zu erhöhen.

Die folgenden Fotos belegen z.B. schon eine Ersparnis von ca. 50 Watt unter voller Auslastung bei höher Leistung und im Durchschnitt, bei besseren Frametimes ca. 30 Watt Ersparnis. Vorallem senkt das UV auch die Stromspitzen, die über Fotos schwer darstellbar sind. Das hat teilweise drastische Folgen für die Temperaturen und die Lüfterkurve, die nun flacher verlaufen kann und die Karte unauffällig macht. Vorallem das Delta zwischen Gesamttemperatur des Kerns und HotSpot-Temperatur verbessert sich.

Im CyberPunk 2077 Vergleich zwischen Stock und Optimiert seht ihr mit jeweils 87 vs 70°C auf dem HotSpot eine Differenz von 17 Grad. Die Kerntemperatur differiert dabei um 12 Grad zwischen 69 und 57°C. Und das bei weniger Lüfterdrehzahl.

Eine Legende, zum Verständnis für die Messwerte von FPS-Monitor, findet ihr im Anhang des Artikels.

Beachtet bitte auch, dass die Grafikeinstellungen der Spiele nur für die Vergleichbarkeit gewählt wurden.

Tatsächlich spiele ich immer mit einem Mix aus Einstellungen, je nach optischem Vorteil und damit einhergehenden Kosten.

Hier ging es nicht darum, die maximale Leistung der GPU zu demonstrieren, oder RT und Ultra Einstellungen als immer sinnvoll darzustellen

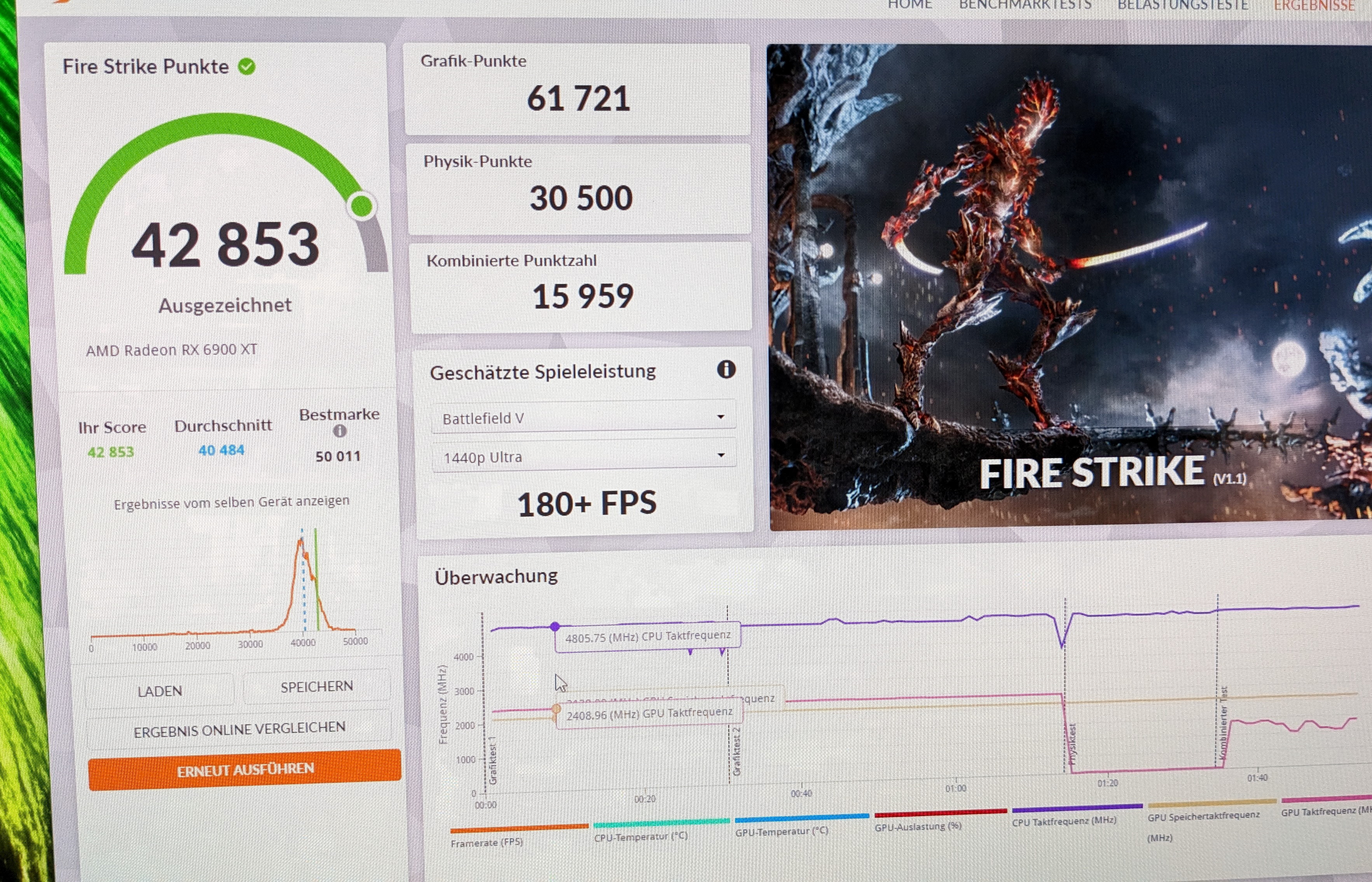

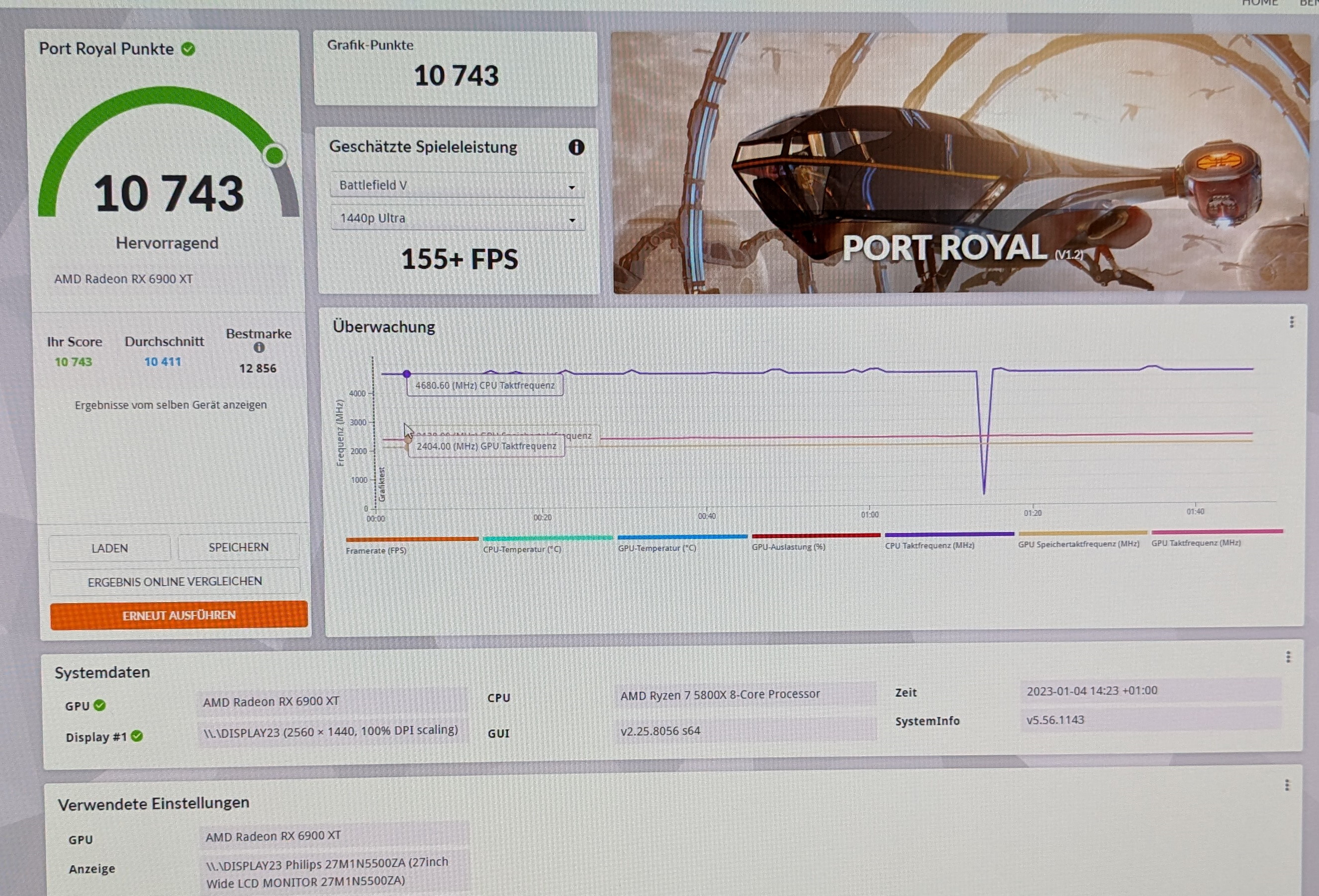

In den 3D-Mark Läufen erkennt man gut, wie konstant der Takt verläuft. Das Leistungsergebnis, obwohl nicht auf die Höchstepunktzahl abgezielt, kann sich auch sehen lassen.Dies sind die Einstellungen die ich für die 6900XT verwendet habe. Leser können sie gerne als Orientierung verwenden, 1 zu 1 übertragen lassen sich die Einstellungen in der Regel nicht, da jeder Karte und sogar die einzelnen Chips darauf sich individuell voneinander in ihrer Güte unterscheiden. Einen guten Hinweis wie ihr noch mehr Energie sparen könnt findet ihr auch hier: https://www.computerbase.de/forum/t...fizienz-getrimmt.2123443/page-8#post-27884580

Generell empfehle ich den GANZEN Thread chronologisch zu lesen. Viele Fragen erübrigen sich dann und ihr könnt noch weiter ins Thema einsteigen

Nachtrag: Da mir in The Last of Us Part I die Differenzen zwischen der Standartkonfiguration und meiner Optimierung besonders dramatisch aufgefallen sind, hier noch ein weiterer Vergleich, den ich relativ aufwendig gemacht habe

Einen ähnlichen Test habe ich mit Cyberpunk 2.0 und der 6950XT gemacht, auch dort sind die Unterschiede im Verbrauch ganz deutlich: https://www.computerbase.de/forum/t...er-als-ihr-denkt.2129358/page-4#post-28642262

Anhänge

Zuletzt bearbeitet: