- Registriert

- Jan. 2011

- Beiträge

- 2.628

grenn schrieb:... zudem scheinen bei Bioshock die AMD Karten sowieso besser abzuschneiden als die von Nvidia

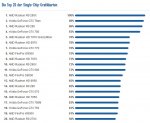

ht4u hatte gestern durch ein Missverständnis alle AMD eigenen Ergebnisse online und nicht nur die von Bioshock, wie jetzt. Dort lag der Mittelwert über alle enthaltenen Spiele bei >20 Prozent. Damit dürfte Bioshock mit +17% nicht wirklich AMD freundlicher sein.