Mir erzählst du da nichts Neues, aber für andere mag es ja interessant sein

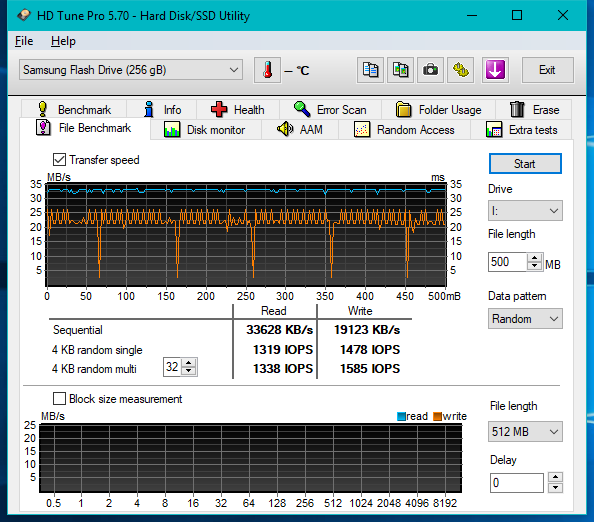

Faule Frage: Mit welchen Tools benchen Leute SSDs zu Tode? Ich wüsste gerne, ab welcher Datenmenge bzw. Blockgröße der gute Samsung sich selbst den Knüppel zwischen die Beine wirft. Sequentiell kommt er jedenfalls klar, von den periodischen Einbrüchen mal abgesehen.

Der Screen entstand nach grob 15% Random-Fill mit HD Sentinel, und zwar lückenlos. D.h. HDS schreibt (exklusiv, und mit Ausnahme der ersten und letzten Sektoren, sonst Dateisystem hinüber), AS-SSD lief davor schon mit korrektem Laufwerk, HDS stoppen, Null-Aktivität im Performancemonitor abwarten bzw. Laufwerk im Explorer abpassen, AS anwerfen. Binnen 30 Sekunden zieht sonst der Controller irgendwelche GC-Mechanismen durch und die Leistung steigt wieder - nicht viel, aber man erhält zumindest wieder

4K-Werte im sequentiellen Schreibbenchmark.

Momentan versuche ich die Dokumentation des Verhaltens über Stunden hinweg, denn der Stick hat sich über Nacht von ähnlicher Performance auf Werksniveau (Leserate 240 MB/s, Schreibraten wie oben) erholt. Er hing an nem USB-Port, der über 5VSB gespeist Strom erhält. Wenn das Teil halt anständig Strom ziehen würde und man erkennen könnte, ob der grade heimlich vor sich hin rattert oder nicht...

Momentan würde ich vermuten, dass hier analog zu SSDs ne Art SLC-Cache verwendet wird, und sobald man dessen kritische Größe überschreitet, bricht alles in sich zusammen und der Stick schreibt ganze Blöcke neu, weil er nicht mehr weiß, wohin er es noch cachen soll. So enorm schnell wie das dann geht ist da ganz sicher hochwertigster NAND dahinter

Während dieser Schneckenphase ist der Verbrauch übrigens deutlich niedriger als bei typischem schnellen Schreiben, ganz knapp über Idle. Es ist also nicht so, dass hier alle Komponenten im Hintergrund auf volle Kanne laufen. Nun müsste man wissen, ob der Controller deutlich mehr Saft zieht als der NAND, oder umgekehrt. Einer von beiden ist der Flaschenhals, und ich tippe hier auf den NAND (während der sonst verbrauchsstarke Controller sich langweilt und schläft)