cunhell schrieb:

@.Sentinel.

1.)Das Feature läuft auf der CPU auf einem Kern und ist extrem lahm.

https://www.tomshardware.com/reviews/nvidia-physx-hack-amd-radeon,2764-5.html

Contrary to some headlines, the Nvidia PhysX SDK actually offers multi-core support for CPUs. When used correctly, it even comes dangerously close to the performance of a single-card, GPU-based solution

cunhell schrieb:

2.)Ich kann die PhysX-Karte sowohl mit AMD, Nvidia und Intel nutzen und nicht nur mit Nvidiahardware

Ja- Zwangsweise, weil der PhysX Beschleuniger auf die Grafikkarten eines Drittherstellers angewiesen waren.

cunhell schrieb:

3.)Die Tessellation-Werte waren absolut übertrieben und konnten nicht im Menü eingestellt werden.

...weil sowohl der Hersteller der Software als auch AMD schlichtweg vergessen haben, einen entsprechenden Regler einzubauen.

Das wurde ja dann relativ schnell nachgeholt. Das ist aber keine Nachlässigkeit seitens Nvidia, da dies z.B. in der Hairworks SDK sauber dokumentiert war. Da hat beispielsweise beim Witcher schön CDPR und AMD versagt und dann wurde versucht, sich gegenseitig den schwarzen Peter unterzuschieben.

Jämmerlich.

Dass für die Markenfetischisten das ganze dann natürlich auch ein gefundenes Fressen war, war abzusehen.

Dass aber nach all den Jahren, wo schon längst bekannt war, wer hier Mist gebaut hat, immernoch versucht wird Nvidia einen Strick zu drehen, zeigt wieder, dass Urban Myths sich äußerst hartnäckig halten.

Gibt ja auch immernoch diejenigen, die meinen, dass bei Crysis 2 damals irrsinnige Tesselationsfaktoren benutzt wurden und selbst das unsichtbare Wasser unterhalb der Oberfläche tesseliert worden wäre.

Wurde zwar alles schon längst richtiggestellt, aber es bleibt halt doch bei der überwiegenden Mehrheit nur der erste Aufschrei und die Empörung im Gedächtnis.

cunhell schrieb:

4.) Kaufte ich mir einen Gsync-Monitor weil ich gerade eine Nvidia-Karte habe konnte man bei einem Grafikkartenwechsel das Feature nicht nutzen und was noch erheblicher ist, auch Freesync nicht nutzen.

So etwas nennt man Wettbewerb und Segmentierung. Deswegen gibt es solche Firmen wie AMD und NVIDIA.

Gewinn erwirtschaften, Innovationen anbieten, Alleinstellungsmerkmale herausarbeiten.

Das MUSS so sein und ist keinem Unternehmen vorzuwerfen, esseidenn man lebt in einem Paralleluniversum.

Die Firmen brauchen die Kundschaft, aber eben die Kundschaft auch die Firmen, die eine entsprechende Nachfrage bedienen. Das Spiel ist keine Einbahnstraße.

cunhell schrieb:

5.) Klar können sie mit ihrem Zeug machen was sie wollen. Allerdings widerspricht das nicht meiner Aussage, dass Nvidia properitäres Zeug produziert.

Natürlich ist das alles proprietät. Genauso wie die Hardware von AMD, deren Treiber und was weiss ich noch.

Deswegen existieren unterschiedliche Firmen erst überhaupt.

cunhell schrieb:

Sie erzeugen eine künstlich eine technische Markenbindung die nicht nötig wäre. Das es eben nicht nötig wäre zeigten die Notebooks.

Natürlich ist sie nötig. Und zwar um die Wirtschaftlichkeit der Unternehmung zu stützen. Du musst ja irgendwie Deine Mitarbeiter bezahlen. Und wenn diese entwas tolles entwickelt haben, willst Du, dass diese im speziellen davon profitieren und nicht die Konkurrenz.

cunhell schrieb:

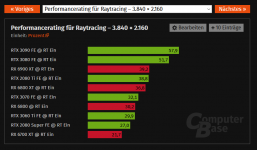

6.) z.B World of Warcraft Shadowlands konnte von anfang an DXR auf AMD. Weitere Spiele suche ich jetzt nich noch raus, da alleine schon WoW SL zeigt, dass DXR schon von Anfang an (Nov 2020) mit AMD RT kann.

Das es erst jetzt mit AMD RT gibt wil sie es nicht gebacken bekommen haben, ist damit widerlegt.

Ist es nicht, da mehrere unabhängige Tests gezeigt haben, dass AMDs Treiber eben fehlerhaft waren und nicht so weit, DXR in vollem Umfang zu unterstützen (siehe Watchdogs).

cunhell schrieb:

7.) Und schön das Du immer brav Nvidias hang zu DX11 verteidigst. Nvidia hat so lange DX11 mit ihrer Marktmacht gepuscht, bis sie selbst DX12 für DXR, ach nein, für Dich heisst es vermutlich RTX, brauchten.

Da muss man nichts verteidigen. Das ist der normale Verlauf einer Entwicklung. API kommt auf den Markt. Je nach Notwendigkeit wird diese adaptiert oder nicht.

Es liegt doch an jedem Hersteller selbst, wie er seine Produkte auf einen entsprechenden Bedarf hin optimiert.

Wie man da auch noch etwas schlechtes hineininterpretieren will, dass NVIDIA seine DX11 Leistung optimiert hat, ist mir wirklich ein Rätsel.

cunhell schrieb:

So und nun hab ich keinen Bock mehr. Für Dich ist Nvidia der heilige Gral

Das hast nicht Du zu entscheiden, was NVIDIA für mich ist.

Für mich ist NVIDIA, wie AMD auch ein Konzern mit Gewinnabsichten. Das ist in meinen Augen Legitim.

Beide Firmen versuchen durch unterschiedliche Methoden ihre Kundschaft an sich zu binden.

Keiner der beiden Firmen hat etwas zu verschenken.

Für mich zählt nur Technik und Innovation und da hat derzeit NVIDIA die Nase mit ihren Produkten vorn.

Ist ja nicht so, als dass AMD nicht auch schon tolle Konzepte parat hatte, die der Konkurrenz voraus waren.

Leider wurden die guten Ansätze auch manchmal durch schlechten Software- Support zunichte gemacht (z.B. primitive shaders).

cunhell schrieb:

der mit seinem Schein alles kritische überstrahlt. So soll es sein.

Nein- Nur ist es im Gegenteil so, dass Du aus Deiner Sicht z.B. alle positiven Errungenschaften, die NVIDIA mit seiner RTX Plattform erreicht hat, in ein negatives Licht rücken willst bzw. den Wert/Impact/Nutzen der Innovation kleinreden. Da trifft dann der Spruch:"Wer im Glashaus sitzt..."

cunhell schrieb:

Wenn Du Dir Nvidias Firmenphilosophie so verinnerlicht hast, macht es eh keinen Sinn weiter zu schreiben.

Was ist denn Nvidias Firmenphilosophie?

Ich bewerte immer nur Produkte und deren Technik.

Mich hat die Firma, die dahintersteht noch nie sonderlich interessiert, denn wenn man tiefer schürft dürfte man moralisch gesehen bei keiner mehr einkaufen. Aber da greift oft der klassische Selbstbetrug bzw. der Rechtfertigungsversuch ganz nach dem Motto "meine Lieblingsfirma ist zumindest weniger schlecht als Deine".