-

Mitspieler gesucht? Du willst dich locker mit der Community austauschen? Schau gerne auf unserem ComputerBase Discord vorbei!

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Deathloop im Test: VRAM ist nur durch mehr VRAM zu ersetzen

- Ersteller Wolfgang

- Erstellt am

- Zum Test: Deathloop im Test: VRAM ist nur durch mehr VRAM zu ersetzen

Markenprodukt

Lt. Junior Grade

- Registriert

- Mai 2013

- Beiträge

- 467

Schlecht optimiert. Wiedermal.

Nehmen wir iOS und Android als Vergleich, dann sehen wir das iOS mit deutlich weniger RAM auskommt.

Android dagegen nimmt alles was es bekommen kann.

Das ist einfach kein guter Weg, der da eingeschlagen wird.

Und ja ich weiß, es gibt mehr Modelle mit Android und so weiter. Aber andere Spiele sind auch optimiert und sehen besser aus.

Und die Raytracing Screenshots sind halt auch keine gute Werbung für Raytracing.

Solche Beleuchtungseffekte waren in abgeschwächter Form auch sonst möglich.

Nehmen wir iOS und Android als Vergleich, dann sehen wir das iOS mit deutlich weniger RAM auskommt.

Android dagegen nimmt alles was es bekommen kann.

Das ist einfach kein guter Weg, der da eingeschlagen wird.

Und ja ich weiß, es gibt mehr Modelle mit Android und so weiter. Aber andere Spiele sind auch optimiert und sehen besser aus.

Und die Raytracing Screenshots sind halt auch keine gute Werbung für Raytracing.

Solche Beleuchtungseffekte waren in abgeschwächter Form auch sonst möglich.

Zuletzt bearbeitet:

T

tukse

Gast

Unterm Strich ist das Spiel technisch also einfach schlecht umgesetzt.

Die Probleme habe ich auch mit der 6900xt und 16gb VRAM. Der VRAM läuft in kürzester Zeit voll - Folge sind heftige Framedrops, Microstuttering,....DarkerThanBlack schrieb:Wenn der VRAM-ständig überläuft, dann läuft er auch bei 12 GB über. Oder bei 16GB. Logikverständnis? 🤔

Es ist mir unbegreiflich, wie man hier versucht anhand eines völlig unfertigen, fehlerhaften Spiels Hypothesen über den VRAM Bedarf zukünftiger Titel aufzustellen. Hier irgendwelche Kausalbeziehungen zu unterstellen ist völlig illegitim.

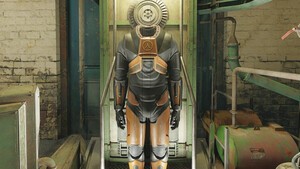

Vielleicht hätte Arkane mal das Konzerntelefonbuch zur Hand nehmen und die Kollegen aus Richardson anrufen sollen. Da hätten sie sicherlich was lernen können...

Recharging

Commodore

- Registriert

- Dez. 2011

- Beiträge

- 4.109

@Neubauten

Danke für deinen Beitrag, man kämpft in dem Thread gegen Windmühlen und die Gesinnung pro/contra AMD/NVidia, was ich total schade und plem plem finde.

Danke für deinen Beitrag, man kämpft in dem Thread gegen Windmühlen und die Gesinnung pro/contra AMD/NVidia, was ich total schade und plem plem finde.

T

Tiara G.

Gast

@Wolfgang Danke für den CPU Test.

Was würdest du bei einer 1080Ti empfehlen einzustellen? Ich würds ungefähr so probieren ...

Preset mittel

RT aus

Limiter auf 60 (Das sollte der 8700K von den Framtimes her noch drücken, hoff ich)

Hab Wqhd 144 Gsync. Muss ich vllt sogar auf FHD runter? Und Gsync, kann es möglicherweise in dem Spiel ein Problem versuchen, bzgl Stuttering?

Ich glaube, das Spiel hat sehr hohes Potential und es wird eines der besten dieses Jahr werden, wenn die Probleme gefixt sind.

MfG

T.

Was würdest du bei einer 1080Ti empfehlen einzustellen? Ich würds ungefähr so probieren ...

Preset mittel

RT aus

Limiter auf 60 (Das sollte der 8700K von den Framtimes her noch drücken, hoff ich)

Hab Wqhd 144 Gsync. Muss ich vllt sogar auf FHD runter? Und Gsync, kann es möglicherweise in dem Spiel ein Problem versuchen, bzgl Stuttering?

Ich glaube, das Spiel hat sehr hohes Potential und es wird eines der besten dieses Jahr werden, wenn die Probleme gefixt sind.

MfG

T.

foo_1337 schrieb:in 4K mit RT reichen die 10GB einer 3080 nicht aus, die Performance an sich wäre aber ok.

Die 16GB einer 6800XT sind dann zwar ausreichend, aber die Performance ist trotzdem beschissen.

Chapeu an die Entwickler würde ich sagen.

Sehr schön zusammen gefasst

Ein 4K Bildschirm würde ich auch niemals nicht mit meiner RTX 3080 betreiben.

Treu dem Motto PCMR dürfen ja keine Regler nach links geschoben werden !!

Quelle: https://tenor.com/view/pc-master-race-gaming-the-feels-gtx1080-gif-7941212

Es stimmt schon - 10GB sind etwas zu wenig. Ich fahre den Kompromiss mit 3440x1440 und RT Off (DLSS ON <- wenn gut umgesetzt)

Somit lässt es sich auch heute gut zocken

4stellig ist eine Grenze die ich für eine Komponente nicht erreichen möchte.

Ich bräuchte dann sowieso UUHD xD - also wieder 21:9 <- bin dem Format verfallen.

TenDance schrieb:Ist das jetzt schlecht programmiert oder war Nvidias Aussage ihre Highend Grafikkarten seien keine Speicherkrüppel im Angesicht bevorstehender Nextgen-Spiele Mal wieder Marketing-Nebelkerzen?

Einerlei, AMD sollte das Spiel in Gold rahmen, das ist von vorne bis hinten Werbung warum die 6800XT eine tolle Karte ist.

Wo in den Benchmarks erkennst du das?

Egal wo du hinschaust, die 3080 liegt vor der 6800 XT.

Ich bin definitiv im Team Red und besitze selbst eine 6900 XT.

Die Benchmarks zeigen aber, dass NOCH die 3080 vorne liegt.

AMD liegt vor allem im Assassin's Creed vorne...

Dass man aufgrund des Kopierschutzes nur 5 CPUs durch den Benchmark bekommt, ist echt ätzend. Mich erstaunt der extreme Unterschied sowohl zwischen Zen 1 und 2 als auch zwischen 2 und 3. Bringen mehr als 6 Kerne etwas? Da jede CPU aus einer anderen Gen kommt (kommen muss...), kann man leider nicht erkennen, ob 5950X und 11900K wegen ihrer Kerne so davon ziehen oder wegen der neueren Architektur. @Wolfgang wäre es möglich bei zukünftigen Benches mit Denuvo bei den großen CPUs jeweils im BIOS auf 6 Kerne zu begrenzen? Dann hätte man ungefähr ne Abschätzung wie sich 5600X und 11600K schlagen würden.

Anon-525334

Banned

- Registriert

- Dez. 2010

- Beiträge

- 1.478

Man sieht aber das ein halbwegs schneller Prozessor reicht und das Geld besser in eine bessere Grafikkarte angelegt ist

VerdientZeroStrat schrieb:Hab dafür auf Twitter hart auf die 12 gekriegt übrigens.

Nein natürlich nicht, ich fand es toll eure Ideen und Nachforschungen zu lesen. Ich denke auch ohne den Artikel wäre auch kein Nope von AMD gekommen (was ja ein kleiner Erkenntnis Gewinn ist/war)

Zum Glück sieht es heute anders aus und ist auf vielen CPUs verfügbar.

Z

ZeroStrat

Gast

Haha! Dieser BullshitBuster Account hatte mich danach auf dem Kieker wegen jedem Mist.bad_sign schrieb:Verdient

Und wieso habe ich dann im Fallout 3 Ordner eine 64Bit.exe? Natürlich, weil es auf 32Bit nur programmiert wurde ne?sethdiabolos schrieb:Fallout 3 kam raus, als ein Großteil der Spieler noch 32Bit-OS hatte (XP & Vista), was für einen Sinn würde es da machen, dass man auf 64Bit programmiert? Für Fallout New Vegas gab es sogar einen speziellen Patch, damit mehr wie 2GB RAM adressiert werden konnten. Fallout 3 wird das Problem als Vorläufer auch gehabt haben und soweit ich weiß konnte die Grundversion von Skyrim auch nur 3,5 GB adressieren. Erst die Special-Version brachte eine 64Bit-Exe mit (korrigiert mich, wenn meine Erinnerung trügt). Fallout 4 hatte eine 64Bit-Exe, aber die Engine ist immer noch die alte und auch da gibt es Probleme deswegen wenn man viele Mods nutzt. Ich bin aber nicht so der Bethesda-Spieler, also juckt mich das insgeheim eh nicht.

Zitat von Golem (zu der Skyrim Special-Edition):

„ Im Prinzip handelt es sich um eine Portierung der vorhandenen Inhalte auf eine neuere Version der Creation-Engine, technisch entspricht der Unterbau weitestgehend dem von Fallout 4. Die Verbesserungen beschränken sich allerdings auf die wichtige 64-Bit-Unterstützung und die Grafik, die Animationen beispielsweise sind so hölzern wie 2011.“

https://www.golem.de/news/skyrim-sp...sere-optik-ist-teuer-erkauft-1610-124128.html

Sprich Skyrim und alle vorlaufenden Games müssen auf 32Bit gelaufen sein.

Ergänzung ()

McFritte schrieb:Fallout 3 wurde ebenso wie Skyrim Classic auf der Gamebryo Engine (von Bethesda als Creation Engine lizensiert) entwickelt und waren in 32 Bit. Erst Skyrim SE und Fallout 4 liefen dann auf einer von Bethesda aufgebohrten Version mit 64 Bit. Soviel zum "selber informieren und Bullshit"

Sollte das jetzt Ironie sein? Youtube quillt über von Videos mit Bugs zu allen Spielen von Bethesda mit der Creation Engine. Bethesda wird nicht umsonst immer wieder als Bugthesda bezeichnet.

Auch zu dir, wie erklärst du dir nun die 64bit.exe?

Und Performance Bugs habe ich keine mitbekommen, lief wie gesagt butterweich bei mir, spielerisch gab es manchmal einen kleinen bug mit dem "aimbot" aber ansonsten kam mir nichts weiter vor die linse.

Ich behaupte einfach mal, die gleiche Qualität ginge auch mit weniger. Die Entwickler haben sich da wenig Mühe gegeben. Die Konkurrenz bekommt es hin.

Außerdem nützt es nur sehr wenig wenn entsprechende Grafikkarten so extrem teuer bleiben. Dann kauft die kaum jemand und es kann nicht vorrausgesetzt werden.

Das Speicher wächst liegt in der Natur, das tat er schon immer... allerdings sollten sich erstmal ~12GB in der Masse durchsetzen.

Außerdem nützt es nur sehr wenig wenn entsprechende Grafikkarten so extrem teuer bleiben. Dann kauft die kaum jemand und es kann nicht vorrausgesetzt werden.

Das Speicher wächst liegt in der Natur, das tat er schon immer... allerdings sollten sich erstmal ~12GB in der Masse durchsetzen.

Einfallslos2021

Banned

- Registriert

- Aug. 2021

- Beiträge

- 80

für das Spiel braucht man gar nichts gross anlegen so denn man kein Grafikfetischist ist oder eben FPS Enthusiastmcsteph schrieb:Man sieht aber das ein halbwegs schneller Prozessor reicht und das Geld besser in eine bessere Grafikkarte angelegt ist

zu meiner Verwunderung ist es sogar mit einer RX570 mit nur 4GB VRAM spielbar, gepaart mit einem 6 Jahre alten i5, liegt auf einer SSD, hat 16GB RAM

war sofort erschrocken als das Popup kam, zu wenig VRAM, selbst auf low kratzt es schon an den 4GB, aber entgegen aller bösen Reviews auf Steam komme ich längerfristig recht flüssig durchs Spiel auf den niedrigen Settings und es ist noch anschaubar

gelockt auf 59 Frames global im Rivatuner ohnehin das System steht die links oben, geht mal in die 40er runter, aber unspielbar wird es eigentlich nie

scheint einer dieser Titel zu sein wo die dicksten Systeme die größten Probleme haben?

- Registriert

- Dez. 2016

- Beiträge

- 19.553

@Einfallslos2021 einen Shooter mit ~40fps zu spielen (selbst wenn nur streckenweise) stell ich mir aber grauslig vor. Da hilft dann auch G-Sync/Freesync nicht mehr.

Als ich Prey gespielt hatte, hatte ich auch 2-3x einen Dip auf unter 60 - je nach dem was grade los war und wo ich mich befand. Das war dann echt nicht mehr schön

Als ich Prey gespielt hatte, hatte ich auch 2-3x einen Dip auf unter 60 - je nach dem was grade los war und wo ich mich befand. Das war dann echt nicht mehr schön

Einfallslos2021

Banned

- Registriert

- Aug. 2021

- Beiträge

- 80

in dem Falle hier reden wir ja nicht von einem Shooter durch und durch, oft genug sneakt man sich ran und macht stealth kills von hinten etc

Ähnliche Themen

- Antworten

- 39

- Aufrufe

- 2.387

D