- Registriert

- Juni 2006

- Beiträge

- 44.584

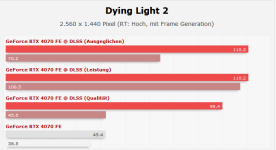

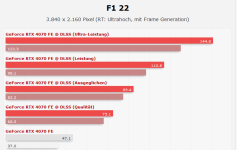

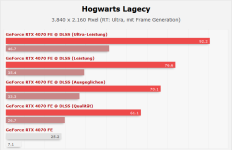

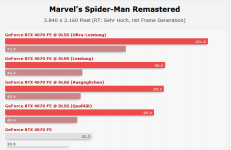

Einige AAA-Titel aus 2023. Und viele künftige, die noch folgen werden. Genau das ist der Trick. Zum Launch werden saftige, lange Balken aufgetischt. Während sich über die Jahre im Hintergrund die Software ändert / bzw. die Anforderungen ändern. Sei es nur durch miese Optimierung der Spiele.CiX schrieb:Leute, die meinen dass 8gb nicht ausreichend seien, sollten dazu schreiben wo das der Fall ist. AAA z.b.

Was du verlangst ist, dass dir jemand 2021 im RTX3070 gesagt hätte haben sollen, dass ein The Last Of Us, ein Dead Space Remake, ein Hogwarts Legacy usw. mit 8GB Probleme bereiten können.

Letztlich haben eine nicht kleine Anzahl an Kommentatoren genau dies bereits vor Jahren getan. Einen faktischen Beweis kann man vllt. bei sich unveränderlichen Parametern verlangen. Was hier nicht der Fall ist.

Für diese Spiele braucht es keine 2023er 500€ Grafikkarte.CiX schrieb:also vom letzten Titel abgesehen alles Titel, die Stunden über Stunden gezockt werden von vielen Vielen Menschen, im Gegensatz zu der irrelevanten AAA Blase hier.

Fazit:

Die hohen Verkaufspreise implizieren (für viele) eine universelle Tauglichkeit des Produkts.

Je nach Auflösung und Größe der Spieleproduktion ist diese bereits ab Tag 1 in Gefahr.