Esenel schrieb:

Da ich noch keine besitze kann ich noch nicht sagen um wie viel schneller der 10900K hier sein wird.

Die 3090 ist für mind. 1440p und aufwärts gedacht. Die 3090 kauft man nicht, um auf 1080p oder 720p zu zocken - schon lange nicht bei min. Einstellungen. Ist genau so ein Schwachsinn, wenn man mit einer 2080ti in 4k einen CPU-Test als Messlatte nimmt.

https://www.techspot.com/article/2103-amd-vs-intel-rtx-3080/

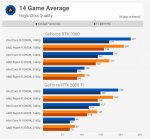

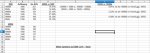

3950X und 10900k Stock mit 3200 CL14 RAM - RTX3080

3950X und 10900k mit 3200MHz CL14 RAM - RTX3080

Um was streitet ihr euch jetzt? Es ist ein Grafikkarten-Test und kein CPU-Test. Mit max. Grafikeinstellung hat man mit einer 3080 einen Unterschied von 8,61 % (laut Techspot) zwischen 3950X und 10900k (im besagtem Parkour - andere Parkours können größere, aber auch kleinere Unterschiede vorweisen!).

Sicherlich wird der 10900k im CPU-Test später wieder bei CB und Co. etwas zulegen - nur vergisst Du, dass die Ryzen auch manchmal im GPU-Limit stecken. Sicherlich wird der 10900k in 1080p etwas zulegen - aber auch nicht signifikant (und ja,

beide können noch per OC ihre Leistung steigern!).

Im obrerem Test zeigt sich, dass beide CPUs ihre Leistung beim Wechsel von einer 2080ti auf eine 3080 steigern konnten. Der 10900k um 16,41 % in 1080p und der 3950X um 14,84 % in 1080p (du vergisst, dass nicht nur der 10900k im GPU-Bottleneck hängen kann!) - dabei war der 10900k nur 8,61 % ggü. dem 3950X im Vorteil (max. Settings in 1080p).

Wären die Ryzen so im Nachteil (CPU-Limit), würde man spätestens in 1440p eine geringere AVG-fps Steigerung erfahren - aber nein der 10900k hat eine Steigerung von 23,13 % in 1440p bei 3080 ggü. der 2080ti und der 3950X eine Steigerung von 21,99 % in 1440p bei 3080 ggü. der 2080ti!

Je nach Parkour wird sich der Wert bei 1080p etwas ändern (man kann ja nur AMD-Game-Lieblinge nehmen oder Intel-Lieblinge, welche die andere CPU zumindest nicht besser stellen). Nur wird es in allen Parkours kaum Unterschiede aufzeigen. Egal ob Intel oder AMD.

Hier geht es um einen GPU-Test. Wenn in enigen Monaten Zen3 released wird, wird es einen neuen CPU-Test mit der 3090 geben und dann wird man sehen, wo der 10900k und 3900X bei 1080p stehen werden.

PS:

Ich habt doch ständig von 720p geredet - da habt ihr euren Test doch, wie schnell der 10900k ggü. einem 3900x ist.

https://www.techpowerup.com/review/intel-core-i9-10900k/14.html

Wozu wird hier wieder dieses Thema aufgemacht? Ja, ich hätte mir auch gewünscht, dass man es auch mit einem 10900k testen würde, dann hätte ich mir die Arbeit ersparen können (wobei es auch irgendwie Spass macht).