captain kirk

Lieutenant

- Registriert

- Okt. 2019

- Beiträge

- 732

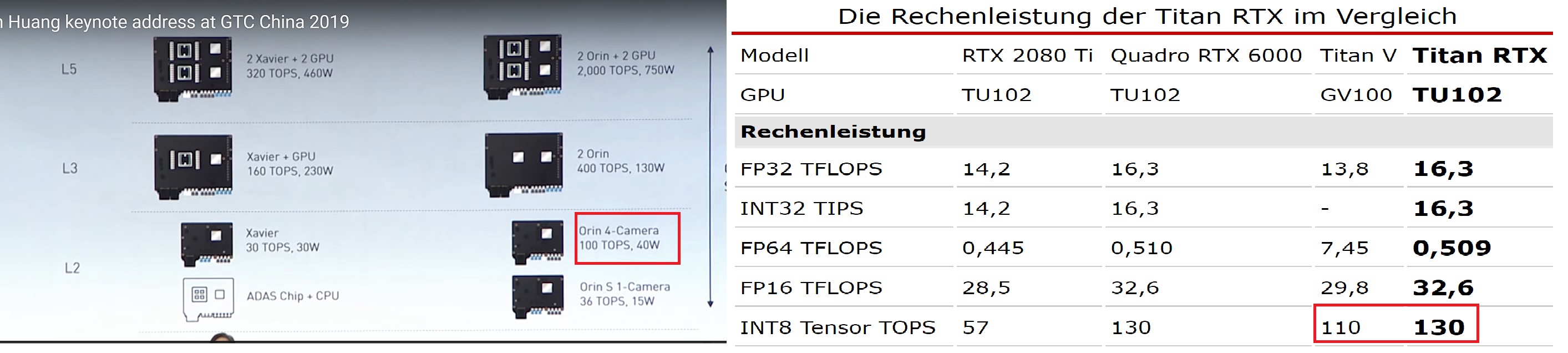

Mal ne kleine interessante Gegenüberstellung der winzige 40 Watt verbrauchende Orin und der schleppt ja noch ARM Cores mit sich rum, würde bei der reinen

8bit Tensor Core Performance sich schon fast anschicken , die riesen Chips Volta V100 und ebenso Titan RTX nahezu aus dem Socken zu hauen.

Und jetzt stell sich jemand mal vor, Nvidia modifiziert diese Units noch zu reinen RT Cores fixed Function, wie bei Turing bereits geschehen

bei 130 Watt ist man die reine Tensor Core Leistung betreffend bereits 4 mal so schnell wie der riesige Volta V100 und über 3 mal schneller wie Turing

Dazu immer noch bedenken das diese next Gen Chips in den Steuergeräten ,eher der 106er Klasse Chips entspringen sofern sich seit Xavier nix verändert hätte

Die 100er"Ampere" GPU hätte hier also noch um einiges mehr Potential ,sowohl von der Siliziumfläche als auch vom zur Verfügung stehenden Energiebudget , das locker nochmal 130 Watt mehr aufrufen könnte

Auch schön zu sehen bei LV5 Autonomie , wo noch zusätzlich reine GPUs dazu kommen ,ohne ARM Part als Klotz am Bein wie bei Orin only , sich das Ganze nochmals zuspitzt bei der Tensor Performance

8bit Tensor Core Performance sich schon fast anschicken , die riesen Chips Volta V100 und ebenso Titan RTX nahezu aus dem Socken zu hauen.

Und jetzt stell sich jemand mal vor, Nvidia modifiziert diese Units noch zu reinen RT Cores fixed Function, wie bei Turing bereits geschehen

bei 130 Watt ist man die reine Tensor Core Leistung betreffend bereits 4 mal so schnell wie der riesige Volta V100 und über 3 mal schneller wie Turing

Dazu immer noch bedenken das diese next Gen Chips in den Steuergeräten ,eher der 106er Klasse Chips entspringen sofern sich seit Xavier nix verändert hätte

Die 100er"Ampere" GPU hätte hier also noch um einiges mehr Potential ,sowohl von der Siliziumfläche als auch vom zur Verfügung stehenden Energiebudget , das locker nochmal 130 Watt mehr aufrufen könnte

Auch schön zu sehen bei LV5 Autonomie , wo noch zusätzlich reine GPUs dazu kommen ,ohne ARM Part als Klotz am Bein wie bei Orin only , sich das Ganze nochmals zuspitzt bei der Tensor Performance

Zuletzt bearbeitet: