Krautmaster schrieb:mich für meinen Teil interessieren diese Peakwerte nicht die Bohne. Was hab ich denn davon wenn ich weiß dass meine GPU vorm Netzteil für Millisekunden auch 1kw ziehen kann? Entscheidend ist doch das was der Rechner aus der Dose zieht und was der Stromzähler erfasst. Für den Consumer sind so Messungen wie THG zwar netter Lesestoff - aber mehr aus theoretischer Natur, weniger praxisbezogen.

Ähhh okay, deshalb schrieb ich auch, dass die Peakwerte für den Stromverbrauch irrelevant sind...

Und nein Tomshardware ist nicht nur netter Lesestoff, sondern sie liefern die transparentesten und akkuratesten GPU/CPU Reviews. Ich finde es besonders gut, dass da genau beschrieben wo Probleme liegen, worauf man achten muss und wie diese gelöst werden. Das Ganze sehr nachvollziehbar. Es gibt sogar einen extra Artikel, der sich mit der Leistungsaufnahme von Grafikkarten beschäftigt

http://www.tomshardware.de/leistung...chselwirkung-messung,testberichte-241622.html

Da geht es übrigens unter anderem um die böse R9 295X2

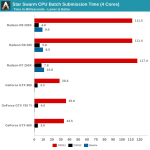

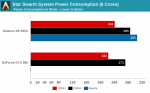

Es wurden einige Mythen zerstört, und man hat die 295X2 sogar auf einem 500W beQuiet problemlos betriebenWie AMD uns mitteilte, ist die TDP der Karte mit maximal 450 Watt spezifiziert - und wenn wir uns die zweite Seite mit Power Tune und der Theorie Erinnerung rufen, dann wissen wir auch, dass diese Angabe nicht nur ein schnöder Schätzwert ist, sondern eine echte Grenze. Beim Gaming messen wir noch knapp unter 430 Watt, so wie von AMD kommuniziert und nicht über 500, wie oft verbreitet:

Deshalb ist Toms Hardware für mich die Referenz wenn es um Leistungsaufnahme geht. Den Käse 100-150W höherer Stromverbrauch von AMD Karten, braucht mir keiner zu erzählen. Und der aktuelle Stand der Dinge ist, dass eine Ref 290X durchschnittlich gut 240W verbraucht, während eine Ref GTX980 185W. Doch während AMD's Partnerkarten durch die geringe Übertaktung und bessere Kühlung ebenfalls bei ca. 250W bleiben, ziehen Custom 980er etwa 200W. Hier dagegen beträgt der Unterschied zw. Ref 980 und 290X ~1GHz weit über 100W. Dass die AMD Karte die CPU so auslastet, dass diese so viel Energie verbraucht, kann ich mir kaum vorstellen...

Es wäre gut, wenn sich der Igor dazu äußern würde.